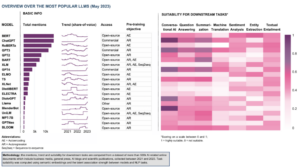

Na hitro razvijajočem se področju umetne inteligence je obdelava naravnega jezika postala osrednja točka za raziskovalce in razvijalce. Graditi na temeljih Arhitektura transformatorjev in BERT-ova dvosmerna nadgradnja, se je v zadnjih letih pojavilo več prelomnih jezikovnih modelov, ki premikajo meje tega, kar lahko stroji razumejo in ustvarijo.

V tem članku se bomo poglobili v najnovejši napredek v svetu jezikovnih modelov velikega obsega, raziskali izboljšave, ki jih uvaja vsak model, njihove zmogljivosti in potencialne aplikacije. Preučili bomo tudi Visual Langauge Models (VLM), ki so usposobljeni za obdelavo ne le besedilnih, ampak tudi vizualnih podatkov.

Če želite preskočiti, so tukaj jezikovni modeli, ki smo jih predstavili:

- GPT-3 avtorja OpenAI

- Google LaMDA

- PaLM od Googla

- Flamingo proizvajalca DeepMind

- BLIP-2 podjetja Salesforce

- LLaMA avtorja Meta AI

- GPT-4 avtorja OpenAI

Če je ta poglobljena izobraževalna vsebina za vas koristna, lahko se naročite na naš seznam raziskav AI za raziskave na katerega bomo opozorili, ko bomo izdali novo gradivo.

Najpomembnejši veliki jezikovni modeli (LLM) in vizualni jezikovni modeli (VLM) v letu 2023

1. GPT-3 z OpenAI

Povzetek

Skupina OpenAI je predstavila GPT-3 kot alternativo označenemu naboru podatkov za vsako novo jezikovno nalogo. Predlagali so, da lahko povečevanje jezikovnih modelov izboljša učinkovitost delovanja v nekaj korakih pri neodvisnosti od nalog. Da bi preizkusili ta predlog, so usposobili avtoregresivni jezikovni model s parametrom 175B, imenovan GPT-3, in ocenil njegovo uspešnost pri več kot dveh ducatih NLP nalog. Vrednotenje z nekajkratnim učenjem, enkratnim učenjem in ničelnim učenjem je pokazalo, da je GPT-3 dosegel obetavne rezultate in občasno celo presegel najsodobnejše rezultate, dosežene z natančno nastavljenimi modeli.

Kaj je cilj?

- Predlagati alternativno rešitev za obstoječo težavo, ko je za vsako novo jezikovno nalogo potreben označen nabor podatkov.

Kako se lotiti problema?

- Raziskovalci so predlagali razširitev jezikovnih modelov, da bi izboljšali učinkovitost delovanja v nekaj posnetkih pri neodvisnosti od nalog.

- O GPT-3 model uporablja isti model in arhitekturo kot GPT-2, vključno s spremenjeno inicializacijo, prednormalizacijo in reverzibilno tokenizacijo.

- V nasprotju z GPT-2 pa v plasteh transformatorja uporablja izmenične goste in lokalno trakaste redke vzorce pozornosti, kot v Redki transformator.

Kakšni so rezultati?

- Model GPT-3 brez natančnega uglaševanja dosega obetavne rezultate pri številnih nalogah NLP in celo občasno presega najsodobnejše modele, ki so bili natančno nastavljeni za to posebno nalogo:

- o CoQA primerjalna vrednost, 81.5 F1 v nastavitvi nič-shot, 84.0 F1 v nastavitvi z enim strelom in 85.0 F1 v nastavitvi z nekaj streli, v primerjavi z oceno 90.7 F1, ki jo je dosegla natančno nastavljena SOTA.

- o TriviaQA primerjalna vrednost, 64.3% natančnost pri nastavitvi nič-shot, 68.0% pri nastavitvi za en strel in 71.2% pri nastavitvi za nekaj strelov, kar presega stanje tehnike (68%) za 3.2%.

- o Lambada nabora podatkov, 76.2% natančnost pri nastavitvi nič-shot, 72.5% pri nastavitvi za en strel in 86.4% pri nastavitvi za nekaj strelov, kar presega stanje tehnike (68%) za 18%.

- Novice, ki jih je ustvaril model GPT-175 s parametrom 3B, je po ocenah človeka težko ločiti od pravih (z natančnostjo komaj nad stopnjo možnosti pri ~ 52%).

- Kljub izjemni zmogljivosti GPT-3 je dobil mešane ocene skupnosti AI:

- »Hype GPT-3 je preveč. Impresivno je (hvala za lepe pohvale!), Vendar ima vseeno resne slabosti in včasih naredi zelo neumne napake. AI bo spremenil svet, toda GPT-3 je šele zelo zgodaj. Veliko moramo še ugotoviti. « - Sam Altman, izvršni direktor in soustanovitelj OpenAI.

- "Šokiran sem, kako težko je ustvariti besedilo o muslimanih iz GPT-3, ki nima nič skupnega z nasiljem ... ali pobijanjem ..." - Abubakar Abid, izvršni direktor in ustanovitelj Gradio.

- »Ne. GPT-3 v bistvu ne razume sveta, o katerem govori. Nadaljnje povečanje korpusa mu bo omogočilo ustvariti verodostojnejšo pastišo, ne bo pa odpravilo njenega temeljnega nerazumevanja sveta. Predstavitve GPT-4 bodo še vedno zahtevale nabiranje človeške češnje. " - Gary Marcus, izvršni direktor in ustanovitelj podjetja Robust.ai.

- "Ekstrapolacija spektakularne zmogljivosti GPT3 v prihodnost kaže, da je odgovor na življenje, vesolje in vse samo 4.398 bilijona parametrov." - Geoffrey Hinton, dobitnik nagrade Turing.

Kje izvedeti več o tej raziskavi?

Kje lahko dobite kodo za izvajanje?

- Koda sama ni na voljo, vendar je nekaj statističnih podatkov nabora podatkov skupaj z brezpogojnimi, nefiltriranimi vzorci 2048 žetonov iz GPT-3 objavljeno GitHub.

2. Google LaMDA

Povzetek

Lajezik Modeli za Ddialog Aaplikacije (TheMDA) so bili ustvarjeni s postopkom natančnega prilagajanja skupine nevronskih jezikovnih modelov, ki temeljijo na Transformerju in so zasnovani posebej za dialoge. Ti modeli imajo največ 137B parametrov in so bili usposobljeni za uporabo zunanjih virov znanja. Razvijalci LaMDA so imeli v mislih tri ključne cilje – kakovost, varnost in utemeljenost. Rezultati so pokazali, da fina nastavitev omogoča zmanjšanje vrzeli v kakovosti na človeško raven, vendar je zmogljivost modela glede varnosti in prizemljenosti ostala pod človeško ravnjo.

Googlov Bard, sprosti pred kratkim kot alternativo ChatGPT poganja LaMDA. Kljub temu, da je Bard pogosto označen kot dolgočasno, bi ga lahko razumeli kot dokaz Googlove zavezanosti dajanju prednosti varnosti, tudi sredi intenzivnega rivalstva med Googlom in Microsoftom za vzpostavitev prevlade na področju generativne umetne inteligence.

Kaj je cilj?

- Izdelati model za odprto domensko pogovorno aplikacijo, kjer se lahko pogovorni agent pogovarja o kateri koli temi z odgovori, ki so razumni, specifični za kontekst, temeljijo na zanesljivih virih in etično.

Kako se lotiti problema?

- LaMDA temelji na Transformer, arhitektura nevronske mreže, ki jo je leta 2017 izumil in odprl kodo Google Research.

- Tako kot drugi veliki jezikovni modeli, vključno z BERT in GPT-3, se LaMDA usposablja na terabajtih besedilnih podatkov, da se nauči, kako so besede povezane med seboj, in nato predvidi, katere besede bodo verjetno naslednje.

- Vendar je bil LaMDA za razliko od večine jezikovnih modelov usposobljen za dialog, da bi zaznal nianse, ki razlikujejo odprti pogovor od drugih oblik jezika.

- Model je tudi natančno nastavljen za izboljšanje občutljivosti, varnosti in specifičnosti svojih odzivov. Čeprav so fraze, kot sta »to je lepo« in »ne vem«, lahko pomembne v mnogih scenarijih dialoga, ni verjetno, da bodo vodile do zanimivih in privlačnih pogovorov.

- Generator LaMDA najprej ustvari več odgovorov kandidatov, ki so vsi ocenjeni glede na to, kako varni, smiselni, specifični in zanimivi so. Odzivi z nizkimi ocenami varnosti so izločeni, nato pa je kot odgovor izbran najvišje uvrščeni rezultat.

Kakšni so rezultati?

- Številni poskusi kažejo, da lahko LaMDA sodeluje pri odprtih pogovorih o različnih temah.

- Vrsta kvalitativnih ocen je potrdila, da so odzivi modela ponavadi smiselni, specifični, zanimivi in temeljijo na zanesljivih zunanjih virih, vendar je še vedno prostor za izboljšave.

- Kljub vsem dosedanjim napredkom se avtorji zavedajo, da ima model še vedno veliko omejitev, ki lahko povzročijo neustrezne ali celo škodljive odzive.

Kje izvedeti več o tej raziskavi?

Kje lahko dobite kodo za izvajanje?

- Odprtokodna implementacija PyTorch za arhitekturo LaMDA pred usposabljanjem je na voljo na GitHub.

3. Google PaLM

Povzetek

Papoti Ltesnoba Model (PaLM) je 540 milijard parametrov, jezikovni model, ki temelji na Transformerju. PaLM je bil usposobljen na čipih 6144 TPU v4 z uporabo Pathways, novega sistema ML za učinkovito usposabljanje v več TPU Pods. Model prikazuje prednosti skaliranja v nekajkratnem učenju, doseganje najsodobnejših rezultatov na stotinah jezikovnega razumevanja in merilih uspešnosti generacije. PaLM prekaša natančno nastavljene najsodobnejše modele pri nalogah sklepanja v več korakih in presega povprečno človeško zmogljivost na merilu uspešnosti BIG.

Kaj je cilj?

- Za izboljšanje razumevanja, kako skaliranje velikih jezikovnih modelov vpliva na učenje v nekaj korakih.

Kako se lotiti problema?

- Ključna ideja je razširiti usposabljanje 540-milijardnega parametrskega jezikovnega modela s sistemom Pathways:

- Ekipa je uporabljala vzporednost podatkov na ravni Poda v dveh Podih Cloud TPU v4, medtem ko je uporabljala standardne podatke in vzporednost modela znotraj vsakega Poda.

- Usposabljanje jim je uspelo razširiti na 6144 čipov TPU v4, kar je največja konfiguracija sistema, ki temelji na TPU, uporabljena za usposabljanje do danes.

- Model je dosegel učinkovitost usposabljanja 57.8% strojne uporabe FLOP-ov, kar je, kot trdijo avtorji, najvišja doslej dosežena učinkovitost usposabljanja za velike jezikovne modele v tem obsegu.

- Podatki o usposabljanju za model PaLM so vključevali kombinacijo angleških in večjezičnih naborov podatkov, ki vsebujejo visokokakovostne spletne dokumente, knjige, Wikipedijo, pogovore in kodo GitHub.

Kakšni so rezultati?

- Številni poskusi kažejo, da se je zmogljivost modela strmo povečala, ko je ekipa prešla na svoj največji model.

- PaLM 540B je dosegel vrhunsko zmogljivost pri številnih zelo težkih nalogah:

- Razumevanje in generiranje jezika. Predstavljeni model je pri 28 od 29 nalog, ki vključujejo naloge z odgovori na vprašanja, naloge za zapiranje in dokončanje stavkov, naloge bralnega razumevanja v kontekstu, naloge zdravorazumskega sklepanja, naloge SuperGLUE in več. Uspešnost PaLM pri nalogah BIG-bench je pokazala, da lahko razlikuje vzrok in posledico ter razume konceptualne kombinacije v ustreznih kontekstih.

- Obrazložitev. Z 8-shotnim ukazovanjem PaLM reši 58 % problemov v GSM8K, merilu tisočev zahtevnih matematičnih vprašanj na osnovni šoli, s čimer preseže prejšnji najvišji rezultat 55 %, dosežen s fino nastavitvijo modela GPT-3 175B. PaLM prav tako dokazuje sposobnost generiranja eksplicitnih razlag v situacijah, ki zahtevajo kompleksno kombinacijo večstopenjskega logičnega sklepanja, poznavanja sveta in globokega razumevanja jezika.

- Ustvarjanje kode. PaLM deluje enako kot natančno nastavljeni Codex 12B, medtem ko za usposabljanje uporablja 50-krat manj kode Python, kar potrjuje, da veliki jezikovni modeli učinkoviteje prenašajo učenje iz drugih programskih jezikov in podatkov naravnega jezika.

Kje izvedeti več o tej raziskavi?

Kje lahko dobite kodo za izvajanje?

- Neuradna izvedba PyTorch posebne arhitekture Transformer iz raziskovalnega dokumenta PaLM je na voljo na GitHub. Ne bo prilagojen in je objavljen samo v izobraževalne namene.

4. Flamingo proizvajalca DeepMind

Povzetek

Flamingo je vrhunska družina vizualnih jezikovnih modelov (VLM), usposobljenih za obsežne večmodalne spletne korpuse z mešanim besedilom in slikami. S tem usposabljanjem se lahko modeli prilagodijo novim nalogam z uporabo minimalnih primerov z opombami, ki so na voljo kot poziv. Flamingo vključuje ključne arhitekturne napredke, zasnovane tako, da združujejo prednosti vnaprej pripravljenih modelov samo za vid in samo za jezik, obdelujejo zaporedja spremenljivo prepletenih vizualnih in besedilnih podatkov ter brezhibno prilagajajo slike ali videoposnetke kot vnose. Modeli izkazujejo izjemno prilagodljivost različnim slikovnim in video nalogam, kot so vizualni odgovori na vprašanja, naloge dodajanja napisov in vizualni odgovori na vprašanja z več možnostmi izbire, s čimer postavljajo nove standarde učinkovitosti z uporabo pozivov, specifičnih za opravila, pri učenju v nekaj posnetkih.

Kaj je cilj?

- Za napredek v smeri omogočanja večmodalnim modelom hitrega učenja in izvajanja novih nalog na podlagi kratkih navodil:

- Široko uporabljena paradigma vnaprejšnjega usposabljanja modela na veliki količini nadzorovanih podatkov, nato natančnega prilagajanja za določeno nalogo, zahteva veliko virov in zahteva na tisoče označenih podatkovnih točk skupaj s skrbnim prilagajanjem hiperparametrov za vsako nalogo.

- Trenutni modeli, ki uporabljajo kontrastni objektiv, omogočajo brezhibno prilagajanje novim nalogam, vendar ne dosegajo bolj odprtih nalog, kot so napisi ali vizualni odgovori na vprašanja, ker nimajo zmožnosti generiranja jezika.

- Namen te raziskave je uvesti nov model, ki učinkovito obravnava ta vprašanja in dokazuje vrhunsko zmogljivost v režimih z malo podatkov.

Kako se lotiti problema?

- DeepMind je predstavil Flamingo, VLM-je, zasnovane za kratkotrajno učenje različnih odprtih vidnih in jezikovnih nalog, z uporabo le nekaj primerov vnosa/izhoda.

- Modeli Flamingo so vizualno pogojeni avtoregresivni modeli za generiranje besedila, ki lahko obdelajo besedilne žetone, pomešane s slikami in/ali videoposnetki, ter ustvarijo besedilo kot izhod.

- Arhitektura Flaminga vključuje dva komplementarna vnaprej pripravljena in zamrznjena modela:

- Model vida, ki je sposoben "zaznavati" vizualne prizore.

- Velik jezikovni model, katerega naloga je izvajanje osnovnega sklepanja.

- Komponente nove arhitekture integrirajo te modele na način, ki ohranja znanje, pridobljeno med njihovim računalniško intenzivnim predhodnim usposabljanjem.

- Poleg tega imajo modeli Flamingo arhitekturo, ki temelji na Perceiverju, kar jim omogoča vnos slik ali videoposnetkov visoke ločljivosti. Ta arhitektura lahko ustvari fiksno število vizualnih žetonov na sliko/videoposnetek iz širokega in spremenljivega niza vizualnih vhodnih funkcij.

Kakšni so rezultati?

- Raziskava kaže, da se podobno kot LLM-ji, ki so dobri učenci nekajkrat, lahko VLM-ji učijo iz nekaj vhodnih/izhodnih primerov za naloge razumevanja slik in videa, kot so klasifikacija, napisi ali odgovarjanje na vprašanja.

- Flamingo postavlja novo merilo uspešnosti pri učenju v nekaj posnetkih, saj prikazuje vrhunsko zmogljivost pri širokem naboru 16 večmodalnih jezikovnih nalog in nalog razumevanja slik/videoposnetkov.

- Za 6 od teh 16 nalog Flamingo presega zmogljivost natančno nastavljenega stanja tehnike, čeprav uporablja samo 32 primerov za posamezne naloge – približno 1000-krat manj podatkov o usposabljanju za specifične naloge kot trenutno najbolj zmogljivi modeli.

Kje izvedeti več o tej raziskavi?

Kje lahko dobite kodo za izvajanje?

- DeepMind ni izdal uradne izvedbe Flaminga.

- Odprtokodno izvedbo uvedenega pristopa boste morda našli v OpenFlamingo Github Repo.

- Na voljo je alternativna izvedba PyTorch tukaj.

5. BLIP-2 podjetja Salesforce

Povzetek

BLIP-2 je učinkovito in generično ogrodje pred usposabljanjem za modele vida in jezika, zasnovano tako, da se izogne vse bolj previsokim stroškom predhodnega usposabljanja velikih modelov. BLIP-2 izkorišča že pripravljene zamrznjene vnaprej naučene kodirnike slik in zamrznjene velike jezikovne modele za zagon predusposabljanja vidnega jezika, ki vključuje lahek Querying Transformer, ki je vnaprej naučen v dveh stopnjah. Prva stopnja sproži učenje predstavitve vidnega jezika iz kodirnika zamrznjene slike, druga stopnja pa požene generativno učenje vida v jezik iz modela zamrznjenega jezika. Kljub bistveno manjšemu številu parametrov, ki jih je mogoče učiti, BLIP-2 prekaša najsodobnejše metode in prekaša DeepMindov Flamingo80B za 8.7 % na VQAv2 z ničelnim strelom s 54-krat manj parametri, ki jih je mogoče učiti. Model izkazuje tudi obetavne zmožnosti generiranja slike v besedilo z ničelnim strelom po navodilih naravnega jezika.

Kaj je cilj?

- Za pridobitev najsodobnejše zmogljivosti pri nalogah vizualnega jezika, hkrati pa zmanjšati stroške računanja.

Kako se lotiti problema?

- Ekipa Salesforce je predstavila nov okvir predhodnega usposabljanja v jeziku vida, poimenovan BLIP-2, Bootstrapping Ljezik-IVrač Pponovno usposabljanje z zamrznjenimi unimodalnimi modeli:

- Vnaprej usposobljeni unimodalni modeli med predhodnim usposabljanjem ostanejo zamrznjeni, da se zmanjšajo stroški izračuna in prepreči katastrofalno pozabljanje.

- Da bi olajšali navzkrižno modalno usklajevanje in premostili modalno vrzel med vnaprej usposobljenimi modeli vida in vnaprej usposobljenimi jezikovnimi modeli, ekipa predlaga lahek poizvedovalni transformator (Q-Former), ki deluje kot informacijsko ozko grlo med kodirnikom zamrznjene slike in zamrznjenim kodirnikom slike. LLM

- Q-former je vnaprej usposobljen z novo dvostopenjsko strategijo:

- Prva stopnja pred usposabljanjem izvaja učenje vizualno-jezikovne reprezentacije. To prisili Q-Former, da se nauči vizualne predstavitve, ki je najbolj pomembna za besedilo.

- Druga stopnja pred usposabljanjem izvaja generativno učenje od vida do jezika s povezovanjem izhoda Q-Formerja z zamrznjenim LLM. Q-Former je usposobljen tako, da LLM lahko interpretira njegovo izhodno vizualno predstavitev.

Kakšni so rezultati?

- BLIP-2 zagotavlja izjemne, najsodobnejše rezultate pri različnih nalogah vizualnega jezika, ki zajemajo vizualno odgovarjanje na vprašanja, napise slik in iskanje slikovnega besedila.

- Na primer, na zero-shot VQAv8.7 prekaša Flamingo za 2 %.

- Poleg tega je ta izjemna zmogljivost dosežena z znatno večjo učinkovitostjo računalnika:

- BLIP-2 prekaša Flamingo-80B, medtem ko uporablja 54× manj parametrov, ki jih je mogoče učiti.

- BLIP-2 ima zmogljivost za ustvarjanje slike v besedilo z ničelnim strelom kot odziv na navodila naravnega jezika, s čimer utira pot za razvoj veščin, kot sta sklepanje vizualnega znanja in vizualni pogovor med drugim.

- Nazadnje je pomembno omeniti, da je BLIP-2 vsestranski pristop, ki lahko izkoristi bolj izpopolnjene unimodalne modele za nadaljnje izboljšanje učinkovitosti predhodnega usposabljanja jezika vida.

Kje izvedeti več o tej raziskavi?

Kje lahko dobite kodo za izvajanje?

Uradna izvedba BLIP-2 je na voljo na GitHub.

6. LLaMA avtorja Meta AI

Povzetek

Ekipa Meta AI trdi, da je manjše modele, ki so usposobljeni za več žetonov, lažje prekvalificirati in natančno prilagoditi za posebne aplikacije izdelkov. Zato uvajajo Klici (Ldenar Lajezik Model Meta AI), zbirka temeljnih jezikovnih modelov s parametri od 7B do 65B. LLaMA 33B in 65B sta bila usposobljena na 1.4 bilijona žetonov, medtem ko je bil najmanjši model, LLaMA 7B, usposobljen na enem bilijonu žetonov. Uporabljali so izključno javno dostopne nize podatkov, ne glede na lastniške ali omejene podatke. Ekipa je uvedla tudi ključne arhitekturne izboljšave in tehnike optimizacije hitrosti usposabljanja. Posledično je LLaMA-13B prekašal GPT-3, saj je bil več kot 10-krat manjši, LLaMA-65B pa je pokazal konkurenčno zmogljivost s PaLM-540B.

Kaj je cilj?

- Za prikaz izvedljivosti usposabljanja najbolj zmogljivih modelov izključno na javno dostopnih nizih podatkov, brez zanašanja na lastniške ali omejene vire podatkov.

- Zagotoviti raziskovalni skupnosti manjše in zmogljivejše modele in tako omogočiti tistim, ki nimajo dostopa do velikih količin infrastrukture, preučevanje velikih jezikovnih modelov.

Kako se lotiti problema?

- Za usposabljanje modela LLaMA so raziskovalci uporabili le podatke, ki so javno dostopni in so združljivi z odprtokodnostjo.

- Uvedli so tudi nekaj izboljšav standardne arhitekture Transformerja:

- S sprejetjem metodologije GPT-3 je bila stabilnost usposabljanja izboljšana z normalizacijo vnosa za vsako podplast transformatorja, namesto normalizacije izhoda.

- Po navdihu modelov PaLM so raziskovalci nadomestili nelinearnost ReLU z aktivacijsko funkcijo SwiGLU, da bi izboljšali zmogljivost.

- Navdih Su et al (2021), so odpravili absolutne pozicijske vdelave in namesto tega vključili rotacijske pozicijske vdelave (RoPE) na vsaki plasti omrežja.

- Končno je ekipa Meta AI izboljšala hitrost usposabljanja svojega modela z:

- Uporaba učinkovite implementacije vzročne pozornosti z več glavami, tako da ne shranjujete uteži pozornosti ali računate prikritih rezultatov ključev/poizvedb.

- Uporaba kontrolne točke za zmanjšanje ponovno izračunanih aktivacij med prehodom nazaj.

- Prekrivanje izračuna aktivacij in komunikacije med grafičnimi procesorji prek omrežja (zaradi operacij all_reduce).

Kakšni so rezultati?

- LLaMA-13B prekaša GPT-3, čeprav je več kot 10-krat manjši, medtem ko LLaMA-65B drži svoje proti PaLM-540B.

Kje izvedeti več o tej raziskavi?

Kje lahko dobite kodo za izvajanje?

- Meta AI omogoča dostop do LLaMA akademskim raziskovalcem, posameznikom, povezanim z vlado, civilno družbo, akademskimi institucijami in globalnimi industrijskimi raziskovalnimi laboratoriji na podlagi ocene posameznega primera. Za prijavo pojdite na naslednje GitHub repozitorij.

7. GPT-4 z OpenAI

Povzetek

GPT-4 je obsežen multimodalni model, ki sprejema slikovne in besedilne vnose ter generira besedilne izhode. Zaradi pomislekov glede konkurence in varnosti so posebne podrobnosti o arhitekturi in usposabljanju modela zadržane. Kar zadeva zmogljivost, GPT-4 presega prejšnje jezikovne modele na tradicionalnih merilih uspešnosti in kaže pomembne izboljšave pri razumevanju namena uporabnika in varnostnih lastnostih. Model dosega tudi uspešnost na človeški ravni pri različnih izpitih, vključno z najboljšim 10-odstotnim rezultatom na simuliranem enotnem pravosodnem izpitu.

Kaj je cilj?

- Razviti multimodalni model velikega obsega, ki lahko sprejme slikovne in besedilne vnose ter ustvari besedilne izhode.

- Razviti infrastrukturo in metode optimizacije, ki se obnašajo predvidljivo v širokem razponu lestvic.

Kako se lotiti problema?

- Zaradi konkurenčnega okolja in varnostnih posledic se je OpenAI odločil zamolčati podrobnosti o arhitekturi, velikosti modela, strojni opremi, računanju za usposabljanje, konstrukciji nabora podatkov in metodah usposabljanja.

- Razkrivajo, da:

- GPT-4 je model, ki temelji na transformatorju in je vnaprej usposobljen za predvidevanje naslednjega žetona v dokumentu.

- Uporablja javno dostopne podatke in podatke z licenco tretjih oseb.

- Model je bil natančno nastavljen z uporabo okrepljenega učenja iz človeških povratnih informacij (RLHF).

- Nepotrjene informacije kažejo, da GPT-4 ni en sam zgoščen model kot njegovi predhodniki, ampak močna koalicija osmih ločenih modelov, od katerih ima vsak osupljivih 220 milijard parametrov.

Kakšni so rezultati?

- GPT-4 dosega uspešnost na človeški ravni pri večini strokovnih in akademskih izpitov, zlasti med 10 % najboljših na simuliranem enotnem pravosodnem izpitu.

- Vnaprej usposobljeni osnovni model GPT-4 prekaša obstoječe jezikovne modele in predhodne najsodobnejše sisteme na tradicionalnih NLP merilih uspešnosti, brez oblikovanja, specifičnega za merilo uspešnosti, ali dodatnih protokolov za usposabljanje.

- GPT-4 dokazuje znatno izboljšanje sledenja nameni uporabnika, pri čemer imajo njegovi odgovori prednost pred odgovori GPT-3.5 v 70.2 % od 5,214 pozivov ChatGPT in API-ja OpenAI.

- Varnostne lastnosti GPT-4 so se znatno izboljšale v primerjavi z GPT-3.5, z 82-odstotnim zmanjšanjem odzivanja na zahteve po nedovoljeni vsebini in 29-odstotnim povečanjem skladnosti s pravilniki za občutljive zahteve (npr. zdravniški nasveti in samopoškodovanje).

Kje izvedeti več o tej raziskavi?

Kje lahko dobite kodo za izvajanje?

- Implementacija kode GPT-4 ni na voljo.

Realne aplikacije velikih (vizijskih) jezikovnih modelov

Najpomembnejši raziskovalni preboj umetne inteligence v zadnjih letih prihaja iz velikih modelov umetne inteligence, usposobljenih na ogromnih zbirkah podatkov. Ti modeli izkazujejo impresivno zmogljivost in fascinantno je razmišljati, kako lahko umetna inteligenca revolucionira celotne industrije, kot so storitve za stranke, trženje, e-trgovina, zdravstvo, razvoj programske opreme, novinarstvo in številne druge.

Veliki jezikovni modeli imajo številne aplikacije v realnem svetu. GPT-4 navaja naslednje:

- Razumevanje in ustvarjanje naravnega jezika za klepetalne robote in virtualne pomočnike.

- Strojno prevajanje med jeziki.

- Povzetek člankov, poročil ali drugih besedilnih dokumentov.

- Analiza razpoloženja za tržne raziskave ali spremljanje družbenih medijev.

- Generiranje vsebine za trženje, družbene medije ali kreativno pisanje.

- Sistemi za odgovore na vprašanja za podporo strankam ali baze znanja.

- Klasifikacija besedila za filtriranje neželene pošte, kategorizacijo tem ali organizacijo dokumentov.

- Prilagojena orodja za učenje jezikov in mentorstvo.

- Generiranje kode in pomoč pri razvoju programske opreme.

- Analiza medicinske, pravne in tehnične dokumentacije ter pomoč.

- Orodja za ljudi s posebnimi potrebami, kot sta pretvorba besedila v govor in govora v besedilo.

- Storitve prepoznavanja in prepisovanja govora.

Če dodamo vizualni del, se področja možnih aplikacij še razširijo:

Zelo razburljivo je spremljati nedavne dosežke umetne inteligence in razmišljati o njihovih potencialnih aplikacijah v resničnem svetu. Vendar pa moramo pred uporabo teh modelov v resničnem življenju obravnavati ustrezna tveganja in omejitve, ki so na žalost precejšnje.

Tveganja in omejitve

Če vprašate GPT-4 o njegovih tveganjih in omejitvah, vam bo verjetno ponudil dolg seznam ustreznih pomislekov. Po filtriranju tega seznama in dodajanju nekaterih dodatnih premislekov sem prišel do naslednjega niza ključnih tveganj in omejitev, ki jih imajo sodobni veliki jezikovni modeli:

- Pristranskost in diskriminacija: Ti modeli se učijo iz ogromnih količin besedilnih podatkov, ki pogosto vsebujejo pristranskost in diskriminatorno vsebino. Posledično lahko ustvarjeni rezultati nehote ohranjajo stereotipe, žaljiv jezik in diskriminacijo na podlagi dejavnikov, kot so spol, rasa ali vera.

- Dezinformacije: Veliki jezikovni modeli lahko ustvarijo vsebino, ki je dejansko napačna, zavajajoča ali zastarela. Čeprav se modeli usposabljajo na različnih virih, morda ne zagotavljajo vedno najbolj natančnih ali najnovejših informacij. Pogosto se to zgodi, ker model daje prednost ustvarjanju rezultatov, ki so slovnično pravilni ali se zdijo koherentni, tudi če so zavajajoči.

- Pomanjkanje razumevanja: Čeprav se zdi, da ti modeli razumejo človeški jezik, delujejo predvsem z ugotavljanjem vzorcev in statističnih povezav v podatkih o usposabljanju. Nimajo globokega razumevanja vsebine, ki jo ustvarjajo, kar lahko včasih povzroči nesmiselne ali nepomembne rezultate.

- Neprimerna vsebina: Jezikovni modeli lahko včasih ustvarijo vsebino, ki je žaljiva, škodljiva ali neprimerna. Čeprav si prizadevamo čim bolj zmanjšati takšno vsebino, se lahko še vedno pojavi zaradi narave podatkov o usposabljanju in nezmožnosti modelov, da bi razbrali kontekst ali namen uporabnika.

zaključek

Veliki jezikovni modeli so nedvomno spremenili področje obdelave naravnega jezika in pokazali ogromen potencial pri povečevanju produktivnosti v različnih vlogah in panogah. Zaradi njihove zmožnosti ustvarjanja besedila, podobnega človeku, avtomatizacije vsakdanjih opravil in zagotavljanja pomoči pri ustvarjalnih in analitičnih procesih, so postali nepogrešljivo orodje v današnjem hitrem svetu, ki ga poganja tehnologija.

Vendar pa je ključnega pomena priznati in razumeti omejitve in tveganja, povezana s temi zmogljivimi modeli. Težav, kot so pristranskost, napačne informacije in možnost zlonamerne uporabe, ni mogoče prezreti. Ker še naprej integriramo te tehnologije, ki jih poganja umetna inteligenca, v naše vsakdanje življenje, je nujno najti ravnovesje med izkoriščanjem njihovih zmogljivosti in zagotavljanjem človeškega nadzora, zlasti v občutljivih situacijah in situacijah z visokim tveganjem.

Če nam bo uspelo odgovorno sprejeti generativne tehnologije umetne inteligence, bomo utrli pot v prihodnost, v kateri bosta umetna inteligenca in človeško strokovno znanje sodelovala pri spodbujanju inovacij in ustvarjanju boljšega sveta za vse.

Uživate v tem članku? Prijavite se za več posodobitev raziskav AI.

Obvestili vas bomo, ko bomo objavili več povzetkov, kot je ta.

Podobni

- Distribucija vsebine in PR s pomočjo SEO. Okrepite se še danes.

- PlatoData.Network Vertical Generative Ai. Opolnomočite se. Dostopite tukaj.

- PlatoAiStream. Web3 Intelligence. Razširjeno znanje. Dostopite tukaj.

- PlatoESG. Avtomobili/EV, Ogljik, CleanTech, Energija, Okolje, sončna energija, Ravnanje z odpadki. Dostopite tukaj.

- BlockOffsets. Posodobitev okoljskega offset lastništva. Dostopite tukaj.

- vir: https://www.topbots.com/top-language-models-transforming-ai-in-2023/

- :ima

- : je

- :ne

- :kje

- $GOR

- 1

- 10

- 12b

- 16

- 2%

- 2017

- 2021

- 2023

- 214

- 220

- 28

- 32

- 50

- 7

- 70

- 710

- 72

- 8

- 84

- 90

- a

- sposobnost

- Sposobna

- O meni

- nad

- absolutna

- akademsko

- Sprejmi

- Sprejema

- dostop

- dostopen

- prilagoditi

- Po

- natančnost

- natančna

- doseže

- Dosega

- doseganju

- potrditi

- čez

- Aktiviranje

- aktivacije

- aktov

- prilagodijo

- prilagoditev

- dodajte

- dodajanje

- Poleg tega

- Dodatne

- Naslov

- naslovi

- Sprejem

- napredek

- nasveti

- po

- proti

- Agent

- AI

- ai raziskave

- Cilje

- AL

- podobno

- vsi

- omogočajo

- Dovoli

- omogoča

- skupaj

- Prav tako

- alternativa

- Čeprav

- vedno

- sredi

- med

- znesek

- zneski

- an

- Analiza

- Analitično

- in

- Še ena

- odgovor

- kaj

- API

- zdi

- aplikacije

- Uporabi

- pristop

- primerno

- približno

- architectural

- Arhitektura

- SE

- območja

- okoli

- Array

- Umetnost

- članek

- članki

- umetni

- Umetna inteligenca

- AS

- pomoč

- pomočniki

- povezan

- združenja

- At

- pozornosti

- Avtorji

- avtomatizirati

- Na voljo

- povprečno

- izogniti

- Nagrada

- Ravnovesje

- bar

- baza

- temeljijo

- Osnovni

- Osnova

- BE

- ker

- postanejo

- pred

- počutje

- spodaj

- merilo

- meril

- Prednosti

- Boljše

- med

- pristranskosti

- pristranskosti

- Billion

- knjige

- Bootstrap

- tako

- Meje

- preboj

- preboji

- MOST

- široka

- izgradnjo

- Building

- zgrajena

- vendar

- by

- se imenuje

- CAN

- Kandidat

- ne more

- Zmogljivosti

- lahko

- kapaciteta

- previdni

- primeru

- katastrofalno

- Vzrok

- ceo

- CEO in ustanovitelj

- izziv

- priložnost

- spremenite

- klepetalnice

- ChatGPT

- čipi

- trdijo

- Razvrstitev

- Cloud

- So-ustanovitelj

- Koda

- KOHERENTNO

- zbirka

- kombinacija

- kombinacije

- kako

- Zaveza

- Komunikacija

- skupnost

- v primerjavi z letom

- združljiv

- konkurenčno

- dopolnilni

- kompleksna

- skladnost

- deli

- računanje

- Izračunajte

- računalnik

- računalništvo

- idejni

- Skrbi

- konfiguracija

- POTRJENO

- Povezovanje

- Posledično

- premislekov

- Gradbeništvo

- vsebina

- ozadje

- kontekstih

- naprej

- kontrast

- Pogovor

- pogovorov

- Pretvorba

- popravi

- Ustrezno

- strošek

- stroški

- bi

- ustvarjajo

- ustvaril

- Creative

- verodostojno

- ključnega pomena

- Trenutna

- stranka

- Za stranke

- Pomoč strankam

- vrhunsko

- vsak dan

- datum

- podatkovne točke

- nabor podatkov

- Datum

- odločil

- zmanjša

- globoko

- Deepmind

- daje

- izkazati

- Dokazano

- dokazuje,

- dokazuje

- Predstavitve

- Odvisno

- uvajanja

- zasnovan

- Kljub

- Podrobnosti

- Razvoj

- Razvijalci

- razvoju

- Razvoj

- Dialog

- Dialog

- težko

- invalidnosti

- Razkrije

- Diskriminacija

- razlikovati

- razne

- do

- dokument

- Dokumenti

- ne

- Prevlada

- dont

- ducata

- pogon

- poimenovan

- 2

- med

- e

- e-trgovina

- E&T

- vsak

- Zgodnje

- lažje

- izobraževalne

- učinek

- učinkovito

- učinkovitosti

- učinkovite

- prizadevanja

- odpraviti

- pojavile

- omogočajo

- omogočanje

- obsežno

- angažiran

- Angleščina

- okrepi

- okrepljeno

- izboljšave

- izboljšanje

- zagotoviti

- bistvena

- vzpostaviti

- vzpostavlja

- etično

- ocenili

- Ocena

- vrednotenja

- Tudi

- Tudi vsak

- vse

- dokazi

- razvija

- Pregled

- Primer

- Primeri

- presega

- izjemno

- zanimivo

- ekskluzivno

- eksponati

- obstoječih

- Razširi

- Poskusi

- strokovno znanje

- Raziskovati

- zunanja

- f1

- olajšati

- dejavniki

- Padec

- družina

- daleč

- zanimivo

- hitro tempu

- Feature

- izrazit

- Lastnosti

- povratne informacije

- Nekaj

- manj

- Polje

- Slika

- filtriranje

- Najdi

- prva

- fiksna

- Všita

- sledi

- po

- za

- Obrazci

- Temelji

- Ustanovitelj

- Okvirni

- iz

- zamrznjena

- funkcija

- temeljna

- v osnovi

- nadalje

- Prihodnost

- pridobljeno

- vrzel

- Spol

- ustvarjajo

- ustvarila

- ustvarja

- ustvarjajo

- generacija

- generativno

- Generativna AI

- generator

- dobili

- GitHub

- Pogled

- Globalno

- Go

- Cilj

- dogaja

- dobro

- Googlova

- vlada

- Grafične kartice

- razred

- prelomni

- skupina

- imel

- se zgodi

- Trdi

- strojna oprema

- škodljiva

- Imajo

- ob

- zdravstveno varstvo

- tukaj

- visoka kvaliteta

- visoka ločljivost

- visoko tveganje

- več

- najvišja

- drži

- Kako

- Vendar

- HTML

- HTTPS

- velika

- človeškega

- Stotine

- hype

- Uglaševanje hiperparametrov

- Ideja

- identifikacijo

- if

- slika

- slike

- neizmerno

- Izvajanje

- izvajali

- posledice

- Pomembno

- Impresivno

- izboljšanje

- izboljšalo

- Izboljšanje

- Izboljšave

- in

- Poglobljena

- nezmožnost

- vključujejo

- vključeno

- Vključno

- Vključena

- vključuje

- vključujoč

- Povečajte

- povečal

- narašča

- vedno

- individualna

- posamezniki

- industrij

- Industrija

- Podatki

- Infrastruktura

- Iniciatorji

- Inovacije

- vhod

- vhodi

- Namesto

- Institucije

- Navodila

- integrirati

- Intelligence

- namen

- Zanimivo

- v

- uvesti

- Uvedeno

- Izmišljeno

- vprašanje

- Vprašanja

- IT

- ITS

- sam

- novinarstvo

- jpg

- samo

- Ključne

- ključni cilji

- Vedite

- znanje

- Labs

- Pomanjkanje

- Pokrajina

- jezik

- jeziki

- velika

- obsežne

- Največji

- Zadnji

- plast

- plasti

- vodi

- UČITE

- učenje

- Pravne informacije

- manj

- Stopnja

- ravni

- Vzvod

- Leverages

- vzvod

- Licencirano

- življenje

- lahek

- kot

- Verjeten

- omejitve

- Seznam

- seznami

- živi

- Llama

- lokalno

- logično

- Long

- Poglej

- Sklop

- nizka

- Stroji

- je

- Znamka

- IZDELA

- več

- Marcus

- Tržna

- tržna raziskava

- Trženje

- Material

- math

- max širine

- največja

- Maj ..

- smiselna

- mediji

- medicinski

- Spoji

- Meta

- Metodologija

- Metode

- Microsoft

- moti

- minimalna

- Dezinformacije

- zavajajoče

- napake

- mešano

- ML

- Model

- modeli

- sodobna

- spremembe

- spremljanje

- več

- Najbolj

- veliko

- več

- Muslimani

- naravna

- Naravni jezik

- Obdelava Natural Language

- Narava

- Nimate

- potrebna

- mreža

- Nevronski

- Nevronski jezik

- nevronska mreža

- Novo

- novice

- Naslednja

- lepo

- nlp

- predvsem

- nič

- Številka

- številne

- Cilj

- Cilji

- pojavijo

- of

- žaljive

- Uradni

- pogosto

- on

- ONE

- tiste

- samo

- odprite

- open source

- OpenAI

- deluje

- operacije

- optimizacija

- or

- Organizacija

- Ostalo

- drugi

- naši

- ven

- več kot uspešen

- Presega

- izhod

- Neporavnani

- več

- lastne

- dlani

- Papir

- paradigma

- parameter

- parametri

- del

- sodelovanje

- zlasti

- mimo

- vzorci

- tlakovati

- Tlakovanje

- za

- opravlja

- performance

- izvajati

- opravlja

- stavki

- kramp

- platon

- Platonova podatkovna inteligenca

- PlatoData

- Stroki

- Točka

- točke

- politike

- mogoče

- potencial

- poganja

- močan

- napovedati

- prednostno

- prejšnja

- v prvi vrsti

- Predhodna

- določanje prednosti

- problem

- Težave

- Postopek

- Procesi

- obravnavati

- proizvodnjo

- Izdelek

- produktivnost

- strokovni

- Programiranje

- programskih jezikov

- Napredek

- obetaven

- Lastnosti

- predlaga

- lastniško

- protokoli

- zagotavljajo

- če

- zagotavlja

- javno

- objavljeno

- namene

- Potiskanje

- Python

- pitorha

- kvalitativno

- kakovost

- vprašanje

- vprašanja

- hitro

- Dirka

- območje

- hitro

- precej

- reading

- pravo

- resnično življenje

- resnični svet

- nedavno

- Pred kratkim

- Priznanje

- priznajo

- zmanjša

- zmanjšanje

- režimi

- okrepljeno učenje

- sprostitev

- sprosti

- pomembno

- zanesljiv

- zanesljivih virov

- religija

- zanašanje

- ostajajo

- ostalo

- izjemno

- nadomesti

- Poročila

- zastopanje

- zahteva

- zahteva

- zahteva

- Raziskave

- raziskovalna skupnost

- raziskovalci

- virov intenzivno

- spoštovanje

- odziva

- Odgovor

- odgovorov

- omejeno

- povzroči

- Rezultati

- ohrani

- Mnenja

- revolucijo

- revolucionirala

- tveganja

- rivalstvo

- robusten

- vloge

- soba

- varna

- Varnost

- prodajni center

- Enako

- Lestvica

- luske

- skaliranje

- scenariji

- prizori

- <span style="color: #f7f7f7;">Šola</span>

- rezultat

- rezultati

- točkovanje

- brez težav

- drugi

- zdi se

- videl

- izbran

- občutljiva

- ločena

- Serija

- resno

- Storitev

- Storitve

- nastavite

- nastavitev

- več

- šokirana

- Kratke Hlače

- Prikaži

- je pokazala,

- Razstave

- podpisati

- pomemben

- bistveno

- podobno

- ednina

- situacije

- Velikosti

- spretnosti

- manj

- So

- doslej

- socialna

- družbeni mediji

- Društvo

- Software

- Razvoj programske opreme

- Izključno

- Rešitev

- Rešuje

- nekaj

- prefinjeno

- vir

- Viri

- Sourcing

- spam

- specifična

- posebej

- specifičnosti

- spektakularen

- govor v besedilo

- hitrost

- Stabilnost

- Stage

- postopka

- standardna

- standardi

- Država

- state-of-the-art

- Statistično

- Statistika

- Še vedno

- Strategija

- prednosti

- stavke

- študija

- precejšen

- uspeh

- taka

- predlagajte

- Predlaga

- POVZETEK

- superior

- nadzor

- podpora

- presegli

- sistem

- sistemi

- pogovori

- Naloga

- Naloge

- skupina

- tehnični

- tehnike

- Tehnologije

- Pogoji

- Test

- tvorjenje besedila

- Besedilo v govor

- kot

- hvala

- da

- O

- Prihodnost

- Država

- svet

- njihove

- Njih

- POTEM

- Tukaj.

- s tem

- zato

- te

- jih

- mislim

- tretjih oseb

- ta

- tisti,

- čeprav?

- tisoče

- 3

- skozi

- krat

- do

- današnje

- skupaj

- žeton

- Tokenizacija

- Boni

- tudi

- orodja

- vrh

- TOPBOTI

- temo

- Teme

- proti

- tradicionalna

- Vlak

- usposobljeni

- usposabljanje

- prenos

- transformator

- preoblikovanje

- prevod

- Bilijona

- turing

- tutorstvo

- dva

- brezpogojno

- pod

- razumeli

- razumevanje

- zavezujeta

- nedvomno

- na žalost

- Vesolje

- za razliko od

- up-to-date

- posodobitve

- uporaba

- Rabljeni

- uporabnik

- uporablja

- uporabo

- izkorišča

- raznolikost

- različnih

- Popravljeno

- vsestranski

- zelo

- Video

- Video posnetki

- Virtual

- Vizija

- VOX

- je

- način..

- we

- web

- Dobro

- so bili

- Kaj

- kdaj

- ki

- medtem

- WHO

- celoti

- široka

- Širok spekter

- Wikipedia

- bo

- z

- v

- brez

- besede

- delo

- delati skupaj

- svet

- pisanje

- let

- še

- jo

- zefirnet

- Zero-Shot Učenje