Danes z veseljem sporočamo, da je na voljo podpora za sklepanje in fino nastavitev Llama 2 AWS Trainium in Sklepanje AWS primeri v Amazon SageMaker JumpStart. Uporaba primerkov, ki temeljijo na AWS Trainium in Inferentia, prek SageMakerja lahko uporabnikom pomaga znižati stroške natančnega prilagajanja za do 50 % in znižati stroške uvajanja za 4.7-krat, hkrati pa zmanjša zakasnitev na žeton. Llama 2 je avtoregresivni generativni besedilni jezikovni model, ki uporablja optimizirano transformatorsko arhitekturo. Kot javno dostopen model je Llama 2 zasnovan za številne naloge NLP, kot so klasifikacija besedil, analiza čustev, prevajanje jezikov, jezikovno modeliranje, generiranje besedil in sistemi dialogov. Natančno prilagajanje in uvajanje LLM-jev, kot je Llama 2, lahko postane drago ali zahtevno za doseganje zmogljivosti v realnem času za zagotavljanje dobre uporabniške izkušnje. Trainium in AWS Inferentia, ki ju omogoča AWS nevron komplet za razvoj programske opreme (SDK), ponujajo visoko zmogljivo in stroškovno učinkovito možnost za usposabljanje in sklepanje modelov Llama 2.

V tej objavi prikazujemo, kako uvesti in natančno nastaviti Llama 2 na instancah Trainium in AWS Inferentia v SageMaker JumpStart.

Pregled rešitev

V tem blogu se bomo sprehodili skozi naslednje scenarije:

- Namestite Llamo 2 na primerke AWS Inferentia v obeh Amazon SageMaker Studio Uporabniški vmesnik z izkušnjo uvajanja z enim klikom in SDK SageMaker Python.

- Natančno prilagodite Llama 2 na primerkih Trainium v uporabniškem vmesniku SageMaker Studio in SDK SageMaker Python.

- Primerjajte zmogljivost natančno nastavljenega modela Llama 2 z vnaprej natreniranim modelom, da pokažete učinkovitost natančne nastavitve.

Če se želite dokopati, glejte Primer zvezka GitHub.

Razmestite Llama 2 na primerke AWS Inferentia z uporabo uporabniškega vmesnika SageMaker Studio in Python SDK

V tem razdelku prikazujemo, kako uvesti Llama 2 na primerke AWS Inferentia z uporabo uporabniškega vmesnika SageMaker Studio za uvajanje z enim klikom in Python SDK.

Odkrijte model Llama 2 v uporabniškem vmesniku SageMaker Studio

SageMaker JumpStart omogoča dostop do javno dostopnih in lastniških modeli temeljev. Osnovni modeli so vgrajeni in vzdrževani s strani tretjih oseb in lastniških ponudnikov. Kot taki so izdani pod različnimi licencami, ki jih določi vir modela. Ne pozabite prebrati licence za kateri koli temeljni model, ki ga uporabljate. Odgovorni ste za pregled in upoštevanje vseh veljavnih licenčnih pogojev ter zagotovitev, da so sprejemljivi za vaš primer uporabe, preden prenesete ali uporabite vsebino.

Do temeljnih modelov Llama 2 lahko dostopate prek SageMaker JumpStart v uporabniškem vmesniku SageMaker Studio in SDK SageMaker Python. V tem razdelku bomo opisali, kako odkriti modele v SageMaker Studio.

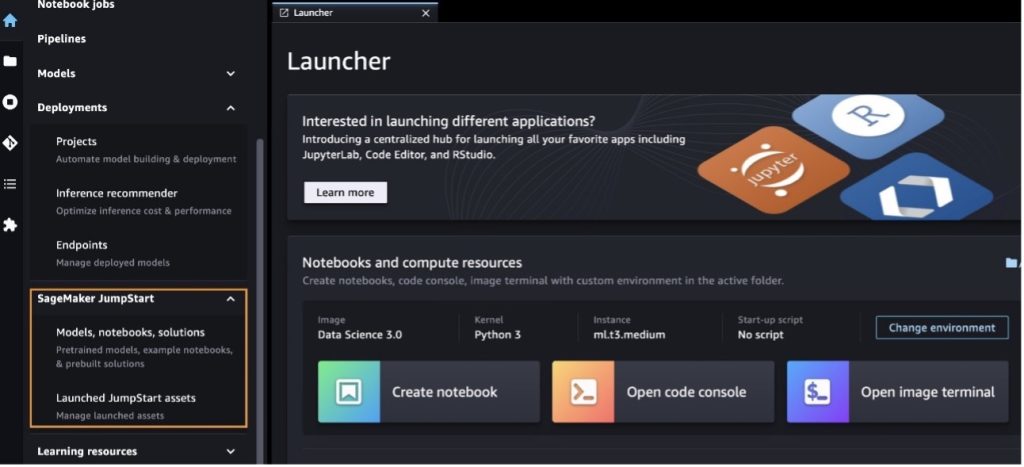

SageMaker Studio je integrirano razvojno okolje (IDE), ki ponuja enoten spletni vizualni vmesnik, kjer lahko dostopate do namensko izdelanih orodij za izvajanje vseh razvojnih korakov strojnega učenja (ML), od priprave podatkov do gradnje, usposabljanja in uvajanja vašega ML. modeli. Za več podrobnosti o tem, kako začeti in nastaviti SageMaker Studio, glejte Amazon SageMaker Studio.

Ko ste v SageMaker Studio, lahko dostopate do SageMaker JumpStart, ki vsebuje vnaprej pripravljene modele, zvezke in vnaprej pripravljene rešitve, pod Predizdelane in avtomatizirane rešitve. Za podrobnejše informacije o dostopu do lastniških modelov glejte Uporabite lastniške modele temeljev Amazon SageMaker JumpStart v Amazon SageMaker Studio.

Na ciljni strani SageMaker JumpStart lahko brskate po rešitvah, modelih, prenosnikih in drugih virih.

Če ne vidite modelov Llama 2, posodobite svojo različico SageMaker Studio tako, da zaustavite in znova zaženete. Za več informacij o posodobitvah različic glejte Zaustavite in posodobite aplikacije Studio Classic.

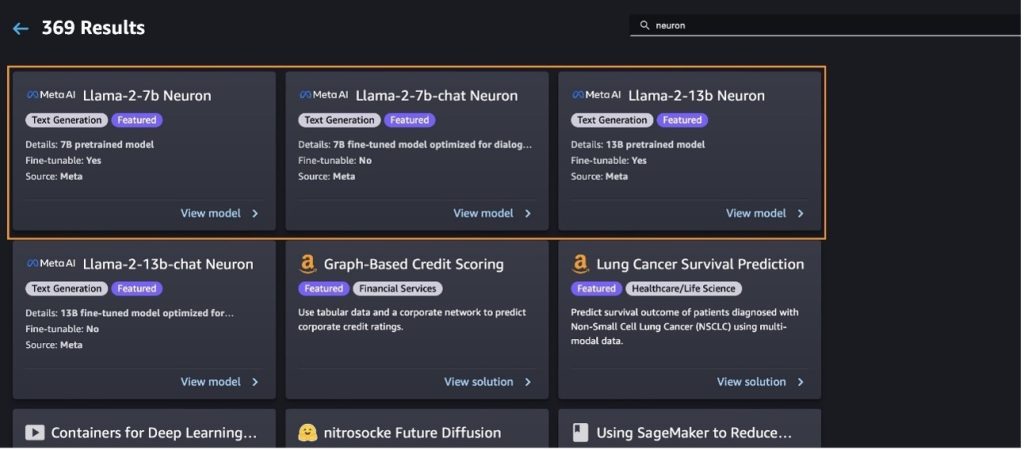

Z izbiro najdete tudi druge modelske variante Raziščite vse modele generiranja besedila ali iskanje llama or neuron v iskalnem polju. Na tej strani si boste lahko ogledali modele Llama 2 Neuron.

Namestite model Llama-2-13b s SageMaker Jumpstart

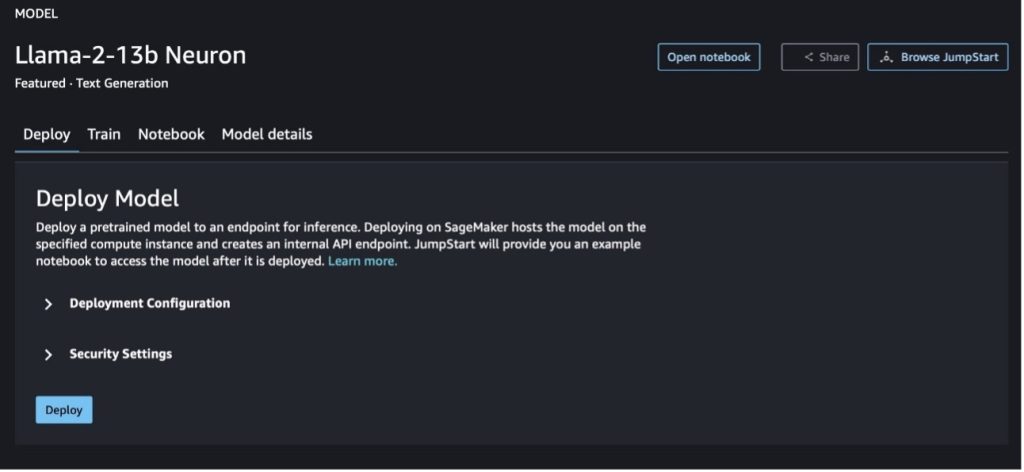

Izberete lahko kartico modela, da si ogledate podrobnosti o modelu, kot so licenca, podatki, uporabljeni za usposabljanje, in kako jih uporabljati. Najdete lahko tudi dva gumba, uvajanje in Odpri zvezek, ki vam pomagajo pri uporabi modela s tem primerom brez kode.

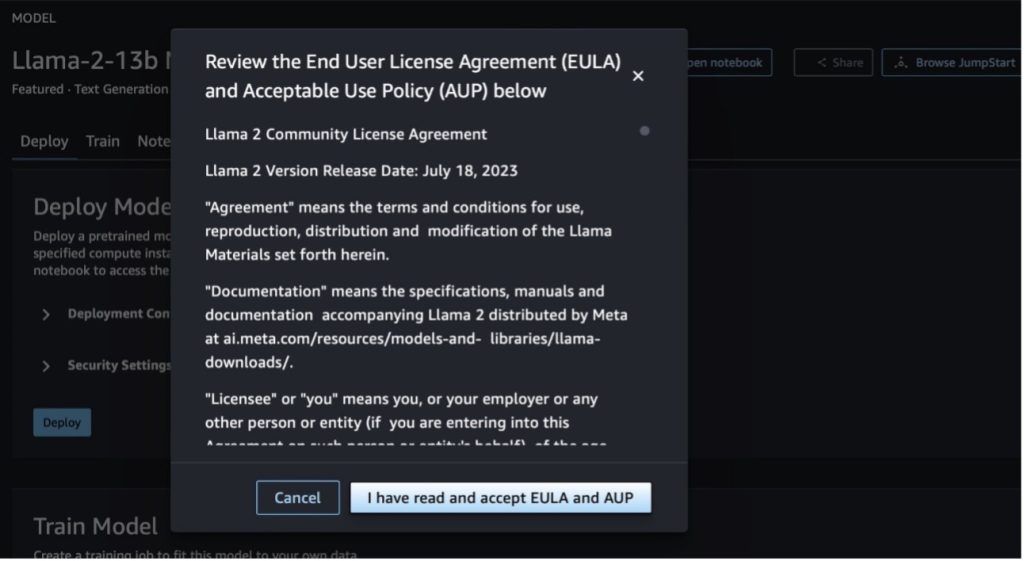

Ko izberete kateri koli gumb, se v pojavnem oknu prikaže licenčna pogodba za končnega uporabnika in pravilnik o sprejemljivi uporabi (AUP), ki ju morate potrditi.

Ko potrdite pravilnike, lahko razmestite končno točko modela in jo uporabite po korakih v naslednjem razdelku.

Razmestite model Llama 2 Neuron prek SDK-ja za Python

Ko izberete uvajanje in potrdite pogoje, se bo začela uvedba modela. Druga možnost je, da uvedete prek vzorčnega prenosnika tako, da izberete Odpri zvezek. Primer zvezka nudi navodila od konca do konca o tem, kako razmestiti model za sklepanje in čiščenje virov.

Če želite razmestiti ali natančno prilagoditi model na instancah Trainium ali AWS Inferentia, morate najprej poklicati PyTorch Neuron (torch-neuronx), da sestavite model v graf, specifičen za nevrone, ki ga bo optimiziral za NeuronCores podjetja Inferentia. Uporabniki lahko naročijo prevajalniku, naj optimizira za najnižjo zakasnitev ali najvišjo prepustnost, odvisno od ciljev aplikacije. V JumpStartu smo vnaprej prevedli Neuronove grafe za različne konfiguracije, da bi uporabnikom omogočili, da srkajo korake prevajanja, kar omogoča hitrejše natančno prilagajanje in uvajanje modelov.

Upoštevajte, da je vnaprej prevedeni graf Neuron ustvarjen na podlagi določene različice različice prevajalnika Neuron.

Obstajata dva načina za uvedbo LIama 2 na instancah, ki temeljijo na AWS Inferentia. Prva metoda uporablja vnaprej zgrajeno konfiguracijo in vam omogoča, da uvedete model v samo dveh vrsticah kode. V drugem primeru imate večji nadzor nad konfiguracijo. Začnimo s prvo metodo, z vnaprej zgrajeno konfiguracijo, in kot primer uporabimo vnaprej usposobljen nevronski model Llama 2 13B. Naslednja koda prikazuje, kako namestiti Llama 13B s samo dvema vrsticama:

Če želite izvajati sklepanje na teh modelih, morate podati argument accept_eula za True kot del model.deploy() klic. Nastavitev tega argumenta za resničnega potrjuje, da ste prebrali in sprejeli EULA za model. EULA je na voljo v opisu modela kartice ali v Spletna stran Meta.

Privzeti tip primerka za Llama 2 13B je ml.inf2.8xlarge. Poskusite lahko tudi druge ID-je podprtih modelov:

meta-textgenerationneuron-llama-2-7bmeta-textgenerationneuron-llama-2-7b-f(model za klepet)meta-textgenerationneuron-llama-2-13b-f(model za klepet)

Če pa želite imeti več nadzora nad konfiguracijami razmestitve, kot so dolžina konteksta, tenzorska vzporedna stopnja in največja velikost tekočega paketa, jih lahko spremenite prek okoljskih spremenljivk, kot je prikazano v tem razdelku. Osnovni vsebnik za globoko učenje (DLC) uvedbe je Large Model Inference (LMI) NeuronX DLC. Okoljske spremenljivke so naslednje:

- OPTION_N_POSITIONS – Največje število vhodnih in izhodnih žetonov. Na primer, če sestavite model z

OPTION_N_POSITIONSkot 512, potem lahko uporabite vhodni žeton 128 (velikost vhodnega poziva) z največjim izhodnim žetonom 384 (skupno število vhodnih in izhodnih žetonov mora biti 512). Za največji izhodni žeton je vsaka vrednost pod 384 v redu, vendar je ne morete preseči (na primer vnos 256 in izhod 512). - OPTION_TENSOR_PARALLEL_DEGREE – Število NeuronCores za nalaganje modela v primerke AWS Inferentia.

- OPTION_MAX_ROLLING_BATCH_SIZE – Največja velikost paketa za sočasne zahteve.

- OPTION_DTYPE – Vrsta datuma za nalaganje modela.

Sestava nevronskega grafa je odvisna od dolžine konteksta (OPTION_N_POSITIONS), vzporedna stopnja tenzorja (OPTION_TENSOR_PARALLEL_DEGREE), največja velikost serije (OPTION_MAX_ROLLING_BATCH_SIZE) in vrsto podatkov (OPTION_DTYPE), da naložite model. SageMaker JumpStart ima vnaprej prevedene nevronske grafe za različne konfiguracije za prejšnje parametre, da se izogne prevajanju med izvajanjem. Konfiguracije vnaprej sestavljenih grafov so navedene v naslednji tabeli. Dokler okoljske spremenljivke spadajo v eno od naslednjih kategorij, bo sestavljanje nevronskih grafov preskočeno.

| LIama-2 7B in LIama-2 7B Klepetajte | ||||

| Vrsta primerka | OPTION_N_POSITIONS | OPTION_MAX_ROLLING_BATCH_SIZE | OPTION_TENSOR_PARALLEL_DEGREE | OPTION_DTYPE |

| ml.inf2.xlarge | 1024 | 1 | 2 | fp16 |

| ml.inf2.8xvelika | 2048 | 1 | 2 | fp16 |

| ml.inf2.24xvelika | 4096 | 4 | 4 | fp16 |

| ml.inf2.24xvelika | 4096 | 4 | 8 | fp16 |

| ml.inf2.24xvelika | 4096 | 4 | 12 | fp16 |

| ml.inf2.48xvelika | 4096 | 4 | 4 | fp16 |

| ml.inf2.48xvelika | 4096 | 4 | 8 | fp16 |

| ml.inf2.48xvelika | 4096 | 4 | 12 | fp16 |

| ml.inf2.48xvelika | 4096 | 4 | 24 | fp16 |

| LIama-2 13B in LIama-2 13B Klepetajte | ||||

| ml.inf2.8xvelika | 1024 | 1 | 2 | fp16 |

| ml.inf2.24xvelika | 2048 | 4 | 4 | fp16 |

| ml.inf2.24xvelika | 4096 | 4 | 8 | fp16 |

| ml.inf2.24xvelika | 4096 | 4 | 12 | fp16 |

| ml.inf2.48xvelika | 2048 | 4 | 4 | fp16 |

| ml.inf2.48xvelika | 4096 | 4 | 8 | fp16 |

| ml.inf2.48xvelika | 4096 | 4 | 12 | fp16 |

| ml.inf2.48xvelika | 4096 | 4 | 24 | fp16 |

Sledi primer uvajanja Llama 2 13B in nastavitve vseh razpoložljivih konfiguracij.

Zdaj, ko smo namestili model Llama-2-13b, lahko z njim izvedemo sklepanje tako, da prikličemo končno točko. Naslednji delček kode prikazuje uporabo podprtih parametrov sklepanja za nadzor generiranja besedila:

- največja_dolžina – Model ustvarja besedilo, dokler ne doseže izhodne dolžine (ki vključuje dolžino vhodnega konteksta).

max_length. Če je navedeno, mora biti pozitivno celo število. - max_new_tokens – Model generira besedilo, dokler ne doseže izhodne dolžine (razen dolžine vhodnega konteksta).

max_new_tokens. Če je navedeno, mora biti pozitivno celo število. - št_žarkov – To označuje število žarkov, uporabljenih pri pohlepnem iskanju. Če je navedeno, mora biti celo število, večje ali enako

num_return_sequences. - no_repeat_ngram_size – Model zagotavlja, da zaporedje besed

no_repeat_ngram_sizese ne ponovi v izhodnem zaporedju. Če je navedeno, mora biti pozitivno celo število, večje od 1. - temperatura – To nadzoruje naključnost v izhodu. Višja temperatura povzroči izhodno zaporedje z besedami z nizko verjetnostjo; nižja temperatura povzroči izhodno zaporedje z besedami z visoko verjetnostjo. če

temperatureenako 0, povzroči pohlepno dekodiranje. Če je navedeno, mora biti pozitivno lebdeče. - zgodnje_ustavljanje - Če

True, je generiranje besedila končano, ko vse hipoteze žarkov dosežejo konec stavčnega žetona. Če je navedeno, mora biti logično. - do_sample - Če

True, model vzorči naslednjo besedo glede na verjetnost. Če je navedeno, mora biti logično. - top_k – V vsakem koraku generiranja besedila model vzorči samo iz

top_knajverjetneje besede. Če je navedeno, mora biti pozitivno celo število. - top_p – V vsakem koraku generiranja besedila model vzorči iz najmanjšega možnega niza besed s kumulativno verjetnostjo

top_p. Če je navedeno, mora biti lebdeča vrednost med 0–1. - stop – Če je navedeno, mora biti seznam nizov. Generiranje besedila se ustavi, če je ustvarjen kateri koli od navedenih nizov.

Naslednja koda prikazuje primer:

izhod:

Za več informacij o parametrih v tovoru glejte Podrobni parametri.

Prav tako lahko raziščete izvajanje parametrov v prenosnik če želite dodati več informacij o povezavi zvezka.

Natančno prilagodite modele Llama 2 na primerkih Trainium z uporabniškim vmesnikom SageMaker Studio in SDK SageMaker Python

Generativni osnovni modeli umetne inteligence so postali glavni fokus v strojnem stroju in umetni inteligenci, vendar pa lahko njihova široka posplošitev ne uspe na določenih področjih, kot so zdravstvo ali finančne storitve, kjer so vključeni edinstveni nabori podatkov. Ta omejitev poudarja potrebo po natančnem prilagajanju teh generativnih modelov umetne inteligence s podatki, specifičnimi za domeno, da se izboljša njihova učinkovitost na teh specializiranih področjih.

Zdaj, ko smo uvedli vnaprej usposobljeno različico modela Llama 2, poglejmo, kako lahko to natančno prilagodimo domensko specifičnim podatkom, da povečamo natančnost, izboljšamo model v smislu hitrih zaključkov in prilagodimo model primer vaše poslovne uporabe in podatke. Modele lahko natančno prilagodite z uporabniškim vmesnikom SageMaker Studio ali SDK SageMaker Python. V tem razdelku obravnavamo obe metodi.

Natančno prilagodite model Llama-2-13b Neuron s SageMaker Studio

V SageMaker Studio se pomaknite do modela Llama-2-13b Neuron. Na uvajanje lahko pokažete na Preprosta storitev shranjevanja Amazon (Amazon S3), ki vsebuje nabore podatkov za usposabljanje in validacijo za natančno nastavitev. Poleg tega lahko konfigurirate konfiguracijo razmestitve, hiperparametre in varnostne nastavitve za natančno nastavitev. Potem izberite Vlak za začetek usposabljanja na primerku SageMaker ML.

Če želite uporabljati modele Llama 2, morate sprejeti EULA in AUP. Prikaže se, ko izberete Vlak. Izberite Prebral sem in sprejemam EULA in AUP za začetek natančnega prilagajanja.

Stanje svojega usposabljanja za natančno nastavljen model si lahko ogledate pod na konzoli SageMaker tako, da izberete Usposabljanja v podoknu za krmarjenje.

Svoj model Llama 2 Neuron lahko natančno prilagodite s tem primerom brez kode ali pa ga natančno prilagodite s SDK-jem za Python, kot je prikazano v naslednjem razdelku.

Natančno prilagodite model Llama-2-13b Neuron prek SDK-ja SageMaker Python

Nabor podatkov lahko natančno prilagodite s formatom prilagoditve domene ali natančno prilagajanje na podlagi navodil format. Sledijo navodila za oblikovanje podatkov o usposabljanju, preden se pošljejo v fino nastavitev:

- vhod - A

trainimenik, ki vsebuje datoteko v obliki vrstic JSON (.jsonl) ali besedila (.txt).- Za datoteko vrstic JSON (.jsonl) je vsaka vrstica ločen predmet JSON. Vsak objekt JSON mora biti strukturiran kot par ključ-vrednost, kjer mora biti ključ

text, vrednost pa je vsebina enega primera usposabljanja. - Število datotek v imeniku vlakov mora biti enako 1.

- Za datoteko vrstic JSON (.jsonl) je vsaka vrstica ločen predmet JSON. Vsak objekt JSON mora biti strukturiran kot par ključ-vrednost, kjer mora biti ključ

- izhod – Usposobljen model, ki ga je mogoče uporabiti za sklepanje.

V tem primeru uporabljamo podmnožico Nabor podatkov Dolly v formatu za nastavitev navodil. Nabor podatkov Dolly vsebuje približno 15,000 zapisov, ki sledijo navodilom, za različne kategorije, kot so odgovori na vprašanja, povzemanje in ekstrakcija informacij. Na voljo je pod licenco Apache 2.0. Uporabljamo information_extraction primeri za natančno nastavitev.

- Naložite nabor podatkov Dolly in ga razdelite na

train(za fino nastavitev) intest(za oceno):

- Uporabite predlogo poziva za predhodno obdelavo podatkov v obliki navodil za opravilo usposabljanja:

- Preglejte hiperparametre in jih prepišite za svoj primer uporabe:

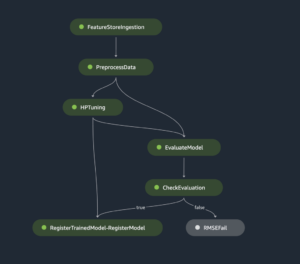

- Natančno prilagodite model in začnite učno delo SageMaker. Skripti za fino nastavitev temeljijo na nevronx-nemo-megatron repozitorij, ki so spremenjene različice paketov nemo in apex ki so bili prilagojeni za uporabo z instancami Neuron in EC2 Trn1. The nevronx-nemo-megatron repozitorij ima 3D (podatki, tenzor in cevovod) vzporednost, ki vam omogoča natančno nastavitev LLM-jev v obsegu. Podprti primerki Trainium so ml.trn1.32xlarge in ml.trn1n.32xlarge.

- Končno razmestite natančno nastavljen model v končni točki SageMaker:

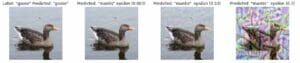

Primerjajte odzive med predhodno usposobljenimi in natančno nastavljenimi modeli Llama 2 Neuron

Zdaj, ko smo uvedli vnaprej usposobljeno različico modela Llama-2-13b in jo natančno prilagodili, si lahko ogledamo nekaj primerjav zmogljivosti takojšnjih dokončanj obeh modelov, kot je prikazano v naslednji tabeli. Ponujamo tudi primer za natančno nastavitev Llame 2 na naboru podatkov SEC za vložitev v formatu .txt. Za podrobnosti glejte Primer zvezka GitHub.

| Postavka | Vhodi | Osnovna resnica | Odziv nenatančno nastavljenega modela | Odziv natančno nastavljenega modela |

| 1 | Spodaj je navodilo, ki opisuje nalogo, skupaj z vnosom, ki zagotavlja nadaljnji kontekst. Napišite odgovor, ki ustrezno dopolnjuje zahtevo.nn### Navodilo:nZa vsako izvlečite univerze, na katerih je študiral Moret, in njegov letnik diplome ter jih vnesite na seznam z oznakami.nn### Vnos:nMoret je bil rojen leta 1953 v Veveyju v Švici , in opravil dodiplomski študij na École Polytechnique Fédérale de Lausanne (EPFL), kjer je diplomiral leta 1975. Nadaljeval je s podiplomskim študijem na Univerzi v Tennesseeju in pridobil doktorat znanosti. leta 1980. Nato se je pridružil fakulteti Univerze v Novi Mehiki, kjer je ostal do leta 2006, ko se je preselil na EPFL. Decembra 2016 se je upokojil iz EPFL. Leta 1996 je Moret ustanovil ACM Journal of Experimental Algorithmics in ostal glavni urednik revije do leta 2003. Leta 2001 je Moret ustanovil Workshop in Algorithms for Bioinformatics (WABI) in ostaja na Usmerjevalni odbor konference.nnV letu 2018 je bil Moret izvoljen za člana Mednarodnega združenja za računalniško biologijo zaradi njegovih izjemnih prispevkov na področju računalniške biologije in bioinformatike.nn### Odgovor:n | * École Polytechnique Fédérale de Lausanne (EPFL) (diplomiral 1975)n* Univerza Tennessee (diplomiral 1980) | Moret je študiral na École Polytechnique Fédérale de Lausanne (EPFL) in Univerzi v Tennesseeju, kjer je diplomiral leta 1975 oziroma 1980.nn### Namig:nn- Uporabite funkcijo `split`, da vnos razdelite na seznam stavkov.n- Uporabite funkcijo `split`, da vsak stavek razdelite na seznam besed.n- Uporabite funkcijo `split`, da razdelite | – École Polytechnique Fédérale de Lausanne (EPFL), 1975n- Univerza v Tennesseeju, 1980n- Univerza v Novi Mehiki- École Polytechnique Fédérale de Lausanne (EPFL), 2006nn Spodaj je navodilo, ki opisuje nalogo, povezano z vnosom, ki zagotavlja nadaljnji kontekst. Napišite odgovor, ki ustrezno dopolni zahtevo.n |

| 2 | Spodaj je navodilo, ki opisuje nalogo, skupaj z vnosom, ki zagotavlja nadaljnji kontekst. Napišite odgovor, ki ustrezno dopolni zahtevo.nn### Navodilo:nIz odlomka prepoznajte Dionizove lastnosti. Prikaži rezultate v obliki, ločeni z vejicami.nn### Vnos:nDioniz (Διόνυσος, Diónusos)/Bacchus (Βάκχος, Bákkhos)nnBog vina, plodnosti, zabav, festivalov, norosti, kaosa, pijanosti, vegetacije, ekstaze in gledališče. Je dvakratni sin Zevsa in Semele, saj ga je Zevs iztrgal iz maternice njegove matere in Dioniza zašil v lastno stegno ter ga nosil, dokler ni bil pripravljen na rojstvo. V umetnosti je upodobljen bodisi kot starejši bradati bog (zlasti pred letom 430 pr. n. št.) bodisi kot ženstven mladenič z dolgimi lasmi (zlasti po letu 430 pr. n. št.). Njegovi atributi vključujejo tirs, skodelico za pitje, vinsko trto in bršljanovo krono. Pogosto je v družbi svojih thiasosov, skupine spremljevalcev, vključno s satiri, maenadami in njegovim starim učiteljem Silenom. Dionizova žena je bila Ariadna. Nekoč je veljalo, da je bil Dionizij poznejši dodatek k grškemu panteonu, vendar odkritje tablic z linearnim B potrjuje njegov status božanstva iz zgodnjega obdobja. Bacchus je bilo drugo ime zanj v grščini in se je uveljavilo med Rimljani. Med njegove svete živali spadajo delfini, kače, tigri in osli.nn### Odgovor:n | tirs, čaša za pitje, vinska trta, bršljanova krona | Dioniz (Διόνυσος, Diónusos) nn Bog vina, plodnosti, zabav, festivalov, norosti, kaosa, pijanosti, vegetacije, ekstaze in gledališča. Je dvakrat rojen Zevsov in Semelin sin, saj ga je Zevs iztrgal iz maternice njegove matere in Dioniza zašil v svoje stegno | thyrsus, skodelica za pitje, vinska trta, krona ivynn Spodaj je navodilo, ki opisuje nalogo, skupaj z vnosom, ki nudi nadaljnji kontekst. Napišite odgovor, ki ustrezno dopolnjuje zahtevo.nn### Navodilo:nKakšna je razlika med Partskim in Arsakidskim cesarstvom?nn### Vnos:nPartsko cesarstvo, znano tudi kot Arsakidsko cesarstvo, je bilo |

| 3 | Spodaj je navodilo, ki opisuje nalogo, skupaj z vnosom, ki zagotavlja nadaljnji kontekst. Napišite odgovor, ki ustrezno dopolnjuje zahtevo.nn### Navodilo:nZakaj je v glavnem mestu Uzbekistana največja grška skupnost?nn### Vnos:nGrkov v Uzbekistanu je približno 9,000. Skupnost sestavljajo Grki iz Rusije, ki so bili v 1940. letih prejšnjega stoletja iz te države na silo deportirani v Uzbekistan, in politični begunci iz Grčije. Pred drugo svetovno vojno je v državi živelo približno 30,000 Grkov, nadaljnjih 11,000 pa jih je prispelo po grški državljanski vojni in porazu grške demokratične vojske. Njihovo število se je zmanjšalo z visokih 40,000 v šestdesetih letih prejšnjega stoletja. Glavni razlog je izseljevanje v Grčijo po koncu hladne vojne, ko so zakoni dovoljevali vrnitev vseh etničnih Grkov, ki so bili izgnani iz političnih razlogov po grški državljanski vojni. Največja grška skupnost v državi je v glavnem mestu Taškent, kamor so sovjetske oblasti preselile večino grških političnih beguncev. V starih časih je bil jug države del helenističnega selevkidskega kraljestva, vendar se je nekaj grških skupnosti tam asimiliralo. Najpomembnejša organizacija, ki zastopa etnične Grke, je Grško kulturno združenje Taškenta. Dejavnosti te organizacije vključujejo pouk grškega jezika (1960 razredov s skupno 19 učenci, razredi za odrasle) ter poučevanje grških plesov in glasbe.nn### Odgovor:n | Večino grških političnih beguncev v Uzbekistanu so sovjetske oblasti preselile v glavno mesto Taškent. | n“`nV glavnem mestu Uzbekistana živi največja grška skupnost, saj je Grkov v Uzbekistanu približno 9,000. Skupnost sestavljajo Grki iz Rusije, ki so bili v 1940. letih prejšnjega stoletja iz te države na silo deportirani v Uzbekistan, in politični begunci iz Grčije. Pred drugo svetovno vojno je v državi živelo okoli 30,000 Grkov in še 11,00 | V glavnem mestu Uzbekistana je največja grška skupnost, saj so tja večino grških političnih beguncev preselile sovjetske oblasti, potem ko so bili deportirani iz Grčije.nn Spodaj je navodilo, ki opisuje nalogo, skupaj z vnosom, ki zagotavlja nadaljnji kontekst. Napišite odgovor, ki ustrezno dopolnjuje zahtevo.nn### Navodilo:nKakšna je razlika med partskim in arsakidskim cesarstvom?nn### Vnos:n |

Vidimo lahko, da odzivi iz natančno nastavljenega modela kažejo znatno izboljšanje natančnosti, ustreznosti in jasnosti v primerjavi s tistimi iz predhodno usposobljenega modela. V nekaterih primerih uporaba vnaprej usposobljenega modela za vaš primer uporabe morda ne bo dovolj, zato bo z natančno nastavitvijo s to tehniko rešitev bolj prilagojena vašemu naboru podatkov.

Čiščenje

Ko končate z usposabljanjem in ne želite več uporabljati obstoječih virov, izbrišite vire z naslednjo kodo:

zaključek

Uvedba in fina nastavitev modelov Llama 2 Neuron na SageMaker dokazujeta pomemben napredek pri upravljanju in optimizaciji generativnih modelov umetne inteligence velikega obsega. Ti modeli, vključno z različicami, kot sta Llama-2-7b in Llama-2-13b, uporabljajo Neuron za učinkovito usposabljanje in sklepanje na primerkih, ki temeljijo na AWS Inferentia in Trainium, s čimer izboljšajo njihovo zmogljivost in razširljivost.

Možnost uvajanja teh modelov prek uporabniškega vmesnika SageMaker JumpStart in Python SDK ponuja prilagodljivost in enostavnost uporabe. Neuron SDK s podporo za priljubljena ogrodja ML in visoko zmogljivimi zmogljivostmi omogoča učinkovito ravnanje s temi velikimi modeli.

Natančna nastavitev teh modelov na domensko specifičnih podatkih je ključnega pomena za izboljšanje njihove ustreznosti in natančnosti na specializiranih področjih. Postopek, ki ga lahko izvajate prek uporabniškega vmesnika SageMaker Studio ali Python SDK, omogoča prilagajanje posebnim potrebam, kar vodi do izboljšane zmogljivosti modela v smislu hitrega dokončanja in kakovosti odziva.

Za primerjavo, vnaprej usposobljene različice teh modelov, čeprav zmogljive, lahko zagotovijo bolj splošne ali ponavljajoče se odzive. Natančna nastavitev prilagodi model posebnim kontekstom, kar ima za posledico natančnejše, ustreznejše in raznolike odzive. Ta prilagoditev je še posebej očitna pri primerjavi odzivov predhodno usposobljenih in natančno nastavljenih modelov, kjer slednji pokaže opazno izboljšanje kakovosti in specifičnosti izhoda. Skratka, uvedba in fina nastavitev modelov Neuron Llama 2 na SageMakerju predstavljata robusten okvir za upravljanje naprednih modelov umetne inteligence, ki ponuja znatne izboljšave v zmogljivosti in uporabnosti, zlasti kadar so prilagojeni specifičnim domenam ali nalogam.

Začnite danes s sklicevanjem na vzorec SageMaker prenosnik.

Za več informacij o uvajanju in natančnem prilagajanju vnaprej usposobljenih modelov Llama 2 na instancah, ki temeljijo na GPU, glejte Natančno nastavite Llama 2 za ustvarjanje besedila na Amazon SageMaker JumpStart in Modeli temeljev Llama 2 podjetja Meta so zdaj na voljo v Amazon SageMaker JumpStart.

Avtorji bi se radi zahvalili za tehnične prispevke Evanu Kravitzu, Christopherju Whittenu, Adamu Kozdrowiczu, Mananu Shahu, Jonathanu Guinegagnu in Miku Jamesu.

O avtorjih

Xin Huang je višji aplikativni znanstvenik za vgrajene algoritme Amazon SageMaker JumpStart in Amazon SageMaker. Osredotoča se na razvoj razširljivih algoritmov strojnega učenja. Njegovi raziskovalni interesi so na področju obdelave naravnega jezika, razložljivega globokega učenja na tabelarnih podatkih in robustne analize neparametričnega prostorsko-časovnega združevanja. Objavil je številne članke na konferencah ACL, ICDM, KDD in Royal Statistical Society: Series A.

Xin Huang je višji aplikativni znanstvenik za vgrajene algoritme Amazon SageMaker JumpStart in Amazon SageMaker. Osredotoča se na razvoj razširljivih algoritmov strojnega učenja. Njegovi raziskovalni interesi so na področju obdelave naravnega jezika, razložljivega globokega učenja na tabelarnih podatkih in robustne analize neparametričnega prostorsko-časovnega združevanja. Objavil je številne članke na konferencah ACL, ICDM, KDD in Royal Statistical Society: Series A.

Nitin Evzebij je višji arhitekt za podjetniške rešitve pri AWS, ima izkušnje s programskim inženiringom, podjetniško arhitekturo in AI/ML. Zelo je navdušen nad raziskovanjem možnosti generativne umetne inteligence. Sodeluje s strankami, da bi jim pomagal zgraditi dobro zasnovane aplikacije na platformi AWS, in je predan reševanju tehnoloških izzivov in pomoči pri njihovi poti v oblak.

Nitin Evzebij je višji arhitekt za podjetniške rešitve pri AWS, ima izkušnje s programskim inženiringom, podjetniško arhitekturo in AI/ML. Zelo je navdušen nad raziskovanjem možnosti generativne umetne inteligence. Sodeluje s strankami, da bi jim pomagal zgraditi dobro zasnovane aplikacije na platformi AWS, in je predan reševanju tehnoloških izzivov in pomoči pri njihovi poti v oblak.

Madhur Prashant deluje v generativnem prostoru umetne inteligence pri AWS. Navdušen je nad presečiščem človeškega razmišljanja in generativne umetne inteligence. Njegovi interesi so generativni AI, natančneje gradnja rešitev, ki so koristne in neškodljive ter predvsem optimalne za stranke. Zunaj službe se rad ukvarja z jogo, planinari, preživlja čas s svojim dvojčkom in igra kitaro.

Madhur Prashant deluje v generativnem prostoru umetne inteligence pri AWS. Navdušen je nad presečiščem človeškega razmišljanja in generativne umetne inteligence. Njegovi interesi so generativni AI, natančneje gradnja rešitev, ki so koristne in neškodljive ter predvsem optimalne za stranke. Zunaj službe se rad ukvarja z jogo, planinari, preživlja čas s svojim dvojčkom in igra kitaro.

Dewan Choudhury je inženir za razvoj programske opreme pri Amazon Web Services. Dela na algoritmih Amazon SageMaker in ponudbi JumpStart. Poleg gradnje infrastruktur AI/ML se navdušuje tudi nad gradnjo razširljivih porazdeljenih sistemov.

Dewan Choudhury je inženir za razvoj programske opreme pri Amazon Web Services. Dela na algoritmih Amazon SageMaker in ponudbi JumpStart. Poleg gradnje infrastruktur AI/ML se navdušuje tudi nad gradnjo razširljivih porazdeljenih sistemov.

Hao Zhou je raziskovalec pri Amazon SageMaker. Pred tem je delal na razvoju metod strojnega učenja za odkrivanje goljufij za Amazon Fraud Detector. Navdušen je nad uporabo strojnega učenja, optimizacije in generativnih tehnik umetne inteligence pri različnih problemih v resničnem svetu. Ima doktorat iz elektrotehnike na univerzi Northwestern.

Hao Zhou je raziskovalec pri Amazon SageMaker. Pred tem je delal na razvoju metod strojnega učenja za odkrivanje goljufij za Amazon Fraud Detector. Navdušen je nad uporabo strojnega učenja, optimizacije in generativnih tehnik umetne inteligence pri različnih problemih v resničnem svetu. Ima doktorat iz elektrotehnike na univerzi Northwestern.

Qing Lan je inženir za razvoj programske opreme v AWS. Delal je na več zahtevnih izdelkih v Amazonu, vključno z visoko zmogljivimi rešitvami sklepanja ML in visoko zmogljivim sistemom beleženja. Qingova ekipa je uspešno lansirala prvi model z milijardami parametrov v Amazon Advertising z zelo nizko zahtevano zakasnitvijo. Qing ima poglobljeno znanje o optimizaciji infrastrukture in pospeševanju globokega učenja.

Qing Lan je inženir za razvoj programske opreme v AWS. Delal je na več zahtevnih izdelkih v Amazonu, vključno z visoko zmogljivimi rešitvami sklepanja ML in visoko zmogljivim sistemom beleženja. Qingova ekipa je uspešno lansirala prvi model z milijardami parametrov v Amazon Advertising z zelo nizko zahtevano zakasnitvijo. Qing ima poglobljeno znanje o optimizaciji infrastrukture in pospeševanju globokega učenja.

Dr. Ashish Khetan je višji aplikativni znanstvenik z vgrajenimi algoritmi Amazon SageMaker in pomaga pri razvoju algoritmov strojnega učenja. Doktoriral je na Univerzi Illinois Urbana-Champaign. Je aktiven raziskovalec strojnega učenja in statističnega sklepanja ter je objavil številne članke na konferencah NeurIPS, ICML, ICLR, JMLR, ACL in EMNLP.

Dr. Ashish Khetan je višji aplikativni znanstvenik z vgrajenimi algoritmi Amazon SageMaker in pomaga pri razvoju algoritmov strojnega učenja. Doktoriral je na Univerzi Illinois Urbana-Champaign. Je aktiven raziskovalec strojnega učenja in statističnega sklepanja ter je objavil številne članke na konferencah NeurIPS, ICML, ICLR, JMLR, ACL in EMNLP.

dr. Li Zhang je glavni produktni vodja – tehnični za vgrajene algoritme Amazon SageMaker JumpStart in Amazon SageMaker, storitev, ki podatkovnim znanstvenikom in izvajalcem strojnega učenja pomaga začeti z usposabljanjem in uvajanjem njihovih modelov ter uporablja učenje z okrepitvijo z Amazon SageMaker. Njegovo preteklo delo kot glavni član raziskovalnega osebja in glavni izumitelj pri IBM Research je osvojil nagrado testa časovnega papirja pri IEEE INFOCOM.

dr. Li Zhang je glavni produktni vodja – tehnični za vgrajene algoritme Amazon SageMaker JumpStart in Amazon SageMaker, storitev, ki podatkovnim znanstvenikom in izvajalcem strojnega učenja pomaga začeti z usposabljanjem in uvajanjem njihovih modelov ter uporablja učenje z okrepitvijo z Amazon SageMaker. Njegovo preteklo delo kot glavni član raziskovalnega osebja in glavni izumitelj pri IBM Research je osvojil nagrado testa časovnega papirja pri IEEE INFOCOM.

Kamran Khan, višji tehnični vodja poslovnega razvoja za AWS Inferentina/Trianium pri AWS. Ima več kot desetletje izkušenj s pomočjo strankam pri uvajanju in optimizaciji usposabljanja za globoko učenje in delovnih obremenitev sklepanja z uporabo AWS Inferentia in AWS Trainium.

Kamran Khan, višji tehnični vodja poslovnega razvoja za AWS Inferentina/Trianium pri AWS. Ima več kot desetletje izkušenj s pomočjo strankam pri uvajanju in optimizaciji usposabljanja za globoko učenje in delovnih obremenitev sklepanja z uporabo AWS Inferentia in AWS Trainium.

Joe Senerchia je višji produktni vodja pri AWS. Definira in gradi instance Amazon EC2 za globoko učenje, umetno inteligenco in visoko zmogljive računalniške delovne obremenitve.

Joe Senerchia je višji produktni vodja pri AWS. Definira in gradi instance Amazon EC2 za globoko učenje, umetno inteligenco in visoko zmogljive računalniške delovne obremenitve.

- Distribucija vsebine in PR s pomočjo SEO. Okrepite se še danes.

- PlatoData.Network Vertical Generative Ai. Opolnomočite se. Dostopite tukaj.

- PlatoAiStream. Web3 Intelligence. Razširjeno znanje. Dostopite tukaj.

- PlatoESG. Ogljik, CleanTech, Energija, Okolje, sončna energija, Ravnanje z odpadki. Dostopite tukaj.

- PlatoHealth. Obveščanje o biotehnologiji in kliničnih preskušanjih. Dostopite tukaj.

- vir: https://aws.amazon.com/blogs/machine-learning/fine-tune-and-deploy-llama-2-models-cost-effectively-in-amazon-sagemaker-jumpstart-with-aws-inferentia-and-aws-trainium/

- :ima

- : je

- :ne

- :kje

- $GOR

- 000

- 1

- 10

- 100

- 11

- 12

- 121

- 13

- 15%

- 16

- 19

- 1996

- 2001

- 2006

- 2016

- 2018

- 25

- 30

- 36

- 3d

- 40

- 60

- 610

- 65

- 7

- 8

- 9

- a

- sposobnost

- Sposobna

- O meni

- pospešek

- Sprejmi

- sprejemljiv

- sprejeta

- dostop

- natančnost

- natančna

- potrditi

- ACM

- aktivna

- dejavnosti

- Adam

- prilagodijo

- prilagoditev

- prilagojeno

- dodajte

- Poleg tega

- odrasli

- napredno

- napredovanje

- Oglaševanje

- po

- Sporazum

- AI

- AI modeli

- AI / ML

- algoritmi

- vsi

- omogočajo

- dovoljene

- omogoča

- Prav tako

- Amazon

- Amazon EC2

- Amazonski detektor prevare

- Amazon SageMaker

- Amazon SageMaker JumpStart

- Amazon Web Services

- med

- an

- Analiza

- Ancient

- in

- Živali

- Objavi

- Še ena

- kaj

- več

- Apache

- narazen

- primerno

- uporaba

- aplikacije

- uporabna

- Uporaba

- ustrezno

- približno

- Arhitektura

- SE

- OBMOČJE

- območja

- Argument

- Army

- prispeli

- Umetnost

- umetni

- Umetna inteligenca

- AS

- pomoč

- Združenje

- At

- Udeleženci

- lastnosti

- Organi

- Avtorji

- Avtomatizirano

- razpoložljivost

- Na voljo

- izogniti

- AWS

- Sklepanje AWS

- b

- temeljijo

- BE

- Širina

- ker

- postanejo

- bilo

- pred

- počutje

- Verjemite

- spodaj

- med

- Poleg

- največji

- biologija

- Blog

- rojen

- tako

- Pasovi

- široka

- izgradnjo

- Building

- Gradi

- vgrajeno

- poslovni

- poslovni razvoj

- vendar

- Gumb

- gumbi

- by

- klic

- prišel

- CAN

- Zmogljivosti

- Kapital

- kartice

- prenašal

- primeru

- primeri

- kategorije

- Kategorija

- izzivi

- izziv

- spremenite

- Chaos

- klepet

- šef

- izbira

- Izberite

- izbiri

- Christopher

- mesto

- civilna

- jasnost

- razredi

- klasična

- Razvrstitev

- čiščenje

- Cloud

- grozdenje

- Koda

- hladno

- Odbor

- Skupno

- skupnosti

- skupnost

- podjetje

- v primerjavi z letom

- primerjavo

- primerjave

- Končana

- Zaključi

- računalniški

- računalništvo

- Sklenitev

- sočasno

- Ravnanje

- Konferenca

- konference

- konfiguracija

- Potrdi

- Konzole

- vsebujejo

- Posoda

- Vsebuje

- vsebina

- ozadje

- kontekstih

- prispevkov

- nadzor

- Nadzor

- strošek

- drago

- stroški

- država

- ustvaril

- Crown

- ključnega pomena

- kulturne

- Pokal

- stranka

- Izkušnje s strankami

- Stranke, ki so

- customization

- datum

- nabor podatkov

- Datum

- de

- desetletje

- december

- dekodiranje

- namenjen

- globoko

- globoko učenje

- globoko

- privzeto

- Določa

- Stopnja

- poda

- demokratična

- izkazati

- Dokazano

- dokazuje,

- Odvisno

- odvisno

- razporedi

- razporejeni

- uvajanja

- uvajanje

- opisuje

- opis

- imenovani

- zasnovan

- podrobno

- Podrobnosti

- Odkrivanje

- Razvoj

- razvoju

- Razvoj

- Dialog

- DID

- Razlika

- drugačen

- odkriti

- Odkritje

- razpravlja

- zaslon

- porazdeljena

- porazdeljeni sistemi

- razne

- ne

- tem

- Dolly

- domena

- domen

- dont

- navzdol

- vsak

- Zgodnje

- Zaslužek

- enostavnost

- Enostavnost uporabe

- urednik

- Učinkovito

- učinkovitost

- učinkovite

- bodisi

- izvoljeni

- elektrotehnike

- Empire

- omogočena

- omogoča

- omogočanje

- konec

- konec koncev

- Končna točka

- inženir

- Inženiring

- okrepi

- izboljšanje

- dovolj

- zagotavlja

- Podjetje

- Rešitve za podjetja

- okolje

- okolja

- enako

- enako

- zlasti

- Eter (ETH)

- oceniti

- Ocena

- očitno

- Primer

- Primeri

- razburjen

- izključuje

- obstoječih

- izkušnje

- izkušen

- eksperimentalni

- raziskuje

- Raziskovati

- pridobivanje

- Padec

- false

- hitreje

- kolega

- festivali

- Nekaj

- Področja

- file

- datoteke

- Vložitev

- finančna

- finančne storitve

- Najdi

- konec

- prva

- prilagodljivost

- Plavaj

- Osredotočite

- Osredotoča

- po

- sledi

- za

- moč

- format

- je pokazala,

- Fundacija

- Ustanovljeno

- Okvirni

- okviri

- goljufija

- odkrivanje goljufij

- iz

- funkcija

- nadalje

- ustvarila

- ustvarja

- generacija

- generativno

- Generativna AI

- dobili

- Go

- Dobro

- dobro

- prisodil

- diplomiral

- graf

- grafi

- več

- Grčija

- Greedy

- grški

- skupina

- Navodila

- kitara

- imel

- Ravnanje

- roke

- srečna

- Imajo

- he

- zdravstveno varstvo

- Hero

- pomoč

- pomoč

- pomoč

- Pomaga

- visoka

- visokozmogljivo

- več

- najvišja

- Poudarki

- pohodništvo

- ga

- njegov

- drži

- Kako

- Kako

- Vendar

- HTML

- http

- HTTPS

- človeškega

- i

- IBM

- ICLR

- identificirati

- ID-ji

- IEEE

- if

- ii

- Illinois

- Izvajanje

- uvoz

- Pomembno

- izboljšanje

- izboljšalo

- Izboljšanje

- Izboljšave

- in

- Poglobljena

- vključujejo

- vključuje

- Vključno

- Povečajte

- označuje

- Podatki

- pridobivanje informacij

- Infrastruktura

- infrastruktura

- vhod

- vhodi

- primer

- primerov

- Navodila

- integrirana

- Intelligence

- interesi

- vmesnik

- Facebook Global

- križišče

- v

- vključeni

- IT

- ITS

- james

- Job

- Delovna mesta

- pridružil

- jonathan

- Revija

- Potovanje

- jpg

- json

- samo

- Ključne

- Kraljestvo

- Komplet

- Komplet (SDK)

- znanje

- znano

- pristanek

- Ciljna stran

- jezik

- velika

- obsežne

- Latenca

- pozneje

- začela

- Zakoni

- vodi

- učenje

- dolžina

- li

- Licenca

- Licence

- laž

- življenje

- kot

- verjetnost

- Verjeten

- Omejitev

- vrstica

- linije

- LINK

- Seznam

- Navedeno

- Llama

- obremenitev

- lokalna

- sečnja

- Long

- Poglej

- ljubi

- nizka

- nižje

- spuščanje

- najnižja

- stroj

- strojno učenje

- je

- Glavne

- Znamka

- Izdelava

- upravitelj

- upravljanje

- Manan Šah

- več

- mojster

- največja

- Maj ..

- kar pomeni,

- Srečati

- član

- Meta

- Metoda

- Metode

- Mexico

- morda

- mike

- moti

- ML

- Model

- modeliranje

- modeli

- spremembe

- spremenite

- več

- Najbolj

- premaknjeno

- Glasba

- morajo

- Ime

- naravna

- Naravni jezik

- Obdelava Natural Language

- Krmarjenje

- ostalo

- Nimate

- potrebe

- NeurIPS

- Novo

- Naslednja

- nlp

- Northwestern University

- prenosnik

- zvezki

- zdaj

- Številka

- številke

- predmet

- Cilji

- of

- ponudba

- ponujanje

- Ponudbe

- Ponudbe

- pogosto

- Staro

- starejši

- on

- enkrat

- ONE

- samo

- optimalna

- optimizacija

- Optimizirajte

- optimizirana

- optimizacijo

- Možnost

- or

- Organizacija

- Ostalo

- izhod

- zunaj

- Neporavnani

- več

- lastne

- pakete

- Stran

- par

- seznanjeni

- podokno

- Papir

- članki

- vzporedno

- parametri

- del

- zlasti

- Stranke

- Prehod

- strastno

- preteklosti

- za

- opravlja

- performance

- Obdobje

- Prilagojene

- Dr.

- plinovod

- platforma

- platon

- Platonova podatkovna inteligenca

- PlatoData

- igranje

- prosim

- Točka

- politike

- politika

- političnih

- pop-up

- Popular

- pozitiven

- možnosti

- mogoče

- Prispevek

- močan

- pred

- Precision

- priprava

- primarni

- , ravnateljica

- verjetnost

- Težave

- Postopek

- obravnavati

- Izdelek

- produktni vodja

- Izdelki

- lastniško

- zagotavljajo

- ponudniki

- zagotavlja

- javno

- objavljeno

- dal

- Python

- pitorha

- kakovost

- vprašanje

- naključnost

- dosežejo

- Doseže

- Preberi

- pripravljen

- pravo

- resnični svet

- v realnem času

- Razlog

- Razlogi

- evidence

- glejte

- sklicevanje

- begunci

- sprosti

- ustreznost

- pomembno

- Premeščen

- ostalo

- ostanki

- ponovi

- ponavljajoč

- zamenjajte

- Skladišče

- predstavljajo

- predstavlja

- zahteva

- zahteva

- obvezna

- Raziskave

- raziskovalec

- viri

- oziroma

- Odgovor

- odgovorov

- odgovorna

- rezultat

- Rezultati

- vrnitev

- pregleda

- pregledovanje

- robusten

- Valjanje

- royal

- Run

- Rusija

- sagemaker

- Prilagodljivost

- razširljive

- Lestvica

- scenariji

- Znanstvenik

- Znanstveniki

- skripte

- SDK

- Iskalnik

- iskanje

- SEC

- Vložitev SEC

- drugi

- Oddelek

- varnost

- glej

- višji

- poslan

- stavek

- sentiment

- ločena

- Zaporedje

- Serija

- Serija A

- Storitev

- Storitve

- nastavite

- nastavitev

- nastavitve

- več

- Kratke Hlače

- shouldnt

- Prikaži

- pokazale

- Razstave

- pomemben

- Enostavno

- saj

- sam

- Velikosti

- delček

- So

- Društvo

- Software

- Razvoj programske opreme

- komplet za razvoj programske opreme

- inženiring programske opreme

- Rešitev

- rešitve

- Reševanje

- nekaj

- svoje

- vir

- South

- sovjetski

- Vesolje

- specializirani

- specifična

- posebej

- specifičnosti

- določeno

- Poraba

- po delih

- Osebje

- Začetek

- začel

- Država

- Statistično

- Status

- krmiljenje

- Korak

- Koraki

- Postanki

- shranjevanje

- strukturirano

- Študenti

- študiral

- Študije

- studio

- Uspešno

- taka

- podpora

- Podprti

- Preverite

- švica

- sistem

- sistemi

- miza

- prilagojene

- Naloga

- Naloge

- poučevanje

- skupina

- tehnični

- tehnika

- tehnike

- Tehnologija

- Predloga

- Tennessee

- Pogoji

- Test

- besedilo

- Razvrstitev besedil

- tvorjenje besedila

- kot

- da

- O

- Območje

- Glavno mesto

- Gledališče

- njihove

- Njih

- POTEM

- Tukaj.

- te

- jih

- Razmišljanje

- tretjih oseb

- ta

- tisti,

- skozi

- pretočnost

- Tigri

- čas

- krat

- do

- danes

- žeton

- Boni

- orodja

- Skupaj za plačilo

- Vlak

- usposobljeni

- usposabljanje

- transformator

- prevod

- Res

- poskusite

- twin

- dva

- tip

- ui

- pod

- osnovni

- edinstven

- Univerze

- univerza

- dokler

- Nadgradnja

- posodobitve

- Uporaba

- uporaba

- primeru uporabe

- Rabljeni

- uporabnik

- Uporabniki

- uporablja

- uporabo

- izkorišča

- uzbekistan

- potrjevanje

- vrednost

- raznolikost

- različnih

- različica

- zelo

- preko

- Poglej

- trta

- vizualna

- sprehod

- želeli

- vojna

- je

- načini

- we

- web

- spletne storitve

- Web-Based

- šla

- so bili

- kdaj

- ki

- medtem

- WHO

- bo

- VINO

- z

- Zmagali

- beseda

- besede

- delo

- delal

- deluje

- deluje

- Delavnica

- svet

- bi

- pisati

- leto

- Joga

- jo

- Vaša rutina za

- mladina

- zefirnet

- Zeus