07 февраля 2023 г. (

Новости Наноуэрк) Большие языковые модели, такие как GPT-3 OpenAI, представляют собой массивные нейронные сети, которые могут генерировать текст, похожий на человеческий, от стихов до программного кода. Эти модели машинного обучения, обученные с использованием большого количества интернет-данных, берут небольшой фрагмент входного текста, а затем прогнозируют текст, который, скорее всего, будет следующим. Но это еще не все, на что способны эти модели. Исследователи изучают любопытный феномен, известный как контекстное обучение, при котором большая языковая модель учится выполнять задачу, просмотрев всего несколько примеров — несмотря на то, что она не была обучена для этой задачи. Например, кто-то может передать модели несколько примеров предложений и их настроения (положительные или отрицательные), а затем подсказать новое предложение, и модель сможет дать правильное мнение. Обычно такую модель машинного обучения, как GPT-3, необходимо переобучить с использованием новых данных для этой новой задачи. В ходе процесса обучения модель обновляет свои параметры по мере обработки новой информации для изучения задачи. Но при контекстном обучении параметры модели не обновляются, поэтому создается впечатление, что модель изучает новую задачу, вообще ничего не изучая. Ученые из Массачусетского технологического института, Google Research и Стэнфордского университета стремятся разгадать эту тайну. Они изучали модели, очень похожие на модели больших языков, чтобы увидеть, как они могут обучаться без обновления параметров. Теоретические результаты исследователей показывают, что эти массивные модели нейронных сетей способны содержать в себе более мелкие и простые линейные модели. Затем большая модель может реализовать простой алгоритм обучения для обучения этой меньшей линейной модели выполнению новой задачи, используя только информацию, уже содержащуюся в более крупной модели. Его параметры остаются фиксированными. Это исследование является важным шагом на пути к пониманию механизмов контекстного обучения и открывает двери для дальнейшего изучения алгоритмов обучения, которые могут реализовать эти большие модели, говорит Экин Акюрек, аспирант компьютерных наук и ведущий автор статьи (

“What learning algorithm is in-context learning? Investigations with linear models”), исследуя это явление. Благодаря лучшему пониманию контекстного обучения исследователи смогут позволить моделям выполнять новые задачи без необходимости дорогостоящего переобучения. «Обычно, если вы хотите точно настроить эти модели, вам необходимо собрать данные по конкретной предметной области и выполнить некоторые сложные инженерные работы. Но теперь мы можем просто ввести в него пять примеров, и он выполнит то, что мы хотим. Так что контекстное обучение — довольно захватывающее явление», — говорит Акюрек. В работе над статьей к Акюреку присоединяются Дейл Шурманс, научный сотрудник Google Brain и профессор компьютерных наук в Университете Альберты; а также старшие авторы Джейкоб Андреас, доцент X-консорциума факультета электротехники и информатики Массачусетского технологического института и член Лаборатории компьютерных наук и искусственного интеллекта Массачусетского технологического института (CSAIL); Тенгю Ма, доцент кафедры информатики и статистики в Стэнфорде; и Дэнни Чжоу, главный научный сотрудник и директор по исследованиям Google Brain. Исследование будет представлено на Международной конференции по обучению представлений.

Модель внутри модели

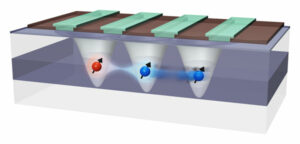

По словам Акюрека, в исследовательском сообществе машинного обучения многие ученые пришли к выводу, что большие языковые модели могут выполнять контекстное обучение благодаря тому, как они обучаются. Например, GPT-3 имеет сотни миллиардов параметров и был обучен путем чтения огромных объемов текста в Интернете, от статей в Википедии до сообщений на Reddit. Таким образом, когда кто-то показывает примеры моделей новой задачи, он, вероятно, уже видел что-то очень похожее, поскольку его набор обучающих данных включал текст с миллиардов веб-сайтов. Он повторяет шаблоны, которые видел во время обучения, вместо того, чтобы учиться выполнять новые задачи. Акюрек предположил, что обучающиеся в контексте не просто сопоставляют ранее замеченные шаблоны, но вместо этого фактически учатся выполнять новые задачи. Он и другие экспериментировали, давая этим моделям подсказки с использованием синтетических данных, которых они раньше нигде не видели, и обнаружили, что модели все еще могут учиться всего на нескольких примерах. Акюрек и его коллеги подумали, что, возможно, эти модели нейронных сетей содержат внутри себя более мелкие модели машинного обучения, которые модели могут обучить для выполнения новой задачи. «Это могло бы объяснить почти все явления обучения, которые мы наблюдали на этих больших моделях», — говорит он. Чтобы проверить эту гипотезу, исследователи использовали модель нейронной сети, называемую трансформатором, которая имеет ту же архитектуру, что и GPT-3, но была специально обучена для контекстного обучения. Исследуя архитектуру этого преобразователя, они теоретически доказали, что он может создавать линейную модель внутри своих скрытых состояний. Нейронная сеть состоит из множества слоев взаимосвязанных узлов, которые обрабатывают данные. Скрытые состояния — это слои между входным и выходным слоями. Их математические оценки показывают, что эта линейная модель записана где-то на самых ранних уровнях преобразователя. Затем преобразователь может обновить линейную модель, реализовав простые алгоритмы обучения. По сути, модель имитирует и обучает уменьшенную версию самой себя.

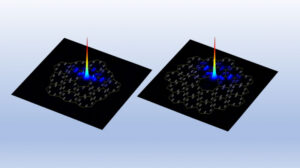

Проверка скрытых слоев

Исследователи исследовали эту гипотезу с помощью пробных экспериментов, в ходе которых они заглядывали в скрытые слои трансформатора, чтобы попытаться восстановить определенное количество. «В этом случае мы попытались восстановить фактическое решение линейной модели и смогли показать, что параметр записан в скрытых состояниях. Это означает, что линейная модель где-то здесь», — говорит он. Основываясь на этой теоретической работе, исследователи могут позволить преобразователю выполнять контекстное обучение, добавив всего два слоя в нейронную сеть. Прежде чем это станет возможным, еще предстоит проработать множество технических деталей, предупреждает Акюрек, но это может помочь инженерам создавать модели, способные выполнять новые задачи без необходимости переобучения на новых данных. В дальнейшем Акюрек планирует продолжить изучение контекстного обучения с использованием более сложных функций, чем линейные модели, которые они изучали в этой работе. Они также могли бы применить эти эксперименты к большим языковым моделям, чтобы увидеть, описывается ли их поведение простыми алгоритмами обучения. Кроме того, он хочет глубже изучить типы предтренировочных данных, которые могут обеспечить контекстное обучение. «Благодаря этой работе люди теперь могут визуализировать, как эти модели могут учиться на примерах. Поэтому я надеюсь, что это изменит взгляды некоторых людей на контекстное обучение», — говорит Акюрек. «Эти модели не так глупы, как думают люди. Они не просто запоминают эти задания. Они могут изучать новые задачи, и мы показали, как это можно сделать».

- SEO-контент и PR-распределение. Получите усиление сегодня.

- Платоблокчейн. Интеллект метавселенной Web3. Расширение знаний. Доступ здесь.

- Источник: https://www.nanowerk.com/news2/robotics/newsid=62325.php