Изображение по автору

В этом посте мы рассмотрим новую современную модель с открытым исходным кодом под названием Mixtral 8x7b. Мы также узнаем, как получить к нему доступ с помощью библиотеки LLaMA C++ и как запускать большие языковые модели с меньшими вычислительными ресурсами и объемом памяти.

Микстрал 8х7б представляет собой высококачественную модель разреженной смеси экспертов (SMoE) с открытыми весами, созданную Mistral AI. Он распространяется под лицензией Apache 2.0 и превосходит Llama 2 70B в большинстве тестов, обеспечивая при этом в 6 раз более быстрый вывод. Mixtral соответствует или превосходит GPT3.5 по большинству стандартных тестов и является лучшей моделью с открытым весом по соотношению цена/производительность.

Изображение из Микстрал экспертов

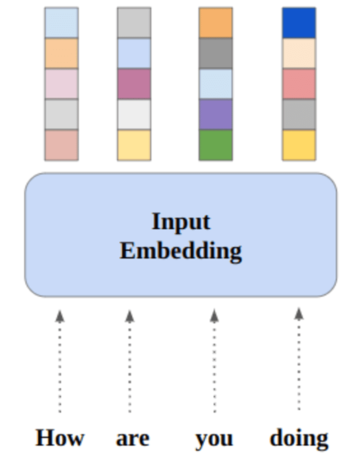

Mixtral 8x7B использует разреженную сеть экспертов, состоящую только из декодеров. Это включает в себя блок прямой связи, выбирающий из 8 групп параметров, при этом сеть маршрутизаторов выбирает две из этих групп для каждого токена, аддитивно объединяя их выходные данные. Этот метод увеличивает количество параметров модели, одновременно управляя затратами и задержкой, что делает ее такой же эффективной, как модель 12.9B, несмотря на то, что общее количество параметров составляет 46.7B.

Модель Mixtral 8x7B превосходно справляется с широким контекстом 32 тысяч токенов и поддерживает несколько языков, включая английский, французский, итальянский, немецкий и испанский. Он демонстрирует высокую производительность при генерации кода и может быть доработан до модели следования инструкциям, получая высокие оценки в таких тестах, как MT-Bench.

LLaMA.cpp — это библиотека C/C++, которая обеспечивает высокопроизводительный интерфейс для больших языковых моделей (LLM) на основе архитектуры LLM Facebook. Это легкая и эффективная библиотека, которую можно использовать для решения различных задач, включая генерацию текста, перевод и ответы на вопросы. LLaMA.cpp поддерживает широкий спектр LLM, включая LLaMA, LLaMA 2, Falcon, Alpaca, Mistral 7B, Mixtral 8x7B и GPT4ALL. Он совместим со всеми операционными системами и может работать как на процессорах, так и на графических процессорах.

В этом разделе мы будем запускать веб-приложение llama.cpp в Colab. Написав несколько строк кода, вы сможете ощутить производительность новой современной модели на своем ПК или в Google Colab.

Первые шаги

Сначала мы загрузим репозиторий llama.cpp GitHub, используя командную строку ниже:

!git clone --depth 1 https://github.com/ggerganov/llama.cpp.gitПосле этого мы перейдем в репозиторий и установим llama.cpp с помощью команды make. Мы устанавливаем llama.cpp для графического процессора NVidia с установленным CUDA.

%cd llama.cpp

!make LLAMA_CUBLAS=1Скачать модель

Мы можем загрузить модель из Hugging Face Hub, выбрав соответствующую версию файла модели `.gguf`. Более подробную информацию о различных версиях можно найти в TheBloke/Mixtral-8x7B-Instruct-v0.1-GGUF.

Изображение из TheBloke/Mixtral-8x7B-Instruct-v0.1-GGUF

Вы можете использовать команду wget для загрузки модели в текущий каталог.

!wget https://huggingface.co/TheBloke/Mixtral-8x7B-Instruct-v0.1-GGUF/resolve/main/mixtral-8x7b-instruct-v0.1.Q2_K.ggufВнешний адрес для сервера LLaMA

Когда мы запустим сервер LLaMA, он предоставит нам IP-адрес локального хоста, который для нас бесполезен в Colab. Нам нужно подключение к прокси-серверу localhost с помощью порта прокси-сервера ядра Colab.

После запуска приведенного ниже кода вы получите глобальную гиперссылку. Мы будем использовать эту ссылку для доступа к нашему веб-приложению позже.

from google.colab.output import eval_js

print(eval_js("google.colab.kernel.proxyPort(6589)"))

https://8fx1nbkv1c8-496ff2e9c6d22116-6589-colab.googleusercontent.com/Запуск сервера

Чтобы запустить сервер LLaMA C++, вам необходимо предоставить команде сервера расположение файла модели и правильный номер порта. Важно убедиться, что номер порта соответствует тому, который мы инициировали на предыдущем шаге для порта прокси.

%cd /content/llama.cpp

!./server -m mixtral-8x7b-instruct-v0.1.Q2_K.gguf -ngl 27 -c 2048 --port 6589

Доступ к веб-приложению чата можно получить, щелкнув гиперссылку прокси-порта на предыдущем шаге, поскольку сервер не работает локально.

Веб-приложение LLaMA C++

Прежде чем мы начнем использовать чат-бота, нам необходимо его настроить. Замените «LLaMA» на название вашей модели в разделе подсказок. Кроме того, измените имя пользователя и имя бота, чтобы различать сгенерированные ответы.

Начните общение, прокрутив вниз и набрав текст в разделе чата. Не стесняйтесь задавать технические вопросы, на которые другие модели с открытым исходным кодом не смогли ответить должным образом.

Если у вас возникли проблемы с приложением, вы можете попробовать запустить его самостоятельно с помощью моего Google Colab: https://colab.research.google.com/drive/1gQ1lpSH-BhbKN-DdBmq5r8-8Rw8q1p9r?usp=sharing

В этом руководстве представлено подробное руководство по запуску расширенной модели с открытым исходным кодом Mixtral 8x7b в Google Colab с использованием библиотеки LLaMA C++. По сравнению с другими моделями Mixtral 8x7b обеспечивает превосходную производительность и эффективность, что делает его отличным решением для тех, кто хочет экспериментировать с большими языковыми моделями, но не обладает обширными вычислительными ресурсами. Вы можете легко запустить его на своем ноутбуке или на бесплатном облачном компьютере. Он удобен для пользователя, и вы даже можете развернуть свое приложение чата, чтобы другие могли его использовать и экспериментировать.

Надеюсь, это простое решение для запуска большой модели оказалось для вас полезным. Я всегда ищу простые и лучшие варианты. Если у вас есть еще лучшее решение, дайте мне знать, и я расскажу о нем в следующий раз.

Абид Али Аван (@ 1abidaliawan) — сертифицированный специалист по анализу данных, который любит создавать модели машинного обучения. В настоящее время он занимается созданием контента и ведением технических блогов по технологиям машинного обучения и обработки данных. Абид имеет степень магистра в области управления технологиями и степень бакалавра в области телекоммуникаций. Его видение состоит в том, чтобы создать продукт искусственного интеллекта с использованием графовой нейронной сети для студентов, борющихся с психическими заболеваниями.

- SEO-контент и PR-распределение. Получите усиление сегодня.

- PlatoData.Network Вертикальный генеративный ИИ. Расширьте возможности себя. Доступ здесь.

- ПлатонАйСтрим. Интеллект Web3. Расширение знаний. Доступ здесь.

- ПлатонЭСГ. Углерод, чистые технологии, Энергия, Окружающая среда, Солнечная, Управление отходами. Доступ здесь.

- ПлатонЗдоровье. Биотехнологии и клинические исследования. Доступ здесь.

- Источник: https://www.kdnuggets.com/running-mixtral-8x7b-on-google-colab-for-free?utm_source=rss&utm_medium=rss&utm_campaign=running-mixtral-8x7b-on-google-colab-for-free

- :является

- :нет

- 1

- 12

- 27

- 46

- 7

- 8

- a

- в состоянии

- доступ

- Доступ

- достижение

- Дополнительно

- адрес

- продвинутый

- AI

- Все

- причислены

- всегда

- am

- an

- и

- ответ

- апаш

- приложение

- Применение

- соответствующий

- архитектура

- МЫ

- AS

- спросить

- основанный

- BE

- начинать

- ниже

- тесты

- ЛУЧШЕЕ

- Лучшая

- между

- Заблокировать

- блоги

- Бот

- изоферменты печени

- строить

- Строительство

- но

- by

- C + +

- под названием

- CAN

- Сертифицированные

- изменение

- чат

- Chatbot

- в чате

- Выбирая

- облако

- код

- комбинируя

- сравненный

- совместим

- комплексный

- вычислительный

- Вычисление

- вычисление

- связи

- содержание

- контентного создание

- контекст

- исправить

- Цена

- чехол для варгана

- создали

- создание

- Текущий

- В настоящее время

- настроить

- данным

- наука о данных

- ученый данных

- Степень

- обеспечивает

- демонстрирует

- развертывание

- Несмотря на

- выделить

- do

- вниз

- скачать

- каждый

- легко

- затрат

- эффективный

- столкновение

- Проект и

- Английский

- Усиливает

- Даже

- отлично

- опыт

- эксперимент

- эксперты

- Больше

- обширный

- Face

- что его цель

- Oшибка

- сокол

- быстрее

- чувствовать

- несколько

- Файл

- фокусировка

- Что касается

- найденный

- Бесплатно

- Французский

- от

- функция

- генерируется

- поколение

- Немецкий

- получить

- GitHub

- Дайте

- Глобальный

- GPU / ГРАФИЧЕСКИЙ ПРОЦЕССОР

- Графические процессоры

- график

- Графическая нейронная сеть

- Группы

- инструкция

- Управляемость

- Есть

- имеющий

- he

- полезный

- High

- высокая производительность

- высококачественный

- его

- имеет

- надежды

- Как

- How To

- HTTPS

- хаб

- i

- if

- болезнь

- Импортировать

- важную

- in

- В том числе

- информация

- начатый

- устанавливать

- Установка

- Интерфейс

- в

- включает в себя

- IP

- вопросы

- IT

- Итальянский

- КДнаггетс

- Знать

- язык

- Языки

- портативный компьютер

- большой

- Задержка

- новее

- УЧИТЬСЯ

- изучение

- позволять

- Библиотека

- Лицензирована

- легкий

- такое как

- линия

- линий

- LINK

- Лама

- в местном масштабе

- расположение

- искать

- любит

- машина

- обучение с помощью машины

- сделать

- Создание

- управление

- управления

- мастер

- спички

- me

- Память

- психический

- Психические заболевания

- метод

- смесь

- модель

- Модели

- изменять

- БОЛЕЕ

- самых

- с разными

- my

- имя

- Необходимость

- сеть

- нервный

- нейронной сети

- Новые

- следующий

- номер

- Nvidia

- of

- on

- ONE

- открытый

- с открытым исходным кодом

- операционный

- операционные системы

- Опции

- or

- Другое

- Другое

- наши

- Превосходит

- выходной

- выходы

- собственный

- параметр

- параметры

- PC

- производительность

- Платон

- Платон Интеллектуальные данные

- ПлатонДанные

- пожалуйста

- После

- предыдущий

- Продукт

- профессиональный

- должным образом

- обеспечивать

- приводит

- полномочие

- вопрос

- Вопросы

- ассортимент

- Цена снижена

- по

- замещать

- хранилище

- исследованиям

- Полезные ресурсы

- ответы

- маршрутизатор

- Run

- Бег

- s

- Наука

- Ученый

- множество

- прокрутки

- Раздел

- выбор

- сервер

- просто

- с

- Решение

- Источник

- Испанский

- стандарт

- современное состояние

- Шаг

- сильный

- Борющийся

- Студенты

- топ

- Поддержка

- Убедитесь

- системы

- задачи

- Технический

- технологии

- Технологии

- телекоммуникация

- текст

- генерация текста

- который

- Ассоциация

- их

- Эти

- этой

- те

- время

- в

- знак

- Лексемы

- Всего

- Переводы

- стараться

- учебник

- два

- под

- us

- использование

- используемый

- Информация о пользователе

- удобно

- использования

- через

- разнообразие

- различный

- версия

- видение

- хотеть

- we

- Web

- веб приложение

- который

- в то время как

- КТО

- широкий

- Широкий диапазон

- будете

- письмо

- являетесь

- ВАШЕ

- зефирнет