Суреш — технологический руководитель с глубокими техническими знаниями в области полупроводников, искусственного интеллекта, кибербезопасности, Интернета вещей, аппаратного обеспечения, программного обеспечения и т. д. Он проработал в отрасли 20 лет, в последнее время занимал должность исполнительного директора по нулевым технологиям с открытым исходным кодом. доверял разработку чипов Институту технологических инноваций в Абу-Даби и другим полупроводниковым компаниям из списка Fortune 500, таким как Intel, Qualcomm и MediaTek, на различных руководящих должностях, где он исследовал и разрабатывал высокопроизводительные, энергоэффективные, постквантовые и безопасные устройства. микрочипы/системы-на-чипе (SoC)/ускорители для рынков центров обработки данных, клиентов, смартфонов, сетей, Интернета вещей и искусственного интеллекта/ML. Он участвовал в программе Falcon LLM (занял первое место в рейтинге HuggingFace) и был ведущим архитектором специальной аппаратной платформы искусственного интеллекта (отменено – приоритеты изменились). Он имеет более 1 патентов США и публиковал/презентовал более чем 15 конференций.

Суреш — технологический руководитель с глубокими техническими знаниями в области полупроводников, искусственного интеллекта, кибербезопасности, Интернета вещей, аппаратного обеспечения, программного обеспечения и т. д. Он проработал в отрасли 20 лет, в последнее время занимал должность исполнительного директора по нулевым технологиям с открытым исходным кодом. доверял разработку чипов Институту технологических инноваций в Абу-Даби и другим полупроводниковым компаниям из списка Fortune 500, таким как Intel, Qualcomm и MediaTek, на различных руководящих должностях, где он исследовал и разрабатывал высокопроизводительные, энергоэффективные, постквантовые и безопасные устройства. микрочипы/системы-на-чипе (SoC)/ускорители для рынков центров обработки данных, клиентов, смартфонов, сетей, Интернета вещей и искусственного интеллекта/ML. Он участвовал в программе Falcon LLM (занял первое место в рейтинге HuggingFace) и был ведущим архитектором специальной аппаратной платформы искусственного интеллекта (отменено – приоритеты изменились). Он имеет более 1 патентов США и публиковал/презентовал более чем 15 конференций.

Суреш также активно занимает руководящую должность в RISC-V International, где он возглавляет группу доверенных вычислений для разработки возможностей конфиденциальных вычислений RISC-V и возглавляет группу AI/ML для разработки аппаратного ускорения RISC-V для рабочих нагрузок AI/ML, таких как Большие языковые модели Transformer, используемые в приложениях типа ChatGPT. Он также консультирует стартапы и фирмы венчурного капитала по вопросам поддержки инвестиционных решений, стратегии продукта, комплексной проверки технологий и т. д.

Он получил степень магистра делового администрирования в INSEAD, степень магистра в Институте технологий и науки Бирла Пилани, сертификат системной инженерии в Массачусетском технологическом институте, сертификат искусственного интеллекта в Стэнфорде и сертификат функциональной безопасности автомобильного транспорта от TÜV SÜD.

Расскажите нам о вашей компании

Мастишка А.И.(Mastiṣka означает «мозг» на санскрите) — компания, занимающаяся искусственным интеллектом, занимающаяся созданием компьютеров, подобных мозгу, для более эффективного запуска базовых моделей для сценариев использования генеративного ИИ в будущем.

Какие проблемы вы решаете?

Учитывая преимущества ИИ/ГенИИ, спрос на него будет только расти, как и его побочные эффекты на нашей планете. Как мы можем уменьшить или нейтрализовать побочные эффекты искусственного интеллекта на нашей планете? Улавливание углерода и ядерная энергетика движутся в правильном направлении. Но нам нужно фундаментально переосмыслить то, как мы используем ИИ, не является ли это неправильным способом выполнения тонн матричных умножений?

Наш мозг может учиться и выполнять множество задач параллельно, потребляя при этом 10 Вт и менее, но почему эти системы искусственного интеллекта потребляют десятки мегаватт для обучения моделей?

Возможно, будущее за энергоэффективными архитектурами, такими как нейроморфные архитектуры и импульсные преобразователи на основе нейронных сетей, которые наиболее близки к человеческому мозгу и могут потреблять в 100-1000 раз меньше энергии, что снижает стоимость использования ИИ, тем самым демократизируя его и сохраняя нашу планета.

Текущие проблемы, с которыми мы сталкиваемся в области ИИ, а именно: а) доступность, б) доступность, в) ценовая доступность и г) экологическая безопасность, а также некоторые рекомендации по их решению.

Если мы предвидим будущее, некоторые полезные концепции AGI будут продемонстрированы в фильме «ОНА», где персонаж «Саманта» — разговорный агент, который естественен, понимает эмоции, проявляет сочувствие, является потрясающим вторым пилотом в работе — и бежит дальше. портативных устройств в течение всего дня, то, возможно, нам придется решить перечисленные ниже проблемы прямо сейчас.

Проблема 1: Обучение LLM может стоить от 150 тысяч до 10+ миллионов долларов, и оно позволяет разрабатывать ИИ только тем, у кого более глубокие карманы. Кроме того, затраты на получение логических выводов также огромны (стоят в 10 раз больше, чем поиск в Интернете).

—> Нам необходимо повысить энергоэффективность моделей/оборудования, чтобы демократизировать ИИ на благо человечества.

Проблема 2. Использование огромных моделей искусственного интеллекта для диалоговых агентов или рекомендательных систем наносит ущерб окружающей среде с точки зрения потребления электроэнергии и охлаждения.

—> Нам необходимо повысить энергоэффективность моделей/оборудования, чтобы сохранить нашу планету для наших детей.

Проблема 3: Человеческий мозг способен выполнять несколько задач одновременно, но потребляет всего 10 Вт вместо мегаватт.

—> Возможно, нам следует быстрее создавать машины, подобные нашему мозгу, а не обычные матричные умножители.

Человечество может процветать только благодаря устойчивым инновациям, а не за счет вырубки всех лесов и кипячения океанов во имя инноваций. Мы должны защитить нашу планету ради благополучия наших детей и будущих поколений…

Какие области применения у вас самые сильные?

Обучение и анализ базовых моделей на основе трансформаторов (и будущей нейронной архитектуры), которые в 50–100 раз более энергоэффективны по сравнению с сегодняшними решениями на базе графических процессоров.

Что не дает вашим клиентам спать по ночам?

Проблемы для клиентов, которые в настоящее время используют другие продукты:

Потребление электроэнергии для обучения огромных языковых моделей зашкаливает, например, обучение LLM с 13B параметрами на 390B текстовых токенах на 200 графических процессорах в течение 7 дней стоит 151,744 XNUMX доллара (Источник: страница сервиса нового обучающего кластера HuggingFace — https://lnkd.in/g6Vc5cz3). А даже более крупные модели со 100+B параметрами стоят более 10 миллионов долларов только за обучение. Затем платите за вывод каждый раз, когда поступает новый запрос на подсказку.

Потребление воды для охлаждения, исследователи из Калифорнийского университета в Риверсайде оценили воздействие сервиса, подобного ChatGPT, на окружающую среду и говорят, что он заглатывает до 500 миллилитров воды (близко к тому, что находится в бутылке с водой емкостью 16 унций) каждый раз, когда вы спрашиваете его об этом. серия от 5 до 50 подсказок или вопросов. Диапазон варьируется в зависимости от того, где расположены его серверы и сезона. Оценка включает косвенное использование воды, которое компании не измеряют, например, для охлаждения электростанций, снабжающих центры обработки электроэнергией. (Источник: https://lnkd.in/gybcxX8C)

Проблемы для тех, кто не пользуется текущей продукцией:

Не могу позволить себе капитальные затраты на покупку оборудования

Не могу позволить себе пользоваться облачными сервисами

Не можете внедрять инновации или использовать искусственный интеллект — застряли в модели услуг, которая устраняет любые конкурентные преимущества.

Как выглядит конкурентная среда и как вы выделяетесь?

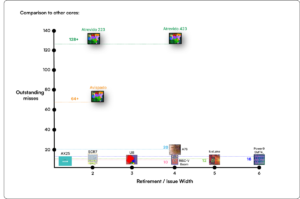

- Графические процессоры доминируют в сфере обучения, хотя специализированные ASIC также конкурируют в этом сегменте.

- У вывода Cloud & Edge слишком много доступных вариантов.

Цифровой, аналоговый, фотонный — что угодно, люди пытаются решить одну и ту же проблему.

Можете ли вы поделиться своими мыслями о текущем состоянии архитектуры микросхем для искусственного интеллекта и машинного обучения, то есть какие тенденции и возможности вы считаете наиболее важными на данный момент?

Следующие тенденции:

Тенденция 1: 10 лет назад аппаратное глубокое обучение процветало, а теперь то же самое оборудование тормозит прогресс. Из-за огромной стоимости оборудования и затрат на электроэнергию для запуска моделей стало сложно получить доступ к оборудованию. Только компании с глубокими карманами могут себе это позволить и становятся монополиями.

Тенденция 2: Теперь, когда эти модели существуют, нам нужно использовать их в практических целях, чтобы нагрузка на логические выводы увеличилась, позволяя процессорам с ускорителями искусственного интеллекта снова оказаться в центре внимания.

Тенденция 3: Стартапы пытаются придумать альтернативные представления чисел с плавающей запятой, которые традиционные форматы IEEE, такие как логарифмический и позиционный, хороши, но недостаточны. Оптимизация пространства проектирования PPA$ взрывается, когда мы пытаемся оптимизировать одно, а другое терпит неудачу.

Тенденция 4: Отрасль переходит от сервисной модели ИИ к размещению собственных частных моделей в собственных помещениях, но доступ к оборудованию является проблемой из-за нехватки поставок, санкций и т. д.

Текущее положение дел:

Доступность оборудования и данных способствовала развитию ИИ 10 лет назад, сейчас то же самое оборудование как бы сдерживает его — позвольте мне объяснить.

С тех пор, как процессоры стали работать плохо, а графические процессоры были перепрофилированы для работы с искусственным интеллектом, произошло много событий.

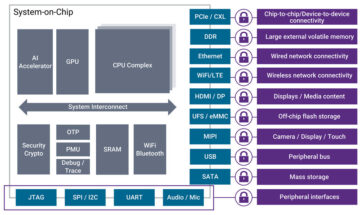

Компании обращаются к 4 сегментам AI/ML, а именно: 1) облачное обучение, 2) облачный логический вывод, 3) периферийный логический вывод и 4) периферийное обучение (федеративное обучение для приложений, чувствительных к конфиденциальности).

Цифровой и аналоговый

Сторона обучения — множество компаний, производящих графические процессоры, клиентские ускорители на базе RISC-V, чипы масштаба пластины (850 тыс. ядер) и т. д. там, где традиционных процессоров не хватает (их общее назначение). Сторона вывода: ускорители NN доступны от каждого производителя в смартфонах, ноутбуках и других периферийных устройствах.

Аналоговые архитектуры на основе мемристоров также появились некоторое время назад.

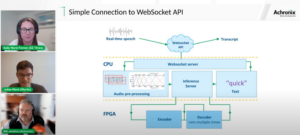

Мы считаем, что процессоры могут очень хорошо выполнять логические выводы, если мы улучшим их с помощью ускорения, например расширения матрицы.

RISC-V сторона дела:

Что касается RISC-V, мы разрабатываем ускорители для матричных операций и других нелинейных операций, чтобы устранить возможные узкие места для рабочих нагрузок трансформатора. Узкие места фон Неймана также устраняются путем создания архитектуры памяти, более близкой к вычислениям, что в конечном итоге делает процессоры с ускорением искусственного интеллекта правильным выбором для логических выводов.

Возможности:

Существуют уникальные возможности по заполнению рынка фундаментных моделей. Пример: OpenAI упоминает, что им не удалось обеспечить достаточное количество вычислительных ресурсов искусственного интеллекта (GPU), чтобы продолжать продвигать свои услуги ChatGPT… и в новостях сообщается о затратах на электроэнергию, в 10 раз превышающих затраты на обычный поиск в Интернете, и о 500 мл воды для охлаждения систем. для каждого запроса. Здесь есть рынок, который нужно заполнить — это не ниша, а весь рынок, который демократизирует ИИ, решая все проблемы, упомянутые выше — а) доступность, б) доступность, в) ценовая доступность и г) экологическая безопасность.

Над какими новыми функциями/технологиями вы работаете?

Мы строим мозг, подобный компьютеру, используя нейромодрические технологии и адаптируя модели для использования преимуществ энергоэффективного оборудования, повторно используя множество доступных открытых инфраструктур.

Каким вы видите рост или изменение сектора искусственного интеллекта и машинного обучения в ближайшие 12–18 месяцев?

Поскольку спрос на графические процессоры снизился (стоимостью около 30 тысяч долларов), а некоторые части мира столкнулись с санкциями на покупку этих графических процессоров, некоторые части мира чувствуют, что они заморожены в исследованиях и разработках в области ИИ, не имея доступа к графическим процессорам. Альтернативные аппаратные платформы собираются захватить рынок.

Модели, возможно, начнут сокращаться — кастомные модели или даже фундаментально плотность информации вырастет.

Тот же вопрос, но как насчет роста и изменений в ближайшие 3-5 лет?

а) процессоры с расширениями ИИ захватят рынок выводов ИИ

б) Модели станут гибкими, а параметры упадут по мере увеличения плотности информации с 16% до 90%.

в) Повышается энергоэффективность, сокращается выброс CO2.

г) Появляются новые архитектуры.

д) затраты на оборудование и электроэнергию снизятся, поэтому барьер входа для небольших компаний в создание и обучение моделей станет доступным.

е) люди говорят о моменте, предшествующем AGI, но я бы ориентировался на характерную Саманту (разговорный ИИ) в фильме «Она»... это, возможно, маловероятно, учитывая высокую стоимость масштабирования.

Какие проблемы могут повлиять или ограничить рост сектора искусственного интеллекта и машинного обучения?

а) Доступ к оборудованию

б) Затраты на электроэнергию, затраты на охлаждение и вред окружающей среде

Читайте также:

Интервью генерального директора: Дэвид Мур из Pragmatic

Интервью генерального директора: доктор Мегхали Чопра из Sandbox Semiconductor

Интервью генерального директора: доктор Дж. Провайн из Aligned Carbon

- SEO-контент и PR-распределение. Получите усиление сегодня.

- PlatoData.Network Вертикальный генеративный ИИ. Расширьте возможности себя. Доступ здесь.

- ПлатонАйСтрим. Интеллект Web3. Расширение знаний. Доступ здесь.

- ПлатонЭСГ. Углерод, чистые технологии, Энергия, Окружающая среда, Солнечная, Управление отходами. Доступ здесь.

- ПлатонЗдоровье. Биотехнологии и клинические исследования. Доступ здесь.

- Источник: https://semiwiki.com/ceo-interviews/338703-ceo-interview-suresh-sugumar-of-mastiska-ai/

- :имеет

- :является

- :нет

- :куда

- $UP

- 1

- 10

- 150

- 20

- 20 лет

- 200

- 50

- 500

- 7

- a

- в состоянии

- О нас

- выше

- Абу-Даби

- ускорение

- ускорители

- доступ

- доступность

- активно

- адрес

- адресованный

- адресация

- плюс

- Дела

- снова

- Агент

- агенты

- AGI

- тому назад

- AI

- AI модели

- ай исследование

- Системы искусственного интеллекта

- варианты использования ИИ

- AI / ML

- выровненный

- Все

- Позволяющий

- позволяет

- вдоль

- причислены

- альтернатива

- удивительный

- an

- и

- Другой

- любой

- откуда угодно

- Применение

- Приложения

- архитектура

- МЫ

- области

- Прибыл

- искусственный

- искусственный интеллект

- AS

- Asics

- спросить

- At

- автомобильный

- свободных мест

- доступен

- прочь

- b

- барьер

- основанный

- BE

- становиться

- становится

- становление

- было

- не являетесь

- верить

- ниже

- эталонный тест

- польза

- Преимущества

- между

- Beyond

- узкие

- связанный

- Мозг

- мозги

- строить

- Строительство

- но

- купить

- by

- Калифорния

- CAN

- отменен

- возможности

- способный

- столица

- захватить

- углерод

- улавливания углерода

- случаев

- Центры

- Генеральный директор

- Интервью с генеральным директором

- сертификат

- вызов

- проблемы

- изменение

- менялась

- изменения

- персонаж

- ChatGPT

- Дети

- чип

- чипсы

- выбор

- Чопра

- клиент

- Закрыть

- ближе

- облако

- Кластер

- co2

- как

- Компании

- Компания

- сравненный

- конкурировать

- конкурентоспособный

- Вычисление

- компьютер

- компьютеры

- вычисление

- понятия

- конференции

- потреблять

- потребление

- продолжать

- способствовало

- диалоговый

- разговорный ИИ

- Холодные

- Цена

- Расходы

- может

- Создайте

- Текущий

- Текущее состояние

- В настоящее время

- изготовленный на заказ

- клиент

- Клиенты

- резки

- Информационная безопасность

- данным

- центров обработки данных

- Datacenter

- Давид

- день

- Дней

- решение

- глубоко

- глубокое обучение

- более глубокий

- Спрос

- демократизировать

- Демократизация

- убивают

- плотность

- в зависимости

- Проект

- развивать

- развитый

- развивающийся

- Развитие

- Устройства

- -Даби

- дифференцировать

- усердие

- направление

- директор

- do

- приносит

- дело

- долларов

- Dont

- вниз

- dr

- Падение

- два

- заработанный

- Edge

- эффекты

- затрат

- эффективный

- эффективно

- электричество

- потребление электроэнергии

- ликвидировать

- ликвидирует

- эмоции

- Сопереживание

- энергетика

- энергоэффективности

- Проект и

- повышать

- достаточно

- Весь

- запись

- Окружающая среда

- окружающий

- себе

- оценка

- к XNUMX году

- и т.д

- Эфир (ETH)

- Даже

- со временем

- Каждая

- пример

- исполнительный

- Исполнительный директор

- существовать

- опыта

- Взрывается

- расширения

- Face

- всего лишь пяти граммов героина

- сокол

- быстрее

- чувствуя

- заполнять

- Компаний

- плавающий

- внимание

- Фут

- Что касается

- предвидеть

- формат

- Fortune

- Год основания

- каркасы

- от

- замороженные

- подпитывается

- функциональная

- принципиально

- будущее

- Общие

- поколения

- генеративный

- Генеративный ИИ

- данный

- Go

- идет

- будет

- хорошо

- Графические процессоры

- группы

- Рост

- Рост

- Аппаратные средства

- Есть

- he

- следовательно

- здесь

- High

- имеет

- хостинг

- Как

- HTTPS

- огромный

- ОбниматьЛицо

- человек

- Человечество

- IEEE

- if

- изображение

- Влияние

- улучшать

- улучшается

- in

- В других

- включает в себя

- Увеличение

- промышленность

- информация

- обновлять

- Инновации

- инновации

- вместо

- Институт

- Intel

- Интеллекта

- Мультиязычность

- Интернет

- Интервью

- инвестиций

- КАТО

- IT

- ЕГО

- всего

- Дети

- Вид

- Отсутствие

- пейзаж

- язык

- ноутбуки

- большой

- больше

- вести

- Наша команда

- УЧИТЬСЯ

- изучение

- позволять

- Кредитное плечо

- Используя

- такое как

- центр внимания

- ОГРАНИЧЕНИЯ

- загрузка

- расположенный

- посмотреть

- выглядит как

- ниже

- Продукция

- Создание

- ПРОИЗВОДИТЕЛЬ

- многих

- рынок

- Области применения:

- матрица

- макс-ширина

- Май..

- может быть

- MBA

- me

- смысл

- означает

- проводить измерение

- памяти

- упомянутый

- может быть

- миллиона

- миллион долларов

- MIT

- модель

- Модели

- момент

- монополии

- месяцев

- БОЛЕЕ

- самых

- кино

- перемещение

- MS

- должен

- my

- имя

- а именно

- натуральный

- Необходимость

- сетевой

- сетей

- нервный

- Новые

- Новости

- следующий

- ниша

- ночь

- ловкий

- сейчас

- ядерный

- Атомная энергия

- номер

- океаны

- of

- on

- ONE

- только

- открытый

- с открытым исходным кодом

- OpenAI

- Операционный отдел

- Возможности

- оптимизация

- Оптимизировать

- Опции

- or

- Другое

- наши

- внешний

- собственный

- страница

- Параллельные

- параметр

- параметры

- части

- Патенты

- ОПЛАТИТЬ

- Люди

- возможно

- планета

- растений

- Платформа

- Платформы

- Платон

- Платон Интеллектуальные данные

- ПлатонДанные

- полнокровие

- плюс

- карманы

- Точка

- должность

- возможное

- мощностью

- электростанции

- практическое

- Печать / PDF

- частная

- Проблема

- проблемам

- Продукт

- Продукция

- Профиль

- Прогресс

- наводящие

- для защиты

- цель

- целей

- Push

- Оферты

- Qualcomm

- вопрос

- Вопросы

- ассортимент

- вошел

- Читать

- недавно

- Рекомендация

- рекомендаций

- уменьшить

- снижение

- регулярный

- Отчеты

- запросить

- исследованиям

- исследование и разработка

- исследователи

- правую

- Прибрежный

- роли

- крыша

- Run

- Бег

- работает

- безопасный

- Сохранность

- то же

- санкции

- песочница

- Сохранить

- экономия

- сообщили

- масштабирование

- Наука

- Поиск

- Время года

- сектор

- безопасный

- посмотреть

- сегментами

- полупроводник

- Полупроводниковые приборы

- Серии

- серверы

- обслуживание

- Услуги

- выступающей

- Поделиться

- дефицит

- должен

- показал

- Шоу

- сторона

- значительный

- с

- меньше

- смартфон

- смартфоны

- So

- Software

- Решения

- Решение

- некоторые

- Источник

- Space

- специализированный

- потраченный

- Стэнфорд

- Начало

- Стартапы

- Область

- Стратегия

- сильная

- такие

- поставка

- поддержка

- комфортного

- системы

- снасти

- Tackling

- портняжное дело

- взять

- Говорить

- задачи

- Технический

- Технологии

- технологические инновации

- terms

- текст

- чем

- который

- Ассоциация

- Будущее

- информация

- мир

- их

- Их

- тогда

- Там.

- тем самым

- Эти

- они

- вещи

- этой

- те

- хоть?

- Thrive

- время

- в

- Сегодняшних

- Лексемы

- завтра

- слишком

- топ

- жеребьевка

- традиционный

- Train

- Обучение

- трансформатор

- трансформеры

- Тенденции

- надежных

- стараться

- пытается

- под

- понимает

- Университет

- Университет Калифорнии

- вряд ли

- us

- Применение

- использование

- используемый

- через

- различный

- предприятие

- венчурный капитал

- Венчурный капитал Фирмы

- очень

- из

- законопроект

- Вода

- Путь..

- we

- Web

- Благосостояние

- были

- Что

- когда

- который

- КТО

- зачем

- будете

- без

- Работа

- работает

- Мир

- бы

- Неправильно

- лет

- являетесь

- ВАШЕ

- зефирнет