Введение

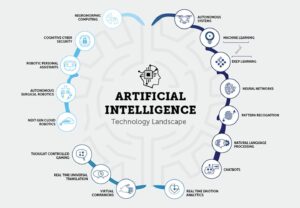

Поскольку область искусственного интеллекта (ИИ) продолжает расти и развиваться, для начинающих разработчиков ИИ становится все более важным быть в курсе последних исследований и достижений. Один из лучших способов сделать это — прочитать статьи об искусственном интеллекте для разработчиков GenAI, в которых содержится ценная информация о передовых методах и алгоритмах. В этой статье будут рассмотрены 15 основных статей по искусственному интеллекту для разработчиков GenAI. Эти статьи охватывают различные темы: от обработки естественного языка до компьютерного зрения. Они улучшат ваше понимание ИИ и повысят ваши шансы получить первую работу в этой интересной области.

Важность статей об искусственном интеллекте для разработчиков GenAI

Документы по искусственному интеллекту для разработчиков GenAI позволяют исследователям и экспертам делиться своими выводами, методологиями и открытиями с более широким сообществом. Читая эти статьи, вы получаете доступ к последним достижениям в области искусственного интеллекта, что позволяет вам оставаться на шаг впереди и принимать обоснованные решения в своей работе. Более того, документы AI для разработчиков GenAI часто содержат подробные объяснения алгоритмов и методов, давая вам более глубокое понимание того, как они работают и как их можно применять для решения реальных проблем.

Чтение статей по искусственному интеллекту для разработчиков GenAI дает начинающим разработчикам искусственного интеллекта несколько преимуществ. Во-первых, это поможет вам оставаться в курсе последних исследований и тенденций в этой области. Эти знания имеют решающее значение при подаче заявления на работу, связанную с искусственным интеллектом, поскольку работодатели часто ищут кандидатов, знакомых с самыми последними достижениями. Кроме того, чтение статей по искусственному интеллекту позволяет вам расширить свои знания и глубже понять концепции и методологии искусственного интеллекта. Эти знания можно применить к вашим проектам и исследованиям, что сделает вас более компетентным и опытным разработчиком ИИ.

Содержание

Обзор: основные документы по искусственному интеллекту для разработчиков GenAI со ссылками

Документ 1. Трансформеры: все, что вам нужно, — это внимание

Ссылка: Читать здесь

Резюме статьи

В документе представлен Transformer, новая архитектура нейронной сети для задач преобразования последовательностей, таких как машинный перевод. В отличие от традиционных моделей, основанных на рекуррентных или сверточных нейронных сетях, Трансформер полагается исключительно на механизмы внимания, устраняя необходимость повторения и извилин. Авторы утверждают, что эта архитектура обеспечивает превосходную производительность с точки зрения качества перевода, повышенной распараллеливаемости и сокращения времени обучения.

Ключевые идеи статей по искусственному интеллекту для разработчиков GenAI

- Механизм внимания

Transformer полностью построен на механизмах внимания, что позволяет ему улавливать глобальные зависимости между входными и выходными последовательностями. Этот подход позволяет модели учитывать взаимосвязи, не ограничиваясь расстоянием между элементами в последовательностях.

- Распараллеливание

Одним из основных преимуществ архитектуры Transformer является ее повышенная распараллеливаемость. Традиционные рекуррентные модели страдают от последовательных вычислений, что затрудняет распараллеливание. Конструкция Transformer обеспечивает более эффективную параллельную обработку во время обучения, сокращая время обучения.

- Превосходное качество и эффективность

В статье представлены результаты экспериментов по задачам машинного перевода, демонстрирующие, что Transformer обеспечивает превосходное качество перевода по сравнению с существующими моделями. Он значительно превосходит предыдущие результаты, включая ансамблевые модели. Кроме того, Трансформатор достигает этих результатов за значительно меньшее время обучения.

- Выполнение перевода

В задаче перевода WMT 2014 с английского на немецкий предлагаемая модель получила оценку BLEU 28.4, превзойдя существующие лучшие результаты более чем на 2 BLEU. При выполнении задания с английского на французский модель установила новый современный показатель BLEU для одной модели, равный 41.8, после обучения в течение всего 3.5 дней на восьми графических процессорах.

- Обобщение на другие задачиАвторы демонстрируют, что архитектура Transformer хорошо обобщается для задач, выходящих за рамки машинного перевода. Они успешно применили эту модель к анализу англоязычных групп, продемонстрировав ее адаптируемость к различным проблемам трансдукции последовательностей.

Документ 2: BERT: предварительная подготовка глубоких двунаправленных преобразователей для понимания языка

Ссылка: Читать здесь

Резюме статьи

Предварительное обучение языковой модели оказалось эффективным для улучшения различных задач обработки естественного языка. В документе проводится различие между подходами на основе функций и подходами тонкой настройки для применения предварительно обученных языковых представлений. BERT введен для устранения ограничений в подходах тонкой настройки, в частности, ограничения однонаправленности стандартных языковых моделей. В документе предлагается цель предварительного обучения «Модель языка в маске» (MLM), вдохновленная задачей Клоза, для обеспечения двунаправленных представлений. Задача «предсказания следующего предложения» также используется для совместной предварительной подготовки представлений текстовых пар.

Ключевые идеи статей по искусственному интеллекту для разработчиков GenAI

- Двунаправленное значение перед тренировкой

В статье подчеркивается важность двунаправленной предварительной подготовки языковых представлений. В отличие от предыдущих моделей, BERT использует замаскированные языковые модели для обеспечения глубоких двунаправленных представлений, превосходя однонаправленные языковые модели, использовавшиеся в предыдущих работах.

- Сокращение архитектур для конкретных задач

BERT демонстрирует, что предварительно обученные представления уменьшают потребность в тщательно спроектированных архитектурах для конкретных задач. Она становится первой моделью представления на основе тонкой настройки, обеспечивающей современную производительность при выполнении широкого спектра задач на уровне предложений и токенов, превосходя по производительности архитектуры для конкретных задач.

- Новейшие достижения

BERT достигает новых современных результатов в одиннадцати задачах обработки естественного языка, демонстрируя свою универсальность. Заметные улучшения включают существенное увеличение показателя GLUE, точность MultiNLI и улучшения в задачах ответа на вопросы SQuAD v1.1 и v2.0.

Вы также можете прочитать: Точная настройка BERT с помощью моделирования языка в масках

Документ 3: GPT: языковые модели мало кто изучает

Ссылка: Читать здесь

Резюме статьи

В статье обсуждаются улучшения, достигнутые в задачах обработки естественного языка (НЛП) за счет масштабирования языковых моделей с упором на GPT-3 (Generative Pre-trained Transformer 3), авторегрессионная языковая модель со 175 миллиардами параметров. Авторы подчеркивают, что хотя в последнее время модели НЛП демонстрируют существенные результаты за счет предварительного обучения и тонкой настройки, им часто требуются наборы данных для конкретных задач с тысячами примеров для точной настройки. Напротив, люди могут выполнять новые языковые задачи с помощью нескольких примеров или простых инструкций.

Ключевые идеи статей по искусственному интеллекту для разработчиков GenAI

- Увеличение масштаба повышает производительность при небольшом количестве выстрелов

Авторы демонстрируют, что масштабирование языковых моделей значительно повышает производительность, не зависящую от задачи, за несколько шагов. GPT-3 с его большим размером параметров иногда достигает конкурентоспособности благодаря современным подходам тонкой настройки без точной настройки для конкретных задач или обновлений градиента.

- Широкая применимость

GPT-3 демонстрирует высокую производительность при выполнении различных задач НЛП, включая перевод, ответы на вопросы, задачи закрытия, а также задачи, требующие оперативного рассуждения или адаптации предметной области. - Проблемы и ограничения

Хотя GPT-3 демонстрирует замечательные возможности обучения с помощью нескольких попыток, авторы определяют наборы данных, в которых он испытывает трудности, и освещают методологические проблемы, связанные с обучением на крупных веб-корпорациях. - Создание статей по-человечески

GPT-3 может генерировать новостные статьи, которые оценщикам-людям трудно отличить от статей, написанных людьми. - Социальные последствия и более широкие соображения

В документе обсуждаются более широкие социальные последствия возможностей GPT-3, особенно в области создания текста, похожего на человеческий. Последствия его работы в различных задачах рассматриваются с точки зрения практического применения и потенциальных проблем. - Ограничения существующих подходов НЛП

Авторы подчеркивают ограничения существующих подходов НЛП, в частности их зависимость от наборов данных точной настройки для конкретных задач, что создает такие проблемы, как потребность в больших размеченных наборах данных и риск переобучения для узкого распределения задач. Кроме того, возникают опасения относительно способности этих моделей к обобщению за пределами их обучающего распространения.

Документ 4: CNN: классификация ImageNet с глубокими сверточными нейронными сетями

Ссылка: Читать здесь

Резюме статьи

В документе описывается разработка и обучение большой глубокой сверточной нейронной сети (CNN) для классификации изображений в наборах данных ImageNet Large Scale Visual Recognition Challenge (ILSVRC). Модель обеспечивает значительное улучшение точности классификации по сравнению с предыдущими современными методами.

Ключевые идеи статей по искусственному интеллекту для разработчиков GenAI

- Модельная архитектура

Нейронная сеть, использованная в исследовании, представляет собой глубокую CNN с 60 миллионами параметров и 650,000 1000 нейронами. Он состоит из пяти сверточных слоев, за некоторыми следуют слои максимального пула, и трех полностью связанных слоев с окончательным softmax из XNUMX путей для классификации.

- Данные обучения

Модель обучена на обширном наборе данных, состоящем из 1.2 миллиона изображений высокого разрешения, полученных с конкурса ImageNet ILSVRC-2010. Процесс обучения включает в себя классификацию изображений по 1000 различным классам.

- Перфоманс

Модель достигает топ-1 и топ-5 коэффициентов ошибок 37.5% и 17.0% на тестовых данных соответственно. Эти коэффициенты ошибок значительно лучше, чем в предыдущем состоянии, что указывает на эффективность предлагаемого подхода.

- Улучшения в переоснащении

В документе представлено несколько методов решения проблем переобучения, в том числе ненасыщающие нейроны, эффективная реализация графического процессора для более быстрого обучения и метод регуляризации, называемый «выпадением» в полностью связанных слоях. - Вычислительная эффективность

Несмотря на вычислительные требования для обучения больших CNN, в документе отмечается, что современные графические процессоры и оптимизированные реализации позволяют обучать такие модели на изображениях с высоким разрешением.

- Публикации

В документе освещается вклад исследования, в том числе обучение одной из крупнейших сверточных нейронных сетей на наборах данных ImageNet и достижение самых современных результатов в соревнованиях ILSVRC.

Вы также можете прочитать: Комплексное руководство по изучению сверточных нейронных сетей

Документ 5: GAT: сети внимания к графам

Ссылка: Читать здесь

Резюме статьи

В документе представлена основанная на внимании архитектура для классификации узлов в данных с графовой структурой, демонстрирующая ее эффективность, универсальность и конкурентоспособность в различных тестах. Включение механизмов внимания оказывается мощным инструментом для работы с произвольно структурированными графами.

Ключевые идеи статей по искусственному интеллекту для разработчиков GenAI

- Сети внимания графов (GAT)GAT используют замаскированные слои самообслуживания для устранения ограничений предыдущих методов, основанных на свертках графов. Архитектура позволяет узлам следить за особенностями своих окрестностей, неявно задавая разные веса различным узлам, не полагаясь на дорогостоящие матричные операции или априорное знание структуры графа.

- Решение проблем, связанных со спектрами

GAT одновременно решают несколько задач в нейронных сетях на основе спектральных графов. Проблемы Graph Attention Network (GAT) включают в себя пространственно-локализованные фильтры, интенсивные вычисления и непространственно-локализованные фильтры. Кроме того, GAT зависят от собственного базиса Лапласа, что способствует их применимости для решения индуктивных и трансдуктивных задач.

- Производительность в тестах

Модели GAT достигают или соответствуют самым современным результатам в четырех установленных графовых тестах: наборах данных сети цитирования Cora, Citeseer и Pubmed, а также наборе данных межбелкового взаимодействия. Эти тесты охватывают как трансдуктивные, так и индуктивные сценарии обучения, демонстрируя универсальность GAT.

- Сравнение с предыдущими подходами

В статье представлен всесторонний обзор предыдущих подходов, включая рекурсивные нейронные сети, График нейронных сетей (GNN), спектральные и неспектральные методы и механизмы внимания. GAT включают в себя механизмы внимания, позволяющие эффективно распараллеливать пары «узел-сосед» и применять их к узлам разной степени.

- Эффективность и применимостьGAT предлагают распараллеливаемую и эффективную операцию, которую можно применять к узлам графа разной степени путем указания произвольных весов соседям. Модель напрямую применима к задачам индуктивного обучения, что делает ее подходящей для задач, где необходимо обобщать совершенно невидимые графики.

- Связь с предыдущими моделями

Авторы отмечают, что GAT можно переформулировать как конкретный экземпляр MoNet, иметь сходство с реляционными сетями и подключать к работам, в которых используются операции внимания соседей. Предлагаемая модель внимания сравнивается со связанными подходами, такими как Duan et al. (2017) и Денил и др. (2017).

Документ 6: ViT: Изображение стоит 16×16 слов: Трансформаторы для масштабного распознавания изображений

Ссылка: Читать здесь

Резюме статьи

В статье признается доминирование сверточных архитектур в компьютерном зрении, несмотря на успех архитектур Transformer в обработке естественного языка. Вдохновленные эффективностью и масштабируемостью преобразователей в НЛП, авторы применили стандартный преобразователь непосредственно к изображениям с минимальными изменениями.

Они представляют Трансформатор видения (ViT), где изображения разбиваются на патчи, а последовательность линейных вложений этих патчей служит входными данными для Трансформера. Модель обучается решению задач классификации изображений под наблюдением. Первоначально, при обучении на наборах данных среднего размера, таких как ImageNet, без сильной регуляризации, ViT достигает точности немного ниже сопоставимых ResNet.

Однако авторы показывают, что крупномасштабное обучение имеет решающее значение для успеха ViT, преодолевая ограничения, налагаемые отсутствием определенных индуктивных предубеждений. При предварительном обучении на массивных наборах данных ViT превосходит современные сверточные сети по нескольким тестам, включая ImageNet, CIFAR-100 и VTAB. В документе подчеркивается влияние масштабирования на достижение замечательных результатов с помощью архитектур Transformer в компьютерном зрении.

Ключевые идеи статей по искусственному интеллекту для разработчиков GenAI

- Трансформатор в компьютерном зрении

В статье бросается вызов преобладающему использованию сверточных нейронных сетей (CNN) для задач компьютерного зрения. Он демонстрирует, что чистый преобразователь, примененный непосредственно к последовательностям фрагментов изображений, может достичь превосходной производительности в задачах классификации изображений.

- Трансформатор видения (ViT)

Авторы представляют Vision Transformer (ViT) — модель, которая использует механизмы самообслуживания, аналогичные Трансформаторам в НЛП. ViT может достигать конкурентоспособных результатов в различных тестах распознавания изображений, включая ImageNet, CIFAR-100 и VTAB.

- Предварительное обучение и трансферное обучение

В статье подчеркивается важность предварительного обучения на больших объемах данных, аналогичного подходу в НЛП, а затем переноса изученных представлений в конкретные задачи распознавания изображений. ViT, предварительно обученный на массивных наборах данных, таких как ImageNet-21k или JFT-300M, превосходит современные сверточные сети по различным критериям.

- Вычислительная эффективностьViT достигает замечательных результатов с существенно меньшими вычислительными ресурсами во время обучения, чем современные сверточные сети. Эта эффективность особенно заметна, когда модель предварительно обучена в большом масштабе.

- Масштабирование воздействия

В документе подчеркивается важность масштабирования для достижения превосходной производительности с помощью архитектур Transformer в области компьютерного зрения. Масштабное обучение на наборах данных, содержащих от миллионов до сотен миллионов изображений, помогает ViT преодолеть отсутствие некоторых индуктивных смещений, присутствующих в CNN.

Документ 7: AlphaFold2: Высокоточная структура белка с помощью AlphaFold

Ссылка: Читать здесь

Резюме статьи

В статье «AlphaFold2: высокоточная структура белка с помощью AlphaFold» представлена AlphaFold2, модель глубокого обучения, которая точно предсказывает структуру белка. AlphaFold2 использует новую архитектуру, основанную на внимании, и совершает прорыв в сворачивании белков.

Ключевые идеи статей по искусственному интеллекту для разработчиков GenAI

- АльфаФолд2 использует глубокую нейронную сеть с механизмами внимания для прогнозирования трехмерной структуры белков на основе их аминокислотных последовательностей.

- Модель была обучена на большом наборе данных об известных белковых структурах и достигла беспрецедентной точности в 14-м соревновании по фолдингу белков по критической оценке прогнозирования структуры белка (CASP14).

- Точные предсказания AlphaFold2 потенциально могут произвести революцию в открытии лекарств, белковой инженерии и других областях биохимии.

Документ 8: GAN: генеративно-состязательные сети

Ссылка: Читать здесь

Резюме статьи

В документе рассматриваются проблемы обучения глубоких генеративных моделей и представлен инновационный подход, называемый состязательными сетями. В этой структуре генеративная и дискриминативная модели участвуют в игре, целью которой является создание образцов, неотличимых от реальных данных. Напротив, дискриминативная модель различает реальные и сгенерированные образцы. Процесс состязательного обучения приводит к уникальному решению: генеративная модель восстанавливает распределение данных.

Ключевые идеи статей по искусственному интеллекту для разработчиков GenAI

- Состязательная структура

Авторы представляют состязательную структуру, в которой одновременно обучаются две модели: генеративная модель (G), которая фиксирует распределение данных, и дискриминативная модель (D), которая оценивает вероятность того, что выборка получена на основе обучающих данных, а не генеративной модели.

- Минимаксная играПроцедура обучения предполагает максимизацию вероятности ошибки дискриминационной модели. Эта структура сформулирована как минимаксная игра для двух игроков, где генеративная модель направлена на создание выборок, неотличимых от реальных данных, а дискриминативная модель направлена на классификацию того, является ли выборка реальной или сгенерированной правильно.

- Уникальное решение

Существует единственное решение в произвольных функциях для G и D, причем G восстанавливает распределение обучающих данных, а D везде равен 1/2. Это равновесие достигается посредством состязательного процесса обучения.

- Многослойные персептроны (MLP)Авторы демонстрируют, что всю систему можно обучить с помощью обратного распространения ошибки, когда многослойные перцептроны представляют G и D. Это устраняет необходимость в цепях Маркова или развернутых сетях приближенного вывода во время обучения и генерации выборок.

- Нет приблизительного вывода

Предлагаемая структура позволяет избежать трудностей аппроксимации трудноразрешимых вероятностных вычислений при оценке максимального правдоподобия. Он также решает проблемы с использованием преимуществ кусочно-линейных единиц в генеративном контексте.

Документ 9: RoBERTa: надежно оптимизированный подход к предварительному обучению BERT

Ссылка: Читать здесь

Резюме статьи

В документе рассматривается проблема недостаточной подготовки BERT и представлена RoBERTa, оптимизированная версия, превосходящая производительность BERT. Модификации процедуры обучения RoBERTa и использование нового набора данных (CC-NEWS) способствуют получению самых современных результатов в решении множества задач обработки естественного языка. Результаты подчеркивают важность выбора дизайна и стратегий обучения для эффективности предварительного обучения языковой модели. Выпущенные ресурсы, включая модель и код RoBERTa, приносят пользу исследовательскому сообществу.

Ключевые идеи статей по искусственному интеллекту для разработчиков GenAI

- BERT Подготовка

Авторы находят, что БЕРТ, широко используемая языковая модель, была значительно недостаточно обучена. Тщательно оценив влияние настройки гиперпараметров и размера обучающего набора, они показывают, что BERT можно улучшить, чтобы он соответствовал или превосходил производительность всех моделей, опубликованных после него.

- Улучшенный рецепт тренировки (RoBERTa)

Авторы вносят изменения в процедуру обучения BERT, в результате чего получается RoBERTa. Эти изменения включают в себя удлиненные периоды обучения с более крупными пакетами, исключение цели прогнозирования следующего предложения, обучение на более длинных последовательностях и настройку шаблонов динамического маскирования для обучающих данных.

- Вклад набора данныхВ документе представлен новый набор данных под названием CC-NEWS, который по размеру сопоставим с другими наборами данных, используемыми в частном порядке. Включение этого набора данных помогает лучше контролировать влияние размера обучающего набора и способствует повышению производительности при выполнении последующих задач.

- Достижения производительности

RoBERTa с предложенными модификациями достигает самых современных результатов в различных тестовых задачах, включая GLUE, RACE и SQuAD. Он соответствует или превосходит производительность всех методов после BERT для таких задач, как MNLI, QNLI, RTE, STS-B, SQuAD и RACE.

- Конкурентоспособность предварительной подготовки модели замаскированного языка

В документе подтверждается, что цель предварительного обучения модели замаскированного языка при правильном выборе дизайна конкурентоспособна по сравнению с другими недавно предложенными целями обучения.

- Выпущенные ресурсы

Авторы выпускают свою модель RoBERTa вместе с кодом предварительной подготовки и тонкой настройки, реализованным в PyTorch, что способствует воспроизводимости и дальнейшему исследованию их результатов.

Читайте также: Нежное введение в RoBERTa

Документ 10: NeRF: представление сцен в виде полей нейронного излучения для синтеза представлений

Ссылка: Читать здесь

Резюме статьи

Оптимизация включает в себя минимизацию ошибки между наблюдаемыми изображениями с известными положениями камеры и видами, полученными из непрерывного представления сцены. В документе рассматриваются проблемы, связанные с конвергенцией и эффективностью, путем введения позиционного кодирования для обработки более высокочастотных функций и предложения иерархической процедуры выборки для уменьшения количества запросов, необходимых для адекватной выборки.

Ключевые идеи статей об искусственном интеллекте для разработчиков GenAI

- Непрерывное представление сцены

В статье представлен метод представления сложных сцен в виде 5D-полей нейронного излучения с использованием базовых сетей многослойного персептрона (MLP).

- Дифференцируемый рендеринг

Предлагаемая процедура рендеринга основана на классических методах объемного рендеринга, позволяющих оптимизировать градиент на основе стандартных изображений RGB.

- Иерархическая стратегия выборки

Введена стратегия иерархической выборки для оптимизации пропускной способности MLP в отношении областей с видимым содержимым сцены, что позволяет решить проблемы конвергенции.

- Позиционное кодированиеИспользование позиционного кодирования для отображения входных 5D-координат в многомерном пространстве позволяет успешно оптимизировать поля нейронного излучения для высокочастотного контента сцены.

Предлагаемый метод превосходит современные подходы к синтезу представлений, включая подгонку нейронных 3D-представлений и обучение глубоких сверточных сетей. В этом документе представлено непрерывное нейронное представление сцены для рендеринга фотореалистичных новых видов с высоким разрешением из изображений RGB в естественных условиях, а в дополнительном видео показаны дополнительные сравнения, чтобы подчеркнуть его эффективность в обработке сложной геометрии и внешнего вида сцены.

Документ 11: FunSearch: математические открытия в результате программного поиска с использованием больших языковых моделей.

Ссылка: Читать здесь

Резюме статьи

В документе представлен FunSearch, новый подход к использованию моделей большого языка (LLM) для решения сложных проблем, особенно в области научных открытий. Основная проблема, которую решают, - это возникновение конфабуляций (галлюцинаций) у LLM, приводящих к правдоподобным, но неверным утверждениям. FunSearch объединяет предварительно обученный LLM с систематическим оценщиком в эволюционной процедуре, позволяющей преодолеть это ограничение.

Ключевые идеи статей по искусственному интеллекту для разработчиков GenAI

- Решение проблем с помощью LLM

В статье рассматривается проблема, когда студенты LLM путают или не могут генерировать новые идеи и правильные решения сложных проблем. Он подчеркивает важность поиска новых, проверяемых правильных идей, особенно для математических и научных задач.

- Эволюционная процедура – FunSearch

FunSearch в эволюционном процессе объединяет предварительно обученного LLM с оценщиком. Он итеративно превращает программы с низкими оценками в программы с высокими оценками, обеспечивая открытие новых знаний. Этот процесс включает в себя подсказки по наилучшему варианту, разработку скелетов программ, поддержание разнообразия программ и асинхронное масштабирование.

- Приложение к экстремальной комбинаторике

В статье демонстрируется эффективность FunSearch при решении задачи о предельном множестве в экстремальной комбинаторике. FunSearch обнаруживает новые конструкции множеств с большой капитализацией, превосходящие самые известные результаты и обеспечивающие самое большое за 20 лет улучшение асимптотической нижней границы.

- Алгоритмическая задача — онлайн-упаковка контейнеров

FunSearch применяется к задаче онлайн-упаковки контейнеров, что приводит к открытию новых алгоритмов, которые превосходят традиционные в хорошо изученных интересующих распределениях. Потенциальные приложения включают улучшение алгоритмов планирования заданий.

- Программы против решенийFunSearch фокусируется на создании программ, которые описывают, как решить проблему, а не на непосредственном выводе решений. Эти программы, как правило, более интерпретируемы, облегчают взаимодействие с экспертами в предметной области и их легче развертывать, чем другие типы описаний, такие как нейронные сети.

- Междисциплинарное влияние

Методология FunSearch позволяет исследовать широкий круг проблем, что делает ее универсальным подходом с междисциплинарными приложениями. В документе подчеркивается его потенциал для совершения поддающихся проверке научных открытий с использованием LLM.

Документ 12: VAE: автоматическое кодирование вариационного Байеса

Ссылка: Читать здесь

Резюме статьи

В статье «Автоматическое кодирование вариационного Байеса» рассматривается проблема эффективного вывода и обучения в направленных вероятностных моделях с непрерывными скрытыми переменными, особенно когда апостериорные распределения трудноразрешимы и имеют дело с большими наборами данных. Авторы предлагают алгоритм стохастического вариационного вывода и обучения, который хорошо масштабируется для больших наборов данных и остается применимым даже в трудноразрешимых апостериорных распределениях.

Ключевые идеи статей по искусственному интеллекту для разработчиков GenAI

- Репараметризация вариационной нижней границы.

В статье демонстрируется перепараметризация вариационной нижней границы, приводящая к получению оценки нижней границы. Эту оценку можно оптимизировать с использованием стандартных методов стохастического градиента, что делает ее вычислительно эффективной.

- Эффективный апостериорный вывод для непрерывных скрытых переменныхАвторы предлагают алгоритм автоматического кодирования VB (AEVB) для наборов данных с непрерывными скрытыми переменными на точку данных. Этот алгоритм использует оценщик стохастического градиента вариационного Байеса (SGVB) для оптимизации модели распознавания, обеспечивая эффективный приблизительный апостериорный вывод посредством предковой выборки. Этот подход позволяет избежать дорогостоящих итеративных схем вывода, таких как цепь Маркова Монте-Карло (MCMC), для каждой точки данных.

- Теоретические преимущества и экспериментальные результаты

Теоретические преимущества предложенного метода отражены в экспериментальных результатах. В статье предполагается, что модель репараметризации и распознавания приводит к вычислительной эффективности и масштабируемости, что делает этот подход применимым к большим наборам данных и в ситуациях, когда апостериорные данные трудноразрешимы.

Читайте также: Раскрытие сущности стохастики в машинном обучении

Документ 13: ДОЛГАЯ КРАТКОСРОЧНАЯ ПАМЯТЬ

Ссылка: Читать здесь

Резюме статьи

В статье рассматривается проблема обучения хранению информации в течение продолжительных интервалов времени в рекуррентных нейронных сетях. Он представляет новый эффективный метод на основе градиента под названием «Длинная краткосрочная память» (LSTM), позволяющий преодолеть проблемы недостаточного и затухшего обратного потока ошибок. LSTM обеспечивает постоянный поток ошибок через «карусели постоянных ошибок» и использует мультипликативные вентильные блоки для управления доступом. Учитывая локальную пространственно-временную сложность (O(1) на временной шаг и вес), экспериментальные результаты показывают, что LSTM превосходит существующие алгоритмы в отношении скорости обучения и показателей успеха, особенно для задач с длительными временными задержками.

Ключевые идеи статей по искусственному интеллекту для разработчиков GenAI

- Анализ проблем

В статье представлен подробный анализ проблем, связанных с обратным потоком ошибок в рекуррентных нейронных сетях, подчеркивая проблемы, связанные с появлением или исчезновением сигналов ошибок с течением времени.

- Введение LSTM

Авторы представляют LSTM как новую архитектуру, предназначенную для решения проблем исчезновения и резкого увеличения сигналов ошибок. LSTM включает постоянный поток ошибок через специализированные блоки и использует мультипликативные вентильные блоки для регулирования доступа к этому потоку ошибок.

- Результаты эксперимента

Путем экспериментов с искусственными данными в статье показано, что LSTM превосходит другие алгоритмы рекуррентных сетей, включая BPTT, RTRL, рекуррентную каскадную корреляцию, сети Элмана и группировку нейронных последовательностей. LSTM демонстрирует более быстрое обучение и более высокие показатели успеха, особенно при решении сложных задач с длительными задержками.

- Локальный в пространстве и времени

LSTM описывается как локальная архитектура в пространстве и времени со сложностью вычислений на каждый временной шаг и весом O(1).

- применимость

Предлагаемая архитектура LSTM эффективно решает сложные задачи с искусственной длительной задержкой, которые не решались успешно предыдущими рекуррентными сетевыми алгоритмами.

- Ограничения и преимущества

В документе обсуждаются ограничения и преимущества LSTM, давая представление о практической применимости предлагаемой архитектуры.

Читайте также: Что такое LSTM? Введение в долговременную кратковременную память

Документ 14: Изучение переносимых визуальных моделей под контролем естественного языка

Ссылка: Читать здесь

Резюме статьи

В статье исследуется обучение современных систем компьютерного зрения путем непосредственного обучения изображениям на основе необработанного текста, а не использования фиксированных наборов заранее определенных категорий объектов. Авторы предлагают задачу предварительного обучения по предсказанию того, какая подпись соответствует данному изображению, используя набор данных из 400 миллионов пар (изображение, текст), собранных из Интернета. Полученная модель CLIP (предварительное обучение контрастному языку-изображению) демонстрирует эффективное и масштабируемое обучение представлениям изображений. После предварительного обучения естественный язык ссылается на визуальные концепции, что позволяет без проблем переходить к различным последующим задачам. CLIP сравнивается с более чем 30 наборами данных компьютерного зрения, демонстрируя конкурентоспособную производительность без специального обучения.

Ключевые идеи статей по искусственному интеллекту для разработчиков GenAI

- Обучение естественному языку для компьютерного зрения

В документе исследуется использование контроля естественного языка для обучения моделей компьютерного зрения вместо традиционного подхода к обучению на наборах данных с множественными метками, таких как ImageNet.

- Предварительное тренировочное заданиеАвторы предлагают простую задачу предварительного обучения: предсказать, какая подпись соответствует данному изображению. Эта задача используется для изучения современных представлений изображений с нуля на огромном наборе данных из 400 миллионов пар (изображение, текст), собранных в Интернете.

- Передача с нулевым выстрелом

После предварительного обучения модель использует естественный язык для ссылки на изученные визуальные концепции или описания новых. Это позволяет без необходимости переносить модель на последующие задачи, не требуя специального обучения набору данных.

- Бенчмаркинг для различных задач

В документе оценивается эффективность предлагаемого подхода на более чем 30 различных наборах данных компьютерного зрения, охватывающих такие задачи, как оптическое распознавание текста, распознавание действий в видео, геолокализация и детальная классификация объектов.

- Конкурентоспособная производительность

Модель демонстрирует конкурентоспособную производительность с полностью контролируемыми базовыми показателями для различных задач, часто совпадая или превосходя точность моделей, обученных на наборах данных для конкретных задач, без дополнительного обучения для конкретного набора данных.

- Исследование масштабируемости

Авторы изучают масштабируемость своего подхода путем обучения серии из восьми моделей с разными уровнями вычислительных ресурсов. Установлено, что производительность передачи является плавно предсказуемой функцией вычислений.

- Надежность модели

В документе подчеркивается, что модели CLIP с нулевым выстрелом более надежны, чем модели ImageNet с эквивалентной точностью и контролируемой точностью, предполагая, что оценка с нулевым выстрелом моделей, не зависящих от задачи, обеспечивает более репрезентативную меру возможностей модели.

Документ 15: LORA: НИЗКОРАНГОВАЯ АДАПТАЦИЯ БОЛЬШИХ ЯЗЫКОВЫХ МОДЕЛЕЙ

Ссылка: Читать здесь

Резюме статьи

В документе LoRA предлагается как эффективный метод адаптации больших предварительно обученных языковых моделей к конкретным задачам, решая проблемы развертывания, связанные с их увеличением размера. Этот метод существенно снижает обучаемые параметры и требования к памяти графического процессора, сохраняя или улучшая качество модели в различных тестах. Реализация с открытым исходным кодом еще больше облегчает внедрение LoRA в практические приложения.

Ключевые идеи статей по искусственному интеллекту для разработчиков GenAI

1. Постановка задачи

- Широкомасштабное предварительное обучение с последующей точной настройкой — распространенный подход к обработке естественного языка.

- Точная настройка становится менее осуществимой по мере увеличения размеров моделей, особенно при развертывании моделей с огромными параметрами, таких как GPT-3 (175 миллиардов параметров).

2. Предлагаемое решение: адаптация низкого ранга (LoRA)

- В документе представлен LoRA, метод, который замораживает веса предварительно обученной модели и вводит обучаемые матрицы разложения ранга на каждый уровень архитектуры Transformer.

- LoRA значительно сокращает количество обучаемых параметров для последующих задач по сравнению с полной точной настройкой.

3. Преимущества ЛоРА

- Сокращение параметров: по сравнению с точной настройкой LoRA может сократить количество обучаемых параметров до 10,000 XNUMX раз, что делает его вычислительно более эффективным.

- Эффективность памяти: LoRA снижает требования к памяти графического процессора почти в 3 раза по сравнению с точной настройкой.

- Качество модели. Несмотря на меньшее количество обучаемых параметров, LoRA работает на том же уровне или лучше, чем точная настройка, с точки зрения качества модели на различных моделях, включая RoBERTa, DeBERTa, GPT-2 и GPT-3.

4. Преодоление проблем развертывания

- В документе рассматривается проблема развертывания моделей со многими параметрами путем введения LoRA, позволяющего эффективно переключать задачи без переобучения всей модели.

5. Эффективность и низкая задержка вывода

- LoRA упрощает совместное использование предварительно обученной модели для создания нескольких модулей LoRA для различных задач, сокращая требования к хранению и накладные расходы на переключение задач.

- Обучение становится более эффективным: аппаратный барьер для входа снижается до 3 раз при использовании адаптивных оптимизаторов.

6. Совместимость и интеграция

- LoRA совместим с различными предшествующими методами и может комбинироваться с ними, например, с настройкой префикса.

- Предлагаемая линейная конструкция позволяет объединять обучаемые матрицы с замороженными весами во время развертывания, не создавая дополнительной задержки вывода по сравнению с полностью настроенными моделями.

7. Эмпирическое исследование

- Статья включает эмпирическое исследование дефицита рангов при адаптации языковой модели, дающее представление об эффективности подхода LoRA.

8. Реализация с открытым исходным кодом

- Авторы предоставляют пакет, который облегчает интеграцию LoRA с моделями PyTorch, а также выпускает реализации и контрольные точки моделей для RoBERTa, DeBERTa и GPT-2.

Вы также можете прочитать: Точная настройка больших языковых моделей с эффективным использованием параметров с помощью LoRA и QLoRA

Заключение

В заключение, изучение 15 основных документов по искусственному интеллекту для разработчиков GenAI, представленных в этой статье, — это не просто рекомендация, а стратегический императив для любого начинающего разработчика. Эти статьи по искусственному интеллекту предлагают всестороннее путешествие по разнообразному ландшафту искусственного интеллекта, охватывающему такие важные области, как обработка естественного языка, компьютерное зрение и другие. Погружаясь в идеи и инновации, представленные в этих статьях, разработчики получают глубокое понимание передовых методов и алгоритмов в этой области.

Похожие страницы:

- SEO-контент и PR-распределение. Получите усиление сегодня.

- PlatoData.Network Вертикальный генеративный ИИ. Расширьте возможности себя. Доступ здесь.

- ПлатонАйСтрим. Интеллект Web3. Расширение знаний. Доступ здесь.

- ПлатонЭСГ. Углерод, чистые технологии, Энергия, Окружающая среда, Солнечная, Управление отходами. Доступ здесь.

- ПлатонЗдоровье. Биотехнологии и клинические исследования. Доступ здесь.

- Источник: https://www.analyticsvidhya.com/blog/2024/01/essential-ai-papers-every-gen-ai-developer-must-read/

- :имеет

- :является

- :нет

- :куда

- $UP

- 000

- 1

- 10

- 11

- 12

- 13

- 14

- 15%

- 17

- 20

- 20 лет

- 2014

- 2017

- 28

- 30

- 3d

- 400

- 41

- 60

- 7

- 8

- 9

- 913

- a

- способность

- О нас

- AC

- доступ

- точность

- точный

- точно

- Достигать

- достигнутый

- Достигает

- достижение

- через

- Действие

- адаптация

- адаптивный

- дополнительный

- Дополнительно

- адрес

- адресованный

- адреса

- адресация

- корректировки

- Принятие

- достижения

- плюс

- Преимущества

- состязательный

- После

- впереди

- AI

- Цель

- AL

- алгоритм

- алгоритмы

- Все

- позволять

- Позволяющий

- позволяет

- вдоль

- причислены

- суммы

- an

- анализ

- и

- любой

- отношение

- Применение

- Приложения

- прикладной

- применяется

- Применить

- Применение

- подхода

- подходы

- приблизительный

- архитектура

- МЫ

- области

- спорить

- возникать

- гайд

- статьи

- искусственный

- искусственный интеллект

- Искусственный интеллект (AI)

- AS

- стремящийся

- оценки;

- связанный

- At

- посещать

- внимание

- Авторы

- барьер

- основанный

- основной

- BE

- становится

- не являетесь

- ниже

- эталонный тест

- протестированные

- тесты

- Преимущества

- ЛУЧШЕЕ

- Лучшая

- между

- Beyond

- предубеждения

- миллиард

- BIN

- повышение

- изоферменты печени

- связанный

- прорыв

- прорывы

- шире

- Строительство

- построенный

- но

- by

- под названием

- пришел

- камера

- CAN

- кандидатов

- глава

- возможности

- возможности

- Пропускная способность

- захватить

- перехватывает

- осторожно

- каскад

- категории

- определенный

- цепь

- цепи

- вызов

- проблемы

- сложные

- шансы

- изменения

- выбор

- классов

- классификация

- классифицировать

- CNN

- код

- сочетании

- комбинаты

- Общий

- сообщество

- сравнимый

- сравненный

- сравнения

- совместим

- компетентный

- конкурс

- Соревнования

- конкурентоспособный

- конкурентоспособность

- полностью

- комплекс

- сложность

- комплексный

- вычисление

- вычислительный

- расчеты

- компьютер

- Компьютерное зрение

- вычисление

- понятия

- Обеспокоенность

- заключение

- Свяжитесь

- подключенный

- Рассматривать

- считается

- состоит

- постоянная

- содержание

- конкурс

- контекст

- продолжается

- (CIJ)

- контраст

- способствовать

- способствует

- содействие

- взносы

- контроль

- Сближение

- сверточная нейронная сеть

- исправить

- правильно

- Корреляция

- соответствует

- дорогостоящий

- чехол для варгана

- покрытие

- критической

- решающее значение

- Текущий

- кривая

- передовой

- данным

- Наборы данных

- Дней

- занимавшийся

- решения

- уменьшается

- глубоко

- глубокое обучение

- глубокая нейронная сеть

- более глубокий

- запросы

- демонстрировать

- демонстрирует

- демонстрирующий

- зависеть

- Зависимости

- развертывание

- развертывание

- развертывание

- описывать

- описано

- описывает

- Проект

- предназначенный

- Несмотря на

- подробный

- Застройщик

- застройщиков

- развивающийся

- различный

- трудный

- затруднения

- направленный

- непосредственно

- Обнаруживает

- открытие

- расстояние

- выделить

- отличает

- распределение

- распределения

- Разное

- Разнообразие

- do

- домен

- доменов

- Господство

- наркотик

- лекарств

- в течение

- динамический

- Е & Т

- каждый

- легче

- Эффективный

- фактически

- эффективность

- эффекты

- эффективность

- затрат

- эффективный

- 8

- или

- элементы

- 11

- ликвидирует

- уничтожение

- подчеркивать

- подчеркивает

- работодателей

- работает

- включить

- позволяет

- позволяет

- кодирование

- заниматься

- Проект и

- Английский

- повышать

- улучшения

- Усиливает

- обеспечение

- Весь

- полностью

- запись

- равный

- Равновесие

- Эквивалент

- ошибка

- особенно

- сущность

- существенный

- установленный

- налаживает

- Оценки

- Эфир (ETH)

- оценки

- оценка

- Даже

- везде

- развивается

- эволюционирует

- развивается

- Примеры

- превышать

- превышает

- отлично

- захватывающий

- Экспонаты

- существующий

- существует

- Расширьте

- дорогим

- экспериментальный

- Эксперименты

- эксперты

- исследование

- Больше

- исследует

- Исследование

- расширенная

- облегчает

- облегчающий

- отсутствии

- знакомый

- быстрее

- выполнимый

- Особенности

- несколько

- меньше

- поле

- Поля

- фильтры

- окончательный

- Найдите

- обнаружение

- результаты

- Во-первых,

- примерка

- 5

- фиксированной

- поток

- фокусируется

- фокусировка

- следует

- Что касается

- найденный

- 4

- Рамки

- частота

- от

- замороженные

- полный

- полностью

- функция

- Функции

- далее

- Gain

- Доходы

- игра

- Gans

- ворота

- Genai

- порождать

- генерируется

- порождающий

- генеративный

- генеративная модель

- слегка

- геометрия

- данный

- Отдаете

- Глобальный

- GPU / ГРАФИЧЕСКИЙ ПРОЦЕССОР

- Графические процессоры

- график

- граф нейронных сетей

- Графики

- Расти

- обрабатывать

- Управляемость

- Аппаратные средства

- имеющий

- помогает

- иерархическая

- High

- Высокая частота

- высокое разрешение

- высший

- Выделите

- Выделенные

- выделив

- основной момент

- очень

- Как

- How To

- HTTPS

- человек

- Людей

- Сотни

- сотни миллионов

- Настройка гиперпараметра

- идеи

- определения

- изображение

- Классификация изображений

- Распознавание изображений

- IMAGEnet

- изображений

- Влияние

- Воздействие

- императив

- реализация

- реализации

- в XNUMX году

- последствия

- значение

- важную

- наложенный

- улучшенный

- улучшение

- улучшение

- улучшается

- улучшение

- in

- включают

- включает в себя

- В том числе

- включать

- включает в себя

- Увеличение

- расширились

- повышение

- все больше и больше

- с указанием

- информация

- сообщил

- первоначально

- инновации

- инновационный

- вход

- размышления

- вдохновленный

- пример

- вместо

- инструкции

- интеграции.

- Интеллекта

- интенсивный

- взаимодействие

- взаимодействие

- интерес

- Интернет

- в

- вводить

- выпустили

- Представляет

- введение

- Введение

- ходе расследования,

- включать в себя

- включает в себя

- вопрос

- вопросы

- IT

- ЕГО

- работа

- Джобс

- путешествие

- JPG

- знания

- известный

- Отсутствие

- посадка

- пейзаж

- язык

- большой

- крупномасштабный

- больше

- крупнейших

- Задержка

- последний

- слой

- слоев

- ведущий

- Лиды

- УЧИТЬСЯ

- узнали

- изучение

- Меньше

- уровни

- Кредитное плечо

- рычаги

- Используя

- такое как

- вероятность

- ограничение

- недостатки

- Ограниченный

- локальным

- Длинное

- много времени

- посмотреть

- Низкий

- ниже

- снижение

- машина

- машинный перевод

- сделанный

- сохранение

- основной

- сделать

- Создание

- способ

- многих

- карта

- Маржа

- массивный

- Совпадение

- спички

- согласование

- математический

- матрица

- макс-ширина

- максимизации

- максимальный

- проводить измерение

- механизмы

- Память

- просто

- объединение

- метод

- методологии

- Методология

- методы

- миллиона

- миллионы

- минимальный

- минимизация

- ошибка

- модель

- Модели

- изменения

- Модули

- БОЛЕЕ

- более эффективным

- Более того

- самых

- с разными

- должен

- Должен прочитать

- натуральный

- Естественный язык

- Обработка естественного языка

- природа

- Необходимость

- необходимый

- потребности

- Nerf

- Сети

- сеть

- сетей

- нервный

- нейронной сети

- нейронные сети

- НейриПС

- Нейроны

- Новые

- Новости

- следующий

- НЛП

- нет

- узел

- узлы

- примечательный

- в своих размышлениях

- Заметки

- роман

- номер

- объект

- цель

- целей

- наблюдается

- вхождение

- OCR

- of

- предлагают

- Предложения

- .

- on

- ONE

- те,

- онлайн

- только

- с открытым исходным кодом

- операция

- Операционный отдел

- оптимизация

- Оптимизировать

- оптимизированный

- or

- Другое

- опережать

- превосходя

- Превосходит

- выходной

- внешнюю

- за

- Преодолеть

- преодоление

- обзор

- пакет

- пар

- Pankaj

- бумага & картон

- бумага

- Параллельные

- параметр

- параметры

- особый

- особенно

- Патчи

- шаблон

- для

- выполнять

- производительность

- выполняет

- периодов

- Фотореалистичная

- Платон

- Платон Интеллектуальные данные

- ПлатонДанные

- правдоподобный

- Точка

- представляет

- потенциал

- потенциально

- мощный

- практическое

- Практическое применение

- предсказывать

- предсказуемый

- прогнозирования

- прогноз

- Predictions

- предсказывает

- представить

- представлены

- разрабатывает

- предыдущий

- первичный

- Предварительный

- вероятность

- Проблема

- проблемам

- процедуры

- процесс

- обработка

- производит

- глубокий

- FitPartner™

- Программы

- проектов

- предлагает

- предложило

- предлагает

- предлагая

- Белкове продукты

- Белки

- доказанный

- доказывает

- обеспечивать

- приводит

- обеспечение

- опубликованный

- pytorch

- Запросы

- Гонки

- ассортимент

- ранг

- Стоимость

- скорее

- Сырье

- достиг

- Читать

- Reading

- подтверждает

- реальные

- реальный мир

- последний

- недавно

- рецепт

- признание

- Рекомендация

- Я выздоровела

- повторение

- повторяющийся

- рекурсивный

- уменьшить

- Цена снижена

- снижает

- снижение

- снижение

- ссылка

- Рекомендации

- отметила

- по

- регламентировать

- Связанный

- Отношения

- освободить

- выпустил

- опора

- опираясь

- остатки

- замечательный

- оказываемых

- оказание

- представлять

- представление

- представитель

- представляющий

- требовать

- требование

- Требования

- исследованиям

- Научно-исследовательское сообщество

- исследователи

- Полезные ресурсы

- соответственно

- в результате

- Итоги

- переквалификация

- показывать

- революционизировать

- RGB

- правую

- Снижение

- надежный

- Масштабируемость

- масштабируемые

- Шкала

- Весы

- масштабирование

- Сценарии

- сцена

- Сцены

- планирование

- схемы

- научный

- Гол

- поцарапать

- Поиск

- предложение

- Последовательность

- Серии

- служит

- набор

- Наборы

- настройки

- несколько

- Поделиться

- разделение

- краткосрочный

- показывать

- продемонстрированы

- Showcasing

- показ

- Шоу

- сигналы

- значение

- значительный

- существенно

- аналогичный

- сходство

- просто

- одновременно

- обстоятельства

- Размер

- квалифицированный

- плавно

- социальный

- только

- Решение

- Решения

- РЕШАТЬ

- Решает

- Решение

- некоторые

- иногда

- Space

- Пространство и время

- напряженность

- специализированный

- конкретный

- Спектральный

- скорость

- раскол

- стандарт

- современное состояние

- отчетность

- оставаться

- Шаг

- диск

- магазин

- Стратегический

- стратегий

- Стратегия

- сильный

- Структура

- структурированный

- структур

- Схватки

- Кабинет

- существенный

- по существу

- успех

- успешный

- Успешно

- такие

- Предлагает

- подходящее

- топ

- надзор

- превосходит

- превосходящие

- SVG

- синтез

- система

- системы

- Сложность задачи

- задачи

- снижения вреда

- Тенденцию

- terms

- тестXNUMX

- текст

- чем

- который

- Ассоциация

- График

- их

- Их

- тогда

- теоретический

- Эти

- они

- этой

- тысячи

- три

- Через

- время

- раз

- в

- инструментом

- Темы

- к

- традиционный

- Train

- специалистов

- Обучение

- перевод

- Передающий

- трансформатор

- трансформеры

- Переводы

- Качество перевода

- Тенденции

- учебник

- два

- Типы

- нижнее подчеркивание

- понимание

- созданного

- единиц

- В отличие от

- беспрецедентный

- обновление

- Updates

- использование

- используемый

- использования

- через

- использует

- v1

- ценный

- различный

- проверяемый

- разносторонний

- многосторонность

- версия

- Видео

- Видео

- Вид

- Просмотры

- видимый

- видение

- системы зрения

- визуальный

- Визуальное распознавание

- объем

- vs

- законопроект

- способы

- Web

- вес

- ЧТО Ж

- когда

- будь то

- который

- в то время как

- широкий

- Широкий диапазон

- широко

- Шире

- Более широкое сообщество

- Википедия.

- будете

- в

- без

- слова

- Работа

- работает

- стоимость

- письменный

- лет

- уступая

- являетесь

- ВАШЕ

- зефирнет