Недавние достижения в разработке LLM популяризировали их использование для различных задач НЛП, которые ранее решались с использованием старых методов машинного обучения. Большие языковые модели способны решать различные языковые задачи, такие как классификация, обобщение, поиск информации, создание контента, ответы на вопросы и поддержание разговора — и все это с использованием одной единственной модели. Но как мы узнаем, что они хорошо справляются со всеми этими различными задачами?

Рост числа LLM выявил нерешенную проблему: у нас нет надежного стандарта для их оценки. Что усложняет оценку, так это то, что они используются для самых разнообразных задач, и у нас нет четкого определения того, что является хорошим ответом для каждого варианта использования.

В этой статье обсуждаются текущие подходы к оценке LLM и представлена новая таблица лидеров LLM, использующая человеческую оценку, которая улучшает существующие методы оценки.

Первая и обычная первоначальная форма оценки — запустить модель на нескольких тщательно подобранных наборах данных и проверить ее эффективность. HuggingFace создал Открыть таблицу лидеров LLM где большие модели открытого доступа оцениваются с использованием четырех известных наборов данных (Задача рассуждения AI2 , ХеллаСваг , ММЛУ , Правдивый контроль качества). Это соответствует автоматической оценке и проверяет способность модели получать факты для некоторых конкретных вопросов.

Это пример вопроса из ММЛУ набор данных.

Тема: колледж_медицина

Вопрос: Ожидаемый побочный эффект от приема креатина.

- А) мышечная слабость

- Б) прибавка в массе тела

- В) мышечные судороги

- Д) потеря электролитов

Ответ: (Б)

Оценка модели при ответе на вопросы такого типа является важным показателем и хорошо служит для проверки фактов, но не проверяет генеративную способность модели. Вероятно, это самый большой недостаток этого метода оценки, поскольку создание свободного текста является одной из наиболее важных особенностей LLM.

Кажется, в сообществе существует консенсус, что для правильной оценки модели нам нужна человеческая оценка. Обычно это делается путем сравнения ответов разных моделей.

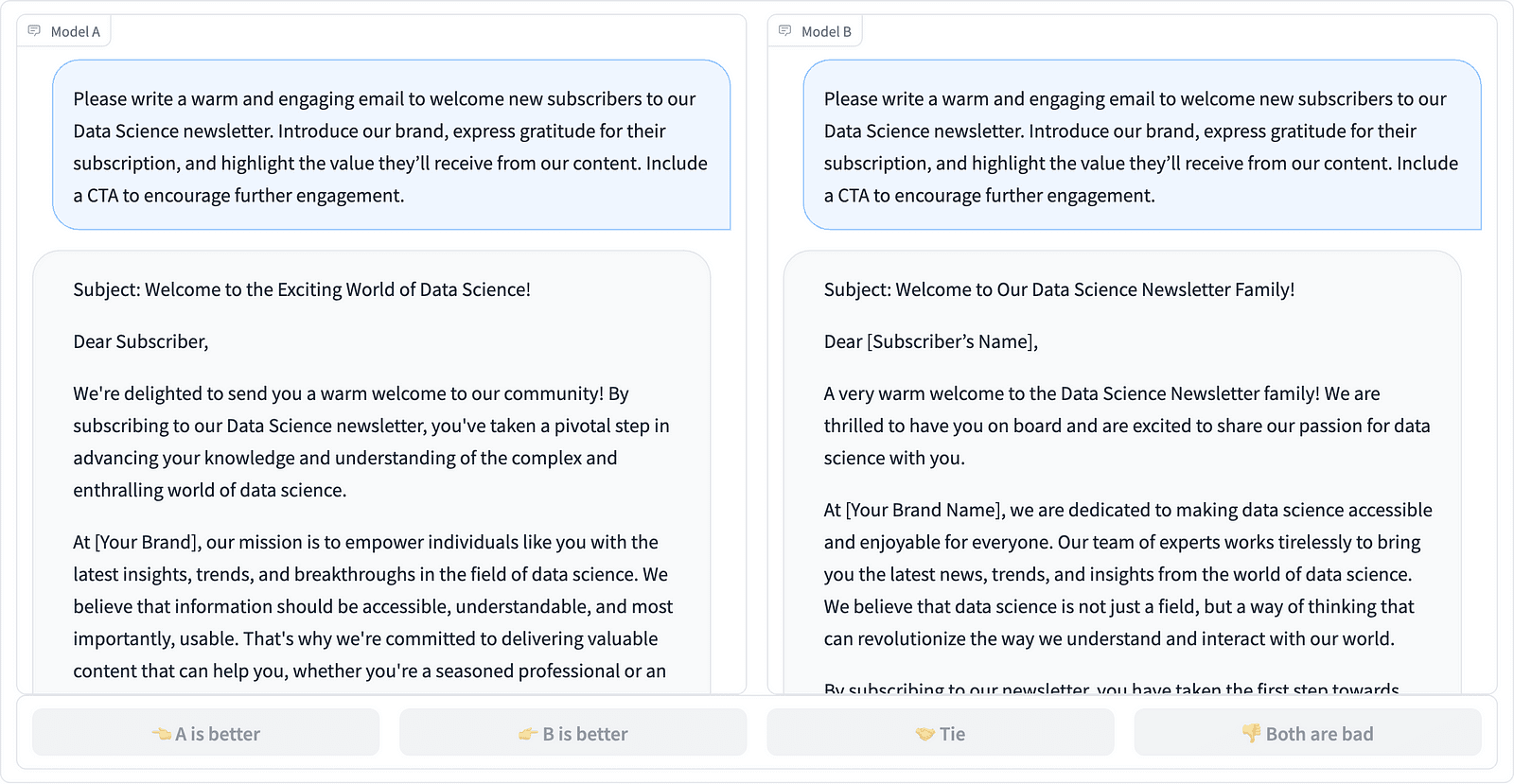

Сравнение двух быстрых завершений в проекте LMSYS – скриншот автора

Аннотаторы решают, какой ответ лучше, как показано в примере выше, и иногда количественно оценивают разницу в качестве подсказок. Организация LMSYS создала лидеров который использует этот тип человеческой оценки и сравнивает 17 различных моделей, сообщая о Эло рейтинг для каждой модели.

Поскольку человеческую оценку трудно масштабировать, были предприняты усилия по масштабированию и ускорению процесса оценки, в результате чего появился интересный проект под названием АльпакаЭвал. Здесь каждая модель сравнивается с базовым уровнем (text-davinci-003, предоставленным GPT-4), а человеческая оценка заменяется оценкой GPT-4. Это действительно быстро и масштабируемо, но можем ли мы доверять приведенной здесь модели для выполнения оценки? Нам необходимо осознавать предвзятость модели. Проект фактически показал, что GPT-4 может предпочитать более длинные ответы.

Методы оценки LLM продолжают развиваться, поскольку сообщество ИИ ищет простые, справедливые и масштабируемые подходы. Последняя разработка принадлежит команде Толока с новым лидеров для дальнейшего совершенствования существующих стандартов оценки.

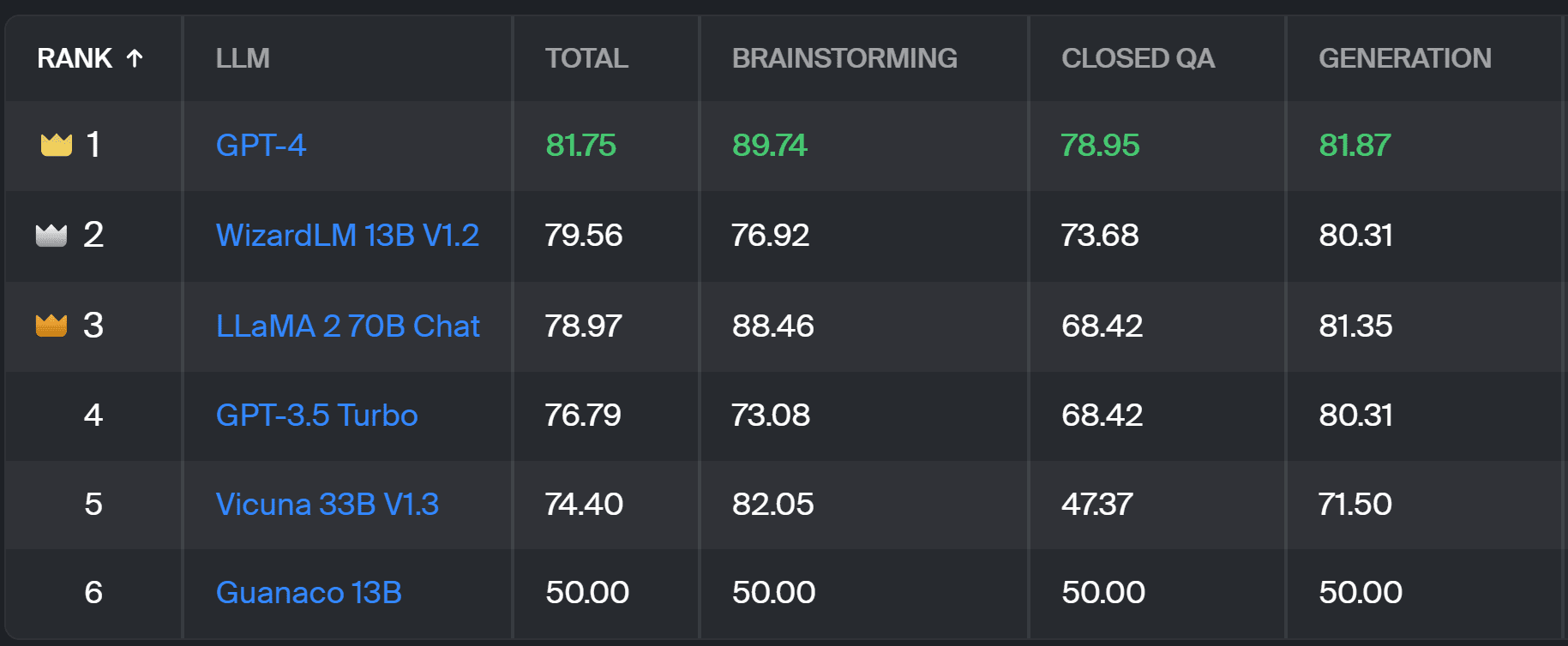

Новый лидеров сравнивает ответы модели с реальными пользовательскими подсказками, которые классифицируются по полезным задачам НЛП, как описано в этот документ InstructGPT. Он также показывает общий процент побед каждой модели во всех категориях.

Таблица лидеров Толоки – скриншот Автора

Оценка, использованная в этом проекте, аналогична той, которая выполняется в AlpacaEval. Очки в таблице лидеров представляют процент побед соответствующей модели по сравнению с Гуанако 13Б модель, которая служит здесь базовым сравнением. Выбор Guanaco 13B является усовершенствованием метода AlpacaEval, который использует в качестве базовой модели скоро устаревшую модель text-davinci-003.

Фактическая оценка выполняется экспертами-аннотаторами на основе набора реальных подсказок. Для каждой подсказки аннотаторам даются два варианта завершения и их спрашивают, какой из них они предпочитают. Подробности о методике вы можете узнать здесь.

Этот тип человеческой оценки более полезен, чем любой другой автоматический метод оценки, и должен улучшить человеческую оценку, используемую для Таблица лидеров LMSYS. Недостатком метода LMSYS является то, что любой, у кого есть ссылке могут принять участие в оценке, что вызывает серьезные вопросы о качестве данных, собранных таким образом. Закрытая группа экспертов-аннотаторов имеет больший потенциал для получения надежных результатов, и Толока применяет дополнительные методы контроля качества для обеспечения качества данных.

В этой статье мы представили новое многообещающее решение для оценки LLM — таблицу лидеров Толоки. Этот подход является инновационным, сочетает в себе сильные стороны существующих методов, добавляет детализацию для конкретных задач и использует надежные методы человеческого аннотирования для сравнения моделей.

Изучите доску и поделитесь с нами своим мнением и предложениями по улучшению.

Магдалена Конкевич — евангелист данных в Toloka, глобальной компании, поддерживающей быструю и масштабируемую разработку искусственного интеллекта. Она получила степень магистра в области искусственного интеллекта в Эдинбургском университете и работала инженером НЛП, разработчиком и специалистом по обработке данных в компаниях в Европе и Америке. Она также участвовала в обучении и наставничестве ученых, работающих с данными, и регулярно участвует в публикациях по науке о данных и машинному обучению.

- SEO-контент и PR-распределение. Получите усиление сегодня.

- PlatoData.Network Вертикальный генеративный ИИ. Расширьте возможности себя. Доступ здесь.

- ПлатонАйСтрим. Интеллект Web3. Расширение знаний. Доступ здесь.

- ПлатонЭСГ. Углерод, чистые технологии, Энергия, Окружающая среда, Солнечная, Управление отходами. Доступ здесь.

- ПлатонЗдоровье. Биотехнологии и клинические исследования. Доступ здесь.

- Источник: https://www.kdnuggets.com/a-better-way-to-evaluate-llms?utm_source=rss&utm_medium=rss&utm_campaign=a-better-way-to-evaluate-llms

- :имеет

- :является

- :нет

- :куда

- $UP

- 17

- a

- способность

- О нас

- выше

- через

- фактического соединения

- на самом деле

- дополнительный

- Добавляет

- продвижение

- авансы

- AI

- Все

- причислены

- Америка

- an

- и

- ответ

- ответы

- любой

- применяется

- подхода

- подходы

- МЫ

- Арене

- гайд

- искусственный

- искусственный интеллект

- AS

- At

- Автоматический

- знать

- b

- Базовая линия

- BE

- , так как:

- было

- Лучшая

- предубеждения

- Крупнейшая

- доска

- тело

- принес

- бизнес

- но

- by

- CAN

- способный

- случаев

- категории

- вызов

- Проверки

- выбор

- классификация

- Очистить

- закрыто

- комбинаты

- выходит

- сообщество

- Компания

- сравнить

- сравненный

- сравнив

- сравнение

- Консенсус

- содержание

- контентного создание

- продолжающийся

- способствует

- контроль

- Разговор

- соответствует

- создали

- создание

- толпа

- Куратор

- Текущий

- данным

- Качество данных

- наука о данных

- ученый данных

- Наборы данных

- решать

- определение

- Степень

- подробнее

- Застройщик

- Развитие

- разница

- различный

- Недостаток

- Разное

- do

- приносит

- дело

- сделанный

- Dont

- нижняя сторона

- каждый

- легко

- Эдинбург

- эффект

- усилия

- электролиты

- инженер

- обеспечивать

- Европе

- оценивать

- оценивается

- оценки

- оценка

- Евангелист

- развивается

- исследовать

- пример

- существующий

- ожидаемый

- эксперту

- Факты

- ярмарка

- БЫСТРО

- в пользу

- Особенности

- Найдите

- First

- Что касается

- форма

- 4

- Бесплатно

- от

- далее

- Gain

- собранный

- порождающий

- генеративный

- получить

- GitHub

- данный

- Глобальный

- хорошо

- хорошая работа

- Жесткий

- Сильнее

- Есть

- здесь

- очень

- имеет

- Как

- HTTPS

- ОбниматьЛицо

- человек

- важную

- улучшать

- улучшение

- улучшение

- улучшается

- in

- информация

- начальный

- инновационный

- Интеллекта

- интересный

- выпустили

- Представляет

- вовлеченный

- IT

- ЕГО

- работа

- всего

- только один

- КДнаггетс

- Знать

- Отсутствие

- язык

- большой

- последний

- изучение

- Используя

- легкий

- дольше

- от

- машина

- обучение с помощью машины

- сохранение

- ДЕЛАЕТ

- способ

- Масса

- мастер

- Май..

- наставничество

- метод

- Методология

- методы

- метрический

- модель

- Модели

- БОЛЕЕ

- самых

- мышца

- Необходимость

- Новые

- новое решение

- НЛП

- of

- старший

- on

- ONE

- открытый

- Мнения

- Другое

- изложенные

- общий

- часть

- выполнять

- производительность

- выполнены

- Платон

- Платон Интеллектуальные данные

- ПлатонДанные

- потенциал

- предпочитать

- предварительно

- вероятно

- Проблема

- проблемам

- процесс

- Проект

- многообещающий

- наводящие

- должным образом

- при условии

- публикациям

- вопрос

- Вопросы

- привлечение

- Обменный курс

- реальный мир

- регулярно

- складская

- заменить

- Reporting

- представлять

- те

- ответ

- ответы

- привело

- Итоги

- Рост

- Run

- s

- масштабируемые

- Шкала

- Наука

- Ученый

- Ученые

- множество

- счет

- поиск

- кажется

- видел

- серьезный

- служит

- набор

- несколько

- Поделиться

- она

- должен

- показанный

- Шоу

- сторона

- аналогичный

- одинарной

- Решение

- Решение

- некоторые

- иногда

- конкретный

- скорость

- стандарт

- стандартов

- сильные

- такие

- поддержки

- взять

- задачи

- Обучение

- команда

- снижения вреда

- тестXNUMX

- текст

- чем

- который

- Ассоциация

- их

- Их

- Там.

- Эти

- они

- этой

- в

- Доверие

- два

- напишите

- типично

- Университет

- на

- us

- Применение

- использование

- прецедент

- используемый

- Информация о пользователе

- использования

- через

- обычный

- разнообразие

- Путь..

- we

- слабость

- ЧТО Ж

- известный

- были

- Что

- Что такое

- который

- выиграть

- в

- работавший

- являетесь

- ВАШЕ

- зефирнет