Inteligența artificială (AI) a revoluționat diverse industrii, oferind numeroase beneficii și oportunități. Cu toate acestea, au apărut preocupări cu privire la potențialul AI de a perpetua discriminarea și părtinirile. Acest articol explorează subiectul discriminării AI, aruncând lumină asupra provocărilor de identificare și abordare a prejudecăților încorporate în sistemele AI. Specialiștii din industrie își exprimă îndoielile cu privire la implicațiile morale și etice ale inteligenței artificiale, invocând îngrijorări legate de dezinformări, părtiniri ale algoritmilor și generarea de conținut înșelător. Pe măsură ce dezbaterile despre IA se intensifică, există o cerere din ce în ce mai mare pentru o reglementare semnificativă pentru a asigura transparența, responsabilitatea și protecția drepturilor fundamentale.

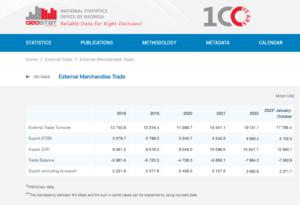

Provocări pentru industriile financiare cu IA

Potrivit lui Nabil Manji, șeful cripto și Web3 la Worldpay by FIS, eficacitatea produselor AI depinde în mare măsură de calitatea materialului sursă folosit pentru antrenament. Într-un interviu acordat CNBC, Manji a explicat că doi factori principali contribuie la performanța AI: datele la care are acces și capacitățile modelului lingvistic mare.

Pentru a ilustra semnificația datelor, Manji a menționat că companii precum Reddit au declarat public restricții privind eliminarea datelor, solicitând plata pentru acces. În sectorul serviciilor financiare, el a subliniat provocarea sistemelor de date fragmentate în diferite limbi și formate. Această lipsă de consolidare și armonizare limitează eficacitatea produselor bazate pe inteligență artificială, mai ales în comparație cu industriile cu infrastructură de date standardizată și modernizată.

Potrivit lui Manji, utilizarea tehnologiei blockchain sau a registrului distribuit poate oferi o soluție potențială pentru a rezolva această problemă. Această abordare inovatoare poate oferi o transparență sporită în datele fragmentate stocate în sistemele complexe ale băncilor convenționale. Cu toate acestea, el a recunoscut că natura foarte reglementată și lentă a băncilor le-ar putea împiedica capacitatea de a adopta rapid noi instrumente de inteligență artificială, spre deosebire de companiile tehnologice mai agile, cum ar fi Microsoft și Google, care au fost în fruntea inovației în ultimii câteva. decenii.

Luând în considerare acești factori, devine evident că industria financiară se confruntă cu provocări unice în valorificarea inteligenței artificiale din cauza complexității integrării datelor și a naturii inerente a sectorului bancar.

Potrivit lui Rumman Chowdhury, fost șef al departamentului de etică, transparență și responsabilitate în învățarea automată la Twitter, împrumutul este un exemplu notabil al modului în care părtinirea sistemelor AI poate afecta negativ comunitățile marginalizate. Vorbind la o discuție la Amsterdam, Chowdhury a evidențiat practica istorică de „redlining” în Chicago în anii 1930. Redlining a implicat refuzarea împrumuturilor către cartierele predominant afro-americane pe baza demografiei rasiale.

Chowdhury a explicat că, deși algoritmii moderni ar putea să nu includă în mod explicit rasa ca punct de date, părtinirile pot fi încă codificate implicit. Atunci când se dezvoltă algoritmi de evaluare a riscului districtelor și persoanelor în scopuri de împrumut, datele istorice care conțin părtiniri pot perpetua, din neatenție, discriminarea.

Angle Bush, vizionarul din spatele Black Women in Artificial Intelligence, a subliniat importanța recunoașterii pericolelor asociate cu reproducerea prejudecăților încorporate în datele istorice atunci când se utilizează sisteme AI pentru a determina aprobarea împrumutului. O astfel de practică poate duce la respingerea automată a cererilor de împrumut din partea comunităților marginalizate, perpetuând astfel inegalitățile rasiale sau de gen.

Frost Li, un dezvoltator AI cu experiență, a subliniat provocările personalizării în Integrare AI. Selectarea „funcțiilor de bază” pentru antrenarea modelelor de IA poate implica uneori factori necorelați care pot duce la rezultate părtinitoare. Li a oferit un exemplu despre modul în care startup-urile fintech care vizează străini s-ar putea confrunta cu criterii diferite de evaluare a creditului în comparație cu băncile locale, care sunt mai familiarizate cu școlile și comunitățile locale.

Niklas Guske, COO al Taktile, un startup specializat în automatizarea procesului decizional pentru fintech, a clarificat că AI generativă nu este folosită de obicei pentru a crea scoruri de credit sau de risc pentru consumatori. Dimpotrivă, puterea sa constă în preprocesarea datelor nestructurate, cum ar fi fișierele text, pentru a îmbunătăți calitatea datelor pentru modelele convenționale de subscriere.

Pe scurt, utilizarea inteligenței artificiale în serviciile financiare și de creditare ridică îngrijorări cu privire la părtinire și discriminare. Prejudecățile istorice încorporate în date și selecția de caracteristici irelevante în timpul instruirii AI pot duce la rezultate nedrepte. Este esențial ca băncile și instituțiile financiare să recunoască și să abordeze aceste probleme pentru a preveni perpetuarea involuntară a discriminării atunci când implementează soluții AI.

Dovada discriminării AI

Demonstrarea discriminării bazate pe inteligența artificială poate fi o provocare, așa cum evidențiază exemple precum cazul care implică Apple și Goldman Sachs. Departamentul pentru Servicii Financiare de Stat din New York a respins acuzațiile de impunere a unor limite mai mici pentru Apple Card pentru femei, invocând lipsa de dovezi justificative.

Kim Smouter, directorul Rețelei europene împotriva rasismului, subliniază că desfășurarea în masă a inteligenței artificiale aduce opacitate în procesele de luare a deciziilor, ceea ce face dificilă identificarea și abordarea discriminării de către indivizi.

Smouter explică că indivizii au adesea cunoștințe limitate despre modul în care funcționează sistemele AI, ceea ce face dificilă detectarea cazurilor de discriminare sau a prejudecăților sistemice. Devine și mai complex atunci când discriminarea face parte dintr-o problemă mai largă care afectează mai mulți indivizi. Smouter face referire la scandalul olandez privind bunăstarea copilului, în care un număr mare de cereri de prestații au fost etichetate în mod greșit drept frauduloase din cauza părtinirii instituționale. Descoperirea unor astfel de disfuncționalități este o provocare, iar obținerea despăgubirilor poate fi dificilă și consumatoare de timp, ceea ce duce la un prejudiciu semnificativ și uneori ireversibil.

Aceste exemple ilustrează dificultățile inerente în fundamentarea discriminării bazate pe IA și în obținerea de remedii atunci când apare o astfel de discriminare. Complexitatea sistemelor AI și lipsa de transparență în procesele de luare a deciziilor pot face ca indivizii să fie dificil să recunoască și să abordeze în mod eficient cazurile de discriminare.

Potrivit Chowdhury, este nevoie urgentă de un organism de reglementare global similar cu Națiunile Unite, care să abordeze riscurile asociate cu IA. În timp ce AI a demonstrat o inovație remarcabilă, tehnologii și eticienii au exprimat îngrijorări cu privire la implicațiile sale morale și etice. Aceste preocupări cuprind probleme precum dezinformarea, prejudecățile rasiale și de gen încorporate în algoritmii AI și generarea de conținut înșelător prin instrumente precum ChatGPT.

Chowdhury își exprimă îngrijorarea cu privire la intrarea într-o lume post-adevăr în care informațiile online, inclusiv text, video și audio, devin nedemne de încredere datorită inteligenței artificiale generative. Acest lucru ridică întrebări despre cum putem asigura integritatea informațiilor și cum ne putem baza pe acestea pentru a lua decizii în cunoștință de cauză. Având ca exemplu Legea AI al Uniunii Europene, reglementarea semnificativă a IA este crucială în acest moment. Cu toate acestea, există îngrijorări cu privire la termenul lung necesar pentru ca propunerile de reglementare să devină eficiente, ceea ce ar putea întârzia acțiunile necesare.

Smouter subliniază necesitatea unei mai mari transparențe și responsabilitate în algoritmii AI. Aceasta include a face algoritmii mai înțeleși pentru cei care nu sunt experți, efectuarea de teste și publicarea rezultatelor, stabilirea de procese independente de reclamație, efectuarea de audituri și raportări periodice și implicarea comunităților rasializate în proiectarea și implementarea tehnologiei. Se preconizează că aplicarea Legii AI, care adoptă o perspectivă privind drepturile fundamentale și introduce concepte precum despăgubiri, va începe în aproximativ doi ani. Reducerea acestui termen ar fi avantajoasă pentru a susține transparența și responsabilitatea ca aspecte integrante ale inovației.

- Distribuție de conținut bazat pe SEO și PR. Amplifică-te astăzi.

- PlatoData.Network Vertical Generative Ai. Împuterniciți-vă. Accesați Aici.

- PlatoAiStream. Web3 Intelligence. Cunoștințe amplificate. Accesați Aici.

- PlatoESG. Automobile/VE-uri, carbon, CleanTech, Energie, Mediu inconjurator, Solar, Managementul deșeurilor. Accesați Aici.

- BlockOffsets. Modernizarea proprietății de compensare a mediului. Accesați Aici.

- Sursa: https://www.forexnewsnow.com/fintech/the-urgency-of-addressing-ai-discrimination-transparency-accountability-and-regulatory-timelines/

- :are

- :este

- :nu

- :Unde

- a

- capacitate

- Despre Noi

- acces

- responsabilitate

- recunoscut

- act

- acțiuni

- adresa

- adresare

- adopta

- avantajos

- negativ

- afecta

- african

- împotriva

- agil

- AI

- AI Act

- Sisteme AI

- Instruire AI

- algoritmi

- acuzaţiile

- Cu toate ca

- american

- Amsterdam

- an

- și

- Anticipat

- Apple

- Cartea Apple

- aplicatii

- abordare

- aprobare

- aproximativ

- SUNT

- articol

- artificial

- inteligență artificială

- AS

- aspecte

- evalua

- evaluare

- asociate

- At

- audio

- audituri

- Automat

- automatizarea

- Bancar

- sectorul bancar

- Băncile

- bazat

- BE

- deveni

- devine

- fost

- în spatele

- beneficia

- Beneficiile

- părtinire

- părtinitor

- distorsiunilor

- Negru

- blockchain

- corp

- Aduce

- mai larg

- by

- apel

- CAN

- capacități

- card

- caz

- contesta

- provocări

- provocare

- Chat GPT

- Chicago

- copil

- creanțe

- clarificat

- CNBC

- Comunități

- Companii

- comparație

- plângere

- complex

- complexități

- complexitate

- Concepte

- preocupările

- efectuarea

- consolidare

- Consumatorii

- conține

- conţinut

- contrar

- a contribui

- convențional

- gânguri

- Crearea

- credit

- Criteriile de

- crucial

- cripto

- pericole

- de date

- infrastructura de date

- integrarea datelor

- calitatea datelor

- dezbateri

- zeci de ani

- Luarea deciziilor

- Deciziile

- Criterii demografice

- Departament

- depinde de

- desfășurarea

- Amenajări

- Dezvoltator

- în curs de dezvoltare

- diferit

- dificil

- dificultăți

- Director

- descoperire

- Discriminare

- discuţie

- distribuite

- Ledger distribuit

- tehnologie distribuită

- conducere

- două

- în timpul

- Olandeză

- Eficace

- în mod eficient

- eficacitate

- încorporat

- a apărut

- subliniază

- înconjura

- executare

- spori

- sporită

- asigura

- intrarea

- mai ales

- stabilirea

- etic

- etică

- european

- Chiar

- dovadă

- evident

- exemplu

- exemple

- cu experienţă

- a explicat

- explică

- Explorează

- expres

- Față

- fete

- factori

- familiar

- DESCRIERE

- puțini

- Fişiere

- financiar

- industriile financiare

- Institutii financiare

- Servicii financiare

- FinTech

- startup-uri fintech

- fintechs

- FIS

- Pentru

- frunte

- Fost

- fragmentată

- necinstit

- din

- fundamental

- Gen

- generaţie

- generativ

- AI generativă

- Caritate

- goldman

- Goldman Sachs

- mai mare

- În creştere

- rău

- Avea

- he

- cap

- puternic

- Evidențiat

- extrem de

- istoric

- Cum

- Totuși

- HTTPS

- identifica

- identificarea

- Punere în aplicare a

- implicații

- importanță

- impozant

- in

- include

- include

- Inclusiv

- independent

- persoane fizice

- industrii

- industrie

- inegalitățile

- informații

- informat

- Infrastructură

- inerent

- Inovaţie

- inovatoare

- Instituţional

- instituții

- integrală

- integrare

- integritate

- Inteligență

- Interviu

- în

- Prezintă

- implica

- implicat

- implicând

- problema

- probleme de

- IT

- ESTE

- cunoştinţe

- lipsă

- limbă

- Limbă

- mare

- conduce

- conducere

- învăţare

- carte mare

- împrumut

- efectului de pârghie

- li

- se află

- ușoară

- ca

- Limitat

- Limitele

- împrumut

- Credite

- local

- BĂNCILE LOCALE

- LOWER

- maşină

- masina de învățare

- Principal

- face

- Efectuarea

- Masa

- material

- Mai..

- semnificativ

- menționat

- Microsoft

- ar putea

- Dezinformare

- derutant

- model

- Modele

- Modern

- moment

- morală

- mai mult

- multiplu

- Națiuni

- Natură

- necesar

- Nevoie

- reţea

- Nou

- New York

- Statul New York

- New York Departamentul de Stat al Serviciilor Financiare

- neexperti

- notabil

- număr

- numeroși

- numeroase beneficii

- obținerea

- of

- oferi

- oferind

- de multe ori

- on

- on-line

- funcionar

- Oportunităţi

- or

- afară

- rezultate

- panou

- Discuții de grup

- parte

- trecut

- plată

- performanță

- periodic

- personalizare

- perspectivă

- Plato

- Informații despre date Platon

- PlatoData

- Punct

- puncte

- potenţial

- potenţial

- practică

- predominant

- presare

- împiedica

- Problemă

- procese

- Produse

- propuneri

- protecţie

- furniza

- prevăzut

- public

- Editare

- scopuri

- calitate

- Întrebări

- Rasă

- rasism

- ridicat

- ridică

- recunoaște

- reducerea

- referințe

- cu privire la

- reglementate

- Regulament

- autoritățile de reglementare

- se bazează

- remarcabil

- Raportarea

- restricții

- REZULTATE

- revoluționat

- Drepturile

- Risc

- Riscurile

- Sachs

- Scandal

- Școli

- scorurile

- notare

- răzuire

- sector

- selectarea

- selecţie

- Servicii

- indicat

- semnificație

- semnificativ

- asemănător

- soluţie

- soluţii

- Sursă

- vorbire

- specializata

- lansare

- Startup-urile

- Stat

- Departamentul de Stat

- Încă

- stocate

- rezistenţă

- astfel de

- REZUMAT

- Înconjurător

- rapid

- sistemice

- sisteme

- aborda

- ia

- direcționare

- tech

- tech

- tehnologi

- Tehnologia

- teste

- acea

- Sursa

- lor

- Acolo.

- astfel

- Acestea

- acest

- consumă timp

- cronologie

- cronologii

- la

- Unelte

- subiect

- Pregătire

- Transparență

- stare de nervozitate

- Două

- tipic

- inteligibil

- subscriere

- nedrept

- unic

- Unit

- Națiunile Unite

- spre deosebire de

- susține

- urgenţă

- utilizare

- utilizat

- diverse

- Video

- vizionar

- we

- Web3

- Asistență socială

- au fost

- cand

- care

- în timp ce

- cu

- în

- Femei

- lume

- WorldPay

- face griji

- ar

- ani

- York

- zephyrnet