După ani de dezvoltare, Meta poate să-și lanseze în sfârșit acceleratoarele AI de acasă într-un mod semnificativ în acest an.

Imperiul Facebook și-a confirmat dorința de a completa implementările GPU-urilor Nvidia H100 și AMD MI300X cu familia de cipuri Meta Training Inference Accelerator (MTIA) săptămâna aceasta. Mai exact, Meta va implementa un procesor optimizat pentru inferență, se spune că poartă numele de cod Artemis, bazat pe piesele de prima generație ale gigantului Silicon Valley dezlânat anul trecut.

„Suntem încântați de progresul pe care l-am făcut în eforturile noastre interne de siliciu cu MTIA și suntem pe cale să începem implementarea variantei noastre de inferență în producție în 2024”, a declarat un purtător de cuvânt al Meta. Registrul joi.

„Considerăm că acceleratoarele noastre dezvoltate intern sunt extrem de complementare cu GPU-urile disponibile comercial, oferind combinația optimă de performanță și eficiență pe sarcinile de lucru specifice Meta”, a continuat reprezentantul. Detalii? Nu. Purtătorul de cuvânt ne-a spus: „Așteptăm cu nerăbdare să împărtășim mai multe actualizări cu privire la planurile noastre viitoare MTIA în cursul acestui an.”

Considerăm asta ca însemnând că cip-ul axat pe inferență din a doua generație se lansează pe scară largă, în urma unei versiuni de laborator de prima generație pentru inferență și s-ar putea să aflăm mai târziu despre părțile destinate în primul rând antrenamentului sau instruirii și inferenței.

Meta a devenit unul dintre cei mai buni clienți ai Nvidia și AMD, deoarece implementarea sarcinilor de lucru AI a crescut, crescând nevoia și utilizarea de siliciu specializat pentru a face software-ul său de învățare automată să ruleze cât mai repede posibil. Astfel, decizia gigantului Instagram de a-și dezvolta propriile procesoare personalizate nu este chiar atât de surprinzătoare.

De fapt, mega-corporația, la prima vedere, este relativ întârziată la partidul personalizat de silicon AI în ceea ce privește implementarea în lumea reală. De câțiva ani, Amazon și Google folosesc componente de origine pentru a accelera sistemele interne de învățare automată, cum ar fi modelele de recomandare și codul ML pentru clienți. Între timp, Microsoft și-a dezvăluit acceleratoarele produse de acasă anul trecut.

Dar, dincolo de faptul că Meta lansează un cip de inferență MTIA la scară, rețeaua de socializare nu și-a dezvăluit arhitectura precisă și nici sarcinile de lucru pe care le rezervă pentru siliciul intern și pe care le descarcă pe GPU-urile AMD și Nvidia.

Este probabil că Meta va rula modele stabilite pe ASIC-urile sale personalizate pentru a elibera resurse GPU pentru aplicații mai dinamice sau în evoluție. L-am văzut pe Meta să meargă pe această cale cu acceleratoare personalizate concepute pentru a descărca date și pentru a calcula sarcini video intensive.

În ceea ce privește designul de bază, observatorii din industrie de la SemiAnalysis ne spun că noul cip se bazează îndeaproape pe arhitectura pieselor de primă generație ale Meta.

Pietre de trepte

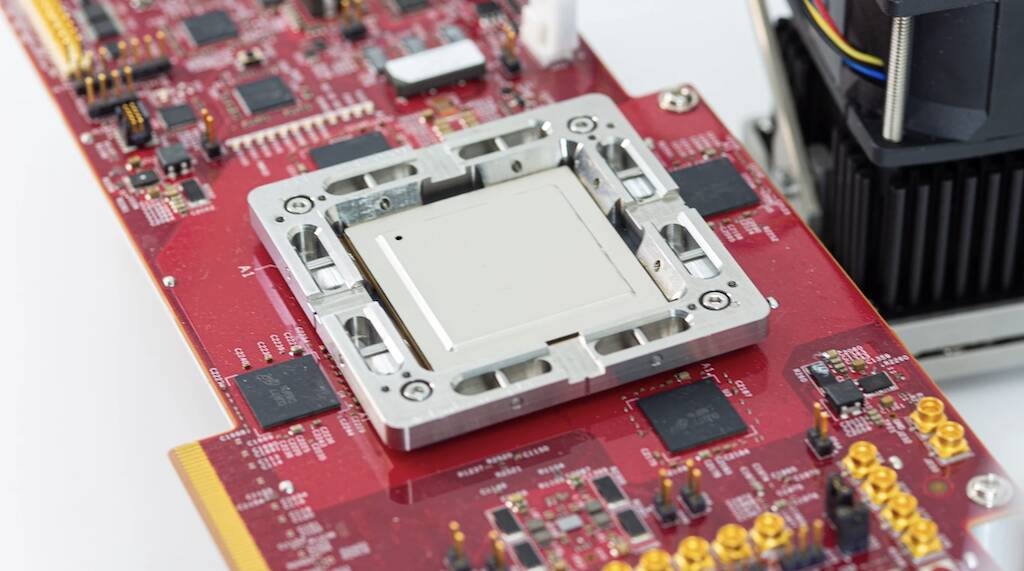

Anunțat la începutul anului 2023, după trei ani de dezvoltare, MTIA v1 componente ale lui Meta, pe care prietenii noștri de la Următoarea platformă sa uitat la în primăvara anului trecut, au fost concepute special având în vedere modelele de recomandare pentru învățare profundă.

Cipul de prima generație a fost construit în jurul unui cluster CPU RISC-V și creat folosind procesul de 7 nm al TSMC. Sub capotă, componenta a folosit o matrice de opt pe opt de elemente de procesare, fiecare echipată cu două nuclee CPU RV, dintre care unul este echipat cu extensii de matematică vectorială. Aceste nuclee se alimentează de la o SRAM generosă de 128 MB pe cip și până la 128 GB de memorie LPDDR5.

După cum a susținut Meta anul trecut, cipul a funcționat la 800 MHz și a depășit 102.4 trilioane de operațiuni pe secundă de performanță INT8 sau 51.2 teraFLOPS la jumătate de precizie (FP16). Prin comparație, H100 de la Nvidia este capabil de aproape patru petaFLOPS de performanță FP8 rară. Deși nici pe departe la fel de puternic precum GPU-urile Nvidia sau AMD, cipul avea un avantaj major: consumul de energie. Cipul în sine a avut o putere de proiectare termică de doar 25 de wați.

În conformitate cu Semianaliză, Cel mai recent cip al Meta se laudă cu nuclee îmbunătățite și schimbă LPDDR5 pentru memorie cu lățime de bandă mare, ambalată folosind tehnologia cip-on-wafer-on-substrate (CoWoS) de la TSMC.

O altă diferență notabilă este că cipul de a doua generație al lui Meta va avea de fapt o implementare pe scară largă în infrastructura centrului de date. Potrivit titanului Facebook, deși partea de primă generație a fost folosită pentru a rula modele de publicitate de producție, nu a părăsit niciodată laboratorul.

Urmărirea inteligenței generale artificiale

Lăsând deoparte părțile personalizate, părintele Facebook și Instagram a abandonat miliarde de dolari pe GPU-uri în ultimii ani pentru a accelera tot felul de sarcini nepotrivite platformelor CPU convenționale. Cu toate acestea, creșterea modelelor de limbaj mari, cum ar fi GPT-4 și propriul Llama 2 de la Meta, a schimbat peisajul și a determinat implementarea clusterelor GPU masive.

La scara pe care o operează Meta, aceste tendințe au necesitat schimbări drastice ale infrastructurii sale, inclusiv ale redesign a mai multor centre de date pentru a sprijini cerințele imense de putere și răcire asociate cu implementările mari de AI.

Iar implementările Meta vor deveni mai mari în următoarele câteva luni, pe măsură ce compania își va muta atenția de la metavers la dezvoltare a inteligenței generale artificiale. Se presupune că munca făcută pe AI va ajuta la formarea metaversului sau ceva de genul acesta.

Potrivit CEO-ului Mark Zuckerberg, Meta intenționează să implementeze până la 350,000 de Nvidia H100 doar în acest an.

Compania a anunțat, de asemenea, planuri de a implementa noi AMD a lansat GPU-urile MI300X în centrele sale de date. Zuckerberg a susținut că corporația sa va încheia anul cu o putere de calcul echivalentă a 600,000 de H100. Deci, în mod clar, cipurile MTIA de la Meta nu vor înlocui GPU-urile în curând. ®

- Distribuție de conținut bazat pe SEO și PR. Amplifică-te astăzi.

- PlatoData.Network Vertical Generative Ai. Împuterniciți-vă. Accesați Aici.

- PlatoAiStream. Web3 Intelligence. Cunoștințe amplificate. Accesați Aici.

- PlatoESG. carbon, CleanTech, Energie, Mediu inconjurator, Solar, Managementul deșeurilor. Accesați Aici.

- PlatoHealth. Biotehnologie și Inteligență pentru studii clinice. Accesați Aici.

- Sursa: https://go.theregister.com/feed/www.theregister.com/2024/02/02/meta_ai_chips/

- :are

- :este

- $UP

- 000

- 102

- 2%

- 2023

- 2024

- 25

- 350

- 4

- 51

- 600

- 800

- a

- Despre Noi

- accelera

- accelerator

- acceleratoare

- Conform

- peste

- de fapt

- Avantaj

- Promovare

- După

- AI

- TOATE

- singur

- pe langa

- de asemenea

- Amazon

- AMD

- an

- și

- a anunțat

- aplicatii

- arhitectură

- SUNT

- în jurul

- artificial

- inteligență generală artificială

- AS

- Asics

- deoparte

- asociate

- At

- disponibil

- bazat

- BE

- deveni

- fost

- înainte

- CEL MAI BUN

- Dincolo de

- biz

- se mândreşte cu

- construit

- by

- capabil

- CEO

- si-a schimbat hainele;

- Modificări

- cip

- Chips

- revendicat

- clar

- îndeaproape

- Grup

- CO

- cod

- comercial

- companie

- comparație

- complementar

- component

- componente

- Calcula

- tehnica de calcul

- puterea de calcul

- CONFIRMAT

- consum

- a continuat

- convențional

- CORPORAȚIE

- Procesor

- personalizat

- client

- clienţii care

- de date

- Datacenter

- decizie

- livrarea

- implementa

- Implementarea

- desfășurarea

- implementări

- Amenajări

- proiectat

- dorință

- detalii

- dezvolta

- dezvoltat

- Dezvoltare

- FĂCUT

- diferenţă

- de dolari

- făcut

- jos

- condus

- dinamic

- fiecare

- Devreme

- eficiență

- Eforturile

- oricare

- element

- Empire

- angajat

- capăt

- echipat

- Echivalent

- stabilit

- Eter (ETH)

- evoluție

- excitat

- extensii

- Față

- fapt

- familie

- FAST

- fed-

- puțini

- În cele din urmă

- Găsi

- Concentra

- următor

- Pentru

- formă

- Înainte

- patru

- Gratuit

- Prietenii lui

- din

- viitor

- General

- inteligenta generala

- generos

- obține

- gigant

- Go

- merge

- GPU

- unități de procesare grafică

- crescut

- HAD

- Jumătate

- Avea

- ajutor

- extrem de

- lui

- homegrown

- capotă

- Totuși

- HTTPS

- imens

- îmbunătățit

- in

- Inclusiv

- crescând

- industrie

- Infrastructură

- Inteligență

- destinate

- intensiv

- intern

- intern

- ISN

- IT

- ESTE

- în sine

- jpg

- doar

- de laborator

- peisaj

- limbă

- mare

- mai mare

- Nume

- Anul trecut

- Târziu

- mai tarziu

- Ultimele

- stânga

- ca

- Probabil

- Lamă

- Uite

- făcut

- major

- face

- manieră

- multe

- marca

- marca zuckerberg

- masiv

- matematica

- Matrice

- Mai..

- însemna

- semnificativ

- Între timp

- Memorie

- meta

- Metaverse

- Microsoft

- minte

- amesteca

- ML

- Modele

- luni

- mai mult

- În apropiere

- aproape

- Nevoie

- reţea

- nu

- Nou

- cip nou

- recent

- următor

- nici

- notabil

- Nvidia

- of

- on

- ONE

- afară

- opereaza

- Operațiuni

- optimă

- or

- al nostru

- afară

- peste

- propriu

- ambalate

- parte

- piese

- parte

- pentru

- performanță

- Planurile

- Platforme

- Plato

- Informații despre date Platon

- PlatoData

- posibil

- putere

- puternic

- precis

- Precizie

- în primul rând

- proces

- prelucrare

- procesor

- procesoare

- producere

- Progres

- RE

- lumea reală

- recent

- relativ

- Cerinţe

- Resurse

- Reuters

- Dezvăluit

- Ridica

- sul

- Rulare

- Traseul

- Alerga

- s

- Scară

- Al doilea

- vedea

- văzut

- câteva

- partajarea

- Ture

- Siliciu

- Silicon Valley

- So

- Social

- reţea socială

- Software

- unele

- ceva

- Curând

- rar

- de specialitate

- specific

- Purtatorul de cuvant al

- primăvară

- Începe

- astfel de

- completa

- a sustine

- surprinzător

- sisteme

- T

- luare

- sarcini

- tech

- spune

- termeni

- acea

- Peisajul

- Metaversul

- termic

- Acestea

- acest

- în această săptămână

- în acest an

- trei

- joi

- Prin urmare

- gigant

- la

- a spus

- depasit

- urmări

- meserii

- Pregătire

- Tendinţe

- Trilion

- tsmc

- Două

- în

- care stau la baza

- actualizări

- us

- utilizare

- utilizat

- folosind

- v1

- Vale

- Variantă

- Ve

- vector

- versiune

- Video

- a fost

- Cale..

- we

- săptămână

- au fost

- care

- în timp ce

- pe larg

- pe scară largă

- voi

- cu

- Castigat

- Apartamente

- ar

- an

- ani

- zephyrnet

- Zuckerberg