O lucrare tehnică intitulată „WWW: What, When, Where to Compute-in-Memory” a fost publicată de cercetătorii de la Universitatea Purdue.

Rezumat:

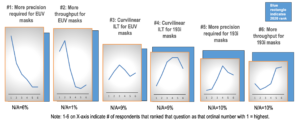

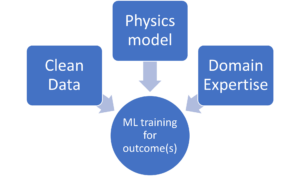

„Compute-in-memory (CiM) a apărut ca o soluție convingătoare pentru a reduce costurile ridicate de mișcare a datelor în mașinile von Neumann. CiM poate efectua operații de multiplicare generală a matricei (GEMM) masiv paralele în memorie, calculul dominant în inferența Machine Learning (ML). Cu toate acestea, reutilizarea memoriei pentru calcul pune întrebări cheie cu privire la 1) Ce tip de CiM să utilizați: Având în vedere o multitudine de CiM-uri analogice și digitale, este necesară determinarea adecvării acestora din perspectiva sistemelor. 2) Când să utilizați CiM: inferența ML include sarcini de lucru cu o varietate de cerințe de memorie și de calcul, ceea ce face dificilă identificarea când CiM este mai benefic decât nucleele de procesare standard. 3) Unde se integrează CiM: Fiecare nivel de memorie are lățime de bandă și capacitate diferite, ceea ce afectează mișcarea datelor și beneficiile localității ale integrării CiM.

În această lucrare, explorăm răspunsurile la aceste întrebări referitoare la integrarea CiM pentru accelerarea inferenței ML. Folosim Timeloop-Accelergy pentru evaluarea timpurie la nivel de sistem a prototipurilor CiM, inclusiv primitive analogice și digitale. Integram CiM în diferite niveluri de memorie cache într-o arhitectură de bază asemănătoare Nvidia A100 și adaptăm fluxul de date pentru diferite sarcini de lucru ML. Experimentele noastre arată că arhitecturile CiM îmbunătățesc eficiența energetică, obținând o energie de până la 0.12 ori mai mică decât linia de bază stabilită cu precizie INT-8 și câștiguri de performanță de până la 4x cu intercalarea și duplicarea greutății. Lucrarea propusă oferă informații despre tipul de CiM de utilizat și când și unde să îl integreze optim în ierarhia cache-ului pentru accelerarea GEMM.”

Găsi lucrare tehnică aici. Publicat în decembrie 2023 (preprint).

Sharma, Tanvi, Mustafa Ali, Indranil Chakraborty și Kaushik Roy. „WWW: Ce, când, unde să se calculeze în memorie.” arXiv preprint arXiv:2312.15896 (2023).

Citire asemănătoare

Creșterea eficienței energetice AI cu calculul în memorie

Cum să procesați sarcinile de lucru la scară zetta și să rămâneți într-un buget fix de energie.

Modelarea calculului în memorie cu eficiență biologică

AI generativă îi obligă pe producătorii de cipuri să folosească resursele de calcul mai inteligent.

SRAM în AI: viitorul memoriei

De ce SRAM este privit ca un element critic în arhitecturile de calcul noi și tradiționale.

- Distribuție de conținut bazat pe SEO și PR. Amplifică-te astăzi.

- PlatoData.Network Vertical Generative Ai. Împuterniciți-vă. Accesați Aici.

- PlatoAiStream. Web3 Intelligence. Cunoștințe amplificate. Accesați Aici.

- PlatoESG. carbon, CleanTech, Energie, Mediu inconjurator, Solar, Managementul deșeurilor. Accesați Aici.

- PlatoHealth. Biotehnologie și Inteligență pentru studii clinice. Accesați Aici.

- Sursa: https://semiengineering.com/cim-integration-for-ml-inference-acceleration/

- :are

- :este

- :Unde

- $UP

- 1

- 2023

- a

- accelerare

- realizarea

- AI

- atenua

- an

- și

- răspunsuri

- arhitectură

- AS

- At

- Lățime de bandă

- De bază

- benefică

- Beneficiile

- atât

- buget

- by

- cache

- CAN

- Capacitate

- convingătoare

- calcul

- Calcula

- Cheltuieli

- critic

- de date

- decembrie

- determinarea

- diferit

- dificil

- digital

- dominant

- fiecare

- Devreme

- eficiență

- element

- a apărut

- energie

- eficiența energetică

- stabilit

- evaluare

- experimente

- explora

- fixată

- Pentru

- Forțele

- din

- viitor

- câștig

- General

- dat

- aici

- ierarhie

- Înalt

- Totuși

- HTTPS

- identifica

- îmbunătăţi

- in

- include

- Inclusiv

- perspective

- integra

- integrare

- în

- IT

- jpg

- Cheie

- învăţare

- Nivel

- nivelurile de

- LOWER

- maşină

- masina de învățare

- Masini

- Efectuarea

- masiv

- Matrice

- Memorie

- ML

- mai mult

- mişcare

- multitudine

- necesar

- Nou

- Nvidia

- of

- on

- deschide

- Operațiuni

- al nostru

- Hârtie

- Paralel

- efectua

- performanță

- perspectivă

- Plato

- Informații despre date Platon

- PlatoData

- ridică

- putere

- Precizie

- proces

- prelucrare

- propus

- prototipuri

- furnizează

- publicat

- Întrebări

- cu privire la

- Cerinţe

- cercetători

- Resurse

- Roy

- Arăta

- soluţie

- standard

- şedere

- potrivire

- sisteme

- Tehnic

- decât

- acea

- Viitorul

- lor

- Acestea

- acest

- cu denumirea

- la

- tradiţional

- tip

- universitate

- utilizare

- varietate

- diverse

- vizualizate

- de

- a fost

- we

- greutate

- Ce

- cand

- cu

- în

- Apartamente

- zephyrnet