Robolawyer. Credit: Midjourney

Dacă îmi citiți munca, probabil că știți că îmi public articolele în primul rând în buletinul informativ AI, Podul algoritmic. Ceea ce poate nu știți este că în fiecare duminică public o rubrică specială pe care o numesc „ce s-ar putea să fi ratat”, unde trec în revistă tot ce s-a întâmplat în timpul săptămânii cu analize care te ajută să dai sens știrilor.

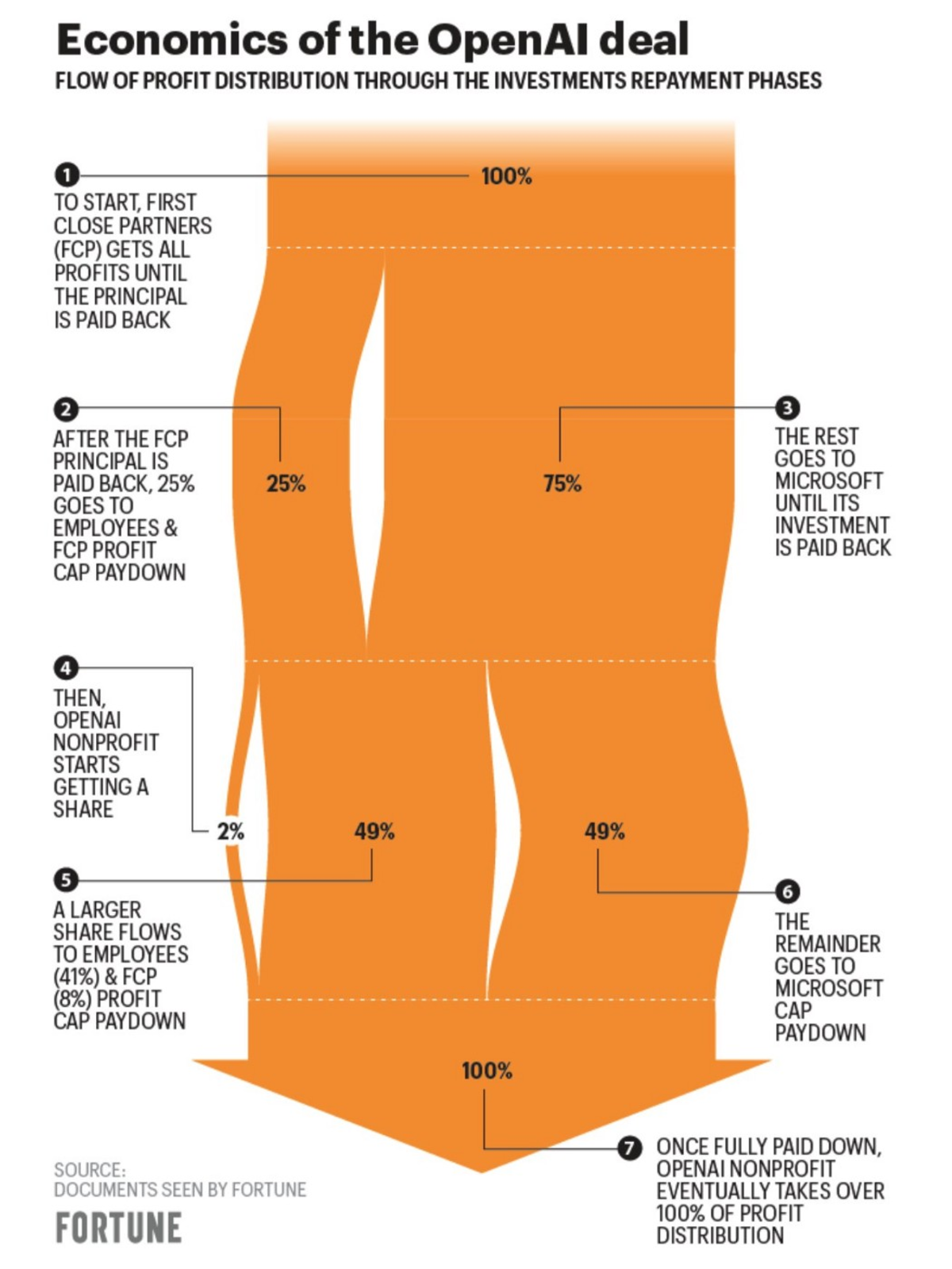

Acord Microsoft-OpenAI de 10 miliarde de dolari

Semafor a raportat în urmă cu două săptămâni, că, dacă totul decurge conform planului, Microsoft va încheia un acord de investiții de 10 miliarde USD cu OpenAI înainte de sfârșitul lunii ianuarie (Satya Nadella, CEO-ul Microsoft, a anunțat că parteneriat extins oficial luni).

Au existat informații greșite despre înțelegere, ceea ce a implicat că directorii OpenAI nu erau siguri de viabilitatea pe termen lung a companiei. In orice caz, s-a clarificat ulterior că afacerea arată așa:

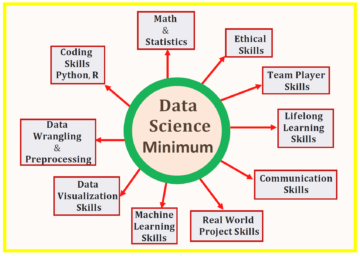

Credit: Avere

Leo L'Orange, care scrie The Neuron, explică că „odată ce 92 de miliarde de dolari în profit plus 13 de miliarde de dolari în investiții inițiale sunt rambursate către Microsoft și odată ce ceilalți investitori de risc câștigă 150 de miliarde de dolari, toate capitalurile revin înapoi la OpenAI”.

Oamenii sunt împărțiți. Unii spun că afacerea este „mișto” sau „interesant”, în timp ce alții spun că este „ciudat” și „nebun”. Ceea ce percep cu ochii mei neexperti este că OpenAI și Sam Altman do încredere (ar spune unii supraîncredere) capacitatea pe termen lung a companiei de a-și atinge obiectivele.

Cu toate acestea, ca Will Knight scrie pentru WIRED, „nu este clar ce produse pot fi construite pe baza tehnologiei.” OpenAI trebuie să descopere un model de afaceri viabil în curând.

Modificări aduse ChatGPT: funcții noi și generare de bani

OpenAI a actualizat ChatGPT pe 9 ianuarie (din actualizarea anterioară din 15 decembrie). Acum chatbot-ul are „factualitate îmbunătățită” și îl puteți opri la mijlocul generației.

De asemenea, lucrează la o „versiune profesională a ChatGPT” (care se zvonește că va fi lansată la $ 42 / luna) în calitate de președinte al OpenAI a anunțat Greg Brockman pe 11 ianuarie. Acestea sunt cele trei caracteristici principale:

„Întotdeauna disponibil (fără ferestre opace).

Răspunsuri rapide de la ChatGPT (adică fără limitare).

Câte mesaje aveți nevoie (cel puțin 2X limita zilnică normală).”

Pentru a vă înscrie pe lista de așteptare trebuie completează un formular unde te întreabă, printre altele, cât ai fi dispus să plătești (și cât ar fi prea mult).

Dacă intenționați să o luați în serios, ar trebui să vă gândiți să vă aprofundați în stiva de produse OpenAI cu Repoziție pentru cărți de bucate OpenAI. Bojan Tunguz a spus că este „cel mai popular repo pe GitHub luna aceasta.” Întotdeauna un semn bun.

ChatGPT, falsul om de știință

ChatGPT a intrat în domeniul științific. Kareem Carr a postat joi o captură de ecran a unei lucrări în care ChatGPT este co-autor.

Dar de ce, având în vedere că ChatGPT este un instrument? „Oamenii încep să trateze ChatGPT ca și cum ar fi un științific de bună-credință, bine acreditat colaborator”, explică Gary Marcus într-o postare Substack. „Oameni de știință, vă rugăm să nu vă lăsați chatbot-ii să devină co-autori”, roagă el.

Mai îngrijorătoare sunt acele cazuri în care nu există nicio dezvăluire a utilizării AI. Oamenii de știință am găsit că nu pot identifica în mod fiabil rezumatele scrise de ChatGPT - prostii sale elocvente prostesc chiar și experții în domeniul lor. După cum i-a spus lui Holly Else Sandra Wachter, care „studiază tehnologia și reglementările” la Oxford o bucată despre natură:

„Dacă ne aflăm acum într-o situație în care experții nu sunt capabili să determine ce este adevărat sau nu, pierdem intermediarul de care avem nevoie disperată pentru a ne ghida prin subiecte complicate.”

Provocarea ChatGPT pentru educație

ChatGPT a fost interzis în centrele educaționale de pe tot globul (de ex școli publice din New York, Universități australiene, și lectori din Marea Britanie se gândesc la asta). După cum am argumentat în un eseu anterior, nu cred că aceasta este cea mai înțeleaptă decizie, ci doar o reacție din cauza nepregătirii pentru dezvoltarea rapidă a IA generativă.

Kevin Roose de la NYT se ceartă că „Potențialul [ChatGPT] ca instrument educațional depășește riscurile sale.” Terence Tao, marele matematician, este de acord: „Pe termen lung, pare inutil să lupți împotriva acestui lucru; poate ceea ce noi, ca lectori, trebuie să facem este să trecem la un mod de examinare „cărți deschise, IA deschisă”.

Giada Pistilli, eticianul principal la Hugging Face, explică provocarea cu care se confruntă școlile cu ChatGPT:

„Din păcate, sistemul educațional pare nevoit să se adapteze la aceste noi tehnologii. Cred că este de înțeles ca reacție, deoarece nu s-a făcut mare lucru pentru a anticipa, a atenua sau a elabora soluții alternative pentru a contura eventualele probleme rezultate. Tehnologiile perturbatoare necesită adesea educația utilizatorilor, deoarece nu pot fi pur și simplu aruncate asupra oamenilor în mod necontrolat.”

Ultima propoziție surprinde perfect unde apare problema și se află potențiala soluție. Trebuie să facem un efort suplimentar pentru a educa utilizatorii cu privire la modul în care funcționează această tehnologie și ce este posibil și nu de a face cu ei. Aceasta este abordarea pe care a luat-o Catalonia. La fel de Raportează Francesc Bracero și Carina Farreras pentru La Vanguardia:

„În Catalonia, Departamentul Educației nu o va interzice „în întregul sistem și pentru toată lumea, deoarece aceasta ar fi o măsură ineficientă”. Potrivit unor surse din minister, este mai bine să ceri centrelor să educe în utilizarea IA, „care poate oferi o mulțime de cunoștințe și avantaje”.

Cel mai bun prieten al studentului: o bază de date cu erori ChatGPT

Gary Marcus și Ernest Davis au înființat un „urmăritor de erori” pentru a capta și clasifica erorile pe care modelele de limbaj precum ChatGPT le fac (aici mai multe informatii despre motivul pentru care alcătuiesc acest document și ce intenționează să facă cu el).

Baza de date este publică și poate participa oricine. Este o resursă grozavă care permite studiul riguros al modului în care aceste modele se comportă incorect și al modului în care oamenii ar putea evita utilizarea greșită. Iată un exemplu hilar de ce contează acest lucru:

OpenAI este conștient de acest lucru și vrea să lupte împotriva dezinformării și a dezinformării: „Prognoza potențialelor utilizări greșite ale modelelor de limbaj pentru campaniile de dezinformare – și cum să reduceți riscul. "

Informație nouă

a sugerat Sam Altman la o întârziere a lansării lui GPT-4 într-o conversație cu Connie Loizos, editorul Silicon Valley la TechCrunch. Altman a spus că „în general, vom lansa tehnologia mult mai încet decât și-ar dori oamenii. Vom sta mult mai mult timp pe el...” Aceasta este părerea mea:

(Altman a mai spus că este în lucru un model video!)

Informații greșite despre GPT-4

Există o afirmație „GPT-4 = 100T” care devine virală peste tot pe rețelele sociale (am văzut-o mai ales pe Twitter și LinkedIn). În cazul în care nu l-ați văzut, arată așa:

Sau asta:

Toate sunt versiuni ușor diferite ale aceluiași lucru: un grafic vizual atrăgător care captează atenția și un cârlig puternic cu comparația GPT-4/GPT-3 (folosesc GPT-3 ca proxy pentru ChatGPT).

Cred că împărtășirea zvonurilor și speculațiilor și a le încadra ca atare este în regulă (Mă simt parțial responsabil pentru asta), dar postarea de informații neverificabile cu un ton autoritar și fără referințe este condamnabilă.

Oamenii care fac acest lucru nu sunt departe de a fi la fel de inutili și periculoși ca surse de informații precum ChatGPT - și cu stimulente mult mai puternice pentru a continua să o facă. Atenție la acest lucru, deoarece va polua fiecare canal de informații despre AI în viitor.

Un avocat robot

Joshua Browder, CEO la DoNotPay, a postat asta pe 9 ianuarie:

Cum nu se putea altfel, această afirmație îndrăzneață a generat multa dezbatere până la punctul în care Twitter acum semnalează tweet-ul cu un link către Pagina Curții Supreme cu articole interzise.

Chiar dacă în cele din urmă nu o pot face din motive legale, merită să luăm în considerare întrebarea din punct de vedere etic și social. Ce se întâmplă dacă sistemul AI face o greșeală gravă? Ar putea persoane fără acces ca un avocat să beneficieze de o versiune matură a acestei tehnologii?

Litigiul împotriva Stable Diffusion a început

Matthew Butterick a publicat asta pe 13 ianuarie:

„În numele a trei minunați reclamanți artiști - Sarah Andersen, Kelly McKernan, și Karla Ortiz — am intentat un proces colectiv împotriva Stabilitate AI, DeviantArt, și Mijlocul călătoriei pentru utilizarea lor de Difuzie stabilă, un instrument de colaj din secolul al XXI-lea care remixează lucrările protejate prin drepturi de autor ale milioanelor de artiști ale căror lucrări au fost folosite ca date de antrenament.”

Începe — primii pași în ceea ce promite a fi o luptă lungă pentru a modera antrenamentul și utilizarea IA generativă. Sunt de acord cu motivația: „AI trebuie să fie corectă și etică pentru toată lumea.”

Dar, ca mulți alții, am găsit inexactități în postarea de pe blog. Intră adânc în aspectele tehnice ale Stable Diffusion, dar nu reușește să explice corect unele părți. Dacă acest lucru este intenționat ca mijloc de a reduce decalajul tehnic pentru oamenii care nu știu - și nu au timp să învețe - despre cum funcționează această tehnologie (sau ca mijloc de a caracteriza tehnologia într-un mod care să-i avantajeze pe ei) ) sau o greșeală este deschisă speculațiilor.

Am certat într-un articol anterior că în acest moment ciocnirea dintre arta AI și artiștii tradiționali este puternic emoționantă. Răspunsurile la acest proces nu vor fi diferite. Va trebui să așteptăm ca judecătorii să decidă rezultatul.

CNET publică articole generate de AI

Futurismul raportat asta acum cateva saptamani:

CNET, un canal de știri tehnologic foarte popular, a folosit în liniște ajutorul „tehnologiei de automatizare” – un eufemism stilistic pentru AI – într-un nou val de articole explicative financiare.”

Gael Breton, care a observat primul asta, a scris o analiză mai profundă vineri. El explică că Google nu pare să împiedice traficul către aceste postări. „Conținutul AI este ok acum?” el intreaba.

Mi se pare decizia CNET pentru a dezvălui pe deplin utilizarea AI în articolele lor un precedent bun. Câți oameni publică conținut acum folosind AI fără a-l dezvălui? Cu toate acestea, consecința este că oamenii își pot pierde locul de muncă dacă acest lucru funcționează (cum eu și mulți alții, a prezis). Se întâmplă deja:

Sunt pe deplin de acord cu acest Tweet de la Santiago:

RLHF pentru generarea de imagini

Dacă învățarea prin consolidare prin feedback uman funcționează pentru modelele lingvistice, de ce nu pentru text-to-image? Asta încearcă să obțină PickaPic.

Demo-ul este în scopuri de cercetare, dar ar putea fi o completare interesantă pentru Stable Diffusion sau DALL-E (Midjourney face ceva similar - ei ghidează intern modelul pentru a scoate imagini frumoase și artistice).

O rețetă pentru „a face Siri/Alexa de 10 ori mai bun”

Rețete care amestecă diferite modele AI generative pentru a crea unele mai bune decât suma părților:

Alberto Romero este un scriitor independent care se concentrează pe tehnologie și AI. El scrie Podul algoritmic, un buletin informativ care ajută persoanele netehnice să dea sens știrilor și evenimentelor despre AI. De asemenea, este analist tehnologic la CambrianAI, unde este specializat în modele de limbaj mari.

Original. Repostat cu permisiunea.

- Distribuție de conținut bazat pe SEO și PR. Amplifică-te astăzi.

- Platoblockchain. Web3 Metaverse Intelligence. Cunoștințe amplificate. Accesați Aici.

- Sursa: https://www.kdnuggets.com/2023/02/chatgpt-gpt4-generative-ai-news.html?utm_source=rss&utm_medium=rss&utm_campaign=chatgpt-gpt-4-and-more-generative-ai-news

- 11

- 7

- 9

- a

- capacitate

- Capabil

- Despre Noi

- despre

- rezumate

- Conform

- Obține

- peste

- adapta

- plus

- Avantajele

- împotriva

- AI

- ai art

- algoritmică

- TOATE

- permite

- deja

- alternativă

- mereu

- printre

- analiză

- analist

- și

- a anunțat

- anticipa

- oricine

- interesant

- abordare

- Artă

- bunuri

- artistic

- Artiști

- atenţie

- disponibil

- înapoi

- interzis

- frumos

- deoarece

- înainte

- fiind

- beneficia

- Beneficiile

- CEL MAI BUN

- Mai bine

- între

- Ai grijă

- Miliard

- Blog

- Manuale

- POD

- construit

- afaceri

- model de afaceri

- apel

- Campanii

- nu poti

- captura

- capturi

- caz

- cazuri

- Centre

- CEO

- contesta

- Canal

- caracteriza

- chatbot

- chatbots

- Chat GPT

- pretinde

- ciocnire

- Clasifica

- Închide

- CNET

- Coautor

- Coloană

- COM

- Compania

- comparație

- complicat

- Lua în considerare

- luand in considerare

- conţinut

- Conversație

- ar putea

- Cuplu

- Tribunal

- crea

- credit

- zilnic

- dall-e

- Periculos

- de date

- Baza de date

- Davis

- afacere

- decizie

- adânc

- Mai adânc

- întârziere

- Cerere

- Departament

- Determina

- Dezvoltare

- diferit

- difuziune

- dezvălui

- Dezvăluirea

- dezvăluire

- dezinformare

- brizant

- împărțit

- document

- Nu

- face

- domeniu

- Dont

- în timpul

- câștiga

- editor

- educa

- Educaţie

- de învăţământ

- efort

- Elaborat

- a intrat

- Întreg

- echitate

- Erori

- Eter (ETH)

- etic

- Chiar

- evenimente

- Fiecare

- toată lumea

- tot

- exemplu

- Execs

- experți

- Explica

- explică

- suplimentar

- Ochi

- Față

- eșuează

- echitabil

- fals

- FAST

- DESCRIERE

- feedback-ul

- camp

- luptă

- Figura

- În cele din urmă

- financiar

- Găsi

- First

- primii pasi

- steaguri

- se concentrează

- primordial

- Înainte

- găsit

- independent

- prieten

- din

- complet

- decalaj

- Gary

- General

- generativ

- AI generativă

- GitHub

- dat

- glob

- Go

- Goluri

- Merge

- merge

- bine

- grafic

- mare

- Crește

- ghida

- sa întâmplat

- se întâmplă

- ajutor

- ajută

- vesel

- Cum

- Cum Pentru a

- Totuși

- HTML

- HTTPS

- uman

- identifica

- imagine

- imagini

- implicite

- in

- stimulente

- info

- informații

- inițială

- Intenționat

- interesant

- intern

- investiţie

- Investitori

- IT

- Jan

- ianuarie

- Locuri de munca

- KDnuggets

- A pastra

- Cavaler

- Cunoaște

- cunoştinţe

- limbă

- mare

- Nume

- proces

- avocat

- AFLAȚI

- învăţare

- Legal

- LIMITĂ

- LINK

- Lung

- pe termen lung

- Se pare

- pierde

- Lot

- Principal

- face

- FACE

- multe

- mulți oameni

- Marcus

- masiv

- materie

- matur

- mijloace

- măsura

- Mass-media

- mediu

- pur și simplu

- mesaje

- Microsoft

- MidJourney

- minister

- Dezinformare

- greşeală

- diminua

- mod

- model

- Modele

- luni

- mai mult

- motivaţia

- muta

- Natură

- Nevoie

- nevoilor

- Nou

- Funcții noi

- Noi tehnologii

- ştiri

- Ştiri şi Evenimente

- Stiri lunare via e-mail

- non tehnic

- Oficial

- Bine

- deschide

- OpenAI

- Altele

- Altele

- in caz contrar

- Rezultat

- Oxford

- Hârtie

- participa

- piese

- Plătește

- oameni

- poate

- permisiune

- bucată

- plan

- Plato

- Informații despre date Platon

- PlatoData

- pledează

- "vă rog"

- la care se adauga

- Punct

- Popular

- posibil

- Post

- postat

- postări

- potenţial

- Precedent

- precedent

- Principal

- probabil

- Problemă

- probleme

- Produs

- Produse

- Profit

- interzice

- Promisiuni

- furniza

- împuternicit

- public

- publica

- Editare

- scopuri

- întrebare

- cuminte

- reacţie

- Citeste

- motive

- reţetă

- reduce

- referințe

- regulat

- Consolidarea învățării

- eliberaţi

- cercetare

- resursă

- responsabil

- rezultând

- revizuiască

- riguros

- Riscurile

- robot

- Zvonurile

- Said

- Sam

- acelaşi

- Satya Nadella

- Școli

- pare

- semafor

- sens

- propoziție

- serios

- set

- partajarea

- să

- semna

- Siliciu

- Silicon Valley

- asemănător

- pur şi simplu

- întrucât

- situație

- ușor diferite

- Încet

- Social

- social media

- soluţie

- soluţii

- unele

- ceva

- Curând

- Surse

- special

- specializată

- speculație

- stabil

- stivui

- Pornire

- paşi

- Stop

- puternic

- puternic

- tare

- Studiu

- astfel de

- sistem

- Lua

- tech

- tech de știri

- TechCrunch

- Tehnic

- Tehnologii

- Tehnologia

- lor

- lucru

- lucruri

- Gândire

- trei

- Prin

- timp

- la

- TONE

- de asemenea

- instrument

- top

- subiecte

- tradiţional

- trafic

- Pregătire

- trata

- trend

- adevărat

- Încredere

- tweet

- stare de nervozitate

- typeform

- inteligibil

- Actualizează

- actualizat

- us

- utilizare

- Utilizator

- utilizatorii

- Vale

- aventura

- versiune

- viabilitate

- viabil

- Video

- aștepta

- Val

- săptămână

- săptămâni

- Ce

- dacă

- care

- OMS

- voi

- dispus

- ferestre

- fără

- Apartamente

- de lucru

- fabrică

- valoare

- ar

- scriitor

- scris

- Ta

- zephyrnet