Introducere

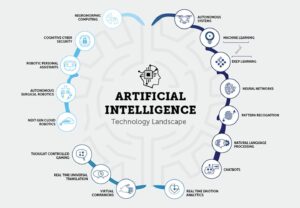

Pe măsură ce domeniul inteligenței artificiale (AI) continuă să crească și să evolueze, devine din ce în ce mai important pentru dezvoltatorii de inteligență artificială aspiranți să rămână la curent cu cele mai recente cercetări și progrese. Una dintre cele mai bune modalități de a face acest lucru este citirea documentelor AI pentru dezvoltatorii GenAI, care oferă informații valoroase despre tehnici și algoritmi de ultimă oră. Acest articol va explora 15 lucrări esențiale AI pentru dezvoltatorii GenAI. Aceste lucrări acoperă diverse subiecte, de la procesarea limbajului natural până la viziunea computerizată. Ele vă vor îmbunătăți înțelegerea AI și vă vor crește șansele de a obține primul loc de muncă în acest domeniu interesant.

Importanța documentelor AI pentru dezvoltatorii GenAI

Documentele AI pentru dezvoltatorii GenAI permit cercetătorilor și experților să-și împărtășească descoperirile, metodologiile și descoperirile cu comunitatea mai largă. Citind aceste lucrări, obțineți acces la cele mai recente progrese în AI, permițându-vă să rămâneți în fruntea curbei și să luați decizii informate în munca dvs. Mai mult, documentele AI pentru dezvoltatorii GenAI oferă adesea explicații detaliate ale algoritmilor și tehnicilor, oferindu-vă o înțelegere mai profundă a modului în care funcționează și a modului în care pot fi aplicate la problemele din lumea reală.

Citirea documentelor AI pentru dezvoltatorii GenAI oferă mai multe beneficii pentru dezvoltatorii AI aspiranți. În primul rând, vă ajută să fiți la curent cu cele mai recente cercetări și tendințe în domeniu. Aceste cunoștințe sunt esențiale atunci când aplică pentru joburi legate de IA, deoarece angajatorii caută adesea candidați familiarizați cu cele mai recente progrese. În plus, citirea lucrărilor AI vă permite să vă extindeți cunoștințele și să obțineți o înțelegere mai profundă a conceptelor și metodologiilor AI. Aceste cunoștințe pot fi aplicate proiectelor și cercetărilor dvs., făcându-vă un dezvoltator AI mai competent și mai priceput.

Cuprins

O prezentare generală: documente esențiale AI pentru dezvoltatorii GenAI cu legături

Lucrarea 1: Transformers: Atenția este tot ce aveți nevoie

Legătură: Citiți aici

Rezumatul hârtiei

Lucrarea prezintă Transformerul, o nouă arhitectură de rețea neuronală pentru sarcini de transducție a secvenței, cum ar fi traducerea automată. Spre deosebire de modelele tradiționale bazate pe rețele neuronale recurente sau convoluționale, Transformerul se bazează exclusiv pe mecanisme de atenție, eliminând necesitatea recurenței și a convoluțiilor. Autorii susțin că această arhitectură oferă performanțe superioare în ceea ce privește calitatea traducerii, paralelizare sporită și timp redus de antrenament.

Perspective cheie ale documentelor AI pentru dezvoltatorii GenAI

- Mecanismul de atenție

Transformerul este construit în întregime pe mecanisme de atenție, permițându-i să capteze dependențele globale dintre secvențele de intrare și de ieșire. Această abordare permite modelului să ia în considerare relațiile fără a fi limitat de distanța dintre elementele din secvențe.

- Paralelizare

Un avantaj major al arhitecturii Transformer este paralelizarea sporită. Modelele recurente tradiționale suferă de calcul secvenţial, ceea ce face ca paralelizarea să fie dificilă. Designul Transformerului permite o procesare paralelă mai eficientă în timpul antrenamentului, reducând timpul de antrenament.

- Calitate superioară și eficiență

Lucrarea prezintă rezultate experimentale privind sarcinile de traducere automată, demonstrând că Transformer atinge o calitate superioară a traducerii în comparație cu modelele existente. Depășește rezultatele anterioare de ultimă generație, inclusiv modelele de ansamblu, cu o marjă semnificativă. În plus, Transformerul realizează aceste rezultate cu un timp de antrenament considerabil mai mic.

- Performanță de traducere

La sarcina de traducere din engleză în germană WMT 2014, modelul propus atinge un scor BLEU de 28.4, depășind cele mai bune rezultate existente cu peste 2 BLEU. În ceea ce privește sarcina de la engleză la franceză, modelul stabilește un nou scor BLEU de ultimă generație pentru un singur model de 41.8 după antrenament timp de doar 3.5 zile pe opt GPU-uri.

- Generalizare la alte sarciniAutorii demonstrează că arhitectura Transformer se generalizează bine la sarcini dincolo de traducerea automată. Ei aplică cu succes modelul la analizarea circumscripției engleze, arătând adaptabilitatea acestuia la diferite probleme de transducție a secvenței.

Lucrarea 2: BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding

Legătură: Citiți aici

Rezumatul hârtiei

Preinstruirea modelului de limbaj s-a dovedit eficientă pentru îmbunătățirea diferitelor sarcini de procesare a limbajului natural. Lucrarea face distincție între abordările bazate pe caracteristici și cele de reglare fină pentru aplicarea reprezentărilor limbajului pre-antrenat. BERT este introdus pentru a aborda limitările abordărilor de reglare fină, în special constrângerea unidirecțională a modelelor de limbaj standard. Lucrarea propune un obiectiv de pre-training „Masked Language Model” (MLM), inspirat de sarcina Cloze, pentru a permite reprezentări bidirecționale. O sarcină de „predicire a următoarei propoziții” este, de asemenea, utilizată pentru a antrena împreună reprezentările perechi de text.

Perspective cheie ale documentelor AI pentru dezvoltatorii GenAI

- Importanța pre-antrenamentului bidirecțională

Lucrarea subliniază semnificația pre-antrenării bidirecționale pentru reprezentările limbajului. Spre deosebire de modelele anterioare, BERT utilizează modele de limbaj mascat pentru a permite reprezentări bidirecționale profunde, depășind modelele de limbaj unidirecționale utilizate de lucrările anterioare.

- Reducerea arhitecturilor specifice sarcinilor

BERT demonstrează că reprezentările pre-antrenate reduc nevoia de arhitecturi puternic proiectate specifice sarcinilor. Devine primul model de reprezentare bazat pe reglaj fin care realizează performanțe de ultimă generație într-o gamă variată de sarcini la nivel de propoziție și la nivel de simbol, depășind arhitecturile specifice sarcinilor.

- Progrese de ultimă generație

BERT obține rezultate noi de ultimă generație la unsprezece sarcini de procesare a limbajului natural, arătându-și versatilitatea. Îmbunătățirile notabile includ o creștere substanțială a scorului GLUE, acuratețea MultiNLI și îmbunătățiri în sarcinile de răspuns la întrebări SQuAD v1.1 și v2.0.

De asemenea, puteți citi: Ajustarea BERT cu modelarea limbajului mascat

Lucrarea 3: GPT: Modelele lingvistice sunt elevi puțini

Legătură: Citiți aici

Rezumatul hârtiei

Lucrarea discută îmbunătățirile obținute în sarcinile de procesare a limbajului natural (NLP) prin extinderea modelelor de limbaj, concentrându-se pe GPT-3 (Generative Pre-trained Transformer 3), un model de limbaj autoregresiv cu 175 de miliarde de parametri. Autorii evidențiază că, deși recent Modele NLP demonstrează câștiguri substanțiale prin pre-instruire și reglare fină, ele necesită adesea seturi de date specifice sarcinii cu mii de exemple pentru reglare fină. În schimb, oamenii pot efectua noi sarcini de limbaj cu câteva exemple sau instrucțiuni simple.

Perspective cheie ale documentelor AI pentru dezvoltatorii GenAI

- Creșterea îmbunătățește performanța cu câteva fotografii

Autorii demonstrează că extinderea modelelor de limbaj îmbunătățește în mod semnificativ performanța agnostică a sarcinilor, cu puține rezultate. GPT-3, cu dimensiunea mare a parametrilor, atinge uneori competitivitate cu abordări de reglare fină de ultimă generație, fără reglaj fin sau actualizări de gradient specifice sarcinii.

- Aplicabilitate largă

GPT-3 prezintă performanțe puternice în diverse sarcini NLP, inclusiv traducere, răspunsuri la întrebări, sarcini de închidere și sarcini care necesită raționament din mers sau adaptare la domeniu. - Provocări și limitări

În timp ce GPT-3 prezintă capacități de învățare remarcabile, autorii identifică seturile de date în care se confruntă cu probleme și evidențiază problemele metodologice legate de formarea pe corpuri web mari. - Generarea articolelor asemănătoare omului

GPT-3 poate genera articole de știri pe care evaluatorii umani le distinge greu de articolele scrise de oameni. - Impacturi societale și considerații mai ample

Lucrarea discută efectele societale mai ample ale capacităților GPT-3, în special în generarea de text asemănător omului. Implicațiile performanței sale în diverse sarcini sunt luate în considerare în termeni de aplicații practice și provocări potențiale. - Limitările abordărilor actuale ale NLP

Autorii evidențiază limitările abordărilor actuale NLP, în special dependența lor de seturile de date de reglare fină specifice sarcinilor, care ridică provocări, cum ar fi cerințele pentru seturi de date mari etichetate și riscul de supraadaptare la distribuțiile de sarcini înguste. În plus, apar preocupări cu privire la capacitatea de generalizare a acestor modele în afara limitelor distribuției lor de antrenament.

Lucrarea 4: CNN-uri: Clasificare ImageNet cu rețele neuronale convoluționale profunde

Legătură: Citiți aici

Rezumatul hârtiei

Lucrarea descrie dezvoltarea și antrenarea unei rețele neuronale convoluționale (CNN) mari și profunde pentru clasificarea imaginilor pe seturile de date ImageNet Large Scale Visual Recognition Challenge (ILSVRC). Modelul realizează îmbunătățiri semnificative ale preciziei clasificării în comparație cu metodele anterioare de ultimă generație.

Perspective cheie ale documentelor AI pentru dezvoltatorii GenAI

- Arhitectura model

Rețeaua neuronală folosită în studiu este un CNN profund cu 60 de milioane de parametri și 650,000 de neuroni. Este alcătuit din cinci straturi convoluționale, unele urmate de straturi de max-pooling și trei straturi complet conectate cu un softmax final de 1000 de căi pentru clasificare.

- Date de instruire

Modelul este antrenat pe un set de date substanțial de 1.2 milioane de imagini de înaltă rezoluție de la concursul ImageNet ILSVRC-2010. Procesul de instruire presupune clasificarea imaginilor în 1000 de clase diferite.

- Performanţă

Modelul atinge rate de eroare de top-1 și top-5 de 37.5% și, respectiv, 17.0% pe datele de testare. Aceste rate de eroare sunt considerabil mai bune decât stadiul anterior al tehnicii, indicând eficacitatea abordării propuse.

- Îmbunătățiri în supraajustarea

Lucrarea introduce mai multe tehnici pentru a aborda problemele de supraadaptare, inclusiv neuronii nesaturați, implementarea eficientă a GPU-ului pentru un antrenament mai rapid și o metodă de regularizare numită „abandon” în straturi complet conectate. - Eficiență de calcul

În ciuda cerințelor de calcul ale antrenării CNN-urilor mari, lucrarea notează că GPU-urile actuale și implementările optimizate fac posibilă antrenarea unor astfel de modele pe imagini de înaltă rezoluție.

- Contribuții

Lucrarea evidențiază contribuțiile studiului, inclusiv antrenarea uneia dintre cele mai mari rețele neuronale convoluționale pe seturile de date ImageNet și obținerea de rezultate de ultimă generație în competițiile ILSVRC.

De asemenea, puteți citi: Un tutorial cuprinzător pentru a învăța rețelele neuronale convoluționale

Lucrarea 5: GAT-uri: Rețele de atenție grafică

Legătură: Citiți aici

Rezumatul hârtiei

Lucrarea introduce o arhitectură bazată pe atenție pentru clasificarea nodurilor în date structurate în grafic, prezentându-și eficiența, versatilitatea și performanța competitivă în diferite benchmark-uri. Încorporarea mecanismelor de atenție se dovedește a fi un instrument puternic pentru manipularea graficelor structurate arbitrar.

Perspective cheie ale documentelor AI pentru dezvoltatorii GenAI

- Rețele de atenție grafică (GAT)GAT-urile folosesc straturi de auto-atenție mascate pentru a aborda limitările metodelor anterioare bazate pe convoluțiile grafice. Arhitectura permite nodurilor să se ocupe de caracteristicile vecinătăților lor, specificând implicit ponderi diferite pentru diferite noduri, fără a se baza pe operațiuni matrice costisitoare sau pe cunoașterea a priori a structurii graficului.

- Abordarea provocărilor bazate pe spectre

GAT-urile abordează simultan mai multe provocări în rețelele neuronale bazate pe grafice spectrale. Provocările Graph Attention Network (GAT) implică filtre localizate spațial, calcule intense și filtre nelocalizate spațial. În plus, GAT-urile depind de baza proprie laplaciană, contribuind la aplicabilitatea lor la problemele inductive și transductive.

- Performanță în cadrul benchmark-urilor

Modelele GAT realizează sau potrivesc rezultate de ultimă generație în cadrul a patru benchmark-uri de grafice stabilite: seturi de date de rețea de citare Cora, Citeseer și Pubmed, precum și un set de date de interacțiune proteină-proteină. Aceste repere acoperă atât scenarii de învățare transductivă, cât și inductivă, arătând versatilitatea GAT-urilor.

- Comparație cu abordările anterioare

Lucrarea oferă o imagine de ansamblu cuprinzătoare a abordărilor anterioare, inclusiv a rețelelor neuronale recursive, Grafic rețele neuronale (GNN), metode spectrale și non-spectrale și mecanisme de atenție. GAT-urile încorporează mecanisme de atenție, permițând paralelizarea eficientă între perechile nod-vecin și aplicarea la noduri cu grade diferite.

- Eficiență și aplicabilitateGAT-urile oferă o operație paralelizabilă, eficientă, care poate fi aplicată nodurilor grafice cu grade diferite prin specificarea unor ponderi arbitrare pentru vecini. Modelul se aplică direct problemelor de învățare inductivă, făcându-l potrivit pentru sarcini în care trebuie să se generalizeze la grafice complet nevăzute.

- Relație cu modelele anterioare

Autorii notează că GAT-urile pot fi reformulate ca o instanță particulară a MoNet, pot împărtăși asemănări cu rețelele relaționale și se pot conecta la lucrări care utilizează operațiuni de atenție în vecinătate. Modelul de atenție propus este comparat cu abordări similare, cum ar fi Duan și colab. (2017) și Denil și colab. (2017).

Lucrarea 6: ViT: O imagine valorează 16×16 cuvinte: Transformatori pentru recunoașterea imaginilor la scară

Legătură: Citiți aici

Rezumatul hârtiei

Lucrarea recunoaște dominația arhitecturilor convoluționale în viziunea computerizată, în ciuda succesului arhitecturilor Transformer în procesarea limbajului natural. Inspirați de eficiența și scalabilitatea transformatoarelor în NLP, autorii au aplicat un transformator standard direct imaginilor cu modificări minime.

Ei introduc Transformator de vedere (ViT), unde imaginile sunt împărțite în patch-uri, iar secvența de înglobare liniară a acestor patch-uri servește ca intrare pentru Transformer. Modelul este instruit cu privire la sarcinile de clasificare a imaginilor într-o manieră supravegheată. Inițial, atunci când este instruit pe seturi de date de dimensiuni medii, cum ar fi ImageNet, fără o regularizare puternică, ViT atinge acuratețe puțin sub ResNets comparabile.

Cu toate acestea, autorii dezvăluie că formarea pe scară largă este crucială pentru succesul ViT, depășind limitările impuse de absența anumitor părtiniri inductive. Când este antrenat în prealabil pe seturi de date masive, ViT depășește rețelele convoluționale de ultimă generație pe mai multe benchmark-uri, inclusiv ImageNet, CIFAR-100 și VTAB. Lucrarea subliniază impactul scalarii în obținerea de rezultate remarcabile cu arhitecturile Transformer în viziunea computerizată.

Perspective cheie ale documentelor AI pentru dezvoltatorii GenAI

- Transformator în Computer Vision

Lucrarea contestă dependența predominantă de rețelele neuronale convoluționale (CNN) pentru sarcinile de viziune pe computer. Demonstrează că un transformator pur, atunci când este aplicat direct la secvențe de patch-uri de imagine, poate obține performanțe excelente în sarcinile de clasificare a imaginilor.

- Transformator de vedere (ViT)

Autorii introduc Vision Transformer (ViT), un model care utilizează mecanisme de auto-atenție similare cu Transformers în NLP. ViT poate obține rezultate competitive pe diferite standarde de recunoaștere a imaginii, inclusiv ImageNet, CIFAR-100 și VTAB.

- Pre-formare și transfer de învățare

Lucrarea subliniază importanța pregătirii preliminare pe cantități mari de date, similar cu abordarea în NLP, și apoi transferarea reprezentărilor învățate la sarcini specifice de recunoaștere a imaginii. ViT, atunci când este antrenat în prealabil pe seturi de date masive, cum ar fi ImageNet-21k sau JFT-300M, depășește rețelele convoluționale de ultimă generație pe diferite benchmark-uri.

- Eficiență de calculViT atinge rezultate remarcabile cu mult mai puține resurse de calcul în timpul antrenamentului decât rețele convoluționale de ultimă generație. Această eficiență este deosebit de notabilă atunci când modelul este pre-antrenat la scară largă.

- Scalare impact

Lucrarea evidențiază importanța scalării în obținerea performanțelor superioare cu arhitecturile Transformer în viziunea computerizată. Instruirea la scară largă privind seturile de date care conțin milioane până la sute de milioane de imagini ajută ViT să depășească lipsa unor părtiniri inductive prezente în CNN-uri.

Lucrarea 7: AlphaFold2: Structura proteică foarte precisă cu AlphaFold

Legătură: Citiți aici

Rezumatul hârtiei

Lucrarea „AlphaFold2: Structura proteinelor extrem de precise cu AlphaFold” prezintă AlphaFold2, un model de învățare profundă care prezice cu precizie structurile proteinelor. AlphaFold2 folosește o arhitectură nouă bazată pe atenție și realizează o descoperire în plierea proteinelor.

Perspective cheie ale documentelor AI pentru dezvoltatorii GenAI

- AlphaFold2 folosește o rețea neuronală profundă cu mecanisme de atenție pentru a prezice structura 3D a proteinelor din secvențele lor de aminoacizi.

- Modelul a fost antrenat pe un set mare de date de structuri de proteine cunoscute și a obținut o acuratețe fără precedent în cea de-a 14-a competiție de pliere a proteinelor de evaluare critică a predicției structurii proteinelor (CASP14).

- Predicțiile exacte ale lui AlphaFold2 pot revoluționa descoperirea medicamentelor, ingineria proteinelor și alte domenii ale biochimiei.

Lucrarea 8: GANs: Generative Adversarial Nets

Legătură: Citiți aici

Rezumatul hârtiei

Lucrarea abordează provocările în formarea modelelor generative profunde și introduce o abordare inovatoare numită rețele adverse. În acest cadru, modelele generative și discriminative se angajează într-un joc în care modelul generativ își propune să producă mostre care nu se pot distinge de datele reale. În schimb, modelul discriminativ diferențiază între eșantioanele reale și cele generate. Procesul de antrenament adversar conduce la o soluție unică, modelul generativ recuperând distribuția datelor.

Perspective cheie ale documentelor AI pentru dezvoltatorii GenAI

- Cadrul adversar

Autorii introduc un cadru contradictoriu în care două modele sunt antrenate simultan - un model generativ (G) care surprinde distribuția datelor și un model discriminativ (D) care estimează probabilitatea ca un eșantion să provină din datele de antrenament, mai degrabă decât din modelul generativ.

- Joc MinimaxProcedura de antrenament presupune maximizarea probabilității ca modelul discriminativ să facă o greșeală. Acest cadru este formulat ca un joc minimax pentru doi jucători, în care modelul generativ urmărește să genereze eșantioane care nu se pot distinge de datele reale, iar modelul discriminativ urmărește să clasifice dacă un eșantion este real sau generat corect.

- Soluție unică

O soluție unică există în funcțiile arbitrare pentru G și D, cu G recuperând distribuția datelor de antrenament și D fiind egal cu 1/2 peste tot. Acest echilibru este atins prin procesul de antrenament adversar.

- Perceptroni multistrat (MLP)Autorii demonstrează că întregul sistem poate fi antrenat utilizând backpropagation atunci când perceptronii multistrat reprezintă G și D. Acest lucru elimină necesitatea lanțurilor Markov sau a rețelelor de inferență aproximative desfășurate în timpul antrenării și generării de mostre.

- Fără concluzie aproximativă

Cadrul propus evită dificultățile de aproximare a calculelor probabilistice insolubile în estimarea cu maximă probabilitate. De asemenea, depășește provocările în valorificarea beneficiilor unităților liniare pe bucăți în contextul generativ.

Lucrarea 9: Roberta: O abordare de preformare BERT optimizată robust

Legătură: Citiți aici

Rezumatul hârtiei

Lucrarea abordează problema de undertraining a BERT și introduce RoBERTa, o versiune optimizată care depășește performanța BERT. Modificările în procedura de instruire a lui Roberta și utilizarea unui set de date nou (CC-NEWS) contribuie la rezultate de ultimă generație în mai multe sarcini de procesare a limbajului natural. Constatările subliniază importanța alegerilor de proiectare și a strategiilor de formare în eficacitatea preformarii modelului lingvistic. Resursele lansate, inclusiv modelul și codul Roberta, contribuie la comunitatea de cercetare.

Perspective cheie ale documentelor AI pentru dezvoltatorii GenAI

- BERT Undertraining

Autorii constată că OARET, un model de limbaj larg utilizat, a fost semnificativ subantrenat. Evaluând cu atenție impactul reglajului hiperparametrului și al dimensiunii setului de antrenament, ei arată că BERT poate fi îmbunătățit pentru a se potrivi sau depăși performanța tuturor modelelor publicate după el.

- Rețetă de antrenament îmbunătățită (RoBERTa)

Autorii introduc modificări în procedura de formare BERT, producând RoBERTa. Aceste modificări implică perioade de antrenament extinse cu loturi mai mari, eliminarea următorului obiectiv de predicție a propoziției, antrenament pe secvențe mai lungi și ajustări dinamice ale modelului de mascare pentru datele de antrenament.

- Contribuția la setul de dateLucrarea introduce un nou set de date numit CC-NEWS, care este comparabil ca dimensiune cu alte seturi de date utilizate în mod privat. Includerea acestui set de date ajută la un control mai bun al efectelor dimensiunii setului de antrenament și contribuie la îmbunătățirea performanței la sarcinile din aval.

- Realizări de performanță

Roberta, cu modificările sugerate, obține rezultate de ultimă generație la diferite sarcini de referință, inclusiv GLUE, RACE și SQuAD. Se potrivește sau depășește performanța tuturor metodelor post-BERT în sarcini precum MNLI, QNLI, RTE, STS-B, SQuAD și RACE.

- Competitivitatea preformarii modelului de limbaj mascat

Lucrarea reafirmă că obiectivul de preformare a modelului de limbaj mascat, cu alegerile corecte de proiectare, este competitiv cu alte obiective de formare propuse recent.

- Resurse lansate

Autorii își lansează modelul RoBERTa, împreună cu codul de preinstruire și reglare fină implementat în PyTorch, contribuind la reproductibilitatea și explorarea ulterioară a descoperirilor lor.

Citeste si: O introducere blândă la Roberta

Lucrarea 10: NeRF: Reprezentarea scenelor ca câmpuri de radiație neuronală pentru sinteza vizualizării

Legătură: Citiți aici

Rezumatul hârtiei

Optimizarea implică minimizarea erorii dintre imaginile observate cu ipostaze cunoscute ale camerei și vederile redate din reprezentarea continuă a scenei. Lucrarea abordează provocările legate de convergență și eficiență prin introducerea codificării poziționale pentru a gestiona funcții de frecvență mai mare și propunând o procedură de eșantionare ierarhică pentru a reduce numărul de interogări necesare pentru o eșantionare adecvată.

Perspective cheie ale documentelor AI pentru dezvoltatorii GenAI

- Reprezentare continuă a scenei

Lucrarea prezintă o metodă de reprezentare a scenelor complexe ca câmpuri de radiație neurale 5D utilizând rețele de bază de perceptron multistrat (MLP).

- Redare diferențiabilă

Procedura de randare propusă se bazează pe tehnici clasice de randare a volumului, permițând optimizarea bazată pe gradient folosind imagini RGB standard.

- Strategia de eșantionare ierarhică

Este introdusă o strategie de eșantionare ierarhică pentru a optimiza capacitatea MLP către zone cu conținut vizibil de scenă, abordând problemele de convergență.

- Codificare poziționalăUtilizarea codificării poziționale pentru a mapa coordonatele 5D de intrare într-un spațiu de dimensiuni mai mari permite optimizarea cu succes a câmpurilor de radiație neuronală pentru conținutul scenei de înaltă frecvență.

Metoda propusă depășește abordările de sinteză a vederii de ultimă generație, inclusiv potrivirea reprezentărilor 3D neuronale și antrenarea rețelelor convoluționale profunde. Această lucrare introduce o reprezentare continuă a scenei neuronale pentru redarea imaginilor fotorealiste noi de înaltă rezoluție din imagini RGB în setări naturale, cu comparații suplimentare prezentate în videoclipul suplimentar pentru a evidenția eficacitatea acesteia în gestionarea geometriei și aspectului scenei complexe.

Lucrarea 11: FunSearch: Descoperiri matematice din căutarea programelor cu modele mari de limbaj

Legătură: Citiți aici

Rezumatul hârtiei

Lucrarea prezintă FunSearch, o abordare nouă pentru utilizarea modelelor de limbaj mari (LLM) pentru a rezolva probleme complexe, în special în descoperirile științifice. Principala provocare abordată este apariția confabulațiilor (halucinațiilor) în LLM, care conduc la afirmații plauzibile, dar incorecte. FunSearch combină un LLM pre-instruit cu un evaluator sistematic într-o procedură evolutivă pentru a depăși această limitare.

Perspective cheie ale documentelor AI pentru dezvoltatorii GenAI

- Rezolvarea problemelor cu LLM

Lucrarea abordează problema LLM-urilor care confabulează sau nu reușesc să genereze idei noi și soluții corecte pentru probleme complexe. Subliniază importanța găsirii de idei noi, corecte verificabil, în special pentru provocările matematice și științifice.

- Procedura evolutivă – FunSearch

FunSearch combină un LLM preformat cu un evaluator într-un proces evolutiv. Evoluează în mod iterativ programele cu scoruri scăzute în cele cu scoruri mari, asigurând descoperirea de noi cunoștințe. Procesul implică indicarea optimă, evoluția scheletelor programului, menținerea diversității programului și scalarea asincronă.

- Aplicație la combinatorie extremă

Lucrarea demonstrează eficacitatea FunSearch asupra problemei setului de capace în combinatorică extremă. FunSearch descoperă noi construcții de seturi cu capital mare, depășind cele mai cunoscute rezultate și oferind cea mai mare îmbunătățire din ultimii 20 de ani limitei inferioare asimptotice.

- Problemă algoritmică – Ambalarea coșului online

FunSearch este aplicat problemei de împachetare online, ducând la descoperirea de noi algoritmi care îi depășesc pe cei tradiționali pe distribuții de interes bine studiate. Aplicațiile potențiale includ îmbunătățirea algoritmilor de programare a locurilor de muncă.

- Programe vs. SoluțiiFunSearch se concentrează pe generarea de programe care descriu cum să rezolve o problemă, mai degrabă decât să scoată direct soluții. Aceste programe tind să fie mai interpretabile, facilitând interacțiunile cu experții din domeniu și sunt mai ușor de implementat decât alte tipuri de descrieri, cum ar fi rețelele neuronale.

- Impact interdisciplinar

Metodologia FunSearch permite explorarea unei game largi de probleme, făcându-l o abordare versatilă cu aplicații interdisciplinare. Lucrarea evidențiază potențialul său de a face descoperiri științifice verificabile folosind LLM-uri.

Lucrarea 12: VAE-uri: Bayes variaționale cu codare automată

Legătură: Citiți aici

Rezumatul hârtiei

Lucrarea „Auto-Coding Variational Bayes” abordează provocarea inferenței și învățării eficiente în modele probabilistice direcționate cu variabile latente continue, în special atunci când distribuțiile posterioare sunt insolubile și au de-a face cu seturi de date mari. Autorii propun o inferență variațională stocastică și un algoritm de învățare care se scalează bine pentru seturi mari de date și rămâne aplicabil chiar și în distribuțiile posterioare insolubile.

Perspective cheie ale documentelor AI pentru dezvoltatorii GenAI

- Reparametrizarea limitei inferioare variaționale

Lucrarea demonstrează o reparametrizare a limitei inferioare variaționale, rezultând un estimator al limitei inferioare. Acest estimator este susceptibil de optimizare folosind metode standard de gradient stocastic, făcându-l eficient din punct de vedere computațional.

- Inferență posterioară eficientă pentru variabile latente continueAutorii propun algoritmul Auto-Encoding VB (AEVB) pentru seturi de date cu variabile latente continue per punct de date. Acest algoritm utilizează estimatorul Stochastic Gradient Variational Bayes (SGVB) pentru a optimiza un model de recunoaștere, permițând o inferență posterioară aproximativă eficientă prin eșantionarea ancestrală. Această abordare evită schemele de inferență iterativă costisitoare precum Markov Chain Monte Carlo (MCMC) pentru fiecare punct de date.

- Avantaje teoretice și rezultate experimentale

Avantajele teoretice ale metodei propuse sunt reflectate în rezultatele experimentale. Lucrarea sugerează că modelul de reparametrizare și recunoaștere duce la eficiență și scalabilitate computațională, făcând abordarea aplicabilă la seturi de date mari și în situațiile în care posteriorul este insolubil.

De asemenea, se va citi: Dezvăluirea esenței stochasticului în învățarea automată

Lucrarea 13: MEMORIA PE TERMEN LUNG SCURT

Legătură: Citiți aici

Rezumatul hârtiei

Lucrarea abordează provocarea de a învăța să stocheze informații pe intervale de timp extinse în rețelele neuronale recurente. Introduce o metodă nouă, eficientă, bazată pe gradient, numită „Memorie pe termen lung pe termen lung” (LSTM), care depășește problemele de retur de eroare insuficiente și în descompunere. LSTM impune fluxul constant de erori prin „caruselele cu erori constante” și utilizează unități de poartă multiplicatoare pentru a controla accesul. Cu complexitatea spațiu-timp locală (O(1) pe pas de timp și greutate), rezultatele experimentale arată că LSTM depășește algoritmii existenți în ceea ce privește viteza de învățare și ratele de succes, în special pentru sarcinile cu decalaje prelungite.

Perspective cheie ale documentelor AI pentru dezvoltatorii GenAI

- Analiza problemelor

Lucrarea oferă o analiză detaliată a provocărilor asociate cu returnarea erorilor în rețelele neuronale recurente, evidențiind problemele semnalelor de eroare care fie explodează, fie dispar în timp.

- Introducerea LSTM

Autorii introduc LSTM ca o arhitectură nouă concepută pentru a aborda problemele semnalelor de eroare care dispar și explodează. LSTM încorporează un flux constant de eroare prin unități specializate și folosește unități de poartă multiplicativă pentru a regla accesul la acest flux de eroare.

- Rezultate experimentale

Prin experimente cu date artificiale, lucrarea demonstrează că LSTM depășește alți algoritmi de rețea recurenți, inclusiv BPTT, RTRL, corelația în cascadă recurentă, rețele Elman și Neural Sequence Chunking. LSTM arată o învățare mai rapidă și rate de succes mai mari, în special în rezolvarea sarcinilor complexe cu decalaje lungi.

- Local în spațiu și timp

LSTM este descrisă ca o arhitectură locală în spațiu și timp, complexitatea de calcul pe pas de timp și greutatea fiind O(1).

- aplicabilitate

Arhitectura LSTM propusă rezolvă în mod eficient sarcini complexe, artificiale de întârziere de lungă durată, care nu au fost abordate cu succes de algoritmii de rețea recurenți anteriori.

- Limitări și avantaje

Lucrarea discută limitările și avantajele LSTM, oferind perspective asupra aplicabilității practice a arhitecturii propuse.

De asemenea, se va citi: Ce este LSTM? Introducere în memoria pe termen lung pe termen scurt

Lucrarea 14: Învățarea modelelor vizuale transferabile din supravegherea limbajului natural

Legătură: Citiți aici

Rezumatul hârtiei

Lucrarea explorează instruirea sistemelor de viziune computerizată de ultimă generație prin învățarea directă din text brut despre imagini, mai degrabă decât bazându-se pe seturi fixe de categorii de obiecte predeterminate. Autorii propun o sarcină pre-antrenament de a prezice ce legendă corespunde unei imagini date, folosind un set de date de 400 de milioane de perechi (imagine, text) colectate de pe internet. Modelul rezultat, CLIP (Contrastive Language-Image Pre-training), demonstrează o învățare eficientă și scalabilă a reprezentărilor de imagini. După pregătire preliminară, limbajul natural face referire la concepte vizuale, permițând transferul zero-shot la diferite sarcini din aval. CLIP este evaluat pe peste 30 de seturi de date de viziune computerizată, prezentând performanța competitivă fără pregătire specifică sarcinii.

Perspective cheie ale documentelor AI pentru dezvoltatorii GenAI

- Training privind limbajul natural pentru viziunea computerizată

Lucrarea explorează utilizarea supravegherii în limbaj natural pentru a antrena modele de viziune computerizată în loc de abordarea tradițională de formare pe seturi de date etichetate de mulțime, cum ar fi ImageNet.

- Sarcina de pre-antrenamentAutorii propun o sarcină simplă de pre-antrenament: prezicerea legendei care corespunde unei imagini date. Această sarcină este folosită pentru a învăța reprezentări de imagini de ultimă generație de la zero pe un set masiv de date de 400 de milioane de perechi (imagine, text) colectate online.

- Transfer Zero-Shot

După antrenament preliminar, modelul utilizează limbajul natural pentru a face referire la concepte vizuale învățate sau pentru a le descrie pe altele noi. Acest lucru permite transferul zero-shot al modelului către sarcinile din aval fără a necesita instruire specifică pentru setul de date.

- Benchmarking pe diverse sarcini

Lucrarea evaluează performanța abordării propuse pe peste 30 de seturi diferite de date de viziune computerizată, acoperind sarcini precum OCR, recunoașterea acțiunilor în videoclipuri, geo-localizarea și clasificarea obiectelor cu granulație fină.

- Performanță competitivă

Modelul demonstrează performanță competitivă cu linii de bază complet supravegheate pentru diferite sarcini, deseori potrivindu-se sau depășind acuratețea modelelor antrenate pe seturi de date specifice sarcinii fără instruire suplimentară specifică setului de date.

- Studiu de scalabilitate

Autorii studiază scalabilitatea abordării lor prin antrenarea unei serii de opt modele cu diferite niveluri de resurse de calcul. Performanța de transfer se dovedește a fi o funcție ușor previzibilă a calculului.

- Robustitatea modelului

Lucrarea subliniază faptul că modelele CLIP zero-shot sunt mai robuste decât modelele ImageNet supravegheate cu acuratețe echivalentă, sugerând că evaluarea zero-shot a modelelor agnostice de sarcini oferă o măsură mai reprezentativă a capacității unui model.

Lucrarea 15: LORA: ADAPTARE LA RANG JOS A MODELELOR DE LIMBĂ MARI

Legătură: Citiți aici

Rezumatul hârtiei

Lucrarea propune LoRA ca o metodă eficientă de adaptare a modelelor lingvistice mari pre-instruite la sarcini specifice, abordând provocările de implementare asociate cu creșterea dimensiunii lor. Metoda reduce substanțial parametrii antrenabili și cerințele de memorie GPU, menținând sau îmbunătățind în același timp calitatea modelului în diferite benchmark-uri. Implementarea open-source facilitează și mai mult adoptarea LoRA în aplicații practice.

Perspective cheie ale documentelor AI pentru dezvoltatorii GenAI

1. Declarație problemă

- Preinstruirea la scară largă, urmată de reglarea fină, este o abordare comună în procesarea limbajului natural.

- Reglarea fină devine mai puțin fezabilă pe măsură ce modelele cresc, în special atunci când implementează modele cu parametri masivi, cum ar fi GPT-3 (175 de miliarde de parametri).

2. Soluția propusă: Adaptare la nivel scăzut (LoRA)

- Lucrarea introduce LoRA, o metodă care îngheață greutățile modelelor preantrenate și introduce matrici de descompunere a rangurilor antrenabile în fiecare strat al arhitecturii Transformer.

- LoRA reduce semnificativ numărul de parametri antrenabili pentru sarcinile din aval în comparație cu reglarea fină completă.

3. Beneficiile LoRA

- Reducerea parametrilor: în comparație cu reglarea fină, LoRA poate reduce numărul de parametri antrenabili de până la 10,000 de ori, făcându-l mai eficient din punct de vedere computațional.

- Eficiența memoriei: LoRA scade cerințele de memorie GPU de până la 3 ori în comparație cu reglajul fin.

- Calitate model: În ciuda faptului că are mai puțini parametri antrenabili, LoRA are performanțe egale sau mai bune decât reglajul fin în ceea ce privește calitatea modelului pe diferite modele, inclusiv RoBERTa, DeBERTa, GPT-2 și GPT-3.

4. Depășirea provocărilor de implementare

- Lucrarea abordează provocarea implementării modelelor cu mulți parametri prin introducerea LoRA, permițând schimbarea eficientă a sarcinilor fără a reinstrui întregul model.

5. Eficiență și latență scăzută de inferență

- LoRA facilitează partajarea unui model pre-instruit pentru construirea mai multor module LoRA pentru diferite sarcini, reducând cerințele de stocare și overhead de comutare a sarcinilor.

- Antrenamentul devine mai eficient, coborând bariera hardware la intrare de până la 3 ori atunci când se utilizează optimizatori adaptivi.

6. Compatibilitate și integrare

- LoRA este compatibil cu diverse metode anterioare și poate fi combinat cu acestea, cum ar fi reglarea prefixului.

- Designul liniar propus permite îmbinarea matricelor antrenabile cu greutăți înghețate în timpul implementării, fără a introduce o latență de inferență suplimentară în comparație cu modelele complet reglate.

7. Investigație empirică

- Lucrarea include o investigație empirică a deficienței de rang în adaptarea modelului lingvistic, oferind perspective asupra eficacității abordării LoRA.

8. Implementare open-source

- Autorii furnizează un pachet care facilitează integrarea LoRA cu modelele PyTorch și lansează implementări și puncte de control pentru modele pentru RoBERTa, DeBERTa și GPT-2.

De asemenea, puteți citi: Reglare fină eficientă în funcție de parametri a modelelor de limbă mari cu LoRA și QLoRA

Concluzie

În concluzie, aprofundarea celor 15 documente esențiale AI pentru dezvoltatorii GenAI evidențiate în acest articol nu este doar o recomandare, ci un imperativ strategic pentru orice dezvoltator aspirant. Aceste lucrări de inteligență artificială oferă o călătorie cuprinzătoare prin peisajul divers al inteligenței artificiale, cuprinzând domenii critice precum procesarea limbajului natural, viziunea computerizată și nu numai. Prin scufundarea în perspectivele și inovațiile prezentate în aceste lucrări, dezvoltatorii obțin o înțelegere profundă a tehnicilor și algoritmilor de ultimă oră din domeniu.

Legate de

- Distribuție de conținut bazat pe SEO și PR. Amplifică-te astăzi.

- PlatoData.Network Vertical Generative Ai. Împuterniciți-vă. Accesați Aici.

- PlatoAiStream. Web3 Intelligence. Cunoștințe amplificate. Accesați Aici.

- PlatoESG. carbon, CleanTech, Energie, Mediu inconjurator, Solar, Managementul deșeurilor. Accesați Aici.

- PlatoHealth. Biotehnologie și Inteligență pentru studii clinice. Accesați Aici.

- Sursa: https://www.analyticsvidhya.com/blog/2024/01/essential-ai-papers-every-gen-ai-developer-must-read/

- :are

- :este

- :nu

- :Unde

- $UP

- 000

- 1

- 10

- 11

- 12

- 13

- 14

- 15%

- 17

- 20

- ani 20

- 2014

- 2017

- 28

- 30

- 3d

- 400

- 41

- 60

- 7

- 8

- 9

- 913

- a

- capacitate

- Despre Noi

- AC

- acces

- precizie

- precis

- precis

- Obține

- realizat

- Realizeaza

- realizarea

- peste

- Acțiune

- adaptare

- adaptivă

- Suplimentar

- În plus,

- adresa

- adresat

- adrese

- adresare

- ajustări

- Adoptare

- progresele

- Avantaj

- Avantajele

- contradictorialității

- După

- înainte

- AI

- isi propune

- AL

- Algoritmul

- algoritmi

- TOATE

- permite

- Permiterea

- permite

- de-a lungul

- de asemenea

- Sume

- an

- analiză

- și

- Orice

- aplicabil

- aplicație

- aplicatii

- aplicat

- se aplică

- Aplică

- Aplicarea

- abordare

- abordari

- aproximativ

- arhitectură

- SUNT

- domenii

- argumenta

- apărea

- articol

- bunuri

- artificial

- inteligență artificială

- Inteligența artificială (AI)

- AS

- aspirant

- evaluare

- asociate

- At

- asista la

- atenţie

- Autorii

- barieră

- bazat

- de bază

- BE

- devine

- fiind

- de mai jos

- Benchmark

- comparativ

- valori de referință

- Beneficiile

- CEL MAI BUN

- Mai bine

- între

- Dincolo de

- distorsiunilor

- Miliard

- BIN

- a stimula

- atât

- legat

- descoperire

- descoperiri

- mai larg

- Clădire

- construit

- dar

- by

- denumit

- a venit

- aparat foto

- CAN

- candidaţilor

- capac

- capacități

- capacitate

- Capacitate

- captura

- capturi

- cu grijă

- cascadă

- categorii

- sigur

- lanţ

- lanţuri

- contesta

- provocări

- provocare

- șansele

- Modificări

- alegeri

- clase

- clasificare

- Clasifica

- CNN

- cod

- combinate

- combină

- Comun

- comunitate

- comparabil

- comparație

- comparații

- compatibil

- competent

- concurs

- Competiţii

- competitiv

- competitivităţii

- complet

- complex

- complexitate

- cuprinzător

- calcul

- de calcul

- calcule

- calculator

- Computer Vision

- tehnica de calcul

- Concepte

- preocupările

- concluzie

- Conectați

- legat

- Lua în considerare

- luate în considerare

- constă

- constant

- conţinut

- concurs

- context

- continuă

- continuu

- contrast

- a contribui

- contribuie

- contribuind

- contribuţii

- Control

- Convergenţă

- rețea neuronală convoluțională

- corecta

- corect

- Corelație

- corespunde

- costisitor

- acoperi

- acoperire

- critic

- crucial

- Curent

- curba

- ultima generație

- de date

- seturi de date

- Zi

- abuzive

- Deciziile

- scade

- adânc

- învățare profundă

- rețea neuronală profundă

- Mai adânc

- cererile

- demonstra

- demonstrează

- demonstrând

- depinde

- dependențe

- implementa

- Implementarea

- desfășurarea

- descrie

- descris

- descrie

- Amenajări

- proiectat

- În ciuda

- detaliat

- Dezvoltator

- Dezvoltatorii

- în curs de dezvoltare

- diferit

- dificil

- dificultăți

- dirijat

- direct

- descopera

- descoperire

- distanţă

- distinge

- face distincția

- distribuire

- distribuții

- diferit

- Diversitate

- do

- domeniu

- domenii

- Predominanța

- medicament

- descoperirea de droguri

- în timpul

- dinamic

- E&T

- fiecare

- mai ușor

- Eficace

- în mod eficient

- eficacitate

- efecte

- eficacitate

- eficiență

- eficient

- opt

- oricare

- element

- unsprezece

- elimină

- eliminarea

- scoate in evidenta

- subliniază

- patronat

- angajează

- permite

- permite

- permițând

- codare

- angaja

- Inginerie

- Engleză

- spori

- îmbunătățiri

- Îmbunătăţeşte

- asigurare

- Întreg

- în întregime

- intrare

- egal

- Echilibru

- Echivalent

- eroare

- mai ales

- esenţă

- esenţial

- stabilit

- stabilește

- estimări

- Eter (ETH)

- evaluarea

- evaluare

- Chiar

- pretutindeni

- evolua

- evoluează

- evoluție

- exemple

- depăși

- depășește

- excelent

- captivant

- Exponatele

- existent

- există

- Extinde

- scump

- experimental

- experimente

- experți

- explorare

- explora

- Explorează

- Explorarea

- extins

- facilitează

- facilitând

- în lipsa

- familiar

- mai repede

- realizabil

- DESCRIERE

- puțini

- mai puține

- camp

- Domenii

- Filtre

- final

- Găsi

- descoperire

- constatările

- First

- montaj

- cinci

- fixată

- debit

- se concentrează

- concentrându-se

- a urmat

- Pentru

- găsit

- patru

- Cadru

- Frecvență

- din

- congelate

- Complet

- complet

- funcţie

- funcții

- mai mult

- Câştig

- câștig

- joc

- Gans

- poartă

- genai

- genera

- generată

- generator

- generativ

- model generativ

- blând

- geometrie

- dat

- Oferirea

- Caritate

- GPU

- unități de procesare grafică

- grafic

- grafic rețele neuronale

- grafice

- Crește

- manipula

- Manipularea

- Piese metalice

- având în

- ajută

- ierarhic

- Înalt

- Frecventa inalta

- Rezoluție înaltă

- superior

- Evidențiați

- Evidențiat

- subliniind

- highlights-uri

- extrem de

- Cum

- Cum Pentru a

- HTTPS

- uman

- Oamenii

- sute

- sute de milioane

- Reglarea hiperparametrului

- idei

- identifica

- imagine

- Clasificarea imaginilor

- Recunoașterea imaginii

- IMAGEnet

- imagini

- Impactul

- Impacturi

- imperativ

- implementarea

- implementările

- implementat

- implicații

- importanță

- important

- impusă

- îmbunătățit

- îmbunătățire

- îmbunătățiri

- îmbunătăţeşte

- îmbunătățirea

- in

- include

- include

- Inclusiv

- incorpora

- încorporează

- Crește

- a crescut

- crescând

- tot mai mult

- indicând

- informații

- informat

- inițial

- inovații

- inovatoare

- intrare

- perspective

- inspirat

- instanță

- in schimb

- instrucțiuni

- integrare

- Inteligență

- intens

- interacţiune

- interacţiuni

- interes

- Internet

- în

- introduce

- introdus

- Prezintă

- introducerea

- Introducere

- investigaţie

- implica

- implică

- problema

- probleme de

- IT

- ESTE

- Loc de munca

- Locuri de munca

- călătorie

- jpg

- cunoştinţe

- cunoscut

- lipsă

- aterizare

- peisaj

- limbă

- mare

- pe scară largă

- mai mare

- cea mai mare

- Latență

- Ultimele

- strat

- straturi

- conducere

- Conduce

- AFLAȚI

- învățat

- învăţare

- mai puțin

- nivelurile de

- Pârghie

- pîrghii

- efectului de pârghie

- ca

- probabilitate

- limitare

- limitări

- Limitat

- local

- Lung

- perioadă lungă de timp

- Uite

- Jos

- LOWER

- scăderea

- maşină

- traducere automată

- făcut

- mentine

- major

- face

- Efectuarea

- manieră

- multe

- Hartă

- Margine

- masiv

- Meci

- meciuri

- potrivire

- matematic

- Matrice

- max-width

- maximizarea

- maxim

- măsura

- mecanisme

- Memorie

- pur și simplu

- care fuzionează

- metodă

- metodologii

- Metodologie

- Metode

- milion

- milioane

- minim

- minimizând

- greşeală

- model

- Modele

- modificările aduse

- Module

- mai mult

- mai eficient

- În plus

- cele mai multe

- multiplu

- trebuie sa

- Trebuie citit

- Natural

- Limbajul natural

- Procesarea limbajului natural

- Natură

- Nevoie

- necesar

- nevoilor

- Nerf

- Plase

- reţea

- rețele

- neural

- rețele neuronale

- rețele neuronale

- NeurIPS

- neuronii

- Nou

- ştiri

- următor

- nlp

- Nu.

- nod

- noduri

- notabil

- nota

- notițe

- roman

- număr

- obiect

- obiectiv

- Obiectivele

- observate

- apariţie

- OCR

- of

- oferi

- promoții

- de multe ori

- on

- ONE

- cele

- on-line

- afară

- open-source

- operaţie

- Operațiuni

- optimizare

- Optimizați

- optimizate

- or

- Altele

- outperform

- surclasa

- surclasează

- producție

- exterior

- peste

- Învinge

- depășirea

- Prezentare generală

- pachet

- perechi

- Pankaj

- Hârtie

- lucrări

- Paralel

- parametru

- parametrii

- special

- în special

- Patch-uri

- Model

- pentru

- efectua

- performanță

- efectuează

- perioadele

- Fotorealist

- Plato

- Informații despre date Platon

- PlatoData

- plauzibil

- Punct

- ridică

- potenţial

- potenţial

- puternic

- Practic

- Aplicații practice

- prezice

- predictibil

- estimarea

- prezicere

- Predictii

- prezice

- prezenta

- prezentat

- cadouri

- precedent

- primar

- anterior

- probabilitate

- Problemă

- probleme

- procedură

- proces

- prelucrare

- produce

- profund

- Program

- Programe

- Proiecte

- propune

- propus

- propune

- propunând

- Proteină

- Proteine

- dovedit

- dovedește

- furniza

- furnizează

- furnizarea

- publicat

- pirtorh

- calitate

- interogări

- Rasă

- gamă

- rank

- tarife

- mai degraba

- Crud

- atins

- Citeste

- Citind

- reafirmă

- real

- lumea reală

- recent

- recent

- reţetă

- recunoaştere

- Recomandare

- recuperare

- recurență

- recurent

- recursive

- reduce

- Redus

- reduce

- reducerea

- reducere

- referință

- referințe

- reflectat

- cu privire la

- Reglementa

- legate de

- Relaţii

- eliberaţi

- eliberat

- încredere

- bazându-se

- rămășițe

- remarcabil

- prestate

- tencuială

- reprezenta

- reprezentare

- reprezentant

- reprezentând

- necesita

- cerință

- Cerinţe

- cercetare

- Comunitatea de cercetare

- cercetători

- Resurse

- respectiv

- rezultând

- REZULTATE

- reconversie profesională

- dezvălui

- revoluţiona

- RGB

- dreapta

- Risc

- robust

- scalabilitate

- scalabil

- Scară

- cântare

- scalare

- scenarii

- scenă

- scene

- programare

- scheme

- ştiinţific

- scor

- zgâria

- Caută

- propoziție

- Secvenţă

- serie

- servește

- set

- Seturi

- setări

- câteva

- Distribuie

- partajarea

- Pe termen scurt

- Arăta

- a prezentat

- simbolizeazã

- arătând

- Emisiuni

- semnalele

- semnificație

- semnificativ

- semnificativ

- asemănător

- asemănări

- simplu

- simultan

- situații

- Mărimea

- calificat

- lin

- societate

- Numai

- soluţie

- soluţii

- REZOLVAREA

- rezolvă

- Rezolvarea

- unele

- uneori

- Spaţiu

- Spațiu și Timp

- tensiune

- de specialitate

- specific

- Spectral

- viteză

- împărţi

- standard

- de ultimă oră

- Declarații

- şedere

- Pas

- depozitare

- stoca

- Strategic

- strategii

- Strategie

- puternic

- structura

- structurat

- structurile

- luptele

- Studiu

- substanțial

- substanţial

- succes

- de succes

- Reușit

- astfel de

- sugerează

- potrivit

- superior

- supraveghere

- depășește

- depășind

- SVG

- sinteză

- sistem

- sisteme

- Sarcină

- sarcini

- tehnici de

- Tind

- termeni

- test

- a) Sport and Nutrition Awareness Day in Manasia Around XNUMX people from the rural commune Manasia have participated in a sports and healthy nutrition oriented activity in one of the community’s sports ready yards. This activity was meant to gather, mainly, middle-aged people from a Romanian rural community and teach them about the benefits that sports have on both their mental and physical health and on how sporting activities can be used to bring people from a community closer together. Three trainers were made available for this event, so that the participants would get the best possible experience physically and so that they could have the best access possible to correct information and good sports/nutrition practices. b) Sports Awareness Day in Poiana Țapului A group of young participants have taken part in sporting activities meant to teach them about sporting conduct, fairplay, and safe physical activities. The day culminated with a football match.

- decât

- acea

- Graficul

- lor

- Lor

- apoi

- teoretic

- Acestea

- ei

- acest

- mii

- trei

- Prin

- timp

- ori

- la

- instrument

- subiecte

- față de

- tradiţional

- Tren

- dresat

- Pregătire

- transfer

- transferare

- transformator

- transformatoare

- Traducere

- Calitatea traducerii

- Tendinţe

- tutorial

- Două

- Tipuri

- subliniere

- înţelegere

- unic

- de unităţi

- spre deosebire de

- fără precedent

- actualizat

- actualizări

- utilizare

- utilizat

- utilizări

- folosind

- utilizează

- v1

- Valoros

- diverse

- verificabil

- multilateral

- versatilitate

- versiune

- Video

- Video

- Vizualizare

- vizualizari

- vizibil

- viziune

- sisteme de vedere

- vizual

- Recunoașterea vizuală

- volum

- vs

- a fost

- modalități de

- web

- greutate

- BINE

- cand

- dacă

- care

- în timp ce

- larg

- Gamă largă

- pe larg

- mai larg

- Comunitate mai largă

- Wikipedia

- voi

- cu

- în

- fără

- cuvinte

- Apartamente

- fabrică

- valoare

- scris

- ani

- elastic

- tu

- Ta

- zephyrnet