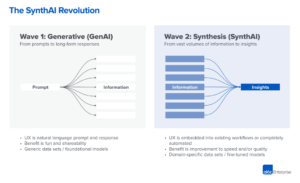

Estamos começando a ver os primeiros estágios de uma pilha de tecnologia emergindo na inteligência artificial (IA) generativa. Centenas de novas startups estão entrando no mercado para desenvolver modelos de fundação, criar aplicativos nativos de IA e criar infraestrutura/ferramentas.

Muitas tendências tecnológicas quentes são exageradas muito antes de o mercado alcançá-las. Mas o boom generativo da IA foi acompanhado por ganhos reais em mercados reais e tração real de empresas reais. Modelos como Stable Diffusion e ChatGPT estão estabelecendo recordes históricos de crescimento de usuários, e vários aplicativos atingiram US$ 100 milhões em receita anualizada menos de um ano após o lançamento. Comparações lado a lado mostram modelos de IA humanos superando em algumas tarefas por várias ordens de grandeza.

Portanto, há dados iniciais suficientes para sugerir que uma transformação massiva está ocorrendo. O que não sabemos, e o que agora se tornou a questão crítica, é: Onde neste mercado o valor será acumulado?

No ano passado, nos reunimos com dezenas de fundadores e operadores de startups em grandes empresas que lidam diretamente com IA generativa. Nós observamos que fornecedores de infraestrutura são provavelmente os maiores vencedores neste mercado até agora, capturando a maioria dos dólares que fluem pela pilha. empresas de aplicativos estão aumentando as receitas principais muito rapidamente, mas muitas vezes lutam com retenção, diferenciação de produto e margens brutas. E a maioria provedores de modelos, embora responsáveis pela própria existência desse mercado, ainda não atingiram grande escala comercial.

Em outras palavras, as empresas que criam mais valor – ou seja, treinando modelos generativos de IA e aplicando-os em novos aplicativos – não capturaram a maior parte dele. Prever o que acontecerá a seguir é muito mais difícil. Mas achamos que o principal a entender é quais partes da pilha são realmente diferenciadas e defensáveis. Isso terá um grande impacto na estrutura do mercado (ou seja, desenvolvimento horizontal versus vertical da empresa) e nos direcionadores de valor de longo prazo (por exemplo, margens e retenção). Até agora, tivemos dificuldade em encontrar defensibilidade estrutural qualquer lugar na pilha, fora dos fossos tradicionais para titulares.

Somos incrivelmente otimistas com a IA generativa e acreditamos que ela terá um grande impacto na indústria de software e além. O objetivo deste post é mapear a dinâmica do mercado e começar a responder às questões mais amplas sobre modelos de negócios de IA generativa.

Pilha de tecnologia de alto nível: infraestrutura, modelos e aplicativos

Para entender como o mercado de IA generativa está tomando forma, primeiro precisamos definir como a pilha se parece hoje. Aqui está nossa visão preliminar.

A pilha pode ser dividida em três camadas:

- Aplicações que integram modelos generativos de IA em um produto voltado para o usuário, executando seus próprios pipelines de modelo (“aplicativos de ponta a ponta”) ou contando com uma API de terceiros

- Modelos que alimentam os produtos de IA, disponibilizados como APIs proprietárias ou como pontos de verificação de código aberto (que, por sua vez, exigem uma solução de hospedagem)

- Infraestrutura fornecedores (ou seja, plataformas de nuvem e fabricantes de hardware) que executam cargas de trabalho de treinamento e inferência para modelos de IA generativa

É importante observar: Este não é um mapa de mercado, mas uma estrutura para analisar o mercado. Em cada categoria, listamos alguns exemplos de fornecedores conhecidos. Não fizemos nenhuma tentativa de ser abrangentes ou listar todos os incríveis aplicativos generativos de IA que foram lançados. Também não estamos nos aprofundando aqui nas ferramentas MLops ou LLMops, que ainda não são altamente padronizadas e serão abordadas em uma postagem futura.

A primeira onda de aplicativos generativos de IA está começando a ganhar escala, mas luta com retenção e diferenciação

Em ciclos de tecnologia anteriores, a sabedoria convencional era que, para construir uma empresa grande e independente, você deveria possuir o cliente final – quer isso significasse consumidores individuais ou compradores B2B. É tentador acreditar que as maiores empresas de IA generativa também serão aplicativos de usuário final. Até agora, não está claro se é esse o caso.

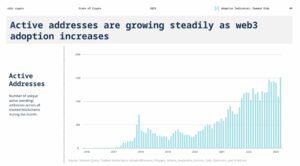

Para ter certeza, o crescimento de aplicativos generativos de IA tem sido impressionante, impulsionado por pura novidade e uma infinidade de casos de uso. Na verdade, estamos cientes de pelo menos três categorias de produtos que já ultrapassaram US$ 100 milhões em receita anualizada: geração de imagens, direitos autorais e criação de códigos.

No entanto, o crescimento por si só não é suficiente para construir empresas de software duráveis. Criticamente, o crescimento deve ser lucrativo - no sentido de que usuários e clientes, uma vez que se inscrevem, geram lucros (altas margens brutas) e permanecem por muito tempo (alta retenção). Na ausência de uma forte diferenciação técnica, os aplicativos B2B e B2C geram valor de longo prazo para o cliente por meio de efeitos de rede, retenção de dados ou criação de fluxos de trabalho cada vez mais complexos.

Na IA generativa, essas suposições não são necessariamente verdadeiras. Nas empresas de aplicativos com as quais conversamos, há uma ampla gama de margens brutas — tão altas quanto 90% em alguns casos, mas mais frequentemente tão baixas quanto 50-60%, impulsionadas principalmente pelo custo da inferência do modelo. O crescimento no topo do funil tem sido incrível, mas não está claro se as estratégias atuais de aquisição de clientes serão escaláveis - já estamos vendo a eficácia da aquisição paga e a retenção começarem a diminuir. Muitos aplicativos também são relativamente indiferenciados, pois dependem de modelos de IA subjacentes semelhantes e não descobriram efeitos de rede óbvios, ou dados/fluxos de trabalho, que são difíceis de serem duplicados pelos concorrentes.

Portanto, ainda não é óbvio que a venda de aplicativos de usuário final seja o único, ou mesmo o melhor, caminho para construir um negócio sustentável de IA generativa. As margens devem melhorar à medida que a concorrência e a eficiência nos modelos linguísticos aumentam (mais sobre isso abaixo). A retenção deve aumentar à medida que os turistas de IA deixarem o mercado. E há um forte argumento a ser feito de que os aplicativos integrados verticalmente têm uma vantagem na diferenciação. Mas ainda há muito a provar.

Olhando para o futuro, algumas das grandes questões enfrentadas pelas empresas de aplicativos de IA generativa incluem:

- Integração vertical (“modelo + app”). O consumo de modelos de IA como um serviço permite que os desenvolvedores de aplicativos interajam rapidamente com uma equipe pequena e troquem os fornecedores de modelos à medida que a tecnologia avança. Por outro lado, alguns desenvolvedores argumentam que o produto is o modelo, e que o treinamento a partir do zero é a única maneira de criar defensibilidade - ou seja, retreinar continuamente os dados do produto proprietário. Mas isso vem com o custo de requisitos de capital muito mais altos e uma equipe de produto menos ágil.

- Recursos de construção versus aplicativos. Os produtos de IA generativa assumem várias formas diferentes: aplicativos de desktop, aplicativos móveis, plug-ins Figma/Photoshop, extensões do Chrome e até mesmo bots do Discord. É fácil integrar produtos de IA onde os usuários já trabalham, pois a IU geralmente é apenas uma caixa de texto. Quais delas se tornarão empresas autônomas – e quais serão absorvidas por empresas estabelecidas, como Microsoft ou Google, que já incorporam IA em suas linhas de produtos?

- Gerenciando através do ciclo do hype. Ainda não está claro se a rotatividade é inerente ao lote atual de produtos generativos de IA ou se é um artefato de um mercado inicial. Ou se o aumento do interesse na IA generativa diminuir à medida que o hype diminuir. Essas questões têm implicações importantes para as empresas de aplicativos, incluindo quando pisar no acelerador na arrecadação de fundos; quão agressivamente investir na aquisição de clientes; quais segmentos de usuários priorizar; e quando declarar adequação do produto ao mercado.

Provedores de modelos inventaram IA generativa, mas não atingiram grande escala comercial

O que hoje chamamos de IA generativa não existiria sem o brilhante trabalho de pesquisa e engenharia feito em lugares como Google, OpenAI e Stability. Por meio de novas arquiteturas de modelos e esforços heróicos para dimensionar pipelines de treinamento, todos nós nos beneficiamos dos recursos alucinantes dos atuais modelos de linguagem grande (LLMs) e modelos de geração de imagens.

No entanto, a receita associada a essas empresas ainda é relativamente pequena em comparação com o uso e o burburinho. Na geração de imagens, o Stable Diffusion teve um crescimento explosivo da comunidade, apoiado por um ecossistema de interfaces de usuário, ofertas hospedadas e métodos de ajuste fino. Mas a Stability oferece seus principais pontos de verificação gratuitamente como um princípio central de seus negócios. Em modelos de linguagem natural, OpenAI domina com GPT-3/3.5 e ChatGPT. Mas relativamente poucos aplicativos matadores construídos em OpenAI existem até agora, e os preços já caiu uma vez.

Isso pode ser apenas um fenômeno temporário. A Stability é uma empresa nova que ainda não se concentrou na monetização. A OpenAI tem o potencial de se tornar um grande negócio, obtendo uma parcela significativa de todas as receitas da categoria NLP à medida que mais aplicativos matadores são criados — especialmente se seus integração no portfólio de produtos da Microsoft vai bem. Dado o enorme uso desses modelos, as receitas em larga escala podem não ficar muito atrás.

Mas também há forças de compensação. Os modelos lançados como código aberto podem ser hospedados por qualquer pessoa, incluindo empresas externas que não arcam com os custos associados ao treinamento de modelo em larga escala (até dezenas ou centenas de milhões de dólares). E não está claro se algum modelo de código fechado pode manter sua vantagem indefinidamente. Por exemplo, estamos começando a ver LLMs construídos por empresas como Anthropic, Cohere e Character.ai se aproximando dos níveis de desempenho da OpenAI, treinados em conjuntos de dados semelhantes (ou seja, a Internet) e com arquiteturas de modelo semelhantes. O exemplo de difusão estável sugere que if modelos de código aberto atingem um nível suficiente de desempenho e suporte da comunidade, então alternativas proprietárias podem achar difícil competir.

Talvez a conclusão mais clara para os provedores de modelos, até agora, seja que a comercialização provavelmente está ligada à hospedagem. A demanda por APIs proprietárias (por exemplo, da OpenAI) está crescendo rapidamente. Os serviços de hospedagem para modelos de código aberto (por exemplo, Hugging Face e Replicate) estão surgindo como centros úteis para compartilhar e integrar facilmente modelos — e até mesmo ter alguns efeitos de rede indiretos entre produtores e consumidores de modelos. Há também uma forte hipótese de que é possível monetizar por meio de ajustes finos e acordos de hospedagem com clientes corporativos.

Além disso, porém, há uma série de grandes questões enfrentadas pelos provedores de modelos:

- Comoditização. Há uma crença comum de que os modelos de IA convergirão em desempenho ao longo do tempo. Conversando com desenvolvedores de aplicativos, fica claro que isso ainda não aconteceu, com fortes líderes em modelos de texto e imagem. Suas vantagens não se baseiam em arquiteturas de modelo exclusivas, mas em altos requisitos de capital, dados de interação de produtos proprietários e poucos talentos de IA. Isso servirá como uma vantagem durável?

- Risco de graduação. Contar com fornecedores de modelos é uma ótima maneira de as empresas de aplicativos começarem e até mesmo expandirem seus negócios. Mas há um incentivo para que construam e/ou hospedem seus próprios modelos assim que atingirem escala. E muitos provedores de modelos têm distribuições de clientes altamente distorcidas, com alguns aplicativos representando a maior parte da receita. O que acontecerá se/quando esses clientes mudarem para o desenvolvimento interno de IA?

- O dinheiro é importante? A promessa da IA generativa é tão grande – e também potencialmente tão prejudicial – que muitos provedores de modelo se organizaram como corporações de benefício público (corporações B), emitiram participações nos lucros limitadas ou incorporaram o bem público explicitamente em sua missão. Isso não atrapalhou em nada seus esforços de arrecadação de fundos. Mas há uma discussão razoável sobre se a maioria dos provedores de modelos realmente queremos para capturar valor, e se eles deveriam.

Os fornecedores de infraestrutura tocam em tudo e colhem os frutos

Quase tudo na IA generativa passa por uma GPU (ou TPU) hospedada na nuvem em algum momento. Seja para provedores de modelos/laboratórios de pesquisa que executam cargas de trabalho de treinamento, empresas de hospedagem que executam inferência/ajuste fino ou empresas de aplicativos que fazem uma combinação de ambos — nelos são a força vital da IA generativa. Pela primeira vez em muito tempo, o progresso na tecnologia de computação mais disruptiva é massivamente vinculado à computação.

Como resultado, muito do dinheiro no mercado de IA generativa acaba fluindo para empresas de infraestrutura. Para colocar alguns muito números aproximados: estimamos que, em média, as empresas de aplicativos gastam cerca de 20 a 40% da receita em inferência e ajuste fino por cliente. Isso normalmente é pago diretamente aos provedores de nuvem para instâncias de computação ou a provedores de modelos terceirizados – que, por sua vez, gastam cerca de metade de sua receita em infraestrutura de nuvem. Portanto, é razoável supor que 10-20% dos rendimento total na IA generativa hoje vai para provedores de nuvem.

Além disso, as startups que treinam seus próprios modelos levantaram bilhões de dólares em capital de risco – a maior parte (até 80-90% nas primeiras rodadas) normalmente também é gasta com os provedores de nuvem. Muitas empresas públicas de tecnologia gastam centenas de milhões por ano em treinamento de modelo, seja com provedores de nuvem externos ou diretamente com fabricantes de hardware.

Isso é o que chamaríamos, em termos técnicos, de “muito dinheiro” — especialmente para um mercado nascente. A maior parte é gasta no Big 3 nuvens: Amazon Web Services (AWS), Google Cloud Platform (GCP) e Microsoft Azure. Esses provedores de nuvem coletivamente gastar mais do que US $ 100 bilhões por ano em capex para garantir que eles tenham as plataformas mais abrangentes, confiáveis e competitivas em custo. Na IA generativa, em particular, eles também se beneficiam das restrições de fornecimento porque têm acesso preferencial a hardware escasso (por exemplo, GPUs Nvidia A100 e H100).

Curiosamente, porém, estamos começando a ver surgir uma concorrência confiável. Desafiadores como a Oracle fizeram incursões com grandes gastos de capex e incentivos de vendas. E algumas startups, como Coreweave e Lambda Labs, cresceram rapidamente com soluções voltadas especificamente para grandes desenvolvedores de modelos. Eles competem em custo, disponibilidade e suporte personalizado. Eles também expõem abstrações de recursos mais granulares (ou seja, contêineres), enquanto as grandes nuvens oferecem apenas instâncias de VM devido aos limites de virtualização de GPU.

Nos bastidores, executando a grande maioria das cargas de trabalho de IA, talvez esteja o maior vencedor em IA generativa até agora: a Nvidia. A empresa relatou $ 3.8 bilhão da receita de GPU de data center no terceiro trimestre de seu ano fiscal de 2023, incluindo uma parte significativa para casos de uso de IA generativa. E eles construíram fossos fortes em torno desse negócio por meio de décadas de investimento na arquitetura de GPU, um ecossistema de software robusto e uso profundo na comunidade acadêmica. Uma análise recente descobriu que as GPUs da Nvidia são citadas em artigos de pesquisa 90 vezes mais do que as principais startups de chips de IA juntas.

Existem outras opções de hardware, incluindo Google Tensor Processing Units (TPUs); GPUs AMD Instinct; chips AWS Inferentia e Trainium; e aceleradores de IA de startups como Cerebras, Sambanova e Graphcore. A Intel, atrasada para o jogo, também está entrando no mercado com seus chips Habana de última geração e GPUs Ponte Vecchio. Mas até agora, poucos desses novos chips conquistaram uma participação significativa no mercado. As duas exceções a serem observadas são o Google, cujos TPUs ganharam força na comunidade Stable Diffusion e em alguns grandes negócios do GCP, e o TSMC, que supostamente fabrica todos os dos chips listados aqui, incluindo GPUs Nvidia (a Intel usa uma mistura de suas próprias fábricas e TSMC para fazer seus chips).

A infraestrutura é, em outras palavras, uma camada lucrativa, durável e aparentemente defensável na pilha. As grandes questões a serem respondidas pelas empresas de infraestrutura incluem:

- Manter cargas de trabalho sem estado. As GPUs Nvidia são as mesmas onde quer que você as alugue. A maioria das cargas de trabalho de IA não tem estado, no sentido de que a inferência de modelo não requer bancos de dados anexados ou armazenamento (além dos próprios pesos do modelo). Isso significa que as cargas de trabalho de IA podem ser mais portáteis entre as nuvens do que as cargas de trabalho de aplicativos tradicionais. Como, nesse contexto, os provedores de nuvem podem criar aderência e impedir que os clientes pulem para a opção mais barata?

- Sobrevivendo ao fim da escassez de chips. Os preços para provedores de nuvem e para a própria Nvidia foram suportados por suprimentos escassos das GPUs mais desejáveis. Um provedor nos disse que o preço de tabela do A100s na verdade aumentou desde o lançamento, o que é altamente incomum para hardware de computação. Quando essa restrição de fornecimento for finalmente removida, por meio do aumento da produção e/ou adoção de novas plataformas de hardware, como isso afetará os provedores de nuvem?

- Uma nuvem desafiadora pode romper? Somos fortes crentes que nuvens verticais ganhará participação de mercado das 3 grandes com ofertas mais especializadas. Até agora, na IA, os desafiantes conquistaram tração significativa por meio de diferenciação técnica moderada e suporte da Nvidia - para quem os provedores de nuvem existentes são os maiores clientes e concorrentes emergentes. A questão de longo prazo é: isso será suficiente para superar as vantagens de escala do Big 3?

Então… onde o valor será acumulado?

Claro, ainda não sabemos. Mas com base nos primeiros dados que temos para IA generativa, combinados com nossa experiência com empresas anteriores de IA/ML, nossa intuição é a seguinte.

Não parece haver, hoje, nenhum fosso sistêmico na IA generativa. Como uma aproximação de primeira ordem, as aplicações carecem de forte diferenciação de produto porque usam modelos semelhantes; os modelos enfrentam diferenciação de longo prazo pouco clara porque são treinados em conjuntos de dados semelhantes com arquiteturas semelhantes; os provedores de nuvem carecem de diferenciação técnica profunda porque executam as mesmas GPUs; e até mesmo as empresas de hardware fabricam seus chips nas mesmas fábricas.

Existem, é claro, os fossos padrão: fossos de escala (“Eu tenho ou posso arrecadar mais dinheiro do que você!”), fossos da cadeia de suprimentos (“Eu tenho as GPUs, você não!”), fossos do ecossistema (“ Todo mundo já usa meu software!”), fossos algorítmicos (“Somos mais espertos que você!”), fossos de distribuição (“Já tenho uma equipe de vendas e mais clientes do que você!”) e fossos de pipeline de dados (“Eu Já naveguei mais na internet do que você!”). Mas nenhum desses fossos tende a ser durável a longo prazo. E é muito cedo para dizer se efeitos de rede fortes e diretos estão ocorrendo em qualquer camada da pilha.

Com base nos dados disponíveis, não está claro se haverá uma dinâmica de longo prazo em que o vencedor leva tudo na IA generativa.

Isso é estranho. Mas para nós, é uma boa notícia. O tamanho potencial deste mercado é difícil de entender - em algum lugar entre todos os softwares e todos os esforços humanos - então esperamos muitos, muitos jogadores e uma competição saudável em todos os níveis da pilha. Também esperamos que as empresas horizontais e verticais tenham sucesso, com a melhor abordagem ditada pelos mercados e usuários finais. Por exemplo, se a principal diferenciação no produto final for a própria IA, é provável que a verticalização (ou seja, acoplar fortemente o aplicativo voltado para o usuário ao modelo doméstico) vença. Considerando que, se a IA fizer parte de um conjunto maior de recursos de cauda longa, é mais provável que ocorra horizontalização. Claro, também devemos ver a construção de fossos mais tradicionais ao longo do tempo – e podemos até ver novos tipos de fossos.

Seja qual for o caso, temos certeza de que a IA generativa muda o jogo. Estamos todos aprendendo as regras em tempo real, há uma quantidade enorme de valor que será desbloqueado e, como resultado, o cenário tecnológico parecerá muito, muito diferente. E estamos aqui para isso!

Todas as imagens neste post foram criadas usando Midjourney.

- Conteúdo com tecnologia de SEO e distribuição de relações públicas. Seja amplificado hoje.

- Platoblockchain. Inteligência Metaverso Web3. Conhecimento Ampliado. Acesse aqui.

- Fonte: https://a16z.com/2023/01/19/who-owns-the-generative-ai-platform/

- $ 100 milhões

- $3

- 1

- a

- A100

- Sobre

- acadêmico

- aceleradores

- Acesso

- alcançado

- aquisição

- em

- Adoção

- avanços

- Vantagem

- vantagens

- Depois de

- acordos

- à frente

- AI

- Plataforma de IA

- casos de uso ai

- AI / ML

- algorítmico

- Todos os Produtos

- permite

- sozinho

- já

- alternativas

- surpreendente

- Amazon

- Amazon Web Services

- Amazon Web Services (AWS)

- AMD

- quantidade

- analisar

- e

- anualizado

- responder

- qualquer um

- APIs

- app

- aparecer

- Aplicação

- aplicações

- Aplicando

- abordagem

- Aplicativos

- arquitetura

- argumentar

- argumento

- por aí

- artificial

- inteligência artificial

- Inteligência artificial (AI)

- associado

- disponibilidade

- disponível

- média

- AWS

- Inferência da AWS

- Azul

- B2B

- B2C

- baseado

- Tenha

- Porque

- tornam-se

- antes

- atrás

- crença

- Acreditar

- Acredita

- crentes

- abaixo

- beneficiar

- MELHOR

- entre

- Pós

- Grande

- O maior

- bilhão

- bilhões

- estrondo

- bots

- obrigado

- Caixa

- Break

- brilhante

- mais amplo

- construir

- Prédio

- construído

- Bullish

- negócio

- negócios

- compradores

- chamada

- capacidades

- capital

- capturar

- Capturar

- casas

- casos

- Categorias

- Categoria

- Centralização de

- certo

- desafiador

- Alterações

- personagem

- ChatGPT

- mais barato

- lasca

- Chips

- Chrome

- citado

- remover filtragem

- mais próximo

- Na nuvem

- infraestrutura de nuvem

- Plataforma em nuvem

- código

- coletivamente

- combinação

- combinado

- como

- comercial

- comercialização

- comum

- comunidade

- Empresas

- Empresa

- comparado

- competir

- competição

- concorrentes

- integrações

- compreensivo

- Computar

- computação

- restrições

- Consumidores

- Containers

- contexto

- continuamente

- convencional

- Convergem

- copywriting

- núcleo

- Corporações

- Custo

- custos

- curso

- crio

- criado

- Criar

- credível

- crítico

- Atual

- cliente

- Clientes

- ciclos

- dados,

- Data Center

- bases de dados

- conjuntos de dados

- acordo

- Ofertas

- décadas

- profundo

- Demanda

- área de trabalho

- desenvolver

- desenvolvedores

- Desenvolvimento

- Devs

- diferente

- formas diferentes

- diferenciado

- Distribuição

- diretamente

- diretamente

- discórdia

- descoberto

- discussão

- disruptivo

- distribuição

- distribuições

- dividido

- fazer

- dólares

- domina

- não

- dezenas

- distância

- dirigido

- Drivers

- condução

- dinâmico

- dinâmica

- cada

- Mais cedo

- Cedo

- Ganhando

- facilmente

- ecossistema

- borda

- efeitos

- eficiência

- esforços

- ou

- emergente

- Engenharia

- suficiente

- garantir

- Empreendimento

- clientes corporativos

- especialmente

- estimativa

- Mesmo

- eventualmente

- tudo

- exemplo

- exemplos

- esperar

- vasta experiência

- extensões

- externo

- Rosto

- enfrentando

- Cair

- Característica

- Funcionalidades

- poucos

- Encontre

- descoberta

- Primeiro nome

- primeira vez

- Fiscal

- caber

- Giro

- Fluindo

- Fluxos

- focado

- seguinte

- Forças

- formas

- encontrado

- Foundation

- fundadores

- Quadro

- Gratuito

- da

- Captação de recursos

- futuro

- Ganhos

- jogo

- GAS

- geralmente

- gerar

- geração

- generativo

- IA generativa

- ter

- dado

- dá

- meta

- vai

- vai

- Bom estado, com sinais de uso

- Parceria

- Google Cloud Platform

- GPU

- GPUs

- aperto

- ótimo

- bruto

- Cresça:

- Crescente

- crescido

- Growth

- Metade

- acontecer

- aconteceu

- acontece

- Queijos duros

- Hardware

- prejudicial

- saudável

- SUA PARTICIPAÇÃO FAZ A DIFERENÇA

- Alta

- superior

- altamente

- histórico

- Acertar

- segurar

- segurando

- Horizontal

- hospedeiro

- hospedado

- hospedagem

- HOT

- Como funciona o dobrador de carta de canal

- HTTPS

- enorme

- humano

- Centenas

- centenas de milhões

- Hype

- imagem

- geração de imagem

- imagens

- Impacto

- implicações

- importante

- melhorar

- in

- Em outra

- Incentivo

- incentivos

- incluir

- Incluindo

- Incorporado

- incorporando

- Crescimento

- aumentou

- Aumenta

- cada vez mais

- incrivelmente

- Titular

- de treinadores em Entrevista Motivacional

- Individual

- indústria

- Infraestrutura

- inerente

- integrar

- integrado

- integração

- Intel

- Inteligência

- interação

- interesse

- interfaces de

- Internet

- intuição

- Inventado

- Investir

- investimento

- Emitido

- IT

- se

- Chave

- Saber

- Laboratório

- Falta

- paisagem

- língua

- grande

- em grande escala

- largamente

- Maior

- Sobrenome

- Ano passado

- Atrasado

- lançamento

- camada

- camadas

- líderes

- aprendizagem

- Deixar

- Nível

- níveis

- Provável

- limites

- linhas

- Lista

- Listado

- longo

- muito tempo

- longo prazo

- olhar

- OLHARES

- lote

- Baixo

- lucrativo

- moldadas

- a manter

- principal

- Maioria

- fazer

- Fabricantes

- muitos

- mapa,

- margens

- mercado

- mapa de mercado

- Estrutura de mercado

- Mercados

- maciço

- massivamente

- max-width

- significativo

- significa

- métodos

- Microsoft

- e Microsoft Azure

- Meio da Jornada

- milhão

- milhões

- Missão

- MLOps

- Móvel Esteira

- aplicativos móveis

- modelo

- modelos

- Monetização

- Monetizar

- dinheiro

- mais

- a maioria

- múltiplo

- nascente

- natural

- Linguagem Natural

- necessariamente

- você merece...

- rede

- Novo

- novo hardware

- notícias

- Próximo

- ágil

- PNL

- romance

- novidade

- número

- números

- Nvidia

- óbvio

- oferecer

- Ofertas

- ONE

- aberto

- open source

- OpenAI

- operadores

- Opção

- Opções

- oráculo

- ordens

- Organizado

- Outros

- de outra forma

- lado de fora

- Superar

- próprio

- possui

- pago

- papéis

- parte

- particular

- peças

- passes

- caminho

- atuação

- possivelmente

- Personalizado

- fenómeno

- oleoduto

- Lugar

- Locais

- plataforma

- Plataformas

- platão

- Inteligência de Dados Platão

- PlatãoData

- players

- abundância

- plugins

- ponto

- possível

- Publique

- potencial

- potencialmente

- poder

- prevendo

- evitar

- preço

- Valores

- primário

- Prévio

- Priorizar

- em processamento

- Produtores

- Produto

- Produção

- Produtos

- Lucro

- rentável

- lucros

- Progresso

- promessa

- proprietário

- Prove

- provedor

- fornecedores

- público

- colocar

- Trimestre

- questão

- Frequentes

- rapidamente

- aumentar

- angariado

- alcance

- rapidamente

- alcançar

- alcançado

- reais

- em tempo real

- razoável

- recentemente

- registros

- relativamente

- liberado

- confiável

- Removido

- Aluguel

- representando

- requerer

- Requisitos

- pesquisa

- recurso

- responsável

- resultar

- retenção

- receita

- receitas

- Risco

- uma conta de despesas robusta

- rodadas

- regras

- Execute

- corrida

- vendas

- Incentivos de vendas

- mesmo

- escalável

- Escala

- Escasso

- Escassez

- Cenas

- visto

- segmentos

- Vender

- sentido

- servir

- serviço

- Serviços

- conjunto

- contexto

- vários

- Shape

- Partilhar

- ações

- rede de apoio social

- mostrar

- assinar

- periodo

- semelhante

- desde

- Tamanho

- pequeno

- sem problemas

- So

- até aqui

- Software

- solução

- Soluções

- alguns

- algum lugar

- fonte

- especializado

- especificamente

- gastar

- gasto

- Estabilidade

- estável

- pilha

- Estágio

- suporte

- autônoma

- padrão

- começo

- começado

- Comece

- inicialização

- Startups

- vara

- Ainda

- armazenamento

- estratégias

- mais forte,

- estrutural

- estrutura

- Lutar

- suceder

- suficiente

- Sugere

- supply

- ajuda

- Suportado

- surge

- sustentável

- Interruptor

- sistêmico

- Tire

- tomar

- Talento

- falando

- visadas

- tarefas

- Profissionais

- tecnologia

- empresas de tecnologia

- Dados Técnicos:

- Equipar

- temporário

- condições

- A

- deles

- si mesmos

- coisa

- Terceiro

- De terceiros

- três

- Através da

- Amarrado

- hermeticamente

- tempo

- vezes

- para

- hoje

- também

- topo

- tocar

- tração

- tradicional

- treinado

- Training

- Transformação

- tremendo

- Tendências

- verdadeiro

- TSMC

- VIRAR

- tipos

- tipicamente

- ui

- Em última análise

- subjacente

- compreender

- único

- unidades

- incomum

- us

- Uso

- usar

- Utilizador

- usuários

- valor

- Grande

- fornecedores

- risco

- capitale a rischio,en

- via

- Ver

- Assistir

- Onda

- web

- serviços web

- bem conhecido

- O Quê

- se

- qual

- enquanto

- QUEM

- Largo

- Ampla variedade

- Wikipedia

- precisarão

- ganhar

- vencedores

- sabedoria

- sem

- palavras

- Atividades:

- fluxos de trabalho

- escrita

- ano

- zefirnet