A inteligência artificial (IA) revolucionou vários setores, oferecendo inúmeros benefícios e oportunidades. No entanto, surgiram preocupações relativamente ao potencial da IA para perpetuar a discriminação e os preconceitos. Este artigo explora o tema da discriminação da IA, lançando luz sobre os desafios de identificar e abordar preconceitos incorporados nos sistemas de IA. Os membros da indústria expressam dúvidas sobre as implicações morais e éticas da IA, citando preocupações sobre a desinformação, preconceitos nos algoritmos e a geração de conteúdos enganosos. À medida que os debates em torno da IA se intensificam, há um apelo crescente por uma regulamentação significativa para garantir a transparência, a responsabilização e a proteção dos direitos fundamentais.

Desafios para os setores financeiros com IA

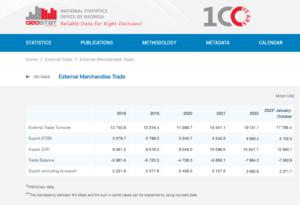

De acordo com Nabil Manji, chefe de criptografia e Web3 da Worldpay by FIS, a eficácia dos produtos de IA depende muito da qualidade do material de origem usado para treinamento. Em entrevista à CNBC, Manji explicou que dois fatores principais contribuem para o desempenho da IA: os dados aos quais ela tem acesso e as capacidades do grande modelo de linguagem.

Para ilustrar a importância dos dados, Manji mencionou que empresas como o Reddit declararam publicamente restrições à extração de dados, exigindo pagamento pelo acesso. No sector dos serviços financeiros, destacou o desafio dos sistemas de dados fragmentados em vários idiomas e formatos. Esta falta de consolidação e harmonização limita a eficácia dos produtos baseados na IA, especialmente quando comparados com indústrias com infraestruturas de dados padronizadas e modernizadas.

De acordo com Manji, a utilização de blockchain ou tecnologia de contabilidade distribuída pode oferecer uma solução potencial para resolver este problema. Esta abordagem inovadora pode proporcionar maior transparência aos dados fragmentados armazenados nos intrincados sistemas dos bancos convencionais. No entanto, reconheceu que a natureza altamente regulamentada e lenta dos bancos pode impedir a sua capacidade de adotar rapidamente novas ferramentas de IA, ao contrário de empresas tecnológicas mais ágeis, como a Microsoft e a Google, que têm estado na vanguarda da promoção da inovação nos últimos anos. décadas.

Considerando estes factores, torna-se evidente que a indústria financeira enfrenta desafios únicos na alavancagem da IA devido às complexidades da integração de dados e à natureza inerente do sector bancário.

De acordo com Rumman Chowdhury, ex-chefe de ética, transparência e responsabilidade de aprendizado de máquina no Twitter, os empréstimos são um exemplo notável de como o preconceito nos sistemas de IA pode afetar negativamente as comunidades marginalizadas. Falando num painel de discussão em Amsterdã, Chowdhury destacou a prática histórica de “redlining” em Chicago durante a década de 1930. Redlining envolveu a negação de empréstimos a bairros predominantemente afro-americanos com base na demografia racial.

Chowdhury explicou que, embora os algoritmos modernos possam não incluir explicitamente a raça como um ponto de dados, os preconceitos ainda podem ser codificados implicitamente. Ao desenvolver algoritmos para avaliar o risco dos distritos e indivíduos para fins de empréstimo, os dados históricos que contêm preconceitos podem perpetuar inadvertidamente a discriminação.

Angle Bush, o visionário por trás das Mulheres Negras na Inteligência Artificial, destacou a importância de reconhecer os perigos associados à reprodução de preconceitos incorporados em dados históricos ao empregar sistemas de IA para tomar decisões de aprovação de empréstimos. Esta prática pode levar à rejeição automática de pedidos de empréstimo de comunidades marginalizadas, perpetuando assim as desigualdades raciais ou de género.

Frost Li, um experiente desenvolvedor de IA, apontou os desafios da personalização em Integração de IA. A seleção de “recursos essenciais” para o treinamento de modelos de IA pode, às vezes, envolver fatores não relacionados que podem levar a resultados tendenciosos. Li deu um exemplo de como as startups de fintech voltadas para estrangeiros podem enfrentar diferentes critérios de avaliação de crédito em comparação com os bancos locais, que estão mais familiarizados com as escolas e comunidades locais.

Niklas Guske, COO da Taktile, uma startup especializada em automatizar a tomada de decisões para fintechs, esclareceu que a IA generativa normalmente não é usada para criar pontuações de crédito ou pontuação de risco dos consumidores. Pelo contrário, a sua força reside no pré-processamento de dados não estruturados, como ficheiros de texto, para melhorar a qualidade dos dados para modelos de subscrição convencionais.

Em resumo, a utilização da IA em empréstimos e serviços financeiros levanta preocupações sobre preconceitos e discriminação. Os preconceitos históricos incorporados nos dados e a seleção de características irrelevantes durante o treino em IA podem levar a resultados injustos. É crucial que os bancos e as instituições financeiras reconheçam e abordem estas questões para evitar a perpetuação inadvertida da discriminação ao implementar soluções de IA.

Prova de discriminação por IA

Provar a discriminação baseada na IA pode ser um desafio, como sublinham exemplos como o caso envolvendo a Apple e a Goldman Sachs. O Departamento de Serviços Financeiros do Estado de Nova York rejeitou as alegações de imposição de limites mais baixos ao Apple Card para mulheres, alegando falta de evidências fundamentadas.

Kim Smouter, diretor da Rede Europeia Contra o Racismo, salienta que a implantação em massa da IA provoca opacidade nos processos de tomada de decisão, tornando difícil para os indivíduos identificar e abordar a discriminação.

Smouter explica que os indivíduos muitas vezes têm conhecimento limitado de como funcionam os sistemas de IA, tornando difícil detectar casos de discriminação ou preconceitos sistêmicos. Torna-se ainda mais complexo quando a discriminação faz parte de uma questão mais ampla que afeta vários indivíduos. Smouter faz referência ao escândalo do bem-estar infantil holandês, onde um grande número de pedidos de benefícios foram erroneamente rotulados como fraudulentos devido a preconceitos institucionais. A descoberta de tais disfunções é um desafio e a obtenção de reparação pode ser difícil e demorada, conduzindo a danos significativos e por vezes irreversíveis.

Estes exemplos ilustram as dificuldades inerentes à fundamentação da discriminação baseada na IA e à obtenção de soluções quando tal discriminação ocorre. A complexidade dos sistemas de IA e a falta de transparência nos processos de tomada de decisão podem tornar difícil para os indivíduos reconhecer e abordar eficazmente os casos de discriminação.

De acordo com Chowdhury, há uma necessidade premente de um órgão regulador global semelhante às Nações Unidas para abordar os riscos associados à IA. Embora a IA tenha demonstrado uma inovação notável, foram levantadas preocupações por tecnólogos e especialistas em ética relativamente às suas implicações morais e éticas. Estas preocupações abrangem questões como a desinformação, os preconceitos raciais e de género incorporados nos algoritmos de IA e a geração de conteúdos enganosos por ferramentas como o ChatGPT.

Chowdhury expressa preocupação em entrar em um mundo pós-verdade, onde as informações online, incluindo texto, vídeo e áudio, tornam-se indignas de confiança devido à IA generativa. Isto levanta questões sobre como podemos garantir a integridade da informação e como podemos confiar nela para tomar decisões informadas. Tomando como exemplo a Lei da IA da União Europeia, uma regulamentação significativa da IA é crucial neste momento. No entanto, existem preocupações sobre o longo prazo necessário para que as propostas regulamentares se tornem eficazes, atrasando potencialmente as ações necessárias.

Smouter enfatiza a necessidade de maior transparência e responsabilidade nos algoritmos de IA. Isto inclui tornar os algoritmos mais compreensíveis para não especialistas, realizar testes e publicar resultados, estabelecer processos de reclamação independentes, realizar auditorias e relatórios periódicos e envolver comunidades racializadas na concepção e implementação de tecnologia. A aplicação da Lei da IA, que adota uma perspectiva de direitos fundamentais e introduz conceitos como reparação, deverá começar em aproximadamente dois anos. A redução deste prazo seria vantajosa para manter a transparência e a responsabilização como aspectos integrantes da inovação.

- Conteúdo com tecnologia de SEO e distribuição de relações públicas. Seja amplificado hoje.

- PlatoData.Network Gerativa Vertical Ai. Capacite-se. Acesse aqui.

- PlatoAiStream. Inteligência Web3. Conhecimento Amplificado. Acesse aqui.

- PlatãoESG. Automotivo / EVs, Carbono Tecnologia Limpa, Energia, Ambiente, Solar, Gestão de resíduos. Acesse aqui.

- BlockOffsets. Modernizando a Propriedade de Compensação Ambiental. Acesse aqui.

- Fonte: https://www.forexnewsnow.com/fintech/the-urgency-of-addressing-ai-discrimination-transparency-accountability-and-regulatory-timelines/

- :tem

- :é

- :não

- :onde

- a

- habilidade

- Sobre

- Acesso

- responsabilidade

- reconhecido

- Aja

- ações

- endereço

- endereçando

- adotar

- vantajoso

- adversamente

- afetar

- africano

- contra

- ágil

- AI

- Lei de IA

- Sistemas de IA

- Treinamento de IA

- algoritmos

- Alegações

- Apesar

- americano

- amsterdam

- an

- e

- Antecipado

- Apple

- Cartão Apple

- aplicações

- abordagem

- aprovação

- aproximadamente

- SOMOS

- artigo

- artificial

- inteligência artificial

- AS

- aspectos

- avaliar

- avaliação

- associado

- At

- auditivo

- auditorias

- Automático

- automatizando

- Bancário

- setor bancário

- bancos

- baseado

- BE

- tornam-se

- torna-se

- sido

- atrás

- beneficiar

- Benefícios

- viés

- tendencioso

- vieses

- Preto

- blockchain

- corpo

- Traz

- mais amplo

- by

- chamada

- CAN

- capacidades

- cartão

- casas

- desafiar

- desafios

- desafiante

- ChatGPT

- Chicago

- criança

- reivindicações

- clarificado

- CNBC

- Comunidades

- Empresas

- comparado

- reclamação

- integrações

- complexidades

- complexidade

- conceitos

- Preocupações

- condutor

- consolidação

- Consumidores

- contém

- conteúdo

- contrário

- contribuir

- convencional

- Coo

- Criar

- crédito

- critérios

- crucial

- cripto

- perigos

- dados,

- infraestrutura de dados

- integração de dados

- qualidade de dados

- debates

- décadas

- Tomada de Decisão

- decisões

- Demografia

- Departamento

- depende

- desenvolvimento

- Design

- Developer

- em desenvolvimento

- diferente

- difícil

- dificuldades

- Diretor

- descoberta

- Discriminação

- discussão

- distribuído

- Ledger distribuído

- tecnologia de contabilidade distribuída

- condução

- dois

- durante

- Neerlandês

- Eficaz

- efetivamente

- eficácia

- incorporado

- emergiu

- enfatiza

- abranger

- aplicação

- aumentar

- aprimorada

- garantir

- entrar

- especialmente

- estabelecendo

- considerações éticas

- ética

- Europa

- Mesmo

- evidência

- evidente

- exemplo

- exemplos

- experiente

- explicado

- Explica

- explora

- expresso

- Rosto

- rostos

- fatores

- familiar

- Funcionalidades

- poucos

- Arquivos

- financeiro

- indústrias financeiras

- Instituições financeiras

- serviços financeiros

- FinTech

- startups fintech

- fintechs

- FIS

- Escolha

- Frente

- Antigo

- fragmentado

- fraudulento

- da

- fundamental

- Gênero

- geração

- generativo

- IA generativa

- Global

- goldman

- Goldman Sachs

- maior

- Crescente

- prejudicar

- Ter

- he

- cabeça

- fortemente

- Destaque

- altamente

- histórico

- Como funciona o dobrador de carta de canal

- Contudo

- HTTPS

- identificar

- identificar

- implementação

- implicações

- importância

- imponente

- in

- incluir

- inclui

- Incluindo

- de treinadores em Entrevista Motivacional

- indivíduos

- indústrias

- indústria

- desigualdades

- INFORMAÇÕES

- informado

- Infraestrutura

- inerente

- Inovação

- inovadores

- DOCUMENTOS

- instituições

- integral

- integração

- integridade

- Inteligência

- Entrevista

- para dentro

- Introduz

- envolver

- envolvido

- envolvendo

- emitem

- questões

- IT

- ESTÁ

- Conhecimento

- Falta

- língua

- Idiomas

- grande

- conduzir

- principal

- aprendizagem

- Ledger

- empréstimo

- aproveitando

- li

- encontra-se

- leve

- como

- Limitado

- limites

- empréstimo

- Empréstimos

- local

- BANCOS LOCAIS

- diminuir

- máquina

- aprendizado de máquina

- a Principal

- fazer

- Fazendo

- Massa

- material

- Posso..

- significativo

- mencionado

- Microsoft

- poder

- Desinformação

- enganosa

- modelo

- modelos

- EQUIPAMENTOS

- momento

- moral

- mais

- múltiplo

- Das Nações

- Natureza

- necessário

- você merece...

- rede

- Novo

- New York

- Estado de Nova Iorque

- Departamento de Serviços Financeiros do Estado de Nova York

- não especialistas

- notável

- número

- numeroso

- numerosos benefícios

- obtendo

- of

- oferecer

- oferecendo treinamento para distância

- frequentemente

- on

- online

- operar

- oportunidades

- or

- Fora

- resultados

- painel

- painel de discussão

- parte

- passado

- pagamento

- atuação

- periodicamente

- Personalização

- perspectiva

- platão

- Inteligência de Dados Platão

- PlatãoData

- ponto

- pontos

- potencial

- potencialmente

- prática

- predominantemente

- premente

- evitar

- Problema

- processos

- Produtos

- Propostas

- proteção

- fornecer

- fornecido

- publicamente

- Publishing

- fins

- qualidade

- Frequentes

- Corrida

- racismo

- angariado

- raises

- reconhecer

- redução

- referências

- em relação a

- regulamentadas

- Regulamento

- reguladores

- depender

- notável

- Relatórios

- restrições

- Resultados

- revolucionou

- direitos

- Risco

- riscos

- Sachs

- Escândalo

- Escolas

- pontuações

- marcar

- raspagem

- setor

- selecionando

- doadores,

- Serviços

- mostrando

- significado

- periodo

- semelhante

- solução

- Soluções

- fonte

- falando

- especializando

- inicialização

- Startups

- Estado

- Departamento de Estado

- Ainda

- armazenadas

- força

- tal

- RESUMO

- Em torno da

- rapidamente

- sistêmico

- sistemas

- equipamento

- toma

- alvejando

- tecnologia

- empresas de tecnologia

- tecnólogos

- Tecnologia

- testes

- que

- A

- A fonte

- deles

- Lá.

- assim

- Este

- isto

- demorado

- linha do tempo

- timelines

- para

- ferramentas

- tópico

- Training

- Transparência

- dois

- tipicamente

- compreensível

- underwriting

- Injusto

- único

- Unido

- nações unidas

- ao contrário

- Defender

- urgência

- usar

- usava

- vário

- Vídeo

- visionário

- we

- Web3

- Bem-estar

- foram

- quando

- qual

- enquanto

- de

- dentro

- Mulher

- mundo

- WorldPay

- preocupar-se

- seria

- anos

- Iorque

- zefirnet