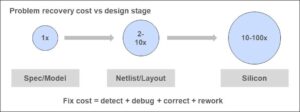

Conversei recentemente com Stelios Diamantidis (Distinguished Architect, Head of Strategy, Autonomous Design Solutions) sobre o anúncio da Synopsys no 100th tapeout do cliente usando sua solução DSO.ai. A minha preocupação em relação aos artigos relacionados com a IA é evitar o hype que rodeia a IA em geral e, inversamente, o cepticismo em reacção a esse hype que leva alguns a rejeitar todas as alegações de IA como óleo de cobra. Fiquei feliz em ouvir Stelios rir e concordar de todo o coração. Tivemos uma discussão bastante fundamentada sobre o que o DSO.ai pode fazer hoje, o que seus clientes de referência veem na solução (com base no que ele pode fazer hoje) e o que ele poderia me dizer sobre a tecnologia.

O que DSO.ai faz

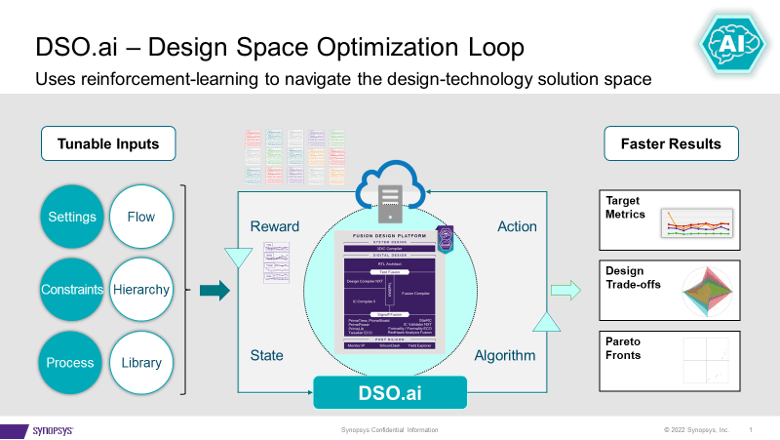

DSO.ai combina com Fusion Compiler e IC Compiler II, que, como Stelios teve o cuidado de enfatizar, significa que esta é uma solução de otimização em nível de bloco; SoCs completos ainda não são um alvo. Isso se adapta às práticas atuais de design, já que Stelios disse que um objetivo importante é ajustar-se facilmente aos fluxos existentes. O objetivo da tecnologia é permitir que os engenheiros de implementação, muitas vezes um único engenheiro, melhorem sua produtividade e, ao mesmo tempo, explorem um espaço de design maior para um PPA melhor do que poderia ser descoberto de outra forma.

A Synopsys anunciou a primeira fita no verão de 2021 e já anunciou 100 fitas. Isso demonstra bem a procura e a eficácia de uma solução como esta. Stelios acrescentou que o valor se torna ainda mais óbvio para aplicações que precisam instanciar um bloco muitas vezes. Pense em um servidor com vários núcleos, uma GPU ou um switch de rede. Otimize um bloco uma vez, instancie várias vezes – isso pode resultar em uma melhoria significativa do PPA.

Perguntei se os clientes que fazem isso estão trabalhando em 7nm e abaixo. Surpreendentemente, há uso ativo até 40nm. Um exemplo interessante é um controlador de flash, um design que não é muito sensível ao desempenho, mas pode funcionar de dezenas a centenas de milhões de unidades. Reduzir o tamanho mesmo em 5% aqui pode ter um grande impacto nas margens.

O que está sob o capô

DSO.ai é baseado no aprendizado por reforço, um tema quente atualmente, mas não prometi nenhum exagero neste artigo. Pedi a Stelios que se aprofundasse um pouco mais, mas não fiquei surpreso quando ele disse que não poderia revelar muito. O que ele poderia me dizer era bastante interessante. Ele destacou que, em aplicações mais gerais, um ciclo através de um conjunto de treinamento (uma época) pressupõe um método rápido (de segundos a minutos) para avaliar as próximas etapas possíveis, por meio de comparações de gradientes, por exemplo.

Mas o design sério de blocos não pode ser otimizado com estimativas rápidas. Cada teste deve percorrer todo o fluxo de produção, mapeando processos de fabricação reais. Fluxos que podem levar horas para serem executados. Parte da estratégia para uma aprendizagem por reforço eficaz, dada esta restrição, é o paralelismo. O resto é molho secreto DSO.ai. Certamente você pode imaginar que se esse molho secreto puder apresentar refinamentos eficazes com base em uma determinada época, então o paralelismo acelerará o progresso ao longo da próxima época.

Para esse fim, esse recurso realmente deve ser executado em uma nuvem para suportar o paralelismo. A nuvem privada local é uma opção. A Microsoft anunciou que está hospedando DSO.ai no Azure, e a ST relata no comunicado à imprensa DSO.ai que usou esse recurso para otimizar a implementação de um núcleo Arm. Imagino que possa haver alguns debates interessantes sobre os prós e os contras de executar uma otimização em uma nuvem pública em, digamos, 1000 servidores, se a redução de área valer a pena.

Feedback do cliente

A Synopsys afirma que os clientes (incluindo ST e SK Hynix neste anúncio) estão relatando aumentos de produtividade 3x+, potência total até 25% menor e redução significativa no tamanho da matriz, tudo com uso reduzido de recursos gerais. Dado o que Stelios descreveu, isto parece-me razoável. A ferramenta permite a exploração de mais pontos no espaço de estados de projeto dentro de um determinado cronograma do que seria possível se essa exploração fosse manual. Contanto que o algoritmo de busca (o ingrediente secreto) seja eficaz, é claro que encontraria um ótimo melhor do que uma busca manual.

Em suma, nem exagero de IA nem óleo de cobra. DSO.ai sugere que a IA está a entrar no mercado como uma extensão de engenharia credível aos fluxos existentes. Você pode aprender mais com o comunicados à CMVM ea partir este blog.

Compartilhe esta postagem via:

- Conteúdo com tecnologia de SEO e distribuição de relações públicas. Seja amplificado hoje.

- Platoblockchain. Inteligência Metaverso Web3. Conhecimento Ampliado. Acesse aqui.

- Fonte: https://semiwiki.com/artificial-intelligence/324430-synopsys-design-space-optimization-hits-a-milestone/

- 100

- 2021

- a

- Sobre

- acelerar

- em

- ativo

- adicionado

- AI

- algoritmo

- Todos os Produtos

- permite

- e

- anunciou

- Anúncio

- aplicações

- ÁREA

- ARM

- por aí

- artigo

- artigos

- Autônomo

- evitando

- Azul

- baseado

- torna-se

- abaixo

- Melhor

- Grande

- Pouco

- Bloquear

- cuidadoso

- certamente

- reivindicações

- Na nuvem

- como

- Interesse

- Desvantagens

- controlador

- núcleo

- poderia

- curso

- credível

- Atual

- cliente

- Clientes

- ciclo

- dias

- debates

- Demanda

- descrito

- Design

- morrem

- discussão

- Fechar

- Distinto

- fazer

- down

- cada

- facilmente

- Eficaz

- eficácia

- enfatizar

- permitir

- engenheiro

- Engenharia

- Engenheiros

- suficiente

- época

- estimativas

- Mesmo

- exemplo

- existente

- exploração

- Explorando

- extensão

- RÁPIDO

- Encontre

- Primeiro nome

- caber

- Flash

- fluxo

- Fluxos

- da

- cheio

- fusão

- Geral

- dado

- meta

- GPU

- feliz

- cabeça

- SUA PARTICIPAÇÃO FAZ A DIFERENÇA

- acessos

- hospedagem

- HOT

- HORÁRIO

- HTTPS

- Hype

- Impacto

- implementação

- importante

- melhorar

- melhoria

- in

- Incluindo

- Aumenta

- interessante

- IT

- Maior

- rir

- APRENDER

- aprendizagem

- longo

- moldadas

- Corrente principal

- manual

- fabrica

- muitos

- mapeamento

- margens

- max-width

- significa

- método

- Microsoft

- poder

- marco miliário

- milhão

- minutos

- mais

- Nem

- rede

- Próximo

- óbvio

- AZEITE E AZEITE EVO

- ONE

- otimização

- Otimize

- otimizado

- ótimo

- Opção

- de outra forma

- global

- parte

- atuação

- platão

- Inteligência de Dados Platão

- PlatãoData

- ponto

- pontos

- possível

- Publique

- poder

- práticas

- imprensa

- Comunicados à CMVM

- privado

- processos

- Produção

- produtividade

- Progresso

- prometido

- PROS

- público

- nuvem pública

- propósito

- Links

- reação

- reais

- razoável

- recentemente

- Reduzido

- redução

- aprendizagem de reforço

- liberar

- Denunciar

- Relatórios

- Recursos

- DESCANSO

- revelar

- Execute

- corrida

- Dito

- cronograma

- Pesquisar

- segundo

- Segredo

- sensível

- grave

- conjunto

- Baixo

- periodo

- solteiro

- Tamanho

- Ceticismo

- solução

- Soluções

- alguns

- Espaço

- fala

- Estado

- Passos

- Estratégia

- Sugere

- verão

- ajuda

- admirado

- Interruptor

- Tire

- Target

- Equipar

- A

- A área

- deles

- Através da

- vezes

- para

- hoje

- também

- ferramenta

- tópico

- Total

- Training

- julgamento

- para

- unidades

- usar

- valor

- via

- O Quê

- qual

- enquanto

- precisarão

- dentro

- trabalhar

- Equivalente há

- seria

- zefirnet