07 de fevereiro de 2023 (

Notícias do Nanowerk) Grandes modelos de linguagem como o GPT-3 da OpenAI são redes neurais massivas que podem gerar textos semelhantes aos humanos, desde poesia até código de programação. Treinados usando uma grande quantidade de dados da Internet, esses modelos de aprendizado de máquina pegam um pequeno pedaço de texto de entrada e, em seguida, prevêem o texto que provavelmente virá a seguir. Mas isso não é tudo que esses modelos podem fazer. Os investigadores estão a explorar um fenómeno curioso conhecido como aprendizagem em contexto, no qual um grande modelo de linguagem aprende a realizar uma tarefa depois de ver apenas alguns exemplos – apesar de não ter sido treinado para essa tarefa. Por exemplo, alguém poderia alimentar o modelo com várias frases de exemplo e seus sentimentos (positivos ou negativos) e, em seguida, sugerir uma nova frase, e o modelo pode fornecer o sentimento correto. Normalmente, um modelo de aprendizado de máquina como o GPT-3 precisaria ser treinado novamente com novos dados para esta nova tarefa. Durante esse processo de treinamento, o modelo atualiza seus parâmetros à medida que processa novas informações para aprender a tarefa. Mas com o aprendizado contextual, os parâmetros do modelo não são atualizados, então parece que o modelo aprende uma nova tarefa sem aprender absolutamente nada. Cientistas do MIT, do Google Research e da Universidade de Stanford estão se esforçando para desvendar esse mistério. Eles estudaram modelos muito semelhantes a grandes modelos de linguagem para ver como poderiam aprender sem atualizar parâmetros. Os resultados teóricos dos pesquisadores mostram que esses modelos de redes neurais massivas são capazes de conter modelos lineares menores e mais simples enterrados dentro deles. O modelo grande poderia então implementar um algoritmo de aprendizagem simples para treinar esse modelo linear menor para completar uma nova tarefa, usando apenas as informações já contidas no modelo maior. Seus parâmetros permanecem fixos. Um passo importante para a compreensão dos mecanismos por trás da aprendizagem no contexto, esta pesquisa abre a porta para uma maior exploração em torno dos algoritmos de aprendizagem que esses grandes modelos podem implementar, diz Ekin Akyürek, estudante de graduação em ciência da computação e autor principal de um artigo (

“Qual algoritmo de aprendizagem é aprendizagem em contexto? Investigações com modelos lineares”) explorando esse fenômeno. Com uma melhor compreensão da aprendizagem no contexto, os investigadores poderiam permitir que os modelos concluíssem novas tarefas sem a necessidade de uma reciclagem dispendiosa. “Normalmente, se você quiser ajustar esses modelos, precisará coletar dados específicos do domínio e fazer alguma engenharia complexa. Mas agora podemos apenas alimentá-lo com uma entrada, cinco exemplos, e ele realiza o que queremos. Portanto, a aprendizagem contextual é um fenômeno bastante interessante”, diz Akyürek. Juntando-se a Akyürek no artigo estão Dale Schuurmans, cientista pesquisador do Google Brain e professor de ciência da computação na Universidade de Alberta; bem como os autores seniores Jacob Andreas, professor assistente do X Consortium no Departamento de Engenharia Elétrica e Ciência da Computação do MIT e membro do Laboratório de Ciência da Computação e Inteligência Artificial do MIT (CSAIL); Tengyu Ma, professor assistente de ciência da computação e estatística em Stanford; e Danny Zhou, principal cientista e diretor de pesquisa do Google Brain. A pesquisa será apresentada na Conferência Internacional sobre Representações de Aprendizagem.

Um modelo dentro de um modelo

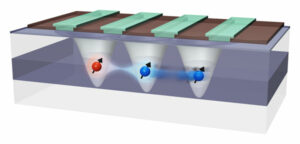

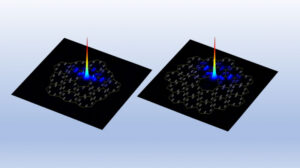

Na comunidade de pesquisa em aprendizado de máquina, muitos cientistas passaram a acreditar que grandes modelos de linguagem podem realizar o aprendizado no contexto devido à forma como são treinados, diz Akyürek. Por exemplo, o GPT-3 tem centenas de bilhões de parâmetros e foi treinado pela leitura de grandes quantidades de texto na Internet, desde artigos da Wikipédia até postagens no Reddit. Portanto, quando alguém mostra exemplos de modelo de uma nova tarefa, provavelmente já viu algo muito semelhante porque seu conjunto de dados de treinamento incluía texto de bilhões de sites. Ele repete padrões observados durante o treinamento, em vez de aprender a realizar novas tarefas. Akyürek levantou a hipótese de que os alunos em contexto não estão apenas correspondendo a padrões vistos anteriormente, mas, em vez disso, estão realmente aprendendo a realizar novas tarefas. Ele e outros experimentaram fornecer instruções a esses modelos usando dados sintéticos, que não poderiam ter visto em nenhum lugar antes, e descobriram que os modelos ainda podiam aprender com apenas alguns exemplos. Akyürek e seus colegas pensaram que talvez esses modelos de redes neurais tenham dentro deles modelos menores de aprendizado de máquina que os modelos possam treinar para completar uma nova tarefa. “Isso poderia explicar quase todos os fenômenos de aprendizagem que vimos com esses grandes modelos”, diz ele. Para testar essa hipótese, os pesquisadores usaram um modelo de rede neural denominado transformador, que possui a mesma arquitetura do GPT-3, mas foi treinado especificamente para aprendizagem no contexto. Ao explorar a arquitetura deste transformador, eles provaram teoricamente que ele pode escrever um modelo linear dentro de seus estados ocultos. Uma rede neural é composta por muitas camadas de nós interconectados que processam dados. Os estados ocultos são as camadas entre as camadas de entrada e saída. Suas avaliações matemáticas mostram que este modelo linear está escrito em algum lugar nas primeiras camadas do transformador. O transformador pode então atualizar o modelo linear implementando algoritmos de aprendizagem simples. Em essência, o modelo simula e treina uma versão menor de si mesmo.

Sondando camadas ocultas

Os pesquisadores exploraram essa hipótese por meio de experimentos de sondagem, onde procuraram nas camadas ocultas do transformador para tentar recuperar uma determinada quantidade. “Nesse caso, tentamos recuperar a solução real do modelo linear e pudemos mostrar que o parâmetro está escrito nos estados ocultos. Isso significa que o modelo linear está em algum lugar”, diz ele. Com base neste trabalho teórico, os pesquisadores podem permitir que um transformador execute o aprendizado no contexto adicionando apenas duas camadas à rede neural. Ainda há muitos detalhes técnicos a serem resolvidos antes que isso seja possível, adverte Akyürek, mas poderia ajudar os engenheiros a criar modelos que possam completar novas tarefas sem a necessidade de retreinamento com novos dados. No futuro, Akyürek planeja continuar explorando a aprendizagem contextual com funções que são mais complexas do que os modelos lineares estudados neste trabalho. Eles também poderiam aplicar esses experimentos a grandes modelos de linguagem para ver se seus comportamentos também são descritos por algoritmos de aprendizagem simples. Além disso, ele quer se aprofundar nos tipos de dados de pré-treinamento que podem permitir a aprendizagem no contexto. “Com este trabalho, as pessoas agora podem visualizar como esses modelos podem aprender com os exemplares. Portanto, espero que isso mude a opinião de algumas pessoas sobre a aprendizagem contextual”, diz Akyürek. “Esses modelos não são tão burros quanto as pessoas pensam. Eles não apenas memorizam essas tarefas. Eles podem aprender novas tarefas e nós mostramos como isso pode ser feito.”

- Conteúdo com tecnologia de SEO e distribuição de relações públicas. Seja amplificado hoje.

- Platoblockchain. Inteligência Metaverso Web3. Conhecimento Ampliado. Acesse aqui.

- Fonte: https://www.nanowerk.com/news2/robotics/newsid=62325.php