À medida que a inovação em inteligência artificial (IA) continua em ritmo acelerado, 2024 será um momento crucial para as organizações e órgãos governamentais estabelecerem padrões de segurança, protocolos e outras proteções para evitar que a IA os ultrapasse, alertam especialistas em segurança.

Grandes modelos de linguagem (LLMs), alimentados por algoritmos sofisticados e enormes conjuntos de dados, demonstram notável compreensão da linguagem e capacidades de conversação semelhantes às humanas. Uma das plataformas mais sofisticadas até o momento é o GPT-4 da OpenAI, que possui recursos avançados de raciocínio e resolução de problemas e alimenta o bot ChatGPT da empresa. E a empresa, em parceria com a Microsoft, começou a trabalhar no GPT-5, que o CEO Sam Altman disse irá muito mais longe – a ponto de possuir “superinteligência”.

Estes modelos representam um enorme potencial para ganhos significativos de produtividade e eficiência para as organizações, mas os especialistas concordam que chegou a hora de a indústria como um todo para lidar com os riscos de segurança inerentes decorrentes do seu desenvolvimento e implantação. De fato, pesquisa recente do Writerbuddy AI, que oferece uma ferramenta de escrita de conteúdo baseada em IA, descobriu que o ChatGPT já teve 14 bilhões de visitas e continua aumentando.

À medida que as organizações avançam em direção ao progresso na IA, isso “deve ser acompanhado de rigorosas considerações éticas e avaliações de risco”, afirma Gal Ringel, CEO da empresa de privacidade e segurança baseada em IA MineOS.

A IA é uma ameaça existencial?

As preocupações em torno da segurança da próxima geração de IA começaram a surgir em março, com uma carta aberta assinada por quase 34,000 tecnólogos de topo que apelavam à suspensão do desenvolvimento de sistemas generativos de IA mais poderosos do que GPA-4 do OpenAI. A carta citava os “riscos profundos” que a tecnologia representa para a sociedade e a “corrida descontrolada dos laboratórios de IA para desenvolver e implantar mentes digitais cada vez mais poderosas que ninguém – nem mesmo seus criadores – pode compreender, prever ou controle confiável.”

Apesar desses medos distópicos, a maioria dos especialistas em segurança não está tão preocupada com um cenário apocalíptico em que as máquinas se tornarão mais inteligentes que os humanos e dominarão o mundo.

“A carta aberta destacou preocupações válidas sobre o rápido avanço e as aplicações potenciais da IA em um sentido amplo, ‘isso é bom para a humanidade’”, disse Matt Wilson, diretor de engenharia de vendas da empresa de segurança cibernética Netrix. “Embora impressionantes em certos cenários, as versões públicas das ferramentas de IA não parecem tão ameaçadoras.”

O que é preocupante é o facto de os avanços e a adoção da IA estarem a avançar demasiado rapidamente para que os riscos possam ser geridos adequadamente, observam os investigadores. “Não podemos fechar a caixa de Pandora”, observa Patrick Harr, CEO do fornecedor de segurança de IA SlashNext.

Além disso, apenas “tentar parar a taxa de inovação no espaço não ajudará a mitigar” os riscos que apresenta, que devem ser abordados separadamente, observa Marcus Fowler, CEO da empresa de segurança de IA DarkTrace Federal. Isso não significa que o desenvolvimento da IA deva continuar sem controle, diz ele. Pelo contrário, a taxa de avaliação de riscos e de implementação de salvaguardas adequadas deve corresponder à taxa a que os LLM estão a ser formados e desenvolvidos.

“A tecnologia de IA está a evoluir rapidamente, por isso os governos e as organizações que utilizam a IA também devem acelerar as discussões sobre a segurança da IA”, explica Fowler.

Riscos de IA generativa

Existem vários riscos amplamente reconhecidos para a IA generativa que exigem consideração e só irão piorar à medida que as gerações futuras da tecnologia se tornarem mais inteligentes. Felizmente para os humanos, nenhum deles até agora representa um cenário apocalíptico de ficção científica em que a IA conspira para destruir os seus criadores.

Em vez disso, incluem ameaças muito mais familiares, como vazamentos de dados, potencialmente de informações confidenciais para os negócios; uso indevido para atividades maliciosas; e resultados imprecisos que podem enganar ou confundir os usuários, resultando em consequências negativas para os negócios.

Como os LLMs exigem acesso a grandes quantidades de dados para fornecer resultados precisos e contextualmente relevantes, informações confidenciais podem ser reveladas inadvertidamente ou utilizadas indevidamente.

“O principal risco são os funcionários alimentando-o com informações confidenciais de negócios ao solicitar que ela escreva um plano ou reformule e-mails ou apresentações de negócios contendo informações proprietárias da empresa”, observa Ringel.

Do ponto de vista do ataque cibernético, os agentes de ameaças já encontraram inúmeras maneiras de transformar o ChatGPT e outros sistemas de IA em armas. Uma maneira tem sido usar os modelos para criar comprometimentos sofisticados de e-mail comercial (BEC) e outros ataques de phishing, que exigem a criação de mensagens personalizadas e socialmente projetadas para o sucesso.

“Com o malware, o ChatGPT permite que os cibercriminosos façam infinitas variações de código para ficar um passo à frente dos mecanismos de detecção de malware”, diz Harr.

As alucinações de IA também representam uma ameaça significativa à segurança e permitem que atores mal-intencionados armem tecnologias baseadas em LLM, como o ChatGPT, de uma maneira única. Uma alucinação de IA é uma resposta plausível da IA que é insuficiente, tendenciosa ou totalmente falsa. “Respostas fictícias ou outras indesejadas podem levar as organizações a tomadas de decisão e processos falhos e a comunicações enganosas”, alerta Avivah Litan, vice-presidente do Gartner.

Os atores da ameaça também podem usar essas alucinações para envenenar LLMs e “gerar desinformação específica em resposta a uma pergunta”, observa Michael Rinehart, vice-presidente de IA do provedor de segurança de dados Securiti. “Isso é extensível à geração de código-fonte vulnerável e, possivelmente, a modelos de chat capazes de direcionar os usuários de um site para ações inseguras.”

Os invasores podem até chegar ao ponto de publicar versões maliciosas de pacotes de software que um LLM pode recomendar a um desenvolvedor de software, acreditando que é uma solução legítima para um problema. Desta forma, os atacantes podem armar ainda mais a IA para montar ataques à cadeia de abastecimento.

O Caminho a Seguir

A gestão destes riscos exigirá uma acção medida e colectiva antes que a inovação da IA ultrapasse a capacidade da indústria para a controlar, observam os especialistas. Mas eles também têm ideias sobre como resolver o problema da IA.

Harr acredita em um “lute contra IA com A” estratégia, na qual “os avanços nas soluções de segurança e nas estratégias para impedir os riscos alimentados pela IA devem desenvolver-se a um ritmo igual ou superior.

“A proteção da segurança cibernética precisa aproveitar a IA para combater com sucesso as ameaças cibernéticas usando a tecnologia de IA”, acrescenta. “Em comparação, a tecnologia de segurança legada não tem chance contra esses ataques.”

No entanto, as organizações também devem adotar uma abordagem ponderada para a adoção da IA – incluindo Soluções de segurança baseadas em IA – para que não introduzam mais riscos em seu ambiente, adverte Wilson da Netrix.

“Entenda o que é e o que não é IA”, ele aconselha. “Desafie os fornecedores que afirmam empregar IA a descrever o que ela faz, como ela aprimora suas soluções e por que isso é importante para sua organização.”

Rinehart da Securiti oferece uma abordagem de dois níveis para incorporar a IA em um ambiente, implantando soluções focadas e, em seguida, colocando proteções em vigor imediatamente antes de expor a organização a riscos desnecessários.

“Primeiro, adote modelos específicos de aplicativos, potencialmente aumentados por bases de conhecimento, que são adaptados para agregar valor em casos de uso específicos”, diz ele. “Então… implemente um sistema de monitoramento para proteger esses modelos, examinando as mensagens enviadas e recebidas por eles em busca de questões de privacidade e segurança.”

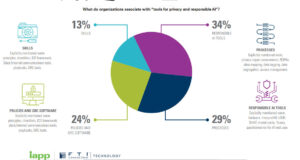

Os especialistas também recomendam a criação de políticas e procedimentos de segurança em torno da IA antes de sua implantação, e não como uma reflexão tardia para mitigar os riscos. Eles podem até criar um responsável ou força-tarefa de risco de IA dedicado para supervisionar a conformidade.

Fora da empresa, a indústria como um todo também deve tomar medidas para estabelecer padrões e práticas de segurança em torno da IA que todos os que desenvolvem e utilizam a tecnologia possam adotar – algo que exigirá uma ação coletiva por parte do setor público e privado em escala global. , diz Fowler da DarkTrace Federal.

Ele cita diretrizes para a construção de sistemas de IA seguros publicado em colaboração pela Agência de Segurança Cibernética e de Infraestrutura dos EUA (CISA) e pelo Centro Nacional de Segurança Cibernética do Reino Unido (NCSC) como um exemplo do tipo de esforços que devem acompanhar a evolução contínua da IA.

“Em essência”, diz Rinehart da Securiti, “o ano de 2024 testemunhará uma rápida adaptação tanto da segurança tradicional quanto das técnicas de IA de ponta para proteger usuários e dados nesta era emergente de IA generativa”.

- Conteúdo com tecnologia de SEO e distribuição de relações públicas. Seja amplificado hoje.

- PlatoData.Network Gerativa Vertical Ai. Capacite-se. Acesse aqui.

- PlatoAiStream. Inteligência Web3. Conhecimento Amplificado. Acesse aqui.

- PlatãoESG. Carbono Tecnologia Limpa, Energia, Ambiente, Solar, Gestão de resíduos. Acesse aqui.

- PlatoHealth. Inteligência em Biotecnologia e Ensaios Clínicos. Acesse aqui.

- Fonte: https://www.darkreading.com/vulnerabilities-threats/skynet-ahoy-what-to-expect-next-gen-ai-security-risks

- :tem

- :é

- :não

- $UP

- 000

- 14

- 2024

- a

- habilidade

- Sobre

- acelerar

- Acesso

- acompanhar

- preciso

- Açao Social

- ações

- atividade

- atores

- adaptação

- endereço

- endereçado

- Adiciona

- adotar

- Adotando

- Adoção

- avançado

- avanço

- avanços

- contra

- agência

- à frente

- AI

- Sistemas de IA

- algoritmos

- Todos os Produtos

- permitir

- já

- tb

- quantidades

- an

- e

- e infra-estrutura

- aparecer

- aplicações

- abordagem

- apropriado

- SOMOS

- ARM

- por aí

- artificial

- inteligência artificial

- Inteligência artificial (AI)

- AS

- pergunta

- avaliação

- avaliações

- At

- Ataques

- tentando

- aumentado

- em caminho duplo

- Batalha

- BE

- BEC

- tornam-se

- sido

- antes

- ser

- acredita

- crente

- tendencioso

- bilhão

- ostenta

- corpos

- Bot

- ambos

- Caixa

- amplo

- Prédio

- negócio

- compromisso de email comercial

- mas a

- by

- chamado

- CAN

- não podes

- capacidades

- capaz

- casos

- cuidados

- Centro

- Chefe executivo

- certo

- cadeia

- desafiar

- chance

- bate-papo

- ChatGPT

- CISA

- citado

- reivindicar

- código

- Collective

- Ação coletiva

- como

- Comunicações

- Empresa

- comparação

- compliance

- compromisso

- preocupado

- concernente

- Preocupações

- Consequências

- consideração

- Considerações

- continuar

- continuou

- continua

- contrário

- ao controle

- conversação

- contando

- acoplado

- crio

- criação

- criadores

- crucial

- ponta

- cibernético

- cíber segurança

- Ataque cibernético

- cibercriminosos

- Cíber segurança

- Agência de segurança cibernética e segurança de infraestrutura

- dados,

- segurança dos dados

- conjuntos de dados

- Data

- Tomada de Decisão

- dedicado

- Demanda

- demonstrar

- implantar

- implantado

- Implantação

- desenvolvimento

- descreve

- projetado

- destruir

- Detecção

- desenvolver

- desenvolvido

- Developer

- em desenvolvimento

- Desenvolvimento

- digital

- dirigindo

- Diretor

- discussões

- parece

- não

- don

- doomsday

- distópico

- eficiência

- esforços

- e-mails

- emergente

- colaboradores

- permite

- engenharia

- Engenharia

- Motores

- Melhora

- enorme

- Empreendimento

- Meio Ambiente

- igual

- Era

- essência

- estabelecer

- Éter (ETH)

- considerações éticas

- Mesmo

- SEMPRE

- todos

- evolução

- evolução

- exemplo

- existencial

- esperar

- especialistas

- Explica

- fato

- familiar

- longe

- defeituoso

- medos

- Federal

- alimentação

- fictício

- Empresa

- Primeiro nome

- Fixar

- pisar fundo

- focado

- Escolha

- força

- Felizmente

- encontrado

- da

- FT

- alimentaram

- mais distante

- futuro

- Ganhos

- GAL

- Gartner

- gerar

- geração

- Gerações

- generativo

- IA generativa

- ter

- obtendo

- Global

- escala global

- Go

- Bom estado, com sinais de uso

- governando

- Governos

- maior

- tinha

- Ter

- he

- ajudar

- Como funciona o dobrador de carta de canal

- Como Negociar

- HTTPS

- Humanidade

- Humanos

- idéias

- imediatamente

- executar

- implementação

- impressionante

- in

- impreciso

- inadvertidamente

- incluir

- Incluindo

- indústria

- info

- INFORMAÇÕES

- Infraestrutura

- inerente

- Inovação

- Inteligência

- para dentro

- introduzir

- isn

- questões

- IT

- ESTÁ

- jpg

- Conhecimento

- Laboratório

- língua

- Vazamentos

- Legado

- legítimo

- carta

- Alavancagem

- como

- máquinas

- a Principal

- fazer

- malicioso

- malwares

- detecção de malware

- gerenciados

- Março

- Marcus

- maciço

- Match

- matt

- Matéria

- significar

- medido

- apenas

- mensagens

- Michael

- Microsoft

- poder

- mentes

- Desinformação

- enganosa

- mau uso

- Mitigar

- modelos

- monitoração

- mais

- a maioria

- MONTE

- em movimento

- muito

- devo

- miríade

- Nacional

- NCSC

- quase

- Cria

- negativo

- Próximo

- não

- nenhum

- nota

- notado

- Notas

- Observa

- of

- Oferece

- Oficial

- on

- ONE

- só

- aberto

- OpenAI

- or

- organização

- organizações

- Outros

- outputs

- Acima de

- vigiar

- Paz

- Pandora

- Google Cloud

- patrick

- Personalizado

- perspectiva

- Phishing

- ataques de phishing

- Lugar

- plano

- Plataformas

- platão

- Inteligência de Dados Platão

- PlatãoData

- ponto

- veneno

- políticas

- colocada

- coloca

- possivelmente

- potencial

- potencialmente

- alimentado

- poderoso

- atribuições

- práticas

- predizer

- presentes

- presidente

- evitar

- política de privacidade

- Privacidade e segurança

- privado

- setor privado

- Problema

- Solução de problemas

- procedimentos

- processos

- produtividade

- profundo

- Progresso

- devidamente

- proprietário

- proteção

- protocolos

- fornecer

- provedor

- público

- publicado

- colocar

- Colocar

- questão

- rapidamente

- Corrida

- rápido

- Taxa

- em vez

- reconhecido

- recomendar

- relevante

- notável

- reformular

- representar

- representa

- requerer

- pesquisa

- pesquisadores

- resposta

- respostas

- resultando

- Revelado

- rigoroso

- Risco

- avaliação de risco

- riscos

- s

- salvaguardando

- proteções

- Segurança

- Dito

- vendas

- Sam

- diz

- Escala

- cenário

- cenários

- setor

- seguro

- segurança

- políticas de segurança

- riscos de segurança

- sentido

- sensível

- conjunto

- Conjuntos

- contexto

- vários

- rede de apoio social

- assinado

- periodo

- local

- Skynet

- mais inteligente

- So

- até aqui

- socialmente

- Sociedade

- Software

- solução

- Soluções

- algo

- sofisticado

- Espaço

- específico

- suporte

- padrões

- começado

- ficar

- dirigir

- Passo

- Passos

- Dê um basta

- estratégias

- Estratégia

- sucesso

- entraram com sucesso

- tal

- Superinteligência

- supply

- cadeia de suprimentos

- .

- sistemas

- T

- adaptados

- Tire

- Tarefa

- força-tarefa

- técnicas

- tecnólogos

- Tecnologia

- do que

- que

- A

- do Reino Unido

- o mundo

- deles

- Eles

- então

- Este

- deles

- isto

- aqueles

- ameaça

- atores de ameaças

- ameaças

- tempo

- para

- também

- ferramenta

- ferramentas

- topo

- para

- tradicional

- treinado

- verdadeiro

- tipo

- Uk

- Em última análise

- compreender

- compreensão

- único

- não desejado

- us

- usar

- usuários

- utilização

- válido

- valor

- variações

- Grande

- fornecedores

- vício

- Vice-Presidente

- Visitas

- Vulnerável

- Avisa

- Caminho..

- maneiras

- we

- O Quê

- quando

- qual

- enquanto

- inteiro

- porque

- largamente

- precisarão

- Wilson

- de

- testemunha

- Atividades:

- mundo

- pior

- escrever

- ano

- investimentos

- zefirnet