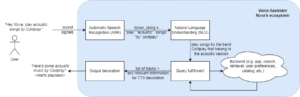

Avanços recentes no desenvolvimento de LLMs popularizaram seu uso para diversas tarefas de PNL que antes eram abordadas usando métodos mais antigos de aprendizado de máquina. Grandes modelos de linguagem são capazes de resolver uma variedade de problemas de linguagem, como classificação, resumo, recuperação de informações, criação de conteúdo, resposta a perguntas e manutenção de uma conversa — tudo isso usando apenas um único modelo. Mas como sabemos que eles estão fazendo um bom trabalho em todas essas diferentes tarefas?

A ascensão dos LLMs trouxe à luz um problema não resolvido: não temos um padrão confiável para avaliá-los. O que torna a avaliação mais difícil é que eles são usados para tarefas muito diversas e não temos uma definição clara do que é uma boa resposta para cada caso de uso.

Este artigo discute as abordagens atuais para avaliar LLMs e apresenta uma nova tabela de classificação LLM que aproveita a avaliação humana que aprimora as técnicas de avaliação existentes.

A primeira e usual forma inicial de avaliação é executar o modelo em vários conjuntos de dados selecionados e examinar seu desempenho. HuggingFace criou um Tabela de classificação LLM aberta onde grandes modelos de acesso aberto são avaliados usando quatro conjuntos de dados bem conhecidos (Desafio de raciocínio AI2 , HellaSwag , MMLU , Controle de Qualidade Verdadeiro). Isto corresponde à avaliação automática e verifica a capacidade do modelo de obter os fatos para algumas questões específicas.

Este é um exemplo de pergunta do MMLU conjunto de dados.

Assunto: faculdade_medicina

Pergunta: Um efeito colateral esperado da suplementação de creatina é.

- A) fraqueza muscular

- B) ganho de massa corporal

- D) cãibras musculares

- D) perda de eletrólitos

Resposta: (B)

A pontuação do modelo ao responder a este tipo de pergunta é uma métrica importante e serve bem para a verificação de factos, mas não testa a capacidade generativa do modelo. Esta é provavelmente a maior desvantagem deste método de avaliação porque a geração de texto livre é uma das características mais importantes dos LLMs.

Parece haver um consenso dentro da comunidade de que para avaliar o modelo adequadamente precisamos de avaliação humana. Isso normalmente é feito comparando as respostas de diferentes modelos.

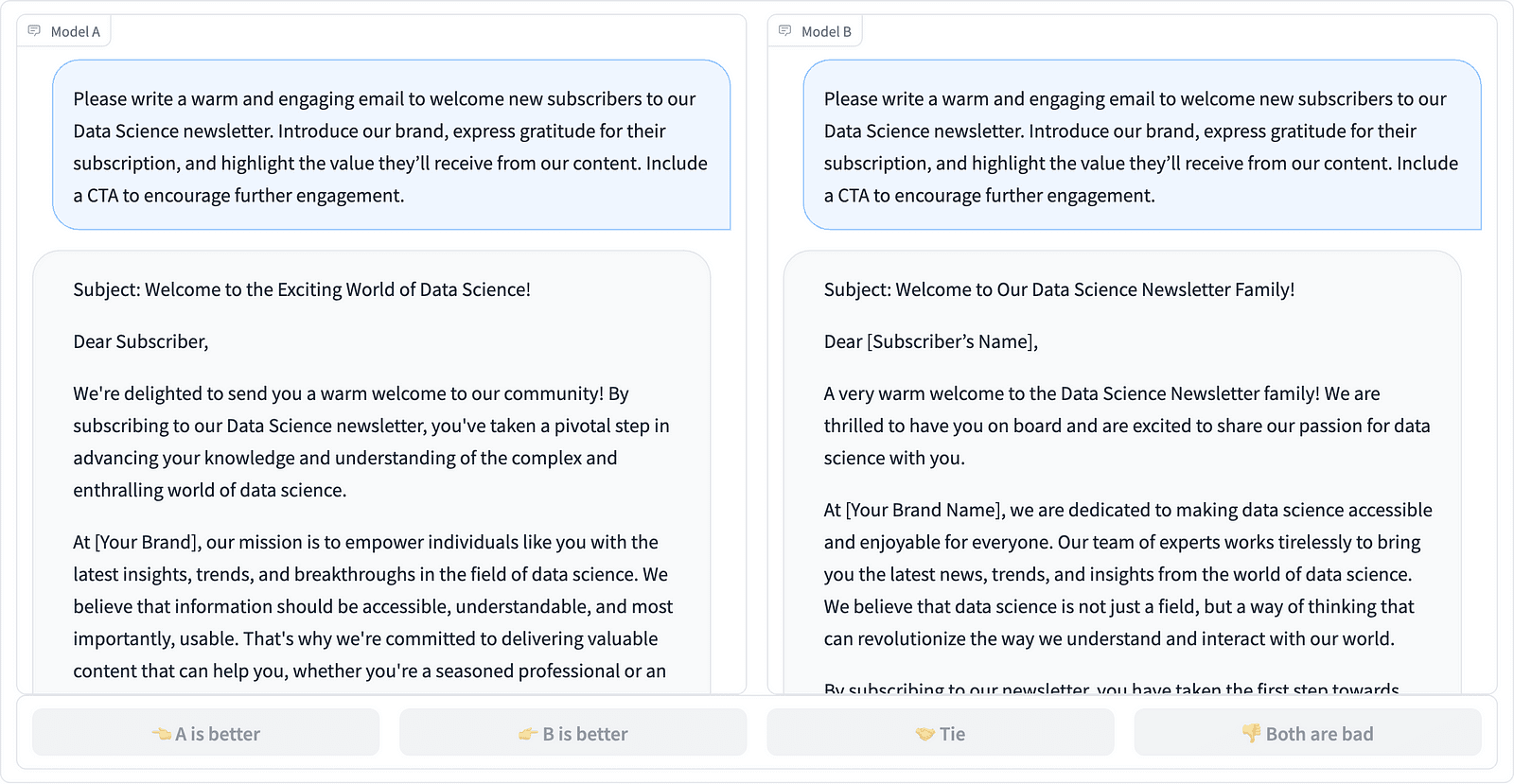

Comparando duas conclusões de prompt no projeto LMSYS – captura de tela do autor

Os anotadores decidem qual resposta é melhor, como visto no exemplo acima, e às vezes quantificam a diferença na qualidade das conclusões imediatas. LMSYS Org criou um leaderboard que utiliza esse tipo de avaliação humana e compara 17 modelos diferentes, relatando o Classificação Elo para cada modelo.

Como a avaliação humana pode ser difícil de escalar, têm havido esforços para escalar e acelerar o processo de avaliação e isso resultou num projeto interessante chamado AlpacaEval. Aqui, cada modelo é comparado a uma linha de base (text-davinci-003 fornecido pelo GPT-4) e a avaliação humana é substituída pelo julgamento do GPT-4. Na verdade, isso é rápido e escalonável, mas podemos confiar no modelo aqui para realizar a pontuação? Precisamos estar cientes dos preconceitos do modelo. Na verdade, o projeto mostrou que o GPT-4 pode favorecer respostas mais longas.

Os métodos de avaliação LLM continuam a evoluir à medida que a comunidade de IA procura abordagens fáceis, justas e escaláveis. O mais recente desenvolvimento vem da equipe da Toloka com um novo leaderboard para avançar ainda mais os padrões de avaliação atuais.

O novo leaderboard compara as respostas do modelo com solicitações do usuário do mundo real que são categorizadas por tarefas úteis de PNL, conforme descrito em este artigo do InstructGPT. Ele também mostra a taxa geral de vitórias de cada modelo em todas as categorias.

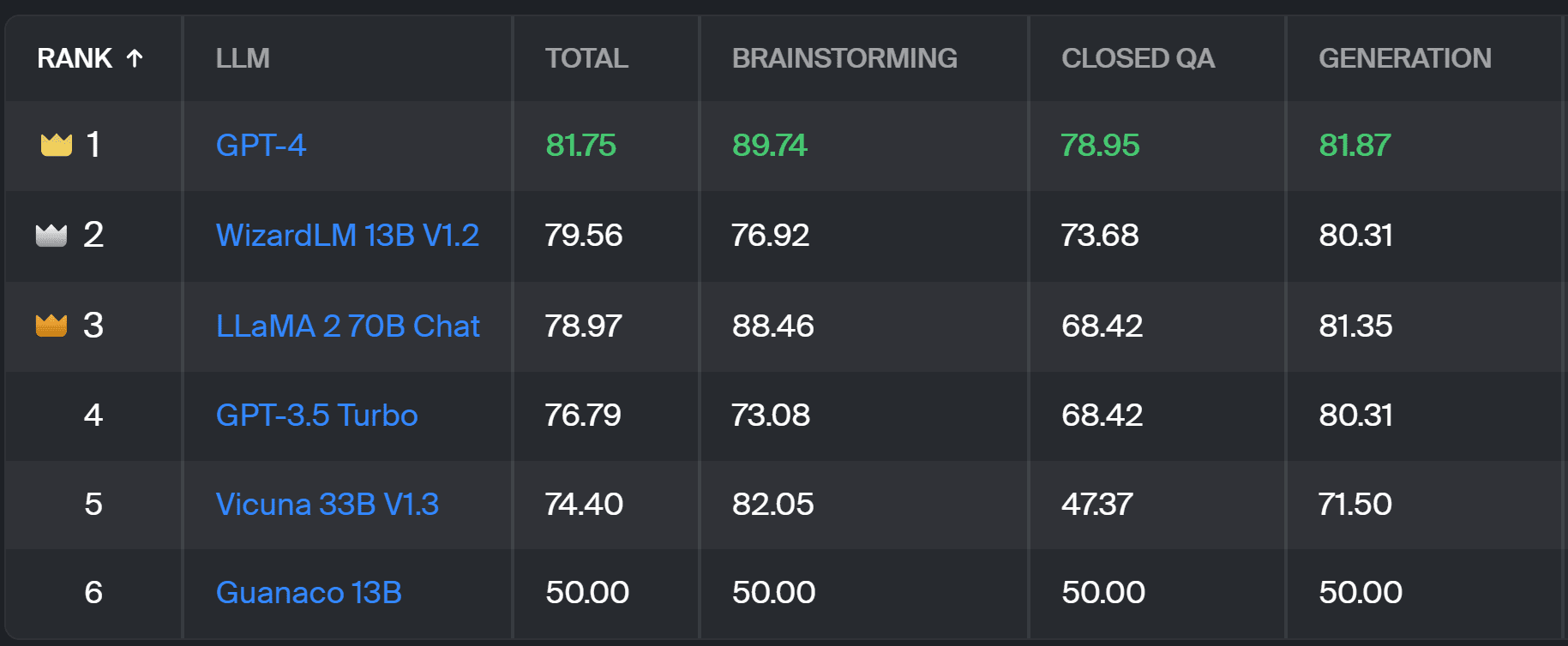

Tabela de classificação de Toloka – captura de tela do autor

A avaliação utilizada para este projeto é semelhante à realizada no AlpacaEval. As pontuações na tabela de classificação representam a taxa de vitória do respectivo modelo em comparação com o Guanaco 13B modelo, que serve aqui como uma comparação de base. A escolha do Guanaco 13B é uma melhoria no método AlpacaEval, que usa o modelo text-davinci-003, que logo ficará desatualizado, como linha de base.

A avaliação real é feita por anotadores especialistas humanos em um conjunto de prompts do mundo real. Para cada prompt, os anotadores recebem duas conclusões e perguntam qual delas preferem. Você pode encontrar detalhes sobre a metodologia SUA PARTICIPAÇÃO FAZ A DIFERENÇA.

Este tipo de avaliação humana é mais útil do que qualquer outro método de avaliação automática e deverá melhorar a avaliação humana utilizada para o Tabela de classificação LMSYS. A desvantagem do método LMSYS é que qualquer pessoa com o link podem participar na avaliação, levantando sérias questões sobre a qualidade dos dados recolhidos desta forma. Um grupo fechado de anotadores especializados tem maior potencial para resultados confiáveis, e Toloka aplica técnicas adicionais de controle de qualidade para garantir a qualidade dos dados.

Neste artigo, apresentamos uma nova solução promissora para avaliar LLMs – o Toloka Leaderboard. A abordagem é inovadora, combina os pontos fortes dos métodos existentes, adiciona granularidade específica à tarefa e utiliza técnicas confiáveis de anotação humana para comparar os modelos.

Explore o quadro e compartilhe conosco suas opiniões e sugestões de melhorias.

Madalena Konkiewicz é evangelista de dados na Toloka, uma empresa global que apoia o desenvolvimento rápido e escalonável de IA. Ela possui mestrado em Inteligência Artificial pela Universidade de Edimburgo e trabalhou como engenheira de PNL, desenvolvedora e cientista de dados para empresas na Europa e na América. Ela também esteve envolvida no ensino e orientação de cientistas de dados e contribui regularmente para publicações de ciência de dados e aprendizado de máquina.

- Conteúdo com tecnologia de SEO e distribuição de relações públicas. Seja amplificado hoje.

- PlatoData.Network Gerativa Vertical Ai. Capacite-se. Acesse aqui.

- PlatoAiStream. Inteligência Web3. Conhecimento Amplificado. Acesse aqui.

- PlatãoESG. Carbono Tecnologia Limpa, Energia, Ambiente, Solar, Gestão de resíduos. Acesse aqui.

- PlatoHealth. Inteligência em Biotecnologia e Ensaios Clínicos. Acesse aqui.

- Fonte: https://www.kdnuggets.com/a-better-way-to-evaluate-llms?utm_source=rss&utm_medium=rss&utm_campaign=a-better-way-to-evaluate-llms

- :tem

- :é

- :não

- :onde

- $UP

- 17

- a

- habilidade

- Sobre

- acima

- em

- real

- Adicional

- Adiciona

- avançar

- avanços

- AI

- Todos os Produtos

- tb

- América

- an

- e

- responder

- respostas

- qualquer

- aplica

- abordagem

- se aproxima

- SOMOS

- Arena

- artigo

- artificial

- inteligência artificial

- AS

- At

- Automático

- consciente

- b

- Linha de Base

- BE

- Porque

- sido

- Melhor

- vieses

- O maior

- borda

- corpo

- Trazido

- negócios

- mas a

- by

- CAN

- capaz

- casas

- Categorias

- desafiar

- Cheques

- escolha

- classificação

- remover filtragem

- fechado

- combina

- vem

- comunidade

- Empresa

- comparar

- comparado

- comparando

- comparação

- Consenso

- conteúdo

- Criação de conteúdo

- continuar

- contribui

- ao controle

- Conversa

- corresponde

- criado

- criação

- multidão

- comissariada

- Atual

- dados,

- qualidade de dados

- ciência de dados

- cientista de dados

- conjuntos de dados

- decidir

- definição

- Grau

- detalhes

- Developer

- Desenvolvimento

- diferença

- diferente

- Desvantagem

- diferente

- do

- parece

- fazer

- feito

- não

- desvantagem

- cada

- fácil

- Edimburgo

- efeito

- esforços

- eletrólitos

- engenheiro

- garantir

- Europa

- avaliar

- avaliadas

- avaliação

- avaliação

- Evangelista

- evolui

- examinar

- exemplo

- existente

- esperado

- especialista

- fatos

- feira

- RÁPIDO

- favorecer

- Funcionalidades

- Encontre

- Primeiro nome

- Escolha

- formulário

- quatro

- Gratuito

- da

- mais distante

- Ganho

- colhido

- gerando

- generativo

- ter

- GitHub

- dado

- Global

- Bom estado, com sinais de uso

- bom trabalho

- Queijos duros

- mais duro

- Ter

- SUA PARTICIPAÇÃO FAZ A DIFERENÇA

- altamente

- detém

- Como funciona o dobrador de carta de canal

- HTTPS

- Abraçando o Rosto

- humano

- importante

- melhorar

- melhoria

- melhorias

- melhora

- in

- INFORMAÇÕES

- do estado inicial,

- inovadores

- Inteligência

- interessante

- introduzido

- Introduz

- envolvido

- IT

- ESTÁ

- Trabalho

- apenas por

- apenas um

- KDnuggetsGenericName

- Saber

- Falta

- língua

- grande

- mais recente

- aprendizagem

- aproveitando

- leve

- mais

- fora

- máquina

- aprendizado de máquina

- manutenção

- FAZ

- maneira

- Massa

- dominar

- Posso..

- mentoring

- método

- Metodologia

- métodos

- métrico

- modelo

- modelos

- mais

- a maioria

- músculo

- você merece...

- Novo

- nova solução

- PNL

- of

- mais velho

- on

- ONE

- aberto

- Opiniões

- Outros

- delineado

- global

- parte

- realizar

- atuação

- realizada

- platão

- Inteligência de Dados Platão

- PlatãoData

- potencial

- preferir

- anteriormente

- provavelmente

- Problema

- problemas

- processo

- projeto

- promissor

- solicita

- devidamente

- fornecido

- publicações

- qualidade

- questão

- Frequentes

- elevando

- Taxa

- mundo real

- regularmente

- confiável

- substituído

- Relatórios

- representar

- aqueles

- resposta

- respostas

- resultou

- Resultados

- Subir

- Execute

- s

- escalável

- Escala

- Ciência

- Cientista

- cientistas

- pontuações

- marcar

- pesquisas

- parece

- visto

- grave

- serve

- conjunto

- vários

- Partilhar

- ela

- rede de apoio social

- mostrando

- Shows

- lado

- semelhante

- solteiro

- solução

- Resolvendo

- alguns

- às vezes

- específico

- velocidade

- padrão

- padrões

- pontos fortes

- tal

- Apoiar

- Tire

- tarefas

- Ensino

- Profissionais

- técnicas

- teste

- texto

- do que

- que

- A

- deles

- Eles

- Lá.

- Este

- deles

- isto

- para

- Confiança

- dois

- tipo

- tipicamente

- universidade

- sobre

- us

- Uso

- usar

- caso de uso

- usava

- Utilizador

- usos

- utilização

- habitual

- variedade

- Caminho..

- we

- fraqueza

- BEM

- bem conhecido

- foram

- O Quê

- O que é a

- qual

- ganhar

- de

- dentro

- trabalhou

- Você

- investimentos

- zefirnet