A velocidade de transferência da memória e a baixa latência são essenciais à medida que a inferência muda do data center para a borda da rede.

AI/ML está evoluindo em um ritmo relâmpago. Não passa uma semana sem alguns desenvolvimentos novos e emocionantes no campo, e aplicativos como o ChatGPT trouxeram os recursos generativos de IA firmemente para o primeiro plano da atenção do público.

AI/ML consiste, na verdade, em duas aplicações: treinamento e inferência. Cada um depende do desempenho da memória e possui um conjunto exclusivo de requisitos que orientam a escolha da melhor solução de memória.

Com o treinamento, a largura de banda e a capacidade da memória são requisitos críticos. Isto é especialmente verdade devido ao tamanho e à complexidade dos modelos de dados de redes neurais que têm crescido a uma taxa de 10 vezes por ano. A precisão da rede neural depende da qualidade e quantidade de exemplos no conjunto de dados de treinamento, o que se traduz na necessidade de enormes quantidades de dados e, portanto, de largura de banda e capacidade de memória.

Dado o valor criado através do treinamento, existe um incentivo poderoso para concluir as sessões de treinamento o mais rápido possível. À medida que os aplicativos de treinamento são executados em data centers cada vez mais limitados em termos de energia e espaço, soluções que oferecem eficiência energética e tamanho menor são preferidas. Considerando todos esses requisitos, o HBM3 é uma solução de memória ideal para hardware de treinamento de IA. Ele fornece excelentes recursos de largura de banda e capacidade.

O resultado do treinamento da rede neural é um modelo de inferência que pode ser amplamente implantado. Com este modelo, um dispositivo de inferência pode processar e interpretar entradas fora dos limites dos dados de treinamento. Para inferência, a velocidade de transferência de memória e a baixa latência são essenciais, especialmente quando é necessária ação em tempo real. Com cada vez mais inferências de IA migrando do centro do data center para a borda da rede, esses recursos de memória estão se tornando ainda mais críticos.

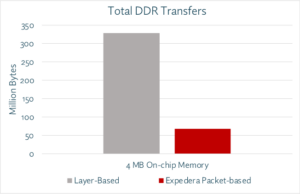

Os designers têm várias opções de memória para inferência de AI/ML, mas no parâmetro crítico de largura de banda, a memória GDDR6 realmente brilha. Com uma taxa de dados de 24 Gigabits por segundo (Gb/s) e uma interface ampla de 32 bits, um dispositivo GDDR6 pode fornecer 96 Gigabytes por segundo (GB/s) de largura de banda de memória, mais que o dobro de qualquer DDR alternativo ou Soluções LPDDR. A memória GDDR6 oferece uma excelente combinação de velocidade, largura de banda e desempenho de latência para inferência de AI/ML, especialmente para inferência na borda.

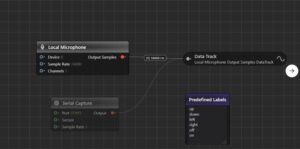

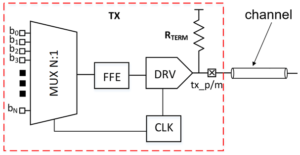

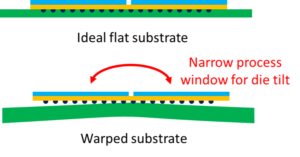

O subsistema de interface de memória Rambus GDDR6 oferece desempenho de 24 Gb/s e é construído sobre uma base de mais de 30 anos de experiência em integridade de sinal de alta velocidade e integridade de energia (SI/PI), fundamental para operar GDDR6 em altas velocidades. Ele consiste em um controlador PHY e digital – fornecendo um subsistema completo de interface de memória GDDR6.

Junte-se a mim no webinar Rambus este mês em “Inferência de AI/ML de alto desempenho com memória 24G GDDR6” para descobrir como o GDDR6 oferece suporte aos requisitos de memória e desempenho das cargas de trabalho de inferência de AI/ML e aprender sobre algumas das principais considerações de design e implementação dos subsistemas de interface de memória GDDR6.

Recursos:

Frank Ferro

(Todas as publicações)

Frank Ferro é diretor sênior de marketing de produtos para núcleos IP da Rambus.

- Conteúdo com tecnologia de SEO e distribuição de relações públicas. Seja amplificado hoje.

- PlatoAiStream. Inteligência de Dados Web3. Conhecimento Amplificado. Acesse aqui.

- Cunhando o Futuro com Adryenn Ashley. Acesse aqui.

- Compre e venda ações em empresas PRE-IPO com PREIPO®. Acesse aqui.

- Fonte: https://semiengineering.com/gddr6-delivers-the-performance-for-ai-ml-inference/

- :tem

- :é

- :não

- 24

- 26

- 27

- 30

- 8

- a

- Sobre

- precisão

- Açao Social

- AI

- Treinamento de IA

- AI / ML

- Todos os Produtos

- Todas as mensagens

- alternativa

- quantidades

- an

- e

- qualquer

- aplicações

- SOMOS

- AS

- At

- por WhatsApp.

- Largura de Banda

- BE

- tornando-se

- sido

- MELHOR

- amplamente

- Trazido

- construído

- mas a

- by

- CAN

- capacidades

- Capacidade

- Centralização de

- Centros

- ChatGPT

- escolha

- escolhas

- combinação

- completar

- complexidade

- Considerações

- controlador

- criado

- crítico

- dados,

- Data Center

- centros de dados

- conjunto de dados

- entregar

- entrega

- depende

- implantado

- Design

- desenvolvimentos

- dispositivo

- digital

- Diretor

- descobrir

- duplo

- distância

- cada

- borda

- eficiência

- enorme

- especialmente

- Mesmo

- evolução

- exemplos

- excelente

- emocionante

- experiência

- Funcionalidades

- campo

- firmemente

- Escolha

- Frente

- Foundation

- da

- generativo

- IA generativa

- dado

- vai

- ótimo

- Crescente

- Hardware

- Ter

- Coração

- conseqüentemente

- Alta

- Como funciona o dobrador de carta de canal

- HTTPS

- ideal

- implementação

- in

- Incentivo

- cada vez mais

- inputs

- integridade

- Interface

- para dentro

- IP

- IT

- jpg

- Chave

- Latência

- APRENDER

- relâmpago

- como

- Baixo

- Marketing

- Memória

- modelo

- modelos

- Mês

- mais

- necessário

- necessitando

- rede

- Dados de rede

- Neural

- rede neural

- Novo

- agora

- número

- of

- oferecer

- Oferece

- on

- operando

- or

- saída

- lado de fora

- Acima de

- Paz

- parâmetro

- particular

- particularmente

- atuação

- platão

- Inteligência de Dados Platão

- PlatãoData

- popularidade

- possível

- POSTAGENS

- poder

- poderoso

- processo

- Produto

- fornece

- fornecendo

- público

- qualidade

- quantidade

- rapidamente

- Taxa

- em tempo real

- clientes

- Requisitos

- certo

- LINHA

- Execute

- Segundo

- senior

- conjunto

- MUDANÇA

- Turnos

- Signal

- Tamanho

- menor

- So

- solução

- Soluções

- alguns

- Espaço

- velocidade

- velocidades

- suportes

- do que

- que

- A

- Lá.

- Este

- isto

- Através da

- Taxa de transferência

- miniaturas

- para

- Training

- dois

- único

- valor

- webinar

- semana

- quando

- qual

- Largo

- de

- sem

- ano

- anos

- zefirnet