Przedsiębiorca technologiczny Wayne Chang twierdzi, że opracował narzędzie AI, LLM Shield, które zapobiega chatbotom i dużym modelom językowym (LLM), takim jak ChatGPT od zabierania tajemnic firmowych. Ostatnio wzrasta wykorzystanie narzędzi AI, co budzi obawy, że firmy mogą być narażone na wycieki danych i procesy sądowe.

Według raportu Cyberhaven, szacunkowo 2.3% pracowników umieściło poufne informacje firmowe w ChatGPT, podczas gdy 11% danych wklejonych do chatbota jest poufnych.

W rezultacie wiele firm, w tym JP Morgan Chase & Co podobno zablokowany dostęp pracownika do narzędzia.

Przeczytaj także: Czy biura Metaverse powracają?

LLM Shield ma na celu ochronę firm i rządów przed przesyłaniem poufnych danych do narzędzi opartych na sztucznej inteligencji, takich jak ChatGPT i Bard.

Chang powiedział Fox Business, że kiedy ChatGPT OpenAI został wypuszczony na rynek w listopadzie, zobaczył, jak potężny będzie i że wiąże się z „wielkim, dużym ryzykiem”.

„Sprawy będą się eskalować dość szybko – to zarówno pozytywy, jak i negatywy” – powiedział.

„Koncentruję się tutaj na tym, aby upewnić się, że możemy pozytywnie skierować sztuczną inteligencję w pozytywnym kierunku i uniknąć w jak największym stopniu wad”.

Technologia kontroli technologii

Wydany dopiero w zeszłym tygodniu, LLM Shield ostrzega organizacje za każdym razem, gdy następuje próba przesłania poufnych informacji. Według Fox Business administratorzy mogą ustawić bariery dla typów danych, które firma chce chronić.

Każda próba przesłania takich informacji spowoduje, że LLM Shield zaalarmuje użytkowników, że zamierzają wysłać poufne dane, i zaciemni szczegóły, aby treść była użyteczna, ale nieczytelna dla ludzi.

🚨 Firmy i kraje ZABRONIAJĄ LLM z lewej i prawej strony. 🚨

Nie ma narzędzi, które by to rozwiązały („zasady” nie działają).

Ogłaszając @LLMShield – technologia zapobiegająca wyciekom stworzona z myślą o świecie opartym na sztucznej inteligencji.

Czy *wiesz*, kto kopiuje i wkleja Twoje dane? https://t.co/EtO5bHJow1

— Wayne Chang (@Wayne) 20 kwietnia 2023 r.

Oczekuje się, że LLM Shield będzie coraz inteligentniejszy, podobnie jak narzędzia sztucznej inteligencji, których moce ma za zadanie ograniczać. Aktualizuje się również jak filtr spamu, więc gdy więcej botów trafi na rynek, automatycznie zaktualizuje się, aby wzmocnić ochronę.

Według Changa istnieją plany wydania osobistej wersji do pobrania przez osoby fizyczne do użytku domowego.

Wycieki danych martwią firmy

W tym roku nastąpił gwałtowny wzrost wykorzystania narzędzi sztucznej inteligencji przez firmy i prawdopodobnie rok 2023 uznamy za rok, w którym rewolucja sztucznej inteligencji rozpoczęła się na dobre.

Jednak napływ tych narzędzi wzbudził również obawy, że pracownicy mogą dobrowolnie lub przypadkowo ujawnić poufne informacje do narzędzi opartych na sztucznej inteligencji, takich jak ChatGPT.

Ryzyko już istnieje. Samsung niedawno doświadczyła serii wycieków danych, kiedy jej pracownicy rzekomo wkleili kod źródłowy do nowych botów, co potencjalnie mogłoby ujawnić zastrzeżone informacje.

Coraz częściej pracodawcy denerwowanie się o tym, jak ich pracownicy mogą używać narzędzi AI w pracy. Niektóre firmy już zakazały korzystania z ChatGPT w pracy, chociaż pracownicy wciąż znajdują sposób na obejście ograniczeń.

W ujawnionej notatce Walmart ostrzegł pracowników, aby nie udostępniali poufnych informacji ChatGPT. Grupa stwierdziła, że wcześniej zablokowała chatbota z powodu „działań, które stanowiły zagrożenie dla naszej firmy”.

Amazon ostrzegł również swoich pracowników przed tym samym wyzwaniem. Jej prawnik korporacyjny powiedział pracownikom, że firma widziała już przypadki odpowiedzi ChatGPT, które były podobne do wewnętrzny Amazon danych.

Sprytni pracownicy

Podobnie jak w krajach, w których ChatGPT jest zabroniony, ale nadal używany – Chiny i części Afryki – pracownicy nie zostali zniechęceni do korzystania z narzędzia opartego na sztucznej inteligencji w swoich organizacjach.

A Badanie akwarium opublikowany w lutym ujawnił, że prawie 70% pracowników korzysta z ChatGPT w pracy bez wiedzy swoich szefów.

Dyrektor generalny Cyberhaven, Howard Ting, powiedział firmie Axios, że pracownicy zawsze znajdowali sposoby na obejście zakazów sieci korporacyjnych blokujących dostęp do chatbotów.

Powiedział, że niektóre firmy uważały, że pracownicy nie mają dostępu do chatbota, zanim jego firma nie powiedziała im inaczej.

„Użytkownicy mogą korzystać z serwera proxy, aby obejść wiele narzędzi bezpieczeństwa opartych na sieci” — ujawnił.

- Dystrybucja treści i PR oparta na SEO. Uzyskaj wzmocnienie już dziś.

- PlatoAiStream. Analiza danych Web3. Wiedza wzmocniona. Dostęp tutaj.

- Wybijanie przyszłości w Adryenn Ashley. Dostęp tutaj.

- Źródło: https://metanews.com/zuckerberg-ridiculed-in-press-analyst-firm-suggests-meta-rename-again/

- :ma

- :Jest

- :nie

- :Gdzie

- 20

- 2023

- a

- O nas

- dostęp

- Stosownie

- Administratorzy

- Afryka

- AI

- Zasilany AI

- Alarm

- Alerty

- rzekomo

- już

- również

- zawsze

- an

- analityk

- i

- SĄ

- na około

- AS

- At

- automatycznie

- Axios

- z powrotem

- zakazany

- Zakazy

- na podstawie

- BE

- być

- zanim

- rozpoczął

- Uważa

- Duży

- zablokowany

- bloking

- wysięgnik

- bossowie

- obie

- boty

- wybudowany

- biznes

- biznes

- ale

- by

- CAN

- ceo

- wyzwanie

- pościg

- chatbot

- nasze chatboty

- ChatGPT

- roszczenia

- CO

- kod

- Comeback

- Firmy

- sukcesy firma

- Obawy

- zawartość

- kontynuować

- kontrola

- biurowy

- Korporacyjny

- mógłby

- kraje

- dane

- zaprojektowany

- detale

- rozwinięty

- kierunek

- nie

- pobieranie

- minusem

- każdy

- Pracownik

- pracowników

- pracodawcy

- Przedsiębiorca

- szacunkowa

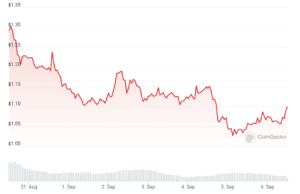

- Eter (ETH)

- spodziewany

- doświadczony

- luty

- filtrować

- Znajdź

- Firma

- Skupiać

- W razie zamówieenia projektu

- znaleziono

- Fox Business

- od

- otrzymać

- miejsce

- będzie

- Rządy

- Zarządzanie

- Have

- he

- tutaj

- Dobranie (Hit)

- Strona główna

- W jaki sposób

- HTTPS

- Ludzie

- i

- in

- Włącznie z

- wzrastający

- osób

- napływ

- Informacja

- przykład

- najnowszych

- IT

- JEGO

- samo

- jp morgan

- JP Morgan Chase

- właśnie

- wiedza

- język

- duży

- Nazwisko

- Późno

- Pozwy

- prawnik

- przeciec

- Wycieki

- lubić

- Prawdopodobnie

- Popatrz

- Partia

- robić

- Dokonywanie

- wiele

- rynek

- Może..

- Meta

- Metaverse

- może

- modele

- jeszcze

- Morgan

- prawie

- ujemny

- sieć

- Nowości

- listopad

- of

- biura

- on

- tylko

- or

- organizacji

- Inaczej

- ludzkiej,

- Nasza firma

- strony

- osobisty

- plany

- plato

- Analiza danych Platona

- PlatoDane

- pozytywny

- możliwy

- potencjalnie

- mocny

- uprawnienia

- przedstawione

- naciśnij

- bardzo

- Zapobieganie

- poprzednio

- własność

- chronić

- ochrona

- pełnomocnik

- położyć

- szybko

- wychowywanie

- Czytaj

- niedawno

- zwolnić

- wydany

- raport

- Ograniczenia

- dalsze

- Ujawnił

- Rewolucja

- Ryzyko

- ryzyko

- Powiedział

- taki sam

- bezpieczeństwo

- widziany

- wrażliwy

- Serie

- zestaw

- Share

- Tarcza

- podobny

- mądrzejszy

- So

- Rozwiązywanie

- kilka

- Źródło

- Kod źródłowy

- spam

- Personel

- Nadal

- Wzmacniać

- taki

- Wskazuje

- biorąc

- Technologia

- że

- Połączenia

- ich

- Im

- Tam.

- Te

- one

- to

- tych

- czas

- do

- narzędzie

- narzędzia

- prawdziwy

- typy

- Aktualizacja

- Nowości

- Uploading

- posługiwać się

- używany

- Użytkownicy

- za pomocą

- wersja

- Wrażliwy

- była

- Droga..

- sposoby

- we

- tydzień

- były

- Co

- jeśli chodzi o komunikację i motywację

- który

- Podczas

- będzie

- chętnie

- w

- bez

- Praca

- pracowników

- świat

- by

- WSJ

- rok

- ty

- Twój

- zefirnet

- Zuckerberg