Zaczynamy widzieć, jak pojawiają się bardzo wczesne etapy stosu technologii w generatywnej sztucznej inteligencji (AI). Setki nowych startupów wkraczają na rynek, aby opracowywać podstawowe modele, tworzyć natywne aplikacje oparte na sztucznej inteligencji i tworzyć infrastrukturę/narzędzia.

Wiele gorących trendów technologicznych jest przereklamowanych na długo przed nadrobieniem zaległości rynkowych. Jednak boomowi na generatywną sztuczną inteligencję towarzyszyły realne zyski na rzeczywistych rynkach i prawdziwa trakcja ze strony prawdziwych firm. Modele takie jak Stable Diffusion i ChatGPT ustanawiają historyczne rekordy wzrostu liczby użytkowników, a kilka aplikacji osiągnęło roczny przychód w wysokości 100 milionów dolarów w niecały rok po uruchomieniu. Bezpośrednie porównania pokazują modele AI przewyższające ludzi w niektórych zadaniach o wiele rzędów wielkości.

Jest więc wystarczająco dużo wczesnych danych, aby sugerować, że ma miejsce masowa transformacja. Czego nie wiemy i co stało się teraz kluczowym pytaniem, to: Gdzie na tym rynku pojawi się wartość?

W ciągu ostatniego roku spotkaliśmy się z dziesiątkami założycieli startupów i operatorów w dużych firmach, którzy zajmują się bezpośrednio generatywną sztuczną inteligencją. Zaobserwowaliśmy to dostawcy infrastruktury są jak dotąd prawdopodobnie największymi zwycięzcami na tym rynku, zdobywając większość dolarów przepływających przez stos. Firmy aplikacyjne bardzo szybko zwiększają przychody, ale często mają problemy z retencją, zróżnicowaniem produktów i marżami brutto. I najbardziej dostawcy modeli, choć odpowiadają za samo istnienie tego rynku, nie osiągnęły jeszcze dużej skali komercyjnej.

Innymi słowy, firmy tworzące największą wartość — tj. szkolące generatywne modele sztucznej inteligencji i stosujące je w nowych aplikacjach — większości z nich nie uchwyciły. Przewidywanie, co będzie dalej, jest znacznie trudniejsze. Uważamy jednak, że kluczową rzeczą do zrozumienia jest to, które części stosu są naprawdę zróżnicowane i można je obronić. Będzie to miało duży wpływ na strukturę rynku (tj. poziomy i pionowy rozwój firmy) oraz czynniki kształtujące wartość długoterminową (np. marże i retencja). Jak dotąd, mieliśmy trudności ze znalezieniem strukturalnej obrony nigdzie w stosie, poza tradycyjnymi fosami dla zasiedziałych.

Jesteśmy niezwykle optymistycznie nastawieni do generatywnej sztucznej inteligencji i wierzymy, że będzie ona miała ogromny wpływ na branżę oprogramowania i nie tylko. Celem tego wpisu jest nakreślenie dynamiki rynku i udzielenie odpowiedzi na szersze pytania dotyczące generatywnych modeli biznesowych sztucznej inteligencji.

Stos technologii wysokiego poziomu: infrastruktura, modele i aplikacje

Aby zrozumieć, jak kształtuje się rynek generatywnej sztucznej inteligencji, najpierw musimy określić, jak wygląda stos dzisiaj. Oto nasz wstępny pogląd.

Stos można podzielić na trzy warstwy:

- Konsultacje które integrują generatywne modele sztucznej inteligencji z produktem skierowanym do użytkownika, uruchamiając własne potoki modeli („aplikacje kompleksowe”) lub opierając się na interfejsie API innej firmy

- modele które zasilają produkty AI, udostępniane jako zastrzeżone interfejsy API lub jako punkty kontrolne typu open source (które z kolei wymagają rozwiązania hostingowego)

- Infrastruktura dostawcy (tj. platformy chmurowe i producenci sprzętu), którzy wykonują obciążenia szkoleniowe i wnioskowania dla generatywnych modeli sztucznej inteligencji

Ważne jest, aby pamiętać: To nie jest mapa rynku, ale ramy do analizy rynku. W każdej kategorii wymieniliśmy kilka przykładów dobrze znanych dostawców. Nie próbowaliśmy być wyczerpujący ani wymieniać wszystkich niesamowitych generatywnych aplikacji AI, które zostały wydane. Nie zagłębiamy się tutaj również w narzędzia MLops lub LLMops, które nie są jeszcze wysoce ustandaryzowane i zostaną omówione w przyszłym poście.

Pierwsza fala generatywnych aplikacji AI zaczyna osiągać skalę, ale ma problemy z utrzymaniem i zróżnicowaniem

We wcześniejszych cyklach technologicznych powszechnie panowało przekonanie, że aby zbudować dużą, niezależną firmę, trzeba posiadać klienta końcowego — niezależnie od tego, czy chodziło o indywidualnych konsumentów, czy o nabywców B2B. Kuszące jest przekonanie, że największe firmy w generatywnej sztucznej inteligencji będą również tworzyć aplikacje dla użytkowników końcowych. Jak dotąd nie jest jasne, czy tak jest.

Z pewnością rozwój generatywnych aplikacji AI był oszałamiający, napędzany czystą nowością i mnóstwem przypadków użycia. W rzeczywistości jesteśmy świadomi co najmniej trzech kategorii produktów, które przekroczyły już 100 milionów dolarów rocznego przychodu: generowanie obrazu, copywriting i pisanie kodu.

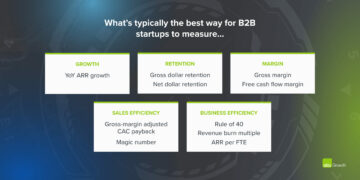

Jednak sam wzrost nie wystarczy, aby zbudować trwałe firmy programistyczne. Krytycznie rzecz biorąc, wzrost musi być opłacalny — w tym sensie, że użytkownicy i klienci, którzy się zarejestrują, generują zyski (wysokie marże brutto) i zostają z nami na długi czas (wysoka retencja). W przypadku braku silnego zróżnicowania technicznego aplikacje B2B i B2C generują długoterminową wartość dla klienta poprzez efekty sieciowe, przechowywanie danych lub budowanie coraz bardziej złożonych przepływów pracy.

W generatywnej sztucznej inteligencji założenia te niekoniecznie są prawdziwe. Wśród firm produkujących aplikacje, z którymi rozmawialiśmy, istnieje szeroki zakres marż brutto — w kilku przypadkach nawet do 90%, ale częściej nawet do 50-60%, co wynika głównie z kosztu wnioskowania o modelu. Wzrost na początku ścieżki był niesamowity, ale nie jest jasne, czy obecne strategie pozyskiwania klientów będą skalowalne — już teraz obserwujemy, jak skuteczność płatnego pozyskiwania i retencja zaczynają spadać. Wiele aplikacji jest również stosunkowo niezróżnicowanych, ponieważ opierają się na podobnych podstawowych modelach sztucznej inteligencji i nie odkryły oczywistych efektów sieciowych lub przepływów danych/pracy, które konkurenci trudno byłoby powielić.

Nie jest więc jeszcze oczywiste, że sprzedaż aplikacji dla użytkowników końcowych jest jedyną, a nawet najlepszą drogą do zbudowania zrównoważonego generatywnego biznesu AI. Marginesy powinny się poprawiać wraz ze wzrostem konkurencji i efektywności modeli językowych (więcej na ten temat poniżej). Retencja powinna wzrosnąć, gdy turyści AI opuszczą rynek. Istnieje mocny argument, że aplikacje zintegrowane pionowo mają przewagę w promowaniu zróżnicowania. Ale jest jeszcze wiele do udowodnienia.

Patrząc w przyszłość, niektóre z głównych pytań, przed którymi stoją firmy generujące aplikacje AI, obejmują:

- Integracja pionowa („model + aplikacja”). Wykorzystywanie modeli AI jako usługi umożliwia twórcom aplikacji szybkie iteracje z małym zespołem i wymianę dostawców modeli w miarę postępu technologicznego. Z drugiej strony, niektórzy deweloperzy twierdzą, że produkt is modelu i że szkolenie od podstaw jest jedynym sposobem na stworzenie możliwości obrony — tj. poprzez ciągłe ponowne szkolenie w zakresie zastrzeżonych danych produktu. Ale odbywa się to kosztem znacznie wyższych wymagań kapitałowych i mniej zwinnego zespołu produktowego.

- Funkcje budowania a aplikacje. Produkty Generative AI przybierają różne formy: aplikacje komputerowe, aplikacje mobilne, wtyczki Figma/Photoshop, rozszerzenia Chrome, a nawet boty Discord. Łatwo jest zintegrować produkty AI tam, gdzie użytkownicy już pracują, ponieważ interfejs użytkownika to zazwyczaj tylko pole tekstowe. Które z nich staną się samodzielnymi firmami — a które zostaną wchłonięte przez zasiedziałych graczy, takich jak Microsoft czy Google, którzy już włączają sztuczną inteligencję do swoich linii produktów?

- Zarządzanie przez cykl szumu. Nie jest jeszcze jasne, czy rezygnacja jest nieodłącznym elementem obecnej partii generatywnych produktów AI, czy też jest artefaktem wczesnego rynku. Lub jeśli wzrost zainteresowania generatywną sztuczną inteligencją spadnie, gdy szum opadnie. Te pytania mają ważne implikacje dla firm zajmujących się aplikacjami, w tym kiedy należy wcisnąć pedał gazu podczas zbierania funduszy; jak agresywnie inwestować w pozyskiwanie klientów; którym segmentom użytkowników nadać priorytet; oraz kiedy deklarować dopasowanie produktu do rynku.

Dostawcy modeli wynaleźli generatywną sztuczną inteligencję, ale nie osiągnęli dużej skali komercyjnej

To, co teraz nazywamy generatywną sztuczną inteligencją, nie istniałoby bez genialnych badań i prac inżynierskich wykonanych w miejscach takich jak Google, OpenAI i Stability. Dzięki nowatorskim architekturom modeli i heroicznym wysiłkom na rzecz skalowania potoków szkoleniowych wszyscy korzystamy z niesamowitych możliwości obecnych dużych modeli językowych (LLM) i modeli generowania obrazów.

Jednak dochody związane z tymi firmami są nadal stosunkowo niewielkie w porównaniu z użytkowaniem i szumem. W zakresie generowania obrazów firma Stable Diffusion odnotowała gwałtowny wzrost społeczności, wspierany przez ekosystem interfejsów użytkownika, hostowane oferty i metody dostrajania. Ale stabilność udostępnia swoje główne punkty kontrolne za darmo jako podstawową zasadę ich działalności. W modelach języka naturalnego dominuje OpenAI z GPT-3/3.5 i ChatGPT. Jednak stosunkowo jak dotąd istnieje kilka zabójczych aplikacji opartych na OpenAI, a ceny już się pojawiły spadł raz.

Może to być tylko tymczasowe zjawisko. Stabilność to nowa firma, która nie skupiła się jeszcze na monetyzacji. OpenAI ma potencjał, aby stać się ogromnym biznesem, zarabiającym znaczną część wszystkich przychodów z kategorii NLP w miarę tworzenia coraz większej liczby zabójczych aplikacji — zwłaszcza jeśli ich integracji z portfolio produktów firmy Microsoft idzie gładko. Biorąc pod uwagę ogromne wykorzystanie tych modeli, przychody na dużą skalę mogą nie być daleko w tyle.

Ale są też siły przeciwstawne. Modele udostępnione jako open source mogą być hostowane przez każdego, w tym przez firmy zewnętrzne, które nie ponoszą kosztów związanych ze szkoleniem modeli na dużą skalę (do dziesiątek lub setek milionów dolarów). I nie jest jasne, czy jakiekolwiek modele z zamkniętym źródłem mogą utrzymać swoją przewagę w nieskończoność. Na przykład zaczynamy dostrzegać, że LLM tworzone przez firmy takie jak Anthropic, Cohere i Character.ai zbliżają się do poziomów wydajności OpenAI, wyszkolonych na podobnych zbiorach danych (tj. w Internecie) i z podobnymi architekturami modeli. Sugeruje to przykład stabilnej dyfuzji if modele open source osiągną wystarczający poziom wydajności i wsparcia społeczności, wówczas zastrzeżone alternatywy mogą mieć trudności z konkurowaniem.

Być może jak dotąd najwyraźniejszym wnioskiem dla dostawców modeli jest to, że komercjalizacja jest prawdopodobnie powiązana z hostingiem. Popyt na autorskie API (np. z OpenAI) szybko rośnie. Usługi hostingowe dla modeli open source (np. Hugging Face i Replicate) stają się użytecznymi centrami do łatwego udostępniania i integrowania modeli — a nawet mają pewne pośrednie efekty sieciowe między producentami modeli a konsumentami. Istnieje również mocna hipoteza, że można zarabiać na dostrajaniu i umowach hostingowych z klientami korporacyjnymi.

Poza tym jednak dostawcy modeli mają wiele ważnych pytań:

- Utowarowienie. Istnieje powszechne przekonanie, że modele AI będą zbiegać się pod względem wydajności w miarę upływu czasu. Rozmawiając z twórcami aplikacji, jasne jest, że tak się jeszcze nie stało, z silnymi liderami zarówno w modelach tekstowych, jak i graficznych. Ich zalety opierają się nie na unikalnych architekturach modeli, ale na wysokich wymaganiach kapitałowych, zastrzeżonych danych interakcji produktów i rzadkich talentach AI. Czy będzie to trwała przewaga?

- Ryzyko ukończenia studiów. Poleganie na dostawcach modeli to świetny sposób dla firm tworzących aplikacje na rozpoczęcie działalności, a nawet na jej rozwój. Ale jest dla nich zachęta do budowania i / lub hostowania własnych modeli, gdy osiągną skalę. A wielu dostawców modeli ma bardzo wypaczoną dystrybucję klientów, z kilkoma aplikacjami reprezentującymi większość przychodów. Co się stanie, jeśli/kiedy ci klienci przestawią się na wewnętrzny rozwój sztucznej inteligencji?

- Czy pieniądze są ważne? Obietnica generatywnej sztucznej inteligencji jest tak wielka — a także potencjalnie tak szkodliwa — że wielu dostawców modeli zorganizowało się jako korporacje pożytku publicznego (korpus B), emitowało ograniczone akcje w zyskach lub w inny sposób wyraźnie włączyło dobro publiczne do swojej misji. Wcale to nie przeszkodziło im w zbieraniu funduszy. Ale istnieje rozsądna dyskusja na temat tego, czy faktycznie większość dostawców modeli chcieć uchwycić wartość, a jeśli powinni.

Dostawcy infrastruktury dotykają wszystkiego i czerpią korzyści

Prawie wszystko w generatywnej sztucznej inteligencji przechodzi w pewnym momencie przez hostowany w chmurze procesor graficzny (lub TPU). Niezależnie od tego, czy chodzi o dostawców modeli / laboratoria badawcze obsługujące obciążenia szkoleniowe, firmy hostingowe prowadzące wnioskowanie/dostrajanie, czy też firmy aplikacyjne wykonujące kombinację obu — FLOPS są siłą napędową generatywnej sztucznej inteligencji. Po raz pierwszy od bardzo dawna postęp w najbardziej przełomowej technologii komputerowej jest w dużym stopniu związany z mocą obliczeniową.

W rezultacie wiele pieniędzy na generatywnym rynku sztucznej inteligencji ostatecznie trafia do firm infrastrukturalnych. Aby umieścić trochę początku. przybliżone liczby: szacujemy, że firmy produkujące aplikacje wydają średnio około 20-40% przychodów na wnioskowanie i dostrajanie pod kątem klienta. Jest to zwykle płacone albo bezpośrednio dostawcom chmury za instancje obliczeniowe, albo zewnętrznym dostawcom modeli — którzy z kolei wydają około połowy swoich przychodów na infrastrukturę chmurową. Można więc przypuszczać, że 10-20 proc całkowity dochód w generatywnej sztucznej inteligencji trafia dziś do dostawców chmury.

Co więcej, startupy szkolące własne modele zgromadziły miliardy dolarów kapitału podwyższonego ryzyka — z których większość (do 80-90% we wczesnych rundach) jest zwykle wydawana również z dostawcami usług w chmurze. Wiele publicznych firm technologicznych wydaje setki milionów rocznie na szkolenie modeli, zarówno u zewnętrznych dostawców chmury, jak i bezpośrednio u producentów sprzętu.

Technicznie rzecz biorąc, nazwalibyśmy to „mnóstwem pieniędzy” — szczególnie w przypadku rodzącego się rynku. Większość z nich spędza się na tzw Big 3 chmury: Amazon Web Services (AWS), Google Cloud Platform (GCP) i Microsoft Azure. Ci dostawcy usług w chmurze łącznie wydać więcej niż $ 100 miliardów rocznie w nakładach inwestycyjnych, aby mieć pewność, że dysponują najbardziej wszechstronnymi, niezawodnymi i konkurencyjnymi kosztowo platformami. W szczególności w generatywnej sztucznej inteligencji korzystają oni również z ograniczeń podaży, ponieważ mają preferencyjny dostęp do rzadkiego sprzętu (np. procesorów graficznych Nvidia A100 i H100).

Co ciekawe, zaczynamy dostrzegać pojawiającą się wiarygodną konkurencję. Konkurenci, tacy jak Oracle, dokonali inwazji dzięki dużym wydatkom inwestycyjnym i zachętom do sprzedaży. A kilka startupów, takich jak Coreweave i Lambda Labs, szybko się rozwinęło dzięki rozwiązaniom skierowanym specjalnie do twórców dużych modeli. Konkurują pod względem kosztów, dostępności i spersonalizowanego wsparcia. Uwidaczniają również bardziej szczegółowe abstrakcje zasobów (tj. kontenery), podczas gdy duże chmury oferują tylko instancje maszyn wirtualnych ze względu na ograniczenia wirtualizacji GPU.

Za kulisami, obsługujący ogromną większość obciążeń AI, jest prawdopodobnie największym jak dotąd zwycięzcą w generatywnej sztucznej inteligencji: Nvidia. Przedsiębiorstwo zgłoszone 3.8 XNUMX $ miliard przychodów z procesorów graficznych w centrach danych w trzecim kwartale roku podatkowego 2023, w tym znaczącą część dla generatywnych przypadków użycia AI. I zbudowali silne fosy wokół tego biznesu przez dziesięciolecia inwestycji w architekturę GPU, solidny ekosystem oprogramowania i głębokie wykorzystanie w społeczności akademickiej. Jedna niedawna analiza odkryli, że procesory graficzne Nvidia są cytowane w artykułach badawczych 90 razy częściej niż topowe start-upy z układami AI razem wzięte.

Istnieją inne opcje sprzętowe, w tym Google Tensor Processing Units (TPU); procesory graficzne AMD Instinct; chipy AWS Inferentia i Trainium; oraz akceleratory AI od startupów, takich jak Cerebras, Sambanova i Graphcore. Spóźniony Intel również wchodzi na rynek ze swoimi wysokiej klasy chipami Habana i procesorami graficznymi Ponte Vecchio. Jednak jak dotąd niewiele z tych nowych chipów zdobyło znaczący udział w rynku. Dwa wyjątki, na które należy zwrócić uwagę, to Google, którego TPU zyskały popularność w społeczności Stable Diffusion i w niektórych dużych transakcjach GCP, oraz TSMC, który prawdopodobnie produkuje cała kolekcja z wymienionych tutaj chipów, w tym GPU Nvidia (Intel używa mieszanki własnych fabryk i TSMC do produkcji swoich chipów).

Innymi słowy, infrastruktura jest lukratywną, trwałą i pozornie dającą się obronić warstwą stosu. Główne pytania, na które firmy infra muszą odpowiedzieć, obejmują:

- Trzymanie się obciążeń bezstanowych. Procesory graficzne Nvidia są takie same, niezależnie od tego, gdzie je wypożyczysz. Większość obciążeń sztucznej inteligencji jest bezstanowa w tym sensie, że wnioskowanie o modelu nie wymaga dołączonych baz danych ani magazynu (poza samymi wagami modelu). Oznacza to, że obciążenia sztucznej inteligencji mogą być bardziej przenośne w chmurach niż tradycyjne obciążenia aplikacji. Jak w tym kontekście dostawcy usług w chmurze mogą stworzyć lepkość i uniemożliwić klientom przejście do najtańszej opcji?

- Przetrwanie końca niedoboru żetonów. Ceny dla dostawców chmury, a także dla samej Nvidii, były wspierane przez ograniczone dostawy najbardziej pożądanych procesorów graficznych. Jeden dostawca powiedział nam, że cena katalogowa A100s faktycznie ma wzrosła od premiery, co jest bardzo nietypowe dla sprzętu obliczeniowego. Kiedy to ograniczenie podaży zostanie ostatecznie usunięte poprzez zwiększoną produkcję i/lub przyjęcie nowych platform sprzętowych, w jaki sposób wpłynie to na dostawców usług w chmurze?

- Czy chmura pretendentów może się przebić? Mocno w to wierzymy pionowe chmury przejmie udział w rynku Wielkiej Trójki dzięki bardziej wyspecjalizowanym ofertom. Jak dotąd w sztucznej inteligencji pretendenci wypracowali znaczącą trakcję dzięki umiarkowanemu zróżnicowaniu technicznemu i wsparciu Nvidii — dla której obecni dostawcy chmury są zarówno największymi klientami, jak i wschodzącymi konkurentami. Długoterminowe pytanie brzmi: czy to wystarczy, aby przezwyciężyć zalety skali Wielkiej Trójki?

Więc… gdzie będzie się gromadzić wartość?

Oczywiście, jeszcze nie wiemy. Ale w oparciu o wczesne dane, które mamy dla generatywnej sztucznej inteligencji, w połączeniu z nasze doświadczenie z wcześniejszymi firmami AI/ML, nasza intuicja jest następująca.

Wydaje się, że obecnie nie ma żadnych systemowych fos w generatywnej sztucznej inteligencji. Jako przybliżenie pierwszego rzędu, aplikacjom brakuje silnego zróżnicowania produktów, ponieważ używają podobnych modeli; modele napotykają niejasne długoterminowe zróżnicowanie, ponieważ są szkolone na podobnych zbiorach danych o podobnej architekturze; dostawcom chmury brakuje głębokiego zróżnicowania technicznego, ponieważ korzystają z tych samych procesorów graficznych; a nawet firmy produkujące sprzęt produkują swoje chipy w tych samych fabrykach.

Istnieją oczywiście standardowe fosy: fosy łuskowe („Mam lub mogę zebrać więcej pieniędzy niż ty!”), fosy łańcucha dostaw („Ja mam procesory graficzne, ty nie!”), fosy ekosystemowe („Ja mam procesory graficzne, ty nie!”). Wszyscy już korzystają z mojego oprogramowania!”), fosy algorytmiczne („Jesteśmy sprytniejsi od ciebie!”), fosy dystrybucyjne („Mam już zespół sprzedaży i więcej klientów niż ty!”) i fosy potoków danych („Ja przeszukaliśmy więcej internetu niż ty!”). Ale żadna z tych fos nie jest trwała na dłuższą metę. I jest zbyt wcześnie, aby stwierdzić, czy silne, bezpośrednie efekty sieciowe utrzymują się w którejkolwiek warstwie stosu.

Na podstawie dostępnych danych po prostu nie jest jasne, czy w generatywnej sztucznej inteligencji będzie istniała długoterminowa dynamika typu „zwycięzca bierze wszystko”.

To jest dziwne. Ale dla nas to dobra wiadomość. Potencjalny rozmiar tego rynku jest trudny do uchwycenia – gdzieś pomiędzy całe oprogramowanie i wszystkie ludzkie starania — więc spodziewamy się wielu, wielu graczy i zdrowej rywalizacji na wszystkich poziomach stacka. Oczekujemy również, że zarówno firmy horyzontalne, jak i pionowe odniosą sukces, przy najlepszym podejściu podyktowanym przez rynki końcowe i użytkowników końcowych. Na przykład, jeśli główną różnicą w produkcie końcowym jest sama sztuczna inteligencja, prawdopodobne jest, że pionizacja (tj. ścisłe powiązanie aplikacji skierowanej do użytkownika z modelem domowym) zwycięży. Natomiast jeśli sztuczna inteligencja jest częścią większego zestawu funkcji z długim ogonem, bardziej prawdopodobne jest, że nastąpi poziomowanie. Oczywiście z biegiem czasu powinniśmy również zobaczyć budowę bardziej tradycyjnych fos - i możemy nawet zobaczyć, jak powstają nowe typy fos.

W każdym razie, jednej rzeczy jesteśmy pewni, że generatywna sztuczna inteligencja zmieni grę. Wszyscy uczymy się zasad w czasie rzeczywistym, istnieje ogromna ilość wartości, które zostaną odblokowane, aw rezultacie krajobraz technologiczny będzie wyglądał znacznie, znacznie inaczej. I po to tu jesteśmy!

Wszystkie obrazy w tym poście zostały utworzone za pomocą Midjourney.

- Dystrybucja treści i PR oparta na SEO. Uzyskaj wzmocnienie już dziś.

- Platoblockchain. Web3 Inteligencja Metaverse. Wzmocniona wiedza. Dostęp tutaj.

- Źródło: https://a16z.com/2023/01/19/who-owns-the-generative-ai-platform/

- $ 100 mln

- $3

- 1

- a

- A100

- O nas

- akademicki

- akceleratory

- dostęp

- osiągnięty

- nabycie

- w poprzek

- faktycznie

- Przyjęcie

- zaliczki

- Korzyść

- Zalety

- Po

- umowy

- przed

- AI

- Platforma AI

- przypadki użycia ai

- AI / ML

- algorytmiczny

- Wszystkie kategorie

- pozwala

- sam

- już

- alternatywy

- zdumiewający

- Amazonka

- Amazon Web Services

- Amazon Web Services (AWS)

- AMD

- ilość

- w czasie rzeczywistym sprawiają,

- i

- roczny

- odpowiedź

- ktoś

- Pszczoła

- Aplikacja

- zjawić się

- Zastosowanie

- aplikacje

- Stosowanie

- podejście

- mobilne i webowe

- architektura

- argumentować

- argument

- na około

- sztuczny

- sztuczna inteligencja

- Sztuczna inteligencja (AI)

- powiązany

- dostępność

- dostępny

- średni

- AWS

- Inferencja AWS

- Lazur

- B2B

- B2C

- na podstawie

- Niedźwiedź

- bo

- stają się

- zanim

- za

- wiara

- uwierzyć

- Uważa

- wierzący

- poniżej

- korzyści

- BEST

- pomiędzy

- Poza

- Duży

- Najwyższa

- Miliard

- miliardy

- wysięgnik

- boty

- związany

- Pudełko

- przerwa

- błyskotliwy

- szerszy

- budować

- Budowanie

- wybudowany

- Uparty

- biznes

- biznes

- kupujący

- wezwanie

- możliwości

- kapitał

- zdobyć

- Przechwytywanie

- walizka

- Etui

- kategorie

- Kategoria

- Centrum

- pewien

- challenger

- Zmiany

- charakter

- ChatGPT

- najtańsze

- żeton

- Frytki

- Chrom

- cytowane

- jasny

- bliższy

- Chmura

- infrastruktura chmurowa

- Platforma chmurowa

- kod

- zbiorowo

- połączenie

- połączony

- jak

- handlowy

- komercjalizacja

- wspólny

- społeczność

- Firmy

- sukcesy firma

- w porównaniu

- rywalizować

- konkurencja

- konkurenci

- kompleks

- wszechstronny

- obliczać

- computing

- Ograniczenia

- Konsumenci

- Pojemniki

- kontekst

- nieustannie

- Konwencjonalny

- zbieżny

- copywriting

- rdzeń

- Korporacje

- Koszty:

- Koszty:

- kurs

- Stwórz

- stworzony

- Tworzenie

- wiarygodny

- krytyczny

- Aktualny

- klient

- Klientów

- Cykle

- dane

- Centrum danych

- Bazy danych

- zbiory danych

- sprawa

- Promocje

- lat

- głęboko

- Kreowanie

- stacjonarny

- rozwijać

- deweloperzy

- oprogramowania

- Devs

- różne

- Różne formy

- zróżnicowany

- Transmitowanie

- kierować

- bezpośrednio

- niezgoda

- odkryty

- dyskusja

- uciążliwy

- 分配

- Dystrybucje

- podzielony

- robi

- dolarów

- dominuje

- nie

- dziesiątki

- napęd

- napędzany

- sterowniki

- jazdy

- dynamiczny

- dynamika

- każdy

- Wcześniej

- Wcześnie

- Zarobek

- z łatwością

- Ekosystem

- krawędź

- ruchomości

- efektywność

- starania

- bądź

- wschodzących

- Inżynieria

- dość

- zapewnić

- Enterprise

- klienci korporacyjni

- szczególnie

- oszacowanie

- Parzyste

- ostatecznie

- wszystko

- przykład

- przykłady

- oczekiwać

- doświadczenie

- rozszerzenia

- zewnętrzny

- Twarz

- okładzina

- Spadać

- Cecha

- Korzyści

- kilka

- Znajdź

- znalezieniu

- i terminów, a

- pierwszy raz

- Fiskalny

- dopasować

- Trzepnięcie

- Płynący

- Przepływy

- koncentruje

- następujący

- Siły

- formularze

- znaleziono

- Fundacja

- założyciele

- Framework

- Darmowy

- od

- Fundraising

- przyszłość

- Zyski

- gra

- GAS

- ogólnie

- Generować

- generacja

- generatywny

- generatywna sztuczna inteligencja

- otrzymać

- dany

- daje

- cel

- Goes

- będzie

- dobry

- Google Cloud

- Platforma Google Cloud

- GPU

- GPU

- chwycić

- wspaniały

- brutto

- Rosnąć

- Rozwój

- dorosły

- Wzrost

- Pół

- zdarzyć

- się

- dzieje

- Ciężko

- sprzęt komputerowy

- szkodliwy

- zdrowy

- tutaj

- Wysoki

- wyższy

- wysoko

- historyczny

- Dobranie (Hit)

- przytrzymaj

- przytrzymanie

- Poziomy

- gospodarz

- hostowane

- Hosting

- HOT

- W jaki sposób

- HTTPS

- olbrzymi

- człowiek

- Setki

- setki milionów

- Szum

- obraz

- generowanie obrazu

- zdjęcia

- Rezultat

- implikacje

- ważny

- podnieść

- in

- W innych

- Motywacja

- zachęty

- zawierać

- Włącznie z

- Rejestrowy

- włączenie

- Zwiększać

- wzrosła

- Zwiększenia

- coraz bardziej

- niewiarygodnie

- Beneficjant

- niezależny

- indywidualny

- przemysł

- Infrastruktura

- nieodłączny

- integrować

- zintegrowany

- integracja

- Intel

- Inteligencja

- wzajemne oddziaływanie

- odsetki

- interfejsy

- Internet

- intuicja

- Zmyślony

- Inwestuj

- inwestycja

- Wydany

- IT

- samo

- Klawisz

- Wiedzieć

- Labs

- Brak

- krajobraz

- język

- duży

- na dużą skalę

- w dużej mierze

- większe

- Nazwisko

- Ostatni rok

- Późno

- uruchomić

- warstwa

- nioski

- Przywódcy

- nauka

- Pozostawiać

- poziom

- poziomy

- Prawdopodobnie

- Limity

- linie

- Lista

- Katalogowany

- długo

- długi czas

- długoterminowy

- Popatrz

- WYGLĄD

- Partia

- niski

- lukratywny

- zrobiony

- utrzymać

- poważny

- Większość

- robić

- Producenci

- wiele

- mapa

- marginesy

- rynek

- mapa rynku

- Struktura rynku

- rynki

- masywny

- masywnie

- Maksymalna szerokość

- wymowny

- znaczy

- metody

- Microsoft

- Azure firmy Microsoft

- W połowie podróży

- milion

- miliony

- Misja

- MLOps

- Aplikacje mobilne

- aplikacje mobilne

- model

- modele

- Monetyzacji

- zarabiać

- pieniądze

- jeszcze

- większość

- wielokrotność

- powstający

- Naturalny

- Język naturalny

- koniecznie

- Potrzebować

- sieć

- Nowości

- nowy sprzęt

- aktualności

- Następny

- zwinny

- nlp

- powieść

- nowość

- numer

- z naszej

- Nvidia

- oczywista

- oferta

- Oferty

- ONE

- koncepcja

- open source

- OpenAI

- operatorzy

- Option

- Opcje

- wyrocznia

- Zlecenia

- Zorganizowany

- Inne

- Inaczej

- zewnętrzne

- Przezwyciężać

- własny

- posiada

- płatny

- Papiery

- część

- szczególny

- strony

- przebiegi

- ścieżka

- jest gwarancją najlepszej jakości, które mogą dostarczyć Ci Twoje monitory,

- może

- Personalizowany

- zjawisko

- rurociąg

- Miejsce

- Miejsca

- Platforma

- Platformy

- plato

- Analiza danych Platona

- PlatoDane

- gracze

- nadmiar

- wtyczki

- punkt

- możliwy

- Post

- potencjał

- potencjalnie

- power

- przewidywanie

- zapobiec

- Cena

- Cennik

- pierwotny

- Wcześniejszy

- Priorytet

- przetwarzanie

- Producenci

- Produkt

- Produkcja

- Produkty

- Zysk

- rentowny

- zyski

- Postęp

- obietnica

- własność

- Udowodnij

- dostawca

- dostawców

- publiczny

- położyć

- Kwartał

- pytanie

- pytania

- szybko

- podnieść

- zasięg

- szybko

- dosięgnąć

- osiągnięty

- real

- w czasie rzeczywistym

- rozsądny

- niedawny

- dokumentacja

- stosunkowo

- wydany

- rzetelny

- Usunięto

- Wynajem

- reprezentowanie

- wymagać

- wymagania

- Badania naukowe

- Zasób

- odpowiedzialny

- dalsze

- retencja

- dochód

- przychody

- Ryzyko

- krzepki

- rundy

- reguły

- run

- bieganie

- sole

- Zachęty sprzedażowe

- taki sam

- skalowalny

- Skala

- Rzadki

- Niedobór

- Sceny

- widzenie

- Segmenty

- Sprzedawanie

- rozsądek

- służyć

- usługa

- Usługi

- zestaw

- ustawienie

- kilka

- Shape

- Share

- Akcje

- powinien

- pokazać

- znak

- znaczący

- podobny

- ponieważ

- Rozmiar

- mały

- płynnie

- So

- dotychczas

- Tworzenie

- rozwiązanie

- Rozwiązania

- kilka

- gdzieś

- Źródło

- wyspecjalizowanym

- swoiście

- wydać

- spędził

- Stabilność

- stabilny

- stos

- etapy

- stoisko

- standalone

- standard

- początek

- rozpoczęty

- Startowy

- startup

- Startups

- Kij

- Nadal

- przechowywanie

- strategie

- silny

- strukturalny

- Struktura

- Walka

- osiągnąć sukces

- wystarczający

- Wskazuje

- Dostawa

- wsparcie

- Utrzymany

- powstaje

- zrównoważone

- Przełącznik

- systemowy

- Brać

- biorąc

- Talent

- rozmawiać

- ukierunkowane

- zadania

- zespół

- tech

- tech

- Techniczny

- Technologia

- tymczasowy

- REGULAMIN

- Połączenia

- ich

- sami

- rzecz

- Trzeci

- innych firm

- trzy

- Przez

- Związany

- ciasno

- czas

- czasy

- do

- już dziś

- także

- Top

- Kontakt

- trakcja

- tradycyjny

- przeszkolony

- Trening

- Transformacja

- ogromny

- Trendy

- prawdziwy

- TSMC

- SKRĘCAĆ

- typy

- zazwyczaj

- ui

- Ostatecznie

- zasadniczy

- zrozumieć

- wyjątkowy

- jednostek

- niezwykły

- us

- Stosowanie

- posługiwać się

- Użytkownik

- Użytkownicy

- wartość

- Naprawiono

- sprzedawców

- przedsięwzięcie

- venture capital

- przez

- Zobacz i wysłuchaj

- Oglądaj

- fala

- sieć

- usługi internetowe

- znane

- Co

- czy

- który

- Podczas

- KIM

- szeroki

- Szeroki zasięg

- Wikipedia

- będzie

- wygrać

- Zwycięzcy

- mądrość

- bez

- słowa

- Praca

- przepływów pracy

- pisanie

- rok

- zefirnet