Eksperci przy stole: Semiconductor Engineering zasiedli do dyskusji, w jaki sposób i dlaczego firmy dzielą pracę lokalną i w chmurze oraz na co należy uważać, z Philipem Steinke, współpracownikiem ds. infrastruktury CAD i projektowania fizycznego w AMD; Mahesh Turaga, wiceprezes ds. rozwoju biznesu w chmurze w Systemy projektowania kadencji; Richard Ho, wiceprezes ds. inżynierii sprzętu w firmie Lightmatter; Craig Johnson, wiceprezes ds. rozwiązań chmurowych w firmie Siemens Digital Industries Software; i Rob Aitken, kolega w Synopsys. Poniżej znajdują się fragmenty tej rozmowy, która odbyła się przed publicznością na żywo podczas konferencji Design Automation. Część pierwsza tej dyskusji jest tutaj.

SE: Przy tak dużej stawce w projektowaniu układów scalonych, w jaki sposób można osiągnąć najlepszy zwrot z inwestycji dzięki zasobom w chmurze?

Steinke: Wybierając przepływy pracy do obsługi chmury, zaczęliśmy od przyjrzenia się danym. Które z nich mają łatwy do zarządzania zestaw danych, które można hermetyzować, przenosić do centrum danych hostowanego w chmurze w celu wykonania jakiegoś rodzaju obliczeń, a następnie uzyskać rozsądną liczbę wyników, które wracają? Jednym z obszarów, na którym się skupiliśmy, była weryfikacja front-end. Preferowany przeze mnie proces polega na utrzymywaniu naszych kompilacji na miejscu, łączeniu samego modelu wraz z bodźcem testowym i wysyłaniem go do rzeczywistej symulacji w chmurze obliczeniowej. Inną klasą obciążeń, dla których udostępniliśmy chmurę, są obciążenia z pełną weryfikacją chipów, przebiegi pełnego podpisu w celu statycznego pomiaru czasu, weryfikacji fizycznej i zasilania — głównie dlatego, że w środowisku typu „miejsce i trasa” wchodzisz w regularna kadencja codziennych ECO lub zwykłych ECO, które mają miejsce i wprowadzają zmiany, i istnieje już konfiguracja zarządzania danymi, z wydaniami projektu. Jesteśmy więc w stanie umieścić haki w tym mechanizmie uwalniania, nie tylko po to, aby umieścić go w jakimś lokalnym woluminie wydania w naszym własnym centrum danych, ale następnie wypchnąć te dane do centrum danych w chmurze, które zostało wybrane do wykonania tych Oferty pracy. Jedną z obaw związanych z tak dużym obciążeniem jest to, że jeśli masz już scaloną Oasis lub jeśli zebrałeś wszystkie specyfikacje dla swojego projektu, na którym chcesz uruchomić statyczne taktowanie, jest to znaczna część danych do przesunięcia wszystko na raz. Ale aktualizując metodologię uwalniania na poziomie bloków, pojawiają się, gdy każdy blok jest uwalniany w ciągu dnia. W ten sposób możesz rozpocząć hostowane w chmurze zadanie analizy pełnego układu z mniejszymi opóźnieniami. Główne wyzwanie, jakie tam widziałem, to dostęp do dobrych maszyn wirtualnych w chmurze z wystarczającą ilością pamięci do uruchamiania tych dużych zadań. To kolejna przestrzeń, do której wciąż zachęcamy naszych partnerów w chmurze — rozwiązania z dużą ilością pamięci RAM, z których mogą korzystać firmy projektujące układy scalone.

SE: Jakiej rady możesz udzielić na temat rozróżniania, kiedy obciążenie powinno być wykonywane w wersji premium, a kiedy w chmurze?

Aitken: Istnieje interesująca dynamika, którą widzimy właśnie u przedstawicieli tego panelu, ponieważ sposób, w jaki Richard może do tego podejść, a sposób, w jaki może podejść do tego Phil, będzie inny. Jeden jest bardzo skoncentrowany na projekcie przechodzącym przez szczyty i doliny pod względem potrzeb. W AMD przypuszczalnie cały czas powstaje wiele projektów, więc najpierw trzeba się zastanowić, co próbują zrobić. Jaka infrastruktura ma sens, jeśli próbujesz dostać się do świata, w którym wszystkie projekty będziesz wykonywać w chmurze, a po prostu wolałbyś nie mieć w ogóle centrum danych na miejscu? Sposób, w jaki do tego podejdziesz, będzie inny niż w przypadku korzystania z chmury jako możliwości tworzenia kopii zapasowych i rozszerzania ogromnej infrastruktury, którą już posiadasz.

SE: Praktycznie rzecz biorąc, jak podejmujesz decyzję?

Kaszel: Patrzysz na dane. Ile masz danych? Ile danych zamierzasz wygenerować? A czego potrzebujesz z powrotem? Kluczem do sukcesu jest to, że informacje, które chcesz odzyskać z chmury. On-prem musi być minimalny, więc pojawią się tylko raporty i wyniki twoich regresji. Nasza kompilacja opiera się właściwie na naszej małej lokalnej siedzibie. Wysyłamy go i przeprowadzamy tam nasze symulacje, a także przeprowadzamy własną analizę zasięgu. Potem odsyłamy wyniki, są bardzo małe i dobre. Zaplecze jest inne. Jeśli chodzi o projekt fizyczny, wysyłasz projekt tam, chcesz, aby pozostał w chmurze tak długo, jak to możliwe, ponieważ te bazy danych są ogromne i naprawdę nie chcesz, aby w ogóle wrócił. W tym momencie jest to infrastruktura jako usługa. Wystarczy, że Twoi ludzie zalogują się do chmury i wykonają tam cały fizyczny projekt, dopóki nie otrzymasz GDS. Tam, to rzeczy wewnątrz maszyny — ile pamięci możesz uzyskać? To jeden z ograniczników. W rzeczywistości posiadanie bardzo dużych maszyn wirtualnych w chmurze jest bardzo drogie. Dość często taniej jest kupić własne. Nie rozmawialiśmy o kosztach. Koszt chmury nie jest tym, co ludzie myślą. Jest dość wysoko. Dość często jest to coś więcej niż on-prem, więc musisz to zrównoważyć, aby uzyskać przewagę elastyczności i dostępu do dużych zasobów pamięci. A wygląd będzie bardzo indywidualny dla każdego klienta.

Johnson: To pytanie naprawdę odnosi się do zwrotu z inwestycji w to. To zależy od tego, co próbujesz osiągnąć jako użytkownik środowiska, i to jest część wyzwania. Każda firma przeprowadza własne obliczenia w oparciu o swoją strategię, aby dowiedzieć się, co chce robić w chmurze i jak agresywnie jest skłonna wydać, aby czerpać z tego korzyści. Drugim elementem jest zwrot, który mierzysz różni się od kosztu posiadania. Zwykle jesteśmy lepsi w przeprowadzaniu analizy całkowitego kosztu posiadania niż część „R” zwrotu z inwestycji, która musi następnie uwzględniać bardziej niematerialne czynniki, czas przepustowości i przewagę w czasie wprowadzania na rynek.

Aitken: Nawet przy czymś tak prostym, jak opóźnienie, kiedy uruchamiasz narzędzie, a czas odpowiedzi to „poruszałem myszką, a chwilę później coś się dzieje”, może to być bardzo frustrujące.

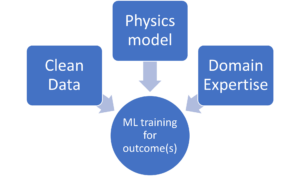

Turaga: Historycznie, jeśli spojrzymy na zwrot z inwestycji w chmurze, istnieją trzy klasy narzędzi, które mogą bardzo skutecznie wykorzystać chmurę. Pierwsza to organizacja projektu, iteracje projektu, regresje z weryfikacją. Po drugie, istnieją długotrwałe symulacje z dużymi obciążeniami obliczeniowymi, które można bardzo dobrze skalować, aby wykorzystać algorytmy obliczeniowe w różnych przypadkach. Trzeci to typ interaktywny, podobnie jak narzędzia, które wymagają opóźnień, a także wymagają dużego rozwoju współpracy. Oto trzy kategorie narzędzi, które zapewniają najlepszy zwrot z inwestycji w chmurze. I znowu, w zależności od sytuacji każdego klienta, zależy to od narzędzia, które chcą uruchomić w chmurze. Niektórzy z naszych klientów rozpoczęli od weryfikacji, ale zależy to od konkretnej sytuacji klienta.

SE: Jeśli chodzi o użytkowników chmury, jak doszedłeś do decyzji dotyczących Twojego modelu korzystania z chmury?

Steinke: Jesteśmy już jakiś czas. Mieliśmy już dość duże centrum danych, więc na początku nie musieliśmy wchodzić all-in. Chcieliśmy rozszerzyć to, co mamy, o to, co ma do zaoferowania chmura. Nasze lokalne centrum danych nadal zapewnia ogromną ilość mocy obliczeniowej. Projekty przychodzą i odchodzą, i dzieją się nieoczekiwane rzeczy; możliwość zastosowania tej elastyczności i posiadania wielu źródeł mocy obliczeniowej, z których możemy czerpać, to zaleta, z której chcieliśmy skorzystać. To była duża część naszej motywacji do chmury i dlaczego poszliśmy w tę stronę. Mieliśmy już tę wstępną inwestycję, więc było to coś, co chcieliśmy rozszerzyć i rozbudować.

Kaszel: Mogę na to odpowiedzieć z dwóch perspektyw. Pierwsza perspektywa jest taka, że zanim trafiłem do Lightmatter, pracowałem w Google nad TPU i zespołem ds. infrastruktury, tam również korzystaliśmy z chmury. Odpowiedź tam jest inna niż odpowiedź w Lightmatter. Jednym z pytań, które musisz sobie zadać, jest to, czy chcesz, aby Twoje repo (repozytorium) było na miejscu, czy w chmurze. W firmie takiej jak Google i prawdopodobnie AMD chcą, aby ich repozytorium było na miejscu. Czują się bezpieczniej, czują, że mają większą kontrolę. W mniejszej firmie, takiej jak Lightmatter, niekoniecznie mnie to obchodzi. Czułem się komfortowo z bezpieczeństwem chmury, więc mogę mieć repozytorium w chmurze. A w tym mniejszym kontekście posiadanie repozytorium w chmurze oznacza, że używamy chmury prawie jako pełnej infrastruktury. To jest to samo, co mój on-prem. To pierwsza obawa. Drugi problem to dziedzictwo. Niektóre firmy mają tradycje, a kiedy próbujesz przejść od starszego rozwiązania do rozwiązania opartego na chmurze, naprawdę musisz zrozumieć, co zyskujesz, co przemawia do celu tego panelu. Staramy się wskazać, gdzie zyskujesz korzyści w zakresie elastyczności, możliwości posiadania nowszych maszyn itp. To, co naprawdę się liczy, dotyczy niektórych z tych obciążeń, w przypadku których odbywa się wiele równoległych przebiegów. Chcesz zarządzać dużym zestawem serwerów i uruchomionych zadań, i właśnie tam powinieneś przejść do chmury. Możesz wykorzystać to w swoim obciążeniu pracą. Następnie, wracając do przepływu danych, gdzie masz ograniczenie, musisz podjąć decyzję. Podjęliśmy decyzję o repozytorium fizycznego projektu w chmurze, ale inne firmy tego nie zrobiły. Wiem, że firmy mają więcej. Wykonali wiele projektów fizycznych, które nadal są dostępne, ponieważ potrzebują dużo pamięci i nie potrzebują tak wielu maszyn. Musisz więc przyjrzeć się każdemu z tych przypadków i podjąć decyzję w oparciu o twoją sytuację.

Turaga: Wiele małych i średnich startupów naszych klientów nie chce repo on-prem. Nie mają problemów ze starszymi centrami danych, więc naprawdę w pełni wykorzystują chmurę. Niektóre z większych firm, które mają już ogromną infrastrukturę lokalną, przechodzą na model hybrydowy.

SE: Biorąc pod uwagę niemal zdumiewającą liczbę typów instancji dostępnych w chmurze od różnych dostawców, oprócz kosztów licencji, które nie są jeszcze zoptymalizowane pod kątem chmury, w jaki sposób użytkownicy mogą ulepszyć sposób, w jaki wybierają odpowiedni rodzaj instancji do wykonywania swoich zadań?

Johnson: To jedna z podstawowych rzeczy, którymi próbujemy się zająć. Nasz pomysł był skierowany do firm takich jak AMD, które w dużej mierze chcą zarządzać własną infrastrukturą i optymalizować ją w określony sposób. Potrzebują od nas pomocy w podejmowaniu decyzji dotyczących konkretnych aplikacji, dotyczących tego, jakie typy instancji z jaką ilością pamięci działają najlepiej, a może konfiguracja samego obciążenia. Jak mogą zarządzać przebiegami zadań w celu uzyskania optymalnej wydajności? Próbujemy spakować to wszystko w coś, co nazywamy planem lotu. Mamy te plany lotów dostępne dla różnych części naszego przepływu z sugestiami dotyczącymi linii bazowych. Jeśli klient chce z tego skorzystać, świetnie. Jeśli chcą na tym riffować i poprawiać, to też jest w porządku dla nas.

Aitken: Widok Synopsys jest taki sam, ale istnieje również zależność od konkretnego projektu, który wykonujesz. Niektóre projekty będą po prostu wymagać większych lub wyższych instancji niż inne. W zależności od tego, jaki jest twój konkretny przepływ pracy, niektóre instancje będą miały mniej lub więcej sensu niż inne. Poza tym nie chodzi tylko o koszty licencji. To także koszty maszyn w chmurze, które trzeba również przeliczyć. Większe maszyny są droższe, ale być może możesz dłużej obsługiwać obciążenie na mniejszej instancji i płacić więcej opłat licencyjnych, ale mniej niż opłaty obliczeniowe.

Kaszel: Skupiliśmy się na tym, aby spojrzeć na to pod kątem rzeczywistego przebiegu. Czy to lot przed odprawą? Dzięki wstępnemu zameldowaniu potrzebujesz szybszego działania z niskimi opóźnieniami, więc otrzymujesz do tego naprawdę wydajną instancję. Czy to nocna regresja? W takim przypadku niekoniecznie obchodzi mnie, jak szybko się skończy. Musi tylko zakończyć się z dnia na dzień, co oznacza, że mogę zapłacić za tańsze instancje za moje nocne regresje. Współpracujemy z naszym dostawcą usług w chmurze, aby dowiedzieć się, jaka instancja jest najlepsza dla uruchomienia tego typu zadań. Następnie kwestia optymalizacji kosztów. Chcesz utrzymać koszty na jak najniższym poziomie, ponieważ, jak powiedziałem, sumują się one dość szybko. Przyglądamy się każdemu konkretnemu obciążeniu i pytamy: „Jaki typ instancji jest do tego potrzebny?” Jednocześnie staje się to trudne, ponieważ następnie trzeba zarządzać pulami instancji dla każdego zadania, a następnie upewnić się, że dostępna jest wystarczająca ilość tej puli instancji, aby zadanie faktycznie uruchomione działało w rozsądnym czasie. ramy czasowe. Gdy dojdziesz do wdrożenia, musisz odpowiedzieć na te pytania.

Turaga: Przez lata wypracowaliśmy kilka najlepszych praktyk. Początkowo, gdy nie masz pewności, jakiego typu instancji użyć, wybierasz coś z równowagą między mocą obliczeniową a pamięcią lub ten ogólny typ instancji. Ale patrząc na różne typy obciążeń i weryfikację, potrzebujesz trochę więcej pamięci. Tak samo jest z timingiem. Potrzebujesz jeszcze więcej pamięci. Do analizy CFD mogą być potrzebne procesory graficzne. To część opracowanych przez nas najlepszych praktyk, którymi dzielimy się z klientami.

- Dystrybucja treści i PR oparta na SEO. Uzyskaj wzmocnienie już dziś.

- PlatoData.Network Pionowe generatywne AI. Wzmocnij się. Dostęp tutaj.

- PlatoAiStream. Inteligencja Web3. Wiedza wzmocniona. Dostęp tutaj.

- PlatonESG. Motoryzacja / pojazdy elektryczne, Węgiel Czysta technologia, Energia, Środowisko, Słoneczny, Gospodarowanie odpadami. Dostęp tutaj.

- Platon Zdrowie. Inteligencja w zakresie biotechnologii i badań klinicznych. Dostęp tutaj.

- ChartPrime. Podnieś poziom swojej gry handlowej dzięki ChartPrime. Dostęp tutaj.

- Przesunięcia bloków. Modernizacja własności offsetu środowiskowego. Dostęp tutaj.

- Źródło: https://semiengineering.com/tradeoffs-between-on-premise-and-on-cloud-design/

- :ma

- :Jest

- :nie

- :Gdzie

- $W GÓRĘ

- a

- Zdolny

- O nas

- dostęp

- Osiągać

- działalność

- rzeczywisty

- faktycznie

- adres

- Dodaje

- Korzyść

- Rada

- ponownie

- Algorytmy

- Wszystkie kategorie

- wzdłuż

- już

- również

- AMD

- ilość

- an

- analiza

- i

- Inne

- odpowiedź

- podejście

- SĄ

- obszary

- na około

- AS

- At

- publiczność

- Automatyzacja

- dostępny

- z powrotem

- Back-end

- backup

- Bilans

- na podstawie

- Baseline

- BE

- bo

- być

- zanim

- Początek

- jest

- korzyści

- BEST

- Najlepsze praktyki

- Ulepsz Swój

- pomiędzy

- Duży

- Big Data

- większe

- Bit

- Blokować

- przynieść

- budować

- Buduje

- biznes

- rozwój biznesu

- ale

- kupować

- by

- CAD

- Kadencja

- wezwanie

- CAN

- zdolność

- Pojemność

- który

- walizka

- Etui

- kategorie

- Centrum

- CFD

- wyzwanie

- Zmiany

- tańsze

- żeton

- Dodaj

- klasa

- Klasy

- Chmura

- współpraca

- jak

- wygodny

- przyjście

- Firmy

- sukcesy firma

- obliczać

- Troska

- Obawy

- Konferencja

- systemu

- kontekst

- kontynuować

- ciągły

- kontrola

- Rozmowa

- Koszty:

- Koszty:

- pokrycie

- Craig

- klient

- Klientów

- codziennie

- dane

- Centrum danych

- zarządzanie danymi

- Bazy danych

- dzień

- zdecydować

- decyzja

- Decyzje

- dostarczyć

- Zależność

- W zależności

- zależy

- Wdrożenie

- Wnętrze

- projekty

- rozwinięty

- oprogramowania

- ZROBIŁ

- różne

- trudny

- cyfrowy

- dyskutować

- dyskusja

- do

- robi

- robi

- zrobić

- nie

- na dół

- dynamiczny

- każdy

- Echa

- faktycznie

- wysiłek

- element

- ogarnięcie

- włączanie

- obudowane

- Inżynieria

- ogromny

- dość

- Środowisko

- itp

- Parzyste

- wykonywania

- ekspansja

- drogi

- Czynniki

- FAST

- szybciej

- czuć

- Opłaty

- facet

- Postać

- w porządku

- koniec

- i terminów, a

- Elastyczność

- elastyczne

- lot

- pływ

- Skupiać

- koncentruje

- następujący sposób

- W razie zamówieenia projektu

- od

- z przodu

- frustrujące

- pełny

- w pełni

- Wzrost

- zyskuje

- Ogólne

- Generować

- otrzymać

- Dać

- Go

- cel

- będzie

- dobry

- GPU

- wspaniały

- Wzrost

- miał

- zdarzyć

- Wydarzenie

- dzieje

- sprzęt komputerowy

- Have

- mający

- ciężki

- Trzymany

- pomoc

- Wysoki

- wysoka wydajność

- wyższy

- Haczyki

- W jaki sposób

- HTTPS

- olbrzymi

- i

- pomysł

- if

- podnieść

- in

- indywidualny

- przemysłowa

- Informacja

- Infrastruktura

- początkowy

- początkowo

- wewnątrz

- przykład

- interaktywne

- ciekawy

- najnowszych

- inwestycja

- problemy

- IT

- iteracje

- JEGO

- samo

- Praca

- Oferty pracy

- Johnson

- skok

- właśnie

- Trzymać

- konserwacja

- Klawisz

- kopać

- Kicks

- Uprzejmy

- Wiedzieć

- duży

- w dużej mierze

- większe

- Utajenie

- później

- warstwa

- Dziedzictwo

- mniej

- pomniejszy

- Dźwignia

- Licencja

- Koncesjonowanie

- lubić

- relacja na żywo

- masa

- miejscowy

- log

- długo

- dłużej

- Popatrz

- poszukuje

- WYGLĄD

- Partia

- niski

- niższy

- maszyna

- maszyny

- zrobiony

- Główny

- głównie

- robić

- WYKONUJE

- Dokonywanie

- zarządzanie

- i konserwacjami

- wiele

- masywny

- Może..

- może

- znaczy

- zmierzyć

- mechanizm

- średni

- Pamięć

- Metodologia

- może

- minimalny

- model

- jeszcze

- Motywacja

- ruch

- przeniósł

- przeniesienie

- dużo

- wielokrotność

- my

- koniecznie

- Potrzebować

- potrzebne

- wymagania

- nowsza

- numer

- oaza

- of

- poza

- oferta

- często

- on

- pewnego razu

- ONE

- te

- Optymalny

- Optymalizacja

- zoptymalizowane

- optymalizacji

- or

- organizacja

- Inne

- Pozostałe

- ludzkiej,

- na zewnątrz

- w ciągu nocy

- własny

- własność

- pakiet

- płyta

- Parallel

- część

- szczególny

- wzmacniacz

- strony

- Zapłacić

- Ludzie

- jest gwarancją najlepszej jakości, które mogą dostarczyć Ci Twoje monitory,

- perspektywa

- perspektywy

- PHIL

- fizyczny

- krok po kroku

- plany

- plato

- Analiza danych Platona

- PlatoDane

- Grać

- Volcano Plenty Vaporizer Storz & Bickel

- punkt

- basen

- Baseny

- power

- praktycznie

- praktyki

- Korzystny

- premia

- prezydent

- bardzo

- projektowanie

- dostawca

- Naciskać

- położyć

- pytanie

- pytania

- RAM

- raczej

- naprawdę

- rozsądny

- regresja

- regularny

- zwolnić

- prasowe

- Raporty

- składnica

- Przedstawiciele

- wymagać

- Zasoby

- odpowiedź

- Efekt

- powrót

- Richard

- prawo

- rabować

- ROI

- run

- bieganie

- działa

- Powiedział

- taki sam

- powiedzieć

- Skala

- druga

- bezpieczne

- bezpieczeństwo

- widzieć

- widziany

- wybrany

- wybierając

- Semiconductor

- wysyłanie

- rozsądek

- usługa

- zestaw

- ustawienie

- Share

- przesunięcie

- przesunięty

- powinien

- pokazać

- znaczący

- Prosty

- symulacja

- sytuacja

- mały

- mniejszy

- So

- rozwiązanie

- Rozwiązania

- kilka

- coś

- Źródła

- Typ przestrzeni

- Mówiąc

- Mówi

- specyficzny

- okular

- wydać

- stawka

- początek

- rozpoczęty

- Startups

- pobyt

- Nadal

- bodziec

- przechowywanie

- Strategia

- udany

- pewnie

- stół

- Brać

- zespół

- REGULAMIN

- test

- niż

- że

- Połączenia

- Informacje

- ich

- następnie

- Tam.

- Te

- one

- rzecz

- rzeczy

- myśleć

- Trzeci

- to

- tych

- trzy

- Przez

- wydajność

- czas

- ramy czasowe

- wyczucie czasu

- do

- już dziś

- także

- narzędzie

- narzędzia

- Top

- handel

- próbować

- drugiej

- rodzaj

- typy

- zrozumieć

- Nieoczekiwany

- aż do

- aktualizowanie

- us

- posługiwać się

- używany

- Użytkownik

- Użytkownicy

- za pomocą

- różnorodny

- sprzedawców

- Weryfikacja

- Przeciw

- początku.

- wice

- Wiceprezes

- Zobacz i wysłuchaj

- Wirtualny

- Tom

- chcieć

- poszukiwany

- chce

- była

- Oglądaj

- Droga..

- we

- DOBRZE

- poszedł

- były

- Co

- Co to jest

- jeśli chodzi o komunikację i motywację

- który

- Podczas

- dlaczego

- będzie

- skłonny

- w

- Praca

- workflow

- przepływów pracy

- pracujący

- świat

- by

- lat

- jeszcze

- ty

- Twój

- siebie

- zefirnet