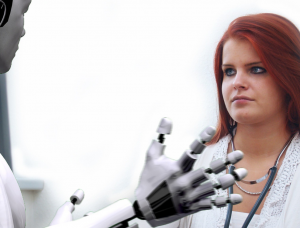

Sztuczna inteligencja (AI) zrewolucjonizowała różne branże, oferując liczne korzyści i możliwości. Pojawiły się jednak obawy dotyczące potencjału sztucznej inteligencji do utrwalania dyskryminacji i uprzedzeń. W tym artykule omówiono temat dyskryminacji AI, rzucając światło na wyzwania związane z identyfikowaniem uprzedzeń wbudowanych w systemy AI i eliminowaniem ich. Znawcy branży wyrażają wątpliwości co do moralnych i etycznych implikacji sztucznej inteligencji, powołując się na obawy związane z dezinformacją, błędami w algorytmach i generowaniem wprowadzających w błąd treści. W miarę nasilania się debat na temat sztucznej inteligencji rośnie zapotrzebowanie na znaczące regulacje zapewniające przejrzystość, rozliczalność i ochronę praw podstawowych.

Wyzwania dla branż finansowych związane ze sztuczną inteligencją

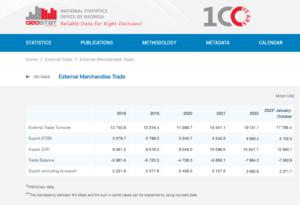

Według Nabila Manjiego, szefa krypto i Web3 w Worldpay by FIS, skuteczność produktów AI zależy w dużym stopniu od jakości materiału źródłowego wykorzystywanego do szkoleń. W wywiadzie dla CNBC Manji wyjaśnił, że na wydajność sztucznej inteligencji wpływają dwa główne czynniki: dane, do których ma ona dostęp, oraz możliwości modelu wielkojęzykowego.

Aby zilustrować znaczenie danych, Manji wspomniał, że firmy takie jak Reddit publicznie ogłosiły ograniczenia dotyczące skrobania danych, wymagające zapłaty za dostęp. W sektorze usług finansowych podkreślił wyzwanie, jakim są fragmentaryczne systemy danych w różnych językach i formatach. Ten brak konsolidacji i harmonizacji ogranicza skuteczność produktów opartych na sztucznej inteligencji, zwłaszcza w porównaniu z branżami posiadającymi standaryzowaną i zmodernizowaną infrastrukturę danych.

Według Manjiego potencjalnym rozwiązaniem tego problemu może być wykorzystanie technologii blockchain lub księgi rozproszonej. To innowacyjne podejście może zapewnić większą przejrzystość fragmentarycznych danych przechowywanych w skomplikowanych systemach tradycyjnych banków. Przyznał jednak, że wysoce uregulowany i powolny charakter banków może utrudniać im szybkie wdrażanie nowych narzędzi sztucznej inteligencji, w przeciwieństwie do bardziej elastycznych firm technologicznych, takich jak Microsoft i Google, które od kilku ostatnich lat przodują we wprowadzaniu innowacji. dziesięciolecia.

Biorąc pod uwagę te czynniki, staje się oczywiste, że branża finansowa stoi przed wyjątkowymi wyzwaniami w zakresie wykorzystania sztucznej inteligencji ze względu na złożoność integracji danych i nieodłączną naturę sektora bankowego.

Według Rummana Chowdhury’ego, byłego szefa ds. etyki uczenia maszynowego, przejrzystości i odpowiedzialności w Twitterze, udzielanie pożyczek jest godnym uwagi przykładem tego, jak stronniczość w systemach sztucznej inteligencji może niekorzystnie wpływać na marginalizowane społeczności. Przemawiając podczas dyskusji panelowej w Amsterdamie, Chowdhury podkreślił historyczną praktykę „redliningu” w Chicago w latach trzydziestych XX wieku. Redlining polegał na odmowie pożyczek dzielnicom zamieszkanym głównie przez Afroamerykanów ze względu na rasę demograficzną.

Chowdhury wyjaśnił, że chociaż nowoczesne algorytmy mogą nie uwzględniać bezpośrednio rasy jako punktu danych, błędy systematyczne można nadal kodować w sposób dorozumiany. Podczas opracowywania algorytmów oceny ryzyka okręgów i osób fizycznych w zakresie udzielania pożyczek dane historyczne zawierające błędy mogą w sposób niezamierzony utrwalić dyskryminację.

Angle Bush, wizjonerka stojąca za Czarnymi kobietami w sztucznej inteligencji, podkreśliła znaczenie uznania niebezpieczeństw związanych z powielaniem uprzedzeń osadzonych w danych historycznych podczas stosowania systemów sztucznej inteligencji do podejmowania decyzji o zatwierdzeniu pożyczki. Taka praktyka może prowadzić do automatycznego odrzucania wniosków o pożyczkę składanych przez społeczności zmarginalizowane, utrwalając w ten sposób nierówności rasowe lub płciowe.

Frost Li, doświadczony programista AI, zwrócił uwagę na wyzwania, jakie niesie ze sobą personalizacja Integracja AI. Wybór „podstawowych funkcji” do szkolenia modeli sztucznej inteligencji może czasami obejmować niepowiązane ze sobą czynniki, które mogą prowadzić do stronniczych wyników. Li podał przykład tego, jak start-upy fintech skierowane do obcokrajowców mogą podlegać innym kryteriom oceny kredytowej w porównaniu z lokalnymi bankami, które są lepiej zaznajomione z lokalnymi szkołami i społecznościami.

Niklas Guske, dyrektor operacyjny Taktile, startupu specjalizującego się w automatyzacji podejmowania decyzji dla fintechów, wyjaśnił, że generatywna sztuczna inteligencja nie jest zazwyczaj wykorzystywana do tworzenia ocen kredytowych ani oceny ryzyka konsumentów. Wręcz przeciwnie, jego siła polega na wstępnym przetwarzaniu nieustrukturyzowanych danych, takich jak pliki tekstowe, w celu poprawy jakości danych w konwencjonalnych modelach underwritingu.

Podsumowując, wykorzystanie sztucznej inteligencji w usługach kredytowych i finansowych budzi obawy związane z uprzedzeniami i dyskryminacją. Historyczne uprzedzenia osadzone w danych i wybór nieistotnych funkcji podczas szkolenia AI mogą prowadzić do nieuczciwych wyników. Dla banków i instytucji finansowych niezwykle ważne jest rozpoznanie tych problemów i zajęcie się nimi, aby zapobiec niezamierzonemu utrwalaniu się dyskryminacji podczas wdrażania rozwiązań AI.

Udowodnij dyskryminację AI

Udowodnienie dyskryminacji ze względu na sztuczną inteligencję może stanowić wyzwanie, jak pokazują przykłady takie jak sprawa Apple i Goldman Sachs. Departament Usług Finansowych stanu Nowy Jork odrzucił zarzuty dotyczące nałożenia niższych limitów na kartę Apple Card dla kobiet, powołując się na brak potwierdzających dowodów.

Kim Smouter, dyrektor Europejskiej Sieci Przeciwko Rasizmowi, wskazuje, że masowe wdrażanie sztucznej inteligencji powoduje nieprzejrzystość procesów decyzyjnych, co utrudnia jednostkom identyfikowanie dyskryminacji i przeciwdziałanie jej.

Smouter wyjaśnia, że jednostki często mają ograniczoną wiedzę na temat działania systemów sztucznej inteligencji, co utrudnia wykrycie przypadków dyskryminacji lub uprzedzeń systemowych. Sprawa staje się jeszcze bardziej złożona, gdy dyskryminacja stanowi część szerszego problemu, który dotyczy wielu osób. Smouter nawiązuje do holenderskiego skandalu dotyczącego opieki nad dziećmi, w którym duża liczba wniosków o świadczenia została błędnie oznaczona jako oszukańcza ze względu na stronniczość instytucjonalną. Wykrycie takich dysfunkcji stanowi wyzwanie, a uzyskanie zadośćuczynienia może być trudne i czasochłonne, co może prowadzić do znacznych, a czasem nieodwracalnych szkód.

Przykłady te ilustrują nieodłączne trudności w uzasadnianiu dyskryminacji ze względu na sztuczną inteligencję i uzyskiwaniu środków zaradczych w przypadku takiej dyskryminacji. Złożoność systemów sztucznej inteligencji i brak przejrzystości w procesach decyzyjnych mogą utrudniać jednostkom skuteczne rozpoznawanie przypadków dyskryminacji i eliminowanie ich.

Według Chowdhury’ego istnieje pilna potrzeba powołania globalnego organu regulacyjnego na wzór Organizacji Narodów Zjednoczonych, który zająłby się zagrożeniami związanymi ze sztuczną inteligencją. Chociaż sztuczna inteligencja wykazała się niezwykłą innowacyjnością, technolodzy i etycy wyrazili obawy dotyczące jej konsekwencji moralnych i etycznych. Obawy te obejmują takie kwestie, jak dezinformacja, uprzedzenia rasowe i płciowe wbudowane w algorytmy sztucznej inteligencji oraz generowanie treści wprowadzających w błąd za pomocą narzędzi takich jak ChatGPT.

Chowdhury wyraża zaniepokojenie wejściem w świat postprawdy, w którym informacje dostępne w Internecie, w tym tekst, wideo i audio, stają się niewiarygodne z powodu generatywnej sztucznej inteligencji. Rodzi to pytania o to, w jaki sposób możemy zapewnić integralność informacji i jak możemy na nich polegać przy podejmowaniu świadomych decyzji. Na przykładzie unijnej ustawy o sztucznej inteligencji istotne uregulowanie sztucznej inteligencji ma obecnie kluczowe znaczenie. Istnieją jednak obawy dotyczące długiego czasu potrzebnego, aby propozycje regulacyjne stały się skuteczne, co może opóźnić niezbędne działania.

Smouter podkreśla potrzebę większej przejrzystości i odpowiedzialności w algorytmach AI. Obejmuje to zwiększanie zrozumiałości algorytmów dla osób niebędących ekspertami, przeprowadzanie testów i publikowanie wyników, ustanawianie niezależnych procesów rozpatrywania skarg, przeprowadzanie okresowych audytów i raportowanie oraz angażowanie społeczności rasowych w projektowanie i wdrażanie technologii. Oczekuje się, że egzekwowanie ustawy o sztucznej inteligencji, która uwzględnia perspektywę praw podstawowych i wprowadza pojęcia takie jak zadośćuczynienie, rozpocznie się za około dwa lata. Skrócenie tego harmonogramu byłoby korzystne ze względu na utrzymanie przejrzystości i odpowiedzialności jako integralnych aspektów innowacji.

- Dystrybucja treści i PR oparta na SEO. Uzyskaj wzmocnienie już dziś.

- PlatoData.Network Pionowe generatywne AI. Wzmocnij się. Dostęp tutaj.

- PlatoAiStream. Inteligencja Web3. Wiedza wzmocniona. Dostęp tutaj.

- PlatonESG. Motoryzacja / pojazdy elektryczne, Węgiel Czysta technologia, Energia, Środowisko, Słoneczny, Gospodarowanie odpadami. Dostęp tutaj.

- Przesunięcia bloków. Modernizacja własności offsetu środowiskowego. Dostęp tutaj.

- Źródło: https://www.forexnewsnow.com/fintech/the-urgency-of-addressing-ai-discrimination-transparency-accountability-and-regulatory-timelines/

- :ma

- :Jest

- :nie

- :Gdzie

- a

- zdolność

- O nas

- dostęp

- odpowiedzialność

- przyznał

- działać

- działania

- adres

- adresowanie

- przyjąć

- korzystny

- niekorzystnie

- oddziaływać

- Czarnoskórzy

- przed

- zwinny

- AI

- Ustawa o sztucznej inteligencji

- Systemy SI

- Trening AI

- Algorytmy

- Zarzuty

- Chociaż

- amerykański

- Amsterdam

- an

- i

- Przewiduje

- Apple

- Karta Apple

- aplikacje

- podejście

- zatwierdzenie

- w przybliżeniu

- SĄ

- artykuł

- sztuczny

- sztuczna inteligencja

- AS

- aspekty

- oszacować

- oszacowanie

- powiązany

- At

- audio

- kontrole

- automatycznie

- automatyzacja

- Bankowość

- sektor bankowy

- Banki

- na podstawie

- BE

- stają się

- staje się

- być

- za

- korzyści

- Korzyści

- stronniczość

- stronniczy

- uprzedzenia

- Czarny

- blockchain

- ciało

- Przynosi

- szerszy

- by

- wezwanie

- CAN

- możliwości

- karta

- walizka

- wyzwanie

- wyzwania

- wyzwanie

- ChatGPT

- Chicago

- dziecko

- roszczenia

- wyjaśnione

- CNBC

- społeczności

- Firmy

- w porównaniu

- skarga

- kompleks

- złożoności

- kompleksowość

- Koncepcje

- Obawy

- prowadzenia

- konsolidacja

- Konsumenci

- zawiera

- zawartość

- przeciwnie

- przyczynić się

- Konwencjonalny

- gruchanie

- Tworzenie

- kredyt

- Kryteria

- istotny

- Crypto

- Niebezpieczeństwa

- dane

- infrastruktura danych

- integracja danych

- jakość danych

- Debaty

- lat

- Podejmowanie decyzji

- Decyzje

- Demografia

- Departament

- zależy

- Wdrożenie

- Wnętrze

- Deweloper

- rozwijanie

- różne

- trudny

- trudności

- Dyrektor

- odkrycie

- dyskryminacja

- dyskusja

- dystrybuowane

- Rozproszona księga

- rozproszona technologia księgi

- jazdy

- z powodu

- podczas

- holenderski

- Efektywne

- faktycznie

- skuteczność

- osadzone

- wyłonił

- podkreśla

- objąć

- egzekwowanie

- wzmacniać

- wzmocnione

- zapewnić

- wprowadzenie

- szczególnie

- ustanowienie

- etyczny

- etyka

- europejski

- Parzyste

- dowód

- oczywisty

- przykład

- przykłady

- doświadczony

- wyjaśnione

- Objaśnia

- odkrywa

- ekspresowy

- Twarz

- twarze

- Czynniki

- znajomy

- Korzyści

- kilka

- Akta

- budżetowy

- branże finansowe

- Instytucje finansowe

- usługi finansowe

- FINTECH

- start-upy fintech

- fintechy

- FIS

- W razie zamówieenia projektu

- czoło

- Dawny

- rozdrobniony

- nieuczciwy

- od

- fundamentalny

- Płeć

- generacja

- generatywny

- generatywna sztuczna inteligencja

- Globalne

- Goldman

- Goldman Sachs

- większy

- Rozwój

- zaszkodzić

- Have

- he

- głowa

- ciężko

- Podświetlony

- wysoko

- historyczny

- W jaki sposób

- Jednak

- HTTPS

- zidentyfikować

- identyfikacja

- wykonawczych

- implikacje

- znaczenie

- imponujący

- in

- zawierać

- obejmuje

- Włącznie z

- niezależny

- osób

- przemysłowa

- przemysł

- Nierówności

- Informacja

- poinformowany

- Infrastruktura

- nieodłączny

- Innowacja

- Innowacyjny

- instytucjonalny

- instytucje

- integralny

- integracja

- integralność

- Inteligencja

- Wywiad

- najnowszych

- Przedstawia

- angażować

- zaangażowany

- z udziałem

- problem

- problemy

- IT

- JEGO

- wiedza

- Brak

- język

- Języki

- duży

- prowadzić

- prowadzący

- nauka

- Księga główna

- pożyczanie

- lewarowanie

- li

- leży

- lekki

- lubić

- Ograniczony

- Limity

- pożyczka

- Kredyty

- miejscowy

- BANKÓW LOKALNYCH

- niższy

- maszyna

- uczenie maszynowe

- Główny

- robić

- Dokonywanie

- Masa

- materiał

- Może..

- wymowny

- wzmiankowany

- Microsoft

- może

- Mylna informacja

- zwodniczy

- model

- modele

- Nowoczesne technologie

- moment

- morał

- jeszcze

- wielokrotność

- Narodów

- Natura

- niezbędny

- Potrzebować

- sieć

- Nowości

- I Love New York

- Stan Nowy Jork

- Departament Usług Finansowych stanu Nowy Jork

- nie-eksperci

- dostojnik

- numer

- liczny

- liczne korzyści

- uzyskiwanie

- of

- oferta

- oferuje

- często

- on

- Online

- działać

- Szanse

- or

- na zewnątrz

- wyniki

- płyta

- panel dyskusyjny

- część

- Przeszłość

- płatność

- jest gwarancją najlepszej jakości, które mogą dostarczyć Ci Twoje monitory,

- periodycznie

- personalizacja

- perspektywa

- plato

- Analiza danych Platona

- PlatoDane

- punkt

- zwrotnica

- potencjał

- potencjalnie

- praktyka

- przeważnie

- pilny

- zapobiec

- Problem

- procesów

- Produkty

- Propozycje

- ochrona

- zapewniać

- pod warunkiem,

- publicznie

- Wydawniczy

- cele

- jakość

- pytania

- Wyścig

- rasizm

- podnosi

- rozpoznać

- redukcja

- referencje

- w sprawie

- regulowane

- Regulacja

- regulacyjne

- polegać

- znakomity

- Raportowanie

- Ograniczenia

- Efekt

- zrewolucjonizował

- prawa

- Ryzyko

- ryzyko

- Sachs

- Skandal

- Szkoły

- wyniki

- punktacji

- skrobanie

- sektor

- wybierając

- wybór

- Usługi

- pokazane

- znaczenie

- znaczący

- podobny

- rozwiązanie

- Rozwiązania

- Źródło

- Mówiąc

- specjalizujący się

- startup

- Startups

- Stan

- Departament stanu

- Nadal

- przechowywany

- jest determinacja.

- taki

- PODSUMOWANIE

- otaczający

- szybko

- systemowy

- systemy

- sprzęt

- trwa

- kierowania

- tech

- tech

- technolodzy

- Technologia

- Testy

- że

- Połączenia

- Źródło

- ich

- Tam.

- a tym samym

- Te

- to

- czasochłonne

- Oś czasu

- terminy

- do

- narzędzia

- aktualny

- Trening

- Przezroczystość

- i twitterze

- drugiej

- zazwyczaj

- zrozumiały

- gwarantowanie

- niesprawiedliwy

- wyjątkowy

- Zjednoczony

- Narody Zjednoczone

- w odróżnieniu

- Utrzymuj

- pilna sprawa

- posługiwać się

- używany

- różnorodny

- Wideo

- wizjoner

- we

- Web3

- Dobrobyt

- były

- jeśli chodzi o komunikację i motywację

- który

- Podczas

- w

- w ciągu

- Kobieta

- świat

- WorldPay

- martwić się

- by

- lat

- york

- zefirnet