Wszyscy chcemy, aby nasze idealne wartości ludzkie znalazły odzwierciedlenie w naszych technologiach. Oczekujemy, że technologie takie jak sztuczna inteligencja (AI) nie będą nas okłamywać, nie dyskryminują i będą bezpieczne w użytkowaniu dla nas i naszych dzieci. Jednak wielu twórców sztucznej inteligencji spotyka się obecnie z ostrym sprzeciwem w związku z uprzedzeniami, niedokładnościami i problematycznymi praktykami dotyczącymi danych ujawnianymi w ich modelach. Kwestie te wymagają czegoś więcej niż rozwiązania technicznego, algorytmicznego lub opartego na sztucznej inteligencji. W rzeczywistości wymagane jest całościowe podejście socjotechniczne.

Matematyka pokazuje potężną prawdę

Wszystkie modele predykcyjne, w tym sztuczna inteligencja, są dokładniejsze, gdy uwzględniają różnorodną ludzką inteligencję i doświadczenie. To nie jest opinia; ma ona ważność empiryczną. Weź pod uwagę twierdzenie o przewidywaniu różnorodności. Mówiąc najprościej, gdy różnorodność w grupie jest duża, błąd tłumu jest niewielki, co potwierdza koncepcję „mądrości tłumu”. W wpływowym badaniu wykazano, że zróżnicowane grupy osób rozwiązujących problemy o niskich umiejętnościach mogą osiągać lepsze wyniki niż grupy osób rozwiązujących problemy o wysokich zdolnościach (Honga i Page’a, 2004).

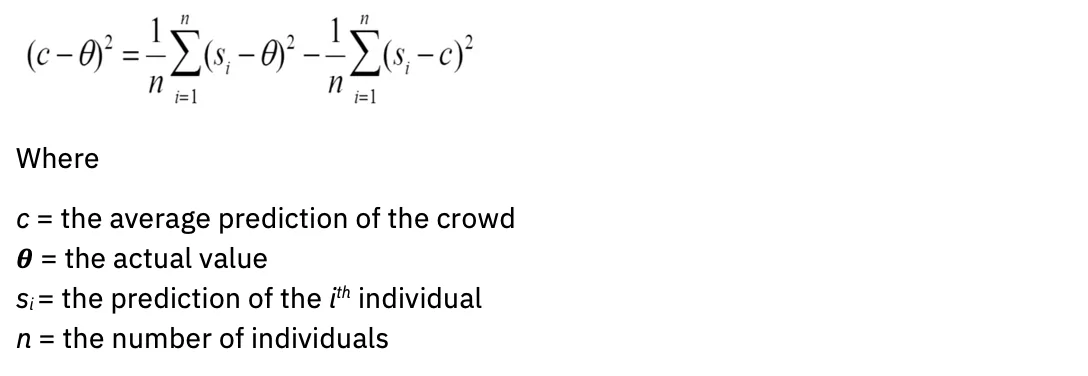

W języku matematycznym: im szersza jest wariancja, tym bardziej standardowa jest średnia. Równanie wygląda tak:

A Dalsze badanie dostarczył więcej obliczeń, które udoskonaliły statystyczne definicje mądrego tłumu, w tym nieznajomość przewidywań innych członków i włączenie osób z maksymalnie różne (ujemnie skorelowane) przewidywania lub osądy. Zatem nie tylko wielkość, ale i różnorodność poprawiają przewidywania. Jak ta wiedza może wpłynąć na ocenę modeli AI?

(Nie)dokładność modelu

Cytując popularny aforyzm, wszystkie modele są błędne. Dotyczy to obszarów statystyki, nauki i sztucznej inteligencji. Modele utworzone przy braku wiedzy dziedzinowej mogą prowadzić do: błędny wyjścia.

Obecnie niewielka, jednorodna grupa ludzi określa, jakie dane wykorzystać do szkolenia generatywnych modeli sztucznej inteligencji, które są pobierane ze źródeł, które w znacznym stopniu nadreprezentują język angielski. „W przypadku większości z ponad 6,000 języków na świecie dostępne dane tekstowe nie wystarczą do wytrenowania podstawowego modelu na dużą skalę” (z „O szansach i zagrożeniach modeli podstawowych”, Bommasani i in., 2022).

Ponadto same modele są tworzone na podstawie ograniczonych architektur: „Prawie wszystkie najnowocześniejsze modele NLP są obecnie adaptowane z jednego z kilku podstawowych modeli, takich jak BERT, RoBERTa, BART, T5 itp. Chociaż ta homogenizacja prowadzi do niezwykle wysoka dźwignia (wszelkie ulepszenia podstawowych modeli mogą prowadzić do natychmiastowych korzyści w całym NLP), jest to również zobowiązanie; wszystkie systemy sztucznej inteligencji mogą odziedziczyć te same problematyczne błędy kilku podstawowych modeli (Bommasani i in.) "

Aby generatywna sztuczna inteligencja lepiej odzwierciedlała różnorodne społeczności, którym służy, w modelach należy przedstawić znacznie szerszą gamę danych dotyczących ludzi.

Ocena dokładności modelu idzie w parze z oceną błędu systematycznego. Musimy zadać sobie pytanie, jaka jest intencja modelu i dla kogo jest on zoptymalizowany? Zastanów się na przykład, kto czerpie najwięcej korzyści z algorytmów rekomendacji treści i algorytmów wyszukiwarek. Interesariusze mogą mieć bardzo różne interesy i cele. Algorytmy i modele wymagają wartości docelowych lub zastępczych dla błędu Bayesa: minimalnego błędu, który model musi poprawić. Tym pełnomocnikiem jest często osoba, na przykład ekspert merytoryczny posiadający wiedzę specjalistyczną w danej dziedzinie.

Bardzo ludzkie wyzwanie: ocena ryzyka przed zakupem lub opracowaniem modelu

Pojawiające się regulacje i plany działania dotyczące sztucznej inteligencji w coraz większym stopniu podkreślają znaczenie algorytmicznych formularzy oceny wpływu. Celem tych formularzy jest przechwycenie kluczowych informacji na temat modeli sztucznej inteligencji, aby zespoły zarządzające mogły ocenić i zaradzić ryzyku przed ich wdrożeniem. Typowe pytania obejmują:

- Jaki jest przypadek użycia Twojego modelu?

- Jakie ryzyko wiąże się z odmiennym wpływem?

- Jak oceniasz uczciwość?

- Jak wyjaśniasz swój model?

Choć projektowano je z dobrymi intencjami, problem polega na tym, że większość właścicieli modeli sztucznej inteligencji nie rozumie, jak ocenić ryzyko w przypadku ich użycia. Częstym refrenem może być: „Jak mój model może być nieuczciwy, jeśli nie gromadzi danych osobowych (PII)?” W rezultacie formularze rzadko są wypełniane z należytą starannością niezbędną, aby systemy zarządzania mogły dokładnie oznaczać czynniki ryzyka.

Tym samym podkreślony zostaje społeczno-techniczny charakter rozwiązania. Właściciel modelu – osoba fizyczna – nie może po prostu otrzymać listy pól wyboru umożliwiających ocenę, czy jego przypadek użycia spowoduje szkodę. Zamiast tego potrzebne są grupy ludzi o bardzo zróżnicowanych doświadczeniach w świecie, które spotykają się w społecznościach zapewniających bezpieczeństwo psychologiczne, aby móc prowadzić trudne rozmowy na temat odmiennych skutków.

Z zadowoleniem przyjmujemy szersze perspektywy dla godnej zaufania sztucznej inteligencji

IBM® wierzy w podejście „klienta zero” poprzez wdrażanie rekomendacji i systemów, które stworzyłby dla swoich klientów w ramach rozwiązań konsultingowych i opartych na produktach. Podejście to rozciąga się na praktyki etyczne, dlatego IBM stworzył Godne Zaufania Centrum Doskonałości AI (COE).

Jak wyjaśniono powyżej, różnorodność doświadczeń i zestawów umiejętności ma kluczowe znaczenie dla właściwej oceny wpływu sztucznej inteligencji. Jednak perspektywa udziału w Centrum Doskonałości może być onieśmielająca w firmie pełnej innowatorów, ekspertów i wybitnych inżynierów w dziedzinie sztucznej inteligencji, dlatego potrzebne jest kultywowanie społeczności zapewniającej bezpieczeństwo psychiczne. IBM komunikuje to jasno, mówiąc: „Interesujesz się sztuczną inteligencją? Interesujesz się etyką AI? Masz miejsce przy tym stole.

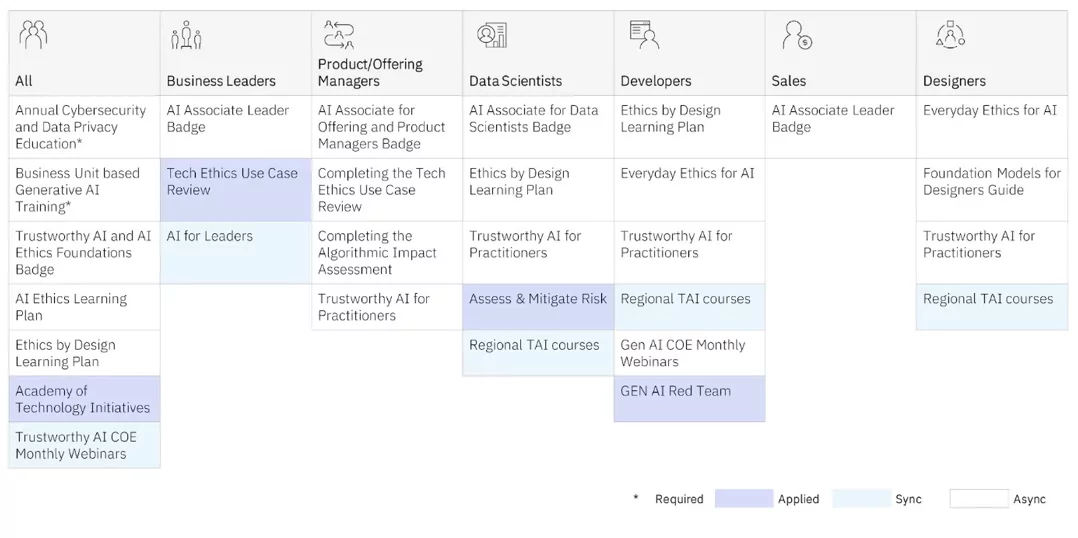

COE oferuje szkolenia w zakresie etyki sztucznej inteligencji praktykom na każdym poziomie. Oferowane są zarówno programy do nauki synchronicznej (nauczyciel i uczniowie w klasie), jak i asynchronicznej (samodzielne nauczanie).

Ale to COE stosowany szkolenia, które zapewniają naszym praktykom najgłębszy wgląd w pracę z globalnymi, zróżnicowanymi, multidyscyplinarnymi zespołami nad prawdziwymi projektami, aby lepiej zrozumieć odmienny wpływ. Wykorzystują także ramy myślenia projektowego opracowane przez IBM Projekt dla sztucznej inteligencji grupa wykorzystuje wewnętrznie i wspólnie z klientami do oceny niezamierzonych skutków modeli sztucznej inteligencji, mając na uwadze osoby często marginalizowane. (Zobacz artykuł Sylvii Duckworth Koło Władzy i Przywilejów aby zapoznać się z przykładami krzyżowania się cech osobistych, co uprzywilejowuje lub marginalizuje ludzi). IBM przekazał także wiele frameworków społeczności open source Projektuj etycznie.

Poniżej znajduje się kilka raportów opublikowanych publicznie przez IBM na temat tych projektów:

Aby uzyskać ważne informacje na temat działania modelu AI, wymagane są zautomatyzowane narzędzia do zarządzania modelem AI. Należy jednak pamiętać, że optymalne jest wykrycie ryzyka na długo przed opracowaniem modelu i wejściem go do produkcji. Tworząc społeczności różnorodnych, multidyscyplinarnych praktyków, które oferują bezpieczną przestrzeń dla ludzi do prowadzenia trudnych rozmów na temat odmiennego wpływu, możesz rozpocząć podróż w kierunku operacjonalizacji swoich zasad i odpowiedzialnego rozwoju sztucznej inteligencji.

W praktyce, zatrudniając specjalistów zajmujących się sztuczną inteligencją, należy pamiętać, że znacznie ponad 70% wysiłku związanego z tworzeniem modeli polega na selekcji właściwych danych. Chcesz zatrudnić osoby, które wiedzą, jak zbierać dane, które są reprezentatywne, ale jednocześnie zbierane za zgodą. Chcesz także, aby ludzie, którzy wiedzą, jak blisko współpracować z ekspertami w danej dziedzinie, mieli pewność, że mają właściwe podejście. Kluczowe znaczenie ma zapewnienie tym praktykom inteligencji emocjonalnej umożliwiającej podjęcie wyzwania odpowiedzialnego zarządzania sztuczną inteligencją z pokorą i rozeznaniem. Musimy świadomie uczyć się, jak i kiedy systemy sztucznej inteligencji mogą pogłębiać nierówności w takim samym stopniu, w jakim mogą zwiększać ludzką inteligencję.

Odkryj na nowo sposób działania swojej firmy dzięki sztucznej inteligencji

Czy ten artykuł był pomocny?

TakNie

Więcej z Sztuczna inteligencja

Biuletyny IBM

Otrzymuj nasze biuletyny i aktualizacje tematów, które dostarczają najnowszych informacji i spostrzeżeń na temat pojawiających się trendów.

Subskrybuj teraz

Więcej biuletynów

- Dystrybucja treści i PR oparta na SEO. Uzyskaj wzmocnienie już dziś.

- PlatoData.Network Pionowe generatywne AI. Wzmocnij się. Dostęp tutaj.

- PlatoAiStream. Inteligencja Web3. Wiedza wzmocniona. Dostęp tutaj.

- PlatonESG. Węgiel Czysta technologia, Energia, Środowisko, Słoneczny, Gospodarowanie odpadami. Dostęp tutaj.

- Platon Zdrowie. Inteligencja w zakresie biotechnologii i badań klinicznych. Dostęp tutaj.

- Źródło: https://www.ibm.com/blog/why-we-need-diverse-multidisciplinary-coes-for-model-risk/

- :ma

- :Jest

- :nie

- :Gdzie

- $W GÓRĘ

- 000

- 1

- 16

- 2022

- 2024

- 23

- 25

- 28

- 29

- 30

- 300

- 32

- 39

- 40

- 400

- 65

- 7

- 9

- a

- zdolność

- O nas

- powyżej

- AC

- przyśpieszyć

- precyzja

- dokładny

- dokładnie

- w poprzek

- Działania

- przystosowany

- adres

- przyznać

- przyjąć

- Reklama

- Rada

- oddziaływać

- agentów

- AI

- Modele AI

- Systemy SI

- zmierzać

- AL

- algorytmiczny

- Algorytmy

- Wszystkie kategorie

- również

- zawsze

- amp

- an

- analityka

- i

- każdy

- Zastosowanie

- aplikacje

- podejście

- SĄ

- obszary

- artykuł

- sztuczny

- sztuczna inteligencja

- Sztuczna inteligencja (AI)

- AS

- zapytać

- oszacować

- oceniając

- oszacowanie

- asystenci

- pomoc

- At

- audio

- zwiększać

- autor

- dostępny

- uniknąć

- z powrotem

- równoważenie

- BE

- być

- zanim

- rozpocząć

- jest

- uważa,

- Korzyści

- Ulepsz Swój

- Poza

- stronniczość

- uprzedzenia

- Blog

- blogi

- Niebieski

- boston

- obie

- szerszy

- Budowanie

- biznes

- Funkcje biznesowe

- biznes

- ale

- przycisk

- by

- CAN

- zdobyć

- Przechwytywanie

- węgiel

- karta

- Kartki okolicznosciowe

- który

- walizka

- CAT

- Kategoria

- Spowodować

- Centrum

- Centrum Doskonałości

- centralny

- pewien

- wyzwanie

- Charakterystyka

- nasze chatboty

- ZOBACZ

- dziecko

- Dzieci

- koła

- CIS

- klasa

- wyraźnie

- klientów

- dokładnie

- Chmura

- kolor

- połączenie

- przyjście

- wspólny

- społeczności

- społeczność

- Firmy

- sukcesy firma

- Zakończony

- pojęcie

- zgoda

- w konsekwencji

- Rozważać

- consulting

- Pojemnik

- kontynuować

- rozmowy

- rdzeń

- skorygowania

- współzależny

- Koszty:

- mógłby

- stworzony

- Tworzenie

- twórcy

- krytyczny

- tłum

- CSS

- kurator

- Obecnie

- zwyczaj

- klient

- doświadczenie klienta

- Klientów

- dane

- Data

- Decyzje

- najgłębszy

- Domyślnie

- definicje

- dostarczyć

- demonstruje

- wdrażanie

- opis

- Wnętrze

- Myślenie projektowe

- zaprojektowany

- Ustalać

- rozwijać

- rozwinięty

- różne

- trudny

- cyfrowy

- cyfrowy Transformacja

- różny

- Wybitny

- inny

- Różnorodność

- do

- domena

- wygrałem

- sporządzony

- napęd

- E i T

- ruchomości

- wysiłek

- eliminując

- osadzanie

- objąć

- wschodzących

- pracowników

- umożliwiać

- ujmujący

- silnik

- Inżynierowie

- Angielski

- dość

- zapewnienie

- Wchodzę

- błąd

- itp

- Eter (ETH)

- etyczny

- etyka

- oceniać

- oceny

- ewaluację

- Parzyste

- Każdy

- wszędzie

- zaostrzyć

- przykład

- przykłady

- Doskonałość

- Wyjście

- oczekiwać

- doświadczenie

- Doświadczenia

- ekspert

- ekspertyza

- eksperci

- wyjaśnione

- narażony

- rozciąga się

- niezwykle

- facebook messenger

- ułatwiać

- okładzina

- Czynniki

- uczciwość

- fałszywy

- daleko

- FAST

- kilka

- Znajdź

- Skupiać

- obserwuj

- następujący

- czcionki

- W razie zamówieenia projektu

- czoło

- formularze

- Fundacja

- Ramy

- od

- z przodu

- Funkcje

- zbierać

- zebrane

- zebranie

- generatywny

- generatywna sztuczna inteligencja

- generator

- otrzymać

- dany

- daje

- Globalne

- cel

- Gole

- Goes

- dobry

- zarządzanie

- Gramatyka

- bardzo

- Krata

- Zarządzanie

- Grupy

- Wzrost

- poprowadzi

- zaszkodzić

- Have

- Nagłówek

- słyszeć

- wysokość

- pomoc

- pomocny

- Wysoki

- go

- zatrudnić

- Wynajmowanie

- jego

- posiada

- holistyczne

- Strona główna

- W jaki sposób

- How To

- HTTPS

- człowiek

- ludzka inteligencja

- pokora

- Hybrydowy

- Chmura hybrydowa

- i

- CHORY

- IBM

- ICO

- ICON

- idealny

- zidentyfikowane

- if

- Niewiedza

- obraz

- Natychmiastowy

- Rezultat

- Oddziaływania

- wdrożenia

- wykonawczych

- znaczenie

- ważny

- podnieść

- ulepszenia

- poprawia

- in

- zawierać

- Włącznie z

- włączenie

- włączać

- coraz bardziej

- przyrostowe

- wskaźnik

- przemysł

- Wpływowy

- Informacja

- Innowacja

- innowatorzy

- wkład

- wgląd

- spostrzeżenia

- natychmiast

- zamiast

- Instytut

- ubezpieczenie

- Ubezpieczyciele

- Inteligencja

- Inteligentny

- zamiar

- Zamierzony

- intencje

- zainteresowany

- zainteresowania

- wewnętrznie

- krzyżować

- interwencja

- zastraszające

- wewnętrzny

- ISN

- problem

- problemy

- IT

- JEGO

- styczeń

- przystąpić

- Dołącz do nas

- podróż

- jpg

- właśnie

- konserwacja

- Klawisz

- Wiedzieć

- znany

- Brak

- język

- Języki

- duży

- na dużą skalę

- firmy

- prowadzić

- lider

- Przywództwo

- nauka

- niech

- poziom

- Dźwignia

- odpowiedzialność

- kłamstwo

- lubić

- Ograniczony

- Lista

- miejscowy

- lokalny

- WYGLĄD

- robić

- Dokonywanie

- i konserwacjami

- podręcznik

- wiele

- matematyka

- matematyczny

- Materia

- Maksymalna szerokość

- Może..

- me

- oznaczać

- Poznaj nasz

- Messenger

- może

- min

- nic

- minimum

- minuty

- Aplikacje mobilne

- model

- modele

- modernizacja

- jeszcze

- większość

- ruch

- dużo

- multidyscyplinarny

- musi

- my

- Natura

- Nawigacja

- niezbędny

- Potrzebować

- potrzebne

- wymagania

- ujemnie

- Nowości

- Nowe produkty

- Newsletter

- nlp

- Nie

- noty

- nic

- już dziś

- liczny

- of

- poza

- oferta

- oferowany

- Oferty

- często

- on

- ONE

- open source

- Opinia

- Szanse

- Optymalny

- zoptymalizowane

- or

- organizacji

- Inne

- ludzkiej,

- Przewyższają

- Wyjścia

- koniec

- własny

- właściciele

- strona

- uczestnictwo

- przechodzić

- Ludzie

- wykonywania

- osoba

- osobisty

- Osobiście

- perspektywy

- PHP

- pii

- plany

- plato

- Analiza danych Platona

- PlatoDane

- wtyczka

- polityka

- position

- Post

- potencjał

- potencjalni klienci

- power

- mocny

- praktyka

- praktyki

- przepowiednia

- Przewidywania

- proroczy

- pierwotny

- Zasady

- Priorytet

- przywilej

- Problem

- Zamówień

- produkuje

- Produkcja

- wydajność

- Produkty

- Programy

- projektowanie

- prawidłowo

- Perspektywa

- pod warunkiem,

- że

- proksies

- pełnomocnik

- psychologiczny

- publicznie

- opublikowany

- położyć

- pytania

- szybko

- zacytować

- rzadko

- Gotowość

- Czytający

- real

- Rzeczywistość

- rozpoznać

- zalecenia

- redukcja

- oczyścić

- odzwierciedlić

- odzwierciedlenie

- regulamin

- Raporty

- przedstawiciel

- reprezentowane

- wywołań

- wymagać

- wymagany

- Badania naukowe

- odpowiadanie

- odpowiedzialny

- odpowiedzialnie

- czuły

- dochód

- wzrost przychodu

- prawo

- Ryzyko

- czynniki ryzyka

- ryzyko

- droga

- roboty

- "bezpiecznym"

- Bezpieczeństwo

- Powiedział

- taki sam

- powiedzenie

- Skala

- skalowaniem

- nauka

- Ekran

- skrypty

- Szukaj

- Wyszukiwarka

- bezpieczne

- widzieć

- seo

- służy

- w panelu ustawień

- powinien

- pokazane

- po prostu

- witryna internetowa

- luźny

- mały

- mądry

- Inteligentne głośniki

- SMS

- So

- rozwiązanie

- Rozwiązania

- kilka

- Źródła

- Typ przestrzeni

- Głośniki

- Łącza

- kwadraty

- interesariusze

- standard

- początek

- state-of-the-art

- statystyczny

- statystyka

- Studenci

- Badanie

- przedmiot

- subskrybuj

- taki

- wsparcie

- Wspierający

- SVG

- systemy

- T

- stół

- biorąc

- cele

- nauczyciel

- Zespoły

- Techniczny

- Technologies

- trzeciorzędowy

- XNUMX

- niż

- dzięki

- że

- Połączenia

- świat

- ich

- Im

- motyw

- sami

- Te

- one

- myśleć

- Myślący

- to

- tych

- myśl

- myśl przywództwo

- trzy

- Przez

- czas

- Tytuł

- do

- razem

- narzędzia

- Top

- aktualny

- trudny

- Pociąg

- Trening

- Transformacja

- Trendy

- prawdziwy

- godny zaufania

- i twitterze

- drugiej

- rodzaj

- typowy

- zrozumieć

- niesprawiedliwy

- wyjątkowy

- odblokowywanie

- Nowości

- na

- URL

- us

- posługiwać się

- przypadek użycia

- zastosowania

- Wykorzystując

- wartość

- Wartości

- różnorodność

- zmienne

- początku.

- Wirtualny

- Tom

- W

- chcieć

- była

- we

- DOBRZE

- Co

- Co to jest

- jeśli chodzi o komunikację i motywację

- czy

- który

- Podczas

- KIM

- kogo

- dlaczego

- szeroko

- szerszy

- będzie

- mądrość

- MĄDRY

- w

- słowo

- WordPress

- Praca

- działa

- świat

- by

- napisany

- Źle

- jeszcze

- ty

- Twój

- zefirnet