Firma Synopsys była niedawno gospodarzem międzybranżowego panelu na temat stanu systemów wieloprocesorowych, który wydał mi się interesujący, między innymi ze względu na jego znaczenie dla szybkiego przyspieszania sprzętu zorientowanego na sztuczną inteligencję. Więcej na ten temat poniżej. Panelistami, wszyscy pełniący znaczące role w systemach z wieloma matrycami, byli: Shekhar Kapoor (starszy dyrektor ds. zarządzania produktami, Synopsys), Cheolmin Park (wiceprezes korporacyjny, Samsung), Lalitha Immaneni (wiceprezes ds. architektury, projektowania i rozwiązań technologicznych, Intel), Michael Schaffert (starszy wiceprezes, Bosch) i Murat Becer (wiceprezes ds. badań i rozwoju, Ansys). Panel był moderowany przez Marco Chiappetta (współzałożyciel i główny analityk, HotTech Vision and Analysis).

Czynnik dużego popytu

Powszechnie w tym nagłówku wymienia się wszystkich typowych podejrzanych (HPC, motoryzacja itp.), ale na tej liście nie sprawdza się prawdopodobnie najważniejszy czynnik leżący u podstaw – obecna walka o dominację we wszystkim, co dotyczy LLM i generatywnej sztucznej inteligencji. Duże modele językowe oferują nowy poziom usług SaaS w zakresie wyszukiwania, tworzenia dokumentów i innych możliwości, zapewniając znaczną przewagę konkurencyjną temu, kto zrobi to dobrze jako pierwszy. Na urządzeniach mobilnych i w samochodzie doskonałe sterowanie i informacje zwrotne oparte na języku naturalnym sprawią, że istniejące opcje głosowe będą w porównaniu z nimi wyglądać prymitywnie. Tymczasem generatywne metody tworzenia nowych obrazów przy użyciu modeli przepływu dyfuzyjnego i Poissona mogą wygenerować spektakularne grafiki oparte na tekście lub fotografii uzupełnionej bibliotekami obrazów. Biorąc pod uwagę zainteresowanie konsumentów, może to okazać się kolejną ważną rzeczą w przyszłych wersjach telefonów.

Choć sztuczna inteligencja oparta na transformatorach stwarza ogromne możliwości, wiąże się z wyzwaniami. Technologie, które umożliwiają stosowanie takich metod, sprawdziły się już w chmurze i pojawiają się na jej krawędziach, choć słyną z dużego zapotrzebowania na pamięć. Produkcja LLM obsługuje od miliardów do bilionów parametrów, które muszą zostać załadowane do transformatora. Zapotrzebowanie na przestrzeń roboczą w trakcie procesu jest równie wysokie; Obrazowanie oparte na dyfuzji stopniowo dodaje szum do pełnego obrazu, a następnie powraca do zmodyfikowanego obrazu, ponownie za pośrednictwem platform opartych na transformatorach.

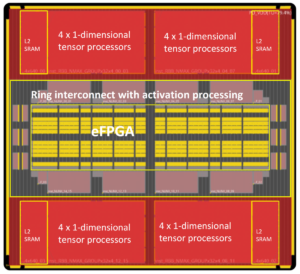

Oprócz początkowego obciążenia żaden z tych procesów nie może sobie pozwolić na obciążenie związane z interakcją z zewnętrzną pamięcią DRAM. Opóźnienia byłyby niedopuszczalne, a zapotrzebowanie na energię spowodowałoby wyczerpanie baterii telefonu lub nadwyrężenie budżetu centrum danych. Cała pamięć musi znajdować się blisko – bardzo blisko – komputera. Jednym z rozwiązań jest umieszczenie pamięci SRAM na wierzchu akceleratora (co AMD, a teraz Intel zademonstrowało w swoich chipach serwerowych). Wbudowana pamięć o dużej przepustowości dodaje kolejną nieco wolniejszą opcję, ale wciąż nie tak powolną jak pamięć DRAM poza chipem.

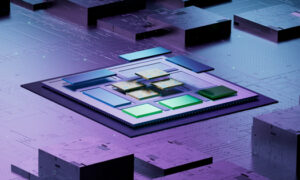

Wszystko to wymaga systemów z wieloma matrycami. Na jakim etapie jesteśmy w przygotowaniu tej opcji do produkcji?

Widoki na to, gdzie jesteśmy

Słyszałem wiele entuzjazmu dla rozwoju w tej dziedzinie, w zakresie adopcji, aplikacji i narzędzi. Intel, AMD, Qualcomm i Samsung są wyraźnie bardzo aktywne w tej przestrzeni. Wiadomo, że Apple M2 Ultra to konstrukcja z dwoma matrycami, a AWS Graviton 3 z systemem z wieloma matrycami. Jestem pewien, że istnieje wiele innych przykładów wśród dużych systemów i domów półprzewodnikowych. Odnoszę wrażenie, że matryce nadal są pozyskiwane głównie wewnętrznie (być może z wyjątkiem stosów HBM) i montowane w technologiach pakowania odlewniczego firm TSMC, Samsung czy Intel. Jednak firma Tenstorrent właśnie ogłosiła, że wybrała firmę Samsung do produkcji projektu sztucznej inteligencji nowej generacji w postaci chipletu (płytki nadającej się do stosowania w systemie z wieloma matrycami), więc ta przestrzeń już zmierza w kierunku szerszego pozyskiwania matryc.

Wszyscy paneliści byli oczywiście entuzjastycznie nastawieni do ogólnego kierunku, a technologie i narzędzia wyraźnie ewoluują szybko, co stanowi przyczynę szumu. Lalitha uzasadniła ten entuzjazm zauważając, że sposób, w jaki obecnie projektowane i projektowane są systemy z wieloma matrycami, jest wciąż w powijakach i nie jest jeszcze gotowy do uruchomienia szerokiego rynku matryc wielokrotnego użytku. To mnie nie dziwi. Wydaje się, że technologia o tej złożoności powinna najpierw dojrzewać w ramach ścisłego partnerstwa pomiędzy projektantami systemów, odlewniami i firmami EDA, być może przez kilka lat, zanim będzie mogła zostać udostępniona szerszemu gronu odbiorców.

Jestem pewien, że odlewnie, producenci systemów i firmy EDA nie pokazują wszystkich swoich kart i mogą być dalej niż chcą się reklamować. Nie mogę się doczekać, aby usłyszeć więcej. Można obejrzeć dyskusję panelową TUTAJ.

Udostępnij ten post przez:

- Dystrybucja treści i PR oparta na SEO. Uzyskaj wzmocnienie już dziś.

- PlatoData.Network Pionowe generatywne AI. Wzmocnij się. Dostęp tutaj.

- PlatoAiStream. Inteligencja Web3. Wiedza wzmocniona. Dostęp tutaj.

- PlatonESG. Węgiel Czysta technologia, Energia, Środowisko, Słoneczny, Gospodarowanie odpadami. Dostęp tutaj.

- Platon Zdrowie. Inteligencja w zakresie biotechnologii i badań klinicznych. Dostęp tutaj.

- Źródło: https://semiwiki.com/artificial-intelligence/336319-synopsys-panel-updates-on-the-state-of-multi-die-systems/

- :Jest

- :nie

- :Gdzie

- 180

- 300

- a

- O nas

- przyśpieszenie

- akcelerator

- Konta

- aktywny

- Dodaje

- Przyjęcie

- Zalety

- Reklamować

- ponownie

- AI

- Wszystkie kategorie

- wzdłuż

- już

- am

- AMD

- wśród

- an

- analiza

- analityk

- i

- ogłosił

- Inne

- nigdzie

- Apple

- aplikacje

- architektura

- SĄ

- AS

- zmontowane

- At

- publiczność

- motoryzacyjny

- AWS

- z powrotem

- przepustowość

- bateria

- BE

- zanim

- jest

- poniżej

- pomiędzy

- Duży

- Najwyższa

- miliardy

- wiać

- Bosch

- szerszy

- budżet

- budowniczowie

- ale

- by

- CAN

- możliwości

- wózek

- Kartki okolicznosciowe

- wyzwania

- Frytki

- Dodaj

- wybrany

- wyraźnie

- Chmura

- Współzałożyciel

- byliśmy spójni, od początku

- wspólny

- Firmy

- porównanie

- konkurencyjny

- kompleksowość

- obliczać

- konsument

- kontrola

- Korporacyjny

- mógłby

- Tworzenie

- tworzenie

- Aktualny

- Obecnie

- Datacenter

- Kreowanie

- wykazać

- Wnętrze

- zaprojektowany

- projektanci

- urządzenia

- Umierać

- Transmitowanie

- kierunek

- Dyrektor

- dyskusja

- dokument

- Nie

- domena

- Przewaga

- drenaż

- rysować

- rysunek

- krawędź

- wschodzących

- entuzjazm

- entuzjastyczny

- Równie

- itp

- wszystko

- ewoluuje

- przykłady

- Z wyjątkiem

- Przede wszystkim system został opracowany

- rozciągać się

- rozległy

- zewnętrzny

- czynnik

- znakomicie

- FAST

- informacja zwrotna

- i terminów, a

- pływ

- W razie zamówieenia projektu

- Naprzód

- znaleziono

- Odlewnia

- od

- pełny

- dalej

- przyszłość

- Ogólne

- generacja

- generatywny

- generatywna sztuczna inteligencja

- otrzymać

- grafika

- Wzrost

- sprzęt komputerowy

- Have

- Nagłówek

- wysłuchany

- przesłuchanie

- Wysoki

- hostowane

- domy

- Jednak

- HPC

- HTML

- HTTPS

- olbrzymi

- Głodny

- i

- obraz

- zdjęcia

- Obrazowanie

- in

- początkowy

- Intel

- interakcji

- ciekawy

- wewnętrznie

- IT

- JEGO

- jpg

- właśnie

- Kapoor

- znany

- język

- duży

- większe

- uruchomić

- najmniej

- poziomy

- biblioteki

- lekki

- lubić

- Lista

- załadować

- Popatrz

- Partia

- M2

- poważny

- robić

- Dokonywanie

- i konserwacjami

- struktura

- rynek

- dojrzały

- Maksymalna szerokość

- Może..

- może

- me

- W międzyczasie

- Pamięć

- metody

- Michał

- Aplikacje mobilne

- urządzenia mobilne

- modele

- zmodyfikowano

- jeszcze

- wielo

- musi

- Naturalny

- Blisko

- wymagania

- Nowości

- Następny

- Hałas

- żaden

- Zauważając

- już dziś

- of

- oferta

- on

- ONE

- Okazja

- Option

- Opcje

- or

- Inne

- na zewnątrz

- koniec

- opakowania

- płyta

- panel dyskusyjny

- parametry

- Park

- partnerstwa

- może

- telefon

- Platformy

- plato

- Analiza danych Platona

- PlatoDane

- Volcano Plenty Vaporizer Storz & Bickel

- możliwy

- Post

- power

- przeważnie

- prezenty

- prymitywny

- Główny

- procesów

- Produkt

- zarządzanie produktem

- Produkcja

- stopniowo

- Udowodnij

- Sprawdzony

- pompa

- Qualcomm

- R & D

- szybki

- gotowy

- niedawno

- prasowe

- mających znaczenie

- Wymaga

- wielokrotnego użytku

- prawo

- role

- Rolka

- run

- SaaS

- Samsung

- Szukaj

- wydaje

- Sprzedaje

- Semiconductor

- senior

- serwer

- Usługi

- kilka

- Short

- powinien

- seans

- znaczący

- powolny

- So

- rozwiązanie

- Rozwiązania

- nieco

- pozyskiwany

- Sourcing

- Typ przestrzeni

- spektakularny

- stos

- Półki na książki

- Stan

- Nadal

- taki

- odpowiedni

- przełożony

- pewnie

- niespodzianka

- system

- systemy

- Technologies

- Technologia

- XNUMX

- niż

- że

- Połączenia

- Buzz

- Państwo

- ich

- następnie

- Tam.

- Te

- one

- rzecz

- to

- Przez

- do

- narzędzia

- Top

- w kierunku

- transformator

- biliony

- TSMC

- Ultra

- dla

- zasadniczy

- Nowości

- używany

- za pomocą

- zwykły

- początku.

- przez

- wizja

- vp

- była

- Oglądaj

- Droga..

- we

- były

- który

- ktokolwiek

- będzie

- w

- działa

- by

- lat

- jeszcze

- ty

- zefirnet