Niedawno rozmawiałem ze Steliosem Diamantidisem (wybitnym architektem, szefem strategii, Autonomous Design Solutions) o ogłoszeniu Synopsys na 100.th tapeout klienta przy użyciu ich rozwiązania DSO.ai. Moje obawy dotyczące artykułów związanych z AI polegają na unikaniu szumu wokół sztucznej inteligencji w ogóle i odwrotnie, sceptycyzmu w reakcji na ten szum, który skłania niektórych do odrzucania wszystkich twierdzeń o sztucznej inteligencji jako oleju węża. Ucieszyłem się, słysząc śmiech Steliosa iz całego serca się z nim zgodziłem. Odbyliśmy bardzo rzeczową dyskusję na temat tego, co DSO.ai może dzisiaj zrobić, co ich klienci referencyjni widzą w rozwiązaniu (w oparciu o to, co może zrobić dzisiaj) i co może mi powiedzieć o tej technologii.

Co robi DSO.ai

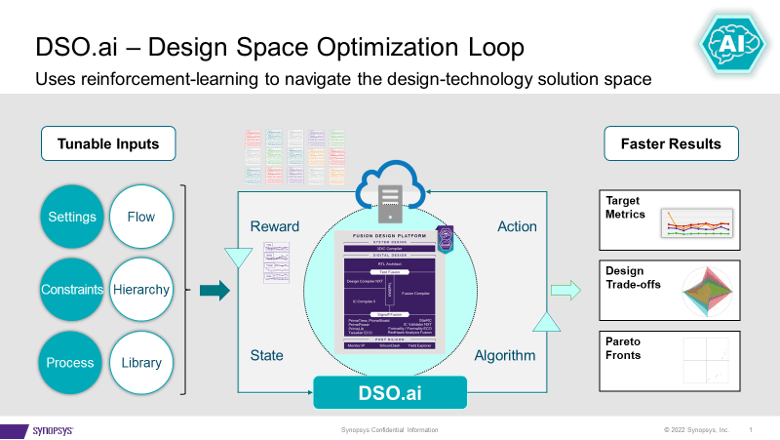

DSO.ai współpracuje z Fusion Compiler i IC Compiler II, co, jak Stelios starannie podkreślił, oznacza, że jest to rozwiązanie optymalizacyjne na poziomie bloków; Pełne SoC nie są jeszcze celem. Pasuje to do obecnych praktyk projektowych, ponieważ Stelios powiedział, że ważnym celem jest łatwe dopasowanie do istniejących przepływów. Celem tej technologii jest umożliwienie inżynierom wdrożeniowym, często pojedynczym inżynierom, poprawienia ich produktywności przy jednoczesnym eksplorowaniu większej przestrzeni projektowej w celu uzyskania lepszego PPA, niż można by znaleźć w inny sposób.

Synopsys ogłosił pierwszą taśmę latem 2021 roku, a teraz ogłosił 100 taśm. To dobrze świadczy o zapotrzebowaniu i skuteczności takiego rozwiązania. Stelios dodał, że wartość staje się jeszcze bardziej oczywista w przypadku aplikacji, które muszą wielokrotnie tworzyć instancje bloku. Pomyśl o wielordzeniowym serwerze, GPU lub przełączniku sieciowym. Zoptymalizuj blok raz, twórz instancje wiele razy – to może sumować się do znacznej poprawy PPA.

Zapytałem, czy wszyscy klienci, którzy to robią, pracują przy 7 nm i poniżej. Co zaskakujące, aktywne jest wykorzystanie aż do 40 nm. Jednym z interesujących przykładów jest kontroler lampy błyskowej, projekt, który nie jest bardzo wrażliwy na wydajność, ale może działać od dziesiątek do setek milionów sztuk. Zmniejszenie rozmiaru nawet o 5% może tu mieć duży wpływ na marże.

Co jest pod maską

DSO.ai opiera się na uczeniu się przez wzmacnianie, gorącym temacie w dzisiejszych czasach, ale obiecałem, że w tym artykule nie będzie szumu. Poprosiłem Steliosa, aby zgłębił trochę więcej, ale nie byłem zaskoczony, gdy powiedział, że nie może ujawnić zbyt wiele. To, co mógł mi powiedzieć, było wystarczająco interesujące. Zwrócił uwagę, że w bardziej ogólnych zastosowaniach jeden cykl przez zbiór uczący (epokę) zakłada szybką (od sekund do minut) metodę oceny kolejnych możliwych kroków, na przykład poprzez porównania gradientów.

Ale poważnego projektu blokowego nie można zoptymalizować za pomocą szybkich szacunków. Każda próba musi przejść przez pełny przepływ produkcyjny, odwzorowując rzeczywiste procesy produkcyjne. Przepływy, których uruchomienie może zająć wiele godzin. Częścią strategii skutecznego uczenia się przez wzmacnianie, biorąc pod uwagę to ograniczenie, jest równoległość. Reszta to sekretny sos DSO.ai. Z pewnością możesz sobie wyobrazić, że jeśli ten sekretny sos może wymyślić skuteczne udoskonalenia oparte na danej epoce, to paralelizm przyspieszy postęp w następnej epoce.

W tym celu ta funkcja naprawdę musi działać w chmurze, aby obsługiwać równoległość. Prywatna chmura lokalna to jedna z opcji. Firma Microsoft ogłosiła, że hostuje DSO.ai na platformie Azure, a firma ST poinformowała w komunikacie prasowym DSO.ai, że wykorzystała tę możliwość do optymalizacji implementacji rdzenia ARM. Wyobrażam sobie, że mogłoby dojść do interesujących debat na temat zalet i wad przeprowadzania optymalizacji w chmurze publicznej na powiedzmy 1000 serwerów, jeśli redukcja obszaru jest tego warta.

Opinie klientów

Synopsys twierdzi, że klienci (w tym ST i SK Hynix w tym ogłoszeniu) zgłaszają ponad 3-krotny wzrost wydajności, do 25% niższą całkowitą moc i znaczne zmniejszenie rozmiaru matrycy, a wszystko to przy zmniejszonym zużyciu ogólnych zasobów. Biorąc pod uwagę to, co opisał Stelios, wydaje mi się to rozsądne. Narzędzie umożliwia eksplorację większej liczby punktów w przestrzeni stanu projektu w ramach danego harmonogramu, niż byłoby to możliwe, gdyby eksploracja była ręczna. Dopóki algorytm wyszukiwania (tajemniczy sos) jest skuteczny, oczywiście znalazłoby to lepsze optimum niż ręczne wyszukiwanie.

Krótko mówiąc, ani szum AI, ani olej węża. DSO.ai sugeruje, że sztuczna inteligencja wchodzi do głównego nurtu jako wiarygodne inżynieryjne rozszerzenie istniejących przepływów. Możesz dowiedzieć się więcej z komunikat prasowy i od ten blog.

Udostępnij ten post przez:

- Dystrybucja treści i PR oparta na SEO. Uzyskaj wzmocnienie już dziś.

- Platoblockchain. Web3 Inteligencja Metaverse. Wzmocniona wiedza. Dostęp tutaj.

- Źródło: https://semiwiki.com/artificial-intelligence/324430-synopsys-design-space-optimization-hits-a-milestone/

- 100

- 2021

- a

- O nas

- przyśpieszyć

- w poprzek

- aktywny

- w dodatku

- AI

- algorytm

- Wszystkie kategorie

- pozwala

- i

- ogłosił

- Zapowiedź

- aplikacje

- POWIERZCHNIA

- ARM

- na około

- artykuł

- towary

- autonomiczny

- unikając

- Lazur

- na podstawie

- staje się

- poniżej

- Ulepsz Swój

- Duży

- Bit

- Blokować

- ostrożny

- na pewno

- roszczenia

- Chmura

- jak

- Troska

- Wady

- kontroler

- rdzeń

- mógłby

- kurs

- wiarygodny

- Aktualny

- klient

- Klientów

- cykl

- Dni

- Debaty

- Kreowanie

- opisane

- Wnętrze

- Umierać

- dyskusja

- Oddalić

- Wybitny

- robi

- na dół

- każdy

- z łatwością

- Efektywne

- skuteczność

- podkreślać

- umożliwiać

- inżynier

- Inżynieria

- Inżynierowie

- dość

- epoka

- Szacunki

- Parzyste

- przykład

- Przede wszystkim system został opracowany

- eksploracja

- Exploring

- rozbudowa

- FAST

- Znajdź

- i terminów, a

- dopasować

- Migać

- pływ

- Przepływy

- od

- pełny

- fuzja

- Ogólne

- dany

- cel

- GPU

- Zaoszczędzić

- głowa

- tutaj

- Odsłon

- Hosting

- HOT

- GODZINY

- HTTPS

- Szum

- Rezultat

- realizacja

- ważny

- podnieść

- poprawa

- in

- Włącznie z

- Zwiększenia

- ciekawy

- IT

- większe

- śmiać się

- UCZYĆ SIĘ

- nauka

- długo

- zrobiony

- Mainstream

- podręcznik

- produkcja

- wiele

- mapowanie

- marginesy

- Maksymalna szerokość

- znaczy

- metoda

- Microsoft

- może

- kamień milowy

- milion

- minuty

- jeszcze

- Ani

- sieć

- Następny

- oczywista

- Olej

- ONE

- optymalizacja

- Optymalizacja

- zoptymalizowane

- optymalny

- Option

- Inaczej

- ogólny

- część

- jest gwarancją najlepszej jakości, które mogą dostarczyć Ci Twoje monitory,

- plato

- Analiza danych Platona

- PlatoDane

- punkt

- zwrotnica

- możliwy

- Post

- power

- praktyki

- naciśnij

- Informacja prasowa

- prywatny

- procesów

- Produkcja

- wydajność

- Postęp

- obiecał

- PROS

- publiczny

- Chmura publiczna

- cel

- Szybki

- reakcja

- real

- rozsądny

- niedawno

- Zredukowany

- redukcja

- uczenie się wzmacniania

- zwolnić

- raport

- Raportowanie

- Zasoby

- REST

- ujawniać

- run

- bieganie

- Powiedział

- rozkład

- Szukaj

- sekund

- Tajemnica

- wrażliwy

- poważny

- zestaw

- Short

- znaczący

- pojedynczy

- Rozmiar

- Sceptycyzm

- rozwiązanie

- Rozwiązania

- kilka

- Typ przestrzeni

- Mówi

- Stan

- Cel

- Strategia

- Wskazuje

- lato

- wsparcie

- zdziwiony

- Przełącznik

- Brać

- cel

- Technologia

- Połączenia

- Strefa

- ich

- Przez

- czasy

- do

- już dziś

- także

- narzędzie

- aktualny

- Kwota produktów:

- Trening

- próba

- dla

- jednostek

- posługiwać się

- wartość

- przez

- Co

- który

- Podczas

- będzie

- w ciągu

- pracujący

- wartość

- by

- zefirnet