07 lut 2023 (

Wiadomości Nanowerk) Duże modele językowe, takie jak GPT-3 OpenAI, to ogromne sieci neuronowe, które mogą generować tekst podobny do ludzkiego, od poezji po kod programowania. Te modele uczenia maszynowego, wyszkolone przy użyciu zasobów danych internetowych, pobierają niewielki fragment tekstu wejściowego, a następnie przewidują tekst, który prawdopodobnie pojawi się jako następny. Ale to nie wszystko, co potrafią te modele. Naukowcy badają ciekawe zjawisko znane jako uczenie się w kontekście, w którym duży model językowy uczy się wykonywania zadania po obejrzeniu zaledwie kilku przykładów — mimo że nie był szkolony do tego zadania. Na przykład, ktoś mógłby podać modelowi kilka przykładowych zdań i jego nastrojów (pozytywnych lub negatywnych), a następnie poprosić go o nowe zdanie, a model może podać poprawne nastroje. Zazwyczaj model uczenia maszynowego, taki jak GPT-3, musiałby zostać przeszkolony z nowymi danymi dla tego nowego zadania. Podczas tego procesu uczenia model aktualizuje swoje parametry w miarę przetwarzania nowych informacji w celu nauczenia się zadania. Ale w przypadku uczenia się w kontekście parametry modelu nie są aktualizowane, więc wygląda na to, że model uczy się nowego zadania, nie ucząc się niczego. Naukowcy z MIT, Google Research i Uniwersytetu Stanforda starają się rozwikłać tę tajemnicę. Badali modele, które są bardzo podobne do dużych modeli językowych, aby zobaczyć, jak mogą się uczyć bez aktualizowania parametrów. Teoretyczne wyniki naukowców pokazują, że te masywne modele sieci neuronowych mogą zawierać w sobie mniejsze, prostsze modele liniowe. Duży model mógłby następnie zaimplementować prosty algorytm uczenia się, aby wyszkolić ten mniejszy, liniowy model w celu wykonania nowego zadania, wykorzystując tylko informacje już zawarte w większym modelu. Jego parametry pozostają stałe. Ważny krok w kierunku zrozumienia mechanizmów uczenia się w kontekście, badania te otwierają drzwi do dalszych badań wokół algorytmów uczenia się, które te duże modele mogą wdrożyć, mówi Ekin Akyürek, absolwent informatyki i główny autor artykułu (

„Jakim algorytmem uczenia się jest uczenie się w kontekście? Badania modelami liniowymi”) badanie tego zjawiska. Dzięki lepszemu zrozumieniu uczenia się w kontekście badacze mogliby umożliwić modelom wykonywanie nowych zadań bez konieczności kosztownego ponownego szkolenia. „Zwykle, jeśli chcesz dostroić te modele, musisz zebrać dane specyficzne dla domeny i wykonać złożoną inżynierię. Ale teraz możemy po prostu podać dane wejściowe, pięć przykładów, i osiąga to, czego chcemy. Tak więc uczenie się w kontekście jest dość ekscytującym zjawiskiem” — mówi Akyürek. Do Akyürka w artykule dołączają Dale Schuurmans, naukowiec z Google Brain i profesor informatyki na Uniwersytecie Alberty; a także starsi autorzy Jacob Andreas, adiunkt X Consortium na Wydziale Elektrotechniki i Informatyki MIT oraz członek Laboratorium Informatyki i Sztucznej Inteligencji MIT (CSAIL); Tengyu Ma, adiunkt informatyki i statystyki na Uniwersytecie Stanforda; oraz Danny Zhou, główny naukowiec i dyrektor ds. badań w Google Brain. Badania zostaną zaprezentowane na Międzynarodowej Konferencji na temat Reprezentacji Uczenia się.

Model w modelu

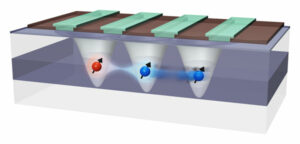

W społeczności badawczej zajmującej się uczeniem maszynowym wielu naukowców uwierzyło, że duże modele językowe mogą uczyć się w kontekście ze względu na sposób, w jaki są szkolone, mówi Akyürek. Na przykład GPT-3 ma setki miliardów parametrów i został wyszkolony poprzez czytanie ogromnych fragmentów tekstu w Internecie, od artykułów w Wikipedii po posty na Reddicie. Kiedy więc ktoś pokazuje modelowe przykłady nowego zadania, prawdopodobnie widział już coś bardzo podobnego, ponieważ jego zestaw danych szkoleniowych zawierał tekst z miliardów stron internetowych. Powtarza wzorce, które widział podczas treningu, zamiast uczyć się wykonywania nowych zadań. Akyürek wysunął hipotezę, że osoby uczące się w kontekście nie tylko dopasowują się do wcześniej widzianych wzorców, ale zamiast tego faktycznie uczą się wykonywania nowych zadań. On i inni eksperymentowali, dając tym modelom monity przy użyciu danych syntetycznych, których nigdzie wcześniej nie mogli zobaczyć, i odkryli, że modele wciąż mogą uczyć się na zaledwie kilku przykładach. Akyürek i jego współpracownicy pomyśleli, że być może te modele sieci neuronowych mają w sobie mniejsze modele uczenia maszynowego, które modele mogą trenować, aby wykonać nowe zadanie. „To mogłoby wyjaśnić prawie wszystkie zjawiska uczenia się, które zaobserwowaliśmy w przypadku tych dużych modeli” – mówi. Aby przetestować tę hipotezę, naukowcy wykorzystali model sieci neuronowej zwany transformatorem, który ma taką samą architekturę jak GPT-3, ale został specjalnie przeszkolony do uczenia się w kontekście. Badając architekturę tego transformatora, teoretycznie udowodnili, że może on napisać liniowy model w swoich ukrytych stanach. Sieć neuronowa składa się z wielu warstw połączonych ze sobą węzłów przetwarzających dane. Stany ukryte to warstwy między warstwą wejściową i wyjściową. Ich matematyczne oceny pokazują, że ten model liniowy jest zapisany gdzieś w najwcześniejszych warstwach transformatora. Transformator może następnie aktualizować model liniowy, wdrażając proste algorytmy uczenia się. Zasadniczo model symuluje i trenuje mniejszą wersję samego siebie.

Badanie ukrytych warstw

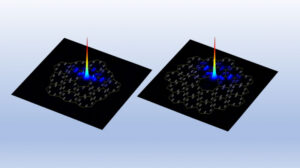

Naukowcy zbadali tę hipotezę za pomocą eksperymentów sondujących, w których zajrzeli do ukrytych warstw transformatora, aby spróbować odzyskać określoną ilość. „W tym przypadku próbowaliśmy odtworzyć rzeczywiste rozwiązanie modelu liniowego i mogliśmy pokazać, że parametr jest zapisany w stanach ukrytych. Oznacza to, że model liniowy gdzieś tam jest” — mówi. Opierając się na tej pracy teoretycznej, naukowcy mogą być w stanie umożliwić transformatorowi uczenie się w kontekście, dodając tylko dwie warstwy do sieci neuronowej. Akyürek ostrzega, że wciąż pozostaje wiele szczegółów technicznych do opracowania, ale może to pomóc inżynierom w tworzeniu modeli, które mogą wykonywać nowe zadania bez konieczności ponownego szkolenia z nowymi danymi. Idąc dalej, Akyürek planuje kontynuować badanie uczenia się w kontekście za pomocą funkcji, które są bardziej złożone niż modele liniowe, które badali w tej pracy. Mogliby również zastosować te eksperymenty do dużych modeli językowych, aby sprawdzić, czy ich zachowania są również opisywane przez proste algorytmy uczenia się. Ponadto chce zagłębić się w typy danych przedtreningowych, które mogą umożliwić uczenie się w kontekście. „Dzięki tej pracy ludzie mogą teraz wizualizować, w jaki sposób te modele mogą uczyć się na przykładach. Mam więc nadzieję, że zmieni to poglądy niektórych osób na temat uczenia się w kontekście” — mówi Akyürek. „Te modele nie są tak głupie, jak ludzie myślą. Nie tylko zapamiętują te zadania. Mogą uczyć się nowych zadań, a my pokazaliśmy, jak można to zrobić”.

- Dystrybucja treści i PR oparta na SEO. Uzyskaj wzmocnienie już dziś.

- Platoblockchain. Web3 Inteligencja Metaverse. Wzmocniona wiedza. Dostęp tutaj.

- Źródło: https://www.nanowerk.com/news2/robotics/newsid=62325.php