Uczenie maszynowe (ML), gałąź sztucznej inteligencji (AI), zyskało w ostatnich latach duże zainteresowanie. ML koncentruje się na szkoleniu komputerów, aby uczyły się na podstawie danych za pomocą algorytmów i modeli w celu podejmowania decyzji lub przewidywań. W tym podejściu szkoleniowym maszyny nie muszą być bezpośrednio programowane. Komputery uczą się na podstawie doświadczenia, tak jak ludzie. Sztuczna inteligencja wykracza poza ML, obejmując różne techniki, takie jak przetwarzanie języka naturalnego (NLP), wizja komputerowa i robotyka. Jego celem jest stworzenie inteligentnych maszyn, które będą w stanie symulować ludzkie zachowanie i samodzielnie wykonywać złożone zadania. Zrozumienie podstawowych koncepcji uczenia maszynowego jest niezbędne dla wszystkich zainteresowanych tymi dziedzinami, ponieważ kryją one ogromny potencjał w przekształcaniu branż takich jak opieka zdrowotna, finanse, transport i nie tylko.

In MLmaszyny analizują bardzo duże zbiory danych, aby zidentyfikować wzorce, trendy i relacje w danych. Ta funkcja oparta na danych pomaga maszynom podejmować świadome decyzje i dokonywać dokładnych przewidywań.

Rola danych w uczeniu maszynowym

Dane stanowią podstawę, na której buduje się modele i dokonuje prognoz. Techniki wstępnego przetwarzania, takie jak czyszczenie, przekształcanie i normalizacja danych, zapewniają ich przydatność do analizy. Ekstrakcja cech odgrywa kluczową rolę w uczeniu maszynowym poprzez identyfikację odpowiednich atrybutów lub cech w zbiorze danych, które przyczyniają się do dokładnych przewidywań. Proces ten polega na wybieraniu lub przekształcaniu zmiennych, które najlepiej reprezentują podstawowe wzorce danych.

Koncepcje wstępnego przetwarzania danych

Wstępne przetwarzanie danych odgrywa kluczową rolę w poprawie dokładności i wiarygodności modeli uczenia maszynowego. Na tym etapie surowe dane są czyszczone poprzez usunięcie błędów i niespójności, a następnie przygotowywane w formacie odpowiednim do dalszej analizy. Kolejnym ważnym etapem wstępnego przetwarzania danych jest ich obsługa brakujące wartości. Brakujące dane mogą wprowadzić błąd i wpłynąć na dokładność modelu. Te etapy wstępnego przetwarzania zapewniają, że algorytmy uczące działają zgodnie z oczekiwaniami.

Kolejnym ważnym krokiem jest skalowanie cech, podczas którego zmienne są dostosowywane tak, aby pewne cechy nie dominowały nad innymi, zapewniając w ten sposób wierną reprezentację cech w modelu.

Co więcej, zmienne kategoryczne często wymagają kodowania w postaci liczbowej w celu zapewnienia zgodności z algorytmami ML. Techniki takie jak kodowanie typu „one-hot” lub kodowanie etykiet są powszechnie stosowane do przekształcania zmiennych kategorycznych w znaczące wartości liczbowe. Ponadto wartości odstające mogą zniekształcać działanie modelu; dlatego też stosowane są metody wykrywania wartości odstających w celu ich identyfikacji i odpowiedniego postępowania.

Ogólnie rzecz biorąc, dokładne wstępne przetwarzanie danych zapewnia, że modele ML otrzymują czyste, spójne i niezawodne dane wejściowe. To nie tylko poprawia dokładność, ale także umożliwia lepsze uogólnianie podczas dokonywania prognoz na podstawie niewidocznych danych.

Koncepcje szkolenia danych: uczenie się nadzorowane i bez nadzoru

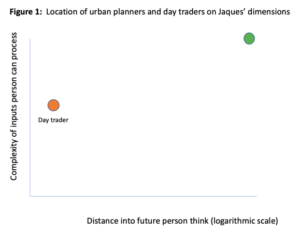

Algorytmy ML może szkolić modele dwiema podstawowymi metodami: uczeniem się pod nadzorem i uczeniem się bez nadzoru. W uczeniu nadzorowanym model uczy się na podstawie oznakowanych danych, gdzie każdy przykład jest powiązany z prawidłowym wynikiem.

Z drugiej strony, uczenie się bez nadzoru Metoda opiera się na „danych bez etykiet”, w przypadku których dostępne są jedynie funkcje wejściowe. Celem jest odkrycie nieodłącznych struktur lub wzorców w danych bez żadnych predefiniowanych etykiet. To podejście jest przydatne w przypadku zadań takich jak grupowanie podobnych instancji lub redukcja wymiarowości.

Niezależnie od wybranego podejścia, dane treningowe odgrywa kluczową rolę w uczeniu maszynowym. Wysokiej jakości zbiory danych są niezbędne do budowania solidnych modeli, które umożliwiają dobre uogólnianie na niewidoczne przykłady. Oprócz danych szkoleniowych inżynieria funkcji odgrywa również istotną rolę w potokach uczenia maszynowego. Polega na przekształceniu surowych cech wejściowych w bardziej odpowiednią reprezentację, która przechwytuje istotne informacje na temat danego problemu.

Pojęcia dotyczące algorytmów ML: modelowanie predykcyjne, sieci neuronowe i głębokie uczenie się

W dziedzinie uczenia maszynowego algorytmy stanowią podstawę tworzenia inteligentnych systemów zdolnych do dokonywania dokładnych przewidywań i podejmowania decyzji. Modelowanie predykcyjne to podstawowa koncepcja uczenia maszynowego, która obejmuje wykorzystanie danych historycznych do budowania modeli prognozujących przyszłe wyniki. Analizując wzorce i relacje w danych, modele predykcyjne umożliwiają nam dokonywanie świadomych przewidywań dotyczących nowych, niewidocznych przypadków.

Sieci neuronowe, specjalna klasa algorytmów, ściśle naśladuje strukturę i funkcjonowanie ludzkiego mózgu. Sieci neuronowe, składające się z połączonych ze sobą węzłów, czyli „neuronów”, wyjątkowo dobrze radzą sobie z rozpoznawaniem złożonych wzorców i wydobywaniem znaczących wniosków z ogromnych ilości danych. Okazały się bardzo skuteczne w różnych dziedzinach, takich jak rozpoznawanie obrazów, przetwarzanie języka naturalnego i systemy rekomendacji.

Głębokie uczenie się (DL) to: podzbiór sieci neuronowych który zyskał ogromną popularność w ostatnich latach ze względu na niezwykłą wydajność w przypadku trudnych zadań. Polega na szkoleniu sieci neuronowych z stopniowo ujawnianymi warstwami (stąd określenie „głębokie”), aby umożliwić hierarchiczne „zdobywanie wiedzy” z surowych danych. Umożliwia to modelom DL automatyczne uczenie się skomplikowanych funkcji bez wyraźnej inżynierii funkcji.

Zagłębiając się w techniki modelowania predykcyjnego, badając wewnętrzne działanie sieci neuronowych i rozumiejąc siłę podejść DL, początkujący mogą uzyskać cenne informacje na temat tego, w jaki sposób algorytmy napędzają rozwiązania ML.

Pojęcia dotyczące oceny wydajności modelu: nadmierne dopasowanie, niedopasowanie, weryfikacja krzyżowa, macierz zamieszania i krzywa Roc

Ewaluacja wydajność modelu jest kluczowym krokiem w procesie ML. W tym podtemacie omówimy kilka ważnych koncepcji związanych z oceną wydajności modelu.

W fazie uczenia model dostosowuje swoje parametry wewnętrzne, aby zminimalizować błędy między przewidywanymi wynikami a rzeczywistymi wartościami docelowymi. Proces ten, znany jako „optymalizacja” lub „dopasowywanie”, umożliwia modelowi uogólnienie uczenia się na niewidoczne przykłady. Dlatego istotna jest ocena wydajności wyszkolonego modelu na niewidocznych danych, aby ocenić jego zdolność do dokonywania dokładnych przewidywań w rzeczywistych scenariuszach. Tutaj w grę wchodzą dane testowe. Dane testowe działają jak niezależny zbiór danych, który nie był używany podczas uczenia, ale zawiera podobne wzorce i rozkłady.

Przeładowanie ma miejsce, gdy model jest zbyt złożony – wychwytuje nieistotne wzorce z danych uczących. Modele tego typu nie sprawdzają się dobrze w przypadku nowych danych. Niedopasowanie jest całkowitym przeciwieństwem – ma miejsce, gdy model jest zbyt prosty, aby uchwycić podstawowe wzorce w danych, co prowadzi do niskiej wydajności.

Walidacja krzyżowa służy do oceny wydajności modelu na niewidocznych danych. Obejmuje to podzielenie zbioru danych na wiele podzbiorów, a następnie iteracyjne szkolenie i testowanie modelu na podzbiorach danych.

Metryki takie jak dokładność, precyzja, zapamiętywanie i wynik F1 zapewniają wgląd w to, jak dobrze modele generalizują na nowe lub niewidoczne dane. Zrozumienie tych koncepcji umożliwi początkującym skuteczną ocenę modeli uczenia maszynowego i podejmowanie świadomych decyzji dotyczących ich wydajności.

Ekstrakcja cech i inżynieria cech: przykłady z życia

Jednym z takich przykładów jest NLP, gdzie wyodrębnianie odpowiednich cech z danych tekstowych ma kluczowe znaczenie. Na przykład w analizie tonacji można wyodrębnić takie funkcje, jak częstotliwość występowania słów, znaczniki części mowy lub leksykony tonacji, aby wytrenować model w celu klasyfikowania tekstu jako pozytywnego lub negatywnego.

W zastosowaniach związanych z wizją komputerową ekstrakcja cech jest niezbędna do rozpoznawania obiektów i wzorców na obrazach. Konwolucyjne sieci neuronowe (CNN) często wykorzystują do tego wstępnie wytrenowane modele, takie jak VGGNet lub ResNet. wydobyć znaczące cechy z obrazów przed szkoleniem w zakresie konkretnych zadań, takich jak wykrywanie obiektów lub klasyfikacja obrazów.

Inny przykład z życia wzięty można znaleźć w systemach wykrywania oszustw. Aby skutecznie wykrywać oszukańcze transakcje, opracowano różne funkcje w oparciu o historię transakcji, w tym częstotliwość transakcji, niezgodność lokalizacji, nietypowe wzorce zakupów i anomalie adresów IP.

W zastosowaniach związanych z opieką zdrowotną inżynieria funkcji odgrywa znaczącą rolę. Na przykład ryzyko chorób serca można przewidzieć na podstawie danych pacjenta, takich jak wiek, ciśnienie krwi, poziom cholesterolu i nawyki palenia. Zmienne te są starannie wybierane i przekształcane w znaczące cechy, które odzwierciedlają odpowiednią wiedzę medyczną.

Systemy rekomendacji i wykrywanie anomalii: przykłady z życia wzięte

W dzisiejszej erze cyfrowej systemy rekomendacji stały się integralną częścią naszego codziennego życia. Od spersonalizowanych rekomendacji filmów na platformach streamingowych po ukierunkowane sugestie produktów w witrynach handlu elektronicznego – systemy te odgrywają kluczową rolę w poprawianiu komfortu użytkowania. Wykorzystując algorytmy ML, systemy rekomendacji analizują ogromne ilości danych, aby dokładnie przewidzieć preferencje użytkowników.

Jednym z wybitnych przykładów systemów rekomendacji jest filtrowanie wspólne, które sugeruje elementy na podstawie preferencji i zachowań podobnych użytkowników. Technika ta zrewolucjonizowała sposób, w jaki odkrywamy nowe treści, wspierając poczucie personalizacji w przytłaczającym świecie online.

Kolejnym fascynującym aspektem uczenia maszynowego są algorytmy wykrywania anomalii. Algorytmy te doskonale identyfikują odchylenia od oczekiwanych wzorców lub zachowań w zbiorze danych. Od wykrywania oszustw w transakcjach finansowych po wykrywanie włamań do sieci w cyberbezpieczeństwie – wykrywanie anomalii odgrywa kluczową rolę w ochronie przed złośliwymi działaniami.

Dzięki zastosowaniu technik takich jak grupowanie, modelowanie statystyczne i sieci neuronowe algorytmy wykrywania anomalii mogą identyfikować wartości odstające i anomalie, które mogłyby pozostać niezauważone w przypadku tradycyjnych metod opartych na regułach. Dzięki tej możliwości są one nieocenionymi narzędziami zwiększania środków bezpieczeństwa w różnych branżach.

W dziedzinie uczenia maszynowego Analiza szeregów czasowych odgrywa kluczową rolę, umożliwiając nam wydobywanie cennych spostrzeżeń z danych, które ewoluują w czasie. Ta gałąź statystyki koncentruje się na zrozumieniu i przewidywaniu wzorców w danych sekwencyjnych, co czyni ją niezbędnym narzędziem do różnych rzeczywistych zastosowań. Jednym z najważniejszych obszarów, w którym analiza szeregów czasowych odgrywa kluczową rolę, jest prognozowanie finansowe.

Analizując historyczne ceny akcji lub kursy wymiany walut, modele ML mogą prognozować przyszłe trendy i pomagać inwestorom w podejmowaniu świadomych decyzji. Podobnie w prognozowaniu sprzedaży zrozumienie przeszłych wzorców sprzedaży jest niezbędne do przewidywania przyszłego popytu i optymalizacji zarządzania zapasami.

Inne istotne zastosowanie leży w dziedzinie nauk o środowisku. Analiza szeregów czasowych pomaga nam zrozumieć wzorce klimatyczne poprzez badanie wahań temperatury, poziomów opadów, a nawet wskaźników jakości powietrza w dłuższych okresach. Identyfikując trendy i sezonowość w tych zbiorach danych, badacze mogą dokonywać dokładnych prognoz dotyczących skutków zmiany klimatu i odpowiednio kierować decydentów.

Co więcej, analiza szeregów czasowych znajduje swoje znaczenie także w opiece zdrowotnej. Analizując parametry życiowe pacjenta na przestrzeni czasu lub badając wzorce postępu choroby, lekarze mogą stawiać trafniejsze diagnozy i przewidywać przebieg choroby z większą precyzją.

Ogólnie rzecz biorąc, analiza szeregów czasowych stanowi integralny składnik aplikacji ML w różnych domenach.

- Dystrybucja treści i PR oparta na SEO. Uzyskaj wzmocnienie już dziś.

- PlatoData.Network Pionowe generatywne AI. Wzmocnij się. Dostęp tutaj.

- PlatoAiStream. Inteligencja Web3. Wiedza wzmocniona. Dostęp tutaj.

- PlatonESG. Węgiel Czysta technologia, Energia, Środowisko, Słoneczny, Gospodarowanie odpadami. Dostęp tutaj.

- Platon Zdrowie. Inteligencja w zakresie biotechnologii i badań klinicznych. Dostęp tutaj.

- Źródło: https://www.dataversity.net/machine-learning-concepts-for-beginners/

- :ma

- :Jest

- :nie

- :Gdzie

- 224

- 300

- a

- zdolność

- O nas

- odpowiednio

- precyzja

- dokładny

- dokładnie

- w poprzek

- zajęcia

- Dzieje Apostolskie

- rzeczywisty

- Ad

- dodatek

- do tego

- adres

- Skorygowana

- dostosowuje się

- oddziaływać

- przed

- wiek

- AI

- Cele

- AIR

- algorytm

- Algorytmy

- również

- kwoty

- an

- analiza

- w czasie rzeczywistym sprawiają,

- Analizując

- i

- wykrywanie anomalii

- Inne

- każdy

- ktoś

- oklaski

- Zastosowanie

- aplikacje

- stosowany

- podejście

- awanse

- odpowiednio

- SĄ

- POWIERZCHNIA

- sztuczny

- sztuczna inteligencja

- Sztuczna inteligencja (AI)

- AS

- aspekt

- oszacować

- pomagać

- At

- Uwaga

- atrybuty

- automatycznie

- autonomicznie

- dostępny

- Kręgosłup

- na podstawie

- podstawowy

- BE

- stają się

- zanim

- początkujących

- zachowanie

- BEST

- Ulepsz Swój

- pomiędzy

- Poza

- stronniczość

- krew

- Ciśnienie krwi

- Mózg

- Oddział

- budować

- Budowanie

- wybudowany

- ale

- by

- CAN

- zdolność

- zdolny

- zdobyć

- przechwytuje

- Przechwytywanie

- Kariera

- ostrożnie

- pewien

- wyzwanie

- zmiana

- Charakterystyka

- wybrany

- klasa

- klasyfikacja

- Klasyfikuj

- kleń

- Sprzątanie

- Klimat

- Zmiana klimatu

- dokładnie

- klastrowanie

- współpracy

- byliśmy spójni, od początku

- powszechnie

- zgodność

- kompleks

- składnik

- zrozumieć

- komputer

- Wizja komputerowa

- Aplikacje do widzenia komputerowego

- komputery

- pojęcie

- Koncepcje

- zamieszanie

- zgodny

- Składający się

- zawiera

- zawartość

- przyczynić się

- konwertować

- skorygowania

- Stwórz

- Tworzenie

- istotny

- Waluta

- Bezpieczeństwo cybernetyczne

- dane

- sterowane danymi

- zbiory danych

- WSZECHSTRONNOŚĆ DANYCH

- Decyzje

- głęboko

- Kreowanie

- wykryć

- Wykrywanie

- cyfrowy

- Era cyfrowa

- odkryj

- choroba

- Dystrybucje

- inny

- do

- robi

- domeny

- dominującym

- napęd

- z powodu

- podczas

- e-commerce

- każdy

- Efektywne

- faktycznie

- zatrudniający

- umożliwiać

- Umożliwia

- umożliwiając

- kodowanie

- obejmujący

- zaprojektowane

- Inżynieria

- wzmocnienie

- zapewnić

- zapewnia

- zapewnienie

- środowiskowy

- Błędy

- niezbędny

- Eter (ETH)

- oceniać

- oceny

- ewaluację

- Parzyste

- wydarzenie

- codzienny

- ewoluuje

- Badanie

- przykład

- przykłady

- przewyższać

- wyjątkowo

- wymiana

- spodziewany

- doświadczenie

- wyraźnie

- odkryj

- Exploring

- dużym

- wyciąg

- ekstrakcja

- f1

- sprawiedliwy

- fascynujący

- Cecha

- Korzyści

- pole

- Łąka

- filtracja

- finansować

- budżetowy

- znajduje

- Wahania

- koncentruje

- W razie zamówieenia projektu

- Prognoza

- Nasz formularz

- format

- formularze

- wychowanie

- znaleziono

- Fundacja

- oszustwo

- wykrywanie oszustw

- nieuczciwy

- Częstotliwość

- od

- funkcjonowanie

- fundamentalny

- dalej

- przyszłość

- Wzrost

- zdobyte

- Go

- cel

- Goes

- większy

- poprowadzi

- ręka

- uchwyt

- dzieje

- Have

- opieki zdrowotnej

- Serce

- Choroby serca

- pomoc

- pomaga

- stąd

- hierarchiczny

- Wysoki

- wysokiej jakości

- wysoko

- historyczny

- historia

- przytrzymaj

- W jaki sposób

- HTML

- HTTPS

- człowiek

- Ludzie

- zidentyfikować

- identyfikacja

- obraz

- Klasyfikacja obrazu

- Rozpoznawanie obrazu

- zdjęcia

- ogromny

- Oddziaływania

- ważny

- poprawia

- poprawy

- in

- Włącznie z

- niespójności

- niezależny

- Indeksy

- przemysłowa

- Informacja

- poinformowany

- nieodłączny

- wewnętrzny

- wkład

- Wejścia

- spostrzeżenia

- przykład

- instancje

- integralny

- Inteligencja

- Inteligentny

- połączone

- zainteresowany

- wewnętrzny

- najnowszych

- zawiły

- przedstawiać

- wykrywania włamań

- nieoceniony

- inwentarz

- Zarządzanie zapasami

- Inwestorzy

- dotyczy

- IP

- Adres IP

- IT

- szt

- JEGO

- właśnie

- Knuggety

- wiedza

- znany

- Etykieta

- Etykiety

- język

- duży

- nioski

- prowadzący

- UCZYĆ SIĘ

- nauka

- poziomy

- lewarowanie

- leży

- lubić

- Zyje

- lokalizacja

- maszyna

- uczenie maszynowe

- maszyny

- zrobiony

- robić

- WYKONUJE

- Dokonywanie

- złośliwy

- i konserwacjami

- Matrix

- Maksymalna szerokość

- wymowny

- środków

- medyczny

- metoda

- metody

- może

- zminimalizować

- brakujący

- ML

- Algorytmy ML

- model

- modelowanie

- modele

- jeszcze

- film

- wielokrotność

- my

- Naturalny

- Język naturalny

- Przetwarzanie języka naturalnego

- ujemny

- sieć

- sieci

- Nerwowy

- sieci neuronowe

- Nowości

- nlp

- węzły

- przedmiot

- Wykrywanie obiektów

- obiekty

- of

- często

- on

- ONE

- Online

- tylko

- naprzeciwko

- optymalizacji

- or

- Inne

- Pozostałe

- Inaczej

- ludzkiej,

- Wynik

- wyniki

- odstające

- Wyjścia

- koniec

- przytłaczający

- sparowany

- parametry

- część

- Przeszłość

- pacjent

- dane pacjenta

- wzory

- wykonać

- jest gwarancją najlepszej jakości, które mogą dostarczyć Ci Twoje monitory,

- okresy

- personalizacja

- Personalizowany

- faza

- kluczowy

- Platformy

- plato

- Analiza danych Platona

- PlatoDane

- Grać

- odgrywa

- Podcast

- politycy

- biedny

- popularność

- pozytywny

- potencjał

- power

- Detaliczność

- predefiniowane

- przewidzieć

- Przewiduje

- przewidywanie

- Przewidywania

- proroczy

- preferencje

- przygotowany

- nacisk

- zapobiec

- Cennik

- pierwotny

- Problem

- wygląda tak

- przetwarzanie

- Produkt

- Sugestie dotyczące produktu

- specjalistów

- zaprogramowany

- progresja

- stopniowo

- wybitny

- Sprawdzony

- zapewniać

- zakup

- jakość

- ceny

- Surowy

- surowe dane

- Prawdziwy świat

- królestwo

- otrzymać

- niedawny

- uznanie

- rozpoznawanie

- Rekomendacja

- zalecenia

- redukcja

- w sprawie

- związane z

- Relacje

- niezawodność

- rzetelny

- znakomity

- usuwanie

- reprezentować

- reprezentacja

- wymagać

- Badacze

- zrewolucjonizował

- Ryzyko

- robotyka

- krzepki

- Rola

- zabezpieczenie

- sole

- skalowaniem

- scenariusze

- nauka

- wynik

- bezpieczeństwo

- Środki bezpieczeństwa

- wybrany

- wybierając

- rozsądek

- sentyment

- Serie

- służy

- kilka

- shutterstock

- znaczenie

- znaczący

- znaki

- podobny

- Podobnie

- Prosty

- Palenie

- Rozwiązania

- specyficzny

- statystyczny

- statystyka

- Ewolucja krok po kroku

- Cel

- stany magazynowe

- Streaming

- Struktura

- Struktury

- Studiowanie

- taki

- Wskazuje

- stosowność

- odpowiedni

- Nadzorowana nauka

- systemy

- Brać

- cel

- ukierunkowane

- zadania

- technika

- Techniki

- semestr

- Testowanie

- XNUMX

- że

- Połączenia

- ich

- Im

- następnie

- Te

- one

- to

- A zatem

- czas

- Szereg czasowy

- do

- dzisiaj

- razem

- także

- narzędzie

- narzędzia

- tradycyjny

- Pociąg

- przeszkolony

- Trening

- transakcja

- transakcje

- transformatorowy

- transport

- ogromny

- Trendy

- drugiej

- rodzaj

- odkryć

- zasadniczy

- zrozumienie

- uczenie się bez nadzoru

- niezwykły

- na

- us

- posługiwać się

- używany

- użyteczny

- Użytkownik

- Doświadczenie użytkownika

- Użytkownicy

- za pomocą

- Cenny

- Wartości

- różnorodny

- Naprawiono

- początku.

- oglądany "

- wizja

- istotny

- była

- Droga..

- we

- strony internetowe

- DOBRZE

- jeśli chodzi o komunikację i motywację

- który

- będzie

- w

- w ciągu

- bez

- słowo

- prace

- świat

- lat

- ZDNET

- zefirnet