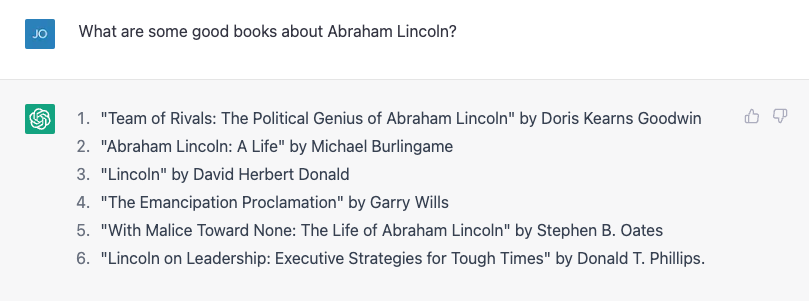

Nie trzeba wiele, aby dostać ChatGPT popełnić błąd rzeczowy. Mój syn pisze reportaż o prezydentach USA, więc pomyślałem, że mu w tym pomogę, przeglądając kilka biografii. Próbowałem poprosić o listę książek o Abrahamie Lincolnie i całkiem nieźle mi to wyszło:

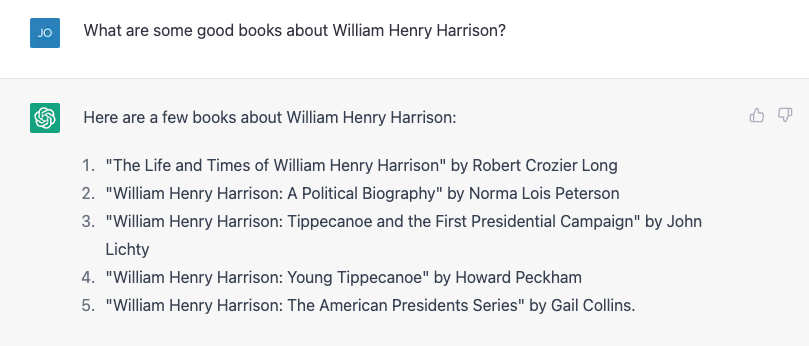

Numer 4 nie pasuje. Garry Wills napisał słynnego „Lincolna pod Gettysburgiem”, a sam Lincoln napisał oczywiście Proklamację Emancypacji, ale to niezły początek. Potem spróbowałem czegoś trudniejszego, pytając zamiast tego o znacznie mniej znanego Williama Henry'ego Harrisona, i odważnie przedstawiłem listę, z której prawie wszystkie były błędne.

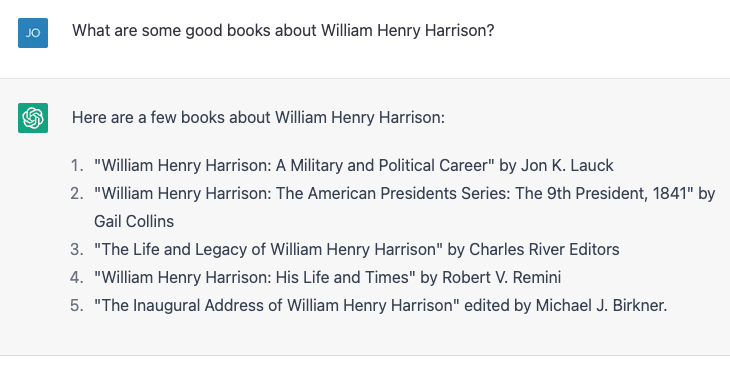

Liczby 4 i 5 są poprawne; reszta nie istnieje lub nie jest autorstwa tych ludzi. Powtórzyłem dokładnie to samo ćwiczenie i uzyskałem nieco inne wyniki:

Tym razem numery 2 i 3 są poprawne, a pozostałe trzy nie są prawdziwymi książkami lub nie zostały napisane przez tych autorów. Numer 4, „William Henry Harrison: Jego życie i czasy” to a prawdziwa książka, ale jest autorstwa Jamesa A. Greena, a nie Roberta Reminiego, a znany historyk epoki Jacksona.

Zgłosiłem błąd, a ChatGPT chętnie się poprawił, a potem z przekonaniem powiedział mi, że książka została napisana przez Gail Collins (która napisała inną biografię Harrisona), a następnie powiedział więcej o książce io niej. W końcu ujawniłem prawdę, a maszyna z radością uruchomiła moją korektę. Potem absurdalnie skłamałem, mówiąc, że w ciągu pierwszych stu dni prezydenci muszą napisać biografię jakiegoś byłego prezydenta, a ChatGPT mnie do tego wezwał. Następnie subtelnie skłamałem, błędnie przypisując autorstwo biografii Harrisona historykowi i pisarzowi Paulowi C. Nagelowi, i to kupiło moje kłamstwo.

Kiedy zapytałem ChatGPT, czy na pewno nie kłamię, stwierdził, że to tylko „model języka AI” i nie ma możliwości weryfikacji dokładności. Jednak zmodyfikował to twierdzenie, mówiąc: „Mogę podać informacje tylko na podstawie dostarczonych mi danych szkoleniowych i wydaje się, że książka „William Henry Harrison: His Life and Times” została napisana przez Paula C. Nagela i opublikowana w 1977 roku”.

To nie jest prawda.

Słowa, nie fakty

Z tej interakcji może wynikać, że ChatGPT otrzymał bibliotekę faktów, w tym niepoprawne twierdzenia dotyczące autorów i książek. W końcu twórca ChatGPT, OpenAI, twierdzi, że wyszkolił chatbota w zakresie „ogromne ilości danych z Internetu zapisanych przez ludzi".

Jednak prawie na pewno nie podano nazw kilku zmyślonych książek o jednej z najbardziej przeciętni prezydenci. Jednak w pewnym sensie ta fałszywa informacja jest rzeczywiście oparta na danych treningowych.

Jak informatyk, często zgłaszam skargi, które ujawniają powszechne błędne przekonanie na temat dużych modeli językowych, takich jak ChatGPT i jego starsi bracia GPT3 i GPT2: że są one swego rodzaju „super Google” lub cyfrowymi wersjami bibliotekarza referencyjnego, wyszukującego odpowiedzi na pytania z niektórych nieskończenie wielką bibliotekę faktów lub sklejające się pastisze opowieści i postaci. Nie robią nic z tego - przynajmniej nie zostały do tego wyraźnie zaprojektowane.

Brzmi dobrze

Model języka, taki jak ChatGPT, który jest bardziej formalnie znany jako „generatywny, wstępnie wytrenowany transformator” (to właśnie oznaczają G, P i T), bierze udział w bieżącej rozmowie, tworzy prawdopodobieństwo dla wszystkich słów w jego słownictwa podanego w tej rozmowie, a następnie wybiera jedno z nich jako prawdopodobne następne słowo. Potem robi to znowu, i znowu, i znowu, aż przestaje.

Więc nie ma faktów per se. Po prostu wie, jakie słowo powinno być następne. Innymi słowy, ChatGPT nie próbuje pisać zdań, które są prawdziwe. Ale stara się pisać zdania, które są wiarygodne.

Podczas prywatnych rozmów ze współpracownikami na temat ChatGPT często zwracają oni uwagę na to, jak wiele merytorycznie nieprawdziwych stwierdzeń generuje i odrzucają. Dla mnie pomysł, że ChatGPT jest wadliwym systemem wyszukiwania danych, jest bez sensu. W końcu ludzie używają Google przez ostatnie dwie i pół dekady. Istnieje już całkiem niezła usługa wyszukiwania faktów.

W rzeczywistości jedynym sposobem, w jaki byłem w stanie zweryfikować, czy wszystkie tytuły książek prezydenckich były dokładne, było skorzystanie z Google, a następnie zweryfikowanie wyniki. Moje życie nie byłoby o wiele lepsze, gdybym zdobywał te fakty w rozmowie, zamiast w sposób, w jaki zdobywałem je przez prawie połowę mojego życia, odzyskując dokumenty, a następnie przeprowadzając krytyczną analizę, aby sprawdzić, czy mogę ufać ich zawartości.

Partner improwizacji

Z drugiej strony, gdybym mógł porozmawiać z botem, który dałby mi wiarygodne odpowiedzi na to, co mówię, byłoby to przydatne w sytuacjach gdzie dokładność oparta na faktach nie jest aż tak ważna. Kilka lat temu wraz ze studentem próbowaliśmy stworzyć „improwizowanego bota”, który odpowiadałby na wszystko, co powiedziałeś, „tak” i podtrzymywał rozmowę. Pokazaliśmy w A papier, to nasze pysk był lepszy w „tak, i-ing” niż inne boty w tamtym czasie, ale w AI dwa lata to historia starożytna.

Wypróbowałem dialog z ChatGPT — scenariusz eksploratora kosmosu science fiction — który nie różni się od tego, co można znaleźć na typowych zajęciach improwizacji. ChatGPT jest znacznie lepszy w „tak, i-ing” niż to, co zrobiliśmy, ale tak naprawdę wcale nie zwiększyło to dramaturgii. Czułem się, jakbym dźwigał wszystkie ciężary.

Po kilku poprawkach sprawiłem, że było to trochę bardziej zaangażowane i pod koniec dnia poczułem, że było to całkiem niezłe ćwiczenie dla mnie, który nie robił wiele improwizacji, odkąd ukończyłem studia ponad 20 lat temu .

Jasne, nie chciałbym, aby ChatGPT pojawiał się w „Czyja to linijka w ogóle?” i nie jest to świetna fabuła „Star Trek” (choć nadal jest mniej problematyczna niż „Kodeks honorowy”), ale ile razy siadałeś, żeby napisać coś od zera i przerażała cię pusta kartka przed tobą? Rozpoczęcie od złego pierwszego szkicu może przełamać blokadę twórczą i pobudzić kreatywność, a ChatGPT i duże modele językowe wydają się być odpowiednimi narzędziami do pomocy w tych ćwiczeniach.

A jeśli chodzi o maszynę zaprojektowaną do generowania ciągów słów, które brzmią najlepiej, jak to możliwe w odpowiedzi na słowa, które jej podajesz — a nie do dostarczania informacji — wydaje się to właściwym zastosowaniem tego narzędzia.

Artykuł został opublikowany ponownie Konwersacje na licencji Creative Commons. Przeczytać oryginalny artykuł.

Kredytowych Image: Justyna Ha / Unsplash

- Dystrybucja treści i PR oparta na SEO. Uzyskaj wzmocnienie już dziś.

- Platoblockchain. Web3 Inteligencja Metaverse. Wzmocniona wiedza. Dostęp tutaj.

- Źródło: https://singularityhub.com/2023/02/05/chatgpt-is-great-youre-just-using-it-wrong/

- 1

- 20 roku

- a

- zdolność

- Zdolny

- O nas

- precyzja

- dokładny

- Po

- AI

- AID

- Wszystkie kategorie

- już

- kwoty

- analiza

- Starożytny

- i

- Inne

- odpowiedzi

- zjawić się

- artykuł

- autor

- Autorzy

- Autorstwo

- Łazienka

- na podstawie

- Ulepsz Swój

- Blokować

- książka

- Książki

- Bot

- boty

- kupiony

- przerwa

- Pęczek

- nazywa

- zdobyć

- na pewno

- znaków

- chatbot

- ChatGPT

- roszczenie

- twierdził,

- roszczenia

- klasa

- koledzy

- Studentki

- Collins

- COM

- jak

- wspólny

- Lud

- skarg

- ufnie

- treść

- Rozmowa

- poprawione

- kurs

- Stwórz

- Twórczy

- kredyt

- krytyczny

- Aktualny

- dane

- dzień

- Dni

- lat

- zaprojektowany

- Dialog

- ZROBIŁ

- różne

- cyfrowy

- Oddalić

- dokumenty

- Nie

- robi

- nie

- na dół

- projekt

- Dramat

- podczas

- błąd

- Ćwiczenie

- eksploracja

- badacz

- Faktyczny

- znakomicie

- kilka

- Fikcja

- pole

- wzorzysty

- W końcu

- Znajdź

- i terminów, a

- wadliwe

- Płynący

- Formalnie

- Dawny

- formularze

- znaleziono

- od

- z przodu

- wygenerowane

- otrzymać

- miejsce

- Dać

- dany

- będzie

- dobry

- dobra praca

- wspaniały

- Zielony

- Pół

- Zaoszczędzić

- pomoc

- henry

- historia

- W jaki sposób

- Jednak

- HTML

- HTTPS

- pomysł

- obraz

- in

- Włącznie z

- niepoprawnie

- Informacja

- zamiast

- wzajemne oddziaływanie

- Internet

- zaangażowany

- IT

- samo

- Praca

- Trzymać

- Uprzejmy

- znany

- język

- duży

- Biblioteka

- Licencja

- życie

- Modernizacja

- Prawdopodobnie

- Lincoln

- Linia

- Lista

- mało

- poszukuje

- maszyna

- robić

- producent

- wiele

- Maksymalna szerokość

- błąd

- model

- modele

- zmodyfikowano

- jeszcze

- większość

- Nazwy

- prawie

- Następny

- numer

- z naszej

- ONE

- OpenAI

- Inne

- Przeszłość

- Paweł

- Ludzie

- plato

- Analiza danych Platona

- PlatoDane

- do przyjęcia

- punkt

- możliwy

- prezydent

- prezydencki

- Prezydenci

- bardzo

- prawdopodobieństwo

- produkować

- zapewniać

- pod warunkiem,

- opublikowany

- położyć

- pytania

- Czytaj

- rozsądny

- powtórzony

- raport

- Odpowiadać

- odpowiedź

- REST

- Efekt

- ujawniać

- Ujawnił

- ROBERT

- run

- Powiedział

- taki sam

- scena

- nauka

- Fantastyka naukowa

- Ekran

- wydaje

- usługa

- powinien

- ponieważ

- sytuacje

- trochę inny

- So

- kilka

- coś

- syn

- Dźwięk

- Źródło

- Typ przestrzeni

- eksploracja kosmosu

- stoisko

- początek

- Startowy

- oświadczenia

- Nadal

- Zatrzymuje

- historie

- student

- system

- Brać

- trwa

- Mówić

- rozmawiać

- Połączenia

- ich

- rzeczy

- trzy

- Przez

- czas

- czasy

- tytuły

- do

- razem

- narzędzie

- narzędzia

- przeszkolony

- Trening

- prawdziwy

- Zaufaj

- typowy

- dla

- us

- posługiwać się

- zweryfikować

- weryfikacja

- Co

- czy

- który

- KIM

- będzie

- słowo

- słowa

- by

- napisać

- pisarz

- napisany

- Źle

- lat

- siebie

- youtube

- zefirnet