Jay'a Dawaniego jest współzałożycielem i dyrektorem generalnym w firmie Laboratoria lemuryjskie, start-up rozwijający platformę przyspieszonego przetwarzania dostosowaną specjalnie do zastosowań AI. Platforma przełamuje bariery sprzętowe, dzięki czemu rozwój sztucznej inteligencji jest szybszy, tańszy, bardziej zrównoważony i dostępny dla więcej niż kilku firm.

Przed założeniem firmy Lemurian Jay założył dwie inne firmy działające w obszarze sztucznej inteligencji. Jest także autorem najwyżej ocenianej książki „Matematyka dla głębokiego uczenia się".

Ekspert w dziedzinie sztucznej inteligencji, robotyki i matematyki, Jay pełnił funkcję dyrektora technologicznego BlocPlay, spółki publicznej budującej platformę do gier opartą na blockchain, a także pełnił funkcję dyrektora ds. sztucznej inteligencji w GEC, gdzie kierował rozwojem kilku projektów klientów obejmujących obszary od handlu detalicznego, handlu algorytmicznego, składania białek, robotów do eksploracji kosmosu, systemów rekomendacji i nie tylko. W wolnym czasie był także doradcą w NASA Frontier Development Lab, Spacebit i SiaClassic.

Ostatnim razem, gdy gościliśmy Lemurian Labs, skupialiście się na robotyce i brzegowej sztucznej inteligencji. Teraz koncentrujesz się na centrum danych i infrastrukturze chmurowej. Co się stało, że chciałeś się przestawić?

Rzeczywiście, przeszliśmy od skupiania się na budowaniu systemu na chipie o wysokiej wydajności i niskim opóźnieniu do zastosowań autonomicznych w robotyce, który mógłby przyspieszyć całą pętlę sens-plan-działanie, do zbudowania specyficznego dla domeny akceleratora dla sztucznej inteligencji, koncentrującego się na zastosowaniach w skali centrum danych . Ale to nie był zwykły obrót; był to wyraźny telefon, na który czuliśmy się zobowiązani odpowiedzieć.

W 2018 roku pracowaliśmy nad wytrenowaniem modelu parametrycznego o wartości 2.1 miliarda dolarów, ale porzuciliśmy ten wysiłek, ponieważ koszt był tak niezwykle wysoki, że nie mogliśmy go uzasadnić. Wyobraźcie sobie zatem moje zdziwienie, że GPT3, który OpenAI wypuścił jako ChatGPT w listopadzie 2022 r., był modelem parametrycznym wartym 175 miliardów dolarów. Ten model jest ponad 80 razy większy niż ten, nad którym pracowaliśmy zaledwie 4 lata wcześniej, co jest zarówno ekscytujące, jak i przerażające.

Koszt wyszkolenia takiego modelu jest, delikatnie mówiąc, porażający. Bazując na obecnych trendach skalowania, możemy spodziewać się, że koszt szkolenia pionierskiego modelu sztucznej inteligencji w niedalekiej przyszłości przekroczy miliard dolarów. Choć możliwości tych modeli będą zdumiewające, koszt jest absurdalnie wysoki. Bazując na tej trajektorii, tylko kilka bardzo dobrze wyposażonych firm posiadających własne centra danych będzie mogło sobie pozwolić na szkolenie, wdrażanie i dostrajanie tych modeli. Nie dzieje się tak wyłącznie dlatego, że obliczenia są drogie i energochłonne, ale także dlatego, że stosy oprogramowania, na których polegamy, nie zostały zbudowane dla tego świata.

Ze względu na ograniczenia geograficzne i energetyczne jest tylko określona liczba miejsc do budowy centrów danych. Aby sprostać wymaganiom obliczeniowym sztucznej inteligencji, musimy być w stanie budować maszyny w skali zetta bez konieczności zasilania ich 20 reaktorami jądrowymi. Potrzebujemy bardziej praktycznego, skalowalnego i ekonomicznego rozwiązania. Rozglądaliśmy się i nie widzieliśmy nikogo, kto byłby w stanie rozwiązać ten problem. Poszliśmy więc do deski kreślarskiej, aby spojrzeć na problem całościowo jako na system systemów i wywnioskować rozwiązanie na podstawie pierwszych zasad. Zadaliśmy sobie pytanie, jak zaprojektowalibyśmy cały stos, od oprogramowania po sprzęt, gdybyśmy musieli ekonomicznie obsługiwać 10 miliardów zapytań LLM dziennie. Do 200 roku skupiliśmy się na maszynie w skali zetty o mocy poniżej 2028 MW.

Sztuka polega na tym, aby spojrzeć na to z punktu widzenia nieproporcjonalnego skalowania – różne części systemu podlegają różnym zasadom skalowania, więc w pewnym momencie wszystko po prostu przestaje działać, zaczyna się psuć lub kompromis między kosztami i korzyściami nie ma już sensu. W takiej sytuacji jedyną opcją jest przeprojektowanie systemu. Nasza ocena i rozwiązanie obejmują całościowo obciążenie pracą, system liczbowy, model programowania, kompilator, środowisko wykonawcze i sprzęt.

Na szczęście nasi obecni inwestorzy i reszta rynku dostrzegają tę wizję, dlatego zebraliśmy rundę zalążkową o wartości 9 milionów dolarów na opracowanie naszego formatu liczbowego – PAL, aby zbadać przestrzeń projektową i połączyć architekturę dla naszego akceleratora specyficznego dla domeny oraz zaprojektować nasz kompilator i środowisko wykonawcze. W symulacjach udało nam się osiągnąć 20-krotny wzrost przepustowości przy mniejszym zużyciu energii w porównaniu z nowoczesnymi procesorami graficznymi i przewidujemy, że będziemy w stanie zapewnić 8-krotny wzrost wydajności systemu przy całkowitym koszcie posiadania w przypadku tej samej technologii tranzystorowej.

Nie trzeba dodawać, że mamy przed sobą dużo pracy, ale jesteśmy bardzo podekscytowani perspektywą możliwości przedefiniowania ekonomii centrów danych, aby zapewnić przyszłość, w której sztuczna inteligencja będzie powszechnie dostępna.

To z pewnością brzmi ekscytująco, a te liczby robią wrażenie. Ale wspomniałeś o systemach liczbowych, sprzęcie, kompilatorach i środowiskach wykonawczych jako o wszystkich rzeczach, na których się koncentrujesz – wydaje się, że dla każdej firmy jest to dużo do podjęcia na raz. Wydaje się to bardzo ryzykowną propozycją. Czy startupy nie powinny być bardziej skoncentrowane?

Brzmi to jak wiele różnych wysiłków, ale w rzeczywistości jest to jeden wysiłek składający się z wielu wzajemnie powiązanych części. Rozwiązanie tylko jednego z tych elementów w oderwaniu od pozostałych jedynie zaszkodzi potencjałowi innowacji, ponieważ spowoduje przeoczenie systemowych nieefektywności i wąskich gardeł. Jensen Huang ujął to najlepiej: „Aby być firmą korzystającą z przyspieszonego przetwarzania danych, trzeba być firmą oferującą pełny pakiet rozwiązań” i całkowicie się z tym zgadzam. Nie bez powodu są obecnym liderem na rynku. Jednak kwestionowałbym pogląd, że nie jesteśmy skupieni. Skupiamy się na tym, jak podchodzimy do problemu całościowo i jak najlepiej go rozwiązać dla naszych klientów.

Wymaga to multidyscyplinarnego podejścia, takiego jak nasze. Każda część naszej pracy informuje i wspiera pozostałe, umożliwiając nam stworzenie rozwiązania, które jest czymś więcej niż sumą jego części. Wyobraź sobie, że musisz zbudować samochód wyścigowy. Nie wybrałbyś arbitralnie podwozia, dodałbyś opon wyścigowych, wrzuciłbyś najmocniejszy silnik, jaki możesz znaleźć i ścigał się nim, prawda? Można by pomyśleć o aerodynamice nadwozia samochodu, aby zmniejszyć opór powietrza i zwiększyć siłę docisku, zoptymalizować rozkład masy w celu zapewnienia dobrego prowadzenia, zaprojektować silnik na zamówienie w celu uzyskania maksymalnych osiągów, uzyskać układ chłodzenia zapobiegający przegrzaniu, wyposażyć klatkę bezpieczeństwa w celu zapewnienia bezpieczeństwa kierowcy itp. Każdy z tych elementów opiera się na drugim i informuje o nim.

To powiedziawszy, próba zrobienia tego wszystkiego na raz w przypadku dowolnej firmy z dowolnej branży jest ryzykowna. Aby zarządzać ryzykiem, stosujemy podejście etapowe, co pozwala nam zweryfikować naszą technologię u klientów i w razie potrzeby dostosować naszą strategię. Udowodniliśmy, że nasz format liczbowy działa i ma lepszy obszar wydajności mocy niż równoważne typy zmiennoprzecinkowe, a jednocześnie ma lepsze właściwości numeryczne, które ułatwiają kwantyzację sieci neuronowych do mniejszych szerokości bitowych. Zaprojektowaliśmy architekturę, w której czujemy się pewnie, i która nadaje się zarówno do uczenia, jak i wnioskowania. Ale ważniejsze niż to wszystko jest odpowiednie oprogramowanie i na tym skupiamy się obecnie. Musimy mieć pewność, że podejmujemy właściwe decyzje dotyczące naszego stosu oprogramowania w sytuacji, w której widzimy świat za rok, dwa lub więcej od dzisiaj.

Budowa firmy produkującej sprzęt jest trudna, kosztowna i zajmuje dużo czasu. Skupienie się na oprogramowaniu wydaje się samo w sobie bardzo opłacalnym biznesem i potencjalnie bardziej atrakcyjnym dla inwestorów w obecnej sytuacji. Dlaczego zajmujecie się także sprzętem, skoro tak wiele dobrze finansowanych firm w branży zamyka swoje drzwi, walcząc o przyjęcie przez klientów, a więksi gracze budują własny sprzęt?

Masz całkowitą rację, że firmy produkujące oprogramowanie są na ogół w stanie pozyskać kapitał znacznie łatwiej niż firmy produkujące sprzęt, a ten sprzęt jest bardzo wytrzymały. Obecnie skupiamy się głównie na oprogramowaniu, ponieważ tam widzimy większy problem. Żeby było jasne, problemem nie jest to, czy uda mi się uruchomić jądra na CPU lub GPU z dużą wydajnością; to dawno rozwiązany problem. Dzisiejszy problem polega na tym, jak ułatwić programistom uzyskanie większej wydajności w sposób produktywny z kilku tysięcy klastrów węzłów składających się z heterogenicznych zasobów obliczeniowych, bez konieczności zmiany ich przepływu pracy.

To jest problem, na którym obecnie koncentrujemy się, aby rozwiązać za pomocą stosu oprogramowania, który daje programistom supermoce i odblokowuje pełne możliwości komputerów magazynowych, dzięki czemu możemy bardziej ekonomicznie szkolić i wdrażać modele sztucznej inteligencji.

Jeśli chodzi o inwestycje, tak, VC są bardziej selektywne pod względem rodzaju wspieranych firm, ale oznacza to również, że VC szukają firm z potencjałem do oferowania naprawdę przełomowych produktów, które mają jasną ścieżkę do komercjalizacji, a jednocześnie mają znaczący wpływ. Wyciągnęliśmy wnioski z wyzwań i błędów innych oraz aktywnie opracowaliśmy nasz model biznesowy i plan działania, aby zaradzić ryzyku. Należy również pamiętać, że sukces startupów rzadko wynika z łatwości, z jaką mogą pozyskać fundusze VC, ale bardziej z ich zaradności, uporu i skupienia na kliencie.

I zanim zapytasz, nadal pracujemy nad sprzętem, ale obecnie głównie nad symulacją. Nie mamy zamiaru nagrywać przez jakiś czas. Ale tę rozmowę możemy zachować na inny raz.

Jest to z pewnością przekonujące, a Twoje etapowe podejście znacznie różni się od tego, co widzieliśmy u innych producentów sprzętu. Rozumiem problem, o którym mówisz, że Twój stos oprogramowania rozwiąże, ale w jaki sposób Twoje oprogramowanie różni się od różnych rozwiązań dostępnych na rynku?

Większość firm, o których mówisz, koncentruje się na ułatwianiu programowania procesorów graficznych poprzez wprowadzenie modeli programowania opartych na kafelkach lub mapowaniu zadań w celu uzyskania większej wydajności z procesorów graficznych lub na tworzeniu nowych języków programowania w celu uzyskania jąder o wysokiej wydajności zaplanowanych na różnych platformy z obsługą montażu liniowego. To ważne problemy, którymi się zajmują, ale my postrzegamy problem, który rozwiązujemy, jako prawie ortogonalny.

Zastanówmy się przez chwilę nad rytmem zmian sprzętu i oprogramowania. Architektury jednordzeniowe zyskały wydajność dzięki szybkości zegara i gęstości tranzystorów, ale ostatecznie prędkości zegara osiągnęły plateau. Równoległość przy użyciu wielu rdzeni obeszła ten problem i zapewniła znaczne przyspieszenia. Oprogramowanie zajęło około dziesięciu lat, aby nadrobić zaległości, ponieważ modele programowania, kompilatory i środowiska wykonawcze musiały zostać ponownie przemyślane, aby pomóc programistom wydobyć wartość z tego paradygmatu. Następnie procesory graficzne zaczęły stawać się akceleratorami ogólnego przeznaczenia, ponownie z innym modelem programowania. Ponownie, wydobycie tutaj wartości zajęło programistom prawie dekadę.

Ponownie sprzęt osiąga plateau – prawo Moore’a, ograniczenia energetyczne i termiczne, wąskie gardła pamięci i różnorodność obciążeń oraz potrzeba wykładniczo większej mocy obliczeniowej popychają nas w kierunku tworzenia coraz bardziej heterogenicznych architektur komputerowych w celu uzyskania lepszej wydajności, wydajności i całkowitych kosztów. Ta zmiana w sprzęcie stworzy oczywiście wyzwania dla oprogramowania, ponieważ nie mamy odpowiednich kompilatorów i środowisk wykonawczych, aby wspierać kolejną ewolucję informatyki. Tym razem jednak nie powinniśmy czekać kolejnych 10 lat, aż oprogramowanie wydobędzie wartość z heterogenicznych architektur lub dużych klastrów, zwłaszcza gdy są one niewykorzystane w ponad 80%.

Koncentrujemy się na budowaniu modelu programowania uwzględniającego heterogeniczność z równoległością opartą na zadaniach, uwzględnieniu wydajności przenośnej za pomocą optymalizacji między procesorami, kompilacji uwzględniającej kontekst i dynamicznej alokacji zasobów. A dla nas nie ma znaczenia, czy jest to CPU, GPU, TPU, SPU (architektura Lemuriana), czy też siatka ich wszystkich. Wiem, że to brzmi jak wiele fantazyjnych słów, ale tak naprawdę oznacza to, że umożliwiliśmy zaprogramowanie dowolnego rodzaju procesora za pomocą jednego podejścia i możemy przenosić kod z jednego rodzaju procesora na inny przy minimalnym wysiłku bez konieczności poświęcania wydajności i planowania pracy adaptacyjnie i dynamicznie pomiędzy węzłami.

Jeśli to, co mówisz, jest prawdą, możesz po prostu całkowicie przedefiniować informatykę. Porozmawiajmy o finansowaniu. W zeszłym roku zebraliście 9 milionów dolarów w formie kapitału zalążkowego, co oznacza silne wsparcie inwestorów i wiarę w waszą wizję. Co zrobiłeś od tego czasu?

W ciągu ostatniego roku, dzięki funduszom zalążkowym, poczyniliśmy znaczne postępy. Nasz zespół liczący obecnie 20 członków skrupulatnie stawiał czoła wyzwaniom, nawiązywał kontakty z klientami i udoskonalał nasze podejście.

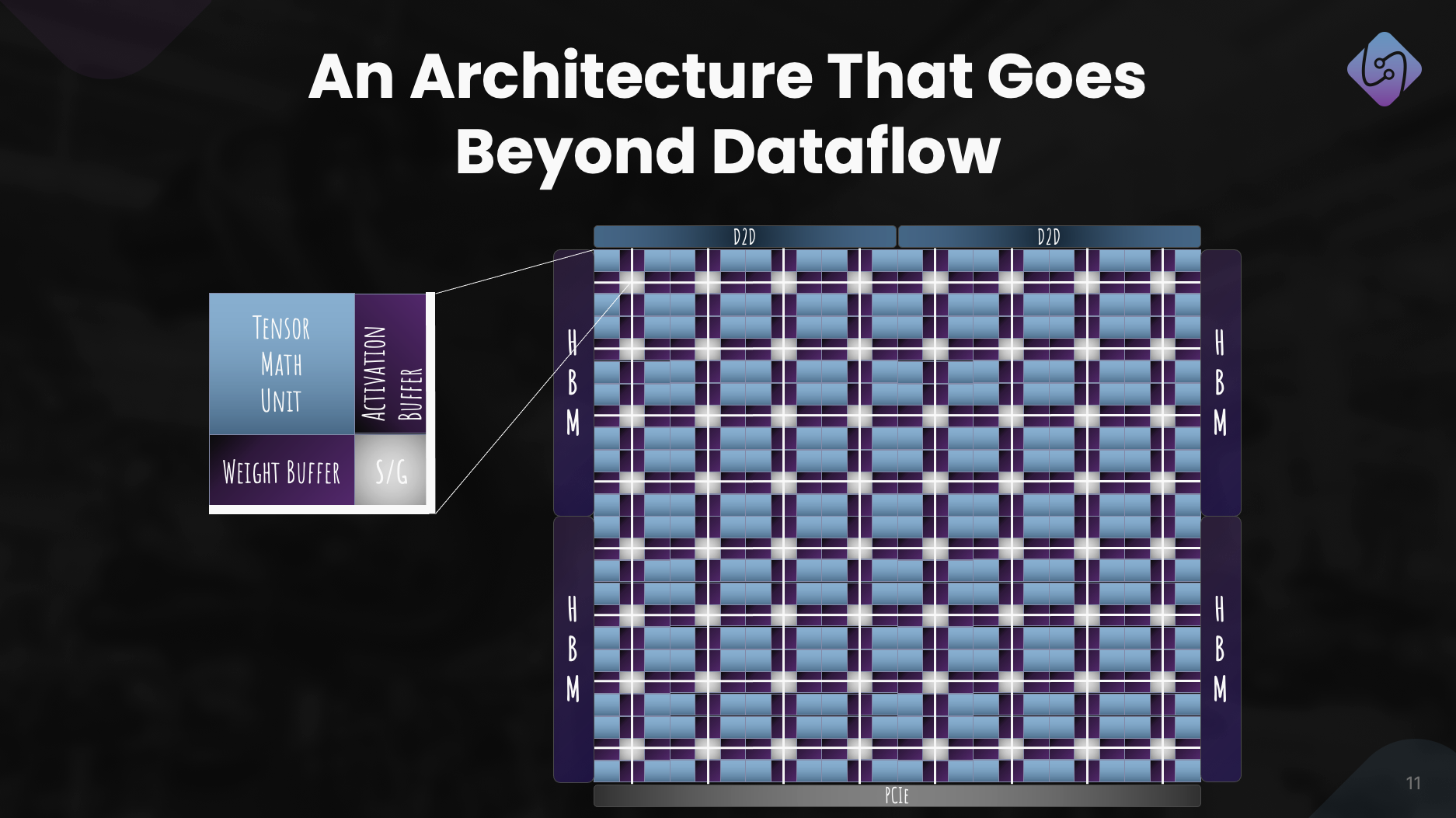

Skoncentrowaliśmy się na udoskonaleniu PAL na potrzeby uczenia i wnioskowania, zbadaliśmy architekturę komputera na potrzeby naszego akceleratora i opracowaliśmy symulator metryk wydajności. Jednocześnie przeprojektowaliśmy nasz stos oprogramowania do zastosowań w centrach danych, kładąc nacisk na przetwarzanie heterogeniczne.

Wysiłki te zaowocowały dobrze zdefiniowaną architekturą, prezentującą skuteczność PAL w zakresie sztucznej inteligencji na dużą skalę. Oprócz postępu technologicznego kontynuowaliśmy współpracę i działania informacyjne w celu demokratyzacji dostępu. Wysiłki te pozwalają firmie Lemurian Labs stawić czoła bezpośrednim wyzwaniom klientów, przygotowując się na wypuszczenie naszego produkcyjnego krzemu.

Jakie są średnioterminowe plany Lemurian Labs dotyczące rozwoju stosu oprogramowania, współpracy i udoskonalenia architektury akceleratora?

Naszym bezpośrednim celem jest stworzenie stosu oprogramowania przeznaczonego dla procesorów, procesorów graficznych i naszych akceleratorów AI o przenośnej wydajności, który zostanie udostępniony wczesnym partnerom pod koniec roku. Obecnie prowadzimy rozmowy z większością wiodących producentów półprzewodników, dostawcami usług w chmurze, firmami zajmującymi się hiperskalerami i sztuczną inteligencją, aby zapewnić im dostęp do naszego kompilatora i środowiska wykonawczego. Równolegle kontynuujemy prace nad i udoskonalamy architekturę naszego akceleratora, aby uzyskać prawdziwie wspólnie zaprojektowany system sprzętu i oprogramowania. I oczywiście właśnie zaczęliśmy podnosić naszą serię A przy bardzo dużym zainteresowaniu społeczności inwestorów, co umożliwi nam powiększenie naszego zespołu i osiągnięcie naszego celu w zakresie dostarczania oprogramowania pod koniec roku.

Podsumowując, jak postrzegasz wkład Lemurian Labs w zmianę krajobrazu rozwoju sztucznej inteligencji, dostępności i równości w nadchodzących latach?

Nie chcieliśmy na nowo zdefiniować informatyki wyłącznie w celach komercyjnych lub dla zabawy. Jako Lemurianie naszą siłą napędową jest wiara w transformacyjny potencjał sztucznej inteligencji i to, że więcej niż kilka firm powinno dysponować zasobami, aby określić przyszłość tej technologii i sposobu jej wykorzystania. Nie możemy również zaakceptować faktu, że infrastruktura centrów danych dla sztucznej inteligencji będzie na dobrej drodze do zużycia aż 20% światowej energii do 2030 r. Wszyscy zebraliśmy się, ponieważ wierzymy, że społeczeństwo może wybrać lepszą drogę naprzód, jeśli uda nam się Sztuczna inteligencja stanie się bardziej dostępna dzięki radykalnemu obniżeniu związanych z nią kosztów, przyspieszeniu tempa innowacji w zakresie sztucznej inteligencji i zwiększeniu jej wpływu. Podejmując wyzwania związane z obecną infrastrukturą sprzętową, staramy się utorować drogę do wyposażenia miliarda ludzi w możliwości sztucznej inteligencji, zapewniając sprawiedliwą dystrybucję tej zaawansowanej technologii. Mamy nadzieję, że nasze zaangażowanie w rozwiązania skoncentrowane na produktach, współpracę i ciągłe innowacje sprawi, że staniemy się siłą napędową w pozytywnym kształtowaniu przyszłości rozwoju sztucznej inteligencji.

Przeczytaj także:

Udostępnij ten post przez:

- Dystrybucja treści i PR oparta na SEO. Uzyskaj wzmocnienie już dziś.

- PlatoData.Network Pionowe generatywne AI. Wzmocnij się. Dostęp tutaj.

- PlatoAiStream. Inteligencja Web3. Wiedza wzmocniona. Dostęp tutaj.

- PlatonESG. Węgiel Czysta technologia, Energia, Środowisko, Słoneczny, Gospodarowanie odpadami. Dostęp tutaj.

- Platon Zdrowie. Inteligencja w zakresie biotechnologii i badań klinicznych. Dostęp tutaj.

- Źródło: https://semiwiki.com/ceo-interviews/341485-ceo-interview-jay-dawani-of-lemurian-labs-2/

- :ma

- :Jest

- :nie

- :Gdzie

- $ 9 mln

- $W GÓRĘ

- 1

- 10

- 20

- 2018

- 2022

- 2028

- 2030

- 20x

- 300

- 4

- a

- Zdolny

- O nas

- absolutnie

- przyśpieszyć

- przyśpieszony

- akcelerator

- akceleratory

- do przyjęcia

- dostęp

- dostępność

- dostępny

- Osiągać

- w poprzek

- aktywnie

- Dodaj

- adres

- zaadresowany

- adresowanie

- dostosować

- Przyjęcie

- zaawansowany

- Zaawansowana technologia

- postępy

- doradca

- ponownie

- przed

- AI

- Modele AI

- algorytmiczny

- handel algorytmiczny

- Wszystkie kategorie

- przydział

- Pozwalać

- prawie

- również

- Amazonka

- an

- i

- Inne

- odpowiedź

- każdy

- ktoś

- pociągający

- aplikacje

- podejście

- dowolnie

- architektura

- architektur

- SĄ

- obszary

- na około

- sztuczny

- sztuczna inteligencja

- AS

- zapytać

- pytanie

- Montaż

- oszacowanie

- powiązany

- zdumiewający

- At

- autor

- autonomiczny

- dostępny

- z powrotem

- bariery

- na podstawie

- BE

- bo

- staje

- być

- zanim

- jest

- wiara

- uwierzyć

- korzyści

- BEST

- Ulepsz Swój

- Poza

- większe

- Miliard

- oparty na blockchain

- deska

- ciało

- obie

- wąskie gardła

- Przełamując

- przerwy

- poszerzać

- budować

- Budowanie

- Buduje

- wybudowany

- objętość

- biznes

- Model biznesowy

- biznes

- ale

- by

- Kadencja

- wezwanie

- oprawa ołowiana witrażu

- CAN

- Może uzyskać

- możliwości

- zdolność

- kapitał

- zapasy

- Centrum

- ceo

- Wywiad z prezesem

- na pewno

- wyzwanie

- wyzwania

- wymiana pieniędzy

- podwozie

- ChatGPT

- tańsze

- jasny

- klient

- Klimat

- zegar

- zamknięcie

- Chmura

- infrastruktura chmurowa

- Współzałożyciel

- kod

- współpraca

- współpraca

- przyjście

- handlowy

- komercjalizacja

- zobowiązanie

- społeczność

- Firmy

- sukcesy firma

- w porównaniu

- zniewalający

- kompilator

- całkowicie

- składniki

- obliczać

- komputer

- komputery

- computing

- pewność

- Ograniczenia

- konsumować

- kontynuować

- ciągły

- przyczyniając

- zbieżny

- Rozmowa

- rozmowy

- system chłodzenia

- skorygowania

- Koszty:

- mógłby

- kurs

- pokrycie

- CPU

- Stwórz

- Krzyż

- CTO

- Aktualny

- Obecnie

- zwyczaj

- na zamówienie

- klient

- Klientów

- dane

- Centrum danych

- Datacenter

- dzień

- dekada

- Decyzje

- głęboko

- określić

- dostarczyć

- dostawa

- wymagania

- zdemokratyzować

- gęstość

- rozwijać

- Wnętrze

- zaprojektowany

- rozwijać

- rozwinięty

- deweloperzy

- rozwijanie

- oprogramowania

- ZROBIŁ

- różne

- różnicować

- Dyrektor

- Odległy

- 分配

- Różnorodność

- do

- robi

- Nie

- robi

- dolarów

- domena

- zrobić

- nie

- Drzwi

- dramatycznie

- rysunek

- kierowca

- jazdy

- Spadek

- dynamiczny

- dynamicznie

- każdy

- Wcześniej

- Wcześnie

- łatwiej

- z łatwością

- ekonomicznie

- ekonomia

- krawędź

- skuteczność

- efektywność

- wysiłek

- starania

- Elementy

- podkreślając

- uprawniającej

- umożliwiać

- umożliwiając

- obejmuje

- zakończenia

- energia

- zaangażowany

- silnik

- wzmacniać

- wzmocnienie

- zapewnić

- zapewnienie

- Cały

- sprawiedliwy

- sprawiedliwość

- Równoważny

- szczególnie

- itp

- ostatecznie

- wszyscy

- ewolucja

- przekraczać

- podniecony

- ekscytujący

- Przede wszystkim system został opracowany

- oczekiwać

- drogi

- ekspert

- eksploracja

- odkryj

- zbadane

- wykładniczo

- wyciąg

- niezwykle

- fakt

- fantazyjny

- daleko

- szybciej

- polecane

- czuć

- błąd

- kilka

- Znajdź

- i terminów, a

- unoszący się

- Skupiać

- koncentruje

- skupienie

- obserwuj

- Ślad stopy

- W razie zamówieenia projektu

- wytrzymałość

- format

- Naprzód

- Założony

- założenie

- od

- Granica

- podsycane

- pełny

- Pełny stos

- w pełni

- zabawa

- Finansowanie

- przyszłość

- Przyszłość AI

- Wzrost

- zdobyte

- gier

- platforma do gier

- mechanizm napędowy

- Ogólne

- ogólnie

- geograficzny

- otrzymać

- miejsce

- Dać

- dany

- daje

- cel

- będzie

- dobry

- got

- GPU

- GPU

- przełomowy

- Rosnąć

- miał

- garstka

- Prowadzenie

- się

- dzieje

- sprzęt komputerowy

- Have

- mający

- he

- pomoc

- tutaj

- Wysoki

- utrudniać

- jego

- Dobranie (Hit)

- uderzanie

- nadzieję

- W jaki sposób

- How To

- HTTPS

- Huang

- Głodny

- i

- if

- obraz

- Natychmiastowy

- Rezultat

- ważny

- imponujący

- podnieść

- poprawa

- in

- coraz bardziej

- przemysł

- nieefektywności

- informuje

- Infrastruktura

- Innowacja

- Inteligencja

- Zamierzam

- połączone

- odsetki

- Wywiad

- wprowadzenie

- inwestycja

- inwestor

- Inwestorzy

- izolacja

- IT

- JEGO

- Jensena Huanga

- jpg

- właśnie

- Trzymać

- Uprzejmy

- Wiedzieć

- laboratorium

- Labs

- krajobraz

- Języki

- duży

- większe

- Nazwisko

- Ostatni rok

- Utajenie

- Prawo

- lider

- prowadzący

- dowiedziałem

- najmniej

- Doprowadziło

- niech

- lubić

- ll

- llm

- długo

- długi czas

- dłużej

- Popatrz

- wyglądał

- poszukuje

- Partia

- niski

- opuszczenie

- maszyna

- maszyny

- zrobiony

- robić

- WYKONUJE

- Dokonywanie

- zarządzanie

- wiele

- rynek

- Lider na rynku

- matematyka

- Materia

- Maksymalna szerokość

- maksymalny

- Może..

- me

- znaczy

- Poznaj nasz

- Użytkownicy

- Pamięć

- wzmiankowany

- jedynie

- siatka

- skrupulatnie

- Metryka

- milion

- minimalny

- błędy

- model

- modele

- Nowoczesne technologie

- moment

- jeszcze

- większość

- dużo

- multidyscyplinarny

- my

- NASA

- Potrzebować

- potrzebne

- potrzeba

- sieci

- Nerwowy

- sieci neuronowe

- Nowości

- Następny

- Nie

- węzeł

- węzły

- noty

- Pojęcie

- listopad

- już dziś

- jądrowy

- numer

- z naszej

- of

- oferta

- on

- pewnego razu

- ONE

- tylko

- OpenAI

- optymalizacje

- Optymalizacja

- Option

- or

- zamówienie

- zwykły

- Inne

- Pozostałe

- ludzkiej,

- sobie

- na zewnątrz

- zasięg

- koniec

- Remont

- własny

- własność

- Pokój

- paradygmat

- Parallel

- parametr

- część

- wzmacniacz

- strony

- Przeszłość

- ścieżka

- wybrukować

- Ludzie

- jest gwarancją najlepszej jakości, które mogą dostarczyć Ci Twoje monitory,

- Stopniowe

- wybierać

- Pivot

- Miejsca

- plany

- Platforma

- Platformy

- plato

- Analiza danych Platona

- PlatoDane

- plus

- punkt

- Punkt widzenia

- przenośny

- position

- Pozycje

- pozytywny

- możliwy

- Post

- potencjał

- potencjalnie

- power

- mocny

- Praktyczny

- bardzo

- zapobiec

- głównie

- Zasady

- Problem

- problemy

- przetwarzanie

- Procesor

- Produkt

- Produkcja

- Produkty

- Program

- Programowanie

- języki programowania

- projektowanie

- niska zabudowa

- propozycja

- Perspektywa

- Białko

- Sprawdzony

- pod warunkiem,

- dostawców

- publiczny

- czysto

- cel

- Popychanie

- zapytania

- Wyścig

- Bridgestone

- podnieść

- wychowywanie

- rzadko

- Czytaj

- naprawdę

- powód

- Rekomendacja

- przedefiniować

- renowacje

- zmniejszyć

- odnoszący się

- rafinowany

- w sprawie

- przeprojektowane

- zwolnić

- wydany

- polegać

- Wymaga

- Zasób

- Zasoby

- odpowiedzialność

- REST

- wynikał

- Efekt

- detaliczny

- prawo

- ryzyko

- ryzykowny

- mapa drogowa

- robotyka

- roboty

- Rolka

- w przybliżeniu

- okrągły

- reguły

- bieganie

- poświęcać

- "bezpiecznym"

- Powiedział

- taki sam

- Zapisz

- powiedzieć

- powiedzenie

- skalowalny

- Skala

- skalowaniem

- rozkład

- zaplanowane

- widzieć

- nasienie

- Finansowanie początkowe

- Runda nasienna

- Szukajcie

- wydaje

- widziany

- selektywny

- Semiconductor

- rozsądek

- Serie

- Seria A

- służyć

- służył

- usługa

- usługodawcy

- zestaw

- kilka

- modelacja

- przesunięcie

- powinien

- ściąganie

- Zabytki

- znaczący

- oznacza

- Krzem

- symulacja

- symulacje

- symulator

- jednocześnie

- ponieważ

- pojedynczy

- spory

- suwak

- mniejszy

- So

- Społeczeństwo

- Tworzenie

- rozwiązanie

- Rozwiązania

- ROZWIĄZANIA

- rozwiązany

- Rozwiązywanie

- kilka

- Dźwięk

- Dźwięki

- Typ przestrzeni

- eksploracja kosmosu

- Przestrzenne

- specyficzny

- swoiście

- prędkość

- prędkości

- stos

- Półki na książki

- oszałamiający

- początek

- rozpoczęty

- startup

- Startups

- Nadal

- Stop

- Strategia

- kroczy

- silny

- Walka

- udany

- taki

- odpowiedni

- suma

- wsparcie

- podpory

- domniemany

- niespodzianka

- zrównoważone

- system

- systemowy

- systemy

- dostosowane

- Brać

- trwa

- biorąc

- Mówić

- taśma

- cel

- cele

- zespół

- tech

- Technologia

- niż

- że

- Połączenia

- Przyszłość

- Krajobraz

- świat

- ich

- Im

- następnie

- Tam.

- termiczny

- Te

- one

- rzeczy

- myśleć

- to

- tych

- chociaż?

- tysiąc

- Przez

- wydajność

- czas

- Opony

- do

- już dziś

- razem

- także

- wziął

- Kwota produktów:

- trudny

- w kierunku

- śledzić

- Handel

- Pociąg

- Trening

- trajektoria

- transformacyjny

- przejście

- przejścia

- Trendy

- sztuczka

- prawdziwy

- naprawdę

- próbować

- drugiej

- typy

- dla

- zrozumieć

- jednostka

- odblokowuje

- na

- us

- posługiwać się

- za pomocą

- UPRAWOMOCNIĆ

- wartość

- różnorodny

- VC

- Finansowanie VC

- VC

- początku.

- przez

- wykonalne

- Zobacz i wysłuchaj

- wizja

- czekać

- chcieć

- Magazyn

- była

- we

- waga

- DOBRZE

- dobrze zdefiniowane

- poszedł

- były

- Co

- jeśli chodzi o komunikację i motywację

- czy

- który

- Podczas

- dlaczego

- będzie

- w

- bez

- słowa

- Praca

- workflow

- pracujący

- działa

- świat

- świat

- by

- rok

- lat

- tak

- ty

- Twój

- zefirnet