Nvidia zarabia na szaleństwie na sztuczną inteligencję, a jej układ A100 napędza większość aplikacji branżowych w ich wyścigu o dominację nad sztuczną inteligencją. Giganci technologiczni, tacy jak Microsoft i Google, ścigają się o włączenie technologii sztucznej inteligencji do swoich wyszukiwarek, podczas gdy firmy takie jak Stable Diffusion i OpenAI są już przed nami.

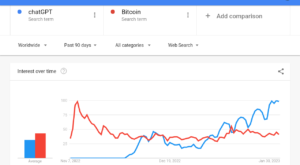

OpenAI wydało swoje ChatGPT w listopadzie do natychmiastowych fanfar, zmuszając inne firmy technologiczne do naśladowania go lub wymyślania konkurencyjnych produktów. Takie wysiłki wymagają dużej mocy obliczeniowej, a jako jedno z najbardziej krytycznych narzędzi dla branży sztucznej inteligencji, A100 firmy Nvidia odegrało kluczową rolę.

Przeczytaj także: Amerykańskie Biuro ds. Praw Autorskich mówi, że nie można mieć praw autorskich do obrazów generowanych przez sztuczną inteligencję

System operacyjny dzisiejszej sztucznej inteligencji

Natan Benaich, inwestor, który publikuje biuletyn poświęcony sztucznej inteligencji, mówi, że A100 stał się w tej chwili „kołem roboczym” dla profesjonalistów AI.

Według New Street Research Nvidia dominuje w 95% całego rynku procesorów graficznych, które można wykorzystać do uczenia maszynowego.

„Nvidia AI to zasadniczo system operacyjny dzisiejszych systemów AI” — powiedział Nvidia Dyrektor generalny Jensen Huang rozmawiał w środę z analitykami o zarobkach firmy.

A100 jest przystosowany do modeli uczenia maszynowego, które zasilają narzędzia takie jak ChatGPT, Bing AI lub Stable Diffusion. Może wykonywać jednocześnie wiele prostych obliczeń, co jest ważne przy trenowaniu i korzystaniu z modeli sieci neuronowych.

Podczas gdy firmy lubią Google i Amazon opracowują własne chipy specjalnie zaprojektowane do obciążeń AI, a Indeks obliczeniowy raportu o stanie AI wskazuje, że sprzęt AI pozostaje silnie skonsolidowany z Nvidią.

W grudniu ponad 21 000 artykułów o sztucznej inteligencji o otwartym kodzie źródłowym twierdziło, że używają chipów Nvidia. Co więcej, większość badaczy uwzględnionych w raporcie korzystała z V100, po raz pierwszy wprowadzonego na rynek w 2017 roku.

Przyszłość to zdecydowanie AI dla Nvidii

Nvidia spopularyzowany procesor graficzny (GPU) i uzyskuje zdecydowaną większość swoich przychodów z tych wyspecjalizowanych chipów. Firma projektuje i sprzedaje procesory graficzne do gier, wydobywania kryptowalut i zastosowań profesjonalnych, a także układy chipowe do użytku w pojazdach, robotyce i innych narzędziach.

Raport o zarobkach za czwarty kwartał, opublikowany w minioną środę, pokazuje ogólny spadek sprzedaży o 21%. Ale następnego dnia inwestorzy popchnęli cenę akcji o około 14%, głównie z powodu biznesu związanego ze sztuczną inteligencją.

Według zarobki zgłosić, dział chipów AI – Data Center – wzrósł o 11% do 3.62 miliarda dolarów w czwartym kwartale. Firma twierdzi, że wzrost był napędzany przez amerykańskich dostawców usług w chmurze, którzy kupowali więcej produktów.

Wzrost ChatGPT napędza akcje Nvidii.

Dyrektor generalny Nvidii, Jensen Huang, od dawna przygotowywał się do tej okazji.

To jest moment sztucznej inteligencji iPhone’a” – powiedział niedawno Huang.

Oto dlaczego inwestorzy są podekscytowani… 🧵 pic.twitter.com/3T74O3lrzF

- Jon Erlichman (@JonErlichman) 20 lutego 2023 r.

Patrząc na rok do 23 lutego, akcje wzrosły o 65%. Huang powiedział, że sztuczna inteligencja znajduje się w „punkcie przegięcia”, zmuszając firmy każdej wielkości do kupowania chipów w celu opracowania oprogramowania do nauki.

"generatywna sztuczna inteligencjaWszechstronność i możliwości tego rozwiązania wywołały w przedsiębiorstwach na całym świecie poczucie pilnej potrzeby opracowania i wdrożenia strategii sztucznej inteligencji” — powiedział Huang.

„Działalność związana z infrastrukturą sztucznej inteligencji, którą zbudowaliśmy, oraz działalność związana z wnioskowaniem za pomocą Hoppera i Ampere w celu wpływania na duże modele językowe, właśnie przeszła przez dach w ciągu ostatnich 60 dni” – dodał.

AI-as-a-service jest już w drodze

Firma ogłosiła również, że zacznie oferować opartą na chmurze opcję sztucznej inteligencji jako usługi, która pozwoli mniejszym firmom wykorzystać jej moc obliczeniową do szkolenia modeli sztucznej inteligencji, w tym takich, które leżą u podstaw ChatGPT.

Współzałożyciel Arete Research Center, Brett Simpson powiedział Yahoo Finance Live, że to coś więcej niż tylko ChatGPT.

„Ostatecznie intensywność sztucznej inteligencji jest znacznie większa niż konwencjonalne przetwarzanie. Myślę więc, że przychody związane ze sztuczną inteligencją będą wprost proporcjonalne do możliwości obliczeniowych, które tutaj widzimy. Obietnica technologii wykracza daleko poza chatbota, że tak powiem” – powiedział Simpson.

Redaktor ds. technologii Yahoo Finance Live, Daniel Howley, powiedział tymczasem: „Na razie przyszłość Nvidii jest bezpośrednio związana ze sztuczną inteligencją”.

Byczy sentyment do akcji

Szum wokół AI, ChatGPT i zdolności Nvidii do zarabiania na tym zaowocował pozytywnymi uwagami gigantów z Wall Street, takich jak Goldman Sachs.

Goldman Sachs powiedział, że „niewłaściwe” było siedzenie z boku w oczekiwaniu na pogorszenie się fundamentów firmy i podwyższył akcje z „neutralnego” do „kupuj” w czwartkowym komunikacie.

„Wierzymy, że przyspieszenie rozwoju/wdrażania sztucznej inteligencji w hiper-skalach, a także w przedsiębiorstwach, jeśli w ogóle, posłuży pozycji lidera firmy, ponieważ klienci z poczuciem pilności będą polegać na rozwiązaniach, które są skalowalne i dostępne” — powiedział Goldman .

Nvidia A100 została po raz pierwszy zaprezentowana w 2020 r., zanim droższy H100 pojawił się w 2022 r. Firma twierdzi jednak, że odnotowała większe przychody z H100 w chipach za kwartał kończący się w styczniu niż z A100.

Według Nvidii, H100 jest pierwszym z jej procesorów graficznych do centrów danych, który został zoptymalizowany pod kątem transformatorów, co jest coraz ważniejszą techniką, z której korzysta wiele najnowszych aplikacji AI.

Nvidia twierdzi, że chce przyspieszyć szkolenie AI o ponad milion procent. Porozmawiaj o prędkości warp.

- Dystrybucja treści i PR oparta na SEO. Uzyskaj wzmocnienie już dziś.

- Platoblockchain. Web3 Inteligencja Metaverse. Wzmocniona wiedza. Dostęp tutaj.

- Źródło: https://metanews.com/baidus-chatgpt-rival-ernie-bot-is-coming-in-march-says-ceo/?utm_source=rss&utm_medium=rss&utm_campaign=baidus-chatgpt-rival-ernie-bot-is-coming-in-march-says-ceo

- $3

- 000

- 10

- 2017

- 2020

- 2022

- 95%

- a

- A100

- zdolność

- O nas

- przyśpieszenie

- w poprzek

- działalność

- w dodatku

- przed

- AI

- Systemy SI

- Trening AI

- Wszystkie kategorie

- już

- Amazonka

- analitycy

- i

- ogłosił

- przewidywanie

- aplikacje

- na około

- sztuczny

- sztuczna inteligencja

- powiązany

- dostępny

- bo

- stają się

- zanim

- uwierzyć

- Poza

- Miliard

- Bing

- Bot

- kupiony

- wybudowany

- biznes

- biznes

- kupować

- wezwanie

- Centrum

- ceo

- chatbot

- ChatGPT

- żeton

- Frytki

- Chmura

- Współzałożyciel

- jak

- przyjście

- Firmy

- sukcesy firma

- Firma

- zniewalający

- obliczać

- computing

- Konwencjonalny

- prawo autorskie

- krytyczny

- Crypto

- wydobycie kryptograficzne

- Klientów

- Daniel

- dane

- Centrum danych

- dzień

- Dni

- grudzień

- upadek

- Zdecydowanie

- rozwijać

- zaprojektowany

- projekty

- rozwijać

- rozwijanie

- Transmitowanie

- bezpośrednio

- dominuje

- napędzany

- podczas

- Zarobki

- zarobki zadzwoń

- zarobki zgłosić

- redaktor

- starania

- silniki

- przedsiębiorstwa

- istotnie

- drogi

- szybciej

- finansować

- firmy

- i terminów, a

- następujący

- Czwarty

- od

- Podstawy

- dalej

- przyszłość

- gier

- Goes

- Goldman

- GPU

- GPU

- grafika

- większy

- Wzrost

- sprzęt komputerowy

- ciężki

- tutaj

- Howleya

- HTML

- HTTPS

- Szum

- Natychmiastowy

- ważny

- in

- włączony

- Włącznie z

- włączać

- coraz bardziej

- wskazuje

- przemysł

- wpływ

- Infrastruktura

- instrumentalny

- Inteligencja

- wprowadzono

- Investopedia

- inwestor

- Inwestorzy

- iPhone

- IT

- styczeń

- Jensena Huanga

- Uprzejmy

- język

- duży

- Nazwisko

- firmy

- Przywództwo

- nauka

- Dźwignia

- relacja na żywo

- długo

- maszyna

- uczenie maszynowe

- Większość

- robić

- wiele

- March

- rynek

- W międzyczasie

- Microsoft

- milion

- Górnictwo

- modele

- moment

- zarabiać

- jeszcze

- większość

- sieć

- Nerwowy

- sieci neuronowe

- Nowości

- Newsletter

- listopad

- Nvidia

- oferuje

- Biurowe

- ONE

- open source

- operacyjny

- system operacyjny

- Okazja

- zoptymalizowane

- Option

- Inne

- ogólny

- własny

- Papiery

- Przeszłość

- procent

- wykonać

- plato

- Analiza danych Platona

- PlatoDane

- punkt

- position

- pozytywny

- power

- Zasilanie

- przygotowanie

- Cena

- przetwarzanie

- Moc przetwarzania

- Procesory

- Produkty

- profesjonalny

- obietnica

- PROS

- dostawców

- Publikuje

- Zatrzymaj się

- popychany

- Popychanie

- Kwartał

- Wyścig

- Czytaj

- niedawno

- nagrany

- wydany

- szczątki

- raport

- wymagać

- Badania naukowe

- Badacze

- dochód

- Rosnąć

- Rywal

- robotyka

- dach

- ROSE

- Sachs

- Powiedział

- sole

- mówią

- skalowalny

- Szukaj

- Wyszukiwarki

- Sprzedaje

- rozsądek

- Poczucie pilności

- sentyment

- służyć

- usługa

- usługodawcy

- Share

- Targi

- Prosty

- rozmiary

- mniejszy

- So

- Tworzenie

- Rozwiązania

- mówić

- wyspecjalizowanym

- specjalnie

- prędkość

- stabilny

- początek

- zacznij oferować

- stany magazynowe

- strategie

- ulica

- strongly

- taki

- system

- systemy

- Mówić

- tech

- technologiczni giganci

- Technologia

- Połączenia

- świat

- ich

- Przez

- Związany

- do

- już dziś

- dzisiaj

- narzędzia

- Kwota produktów:

- Trening

- Transformatory

- rozsierdzony

- prawdziwy

- i twitterze

- jednostka

- zmodernizowane

- pilna sprawa

- us

- posługiwać się

- Naprawiono

- Pojazdy

- wall Street

- Wednesday

- który

- Podczas

- KIM

- będzie

- świat

- Yahoo

- Yahoo Finance

- rok

- zefirnet