Pierwszy startup Josha Lospinoso zajmujący się cyberbezpieczeństwem został przejęty w 2017 roku przez Raytheon/Forcepoint. Jego drugi, Shift5, współpracuje z armią amerykańską, przewoźnikami kolejowymi i liniami lotniczymi, w tym JetBlue. Absolwent West Point z 2009 roku i stypendysta Rhodes, 36-letni były kapitan armii spędził ponad dekadę autorskie narzędzia hakerskie dla Agencji Bezpieczeństwa Narodowego i US Cyber Command.

Lospinoso powiedział niedawno senackiej podkomisji Sił Zbrojnych, w jaki sposób sztuczna inteligencja może pomóc w ochronie operacji wojskowych. Dyrektor generalny / programista omówił ten temat z The Associated Press, a także o tym, jak luki w oprogramowaniu w systemach uzbrojenia są głównym zagrożeniem dla armii USA. Wywiad został zredagowany pod kątem jasności i długości.

P: W swoim zeznaniu opisałeś dwa główne zagrożenia dla technologii wykorzystujących sztuczną inteligencję: Jednym z nich jest kradzież. To oczywiste. Drugi to zatruwanie danych. Czy możesz to wyjaśnić?

O: Jednym ze sposobów myślenia o zatruwaniu danych jest dezinformacja cyfrowa. Jeśli przeciwnicy są w stanie wytworzyć dane, które widzą technologie obsługujące sztuczną inteligencję, mogą głęboko wpłynąć na sposób działania tej technologii.

P: Czy ma miejsce zatruwanie danych?

O: Nie patrzymy na to szeroko. Ale to się stało. Jeden z najbardziej znanych przypadków miał miejsce w 2016 roku. Microsoft wypuścił chatbota na Twitterze o nazwie Tay, który nauczył się z rozmów prowadzonych online. Złośliwi użytkownicy zmówili się, aby tweetować obraźliwy, obraźliwy język. Tay zaczął generować podżegające treści. Microsoft przełączył go w tryb offline.

P: AI to nie tylko chatboty. Od dawna jest integralną częścią cyberbezpieczeństwa, prawda?

Odp.: Sztuczna inteligencja jest używana w filtrach e-mail do próby oznaczania i segregowania niechcianej poczty i przynęt phishingowych. Innym przykładem są punkty końcowe, takie jak program antywirusowy na laptopie lub oprogramowanie do wykrywania złośliwego oprogramowania działające w sieci. Oczywiście ofensywni hakerzy również używają sztucznej inteligencji, aby spróbować pokonać te systemy klasyfikacji. To się nazywa wroga sztuczna inteligencja.

P: Porozmawiajmy o wojskowych systemach oprogramowania. Alarmujący rok 2018 Raport Government Accountability Office powiedział, że prawie wszystkie nowo opracowane systemy uzbrojenia miały krytyczne luki w zabezpieczeniach. A Pentagon myśli o umieszczeniu sztucznej inteligencji w takich systemach?

O: Są tu dwie kwestie. Po pierwsze, musimy odpowiednio zabezpieczyć istniejące systemy uzbrojenia. Mamy dług techniczny, którego spłacenie zajmie bardzo dużo czasu. Następnie pojawia się nowa granica zabezpieczania algorytmów sztucznej inteligencji – nowatorskie rzeczy, które byśmy zainstalowali. Raport GAO tak naprawdę nie mówił o sztucznej inteligencji. Więc zapomnij na chwilę o sztucznej inteligencji. Jeśli te systemy pozostałyby takie, jakie są, nadal są bardzo podatne na ataki.

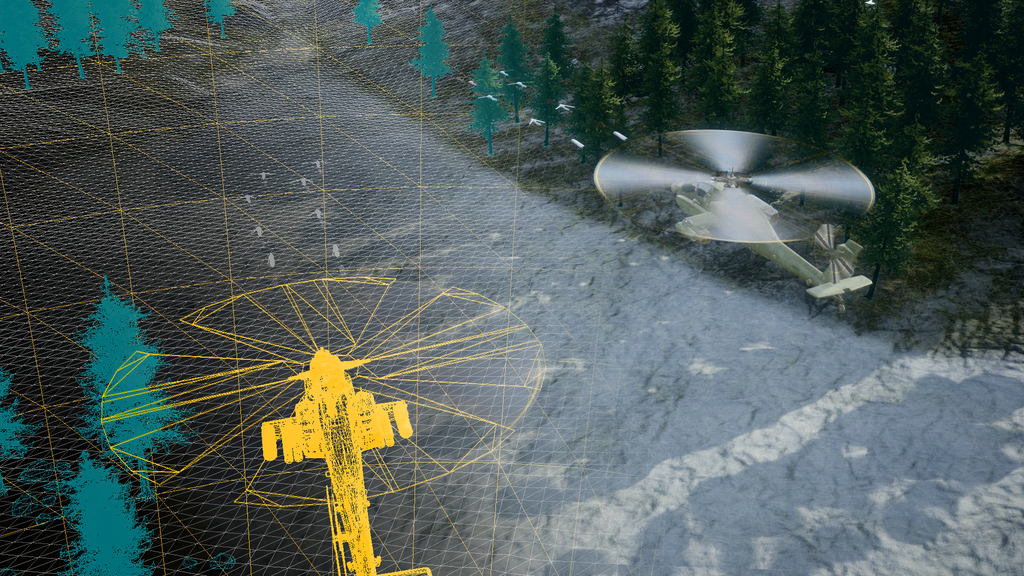

Dyskutujemy o przekroczeniu granic i dodaniu możliwości opartych na sztucznej inteligencji, takich jak ulepszona konserwacja i inteligencja operacyjna. Wszystko dobrze. Ale budujemy na szczycie domku z kart. Wiele systemów ma dziesiątki lat i zostało doposażonych w technologie cyfrowe. Samoloty, pojazdy naziemne, aktywa kosmiczne, okręty podwodne. Teraz są ze sobą połączone. Przekazujemy i wymieniamy dane. Systemy są porowate, trudne do ulepszenia i mogą zostać zaatakowane. Gdy atakujący uzyska dostęp, gra się kończy.

Czasami łatwiej jest zbudować nową platformę niż przeprojektować komponenty cyfrowe istniejących systemów. Ale sztuczna inteligencja odgrywa pewną rolę w zabezpieczaniu tych systemów. Sztucznej inteligencji można użyć do obrony, jeśli ktoś spróbuje ją skompromitować.

P: Zeznałeś, że wstrzymanie badań nad sztuczną inteligencją, jak niektórzy nalegali, byłoby złym pomysłem, ponieważ faworyzowałoby Chiny i innych konkurentów. Ale masz również obawy związane z gwałtownym pędem do produktów AI. Dlaczego?

Odp .: Nienawidzę brzmieć fatalistycznie, ale tak zwany przypadek „palenia” wydaje się mieć zastosowanie. Produkt w pośpiechu wprowadzany na rynek często się zapala (zhakowany, zawodzi, wyrządza niezamierzone szkody). A my mówimy: „Chłopcze, powinniśmy byli zbudować zabezpieczenia”. Spodziewam się, że tempo rozwoju sztucznej inteligencji przyspieszy i możemy nie zatrzymać się na tyle, aby zrobić to w bezpieczny i odpowiedzialny sposób. Przynajmniej Biały Dom i Kongres omawiają te kwestie.

P: Wygląda na to, że wiele firm – w tym z sektora obronnego – spieszy się z ogłoszeniem niedopracowanych produktów AI.

Odp.: Każda firma technologiczna i wiele firm niezwiązanych z technologią zrobiło niemal wstrząsający zwrot w kierunku sztucznej inteligencji. Nadchodzą ekonomiczne dyslokacje. Modele biznesowe zasadniczo się zmienią. Dyslokacje już się dzieją lub są na horyzoncie — a liderzy biznesowi starają się nie dać się złapać.

P: A co z wykorzystaniem sztucznej inteligencji w podejmowaniu decyzji wojskowych, takich jak namierzanie celów?

O: Nie sądzę, kategorycznie nie sądzę, że algorytmy sztucznej inteligencji – dane, które zbieramy – są gotowe do podejmowania decyzji przez śmiercionośny system broni. Po prostu jesteśmy od tego daleko.

- Dystrybucja treści i PR oparta na SEO. Uzyskaj wzmocnienie już dziś.

- PlatoAiStream. Analiza danych Web3. Wiedza wzmocniona. Dostęp tutaj.

- Wybijanie przyszłości w Adryenn Ashley. Dostęp tutaj.

- Kupuj i sprzedawaj akcje spółek PRE-IPO z PREIPO®. Dostęp tutaj.

- Źródło: https://www.defensenews.com/artificial-intelligence/2023/05/29/adversarial-ai-a-threat-to-military-systems-shift5s-lospinoso-says/

- :ma

- :Jest

- :nie

- 2016

- 2017

- 2018

- 70

- a

- Zdolny

- O nas

- przyśpieszyć

- dostęp

- odpowiedzialność

- nabyty

- dodanie

- odpowiednio

- przeciwny

- agencja

- AI

- ai badania

- samolot

- Linie lotnicze

- Algorytmy

- Wszystkie kategorie

- już

- również

- an

- i

- Ogłosić

- Inne

- antywirusowe

- Aplikuj

- SĄ

- uzbrojony

- Armia

- sztuczny

- sztuczna inteligencja

- AS

- Aktywa

- powiązany

- At

- Łazienka

- BE

- bo

- być

- rozpoczął

- szeroko

- budować

- Budowanie

- wybudowany

- Pęczek

- biznes

- ale

- by

- nazywa

- CAN

- możliwości

- Kartki okolicznosciowe

- walizka

- Etui

- złapany

- zmiana

- chatbot

- nasze chatboty

- Chiny

- klarowność

- klasyfikacja

- Zbieranie

- przyjście

- Firmy

- sukcesy firma

- konkurenci

- składniki

- kompromis

- Obawy

- Kongres

- zawartość

- rozmowy

- mógłby

- kurs

- rzemiosło

- krytyczny

- cyber

- Bezpieczeństwo cybernetyczne

- dane

- Dług

- dekada

- lat

- Podejmowanie decyzji

- Decyzje

- Obrona

- opisane

- Wykrywanie

- rozwinięty

- oprogramowania

- cyfrowy

- omówione

- Omawiając

- dezinformacja

- do

- robi

- łatwiej

- Gospodarczy

- dość

- Każdy

- przykład

- Przede wszystkim system został opracowany

- oczekiwać

- Wyjaśniać

- nie

- daleko

- faworyzować

- filtry

- natura

- i terminów, a

- W razie zamówieenia projektu

- Dawny

- od

- Granica

- zasadniczo

- Zyski

- gra

- GAO

- Generować

- otrzymać

- będzie

- wspaniały

- Ziemia

- hacked

- hakerzy

- włamanie

- miał

- się

- Wydarzenie

- Ciężko

- Have

- Na oślep

- pomoc

- tutaj

- jego

- horyzont

- dom

- W jaki sposób

- HTTPS

- i

- pomysł

- if

- zdjęcia

- Rezultat

- ulepszony

- in

- Włącznie z

- zainstalować

- integralny

- Inteligencja

- połączone

- Wywiad

- najnowszych

- problemy

- IT

- jetBlue

- właśnie

- język

- laptopa

- Przywódcy

- dowiedziałem

- najmniej

- Długość

- lubić

- długo

- długi czas

- zrobiony

- konserwacja

- poważny

- Dokonywanie

- malware

- wykrywanie złośliwego oprogramowania

- wiele

- rynek

- Microsoft

- może

- Wojsko

- Misja

- modele

- jeszcze

- O imieniu

- narodowy

- bezpieczeństwo narodowe

- National Security Agency

- prawie

- Potrzebować

- sieci

- Nowości

- Nowa platforma

- powieść

- już dziś

- miejsce

- of

- obraźliwy

- Biurowe

- nieaktywny

- często

- Stary

- on

- pewnego razu

- ONE

- Online

- działa

- operacyjny

- operacje

- operatorzy

- or

- Inne

- na zewnątrz

- koniec

- Pokój

- pauza

- Zapłacić

- pentagon

- phishing

- Pivot

- Platforma

- plato

- Analiza danych Platona

- PlatoDane

- punkt

- naciśnij

- premia

- Główny

- Produkt

- Produkty

- Program

- chronić

- Popychanie

- Putting

- Kolej

- gotowy

- naprawdę

- niedawno

- renowacje

- wydany

- raport

- Badania naukowe

- odpowiedzialny

- prawo

- Rola

- pędzić

- s

- Powiedział

- powiedzieć

- mówią

- druga

- sektor

- bezpieczne

- zabezpieczenia

- bezpieczeństwo

- widzieć

- widzenie

- wydaje

- Senat

- Usługi

- powinien

- So

- dotychczas

- Tworzenie

- kilka

- Ktoś

- Dźwięk

- Typ przestrzeni

- spędził

- startup

- został

- Nadal

- podkomitet

- przedmiot

- taki

- swapping

- system

- systemy

- Brać

- Mówić

- kierowania

- tech

- Firma technologiczna

- Techniczny

- Technologies

- Technologia

- zeznawał

- świadectwo

- niż

- że

- Połączenia

- kradzież

- Im

- następnie

- Tam.

- Te

- one

- rzeczy

- myśleć

- Myślący

- to

- tych

- groźba

- zagrożenia

- czas

- do

- wziął

- Top

- w kierunku

- próbować

- ćwierkać

- i twitterze

- drugiej

- nas

- uaktualnienie

- posługiwać się

- używany

- Użytkownicy

- Pojazdy

- początku.

- Luki w zabezpieczeniach

- Wrażliwy

- była

- Droga..

- we

- Bronie

- DOBRZE

- Zachód

- Co

- biały

- Biały Dom

- dlaczego

- w

- działa

- by

- ty

- Twój

- zefirnet