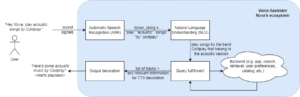

Niedawne postępy w rozwoju LLM spopularyzowały ich wykorzystanie do różnorodnych zadań NLP, które wcześniej były rozwiązywane przy użyciu starszych metod uczenia maszynowego. Duże modele językowe są w stanie rozwiązywać różnorodne problemy językowe, takie jak klasyfikacja, podsumowywanie, wyszukiwanie informacji, tworzenie treści, odpowiadanie na pytania i utrzymywanie konwersacji – a wszystko to przy użyciu tylko jednego modelu. Ale skąd wiemy, że dobrze sobie radzą z tymi wszystkimi różnymi zadaniami?

Rozwój LLM ujawnił nierozwiązany problem: nie mamy wiarygodnych standardów ich oceny. To, co utrudnia ocenę, to fakt, że wykorzystuje się je do bardzo różnorodnych zadań i brakuje nam jasnej definicji dobrej odpowiedzi w każdym przypadku użycia.

W tym artykule omówiono obecne podejścia do oceny LLM i przedstawiono nową tabelę liderów LLM wykorzystującą ocenę ludzką, która stanowi ulepszenie istniejących technik oceny.

Pierwszą i typową początkową formą oceny jest uruchomienie modelu na kilku wybranych zbiorach danych i sprawdzenie jego wydajności. HuggingFace utworzył Otwórz tabelę liderów LLM gdzie duże modele o otwartym dostępie są oceniane przy użyciu czterech dobrze znanych zbiorów danych (Wyzwanie rozumowania AI2 , HellaSwag , MMLU , Prawdziwa kontrola jakości). Odpowiada to automatycznej ocenie i sprawdza zdolność modelu do uzyskania faktów w przypadku niektórych konkretnych pytań.

To jest przykładowe pytanie z MMLU zestaw danych.

Temat: college_medicine

Pytanie: Oczekiwanym skutkiem ubocznym suplementacji kreatyną jest.

- A) osłabienie mięśni

- B) przyrost masy ciała

- C) skurcze mięśni

- D) utrata elektrolitów

Odpowiedź: (B)

Ocena modelu na podstawie odpowiedzi na tego typu pytania jest ważnym miernikiem i dobrze służy do sprawdzania faktów, ale nie sprawdza zdolności generatywnych modelu. Jest to prawdopodobnie największa wada tej metody oceny, ponieważ generowanie dowolnego tekstu jest jedną z najważniejszych cech LLM.

Wydaje się, że w społeczności panuje zgoda co do tego, że aby właściwie ocenić model, potrzebna jest ocena człowieka. Zwykle dokonuje się tego poprzez porównanie odpowiedzi z różnych modeli.

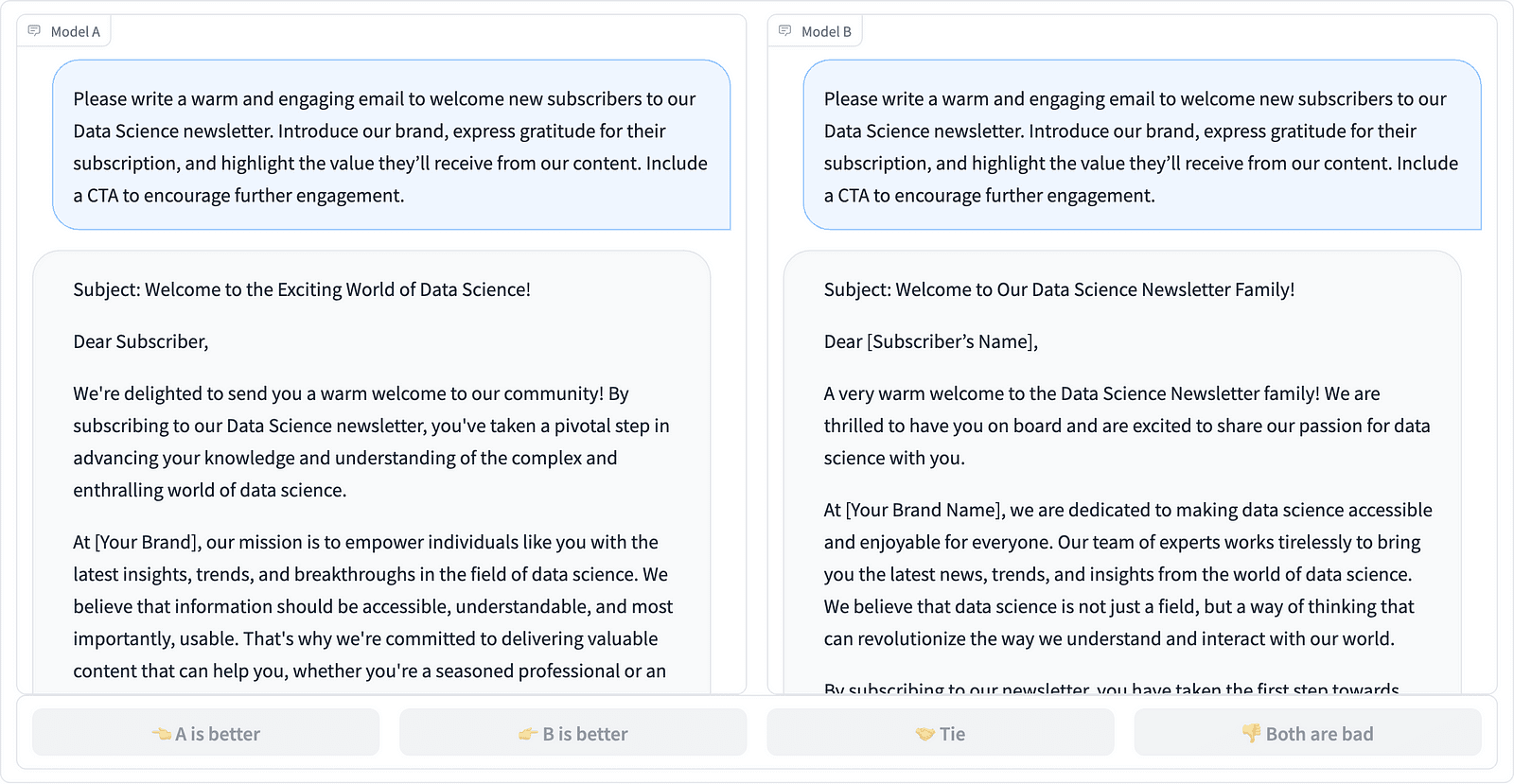

Porównanie dwóch szybkich realizacji w projekcie LMSYS – zrzut ekranu autorstwa Autora

Adnotatorzy decydują, która odpowiedź jest lepsza, jak pokazano w powyższym przykładzie, i czasami określają ilościowo różnicę w jakości szybkich uzupełnień. Organizacja LMSYS Org utworzyła liderów która wykorzystuje tego rodzaju ocenę ludzką i porównuje 17 różnych modeli, zgłaszając Ocena Elo dla każdego modelu.

Ponieważ ocena człowieka może być trudna do skalowania, podjęto wysiłki mające na celu zwiększenie skali i przyspieszenie procesu oceny, co zaowocowało interesującym projektem pod nazwą AlpakaEval. Tutaj każdy model jest porównywany z wartością bazową (text-davinci-003 dostarczony przez GPT-4), a ocena człowieka zostaje zastąpiona oceną GPT-4. To rzeczywiście jest szybkie i skalowalne, ale czy możemy zaufać modelowi, który przeprowadzi punktację? Musimy być świadomi błędów w modelu. Projekt faktycznie wykazał, że GPT-4 może sprzyjać dłuższym odpowiedziom.

Metody oceny LLM stale ewoluują, ponieważ społeczność AI poszukuje łatwych, uczciwych i skalowalnych podejść. Najnowsze osiągnięcie pochodzi od zespołu Toloka z nowością liderów w celu dalszego doskonalenia obecnych standardów oceny.

Nowa liderów porównuje odpowiedzi modelu z podpowiedziami użytkowników w świecie rzeczywistym, które są podzielone na kategorie według przydatnych zadań NLP, jak opisano w ten dokument InstructGPT. Pokazuje także ogólny współczynnik zwycięstw każdego modelu we wszystkich kategoriach.

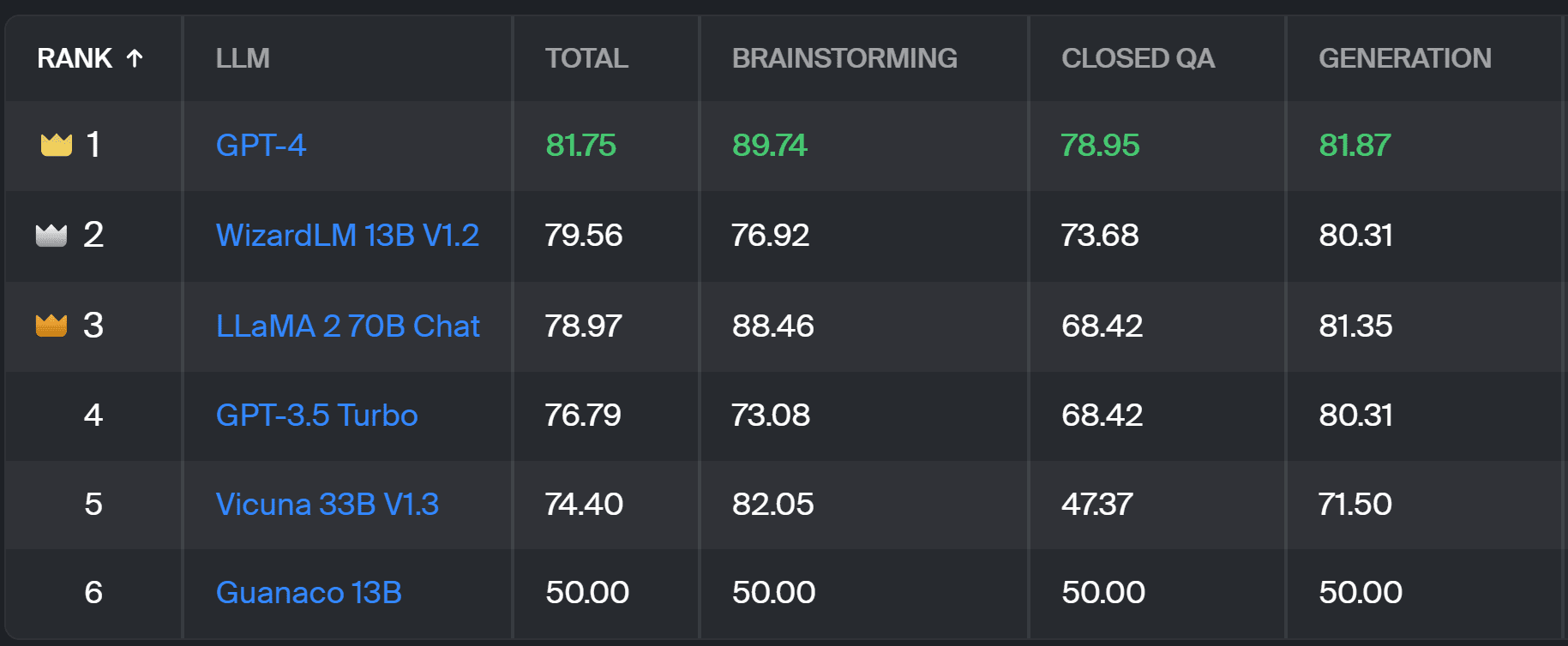

Tablica liderów Toloki – zrzut ekranu autorstwa Autora

Ocena zastosowana w tym projekcie jest podobna do tej przeprowadzonej w AlpacaEval. Wyniki w tabeli liderów reprezentują współczynnik wygranych danego modelu w porównaniu do Guanako 13B model, który służy tutaj jako porównanie bazowe. Wybór Guanaco 13B stanowi ulepszenie metody AlpacaEval, która jako punkt odniesienia wykorzystuje wkrótce przestarzały model Text-davinci-003.

Rzeczywistej oceny dokonują eksperci-komentatorzy na podstawie zestawu podpowiedzi ze świata rzeczywistego. Dla każdego podpowiedzi adnotatorzy otrzymują dwa uzupełnienia i pytają, które z nich wolą. Możesz znaleźć szczegółowe informacje na temat metodologii tutaj.

Ten rodzaj oceny przez człowieka jest bardziej użyteczny niż jakakolwiek inna metoda automatycznej oceny i powinien ulepszyć ocenę przez człowieka stosowaną w tym celu Tabela liderów LMSYS. Wadą metody LMSYS jest to, że każdy, kto ma link mogą wziąć udział w ewaluacji, stawiając poważne pytania dotyczące jakości zebranych w ten sposób danych. Zamknięty tłum ekspertów-komentatorów ma większy potencjał w zakresie wiarygodnych wyników, a Toloka stosuje dodatkowe techniki kontroli jakości, aby zapewnić jakość danych.

W tym artykule przedstawiliśmy nowe, obiecujące rozwiązanie do oceny LLM — Tablicę Liderów Toloka. Podejście jest innowacyjne, łączy w sobie zalety istniejących metod, dodaje szczegółowości specyficznej dla zadania i wykorzystuje niezawodne techniki adnotacji ludzkich do porównywania modeli.

Przeglądaj tablicę i dziel się z nami swoimi opiniami i sugestiami dotyczącymi ulepszeń.

Magdaleny Konkiewicz jest Data Evangelist w Toloka, globalnej firmie wspierającej szybki i skalowalny rozwój AI. Uzyskała tytuł magistra w dziedzinie sztucznej inteligencji na Uniwersytecie w Edynburgu i pracowała jako inżynier, programista i analityk NLP dla firm w Europie i Ameryce. Była również zaangażowana w nauczanie i mentoring dla analityków danych i regularnie publikuje publikacje dotyczące Data Science i Machine Learning.

- Dystrybucja treści i PR oparta na SEO. Uzyskaj wzmocnienie już dziś.

- PlatoData.Network Pionowe generatywne AI. Wzmocnij się. Dostęp tutaj.

- PlatoAiStream. Inteligencja Web3. Wiedza wzmocniona. Dostęp tutaj.

- PlatonESG. Węgiel Czysta technologia, Energia, Środowisko, Słoneczny, Gospodarowanie odpadami. Dostęp tutaj.

- Platon Zdrowie. Inteligencja w zakresie biotechnologii i badań klinicznych. Dostęp tutaj.

- Źródło: https://www.kdnuggets.com/a-better-way-to-evaluate-llms?utm_source=rss&utm_medium=rss&utm_campaign=a-better-way-to-evaluate-llms

- :ma

- :Jest

- :nie

- :Gdzie

- $W GÓRĘ

- 17

- a

- zdolność

- O nas

- powyżej

- w poprzek

- rzeczywisty

- faktycznie

- Dodatkowy

- Dodaje

- awansować

- zaliczki

- AI

- Wszystkie kategorie

- również

- Ameryka

- an

- i

- odpowiedź

- odpowiedzi

- każdy

- dotyczy

- podejście

- awanse

- SĄ

- Arena

- artykuł

- sztuczny

- sztuczna inteligencja

- AS

- At

- automatycznie

- świadomy

- b

- Baseline

- BE

- bo

- być

- Ulepsz Swój

- uprzedzenia

- Najwyższa

- deska

- ciało

- przyniósł

- biznes

- ale

- by

- CAN

- zdolny

- walizka

- kategorie

- wyzwanie

- Wykrywanie urządzeń szpiegujących

- wybór

- klasyfikacja

- jasny

- zamknięte

- kombajny

- byliśmy spójni, od początku

- społeczność

- sukcesy firma

- porównać

- w porównaniu

- porównanie

- porównanie

- Zgoda

- zawartość

- Tworzenie treści

- kontynuując

- przyczynia się

- kontrola

- Rozmowa

- odpowiada

- stworzony

- tworzenie

- tłum

- kurator

- Aktualny

- dane

- jakość danych

- nauka danych

- naukowiec danych

- zbiory danych

- zdecydować

- definicja

- Stopień

- detale

- Deweloper

- oprogramowania

- różnica

- różne

- Niekorzyść

- inny

- do

- robi

- robi

- zrobić

- nie

- minusem

- każdy

- łatwo

- Edynburg

- efekt

- starania

- elektrolity

- inżynier

- zapewnić

- Europie

- oceniać

- oceniane

- oceny

- ewaluację

- Ewangelista

- ewoluuje

- zbadać

- przykład

- Przede wszystkim system został opracowany

- spodziewany

- ekspert

- fakty

- sprawiedliwy

- FAST

- faworyzować

- Korzyści

- Znajdź

- i terminów, a

- W razie zamówieenia projektu

- Nasz formularz

- cztery

- Darmowy

- od

- dalej

- Wzrost

- zebrane

- generujący

- generatywny

- otrzymać

- GitHub

- dany

- Globalne

- dobry

- dobra praca

- Ciężko

- trudniej

- Have

- tutaj

- wysoko

- posiada

- W jaki sposób

- HTTPS

- Przytulanie twarzy

- człowiek

- ważny

- podnieść

- poprawa

- ulepszenia

- poprawia

- in

- Informacja

- początkowy

- Innowacyjny

- Inteligencja

- ciekawy

- wprowadzono

- Przedstawia

- zaangażowany

- IT

- JEGO

- Praca

- właśnie

- tylko jeden

- Knuggety

- Wiedzieć

- Brak

- język

- duży

- firmy

- nauka

- lewarowanie

- lekki

- dłużej

- od

- maszyna

- uczenie maszynowe

- utrzymanie

- WYKONUJE

- sposób

- Masa

- mistrz

- Może..

- mentoring

- metoda

- Metodologia

- metody

- metryczny

- model

- modele

- jeszcze

- większość

- mięsień

- Potrzebować

- Nowości

- nowe rozwiązanie

- nlp

- of

- starszych

- on

- ONE

- koncepcja

- Opinie

- Inne

- opisane

- ogólny

- część

- wykonać

- jest gwarancją najlepszej jakości, które mogą dostarczyć Ci Twoje monitory,

- wykonywane

- plato

- Analiza danych Platona

- PlatoDane

- potencjał

- woleć

- poprzednio

- prawdopodobnie

- Problem

- problemy

- wygląda tak

- projekt

- obiecujący

- monity

- prawidłowo

- pod warunkiem,

- publikacje

- jakość

- pytanie

- pytania

- wychowywanie

- Kurs

- Prawdziwy świat

- regularnie

- rzetelny

- otrzymuje

- Raportowanie

- reprezentować

- osób

- odpowiedź

- Odpowiedzi

- wynikał

- Efekt

- Rosnąć

- run

- s

- skalowalny

- Skala

- nauka

- Naukowiec

- Naukowcy

- wyniki

- punktacji

- wyszukiwania

- wydaje

- widziany

- poważny

- służy

- zestaw

- kilka

- Share

- ona

- powinien

- pokazane

- Targi

- bok

- podobny

- pojedynczy

- rozwiązanie

- Rozwiązywanie

- kilka

- czasami

- specyficzny

- prędkość

- standard

- standardy

- silne strony

- taki

- Wspierający

- Brać

- zadania

- Nauczanie

- zespół

- Techniki

- test

- XNUMX

- niż

- że

- Połączenia

- ich

- Im

- Tam.

- Te

- one

- to

- do

- Zaufaj

- drugiej

- rodzaj

- zazwyczaj

- uniwersytet

- na

- us

- Stosowanie

- posługiwać się

- przypadek użycia

- używany

- Użytkownik

- zastosowania

- za pomocą

- zwykły

- różnorodność

- Droga..

- we

- osłabienie

- DOBRZE

- znane

- były

- Co

- Co to jest

- który

- wygrać

- w

- w ciągu

- pracował

- ty

- Twój

- zefirnet