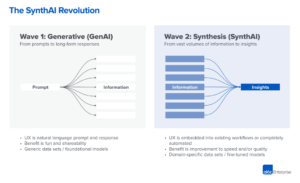

We beginnen de zeer vroege stadia van een tech-stack te zien opduiken in generatieve kunstmatige intelligentie (AI). Honderden nieuwe startups haasten zich de markt op om basismodellen te ontwikkelen, AI-native apps te bouwen en infrastructuur/tooling op te zetten.

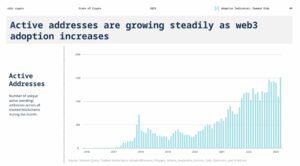

Veel hete technologietrends worden te veel gehyped lang voordat de markt de achterstand inhaalt. Maar de generatieve AI-boom ging gepaard met echte winsten in echte markten en echte tractie van echte bedrijven. Modellen zoals Stable Diffusion en ChatGPT vestigen historische records voor gebruikersgroei, en verschillende applicaties hebben minder dan een jaar na de lancering een omzet van $ 100 miljoen op jaarbasis behaald. Zij-aan-zij vergelijkingen tonen AI-modellen beter presteren dan mensen in sommige taken met meerdere ordes van grootte.

Er zijn dus genoeg vroege gegevens om te suggereren dat er een enorme transformatie plaatsvindt. Wat we niet weten, en wat nu de kritische vraag is geworden, is: Waar in deze markt zal waarde worden opgebouwd?

Het afgelopen jaar hebben we tientallen startup-oprichters en operators in grote bedrijven ontmoet die rechtstreeks met generatieve AI te maken hebben. Dat hebben we geconstateerd leveranciers van infrastructuur zijn tot nu toe waarschijnlijk de grootste winnaars in deze markt en veroveren het grootste deel van de dollars die door de stapel stromen. Applicatie bedrijven laten hun topline-inkomsten zeer snel groeien, maar worstelen vaak met retentie, productdifferentiatie en brutomarges. En het meest modelaanbieders, hoewel verantwoordelijk voor het bestaan van deze markt, hebben nog geen grote commerciële schaal bereikt.

Met andere woorden, de bedrijven die de meeste waarde creëren - dat wil zeggen door generatieve AI-modellen te trainen en deze toe te passen in nieuwe apps - hebben het meeste niet vastgelegd. Voorspellen wat er daarna gaat gebeuren is veel moeilijker. Maar we denken dat het belangrijkste om te begrijpen is welke delen van de stapel echt gedifferentieerd en verdedigbaar zijn. Dit zal een grote impact hebben op de marktstructuur (dwz horizontale vs. verticale bedrijfsontwikkeling) en de aanjagers van langetermijnwaarde (bijv. marges en retentie). Tot nu toe hebben we moeite gehad om structurele verdedigbaarheid te vinden overal in de stapel, buiten de traditionele slotgrachten voor gevestigde exploitanten.

We zijn ongelooflijk optimistisch over generatieve AI en geloven dat dit een enorme impact zal hebben in de software-industrie en daarbuiten. Het doel van deze post is om de dynamiek van de markt in kaart te brengen en de bredere vragen over generatieve AI-bedrijfsmodellen te beantwoorden.

Techstack op hoog niveau: infrastructuur, modellen en apps

Om te begrijpen hoe de generatieve AI-markt vorm krijgt, moeten we eerst definiëren hoe de stapel er vandaag uitziet. Dit is ons voorlopige beeld.

De stapel kan in drie lagen worden verdeeld:

- Toepassingen die generatieve AI-modellen integreren in een gebruikersgericht product, ofwel met hun eigen modelpijplijnen ("end-to-end-apps") of vertrouwend op een API van derden

- Modellen die AI-producten aandrijven, beschikbaar gemaakt als eigen API's of als open-source checkpoints (die op hun beurt een hostingoplossing vereisen)

- Infrastructuur leveranciers (dwz cloudplatforms en hardwarefabrikanten) die trainings- en inferentieworkloads uitvoeren voor generatieve AI-modellen

Het is belangrijk op te merken: dit is geen marktkaart, maar een raamwerk om de markt te analyseren. In elke categorie hebben we een paar voorbeelden van bekende leveranciers op een rijtje gezet. We hebben geen enkele poging gedaan om allesomvattend te zijn of alle verbazingwekkende generatieve AI-applicaties op te sommen die zijn uitgebracht. We gaan hier ook niet diep in op MLops- of LLMops-tooling, die nog niet erg gestandaardiseerd is en in een toekomstige post zal worden behandeld.

De eerste golf van generatieve AI-apps begint schaal te bereiken, maar worstelt met retentie en differentiatie

In eerdere technologiecycli was de conventionele wijsheid dat om een groot, onafhankelijk bedrijf op te bouwen, je eigenaar moet zijn van de eindklant - of dat nu individuele consumenten of B2B-kopers zijn. Het is verleidelijk om te geloven dat de grootste bedrijven in generatieve AI ook eindgebruikerstoepassingen zullen zijn. Tot nu toe is het niet duidelijk dat dat het geval is.

Zeker, de groei van generatieve AI-toepassingen is enorm, voortgestuwd door pure nieuwigheid en een overvloed aan use-cases. We zijn zelfs op de hoogte van ten minste drie productcategorieën die al meer dan $ 100 miljoen aan jaarlijkse inkomsten hebben: het genereren van afbeeldingen, het schrijven van teksten en het schrijven van codes.

Groei alleen is echter niet voldoende om duurzame softwarebedrijven op te bouwen. Het is van cruciaal belang dat groei winstgevend is, in die zin dat gebruikers en klanten, zodra ze zich aanmelden, winst genereren (hoge brutomarges) en lang blijven hangen (hoge retentie). Bij gebrek aan sterke technische differentiatie, zorgen B2B- en B2C-apps voor klantwaarde op de lange termijn door netwerkeffecten, het vasthouden van gegevens of het bouwen van steeds complexere workflows.

Bij generatieve AI zijn die aannames niet noodzakelijkerwijs waar. Bij app-bedrijven waarmee we hebben gesproken, is er een breed scala aan brutomarges - in sommige gevallen wel 90%, maar vaker zo laag als 50-60%, grotendeels gedreven door de kosten van modelinferentie. De groei aan de bovenkant van de trechter was geweldig, maar het is onduidelijk of de huidige strategieën voor klantenwerving schaalbaar zullen zijn. Veel apps zijn ook relatief ongedifferentieerd, omdat ze afhankelijk zijn van vergelijkbare onderliggende AI-modellen en geen duidelijke netwerkeffecten of gegevens/workflows hebben ontdekt die voor concurrenten moeilijk te dupliceren zijn.

Het is dus nog niet duidelijk dat het verkopen van apps voor eindgebruikers de enige of zelfs de beste manier is om een duurzaam generatief AI-bedrijf op te bouwen. De marges zouden moeten verbeteren naarmate de concurrentie en efficiëntie in taalmodellen toenemen (meer hierover hieronder). Retentie zou moeten toenemen naarmate AI-toeristen de markt verlaten. En er is een sterk argument dat verticaal geïntegreerde apps een voordeel hebben bij het stimuleren van differentiatie. Maar er valt nog veel te bewijzen.

Vooruitkijkend zijn enkele van de grote vragen waarmee generatieve AI-app-bedrijven worden geconfronteerd:

- Verticale integratie (“model + app”). Door AI-modellen als een service te gebruiken, kunnen app-ontwikkelaars snel itereren met een klein team en van modelaanbieder wisselen naarmate de technologie voortschrijdt. Aan de andere kant beweren sommige ontwikkelaars dat het product is het model, en dat trainen vanaf het begin de enige manier is om weerbaarheid te creëren - dwz door voortdurend opnieuw te trainen op basis van bedrijfseigen productgegevens. Maar het gaat ten koste van veel hogere kapitaalvereisten en een minder behendig productteam.

- Functies bouwen versus apps. Generatieve AI-producten kunnen verschillende vormen aannemen: desktop-apps, mobiele apps, Figma/Photoshop-plug-ins, Chrome-extensies en zelfs Discord-bots. Het is gemakkelijk om AI-producten te integreren waar gebruikers al werken, aangezien de gebruikersinterface over het algemeen slechts een tekstvak is. Welke van deze bedrijven worden zelfstandige bedrijven en welke worden overgenomen door gevestigde bedrijven, zoals Microsoft of Google, die AI al in hun productlijnen integreren?

- Managen door de hype-cyclus. Het is nog niet duidelijk of churn inherent is aan de huidige reeks generatieve AI-producten, of dat het een artefact is van een vroege markt. Of als de golf van belangstelling voor generatieve AI afneemt naarmate de hype afneemt. Deze vragen hebben belangrijke implicaties voor app-bedrijven, waaronder wanneer het gaspedaal moet worden ingedrukt bij fondsenwerving; hoe agressief te investeren in klantenwerving; aan welke gebruikerssegmenten prioriteit moet worden gegeven; en wanneer product-marktfit moet worden verklaard.

Modelaanbieders hebben generatieve AI uitgevonden, maar hebben nog geen grote commerciële schaal bereikt

Wat we nu generatieve AI noemen, zou niet bestaan zonder het briljante onderzoeks- en technische werk dat is gedaan op plaatsen als Google, OpenAI en Stability. Door nieuwe modelarchitecturen en heldhaftige inspanningen om trainingspijplijnen op te schalen, profiteren we allemaal van de verbluffende mogelijkheden van de huidige grote taalmodellen (LLM's) en modellen voor het genereren van afbeeldingen.

Toch is de omzet van deze bedrijven nog steeds relatief klein in vergelijking met het gebruik en de buzz. Bij het genereren van afbeeldingen heeft Stable Diffusion een explosieve communitygroei gekend, ondersteund door een ecosysteem van gebruikersinterfaces, gehoste aanbiedingen en methoden voor fijnafstemming. Maar Stability geeft hun belangrijkste checkpoints gratis weg als een kernprincipe van hun bedrijf. In natuurlijke taalmodellen domineert OpenAI met GPT-3/3.5 en ChatGPT. Maar relatief Er zijn tot nu toe weinig geweldige apps gebouwd op OpenAI, en de prijzen zijn er al een keer gevallen.

Dit kan slechts een tijdelijk fenomeen zijn. Stability is een nieuw bedrijf dat zich nog niet heeft gericht op het genereren van inkomsten. OpenAI heeft het potentieel om een gigantisch bedrijf te worden, dat een aanzienlijk deel van alle NLP-categorie-inkomsten verdient naarmate er meer geweldige apps worden gebouwd, vooral als hun integratie in het productportfolio van Microsoft gaat vlot. Gezien het enorme gebruik van deze modellen, kunnen grootschalige inkomsten niet ver achterblijven.

Maar er zijn ook tegenkrachten. Modellen die als open source zijn uitgebracht, kunnen door iedereen worden gehost, ook door externe bedrijven die niet de kosten dragen die gepaard gaan met grootschalige modeltraining (tot tientallen of honderden miljoenen dollars). En het is niet duidelijk of closed-source modellen hun voorsprong voor onbepaalde tijd kunnen behouden. We beginnen bijvoorbeeld te zien dat LLM's die zijn gebouwd door bedrijven als Anthropic, Cohere en Character.ai dichter bij OpenAI-prestatieniveaus komen, getraind op vergelijkbare datasets (dwz internet) en met vergelijkbare modelarchitecturen. Het voorbeeld van Stable Diffusion suggereert dat if Als open source-modellen een voldoende niveau van prestaties en gemeenschapsondersteuning bereiken, kunnen propriëtaire alternatieven het moeilijk vinden om te concurreren.

Misschien wel de duidelijkste afhaalmogelijkheid voor modelaanbieders tot nu toe, is dat commercialisering waarschijnlijk verband houdt met hosting. De vraag naar eigen API's (bijvoorbeeld van OpenAI) groeit snel. Hostingservices voor open-sourcemodellen (bijv. Hugging Face en Replicate) zijn in opkomst als handige hubs om eenvoudig modellen te delen en te integreren — en hebben zelfs enkele indirecte netwerkeffecten tussen modelproducenten en consumenten. Er is ook een sterke hypothese dat het mogelijk is om geld te verdienen door middel van afstemming en hostingovereenkomsten met zakelijke klanten.

Afgezien daarvan zijn er echter een aantal grote vragen waarmee modelaanbieders worden geconfronteerd:

- Commoditisering. Er is een algemene overtuiging dat AI-modellen in de loop van de tijd zullen convergeren in prestaties. Praten met app-ontwikkelaars, het is duidelijk dat dit nog niet is gebeurd, met sterke leiders in zowel tekst- als beeldmodellen. Hun voordelen zijn niet gebaseerd op unieke modelarchitecturen, maar op hoge kapitaalvereisten, eigen productinteractiegegevens en schaars AI-talent. Zal dit een duurzaam voordeel zijn?

- Afstuderen risico. Vertrouwen op modelaanbieders is een geweldige manier voor app-bedrijven om aan de slag te gaan en zelfs om hun bedrijf te laten groeien. Maar er is een stimulans voor hen om hun eigen modellen te bouwen en/of te hosten zodra ze op schaal zijn. En veel modelaanbieders hebben een zeer scheve klantverdeling, waarbij een paar apps het grootste deel van de omzet vertegenwoordigen. Wat gebeurt er als/wanneer deze klanten overstappen op in-house AI-ontwikkeling?

- Is geld belangrijk? De belofte van generatieve AI is zo groot – en mogelijk ook zo schadelijk – dat veel modelaanbieders zich hebben georganiseerd als corporaties van openbaar nut (B corps), afgetopte winstdelingen hebben uitgegeven of anderszins het algemeen belang expliciet in hun missie hebben opgenomen. Dit heeft hun fondsenwerving geenszins belemmerd. Maar er is een redelijke discussie te voeren over de vraag of de meeste modelaanbieders dat ook daadwerkelijk doen willen om waarde vast te leggen, en of ze dat zouden moeten doen.

Infrastructuurleveranciers raken alles aan en plukken de vruchten

Bijna alles in generatieve AI gaat op een gegeven moment door een in de cloud gehoste GPU (of TPU). Of het nu gaat om modelaanbieders / onderzoekslaboratoria die trainingsworkloads uitvoeren, hostingbedrijven die inferentie/fijnafstemming uitvoeren, of applicatiebedrijven die een combinatie van beide doen - flops vormen de levensader van generatieve AI. Voor het eerst in zeer lange tijd is de vooruitgang op het gebied van de meest ontwrichtende computertechnologie enorm rekengebonden.

Daardoor stroomt veel van het geld in de generatieve AI-markt uiteindelijk door naar infrastructuurbedrijven. Om wat te zeggen zeer ruwe cijfers eromheen: we schatten dat app-bedrijven gemiddeld ongeveer 20-40% van de omzet besteden aan inferentie en fijnafstemming per klant. Dit wordt doorgaans rechtstreeks aan cloudproviders voor rekeninstances betaald of aan externe modelproviders, die op hun beurt ongeveer de helft van hun inkomsten besteden aan cloudinfrastructuur. Het is dus redelijk om te raden dat 10-20% van de totale omzet in generatieve AI gaat tegenwoordig naar cloudproviders.

Bovendien hebben startups die hun eigen modellen trainen, miljarden dollars aan durfkapitaal opgehaald, waarvan het grootste deel (tot 80-90% in de vroege rondes) doorgaans ook wordt uitgegeven bij de cloudproviders. Veel openbare technologiebedrijven geven honderden miljoenen per jaar uit aan modeltraining, hetzij bij externe cloudproviders, hetzij rechtstreeks bij hardwarefabrikanten.

Dit is wat we in technische termen "veel geld" zouden noemen, vooral voor een opkomende markt. Het meeste wordt besteed aan de Big 3 clouds: Amazon Web Services (AWS), Google Cloud Platform (GCP) en Microsoft Azure. Deze cloudaanbieders samen meer uitgeven dan $ 100 miljard per jaar in capex om ervoor te zorgen dat ze de meest uitgebreide, betrouwbare en kostenconcurrerende platforms hebben. Vooral bij generatieve AI profiteren ze ook van aanbodbeperkingen omdat ze preferentiële toegang hebben tot schaarse hardware (bijvoorbeeld Nvidia A100 en H100 GPU's).

Interessant is echter dat we een geloofwaardige concurrentie beginnen te zien ontstaan. Uitdagers zoals Oracle hebben doorgedrongen met grote capex-uitgaven en verkoopprikkels. En een paar startups, zoals Coreweave en Lambda Labs, zijn snel gegroeid met oplossingen die specifiek gericht zijn op grote modelontwikkelaars. Ze concurreren op kosten, beschikbaarheid en persoonlijke ondersteuning. Ze leggen ook meer granulaire resource-abstracties (dwz containers) bloot, terwijl de grote clouds alleen VM-instances bieden vanwege GPU-virtualisatielimieten.

Achter de schermen, het uitvoeren van de overgrote meerderheid van de AI-workloads, is misschien wel de grootste winnaar in generatieve AI tot nu toe: Nvidia. Het bedrijf meldde $ 3.8 miljard van de GPU-omzet van datacenters in het derde kwartaal van het fiscale jaar 2023, inclusief een zinvol deel voor generatieve AI-use-cases. En ze hebben sterke slotgrachten rond dit bedrijf gebouwd door tientallen jaren van investeringen in de GPU-architectuur, een robuust software-ecosysteem en intensief gebruik in de academische gemeenschap. Een recente analyse ontdekte dat GPU's van Nvidia 90 keer meer worden genoemd in onderzoeksdocumenten dan de beste AI-chipstartups samen.

Er zijn andere hardware-opties, waaronder Google Tensor Processing Units (TPU's); AMD Instinct GPU's; AWS Inferentia- en Trainium-chips; en AI-versnellers van startups als Cerebras, Sambanova en Graphcore. Intel, laat bij het spel, komt ook op de markt met hun high-end Habana-chips en Ponte Vecchio GPU's. Maar tot nu toe hebben maar weinig van deze nieuwe chips een aanzienlijk marktaandeel veroverd. De twee uitzonderingen om in de gaten te houden zijn Google, wiens TPU's grip hebben gekregen in de Stable Diffusion-gemeenschap en in enkele grote GCP-deals, en TSMC, waarvan wordt aangenomen dat ze allen van de hier vermelde chips, inclusief Nvidia GPU's (Intel gebruikt een mix van zijn eigen fabs en TSMC om zijn chips te maken).

Infrastructuur is met andere woorden een lucratieve, duurzame en ogenschijnlijk verdedigbare laag in de stapel. De grote vragen die infrabedrijven moeten beantwoorden zijn:

- Vasthouden aan staatloze workloads. Nvidia GPU's zijn hetzelfde, waar u ze ook huurt. De meeste AI-workloads zijn stateless, in die zin dat modeldeductie geen gekoppelde databases of opslag vereist (behalve voor de modelgewichten zelf). Dit betekent dat AI-workloads mogelijk meer draagbaar zijn tussen clouds dan traditionele applicatieworkloads. Hoe kunnen cloudproviders in deze context plakkerigheid creëren en voorkomen dat klanten naar de goedkoopste optie springen?

- Het einde van de chipschaarste overleven. De prijzen voor cloudproviders en voor Nvidia zelf werden ondersteund door schaarse voorraden van de meest gewilde GPU's. Een aanbieder vertelde ons dat de catalogusprijs voor A100's daadwerkelijk is meer sinds de lancering, wat hoogst ongebruikelijk is voor computerhardware. Wanneer deze leveringsbeperking uiteindelijk wordt weggenomen, door verhoogde productie en/of acceptatie van nieuwe hardwareplatforms, welke gevolgen heeft dit dan voor cloudproviders?

- Kan een challenger cloud doorbreken? Daar zijn we sterk van overtuigd verticale wolken zal marktaandeel overnemen van de Big 3 met meer gespecialiseerde aanbiedingen. Op het gebied van AI hebben uitdagers tot nu toe een betekenisvolle tractie weten te behalen door gematigde technische differentiatie en de ondersteuning van Nvidia - voor wie de gevestigde cloudproviders zowel de grootste klanten als opkomende concurrenten zijn. De vraag op de lange termijn is: zal dit voldoende zijn om de schaalvoordelen van de Big 3 te boven te komen?

Dus... waar zal waarde worden opgebouwd?

We weten het natuurlijk nog niet. Maar op basis van de vroege gegevens die we hebben voor generatieve AI, gecombineerd met onze ervaring met eerdere AI/ML-bedrijven, onze intuïtie is de volgende.

Er lijken vandaag geen systemische slotgrachten te zijn in generatieve AI. Als een benadering van de eerste orde missen toepassingen een sterke productdifferentiatie omdat ze vergelijkbare modellen gebruiken; modellen hebben te maken met onduidelijke differentiatie op de lange termijn omdat ze zijn getraind op vergelijkbare datasets met vergelijkbare architecturen; cloudproviders missen diepgaande technische differentiatie omdat ze dezelfde GPU's gebruiken; en zelfs de hardwarebedrijven vervaardigen hun chips in dezelfde fabrieken.

Er zijn natuurlijk de standaard slotgrachten: schaalgrachten ("Ik heb of kan meer geld inzamelen dan jij!"), slotgrachten voor de toeleveringsketen ("Ik heb de GPU's, jij niet!"), ecosysteemgrachten (" Iedereen gebruikt mijn software al!”), algoritmische slotgrachten (“We zijn slimmer dan jij!”), distributie slotgrachten (“Ik heb al een verkoopteam en meer klanten dan jij!”) en datapijplijn slotgrachten (“Ik heb meer van internet gecrawld dan jij!”). Maar geen van deze grachten is op de lange termijn duurzaam. En het is nog te vroeg om te zeggen of er sterke, directe netwerkeffecten in een laag van de stapel ontstaan.

Op basis van de beschikbare gegevens is het gewoon niet duidelijk of er op de lange termijn een dynamiek van winnaar-alles zal zijn in generatieve AI.

Dit is raar. Maar voor ons is het goed nieuws. De potentiële omvang van deze markt is moeilijk te bevatten - ergens tussenin alle programmatuur en alle menselijke inspanningen - dus we verwachten veel, veel spelers en gezonde concurrentie op alle niveaus van de stapel. We verwachten ook dat zowel horizontale als verticale bedrijven slagen, met de beste aanpak die wordt gedicteerd door eindmarkten en eindgebruikers. Als de primaire differentiatie in het eindproduct bijvoorbeeld de AI zelf is, is het waarschijnlijk dat verticalisatie (dwz het nauw koppelen van de op de gebruiker gerichte app aan het model van eigen bodem) zal winnen. Terwijl als de AI deel uitmaakt van een grotere, long-tail feature set, de kans groter is dat horizontalisering optreedt. Natuurlijk zouden we in de loop van de tijd ook meer traditionele slotgrachten moeten zien bouwen - en misschien zien we zelfs nieuwe soorten slotgrachten.

Hoe het ook zij, een ding waar we zeker van zijn, is dat generatieve AI het spel verandert. We leren allemaal de regels in realtime, er is een enorme hoeveelheid waarde die zal worden ontgrendeld, en het technische landschap zal er daardoor heel, heel anders uitzien. En wij zijn er voor!

Alle afbeeldingen in dit bericht zijn gemaakt met Midjourney.

- Door SEO aangedreven content en PR-distributie. Word vandaag nog versterkt.

- Platoblockchain. Web3 Metaverse Intelligentie. Kennis versterkt. Toegang hier.

- Bron: https://a16z.com/2023/01/19/who-owns-the-generative-ai-platform/

- $ 100 miljoen

- $3

- 1

- a

- A100

- Over

- academische

- versnellers

- toegang

- bereikt

- acquisitie

- over

- werkelijk

- Adoptie

- voorschotten

- Voordeel

- voordelen

- Na

- overeenkomsten

- vooruit

- AI

- AI-platform

- ai-gebruiksgevallen

- AI / ML

- algoritmische

- Alles

- toestaat

- alleen

- al

- alternatieven

- verbazingwekkend

- Amazone

- Amazon Web Services

- Amazon Web Services (AWS)

- AMD

- bedragen

- analyseren

- en

- op jaarbasis

- beantwoorden

- iedereen

- APIs

- gebruiken

- verschijnen

- Aanvraag

- toepassingen

- Het toepassen van

- nadering

- apps

- architectuur

- argumenteren

- argument

- rond

- kunstmatig

- kunstmatige intelligentie

- Kunstmatige intelligentie (AI)

- geassocieerd

- beschikbaarheid

- Beschikbaar

- gemiddelde

- AWS

- AWS Inferentie

- Azuur

- Zakelijk

- B2C

- gebaseerde

- Beer

- omdat

- worden

- vaardigheden

- achter

- geloof

- geloofd wie en wat je bent

- geloofde

- gelovigen

- onder

- voordeel

- BEST

- tussen

- Verder

- Groot

- Grootste

- Miljard

- miljarden

- boom

- bots

- gebonden

- Box camera's

- Breken

- briljant

- bredere

- bouw

- Gebouw

- bebouwd

- Bullish

- bedrijfsdeskundigen

- ondernemingen

- kopers

- Bellen

- mogelijkheden

- hoofdstad

- vangen

- Het vastleggen

- geval

- gevallen

- categorieën

- Categorie

- Centreren

- zeker

- uitdager

- Wijzigingen

- karakter

- ChatGPT

- goedkoopste

- spaander

- chips

- Chrome

- aangehaald

- duidelijk

- dichterbij

- Cloud

- cloud infrastructuur

- Cloud Platform

- code

- collectief

- combinatie van

- gecombineerde

- hoe

- commercieel

- commercialisering

- Gemeen

- gemeenschap

- Bedrijven

- afstand

- vergeleken

- concurreren

- concurrentie

- concurrenten

- complex

- uitgebreid

- Berekenen

- computergebruik

- beperkingen

- Consumenten

- containers

- verband

- permanent

- conventioneel

- convergeren

- copywriting

- Kern

- Bedrijven

- Kosten

- Kosten

- cursus

- en je merk te creëren

- aangemaakt

- Wij creëren

- geloofwaardig

- kritisch

- Actueel

- klant

- Klanten

- cycli

- gegevens

- Data Center

- databanken

- datasets

- transactie

- Deals

- decennia

- deep

- Vraag

- desktop

- ontwikkelen

- ontwikkelaars

- Ontwikkeling

- devs

- anders

- verschillende vormen

- gedifferentieerde

- Verspreiding

- directe

- direct

- onenigheid

- ontdekt

- discussie

- verstorend

- distributie

- Uitkeringen

- Verdeeld

- doen

- dollar

- domineert

- Dont

- tientallen

- rit

- gedreven

- chauffeurs

- aandrijving

- dynamisch

- dynamica

- elk

- Vroeger

- Vroeg

- verdiencapaciteit

- gemakkelijk

- ecosysteem

- rand

- duurt

- doeltreffendheid

- inspanningen

- beide

- opkomende

- Engineering

- genoeg

- verzekeren

- Enterprise

- zakelijke klanten

- vooral

- schatting

- Zelfs

- uiteindelijk

- alles

- voorbeeld

- voorbeelden

- verwachten

- ervaring

- extensies

- extern

- Gezicht

- naar

- Vallen

- Kenmerk

- Voordelen

- weinig

- VIND DE PLEK DIE PERFECT VOOR JOU IS

- het vinden van

- Voornaam*

- eerste keer

- Fiscale

- geschikt

- Tik

- vloeiende

- Stromen

- gericht

- volgend

- Krachten

- formulieren

- gevonden

- Foundation

- oprichters

- Achtergrond

- Gratis

- oppompen van

- fondsenwerving

- toekomst

- verdiensten

- spel

- GAS

- algemeen

- voortbrengen

- generatie

- generatief

- generatieve AI

- krijgen

- gegeven

- geeft

- doel

- Goes

- gaan

- goed

- Kopen Google Reviews

- Google Cloud

- Google Cloud Platform

- GPU

- GPU's

- grijpen

- groot

- bruto

- Groeien

- Groeiend

- gegroeid

- Helft

- gebeuren

- gebeurd

- gebeurt

- Hard

- Hardware

- schadelijk

- gezond

- hier

- Hoge

- hoger

- zeer

- historisch

- Hit

- houden

- bezit

- Horizontaal

- gastheer

- gehost

- Hosting

- Populair

- Hoe

- HTTPS

- reusachtig

- menselijk

- Honderden

- honderdmiljoenen

- Hype

- beeld

- beeldgeneratie

- afbeeldingen

- Impact

- implicaties

- belangrijk

- verbeteren

- in

- Anders

- aansporing

- Incentives

- omvatten

- Inclusief

- Incorporated

- opnemen

- Laat uw omzet

- meer

- Verhoogt

- in toenemende mate

- ongelooflijk

- zittende

- onafhankelijk

- individueel

- -industrie

- Infrastructuur

- inherent

- integreren

- geïntegreerde

- integratie

- Intel

- Intelligentie

- wisselwerking

- belang

- interfaces

- Internet

- intuïtie

- Uitgevonden

- Investeren

- investering

- Uitgegeven

- IT

- zelf

- sleutel

- blijven

- Labs

- Gebrek

- Landschap

- taal

- Groot

- grootschalig

- grotendeels

- groter

- Achternaam*

- Afgelopen jaar

- Laat

- lancering

- lagen

- Legkippen

- leiders

- leren

- Verlof

- Niveau

- niveaus

- Waarschijnlijk

- grenzen

- lijnen

- Lijst

- opgesomd

- lang

- lange tijd

- langdurig

- Kijk

- LOOKS

- lot

- Laag

- winstgevend

- gemaakt

- onderhouden

- groot

- Meerderheid

- maken

- Fabrikanten

- veel

- kaart

- marges

- Markt

- markt kaart

- Marktstructuur

- Markten

- massief

- massief

- max-width

- zinvolle

- middel

- methoden

- Microsoft

- Microsoft Azure

- Halverwege de reis

- miljoen

- miljoenen

- Missie

- MLops

- Mobile

- mobiele apps

- model

- modellen

- gelde maken

- gelde

- geld

- meer

- meest

- meervoudig

- ontluikend

- Naturel

- Natuurlijke taal

- nodig

- Noodzaak

- netwerk

- New

- nieuwe hardware

- nieuws

- volgende

- lenig

- nlp

- roman

- nieuwigheid

- aantal

- nummers

- Nvidia

- Voor de hand liggend

- bieden

- aanbod

- EEN

- open

- open source

- OpenAI

- exploitanten

- Keuze

- Opties

- orakel

- orders

- Georganiseerd

- Overige

- anders-

- buiten

- Overwinnen

- het te bezitten.

- bezit

- betaald

- papieren

- deel

- bijzonder

- onderdelen

- passes

- pad

- prestatie

- misschien

- Gepersonaliseerde

- een fenomeen

- pijpleiding

- plaats

- plaatsen

- platform

- platforms

- Plato

- Plato gegevensintelligentie

- PlatoData

- spelers

- overvloed

- plugins

- punt

- mogelijk

- Post

- potentieel

- mogelijk

- energie

- het voorspellen van

- voorkomen

- prijs

- Prijzen

- primair

- Voorafgaand

- prioriteren

- verwerking

- Producenten

- Product

- productie

- Producten

- Profit

- winstgevend

- winst

- Voortgang

- belofte

- gepatenteerd

- Bewijzen

- leverancier

- providers

- publiek

- zetten

- Quarter

- vraag

- Contact

- snel

- verhogen

- opgebracht

- reeks

- snel

- bereiken

- bereikt

- vast

- real-time

- redelijk

- recent

- archief

- relatief

- uitgebracht

- betrouwbaar

- verwijderd

- Verhuur

- vertegenwoordigen

- vereisen

- Voorwaarden

- onderzoek

- hulpbron

- verantwoordelijk

- resultaat

- behoud

- inkomsten

- inkomsten

- Risico

- robuust

- rondes

- reglement

- lopen

- lopend

- verkoop

- Verkoopprikkels

- dezelfde

- schaalbare

- Scale

- Schaars

- Schaarste

- Scenes

- te zien

- segmenten

- binnen XNUMX minuten

- zin

- dienen

- service

- Diensten

- reeks

- het instellen van

- verscheidene

- Vorm

- Delen

- Aandelen

- moet

- tonen

- teken

- aanzienlijke

- gelijk

- sinds

- Maat

- Klein

- glad

- So

- dusver

- Software

- oplossing

- Oplossingen

- sommige

- ergens

- bron

- gespecialiseerde

- specifiek

- besteden

- besteed

- Stabiliteit

- stabiel

- stack

- stadia

- staan

- standalone

- standaard

- begin

- gestart

- Start

- startup

- Startups

- stok

- Still

- mediaopslag

- strategieën

- sterke

- structureel

- structuur

- slagen

- voldoende

- Stelt voor

- leveren

- ondersteuning

- ondersteunde

- ontstaat

- duurzaam

- Stap over voor slechts

- systemische

- Nemen

- het nemen

- Talent

- praat

- doelgerichte

- taken

- team

- tech

- tech bedrijven

- Technisch

- Technologie

- tijdelijk

- termen

- De

- hun

- zich

- ding

- Derde

- van derden

- drie

- Door

- Gebonden

- strak

- niet de tijd of

- keer

- naar

- vandaag

- ook

- top

- tractie

- traditioneel

- getraind

- Trainingen

- Transformatie

- ontzettend

- Trends

- waar

- TSMC

- BEURT

- types

- typisch

- ui

- Tenslotte

- die ten grondslag liggen

- begrijpen

- unieke

- eenheden

- ongebruikelijk

- us

- Gebruik

- .

- Gebruiker

- gebruikers

- waarde

- groot

- vendors

- onderneming

- venture capital

- via

- Bekijk

- Bekijk de introductievideo

- Wave

- web

- webservices

- bekend

- Wat

- of

- welke

- en

- WIE

- breed

- Grote range

- Wikipedia

- wil

- winnen

- winnaars

- wijsheid

- zonder

- woorden

- Mijn werk

- workflows

- het schrijven van

- jaar

- zephyrnet