Kunstmatige intelligentie (AI) heeft een revolutie teweeggebracht in verschillende sectoren en biedt talloze voordelen en kansen. Er zijn echter zorgen ontstaan over het potentieel van AI om discriminatie en vooroordelen in stand te houden. Dit artikel onderzoekt het onderwerp AI-discriminatie en werpt licht op de uitdagingen van het identificeren en aanpakken van vooroordelen die ingebed zijn in AI-systemen. Insiders uit de industrie uiten hun twijfels over de morele en ethische implicaties van AI, daarbij verwijzend naar zorgen over desinformatie, vooroordelen in algoritmen en het genereren van misleidende inhoud. Naarmate de debatten over AI intensiveren, groeit de roep om betekenisvolle regelgeving om transparantie, verantwoording en bescherming van de grondrechten te garanderen.

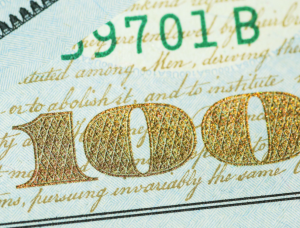

Uitdagingen voor de financiële sector met AI

Volgens Nabil Manji, hoofd crypto en Web3 bij Worldpay by FIS, hangt de effectiviteit van AI-producten sterk af van de kwaliteit van het bronmateriaal dat voor training wordt gebruikt. In een interview met CNBC legde Manji uit dat twee belangrijke factoren bijdragen aan de prestaties van AI: de gegevens waartoe het toegang heeft en de mogelijkheden van het grote taalmodel.

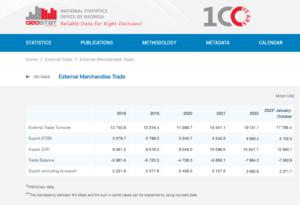

Om het belang van data te illustreren, zei Manji dat bedrijven als Reddit publiekelijk beperkingen hebben afgekondigd op het verzamelen van data, waarbij betaling voor toegang vereist is. In de financiële dienstverleningssector benadrukte hij de uitdaging van gefragmenteerde datasystemen in verschillende talen en formaten. Dit gebrek aan consolidatie en harmonisatie beperkt de effectiviteit van AI-gestuurde producten, vooral in vergelijking met industrieën met gestandaardiseerde en gemoderniseerde data-infrastructuur.

Volgens Manji kan het gebruik van blockchain- of gedistribueerde grootboektechnologie een potentiële oplossing bieden om dit probleem aan te pakken. Deze innovatieve aanpak kan zorgen voor meer transparantie in de gefragmenteerde gegevens die zijn opgeslagen in de ingewikkelde systemen van conventionele banken. Hij erkende echter dat het sterk gereguleerde en traag veranderende karakter van banken hun vermogen zou kunnen belemmeren om snel nieuwe AI-tools te adopteren, in tegenstelling tot meer wendbare technologiebedrijven zoals Microsoft en Google, die de afgelopen paar jaar voorop hebben gelopen bij het stimuleren van innovatie. tientallen jaren.

Als we deze factoren in ogenschouw nemen, wordt het duidelijk dat de financiële sector voor unieke uitdagingen staat bij het benutten van AI vanwege de complexiteit van data-integratie en de inherente aard van de banksector.

Volgens Rumman Chowdhury, voormalig hoofd van machine learning-ethiek, transparantie en verantwoording bij Twitter, is het verstrekken van leningen een opmerkelijk voorbeeld van hoe vooroordelen in AI-systemen negatieve gevolgen kunnen hebben voor gemarginaliseerde gemeenschappen. Tijdens een paneldiscussie in Amsterdam benadrukte Chowdhury de historische praktijk van ‘redlining’ in Chicago in de jaren dertig. Redlining omvatte het weigeren van leningen aan overwegend Afro-Amerikaanse buurten op basis van raciale demografie.

Chowdhury legde uit dat hoewel moderne algoritmen ras misschien niet expliciet als datapunt opnemen, vooroordelen nog steeds impliciet kunnen worden gecodeerd. Bij het ontwikkelen van algoritmen om het risico van districten en individuen voor kredietdoeleinden te beoordelen, kunnen historische gegevens die vooroordelen bevatten onbedoeld discriminatie in stand houden.

Angle Bush, de visionair achter Black Women in Artificial Intelligence, benadrukte het belang van het erkennen van de gevaren die gepaard gaan met het reproduceren van vooroordelen die zijn ingebed in historische gegevens bij het gebruik van AI-systemen om beslissingen te nemen over de goedkeuring van leningen. Een dergelijke praktijk kan leiden tot de automatische afwijzing van leningaanvragen van gemarginaliseerde gemeenschappen, waardoor raciale of genderongelijkheden in stand worden gehouden.

Frost Li, een ervaren AI-ontwikkelaar, wees op de uitdagingen van personalisatie in AI-integratie. Bij het selecteren van ‘kernfuncties’ voor het trainen van AI-modellen kunnen soms niet-gerelateerde factoren betrokken zijn die tot vertekende resultaten kunnen leiden. Li gaf een voorbeeld van hoe fintech-startups die zich op buitenlanders richten, te maken kunnen krijgen met andere kredietbeoordelingscriteria dan lokale banken, die beter bekend zijn met de lokale scholen en gemeenschappen.

Niklas Guske, de COO van Taktile, een startup gespecialiseerd in het automatiseren van de besluitvorming voor fintechs, verduidelijkte dat generatieve AI doorgaans niet wordt gebruikt voor het creëren van kredietscores of risicoscores van consumenten. Integendeel, de kracht ervan ligt in de voorverwerking van ongestructureerde gegevens, zoals tekstbestanden, om de gegevenskwaliteit voor conventionele acceptatiemodellen te verbeteren.

Samenvattend roept het gebruik van AI bij kredietverlening en financiële diensten zorgen op over vooroordelen en discriminatie. De historische vooroordelen die in data zijn ingebed en de selectie van irrelevante kenmerken tijdens AI-training kunnen tot oneerlijke uitkomsten leiden. Het is van cruciaal belang dat banken en financiële instellingen deze problemen onderkennen en aanpakken om de onbedoelde voortzetting van discriminatie bij de implementatie van AI-oplossingen te voorkomen.

Bewijs van AI-discriminatie

Het bewijzen van op AI gebaseerde discriminatie kan een uitdaging zijn, zoals blijkt uit voorbeelden zoals de zaak waarbij Apple en Goldman Sachs betrokken waren. Het New York State Department of Financial Services verwierp de beschuldigingen van het opleggen van lagere limieten aan de Apple Card voor vrouwen, daarbij verwijzend naar een gebrek aan onderbouwend bewijs.

Kim Smouter, directeur van het European Network Against Racism, wijst erop dat de massale inzet van AI voor ondoorzichtigheid in besluitvormingsprocessen zorgt, waardoor het voor individuen moeilijk wordt om discriminatie te identificeren en aan te pakken.

Smouter legt uit dat individuen vaak beperkte kennis hebben van hoe AI-systemen werken, waardoor het een uitdaging is om gevallen van discriminatie of systemische vooroordelen op te sporen. Het wordt zelfs nog complexer wanneer de discriminatie deel uitmaakt van een bredere kwestie die meerdere individuen treft. Smouter verwijst naar het Nederlandse kinderwelzijnsschandaal, waarbij een groot aantal uitkeringsaanvragen ten onrechte als frauduleus werd bestempeld vanwege institutionele vooringenomenheid. De ontdekking van dergelijke disfuncties is een uitdaging, en het verkrijgen van verhaal kan moeilijk en tijdrovend zijn, wat tot aanzienlijke en soms onomkeerbare schade kan leiden.

Deze voorbeelden illustreren de inherente moeilijkheden bij het onderbouwen van op AI gebaseerde discriminatie en het verkrijgen van oplossingen wanneer dergelijke discriminatie zich voordoet. De complexiteit van AI-systemen en het gebrek aan transparantie in besluitvormingsprocessen kunnen het voor individuen lastig maken om gevallen van discriminatie effectief te herkennen en aan te pakken.

Volgens Chowdhury is er dringend behoefte aan een mondiaal regelgevend orgaan vergelijkbaar met de Verenigde Naties om de risico’s die aan AI verbonden zijn, aan te pakken. Hoewel AI opmerkelijke innovatie heeft laten zien, zijn er door technologen en ethici zorgen geuit over de morele en ethische implicaties ervan. Deze zorgen omvatten kwesties zoals desinformatie, ingebedde raciale en gendervooroordelen in AI-algoritmen, en het genereren van misleidende inhoud door tools als ChatGPT.

Chowdhury uit zijn bezorgdheid over het betreden van een post-waarheidswereld waarin online informatie, inclusief tekst, video en audio, onbetrouwbaar wordt als gevolg van generatieve AI. Dit roept vragen op over hoe we de integriteit van informatie kunnen garanderen en hoe we erop kunnen vertrouwen om weloverwogen beslissingen te nemen. Met de AI-wet van de Europese Unie als voorbeeld is zinvolle regulering van AI op dit moment cruciaal. Er zijn echter zorgen over het lange tijdsbestek dat nodig is voordat regelgevingsvoorstellen effectief worden, waardoor noodzakelijke acties mogelijk worden vertraagd.

Smouter benadrukt de noodzaak van meer transparantie en verantwoording in AI-algoritmen. Dit omvat onder meer het begrijpelijker maken van algoritmen voor niet-experts, het uitvoeren van tests en het publiceren van resultaten, het opzetten van onafhankelijke klachtenprocessen, het uitvoeren van periodieke audits en rapportage, en het betrekken van raciale gemeenschappen bij het ontwerp en de inzet van technologie. De handhaving van de AI-wet, die een grondrechtenperspectief hanteert en concepten als verhaal introduceert, zal naar verwachting over ongeveer twee jaar beginnen. Het verkorten van deze tijdlijn zou voordelig zijn om transparantie en verantwoordingsplicht als integrale aspecten van innovatie te handhaven.

- Door SEO aangedreven content en PR-distributie. Word vandaag nog versterkt.

- PlatoData.Network Verticale generatieve AI. Versterk jezelf. Toegang hier.

- PlatoAiStream. Web3-intelligentie. Kennis versterkt. Toegang hier.

- PlatoESG. Automotive / EV's, carbon, CleanTech, Energie, Milieu, Zonne, Afvalbeheer. Toegang hier.

- BlockOffsets. Eigendom voor milieucompensatie moderniseren. Toegang hier.

- Bron: https://www.forexnewsnow.com/fintech/the-urgency-of-addressing-ai-discrimination-transparency-accountability-and-regulatory-timelines/

- : heeft

- :is

- :niet

- :waar

- a

- vermogen

- Over

- toegang

- verantwoording

- erkend

- Handelen

- acties

- adres

- aanpakken

- adopteren

- voordelig

- ongunstig

- invloed hebben op

- Afrikaanse

- tegen

- behendig

- AI

- AI-wet

- AI-systemen

- AI-training

- algoritmen

- beschuldigingen

- Hoewel

- Amerikaans

- an

- en

- verwachte

- Apple

- Apple Card

- toepassingen

- nadering

- goedkeuring

- ongeveer

- ZIJN

- dit artikel

- kunstmatig

- kunstmatige intelligentie

- AS

- aspecten

- schatten

- beoordeling

- geassocieerd

- At

- audio

- audits

- Automatisch

- automatiseren

- Bankieren

- banken sector

- Banken

- gebaseerde

- BE

- worden

- wordt

- geweest

- achter

- voordeel

- betekent

- vooringenomenheid

- vooringenomen

- vooroordelen

- Zwart

- blockchain

- lichaam

- Brengt

- bredere

- by

- Bellen

- CAN

- mogelijkheden

- kaart

- geval

- uitdagen

- uitdagingen

- uitdagend

- ChatGPT

- chicago

- kind

- vorderingen

- verduidelijkt

- CNBC

- Gemeenschappen

- Bedrijven

- vergeleken

- klacht

- complex

- complexiteit

- ingewikkeldheid

- concepten

- Zorgen

- uitvoeren

- consolidering

- Consumenten

- bevat

- content

- tegendeel

- bijdragen

- conventioneel

- kirren

- Wij creëren

- Credits

- criteria

- cruciaal

- crypto

- gevaren

- gegevens

- data-infrastructuur

- gegevens integratie

- data kwaliteit

- debatten

- decennia

- Besluitvorming

- beslissingen

- Demografie

- afdeling

- afhankelijk

- inzet

- Design

- Ontwikkelaar

- het ontwikkelen van

- anders

- moeilijk

- moeilijkheden

- Director

- ontdekking

- Discriminatie

- discussie

- verdeeld

- Gedistribueerd grootboek

- gedistribueerde grootboektechnologie

- aandrijving

- twee

- gedurende

- Nederlands

- effectief

- effectief

- effectiviteit

- ingebed

- voortgekomen

- benadrukt

- omvatten

- handhaving

- verhogen

- verbeterde

- verzekeren

- het invoeren van

- vooral

- oprichting

- ethisch

- ethiek

- Nederlands

- Zelfs

- bewijzen

- duidelijk

- voorbeeld

- voorbeelden

- ervaren

- uitgelegd

- Verklaart

- verkent

- uitdrukkelijk

- Gezicht

- gezichten

- factoren

- vertrouwd

- Voordelen

- weinig

- Bestanden

- financieel

- financiële sectoren

- Financiële instellingen

- financiële diensten

- FinTech

- fintech-startups

- fintechs

- FIS

- Voor

- Voorhoede

- Voormalig

- gefragmenteerd

- frauduleus

- oppompen van

- fundamenteel

- Geslacht

- generatie

- generatief

- generatieve AI

- Globaal

- goldman

- Goldman Sachs

- Kopen Google Reviews

- meer

- Groeiend

- schaden

- Hebben

- he

- hoofd

- hard

- Gemarkeerd

- zeer

- historisch

- Hoe

- Echter

- HTTPS

- identificeren

- het identificeren van

- uitvoering

- implicaties

- belang

- indrukwekkend

- in

- omvatten

- omvat

- Inclusief

- onafhankelijk

- individuen

- industrieën

- -industrie

- ongelijkheid

- informatie

- op de hoogte

- Infrastructuur

- inherent

- Innovatie

- innovatieve

- institutionele

- instellingen

- integraal

- integratie

- integriteit

- Intelligentie

- Interview

- in

- Introduceert

- betrekken

- betrokken zijn

- waarbij

- kwestie

- problemen

- IT

- HAAR

- kennis

- Gebrek

- taal

- Talen

- Groot

- leiden

- leidend

- leren

- Grootboek

- kredietverlening

- leveraging

- li

- ligt

- licht

- als

- Beperkt

- grenzen

- lening

- Leningen

- lokaal

- LOKALE BANKEN

- te verlagen

- machine

- machine learning

- Hoofd

- maken

- maken

- Massa

- materiaal

- Mei..

- zinvolle

- vermeld

- Microsoft

- macht

- Desinformatie

- misleidend

- model

- modellen

- Modern

- moment

- moreel

- meer

- meervoudig

- Landen

- NATUUR

- noodzakelijk

- Noodzaak

- netwerk

- New

- New York

- New York staat

- Afdeling financiële diensten van de staat New York

- niet-experts

- opvallend

- aantal

- vele

- talrijke voordelen

- het verkrijgen van

- of

- bieden

- het aanbieden van

- vaak

- on

- online.

- besturen

- Kansen

- or

- uit

- resultaten

- paneel

- paneldiscussie

- deel

- verleden

- betaling

- prestatie

- periodiek

- Personalisatie

- perspectief

- Plato

- Plato gegevensintelligentie

- PlatoData

- punt

- punten

- potentieel

- mogelijk

- praktijk

- hoofdzakelijk

- druk

- voorkomen

- probleem

- processen

- Producten

- voorstellen

- bescherming

- zorgen voor

- mits

- in het openbaar

- Reclame

- doeleinden

- kwaliteit

- Contact

- Race

- racisme

- opgebracht

- verhoogt

- herkennen

- vermindering

- referenties

- met betrekking tot

- gereguleerd

- Regulatie

- regelgevers

- vertrouwen

- opmerkelijk

- Rapportage

- beperkingen

- Resultaten

- revolutie

- rechten

- Risico

- risico's

- Sachs

- Schandaal

- scholen

- scores

- scoren

- schrapen

- sector

- selecteren

- selectie

- Diensten

- getoond

- betekenis

- aanzienlijke

- gelijk

- oplossing

- Oplossingen

- bron

- spreken

- gespecialiseerd

- startup

- Startups

- Land

- Ministerie van Buitenlandse Zaken

- Still

- opgeslagen

- sterkte

- dergelijk

- OVERZICHT

- nabijgelegen

- snel

- systemische

- Systems

- aanpakken

- neemt

- targeting

- tech

- tech bedrijven

- technologen

- Technologie

- testen

- dat

- De

- De Bron

- hun

- Er.

- daarbij

- Deze

- dit

- tijdrovend

- tijdlijn

- tijdlijnen

- naar

- tools

- onderwerp

- Trainingen

- Transparantie

- X

- twee

- typisch

- begrijpelijk

- underwriting

- oneerlijk

- unieke

- United

- Verenigde Naties

- anders

- hooghouden

- urgentie

- .

- gebruikt

- divers

- Video

- visionaire

- we

- Web3

- Welzijn

- waren

- wanneer

- welke

- en

- Met

- binnen

- Dames

- wereld

- WorldPay

- zorgen

- zou

- jaar

- york

- zephyrnet