We willen allemaal onze ideale menselijke waarden weerspiegeld zien in onze technologieën. We verwachten dat technologieën zoals kunstmatige intelligentie (AI) niet tegen ons liegen, niet discrimineren en veilig zijn voor ons en onze kinderen om te gebruiken. Toch worden veel AI-makers momenteel geconfronteerd met terugslag vanwege de vooroordelen, onnauwkeurigheden en problematische datapraktijken die in hun modellen aan het licht komen. Deze problemen vereisen meer dan een technische, algoritmische of op AI gebaseerde oplossing. In werkelijkheid is een holistische, sociaal-technische benadering vereist.

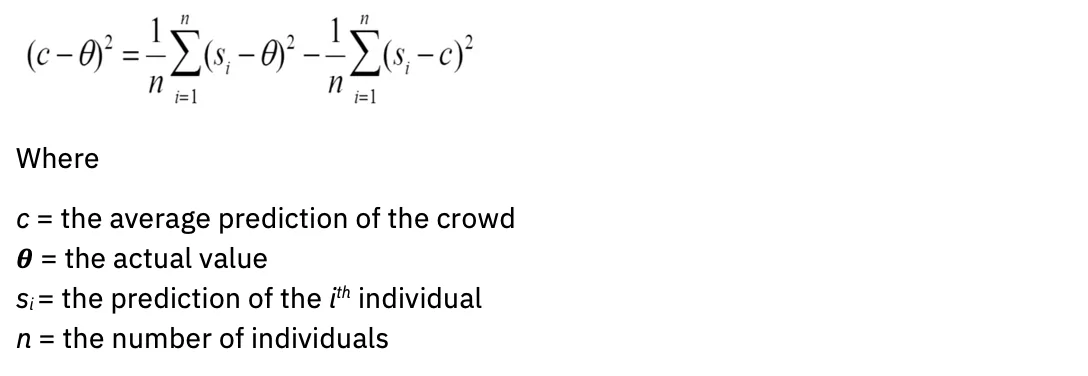

De wiskunde toont een krachtige waarheid aan

Alle voorspellende modellen, inclusief AI, zijn nauwkeuriger als ze diverse menselijke intelligentie en ervaring integreren. Dit is geen mening; het heeft empirische validiteit. Houd rekening met de diversiteitsvoorspellingsstelling. Simpel gezegd: wanneer de diversiteit in een groep groot is, is de fout van de menigte klein – wat het concept van ‘de wijsheid van de menigte’ ondersteunt. In een invloedrijk onderzoek werd aangetoond dat diverse groepen probleemoplossers met een laag vermogen beter kunnen presteren dan groepen probleemoplossers met een hoog vermogen (Hong & Pagina, 2004).

In wiskundige taal: hoe groter uw variantie, hoe standaarder uw gemiddelde. De vergelijking ziet er als volgt uit:

A verdere studie leverden meer berekeningen op die de statistische definities van een wijze menigte verfijnen, inclusief onwetendheid over de voorspellingen van andere leden en het opnemen van mensen met maximaal verschillend (negatief gecorreleerde) voorspellingen of oordelen. Het is dus niet alleen het volume, maar ook de diversiteit die de voorspellingen verbetert. Hoe kan dit inzicht de evaluatie van AI-modellen beïnvloeden?

Model(on)nauwkeurigheid

Om een algemeen aforisme te citeren: alle modellen zijn fout. Dit geldt op het gebied van statistiek, wetenschap en AI. Modellen die zijn gemaakt met een gebrek aan domeinexpertise kunnen leiden tot fout uitgangen.

Tegenwoordig bepaalt een kleine homogene groep mensen welke gegevens moeten worden gebruikt om generatieve AI-modellen te trainen, die zijn ontleend aan bronnen die het Engels sterk oververtegenwoordigd zijn. “Voor de meeste van de ruim 6,000 talen in de wereld zijn de beschikbare tekstgegevens niet voldoende om een grootschalig basismodel te trainen” (uit “Over de kansen en risico's van funderingsmodellen”, Bommasani et al., 2022).

Bovendien zijn de modellen zelf gemaakt op basis van beperkte architecturen: “Bijna alle state-of-the-art NLP-modellen zijn nu aangepast van een van de weinige basismodellen, zoals BERT, RoBERTa, BART, T5, enz. Terwijl deze homogenisering produceert extreem hoge hefboomwerking (elke verbetering in de basismodellen kan leiden tot onmiddellijke voordelen voor heel NLP), het is ook een risico; alle AI-systemen zouden dezelfde problematische vooroordelen van een paar basismodellen kunnen erven (Bommasani et al.) "

Wil generatieve AI de diverse gemeenschappen die zij bedient beter weerspiegelen, dan moet een veel grotere verscheidenheid aan menselijke gegevens in modellen worden weergegeven.

Het evalueren van de nauwkeurigheid van modellen gaat hand in hand met het evalueren van bias. We moeten ons afvragen: wat is de bedoeling van het model en voor wie is het geoptimaliseerd? Denk bijvoorbeeld eens aan wie het meest profiteert van algoritmen voor inhoudsaanbeveling en algoritmen van zoekmachines. Stakeholders kunnen zeer uiteenlopende belangen en doelstellingen hebben. Algoritmen en modellen vereisen doelen of proxy's voor de Bayes-fout: de minimale fout die een model moet verbeteren. Deze proxy is vaak een persoon, zoals een materiedeskundige met domeinexpertise.

Een zeer menselijke uitdaging: het beoordelen van risico's vóór de aanschaf of ontwikkeling van modellen

Opkomende AI-regelgeving en actieplannen onderstrepen steeds meer het belang van algoritmische impactbeoordelingsformulieren. Het doel van deze formulieren is om cruciale informatie over AI-modellen vast te leggen, zodat governanceteams hun risico’s kunnen beoordelen en aanpakken voordat ze worden ingezet. Typische vragen zijn onder meer:

- Wat is de use-case van uw model?

- Wat zijn de risico's voor ongelijksoortige impact?

- Hoe beoordeelt u de eerlijkheid?

- Hoe maak je je model verklaarbaar?

Hoewel ontworpen met goede bedoelingen, is het probleem dat de meeste eigenaren van AI-modellen niet begrijpen hoe ze de risico's voor hun gebruiksscenario moeten evalueren. Een veelgehoord refrein zou kunnen zijn: "Hoe kan mijn model oneerlijk zijn als het geen persoonlijk identificeerbare informatie (PII) verzamelt?" Bijgevolg worden de formulieren zelden met de bedachtzaamheid ingevuld die nodig is voor bestuurssystemen om risicofactoren nauwkeurig te signaleren.

Zo wordt het sociaal-technische karakter van de oplossing onderstreept. Een modeleigenaar – een individu – kan niet zomaar een lijst met selectievakjes krijgen om te beoordelen of zijn gebruiksscenario schade zal aanrichten. Wat in plaats daarvan nodig is, zijn groepen mensen met sterk uiteenlopende ervaringen in de leefwereld die samenkomen in gemeenschappen die psychologische veiligheid bieden, zodat ze moeilijke gesprekken kunnen voeren over uiteenlopende gevolgen.

Het verwelkomen van bredere perspectieven voor betrouwbare AI

IBM® gelooft in een 'client zero'-benadering, waarbij de aanbevelingen en systemen die het voor zijn eigen klanten zou doen, worden geïmplementeerd in advies- en productgestuurde oplossingen. Deze aanpak strekt zich uit tot ethische praktijken, en daarom heeft IBM een Trustworthy AI Center of Excellence (COE) opgericht.

Zoals hierboven uitgelegd, is diversiteit aan ervaringen en vaardigheden van cruciaal belang om de impact van AI goed te kunnen evalueren. Maar het vooruitzicht om deel te nemen aan een Centre of Excellence kan intimiderend zijn in een bedrijf dat barst van de AI-vernieuwers, experts en vooraanstaande ingenieurs, dus het cultiveren van een gemeenschap van psychologische veiligheid is nodig. IBM communiceert dit duidelijk door te zeggen: “Geïnteresseerd in AI? Geïnteresseerd in AI-ethiek? Jij neemt plaats aan deze tafel.”

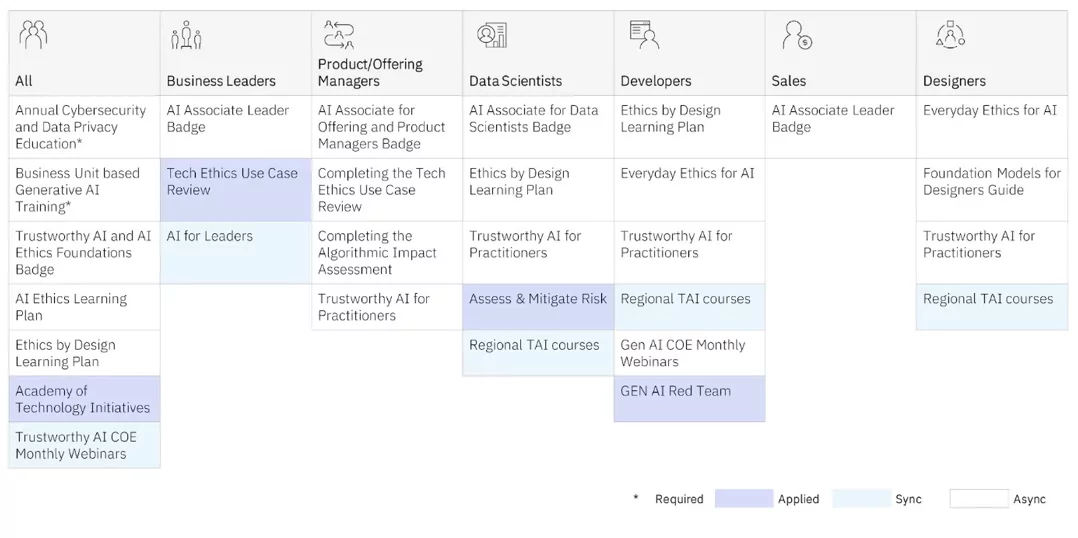

De COE biedt training in AI-ethiek aan beoefenaars op elk niveau. Er worden zowel synchroon leren (leraar en leerlingen in klasverband) als asynchrone (zelfgestuurde) programma's aangeboden.

Maar het zijn de COE's toegepast training die onze praktijkmensen de diepste inzichten geeft, terwijl ze met mondiale, diverse, multidisciplinaire teams aan echte projecten werken om de uiteenlopende impact beter te begrijpen. Ze maken ook gebruik van de design thinking-frameworks van IBM Ontwerp voor AI Group gebruikt dit intern en samen met klanten om de onbedoelde effecten van AI-modellen te beoordelen, waarbij degenen die vaak worden gemarginaliseerd voorop blijven staan. (Zie Sylvia Duckworths Rad van Macht en Privilege voor voorbeelden van hoe persoonlijke kenmerken elkaar kruisen om mensen te bevoorrechten of te marginaliseren.) IBM schonk ook veel van de raamwerken aan de open-sourcegemeenschap Ontwerp ethisch.

Hieronder staan enkele van de rapporten die IBM publiekelijk over deze projecten heeft gepubliceerd:

Geautomatiseerde AI-modelbeheertools zijn nodig om belangrijke inzichten te verkrijgen over hoe uw AI-model presteert. Maar let op: het vastleggen van risico's lang voordat uw model is ontwikkeld en in productie is, is optimaal. Door gemeenschappen van diverse, multidisciplinaire beoefenaars te creëren die mensen een veilige ruimte bieden om moeilijke gesprekken te voeren over uiteenlopende impacts, kunt u uw reis beginnen naar het operationeel maken van uw principes en het op verantwoorde wijze ontwikkelen van AI.

Als u AI-professionals inhuurt, moet u er in de praktijk rekening mee houden dat ruim 70% van de inspanning bij het maken van modellen bestaat uit het verzamelen van de juiste gegevens. Je wilt mensen inhuren die weten hoe ze gegevens moeten verzamelen die representatief zijn en die ook met toestemming worden verzameld. Je wilt ook dat mensen die het weten, nauw samenwerken met domeinexperts om er zeker van te zijn dat ze de juiste aanpak hebben. Ervoor zorgen dat deze beoefenaars over de emotionele intelligentie beschikken om de uitdaging van het verantwoord beheren van AI met nederigheid en onderscheidingsvermogen aan te gaan, is van cruciaal belang. We moeten doelbewust leren herkennen hoe en wanneer AI-systemen de ongelijkheid net zo goed kunnen verergeren als de menselijke intelligentie kunnen vergroten.

Vind opnieuw uit hoe uw bedrijf werkt met AI

Was dit artikel behulpzaam?

JaNee

Meer van Kunstmatige intelligentie

IBM-nieuwsbrieven

Ontvang onze nieuwsbrieven en onderwerpupdates die de nieuwste thought leadership en inzichten over opkomende trends bieden.

Abonneer nu

Meer nieuwsbrieven

- Door SEO aangedreven content en PR-distributie. Word vandaag nog versterkt.

- PlatoData.Network Verticale generatieve AI. Versterk jezelf. Toegang hier.

- PlatoAiStream. Web3-intelligentie. Kennis versterkt. Toegang hier.

- PlatoESG. carbon, CleanTech, Energie, Milieu, Zonne, Afvalbeheer. Toegang hier.

- Plato Gezondheid. Intelligentie op het gebied van biotech en klinische proeven. Toegang hier.

- Bron: https://www.ibm.com/blog/why-we-need-diverse-multidisciplinary-coes-for-model-risk/

- : heeft

- :is

- :niet

- :waar

- $UP

- 000

- 1

- 16

- 2022

- 2024

- 23

- 25

- 28

- 29

- 30

- 300

- 32

- 39

- 40

- 400

- 65

- 7

- 9

- a

- vermogen

- Over

- boven

- AC

- versnellen

- nauwkeurigheid

- accuraat

- nauwkeurig

- over

- Actie

- aangepast

- adres

- toegeven

- adopteren

- ADVERTISING

- advies

- invloed hebben op

- agenten

- AI

- AI-modellen

- AI-systemen

- streven

- AL

- algoritmische

- algoritmen

- Alles

- ook

- altijd

- amp

- an

- analytics

- en

- elke

- Aanvraag

- toepassingen

- nadering

- ZIJN

- gebieden

- dit artikel

- kunstmatig

- kunstmatige intelligentie

- Kunstmatige intelligentie (AI)

- AS

- vragen

- schatten

- Het beoordelen

- beoordeling

- assistenten

- bijstaan

- At

- audio

- vergroten

- auteur

- Beschikbaar

- vermijd

- terug

- balancing

- BE

- geweest

- vaardigheden

- beginnen

- wezen

- gelooft

- betekent

- Betere

- Verder

- vooringenomenheid

- vooroordelen

- Blog

- blogs

- Blauw

- Boston

- zowel

- bredere

- Gebouw

- bedrijfsdeskundigen

- zakelijke functies

- ondernemingen

- maar

- by

- CAN

- vangen

- Het vastleggen

- carbon

- kaart

- Kaarten

- verzorging

- geval

- KAT

- Categorie

- Veroorzaken

- Centreren

- Center of Excellence

- centraal

- zeker

- uitdagen

- kenmerken

- chatbots

- controle

- kind

- Kinderen

- cirkels

- CIS

- klasse

- duidelijk

- klanten

- van nabij

- Cloud

- kleur

- combinatie van

- komst

- Gemeen

- Gemeenschappen

- gemeenschap

- Bedrijven

- afstand

- Voltooid

- concept

- toestemming

- bijgevolg

- Overwegen

- consulting

- Containers

- voortzetten

- conversaties

- Kern

- te corrigeren

- gecorreleerd

- Kosten

- kon

- aangemaakt

- Wij creëren

- scheppers

- kritisch

- menigte

- CSS

- curating

- Op dit moment

- gewoonte

- klant

- klantervaring

- Klanten

- gegevens

- Datum

- beslissingen

- diepste

- Standaard

- definities

- leveren

- demonstreert

- het inzetten

- beschrijving

- Design

- denken over design

- ontworpen

- Bepalen

- ontwikkelen

- ontwikkelde

- anders

- moeilijk

- digitaal

- Digitale Transformatie

- ongelijksoortig

- Gedistingeerd

- diversen

- Verscheidenheid

- do

- domein

- schonk

- getrokken

- rit

- E & T

- duurt

- inspanning

- elimineren

- inbedding

- omarmen

- opkomende

- medewerkers

- in staat stellen

- boeiende

- Motor

- Ingenieurs

- Engels

- genoeg

- zorgen

- Enter

- fout

- etc

- Ether (ETH)

- ethisch

- ethiek

- schatten

- evalueren

- evaluatie

- Zelfs

- Alle

- overal

- verscherpen

- voorbeeld

- voorbeelden

- Uitmuntendheid

- afrit

- verwachten

- ervaring

- Ervaringen

- expert

- expertise

- deskundigen

- uitgelegd

- blootgestelde

- strekt

- uiterst

- facebook messenger

- vergemakkelijken

- naar

- factoren

- eerlijkheid

- vals

- ver

- SNELLE

- weinig

- VIND DE PLEK DIE PERFECT VOOR JOU IS

- Focus

- volgen

- volgend

- fonts

- Voor

- Voorhoede

- formulieren

- Foundation

- frameworks

- oppompen van

- voor

- functies

- verzamelen

- verzameld

- verzameling

- generatief

- generatieve AI

- generator

- krijgen

- gegeven

- geeft

- Globaal

- doel

- Doelen

- Goes

- goed

- bestuur

- Grammatica

- sterk

- Raster

- Groep

- Groep

- gids

- schaden

- Hebben

- Titel

- horen

- Hoogte

- hulp

- nuttig

- Hoge

- hem

- huren

- Verhuring

- zijn

- houdt

- holistische

- Home

- Hoe

- How To

- HTTPS

- menselijk

- menselijke intelligentie

- nederigheid

- Hybride

- hybride cloud

- i

- ZIEK

- IBM

- ICO

- ICON

- ideaal

- geïdentificeerd

- if

- Onwetendheid

- beeld

- Onmiddellijk

- Impact

- Effecten

- uitvoeren

- uitvoering

- belang

- belangrijk

- verbeteren

- verbeteringen

- verbetert

- in

- omvatten

- Inclusief

- inclusie

- nemen

- in toenemende mate

- incrementele

- index

- -industrie

- invloedrijk

- informatie

- Innovatie

- innovators

- invoer

- inzicht

- inzichten

- ogenblikkelijk

- verkrijgen in plaats daarvan

- Instituut

- verzekering

- verzekeraars

- Intelligentie

- Intelligent

- aandachtig

- Opzettelijk

- intenties

- geïnteresseerd

- belangen

- inwendig

- snijden

- tussenkomst

- intimiderend

- intrinsiek

- isn

- kwestie

- problemen

- IT

- HAAR

- Januari

- mee

- Doe mee

- jpg

- voor slechts

- houden

- sleutel

- blijven

- bekend

- Gebrek

- taal

- Talen

- Groot

- grootschalig

- laatste

- leiden

- leider

- Leadership

- leren

- laten

- Niveau

- Hefboomwerking

- aansprakelijkheid

- Leugen

- als

- Beperkt

- Lijst

- lokaal

- lokaal

- LOOKS

- maken

- maken

- management

- handboek

- veel

- wiskunde

- wiskundig

- Materie

- max-width

- Mei..

- me

- gemiddelde

- Maak kennis met

- Messenger

- macht

- Min

- denken

- minimum

- minuten

- Mobile

- model

- modellen

- modernisering

- meer

- meest

- beweging

- veel

- multidisciplinaire

- Dan moet je

- my

- NATUUR

- Navigatie

- noodzakelijk

- Noodzaak

- nodig

- behoeften

- negatief

- New

- nieuwe producten

- Nieuwsbrieven

- nlp

- geen

- nota

- niets

- nu

- vele

- of

- korting

- bieden

- aangeboden

- Aanbod

- vaak

- on

- EEN

- open source

- Advies

- Kansen

- optimale

- geoptimaliseerde

- or

- organisaties

- Overige

- onze

- Overtreffen

- uitgangen

- over

- het te bezitten.

- eigenaren

- pagina

- deelnemende

- passeren

- Mensen

- uitvoerend

- persoon

- persoonlijk

- Persoonlijk

- perspectieven

- PHP

- pii

- plannen

- Plato

- Plato gegevensintelligentie

- PlatoData

- inpluggen

- beleidsmaatregelen

- positie

- Post

- potentieel

- potentiële klanten

- energie

- krachtige

- praktijk

- praktijken

- voorspelling

- Voorspellingen

- voorspellend

- primair

- principes

- prioriteren

- privilege

- probleem

- inkoop

- produceert

- productie

- produktiviteit

- Producten

- Programma's

- projecten

- naar behoren

- vooruitzicht

- mits

- het verstrekken van

- proxies

- volmacht

- psychologisch

- in het openbaar

- gepubliceerde

- zetten

- Contact

- snel

- citeren

- zelden

- gereedheid

- lezing

- vast

- Realiteit

- herkennen

- aanbevelingen

- vermindering

- verfijnen

- reflecteren

- weerspiegeld

- reglement

- Rapporten

- vertegenwoordiger

- vertegenwoordigd

- verzoeken

- vereisen

- nodig

- onderzoek

- reageert

- verantwoordelijk

- verantwoorde

- responsive

- inkomsten

- Omzetgroei

- rechts

- Risico

- risicofactoren

- risico's

- weg

- robots

- veilig

- Veiligheid

- Zei

- dezelfde

- gezegde

- Scale

- scaling

- Wetenschap

- scherm

- scripts

- Ontdek

- zoekmachine

- beveiligen

- zien

- seo

- bedient

- settings

- moet

- getoond

- eenvoudigweg

- website

- speling

- Klein

- slim

- Slimme luidsprekers

- SMS

- So

- oplossing

- Oplossingen

- sommige

- bronnen

- Tussenruimte

- speakers

- Gesponsorde

- pleinen

- stakeholders

- standaard

- begin

- state-of-the-art

- statistisch

- statistiek

- Leerlingen

- Studie

- onderwerpen

- abonneren

- dergelijk

- ondersteuning

- Ondersteuning

- SVG

- Systems

- T

- tafel

- het nemen

- doelen

- leraar

- teams

- Technisch

- Technologies

- tertiair

- tekst

- neem contact

- bedankt

- dat

- De

- de wereld

- hun

- Ze

- thema

- zich

- Deze

- ze

- denken

- het denken

- dit

- die

- gedachte

- thought leadership

- drie

- Door

- niet de tijd of

- Titel

- naar

- samen

- tools

- top

- onderwerp

- taai

- Trainen

- Trainingen

- Transformatie

- Trends

- waar

- betrouwbaar

- X

- twee

- type dan:

- typisch

- begrijpen

- oneerlijk

- unieke

- ontgrendelen

- updates

- op

- URL

- us

- .

- use case

- toepassingen

- Gebruik makend

- waarde

- Values

- variëteit

- wisselende

- zeer

- Virtueel

- volume

- W

- willen

- was

- we

- GOED

- Wat

- Wat is

- wanneer

- of

- welke

- en

- WIE

- wie

- Waarom

- wijd

- bredere

- wil

- wijsheid

- WISE

- Met

- Woord

- WordPress

- Mijn werk

- Bedrijven

- wereld

- zou

- geschreven

- Verkeerd

- nog

- u

- Your

- zephyrnet