Suresh is een technologiemanager met diepgaande technische expertise op het gebied van halfgeleiders, kunstmatige intelligentie, cyberbeveiliging, internet-of-things, hardware, software, enz. Hij heeft twintig jaar in de sector doorgebracht, waarvan hij meest recentelijk als uitvoerend directeur voor open-source zero- trust chipontwikkeling bij het Technology Innovation Institute, Abu Dhabi, en bij andere Fortune 20-halfgeleiderbedrijven zoals Intel, Qualcomm en MediaTek in verschillende leiderschapsrollen, waar hij onderzoek deed naar en ontwikkelde hoogwaardige, energie-efficiënte, post-kwantumveilige, veilige microchips/system-on-chips (SoC's)/accelerators voor de datacenter-, client-, smartphone-, netwerk-, IoT- en AI/ML-markten. Hij droeg bij aan de Falcon LLM (gerangschikt op nummer 500 in Huggingface) en was de hoofdarchitect voor het aangepaste AI-hardwareplatform (geannuleerd – prioriteiten gewijzigd). Hij heeft meer dan 1 Amerikaanse patenten en heeft op meer dan 15 conferenties gepubliceerd/gepresenteerd.

Suresh is een technologiemanager met diepgaande technische expertise op het gebied van halfgeleiders, kunstmatige intelligentie, cyberbeveiliging, internet-of-things, hardware, software, enz. Hij heeft twintig jaar in de sector doorgebracht, waarvan hij meest recentelijk als uitvoerend directeur voor open-source zero- trust chipontwikkeling bij het Technology Innovation Institute, Abu Dhabi, en bij andere Fortune 20-halfgeleiderbedrijven zoals Intel, Qualcomm en MediaTek in verschillende leiderschapsrollen, waar hij onderzoek deed naar en ontwikkelde hoogwaardige, energie-efficiënte, post-kwantumveilige, veilige microchips/system-on-chips (SoC's)/accelerators voor de datacenter-, client-, smartphone-, netwerk-, IoT- en AI/ML-markten. Hij droeg bij aan de Falcon LLM (gerangschikt op nummer 500 in Huggingface) en was de hoofdarchitect voor het aangepaste AI-hardwareplatform (geannuleerd – prioriteiten gewijzigd). Hij heeft meer dan 1 Amerikaanse patenten en heeft op meer dan 15 conferenties gepubliceerd/gepresenteerd.

Suresh bekleedt ook actief een leidende positie bij RISC-V International, waar hij voorzitter is van de Trusted Computing Group om vertrouwelijke computercapaciteiten van RISC-V te ontwikkelen en voorzitter is van de AI/ML Group om RISC-V-hardwareversnelling te ontwikkelen voor AI/ML-workloads zoals Transformer grote taalmodellen die worden gebruikt in ChatGPT-toepassingen. Hij adviseert ook startups en durfkapitaalbedrijven over ondersteuning bij investeringsbeslissingen, productstrategie, technologiedue diligence, enz.

Hij behaalde een MBA van INSEAD, een MS van het Birla Institute of Technology & Science Pilani, een Systems Engineering-certificaat van MIT, een AI-certificaat van Stanford en een auto-functioneel veiligheidscertificaat van TÜV SÜD.

Vertel ons over uw bedrijf

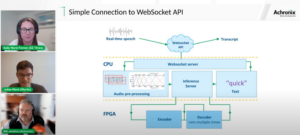

"Mastiska AI” (Mastiṣka betekent Hersenen in het Sanskriet) is een AI-bedrijf dat zich richt op het bouwen van hersenachtige computers om basismodellen efficiënter uit te voeren voor de generatieve AI-gebruiksscenario's van morgen.

Welke problemen los je op?

Gezien de voordelen van AI/GenAI zal de vraag ernaar alleen maar toenemen, en dat geldt ook voor de bijwerkingen op onze planeet. Hoe kunnen we de bijwerkingen van AI op onze planeet verminderen of neutraliseren? Koolstofafvang en kernenergie gaan de goede kant op. Maar we moeten de manier waarop we AI gebruiken fundamenteel heroverwegen: is het de verkeerde manier om tonnen matrixvermenigvuldigingen uit te voeren?

Onze hersenen kunnen veel taken parallel leren en uitvoeren, in en onder de 10 W, maar waarom verbruiken deze AI-systemen tientallen megawatts om modellen te trainen?

Misschien heeft de toekomst energie-efficiënte architecturen zoals neuromorfe architecturen en op neurale netwerken gebaseerde transformatoren die het dichtst bij het menselijk brein staan, die mogelijk 100-1000x minder energie verbruiken, waardoor de kosten van het gebruik van AI worden verlaagd, waardoor het wordt gedemocratiseerd en onze economie wordt gered. planeet.

De huidige uitdagingen waarmee we worden geconfronteerd met AI, namelijk a) beschikbaarheid, b) toegankelijkheid, c) betaalbaarheid en d) milieuveiligheid, samen met enkele aanbevelingen om deze aan te pakken.

Als we in de toekomst voorzien, worden enkele bruikbare AGI-concepten gedemonstreerd in de film “HER”, waarin het personage ‘Samantha’ – een gesprekspartner die natuurlijk is, emoties begrijpt, empathie toont, een geweldige copiloot op het werk is – en op het werk draait de hele dag draagbare apparaten, dan moeten we misschien nu de onderstaande uitdagingen aanpakken.

Probleem 1: Het trainen van een LLM kan tussen de 150 en meer dan 10 miljoen dollar kosten, en alleen mensen met diepere financiële middelen kunnen AI ontwikkelen. Bovendien zijn de kosten voor het infereren ook enorm (kost 10x meer dan een zoekopdracht op internet)

—> We moeten de energie-efficiëntie van modellen/hardware verbeteren om AI te democratiseren ten behoeve van de mensheid.

Probleem 2: Het draaien van gigantische AI-modellen voor gespreksagenten of aanbevelingssystemen belast het milieu in termen van elektriciteitsverbruik en koeling.

-> We moeten de energie-efficiëntie van modellen/hardware verbeteren om onze planeet te redden voor onze kinderen.

Probleem 3: Het menselijk brein is capabel en kan multitasken, maar verbruikt slechts 10 Watt in plaats van Megawatt.

—> Misschien moeten we machines zoals onze hersenen bouwen en niet de reguliere matrixvermenigvuldigers sneller.

De mensheid kan alleen gedijen met duurzame innovaties, en niet door alle bossen te kappen en de oceanen te koken in naam van innovatie. We moeten onze planeet beschermen voor het welzijn van onze kinderen en toekomstige generaties...

Welke toepassingsgebieden zijn uw sterkste?

Training en gevolgtrekking van op Transformer (en toekomstige neurale architectuur) gebaseerde basismodellen, met 50-100x meer energie-efficiëntie vergeleken met de huidige GPU-gebaseerde oplossingen.

Wat houdt uw klanten 's nachts wakker?

Problemen voor klanten die momenteel andere producten gebruiken:

Het elektriciteitsverbruik voor het trainen van gigantische taalmodellen is enorm. Het trainen van een LLM met een parameter van 13B op 390B teksttokens op 200 GPU's gedurende 7 dagen kost bijvoorbeeld $ 151,744 (Bron: HuggingFace nieuwe trainingsclusterservicepagina - https://lnkd.in/g6Vc5cz3). En zelfs grotere modellen met 100+B-parameters kosten $10+M alleen al om te trainen. Betaal vervolgens voor de gevolgtrekking elke keer dat er een nieuw promptverzoek binnenkomt.

Waterverbruik voor koeling, onderzoekers van de Universiteit van Californië, Riverside schatten de milieu-impact van ChatGPT-achtige service, en zeggen dat het 500 milliliter water opslokt (ongeveer wat er in een 16-ounce waterfles zit) elke keer dat je erom vraagt reeks van 5 tot 50 aanwijzingen of vragen. Het bereik varieert afhankelijk van waar de servers zich bevinden en het seizoen. De schatting omvat indirect waterverbruik dat de bedrijven niet meten, bijvoorbeeld voor het koelen van energiecentrales die de datacenters van elektriciteit voorzien. (Bron: https://lnkd.in/gybcxX8C)

Problemen voor niet-klanten van huidige producten:

Kan zich geen CAPEX veroorloven om hardware te kopen

Ik kan het me niet veroorloven om clouddiensten te gebruiken

Kan niet innoveren of AI benutten – zit vast aan een dienstenmodel dat elk concurrentievoordeel elimineert

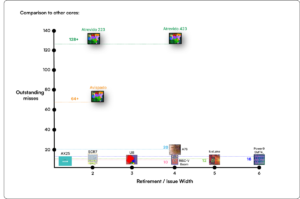

Hoe ziet het concurrentielandschap eruit en hoe onderscheid je je?

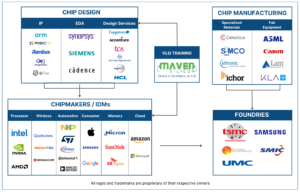

- GPU's domineren de trainingsruimte, ook al concurreren gespecialiseerde ASIC's ook in dit segment

- Cloud & Edge-inferentie heeft te veel opties beschikbaar

Digitaal, analoog, fotonisch – noem maar op, mensen proberen hetzelfde probleem aan te pakken.

Kunt u uw mening geven over de huidige stand van zaken op het gebied van chiparchitectuur voor AI/ML, dat wil zeggen: wat ziet u op dit moment als de belangrijkste trends en kansen?

Volgende trends:

Tendens 1: Tien jaar geleden bloeide het door hardware ondersteunde deep learning, en nu remt diezelfde hardware de vooruitgang af. Vanwege de enorme kosten van hardware en elektriciteitskosten om modellen te laten draaien, is het een uitdaging geworden om toegang te krijgen tot de hardware. Alleen bedrijven met diepe zakken kunnen zich deze veroorloven en worden monopolies.

Tendens 2: Nu deze modellen er zijn, moeten we ze voor praktische doeleinden gebruiken, zodat de inferentiebelasting toeneemt, waardoor CPU's met AI-versnellers weer in de schijnwerpers kunnen komen.

Tendens 3: Startups proberen alternatieve drijvende-kommagetalrepresentaties te bedenken waarbij het traditionele IEEE-formaat – zoals logaritmisch en posit-gebaseerd – goed is, maar niet voldoende. De optimalisatie van de PPA$-ontwerpruimte explodeert wanneer we de een proberen te optimaliseren en de ander een gooi doet.

Tendens 4: De industrie stapt af van het op diensten gebaseerde AI-model naar het hosten van haar eigen privémodellen op eigen terrein – maar de toegang tot hardware is een uitdaging vanwege tekorten in het aanbod, sancties, enz.

Huidige stand van zaken:

De beschikbaarheid van hardware en data heeft tien jaar geleden de groei van AI aangewakkerd, maar nu remt dezelfde hardware dit min of meer af – laat me het uitleggen

Sinds CPU's het slecht deden en GPU's werden herbestemd om AI te doen, zijn er veel dingen gebeurd

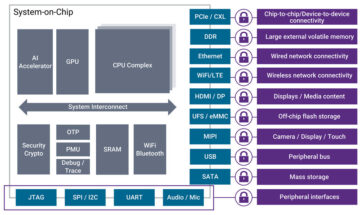

Bedrijven hebben zich beziggehouden met vier segmenten van AI/ML, namelijk: 4) cloudtraining, 1) cloudinferencing, 2) edge-inferencing en 3) edge-training (federatief leren voor privacygevoelige toepassingen).

Digitaal & Analoog

Trainingskant – een overvloed aan bedrijven die GPU's maken, klantversnellers gebaseerd op RISC-V, chips op wafer-schaal (850K cores), enzovoort waar traditionele CPU's ontbreken (hun algemene doel). Inferentiekant – NN-accelerators zijn verkrijgbaar bij elke fabrikant, in smartphones, laptops en andere edge-apparaten.

Analoge, op memristor gebaseerde architecturen zijn enige tijd geleden ook opgedoken.

Wij geloven dat CPU's heel goed kunnen zijn in het maken van conclusies als we dit verbeteren met versnelling, zoals matrixuitbreidingen

RISC-V-kant van de zaak:

Aan de RISC-V-kant ontwikkelen we versnellers voor matrixoperaties en andere niet-lineaire operaties om mogelijke knelpunten voor de werkbelasting van transformatoren te elimineren. Von Neumann-knelpunten worden ook aangepakt door herinneringen dichter bij computers te ontwerpen, waardoor CPU's met AI-versnelling uiteindelijk de juiste keuze worden voor gevolgtrekking.

Mogelijkheden:

Er bestaan unieke mogelijkheden om de markt van funderingsmodellen in te vullen. Voorbeeld – OpenAI heeft vermeld dat ze niet in staat waren om voldoende AI-compute (GPU's) te beveiligen om hun ChatGPT-diensten te blijven pushen... en de nieuwsberichten over elektriciteitskosten van 10x van die van reguliere internetzoekopdrachten en 500 ml water om de systemen te koelen voor elke vraag. Er is hier een markt die moet worden ingevuld – het is geen nichemarkt, maar het is de hele markt die AI zal democratiseren en alle bovengenoemde uitdagingen zal aanpakken – a) beschikbaarheid, b) toegankelijkheid, c) betaalbaarheid en d) milieuveiligheid.

Aan welke nieuwe functies/technologie werkt u?

We bouwen hersenen zoals computers, waarbij we gebruik maken van neuromodrphische technieken en modellen op maat maken om te profiteren van de energie-efficiënte hardware, waarbij we veel van de beschikbare open raamwerken hergebruiken.

Hoe ziet u de AI/ML-sector in de komende twaalf tot achttien maanden groeien of veranderen?

Nu de vraag naar GPU's is afgenomen (die zo'n 30 dollar kosten) en sommige delen van de wereld te maken krijgen met sancties om deze GPU's te kopen, hebben sommige delen van de wereld het gevoel dat ze vastzitten in AI-onderzoek en -ontwikkeling zonder toegang tot GPU's. Alternatieve hardwareplatforms gaan de markt veroveren.

Modellen zullen misschien beginnen te krimpen – op maat gemaakte modellen of zelfs fundamenteel zou de informatiedichtheid toenemen

Dezelfde vraag, maar hoe zit het met de groei en verandering in de komende 3-5 jaar?

a) CPU's met AI-uitbreidingen zouden de markt voor AI-inferentie veroveren

b) Modellen zouden wendbaarder worden en parameters zouden wegvallen naarmate de informatiedichtheid verbetert van 16% naar 90%

c) De energie-efficiëntie verbetert, de CO2-voetafdruk wordt kleiner

d) Er ontstaan nieuwe architecturen

e) De hardware- en energiekosten gaan omlaag, zodat de toetredingsdrempel voor kleinere bedrijven om modellen te creëren en te trainen betaalbaar wordt

f) mensen praten over het pre-AGI-moment, maar mijn maatstaf zou de gekarakteriseerde Samantha (conversationele AI) in de film 'haar' zijn. Dat is misschien onwaarschijnlijk gezien de hoge kosten van opschaling

Wat zijn enkele van de uitdagingen die de groei in de AI/ML-sector kunnen beïnvloeden of beperken?

a) Toegang tot hardware

b) Energiekosten en koelingskosten en milieuschade

Lees ook:

CEO-interview: David Moore van Pragmatic

- Door SEO aangedreven content en PR-distributie. Word vandaag nog versterkt.

- PlatoData.Network Verticale generatieve AI. Versterk jezelf. Toegang hier.

- PlatoAiStream. Web3-intelligentie. Kennis versterkt. Toegang hier.

- PlatoESG. carbon, CleanTech, Energie, Milieu, Zonne, Afvalbeheer. Toegang hier.

- Plato Gezondheid. Intelligentie op het gebied van biotech en klinische proeven. Toegang hier.

- Bron: https://semiwiki.com/ceo-interviews/338703-ceo-interview-suresh-sugumar-of-mastiska-ai/

- : heeft

- :is

- :niet

- :waar

- $UP

- 1

- 10

- 150

- 20

- 20 jaar

- 200

- 50

- 500

- 7

- a

- in staat

- Over

- boven

- abu dhabi

- versnelling

- versnellers

- toegang

- de toegankelijkheid

- actief

- adres

- aangesproken

- aanpakken

- Voordeel

- Zaken

- weer

- Agent

- agenten

- AGI

- geleden

- AI

- AI-modellen

- ai onderzoek

- AI-systemen

- ai-gebruiksgevallen

- AI / ML

- uitgelijnd

- Alles

- Het toestaan

- toestaat

- langs

- ook

- alternatief

- verbazingwekkend

- an

- en

- Nog een

- elke

- overal

- Aanvraag

- toepassingen

- architectuur

- ZIJN

- gebieden

- Komt aan

- kunstmatig

- kunstmatige intelligentie

- AS

- Asics

- vragen

- At

- automotive

- beschikbaarheid

- Beschikbaar

- weg

- b

- barrière

- gebaseerde

- BE

- worden

- wordt

- worden

- geweest

- wezen

- geloofd wie en wat je bent

- onder

- criterium

- voordeel

- betekent

- tussen

- Verder

- knelpunten

- gebonden

- Hersenen

- hersenen

- bouw

- Gebouw

- maar

- kopen

- by

- Californië

- CAN

- geannuleerd

- bekwaamheid

- in staat

- hoofdstad

- vangen

- carbon

- Koolstofopname

- gevallen

- Centra

- ceo

- Interview met de CEO

- certificaat

- uitdagen

- uitdagingen

- verandering

- veranderd

- veranderende

- karakter

- ChatGPT

- Kinderen

- spaander

- chips

- keuze

- Chopra

- klant

- Sluiten

- dichterbij

- Cloud

- TROS

- co2

- hoe

- Bedrijven

- afstand

- vergeleken

- concurreren

- concurrerend

- Berekenen

- computer

- computers

- computergebruik

- concepten

- conferenties

- consumeren

- consumptie

- voortzetten

- bijgedragen

- spraakzaam

- conversatie AI

- Coole

- Kosten

- Kosten

- kon

- en je merk te creëren

- Actueel

- Huidige toestand

- Op dit moment

- gewoonte

- klant

- Klanten

- snijdend

- Cybersecurity

- gegevens

- datacenters

- Datacenter

- David

- dag

- dagen

- beslissing

- deep

- diepgaand leren

- diepere

- Vraag

- democratiseren

- Democratiserend

- gedemonstreerd

- dichtheid

- Afhankelijk

- Design

- ontwikkelen

- ontwikkelde

- het ontwikkelen van

- Ontwikkeling

- systemen

- Dhabi

- onderscheiden

- ijver

- richting

- Director

- do

- doet

- doen

- dollar

- Dont

- beneden

- dr

- Val

- twee

- verdiend

- rand

- duurt

- doeltreffendheid

- doeltreffend

- efficiënt

- elektriciteit

- elektriciteitsverbruik

- elimineren

- elimineert

- emoties

- Empathie

- energie-niveau

- energie-efficiëntie

- Engineering

- verhogen

- genoeg

- Geheel

- toegang

- Milieu

- milieu

- voor ogen

- schatting

- geschat

- etc

- Ether (ETH)

- Zelfs

- uiteindelijk

- Alle

- voorbeeld

- uitvoerend

- Leidinggevend directeur

- bestaan

- expertise

- Ontploft

- extensies

- Gezicht

- naar

- valk

- sneller

- gevoel

- vullen

- bedrijven

- drijvend

- gericht

- Voet

- Voor

- voorzien

- formaat

- Fortuin

- Foundation

- frameworks

- oppompen van

- bevroren

- aangewakkerd

- functioneel

- fundamenteel

- toekomst

- Algemeen

- generaties

- generatief

- generatieve AI

- gegeven

- Go

- Goes

- gaan

- goed

- GPU's

- Groep

- Groeiend

- Hardware

- Hebben

- he

- Vandaar

- hier

- Hoge

- houdt

- Hosting

- Hoe

- HTTPS

- reusachtig

- KnuffelenGezicht

- menselijk

- Mensheid

- IEEE

- if

- beeld

- Impact

- verbeteren

- verbetert

- in

- Anders

- omvat

- Laat uw omzet

- -industrie

- informatie

- innoveren

- Innovatie

- innovaties

- verkrijgen in plaats daarvan

- Instituut

- Intel

- Intelligentie

- Internationale

- Internet

- Interview

- investering

- iot

- IT

- HAAR

- voor slechts

- kinderen

- Soort

- Gebrek

- Landschap

- taal

- laptops

- Groot

- groter

- leiden

- Leadership

- LEARN

- leren

- laten

- Hefboomwerking

- leveraging

- als

- schijnwerpers

- LIMIT

- laden

- gelegen

- Kijk

- ziet eruit als

- te verlagen

- Machines

- maken

- Fabrikant

- veel

- Markt

- Markten

- Matrix

- max-width

- Mei..

- kan zijn

- MBA

- me

- betekenis

- middel

- maatregel

- Memories

- vermeld

- macht

- miljoen

- miljoen dollar

- MIT

- model

- modellen

- moment

- monopolies

- maanden

- meer

- meest

- filmpje

- bewegend

- MS

- Dan moet je

- my

- naam

- namelijk

- Naturel

- Noodzaak

- netwerkgebaseerd

- netwerken

- Neural

- New

- nieuws

- volgende

- nis

- nacht

- lenig

- nu

- nucleair

- Kernenergie

- aantal

- oceanen

- of

- on

- EEN

- Slechts

- open

- open source

- OpenAI

- Operations

- Kansen

- optimalisatie

- Optimaliseer

- Opties

- or

- Overige

- onze

- uit

- het te bezitten.

- pagina

- Parallel

- parameter

- parameters

- onderdelen

- Octrooien

- Betaal

- Mensen

- misschien

- vliegtuig

- planten

- platform

- platforms

- Plato

- Plato gegevensintelligentie

- PlatoData

- overvloed

- plus

- pockets

- punt

- positie

- mogelijk

- energie

- energiecentrales

- PRAKTISCH

- privaat

- probleem

- problemen

- Product

- Producten

- Profiel

- Voortgang

- prompts

- beschermen

- doel

- doeleinden

- Duwen

- puts

- Qualcomm

- vraag

- Contact

- reeks

- gerangschikt

- Lees

- onlangs

- Aanbeveling

- aanbevelingen

- verminderen

- vermindering

- regelmatig

- Rapporten

- te vragen

- onderzoek

- onderzoek en ontwikkeling

- onderzoekers

- rechts

- Rivieroever

- rollen

- dak

- lopen

- lopend

- loopt

- veilig

- Veiligheid

- dezelfde

- sancties

- zandbak

- Bespaar

- besparing

- ervaren

- scaling

- Wetenschap

- Ontdek

- Seizoen

- sector

- beveiligen

- zien

- segmenten

- halfgeleider

- Halfgeleiders

- -Series

- servers

- service

- Diensten

- serveer-

- Delen

- tekorten

- moet

- vertoonde

- Shows

- kant

- aanzienlijke

- sinds

- kleinere

- smartphone

- smartphones

- So

- Software

- Oplossingen

- Het oplossen van

- sommige

- bron

- Tussenruimte

- gespecialiseerde

- besteed

- stanford

- begin

- Startups

- Land

- Strategie

- sterkste

- dergelijk

- leveren

- ondersteuning

- duurzaam

- Systems

- aanpakken

- aanpakken

- maatwerk

- Nemen

- Talk

- taken

- Technisch

- Technologie

- technologische innovatie

- termen

- tekst

- neem contact

- dat

- De

- De toekomst

- de informatie

- de wereld

- hun

- Ze

- harte

- Er.

- daarbij

- Deze

- ze

- spullen

- dit

- die

- toch?

- Thrive

- niet de tijd of

- naar

- vandaag

- tokens

- morgen

- ook

- top

- toss

- traditioneel

- Trainen

- Trainingen

- transformator

- transformers

- Trends

- vertrouwde

- proberen

- proberen

- voor

- begrijpt

- universiteit-

- University of California

- onwaarschijnlijk

- us

- Gebruik

- .

- gebruikt

- gebruik

- divers

- onderneming

- venture capital

- risicokapitaalbedrijven

- zeer

- van

- was

- Water

- Manier..

- we

- web

- Welzijn

- waren

- Wat

- wanneer

- welke

- WIE

- Waarom

- wil

- Met

- zonder

- Mijn werk

- werkzaam

- wereld

- zou

- Verkeerd

- jaar

- u

- Your

- zephyrnet