De snelheid van de geheugendoorvoer en de lage latentie zijn van cruciaal belang nu de inferentie verschuift van het datacenter naar de netwerkrand.

AI/ML evolueert razendsnel. Er gaat momenteel geen week voorbij zonder nieuwe en opwindende ontwikkelingen op dit gebied, en toepassingen als ChatGPT hebben generatieve AI-mogelijkheden stevig op de voorgrond van de publieke aandacht gebracht.

AI/ML bestaat eigenlijk uit twee toepassingen: training en gevolgtrekking. Elk is afhankelijk van de geheugenprestaties en elk heeft een unieke reeks vereisten die de keuze voor de beste geheugenoplossing bepalen.

Bij training zijn geheugenbandbreedte en -capaciteit kritische vereisten. Dit is vooral het geval gezien de omvang en complexiteit van neurale netwerkdatamodellen die met een snelheid van 10x per jaar zijn gegroeid. De nauwkeurigheid van het neurale netwerk hangt af van de kwaliteit en kwantiteit van de voorbeelden in de trainingsdataset, wat zich vertaalt in de behoefte aan enorme hoeveelheden gegevens, en dus aan geheugenbandbreedte en -capaciteit.

Gezien de waarde die door training wordt gecreëerd, is er een krachtige stimulans om trainingsruns zo snel mogelijk te voltooien. Omdat trainingsapplicaties draaien in datacenters die steeds minder stroom en ruimte hebben, wordt de voorkeur gegeven aan oplossingen die energie-efficiëntie en kleinere afmetingen bieden. Gezien al deze vereisten is HBM3 een ideale geheugenoplossing voor AI-trainingshardware. Het biedt uitstekende bandbreedte- en capaciteitsmogelijkheden.

De output van neurale netwerktraining is een gevolgtrekkingsmodel dat breed kan worden ingezet. Met dit model kan een inferentieapparaat input verwerken en interpreteren buiten de grenzen van de trainingsgegevens. Voor gevolgtrekking zijn de geheugendoorvoersnelheid en lage latentie van cruciaal belang, vooral wanneer realtime actie nodig is. Nu steeds meer AI-gevolgen verschuiven van het hart van het datacenter naar de netwerkrand, worden deze geheugenfuncties nog belangrijker.

Ontwerpers hebben een aantal geheugenkeuzes voor AI/ML-inferentie, maar op de kritische parameter bandbreedte blinkt GDDR6-geheugen echt uit. Met een gegevenssnelheid van 24 gigabit per seconde (Gb/s) en een 32-bit brede interface kan een GDDR6-apparaat 96 gigabyte per seconde (GB/s) aan geheugenbandbreedte leveren, meer dan het dubbele van die van enig alternatief DDR- of LPDDR-oplossingen. GDDR6-geheugen biedt een geweldige combinatie van snelheid, bandbreedte en latentieprestaties voor AI/ML-inferentie, met name voor inferentie aan de rand.

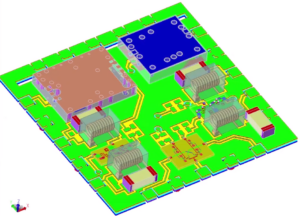

Het Rambus GDDR6-geheugeninterfacesubsysteem biedt prestaties van 24 Gb/s en is gebouwd op een fundament van meer dan 30 jaar expertise op het gebied van signaalintegriteit en stroomintegriteit (SI/PI), cruciaal voor het werken met GDDR6 op hoge snelheden. Het bestaat uit een PHY en een digitale controller – die een compleet GDDR6-geheugeninterfacesubsysteem biedt.

Bezoek mij deze maand op het Rambus-webinar op “Hoogwaardige AI/ML-inferentie met 24G GDDR6-geheugen'om te ontdekken hoe GDDR6 de geheugen- en prestatievereisten van AI/ML-inferentieworkloads ondersteunt en meer te leren over enkele van de belangrijkste ontwerp- en implementatieoverwegingen van GDDR6-geheugeninterfacesubsystemen.

Bronnen:

Frank Ferro

(alle berichten)

Frank Ferro is senior director productmarketing voor IP-cores bij Rambus.

- Door SEO aangedreven content en PR-distributie. Word vandaag nog versterkt.

- PlatoAiStream. Web3 gegevensintelligentie. Kennis versterkt. Toegang hier.

- De toekomst slaan met Adryenn Ashley. Toegang hier.

- Koop en verkoop aandelen in PRE-IPO-bedrijven met PREIPO®. Toegang hier.

- Bron: https://semiengineering.com/gddr6-delivers-the-performance-for-ai-ml-inference/

- : heeft

- :is

- :niet

- 24

- 26

- 27

- 30

- 8

- a

- Over

- nauwkeurigheid

- Actie

- AI

- AI-training

- AI / ML

- Alles

- Alle berichten

- alternatief

- hoeveelheden

- an

- en

- elke

- toepassingen

- ZIJN

- AS

- At

- aandacht

- bandbreedte

- BE

- worden

- geweest

- BEST

- breed

- bracht

- bebouwd

- maar

- by

- CAN

- mogelijkheden

- Inhoud

- Centreren

- Centra

- ChatGPT

- keuze

- keuzes

- combinatie van

- compleet

- ingewikkeldheid

- overwegingen

- controleur

- aangemaakt

- kritisch

- gegevens

- Data Center

- datacenters

- gegevensset

- leveren

- levert

- afhankelijk

- ingezet

- Design

- ontwikkelingen

- apparaat

- digitaal

- Director

- Onthul Nu

- verdubbelen

- rit

- elk

- rand

- doeltreffendheid

- enorm

- vooral

- Zelfs

- evoluerende

- voorbeelden

- uitstekend

- opwindend

- expertise

- Voordelen

- veld-

- stevig

- Voor

- Voorhoede

- Foundation

- oppompen van

- generatief

- generatieve AI

- gegeven

- Goes

- groot

- Groeiend

- Hardware

- Hebben

- Hart

- Vandaar

- Hoge

- Hoe

- HTTPS

- ideaal

- uitvoering

- in

- aansporing

- in toenemende mate

- ingangen

- integriteit

- Interface

- in

- IP

- IT

- jpg

- sleutel

- Wachttijd

- LEARN

- bliksem

- als

- Laag

- Marketing

- Geheugen

- model

- modellen

- Maand

- meer

- nodig

- nodig

- netwerk

- Netwerk gegevens

- Neural

- neuraal netwerk

- New

- nu

- aantal

- of

- bieden

- Aanbod

- on

- werkzaam

- or

- uitgang

- buiten

- over

- Tempo

- parameter

- bijzonder

- vooral

- prestatie

- Plato

- Plato gegevensintelligentie

- PlatoData

- populariteit

- mogelijk

- Berichten

- energie

- krachtige

- Product

- biedt

- het verstrekken van

- publiek

- kwaliteit

- hoeveelheid

- snel

- tarief

- real-time

- werkelijk

- Voorwaarden

- rechts

- RIJ

- lopen

- Tweede

- senior

- reeks

- VERSCHUIVEN

- Ploegen

- Signaal

- Maat

- kleinere

- So

- oplossing

- Oplossingen

- sommige

- Tussenruimte

- snelheid

- snelheden

- steunen

- neem contact

- dat

- De

- Er.

- Deze

- dit

- Door

- doorvoer

- thumbnail

- naar

- Trainingen

- twee

- unieke

- waarde

- webinar

- week

- wanneer

- welke

- breed

- Met

- zonder

- jaar

- jaar

- zephyrnet