人工知能 (AI) はさまざまな業界に革命をもたらし、数多くのメリットと機会をもたらしています。しかし、AIが差別や偏見を永続させる可能性に関する懸念が浮上している。この記事では、AI 差別のトピックを検討し、AI システムに埋め込まれたバイアスを特定して対処するという課題に光を当てます。業界関係者は、誤った情報、アルゴリズムの偏り、誤解を招くコンテンツの生成に対する懸念を挙げ、AIの道徳的および倫理的な影響について疑問を表明している。 AI を巡る議論が激化するにつれ、透明性、説明責任、基本的権利の保護を確保するための有意義な規制を求める声が高まっています。

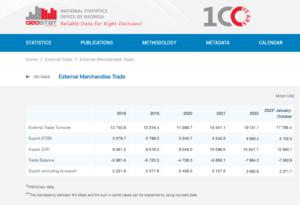

AI による金融業界の課題

Worldpay by FIS の暗号通貨と Web3 の責任者である Nabil Manji 氏によると、AI 製品の有効性はトレーニングに使用されるソース素材の品質に大きく依存します。 CNBC とのインタビューで、Manji 氏は、AI のパフォーマンスに寄与する XNUMX つの主な要素、つまり AI がアクセスできるデータと大規模な言語モデルの機能であると説明しました。

データの重要性を説明するために、Manji 氏は、Reddit のような企業がデータ スクレイピングに対する制限を公に宣言し、アクセスに対して支払いを要求していることに言及しました。金融サービス分野では、さまざまな言語や形式で断片化されたデータ システムの課題を強調しました。この統合と調和の欠如により、特に標準化および最新化されたデータ インフラストラクチャを備えた業界と比較した場合、AI 主導型製品の有効性が制限されます。

マンジ氏によると、ブロックチェーンまたは分散型台帳技術の利用は、この問題に対処する潜在的な解決策を提供する可能性があります。この革新的なアプローチにより、従来の銀行の複雑なシステム内に保存されている断片化されたデータの透明性が向上します。しかし同氏は、ここ数年間イノベーション推進の最前線に立ってきたマイクロソフトやグーグルのような機敏なテクノロジー企業とは異なり、銀行の規制が厳しく動きの遅い性質が新しいAIツールを迅速に導入する能力を妨げる可能性があることを認めた。数十年。

これらの要因を考慮すると、データ統合の複雑さと銀行セクターの固有の性質により、金融業界が AI の活用において特有の課題に直面していることが明らかになります。

Twitter社で機械学習の倫理、透明性、説明責任の元責任者を務めたラマン・チョードリー氏によると、AIシステムの偏見が社会から疎外されたコミュニティに悪影響を及ぼす可能性があることを示す顕著な例は融資だという。アムステルダムでのパネルディスカッションで講演したチョードリー氏は、1930年代のシカゴにおける「レッドライニング」の歴史的な慣行を強調した。レッドライニングには、人種人口統計に基づいてアフリカ系アメリカ人が大多数を占める地域への融資を拒否することが含まれていました。

チョードリー氏は、最新のアルゴリズムでは人種がデータポイントとして明示的に含まれていない可能性があるものの、バイアスは依然として暗黙的にエンコードされる可能性があると説明しました。融資目的で地区や個人のリスクを評価するアルゴリズムを開発する際、バイアスを含む過去のデータが誤って差別を永続させる可能性があります。

人工知能における黒人女性の背後にある先見の明のあるアングル・ブッシュ氏は、ローン承認の決定に AI システムを採用する場合、過去のデータに埋め込まれたバイアスの再現に伴う危険性を認識することの重要性を強調しました。このような慣行は、社会から疎外されたコミュニティからの融資申請を自動的に拒否することにつながり、人種的または男女間の不平等を永続させる可能性があります。

経験豊富な AI 開発者である Frost Li 氏は、パーソナライゼーションの課題を次のように指摘しました。 AI統合。 AI モデルをトレーニングするための「コア機能」の選択には、無関係な要素が含まれる場合があり、偏った結果につながる可能性があります。リー氏は、外国人を対象としたフィンテックスタートアップ企業が、地元の学校や地域社会に精通している地元銀行と比較して、異なる信用評価基準に直面する可能性がある例を示した。

フィンテック向けの意思決定の自動化を専門とする新興企業である Taktile の COO である Niklas Guske 氏は、生成 AI は通常、消費者の信用スコアやリスク スコアリングの作成には使用されないと明言しました。逆に、その強みは、テキスト ファイルなどの非構造化データを前処理して、従来の引受モデルのデータ品質を向上させることにあります。

要約すると、融資や金融サービスにおける AI の使用は、偏見や差別に対する懸念を引き起こします。データに埋め込まれた歴史的なバイアスや、AI トレーニング中に無関係な特徴が選択されると、不公平な結果が生じる可能性があります。銀行や金融機関が AI ソリューションを導入する際に不用意な差別の永続を防ぐためには、これらの問題を認識して対処することが重要です。

AIによる差別の証明

Apple や Goldman Sachs の事件などの例で浮き彫りになっているように、AI に基づく差別を証明するのは困難な場合があります。ニューヨーク州金融サービス局は、女性向けのApple Cardに低い限度額を課しているという疑惑を、実証的証拠の欠如を理由に却下した。

欧州人種差別反対ネットワークのディレクターであるキム・スマウター氏は、AIの大量導入が意思決定プロセスの不透明さをもたらし、個人が差別を特定して対処することが困難になっていると指摘する。

スマーター氏は、個人が AI システムがどのように動作するかについての知識が限られていることが多く、差別や体系的な偏見の事例を検出することが困難であると説明しています。差別が複数の個人に影響を与える広範な問題の一部である場合、事態はさらに複雑になります。スモア氏はオランダの児童福祉スキャンダルに言及している。このスキャンダルでは、多数の給付金請求が制度上の偏見により不正であると誤って分類されていた。このような機能不全の発見は困難であり、救済を得るのは困難で時間がかかり、重大な、場合によっては取り返しのつかない損害につながる可能性があります。

これらの例は、AI に基づく差別を実証し、そのような差別が発生した場合に救済策を得ることが本質的に難しいことを示しています。 AI システムの複雑さと意思決定プロセスの透明性の欠如により、個人が差別の事例を効果的に認識して対処することが困難になる可能性があります。

チョードリー氏によると、AI に関連するリスクに対処するには、国連のような世界的な規制機関が急務であるとのことです。 AI は目覚ましい革新を示していますが、その道徳的および倫理的な影響について技術者や倫理学者から懸念が提起されています。これらの懸念には、誤った情報、AI アルゴリズムに組み込まれた人種および性別の偏見、ChatGPT などのツールによる誤解を招くコンテンツの生成などの問題が含まれます。

チョードリー氏は、生成型 AI により、テキスト、ビデオ、音声を含むオンライン情報が信頼できなくなるポスト真実の世界に突入することへの懸念を表明しています。このため、情報の完全性をどのように確保できるか、情報に基づいた意思決定を行うために情報をどのように信頼できるかという疑問が生じます。欧州連合の AI 法を例に挙げると、現時点では AI に対する有意義な規制が極めて重要です。しかし、規制提案が有効になるまでに長い時間がかかり、必要な措置が遅れる可能性があるという懸念があります。

スムーター氏は、AI アルゴリズムの透明性と説明責任を高める必要性を強調します。これには、アルゴリズムを専門家以外にも理解しやすくすること、テストの実施と結果の公表、独立した苦情プロセスの確立、定期的な監査と報告の実施、テクノロジーの設計と展開への人種化されたコミュニティの関与が含まれます。基本的権利の観点を取り入れ、救済などの概念を導入する AI 法の施行は、約 2 年以内に開始される予定です。このスケジュールを短縮することは、イノベーションの不可欠な側面としての透明性と説明責任を維持するのに有利です。

- SEO を活用したコンテンツと PR 配信。 今日増幅されます。

- PlatoData.Network 垂直生成 Ai。 自分自身に力を与えましょう。 こちらからアクセスしてください。

- プラトアイストリーム。 Web3 インテリジェンス。 知識増幅。 こちらからアクセスしてください。

- プラトンESG。 自動車/EV、 カーボン、 クリーンテック、 エネルギー、 環境、 太陽、 廃棄物管理。 こちらからアクセスしてください。

- ブロックオフセット。 環境オフセット所有権の近代化。 こちらからアクセスしてください。

- 情報源: https://www.forexnewsnow.com/fintech/the-urgency-of-addressing-ai-discrimination-transparency-accountability-and-regulatory-timelines/

- :持っている

- :は

- :not

- :どこ

- a

- 能力

- 私たちについて

- アクセス

- 説明責任

- 認め

- 行為

- 行動

- 住所

- アドレッシング

- 採用

- 有利

- 逆に

- 影響を及ぼす

- アフリカの

- に対して

- 使い勝手のいい

- AI

- AI法

- AIシステム

- AIトレーニング

- アルゴリズム

- 主張

- しかし

- アメリカ

- アムステルダム

- an

- および

- 予期された

- Apple

- アップルカード

- アプローチ

- 承認

- 約

- です

- 記事

- 人工の

- 人工知能

- AS

- 側面

- 評価する

- 評価

- 関連する

- At

- オーディオ

- 監査

- オートマチック

- 自動化する

- バンキング

- 銀行部門

- 銀行

- ベース

- BE

- になる

- になる

- き

- 背後に

- 恩恵

- 利点

- バイアス

- 偏った

- バイアス

- ブラック

- ブロックチェーン

- ボディ

- もたらす

- より広い

- by

- コール

- 缶

- 機能

- カード

- 場合

- 挑戦する

- 課題

- 挑戦

- AI言語モデルを活用してコードのデバッグからデータの異常検出まで、

- シカゴ

- 子

- クレーム

- 明確化

- CNBC

- コミュニティ

- 企業

- 比べ

- 苦情

- 複雑な

- 複雑さ

- 複雑さ

- コンセプト

- 懸念事項

- 導電性

- 圧密

- 消費者

- 含まれています

- コンテンツ

- 逆に

- 貢献する

- 従来の

- coo

- 作成

- クレジット

- 基準

- 重大な

- クリプト

- 危険

- データ

- データインフラストラクチャ

- データ統合

- データ品質

- 討論会

- 数十年

- 意思決定

- 決定

- 人口動態

- 部門

- 依存

- 展開

- 設計

- Developer

- 開発

- 異なります

- 難しい

- 困難

- 取締役

- 発見

- 差別

- 議論

- 配布

- 分散元帳

- 分散型元帳技術

- 運転

- 原因

- 間に

- オランダ語

- 効果的な

- 効果的に

- 有効

- 埋め込まれた

- 登場

- 強調

- 含む

- 執行

- 高めます

- 強化された

- 確保

- 入る

- 特に

- 確立

- 倫理的な

- 倫理

- 欧州言語

- さらに

- 証拠

- 明らか

- 例

- 例

- 経験豊かな

- 説明

- 説明

- 探検する

- 表現します

- 顔

- 顔

- 要因

- おなじみの

- 特徴

- 少数の

- ファイナンシャル

- 金融産業

- 金融機関

- 金融業務

- フィンテック

- fintechスタートアップ

- フィンテック

- FIS

- 最前線

- 前者

- 断片化して

- 不正な

- から

- 基本的な

- 性別

- 世代

- 生々しい

- 生成AI

- グローバル

- ゴールドマン

- ゴールドマン·サックス

- でログイン

- 大きい

- 成長

- 害

- 持ってる

- he

- 重く

- 強調表示された

- 非常に

- 歴史的

- 認定条件

- しかしながら

- HTTPS

- 識別する

- 識別

- 実装

- 意義

- 重要性

- 堂々たる

- in

- include

- 含ま

- 含めて

- 独立しました

- 個人

- 産業

- 産業を変えます

- 不平等

- 情報

- 情報に基づく

- インフラ関連事業

- 固有の

- 革新的手法

- 革新的な

- 制度の

- 機関

- インテグラル

- 統合

- 整合性

- インテリジェンス

- インタビュー

- に

- 紹介します

- 巻き込む

- 関係する

- 関与

- 問題

- 問題

- IT

- ITS

- 知識

- 欠如

- 言語

- ESL, ビジネスESL <br> 中国語/フランス語、その他

- 大

- つながる

- 主要な

- 学習

- 元帳

- 貸し出し

- 活用

- li

- ある

- 光

- ような

- 限定的

- 制限

- ローン

- ローン

- ローカル

- 地方銀行

- 下側

- 機械

- 機械学習

- メイン

- make

- 作成

- 質量

- 材料

- 五月..

- 意味のある

- 言及した

- Microsoft

- かもしれない

- 誤報

- 誤解を招く

- モデル

- モダン

- 瞬間

- 道徳

- 他には?

- の試合に

- 国連

- 自然

- 必要

- 必要

- ネットワーク

- 新作

- ニューヨーク

- ニューヨーク州

- ニューヨーク州金融局

- 非専門家

- 注目すべき

- 数

- 多数の

- 多くの利点

- 入手

- of

- 提供

- 提供すること

- 頻繁に

- on

- オンライン

- 操作する

- 機会

- or

- でる

- 成果

- パネル

- パネルディスカッション

- 部

- 過去

- 支払い

- パフォーマンス

- periodic

- 個人化

- 視点

- プラトン

- プラトンデータインテリジェンス

- プラトデータ

- ポイント

- ポイント

- 潜在的な

- :

- 練習

- 主に

- を押す

- 防ぐ

- 問題

- ラボレーション

- 製品

- 提案

- 保護

- 提供します

- 提供

- 公然と

- 出版

- 目的

- 品質

- 質問

- レース

- 人種差別

- 隆起した

- 提起

- 認識する

- 縮小

- リファレンス

- に対する

- 規制

- 規制

- レギュレータ

- 頼る

- 顕著

- 各種レポート作成

- 制限

- 結果

- 革命を起こした

- 権利

- リスク

- リスク

- サックス

- スキャンダル

- 学校

- スコア

- 得点

- こすること

- セクター

- 選択

- 選択

- サービス

- 示す

- 意義

- 重要

- 同様の

- 溶液

- ソリューション

- ソース

- 話す

- 特化

- スタートアップ

- スタートアップ

- 都道府県

- 国務省

- まだ

- 保存され

- 力

- そのような

- 概要

- 周囲の

- 素早く

- 全身の

- システム

- タックル

- 取り

- ターゲット

- テク

- ハイテク企業

- 技術者

- テクノロジー

- テスト

- それ

- ソース

- アプリ環境に合わせて

- そこ。

- それによって

- ボーマン

- この

- 時間がかかる

- タイムライン

- タイムライン

- 〜へ

- 豊富なツール群

- トピック

- トレーニング

- 透明性

- さえずり

- 2

- 一般的に

- 理解できる

- 引受

- 不公平

- ユニーク

- ユナイテッド

- 国連

- 異なり、

- 支持する

- 緊急

- つかいます

- 中古

- さまざまな

- ビデオ

- 幻の

- we

- Web3

- 福祉

- した

- いつ

- which

- while

- 以内

- レディース

- 世界

- WorldPayの

- 不安

- でしょう

- 年

- ヨーク

- ゼファーネット