Midjourney で生成

世界中のあらゆる業界の企業が、OpenAI の ChatGPT、Anthropic の Claude、AI12Lab の Jurassic などの大規模言語モデル (LLM) の力を統合して、市場調査、顧客サービスなどの幅広いビジネス アプリケーションのパフォーマンスを向上させることを急いでいます。 、コンテンツの生成。

ただし、エンタープライズ規模で LLM アプリケーションを構築するには、従来の機械学習 (ML) アプリケーションの構築とは異なるツールセットと理解が必要です。 ブランドの声と信頼できるサービス品質を維持したいと考えているビジネス リーダーや経営幹部は、LLM がどのように機能するか、および LLM アプリケーション スタック内のさまざまなツールの長所と短所について理解を深める必要があります。

この記事では、ビジネス用の LLM アプリケーションを構築して実行するために必要な高レベルの戦略とツールについて重要な概要を説明します。

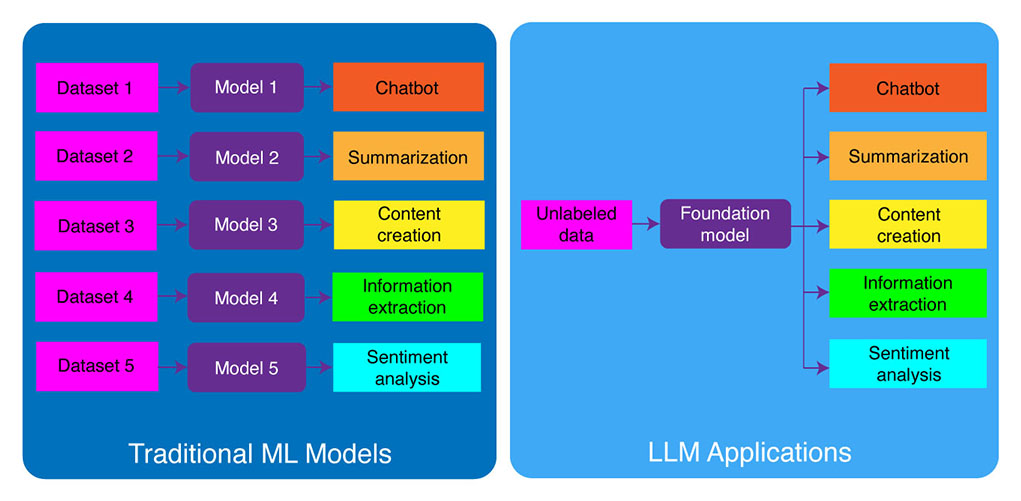

従来の ML 開発と LLM アプリケーションの比較

従来の機械学習モデルはタスク固有であり、異なるタスクごとに個別のモデルを構築する必要がありました。 たとえば、顧客感情を分析したい場合は XNUMX つのモデルを構築する必要があり、カスタマー サポート チャットボットを構築したい場合は別のモデルを構築する必要があります。

タスク固有の ML モデルを構築およびトレーニングするこのプロセスには時間がかかり、大量のデータが必要です。 これらのさまざまな ML モデルをトレーニングするために必要なデータセットの種類も、タスクによって異なります。 顧客の感情を分析するモデルをトレーニングするには、対応する感情 (肯定的、否定的、中立的) でラベル付けされた顧客レビューのデータセットが必要です。 モデルをトレーニングしてカスタマー サポート チャットボットを構築するには、顧客とテクニカル サポートの間の会話のデータセットが必要です。

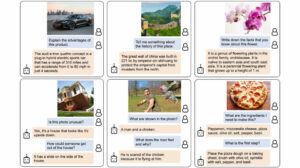

大規模な言語モデルがこれを変えました。 LLM はテキストとコードの大規模なデータセットで事前トレーニングされているため、すぐに使用できる次のような幅広いタスクで適切に実行できます。

- テキスト要約

- コンテンツの作成

- インタビュー

- 情報抽出

- 質問に答える

- 感情分析

- 顧客サポート

- セールスサポート

LLM アプリケーションの開発プロセスは、次の XNUMX つの重要なステップに分類できます。

- 適切な基礎モデルを選択してください。 これは、LLM アプリケーションのパフォーマンスを定義する重要なコンポーネントです。

- 必要に応じてモデルをカスタマイズします。 特定のニーズを満たすために、モデルを微調整したり、追加のナレッジ ベースでモデルを強化したりする必要がある場合があります。

- ML インフラストラクチャをセットアップします。 これには、アプリケーションの実行に必要なハードウェアとソフトウェア (つまり、半導体、チップ、クラウド ホスティング、推論、展開) が含まれます。

- 追加のツールを使用してアプリケーションを拡張します。 これらのツールは、アプリケーションの効率、パフォーマンス、セキュリティの向上に役立ちます。

次に、対応するテクノロジー スタックを見てみましょう。

この詳細な教育コンテンツがあなたに役立つ場合は、 AIメーリングリストに登録する 新しい素材がリリースされたときに警告が表示されます。

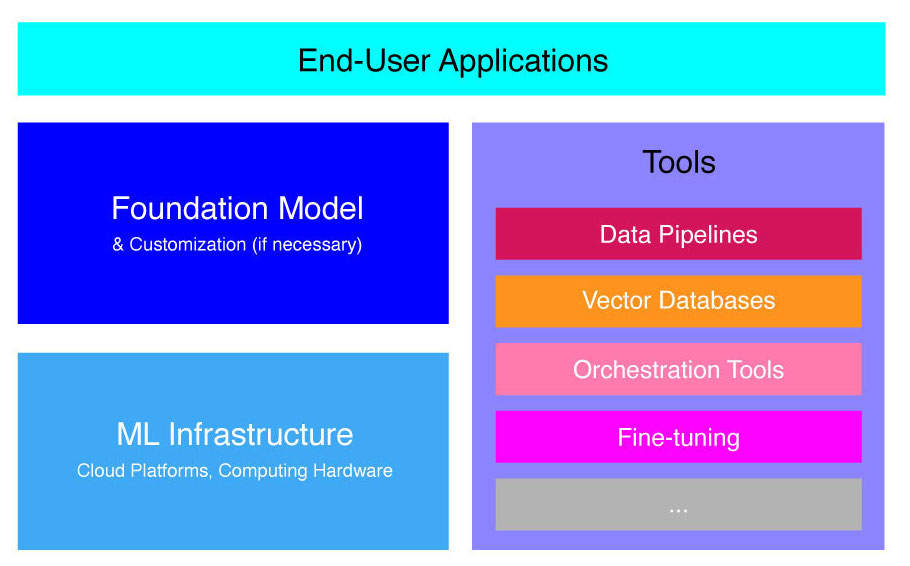

高レベルの LLM アプリケーション スタック

LLM アプリケーションは、次のようないくつかの主要コンポーネント上に構築されています。

- 基礎モデル、特定の使用例ではカスタマイズが必要になる場合があります。

- MLインフラストラクチャ クラウド プラットフォームまたは自社のハードウェアを介して十分なコンピューティング リソースを確保します。

- 追加ツール、データ パイプライン、ベクトル データベース、オーケストレーション ツール、微調整 ML プラットフォーム、モデル パフォーマンス監視ツールなど。

LLM アプリケーションの構築とデプロイに必要なツールキットをよりよく理解できるように、これらのコンポーネントについて簡単に説明します。

基礎モデルとは何ですか?

単一の事前トレーニングされた LLM を使用すると、時間とリソースを大幅に節約できます。 ただし、そのようなモデルをゼロからトレーニングすることは、タイムリーでコストのかかるプロセスであり、一部のエリートのテクノロジー リーダーを除いて、ほとんどの企業の能力を超えています。

いくつかの企業や研究チームがこれらのモデルをトレーニングし、他の企業が使用できるようにしています。 主な例には、ChatGPT、Claude、Llama、Jurassic、T5 などがあります。 これらの公開モデルは基礎モデルと呼ばれます。 それらの一部は独自のものであり、API 呼び出しを介して有料でアクセスできます。 その他はオープンソースであり、無料で使用できます。 これらのモデルは、ラベルのないテキスト データの大規模なデータセットで事前トレーニングされており、クリエイティブな広告コピーの生成から、会社を代表して顧客の母国語でのコミュニケーションまで、幅広いタスクを実行できます。

基盤モデルには、プロプライエタリとオープンソースの XNUMX つの主なタイプがあります。

独自モデル これらは単一の会社または組織によって所有されており、通常は有料でのみ利用できます。 独自モデルの最も一般的な例には、OpenAI の GPT モデル、Anthropic の Claude モデル、AI21 Labs の Jurassic モデルなどがあります。

オープンソースモデル 通常、使いたい人は誰でも無料で利用できます。 ただし、一部のオープンソース モデルには、(1) 研究目的でのみ利用できる、(2) 一定規模の企業による商用利用のみが利用できるなど、使用に制限があります。 オープンソース コミュニティは、そのような制限を設けることでモデルを「オープンソース」として認定することはできないと主張しています。 それでも、無料で使用できる言語モデルの最も有名な例には、Meta の Llama モデル、アブダビの Technology Innovation Institute の Falcon モデル、Stability AI の StableLM モデルなどがあります。 オープンソース モデルとそれに関連するリスクについて詳しく読む こちら.

次に、LLM アプリケーションの基礎モデルを選択する際に考慮すべきいくつかの要素について説明します。

基礎モデルの選択

LLM アプリケーションに最適な基盤モデルを選択するのは難しいプロセスになる可能性がありますが、基本的には次の XNUMX つのステップに分けることができます。

- 独自モデルとオープンソース モデルのどちらかを選択してください。 プロプライエタリ モデルは通常、オープンソース モデルよりも大きく、機能も優れていますが、使用コストが高くつき、柔軟性に欠ける可能性があります。 さらに、コードはそれほど透過的ではないため、独自モデルのパフォーマンスに関する問題のデバッグやトラブルシューティングが困難になります。 一方、オープンソース モデルは通常、更新が少なく、開発者からのサポートも少なくなります。

- モデルのサイズを選択してください。 通常、モデルが大きいほど、質問への回答やクリエイティブなテキストの生成など、多くの知識を必要とするタスクの実行に優れています。 ただし、モデルが大きくなると、使用するための計算コストも高くなります。 まず大きなモデルで実験し、モデルのパフォーマンスがユースケースにとって満足できる限り、小さなモデルに進むことができます。

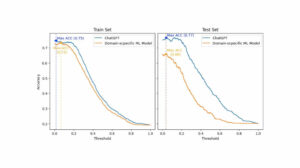

- 特定のモデルを選択します。 まずは一般的なベンチマークを確認して、テスト対象のモデルを最終リストに挙げることができます。 次に、アプリケーション固有の割り当てに対してさまざまなモデルのテストに進みます。 カスタム ベンチマークの場合は、次の計算を検討してください。 ブルーとルージュのスコア、人間参加型アプリケーションの出力をリリースする前に、AI が生成したテキストに必要な修正の数を定量化するのに役立つ指標。

さまざまな言語モデルの違いをより深く理解するには、以下を確認してください。 最も強力な言語 (LLM) とビジュアル言語モデル (VLM) の概要.

アプリケーションの基礎モデルを選択したら、パフォーマンスをさらに向上させるためにモデルをカスタマイズする必要があるかどうかを検討できます。

基礎モデルのカスタマイズ

場合によっては、特定の使用例でのパフォーマンスを向上させるために、基礎言語モデルをカスタマイズすることが必要になる場合があります。 たとえば、次のような特定の項目について最適化したい場合があります。

- ドメイン。 法律、金融、ヘルスケアなどの特定のドメインで業務を行っている場合は、エンドユーザーのクエリをよりよく理解して応答できるように、このドメインでのモデルの語彙を強化することができます。

- 仕事。 たとえば、モデルにマーケティング キャンペーンを生成させたい場合は、ブランド化されたマーケティング コンテンツの具体的な例をモデルに提供できます。 これは、モデルが会社や対象者に適したパターンとスタイルを学習するのに役立ちます。

- 声のトーン。 特定の声調を使用するモデルが必要な場合は、対象の言語サンプルの例を含むデータセットでモデルをカスタマイズできます。

基本言語モデルをカスタマイズするには XNUMX つの方法があります。

- 微調整: 約 100 ~ 500 レコードのドメイン固有のラベル付きデータセットをモデルに提供します。 モデルの重みが更新されると、このデータセットで表されるタスクのパフォーマンスが向上します。

- ドメイン適応: 対応するドメインからの大規模なデータ コーパスを含むドメイン固有のラベルなしデータセットをモデルに提供します。 この場合、モデルの重みも更新されます。

- 情報検索: 基礎モデルをクローズドドメインの知識で強化します。 モデルは再トレーニングされず、モデルの重みは変わりません。 ただし、モデルは、関連データを含むベクトル データベースから情報を取得することができます。

最初の XNUMX つのアプローチでは、モデルを再トレーニングするために大量のコンピューティング リソースが必要ですが、これは通常、カスタマイズを管理する適切な技術的才能を持つ大企業でのみ実現可能です。 小規模な企業は通常、ベクトル データベースを通じてモデルにドメイン知識を追加するという、より一般的なアプローチを使用します。これについては、この記事の後半の LLM ツールに関するセクションで詳しく説明します。

ML インフラストラクチャをセットアップする

LLMOps ランドスケープの ML インフラストラクチャ コンポーネントには、クラウド プラットフォーム、コンピューティング ハードウェア、LLM のデプロイと実行に必要なその他のリソースが含まれます。 このコンポーネントは、オープンソース モデルの使用を選択した場合、またはアプリケーションに合わせてモデルをカスタマイズした場合に特に関連します。 この場合、必要に応じてモデルを微調整し、実行するために大量のコンピューティング リソースが必要になる場合があります。

Google Cloud Platform、Amazon Web Services、Microsoft Azure など、LLM を展開するためのサービスを提供するクラウド プラットフォームが多数あります。 これらのプラットフォームは、LLM の展開と実行を容易にする次のような多くの機能を提供します。

- 特定のアプリケーションに合わせて微調整できる事前トレーニング済みモデル

- 基盤となるハードウェアとソフトウェアを管理する管理されたインフラストラクチャ

- LLM の監視とデバッグのためのツールとサービス

必要なコンピューティング リソースの量は、モデルのサイズと複雑さ、モデルで実行するタスク、およびこのモデルを展開するビジネス活動の規模によって異なります。

ツールによる拡張

追加の LLM 隣接ツールを使用すると、LLM アプリケーションのパフォーマンスをさらに向上させることができます。

データパイプライン

LLM 製品でデータを使用する必要がある場合、従来のエンタープライズ AI スタックと同様に、データ前処理パイプラインが新しい技術スタックの重要な柱になります。 これらのツールには、任意のソースからデータを取り込むためのコネクタ、データ変換レイヤー、ダウンストリーム コネクタが含まれています。 Databricks や Snowflake などの主要なデータ パイプライン プロバイダーと Unstructurald などの新しいプレーヤーにより、開発者は大規模で非常に異質な自然言語データのコーパス (例: 数千の PDF、PowerPoint プレゼンテーション、チャット ログ、スクレイピングされた HTML、など) を単一のアクセスポイントに、または LLM アプリケーションでさらに使用できる単一のドキュメントに保存します。

ベクトルデータベース

大規模な言語モデルは一度に数千単語の処理に制限されているため、単独では大規模なドキュメントを効果的に処理できません。 大規模なドキュメントの能力を活用するには、企業はベクトル データベースを使用する必要があります。

ベクター データベースは、データ パイプラインを通じて受信した大規模なドキュメントを管理可能なベクター (埋め込み) に変換するストレージ システムです。 LLM アプリケーションは、これらのデータベースにクエリを実行して正しいベクトルを特定し、必要な情報のみを抽出できます。

現在利用可能な最も著名なベクター データベースには、Pinecone、Chroma、Weaviate などがあります。

オーケストレーションツール

ユーザーがカスタマー サービスへの質問などのクエリを LLM アプリケーションに送信する場合、アプリケーションはこのクエリを言語モデルに送信する前に一連のプロンプトを作成する必要があります。 言語モデルへの最終リクエストは通常、開発者によってハードコーディングされたプロンプト テンプレート、少数ショット サンプルと呼ばれる有効な出力の例、外部 API から取得された必要な情報、およびベクター データベースから取得された関連ドキュメントのセットで構成されます。 。 LangChain や LlamaIndex などの企業が提供するオーケストレーション ツールは、プロンプトを管理および実行するためのすぐに使用できるフレームワークを提供することで、このプロセスを合理化するのに役立ちます。

微調整

大規模なデータセットでトレーニングされた大規模な言語モデルは、文法的に正しく、流暢なテキストを生成できます。 ただし、医学や法律などの特定の分野では正確性に欠ける場合があります。 ドメイン固有のデータセットでこれらのモデルを微調整することで、それらの領域の固有の特徴を内部に取り込むことができ、関連するテキストを生成する能力が強化されます。

LLM の微調整は、小規模企業にとってはコストがかかるプロセスになる可能性があります。 ただし、Weights & Biases や OctoML などの企業が提供するソリューションは、合理的かつ効率的な微調整に役立ちます。 これらのソリューションは、企業が独自のインフラストラクチャに投資することなく LLM を微調整するためのプラットフォームを提供します。

その他のツール

LLM アプリケーションの構築と実行に役立つツールは他にもたくさんあります。 たとえば、特定のデータ サンプルを使用してモデルを微調整する場合は、ラベル付けツールが必要になる場合があります。 基盤モデルへのわずかな変更や顧客からのリクエストでも、プロンプトのパフォーマンスに大きな影響を与える可能性があるため、アプリケーションのパフォーマンスを監視するために特定のツールをデプロイすることもできます。 最後に、モデルの安全性を監視して、嫌がらせ的なコンテンツ、危険な推奨、偏見の促進を回避するツールがあります。 これらのさまざまなツールの必要性と重要性は、特定の使用例によって異なります。

LLM アプリケーション開発の次のステップは何ですか?

ここで説明した LLM 製品開発の XNUMX つのステップは、大規模な言語モデルを活用するあらゆる企業の生成 AI 戦略の重要な基盤です。 これらは、詳細を実装する技術チームがいる場合でも、技術者以外のビジネス リーダーが理解することが重要です。 今後、市場にある幅広い生成 AI ツールを活用する方法について、より詳細なチュートリアルを公開する予定です。 今のところはできます ニュースレターを購読します 最新のアップデートを入手します。

この記事をお楽しみいただけますか? エンタープライズ AI の最新情報をさらに入手するにはサインアップしてください。

このような要約記事がさらにリリースされたらお知らせします。

関連記事

- SEO を活用したコンテンツと PR 配信。 今日増幅されます。

- PlatoData.Network 垂直生成 Ai。 自分自身に力を与えましょう。 こちらからアクセスしてください。

- プラトアイストリーム。 Web3 インテリジェンス。 知識増幅。 こちらからアクセスしてください。

- プラトンESG。 自動車/EV、 カーボン、 クリーンテック、 エネルギー、 環境、 太陽、 廃棄物管理。 こちらからアクセスしてください。

- ブロックオフセット。 環境オフセット所有権の近代化。 こちらからアクセスしてください。

- 情報源: https://www.topbots.com/llm-product-development-technology-stack/

- :は

- :not

- :どこ

- $UP

- 1

- a

- 能力

- 私たちについて

- アブダビ

- アクセス

- アクセス

- アクティビティ

- Ad

- NEW

- さらに

- 隣接

- AI

- AI戦略

- 許す

- 許可されて

- ことができます

- また

- Amazon

- Amazon Webサービス

- 量

- an

- 分析します

- および

- 別の

- 人間原理

- どれか

- 誰も

- API

- API

- 申し込み

- アプリケーション開発

- アプローチ

- アプローチ

- 適切な

- です

- エリア

- 記事

- 物品

- AS

- 関連する

- At

- 聴衆

- 利用できます

- 避ける

- Azure

- ベース

- 基本的に

- BE

- き

- 代わって

- さ

- ベンチマーク

- ベンチマーク

- BEST

- より良いです

- の間に

- 越えて

- バイアス

- ブースト

- ボックス

- ブランド

- ブランドの

- ブレーク

- 簡潔に

- 壊れた

- ビルド

- 建物

- 内蔵

- ビジネス

- ビジネスアプリケーション

- ビジネスリーダー

- ビジネス

- 焙煎が極度に未発達や過発達のコーヒーにて、クロロゲン酸の味わいへの影響は強くなり、金属を思わせる味わいと乾いたマウスフィールを感じさせます。

- by

- 計算

- 呼ばれます

- コール

- キャンペーン

- 缶

- 機能

- できる

- これ

- 場合

- 例

- 一定

- 挑戦

- 変更

- 変更

- チャットボット

- AI言語モデルを活用してコードのデバッグからデータの異常検出まで、

- チェック

- チップ

- 選択する

- 選択する

- 選ばれた

- クレーム

- クラウド

- クラウドホスティング

- クラウドプラットフォーム

- コード

- コマーシャル

- コマンドと

- 通信中

- コミュニティ

- 企業

- 会社

- 会社の

- 複雑さ

- コンポーネント

- コンポーネント

- 構成

- コンピューティング

- デメリット

- 検討

- 構築する

- 含まれています

- コンテンツ

- 会話

- コピー

- コーナー

- 正しい

- 補正

- 対応する

- 高額で

- クリエイティブ

- 現在

- カスタム

- 顧客

- 顧客サービス

- カスタマーサービス

- Customers

- カスタム化

- カスタマイズ

- 危険な

- データ

- データベース

- データベースを追加しました

- データブリック

- データセット

- より深い

- 定義

- によっては

- 展開します

- 展開する

- 展開

- 詳細

- 詳細な

- 細部

- 開発する

- Developer

- 開発者

- 開発

- 開発

- アブダビ

- の違い

- 異なります

- 難しい

- 話し合います

- 議論する

- ドキュメント

- ドキュメント

- そうではありません

- ドメイン

- ドメイン

- ダウン

- e

- 各

- 簡単に

- 教育の

- 効果的に

- 効率

- 効率的な

- エリート

- 有効にする

- 高めます

- 強化

- 豊かにする

- Enterprise

- 特に

- 本質的な

- 等

- エーテル(ETH)

- さらに

- あらゆる

- 例

- 例

- 除く

- 実行

- 幹部

- 高価な

- 外部

- 要因

- ファルコン

- 実行可能な

- 特徴

- 代

- 少数の

- より少ない

- ファイナル

- 最後に

- ファイナンシャル

- 名

- フレキシブル

- Foundation

- 4

- フレームワーク

- 無料版

- から

- さらに

- 未来

- 生成する

- 生成

- 世代

- 生々しい

- 生成AI

- 取得する

- 与える

- 世界

- Go

- 行く

- でログイン

- Googleクラウド

- Google Cloud Platform

- 陸上

- ハンド

- Hardware

- ハーネス

- 持ってる

- 持って

- ヘルスケア

- 助けます

- こちら

- ハイレベル

- 非常に

- ホスティング

- 認定条件

- How To

- しかしながら

- HTML

- HTTPS

- i

- if

- 影響

- 実装

- 重要性

- 重要

- 改善します

- in

- 綿密な

- include

- 含ま

- 含めて

- 産業を変えます

- 情報

- インフラ

- 革新的手法

- 機関

- 統合する

- に

- 概要

- 投資する

- IT

- JPG

- ただ

- キー

- 種類

- 知っている

- 知識

- ラベリング

- ラボ

- 欠如

- 風景

- 言語

- 大

- より大きい

- 後で

- 最新の

- 最新のアップデート

- 法律

- 層

- リーダー

- 主要な

- LEARN

- 学習

- リーガルポリシー

- less

- 活用します

- レバレッジ

- ような

- 制限

- 限定的

- ラマ

- 長い

- 見て

- たくさん

- 機械

- 機械学習

- メイン

- make

- 作る

- 管理します

- 管理する

- 多くの

- 市場

- 市場調査

- マーケティング

- マーケティングキャンペーン

- 市場

- 大規模な

- 材料

- 最大幅

- 五月..

- 意味

- 薬

- 大会

- Meta

- メトリック

- Microsoft

- Microsoft Azure

- かもしれない

- マイナー

- ML

- モデル

- モニター

- モニタリング

- 他には?

- 最も

- 一番人気

- ネイティブ

- ナチュラル

- 自然言語

- 必要

- 必要

- 必要とされる

- ニーズ

- 負

- 普通

- 新作

- 新しい技術

- ニュースレター

- 次の

- 非技術的な

- 今

- 数

- of

- 提供

- on

- ONE

- もの

- の

- オープンソース

- OpenAI

- 操作する

- 最適化

- or

- 編成

- 組織

- その他

- その他

- 私たちの

- でる

- 出力

- 概要

- 自分の

- 所有している

- パターン

- 実行する

- パフォーマンス

- 実行

- 柱

- パイプライン

- プラットフォーム

- プラットフォーム

- プラトン

- プラトンデータインテリジェンス

- プラトデータ

- プレーヤー

- ポイント

- 人気

- 正の

- 可能

- 電力

- 強力な

- 精度

- プレゼンテーション

- 問題

- プロセス

- 処理

- 作り出す

- プロダクト

- 製品開発

- 著名な

- 推進

- 所有権

- PROS

- 提供します

- プロバイダ

- は、大阪で

- 提供

- パブリッシュ

- 目的

- パッティング

- 資格を得る

- 品質

- クエリ

- 質問

- 質問

- 範囲

- 読む

- 受け取ります

- 提言

- 記録

- リリース

- 解放

- 関連した

- 信頼性のある

- で表さ

- 要求

- リクエスト

- 必要とする

- 必要

- 研究

- リソース

- 反応します

- 制限

- 結果

- レビュー

- レビュー

- 右

- リスク

- ラン

- ランニング

- 安全性

- 同じ

- Save

- 規模

- セクション

- セキュリティ

- 半導体関連装置

- 感情

- 別

- シリーズ

- サービス

- サービス

- セッションに

- いくつかの

- すべき

- 符号

- 重要

- 著しく

- サイズ

- 小さい

- より小さい

- So

- ソフトウェア

- ソリューション

- 一部

- ソース

- 特定の

- 安定性

- スタック

- start

- 滞在

- ステップ

- まだ

- ストレージ利用料

- 戦略

- 流線

- 合理化された

- スタイル

- そのような

- 十分な

- 概要

- サポート

- システム

- 取る

- 取り

- 才能

- ターゲット

- 仕事

- タスク

- チーム

- チーム

- テク

- 技術的

- テクニカル·サポート

- テクノロジー

- 技術革新

- template

- テスト

- より

- それ

- 未来

- アプリ環境に合わせて

- それら

- その後

- そこ。

- ボーマン

- 彼ら

- この

- それらの

- 数千

- 三

- 介して

- 時間

- 時間がかかる

- 〜へ

- TONE

- 声のトーン

- ツールキット

- 豊富なツール群

- top

- トップボット

- 伝統的な

- トレーニング

- 訓練された

- トレーニング

- 最適化の適用

- 変換

- トランスペアレント

- チュートリアル

- 2

- 一般的に

- 根本的な

- わかる

- 理解する

- ユニーク

- ユニークな機能

- 更新しました

- 更新版

- つかいます

- 使用事例

- 中古

- ユーザー

- 通常

- さまざまな

- 、

- ボイス

- vs

- 欲しいです

- wanted

- 望んでいる

- 方法

- we

- ウェブ

- Webサービス

- WELL

- した

- いつ

- かどうか

- which

- 誰

- ワイド

- 広い範囲

- 意志

- 無し

- 言葉

- 仕事

- でしょう

- 貴社

- あなたの

- ゼファーネット