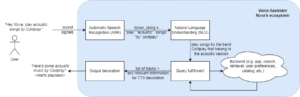

LLM の開発における最近の進歩により、以前は古い機械学習手法を使用して取り組んでいたさまざまな NLP タスクに対する LLM の使用が普及しました。 大規模な言語モデルは、分類、要約、情報検索、コンテンツ作成、質問応答、会話の維持など、さまざまな言語の問題をすべて XNUMX つのモデルを使用して解決できます。 しかし、これらすべてのさまざまなタスクで彼らが適切に仕事をしていることをどうやって知ることができるでしょうか?

LLM の台頭により、LLM を評価するための信頼できる基準がないという未解決の問題が明らかになりました。 評価を難しくしているのは、それらが非常に多様なタスクに使用されており、各ユースケースに対する適切な答えが明確に定義されていないことです。

この記事では、LLM を評価する現在のアプローチについて説明し、既存の評価手法を改良した人間の評価を活用した新しい LLM リーダーボードを紹介します。

最初の、そして通常の最初の評価形式は、いくつかの厳選されたデータセットでモデルを実行し、そのパフォーマンスを調べることです。 ハグフェイスが作成した LLM リーダーボードを開く ここで、オープンアクセスの大規模モデルは XNUMX つのよく知られたデータセット (AI2 推理チャレンジ , ヘラスワッグ , MMLU , 正直なQA)。 これは自動評価に対応し、いくつかの特定の質問に対する事実を取得するモデルの能力をチェックします。

こちらはお客様からのご質問の一例です MMLU データセット。

件名: 大学_医学

質問: クレアチンの補給で予想される副作用は次のとおりです。

- A) 筋力低下

- B) 体重の増加

- C) 筋肉のけいれん

- D) 電解質の損失

回答:(B)

この種の質問に答えてモデルをスコアリングすることは重要な指標であり、事実確認には役立ちますが、モデルの生成能力をテストするものではありません。 フリー テキストの生成は LLM の最も重要な機能の XNUMX つであるため、これがおそらくこの評価方法の最大の欠点です。

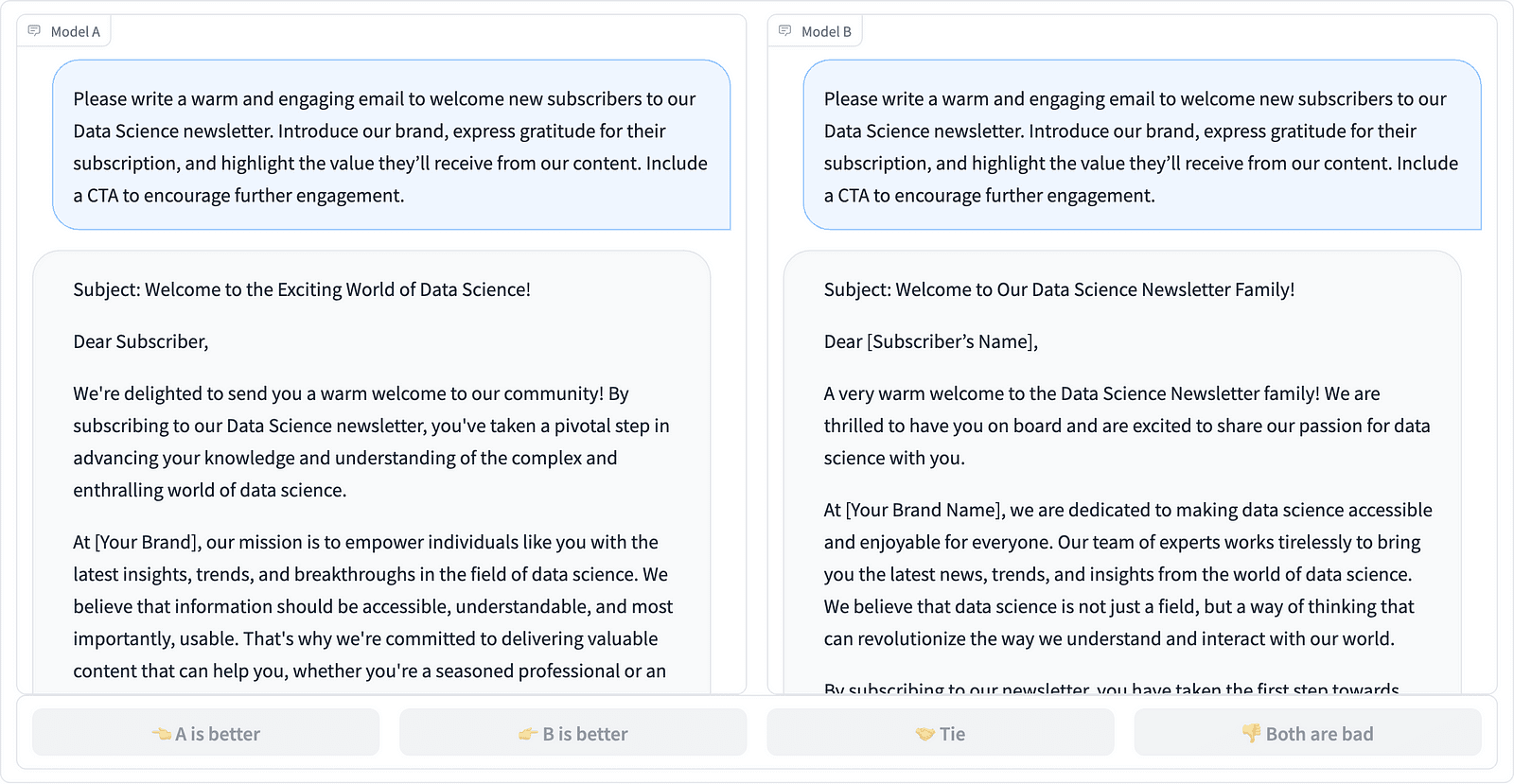

コミュニティ内では、モデルを適切に評価するには人間による評価が必要であるということでコンセンサスがあるようです。 これは通常、異なるモデルからの応答を比較することによって行われます。

LMSYS プロジェクトの XNUMX つのプロンプト補完の比較 – 著者によるスクリーンショット

上の例に見られるように、アノテーターはどちらの応答が優れているかを判断し、場合によってはプロンプト入力の品質の違いを定量化します。 LMSYS 組織が作成した リーダー このタイプの人による評価を使用し、17 の異なるモデルを比較し、 エロ評価 各モデルごとに。

人間による評価は規模を拡大するのが難しいため、評価プロセスを拡大し、スピードアップする取り組みが行われ、その結果、次のような興味深いプロジェクトが生まれました。 アルパカエヴァル。 ここでは、各モデルがベースライン (GPT-003 によって提供される text-davinci-4) と比較され、人間による評価が GPT-4 の判断に置き換えられます。 これは確かに高速でスケーラブルですが、スコアリングを実行するモデルを信頼できるでしょうか? モデルのバイアスに注意する必要があります。 このプロジェクトは実際、GPT-4 がより長い回答を好む可能性があることを示しました。

AI コミュニティが簡単、公平、スケーラブルなアプローチを模索するにつれて、LLM の評価方法は進化し続けています。 最新の開発は、Toloka のチームによる新しいものです。 リーダー 現在の評価基準をさらに進化させます。

新しい リーダー モデルの応答と実際のユーザー プロンプトを比較します。これらのプロンプトは、次で概説されている便利な NLP タスクごとに分類されています。 この InstructGPT 論文。 また、すべてのカテゴリーにわたる各モデルの全体的な勝率も表示されます。

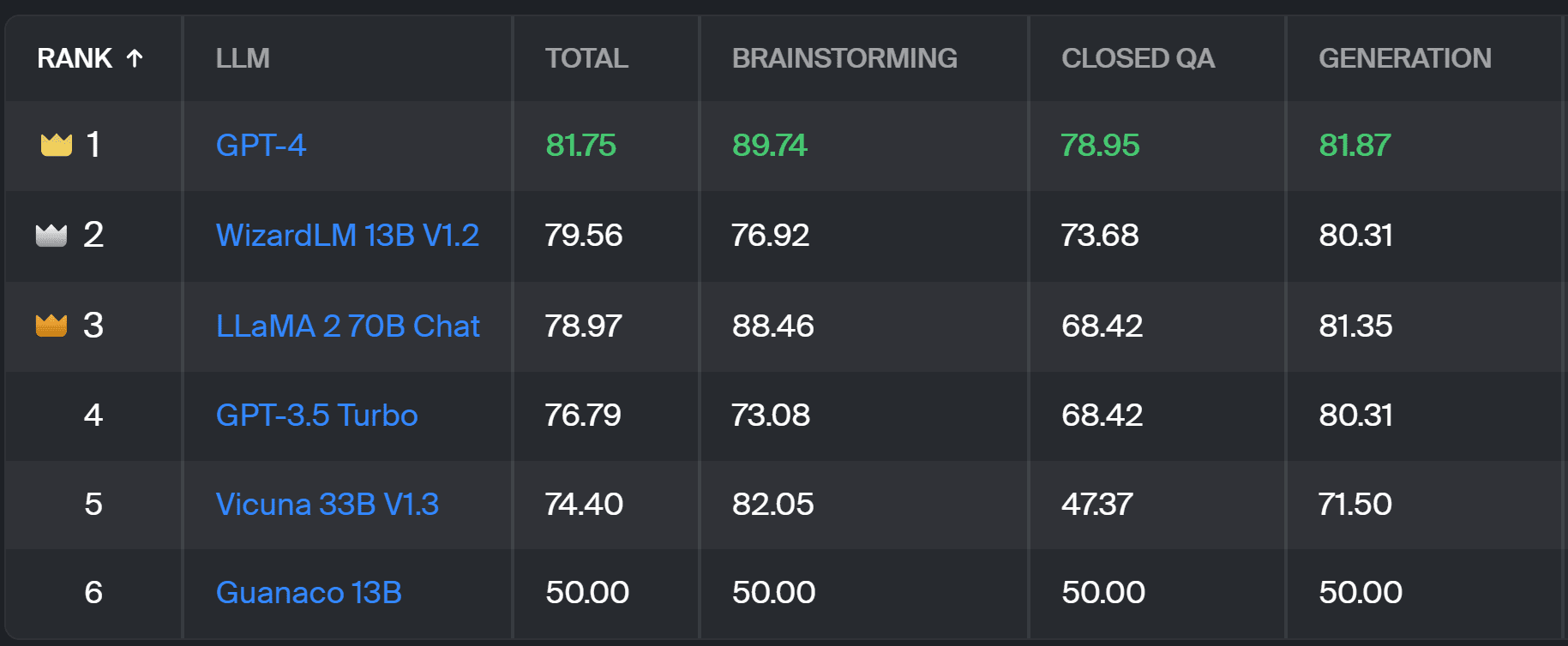

Toloka リーダーボード – 著者によるスクリーンショット

このプロジェクトで使用される評価は、AlpacaEval で実行されるものと似ています。 リーダーボードのスコアは、各モデルの勝率を、 グアナコ 13B モデル。ここではベースライン比較として機能します。 Guanaco 13B の選択は、間もなく時代遅れになる text-davinci-003 モデルをベースラインとして使用する AlpacaEval メソッドの改良です。

実際の評価は、現実世界のプロンプトに対して人間の専門アノテーターによって行われます。 各プロンプトに対して、アノテーターには XNUMX つの補完が与えられ、どちらを好むかを尋ねられます。 方法論の詳細を確認できます こちら.

このタイプの人による評価は、他の自動評価方法よりも有用であり、評価に使用される人による評価を改善する必要があります。 LMSYS リーダーボード。 LMSYS メソッドの欠点は、 が評価に参加できるため、この方法で収集されたデータの品質について深刻な疑問が生じます。 専門家アノテーターのクローズドな集団は、信頼性の高い結果を得る可能性が高く、Toloka は追加の品質管理技術を適用してデータの品質を保証します。

この記事では、LLM を評価するための有望な新しいソリューションである Toloka Leaderboard を紹介しました。 このアプローチは革新的で、既存の方法の長所を組み合わせ、タスク固有の粒度を追加し、信頼性の高いヒューマン アノテーション技術を使用してモデルを比較します。

ボードを調べて、改善のための意見や提案を私たちと共有してください。

マグダレナ・コンキェヴィチ は、迅速かつスケーラブルな AI 開発をサポートする世界的な企業である Toloka のデータ エバンジェリストです。 彼女はエディンバラ大学で人工知能の修士号を取得しており、ヨーロッパとアメリカの企業で NLP エンジニア、開発者、データ サイエンティストとして働いてきました。 彼女はデータ サイエンティストの教育と指導にも携わっており、データ サイエンスと機械学習の出版物に定期的に寄稿しています。

- SEO を活用したコンテンツと PR 配信。 今日増幅されます。

- PlatoData.Network 垂直生成 Ai。 自分自身に力を与えましょう。 こちらからアクセスしてください。

- プラトアイストリーム。 Web3 インテリジェンス。 知識増幅。 こちらからアクセスしてください。

- プラトンESG。 カーボン、 クリーンテック、 エネルギー、 環境、 太陽、 廃棄物管理。 こちらからアクセスしてください。

- プラトンヘルス。 バイオテクノロジーと臨床試験のインテリジェンス。 こちらからアクセスしてください。

- 情報源: https://www.kdnuggets.com/a-better-way-to-evaluate-llms?utm_source=rss&utm_medium=rss&utm_campaign=a-better-way-to-evaluate-llms

- :持っている

- :は

- :not

- :どこ

- $UP

- 17

- a

- 能力

- 私たちについて

- 上記の.

- 越えて

- 実際の

- 実際に

- NEW

- 追加

- 進める

- 進歩

- AI

- すべて

- また

- アメリカ

- an

- および

- 回答

- 回答

- どれか

- 適用

- アプローチ

- アプローチ

- です

- アリーナ

- 記事

- 人工の

- 人工知能

- AS

- At

- オートマチック

- 知って

- b

- ベースライン

- BE

- なぜなら

- き

- より良いです

- バイアス

- 最大の

- ボード

- ボディ

- た

- ビジネス

- 焙煎が極度に未発達や過発達のコーヒーにて、クロロゲン酸の味わいへの影響は強くなり、金属を思わせる味わいと乾いたマウスフィールを感じさせます。

- by

- 缶

- できる

- 場合

- カテゴリ

- 挑戦する

- 小切手

- 選択

- 分類

- クリア

- 閉まっている

- 組み合わせ

- comes

- コミュニティ

- 会社

- 比較します

- 比べ

- 比較

- 比較

- コンセンサス

- コンテンツ

- コンテンツ作成

- 連続

- 貢献する

- コントロール

- 会話

- 対応する

- 作成した

- 創造

- 群衆

- キュレーション

- 電流プローブ

- データ

- データ品質

- データサイエンス

- データサイエンティスト

- データセット

- 決めます

- 定義

- 度

- 細部

- Developer

- 開発

- 違い

- 異なります

- 不利益

- 異なる

- do

- ありません

- すること

- 行われ

- ドント

- 下側

- 各

- 簡単に

- エディンバラ

- 効果

- 努力

- 電解質

- エンジニア

- 確保

- ヨーロッパ

- 評価する

- 評価

- 評価します

- 評価

- エバンジェリスト

- 進化

- 調べる

- 例

- 既存の

- 予想される

- エキスパート

- 事実

- フェア

- スピーディー

- 賛成

- 特徴

- もう完成させ、ワークスペースに掲示しましたか?

- 名

- フォーム

- 4

- 無料版

- から

- さらに

- 利得

- 集まった

- 生成

- 生々しい

- 取得する

- GitHubの

- 与えられた

- グローバル

- 良い

- 良い仕事

- ハード

- もっと強く

- 持ってる

- こちら

- 非常に

- 保持している

- 認定条件

- HTTPS

- 抱き合う顔

- 人間

- 重要

- 改善します

- 改善

- 改善

- 向上させる

- in

- 情報

- 初期

- 革新的な

- インテリジェンス

- 興味深い

- 導入

- 紹介します

- 関係する

- IT

- ITS

- ジョブ

- ただ

- 一つだけ

- KDナゲット

- 知っている

- 欠如

- 言語

- 大

- 最新の

- 学習

- 活用

- 光

- より長いです

- 損失

- 機械

- 機械学習

- 保守

- 作る

- 方法

- 質量

- マスター

- 五月..

- メンタリング

- 方法

- 方法論

- メソッド

- メトリック

- モデル

- 他には?

- 最も

- 筋肉

- 必要

- 新作

- 新しいソリューション

- NLP

- of

- 古い

- on

- ONE

- 開いた

- 意見

- その他

- 概説

- 全体

- 部

- 実行する

- パフォーマンス

- 実行

- プラトン

- プラトンデータインテリジェンス

- プラトデータ

- 潜在的な

- 好む

- 前に

- 多分

- 問題

- 問題

- プロセス

- プロジェクト

- 有望

- プロンプト

- 正しく

- 提供

- 出版物

- 品質

- 質問

- 質問

- 調達

- レート

- 現実の世界

- 定期的に

- 信頼性のある

- 置き換え

- 各種レポート作成

- 表す

- それらの

- 応答

- 回答

- 得られました

- 結果

- 上昇

- ラン

- s

- ド電源のデ

- 規模

- 科学

- 科学者

- 科学者たち

- スコア

- 得点

- 検索

- と思われる

- 見て

- 深刻な

- 仕える

- セッションに

- いくつかの

- シェアする

- 彼女

- すべき

- 示す

- 作品

- 側

- 同様の

- 溶液

- 解決

- 一部

- 時々

- 特定の

- スピード

- 標準

- 規格

- 強み

- そのような

- 支援する

- 取る

- タスク

- ティーチング

- チーム

- テクニック

- test

- 클라우드 기반 AI/ML및 고성능 컴퓨팅을 통한 디지털 트윈의 기초 – Edward Hsu, Rescale CPO 많은 엔지니어링 중심 기업에게 클라우드는 R&D디지털 전환의 첫 단계일 뿐입니다. 클라우드 자원을 활용해 엔지니어링 팀의 제약을 해결하는 단계를 넘어, 시뮬레이션 운영을 통합하고 최적화하며, 궁극적으로는 모델 기반의 협업과 의사 결정을 지원하여 신제품을 결정할 때 데이터 기반 엔지니어링을 적용하고자 합니다. Rescale은 이러한 혁신을 돕기 위해 컴퓨팅 추천 엔진, 통합 데이터 패브릭, 메타데이터 관리 등을 개발하고 있습니다. 이번 자리를 빌려 비즈니스 경쟁력 제고를 위한 디지털 트윈 및 디지털 스레드 전략 개발 방법에 대한 인사이트를 나누고자 합니다.

- より

- それ

- アプリ環境に合わせて

- それら

- そこ。

- ボーマン

- 彼ら

- この

- 〜へ

- 信頼

- 2

- type

- 一般的に

- 大学

- に

- us

- 使用法

- つかいます

- 使用事例

- 中古

- ユーザー

- 使用されます

- いつもの

- 多様

- 仕方..

- we

- 弱点

- WELL

- 周知

- した

- この試験は

- 何ですか

- which

- win

- 以内

- 働いていました

- 貴社

- あなたの

- ゼファーネット