תמונה מאת המחבר

בפוסט זה, נחקור את מודל הקוד הפתוח החדש והחדש שנקרא Mixtral 8x7b. נלמד גם כיצד לגשת אליו באמצעות ספריית LLaMA C++ וכיצד להפעיל מודלים של שפה גדולים על מחשוב וזיכרון מופחתים.

Mixtral 8x7b הוא דגם דליל באיכות גבוהה של מומחים (SMoE) עם משקולות פתוחות, שנוצר על ידי Mistral AI. הוא מורשה תחת Apache 2.0 ומתעלה על Llama 2 70B ברוב המדדים, בעוד שיש לו הסקה מהירה פי 6. Mixtral תואם או מנצח GPT3.5 ברוב המדדים הסטנדרטיים והוא הדגם הטוב ביותר במשקל פתוח לגבי עלות/ביצועים.

תמונה מתוך מיקסטרל של מומחים

Mixtral 8x7B משתמש ברשת תערובת דלילה של מומחים בלבד. זה כרוך בלוק Feedforward בחירה מתוך 8 קבוצות של פרמטרים, כאשר רשת נתבים בוחרת שתיים מהקבוצות הללו עבור כל אסימון, ומשלבת את הפלטים שלהם באופן נוסף. שיטה זו משפרת את ספירת הפרמטרים של המודל תוך ניהול עלות והשהייה, מה שהופך אותו ליעיל כמו מודל 12.9B, למרות שיש לו 46.7B פרמטרים בסך הכל.

דגם Mixtral 8x7B מצטיין בטיפול בהקשר רחב של 32k אסימונים ותומך במספר שפות, כולל אנגלית, צרפתית, איטלקית, גרמנית וספרדית. הוא מפגין ביצועים חזקים ביצירת קוד וניתן לכוונן אותו למודל העוקב אחר הוראות, משיג ציונים גבוהים במדדים כמו MT-Bench.

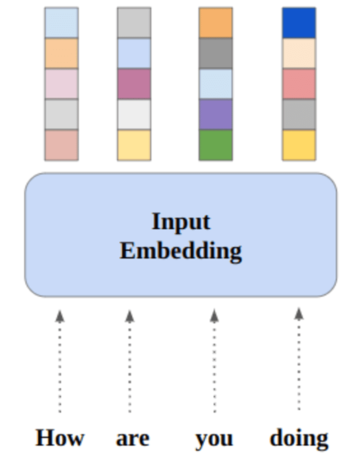

LLaMA.cpp היא ספריית C/C++ המספקת ממשק בעל ביצועים גבוהים עבור מודלים של שפה גדולה (LLMs) המבוסס על ארכיטקטורת LLM של פייסבוק. זוהי ספרייה קלת משקל ויעילה שיכולה לשמש למגוון משימות, כולל הפקת טקסט, תרגום ומענה לשאלות. LLaMA.cpp תומך במגוון רחב של LLMs, כולל LLaMA, LLaMA 2, Falcon, Alpaca, Mistral 7B, Mixtral 8x7B ו-GPT4ALL. זה תואם לכל מערכות ההפעלה ויכול לתפקד גם במעבדים וגם במעבדי GPU.

בחלק זה, נריץ את אפליקציית האינטרנט llama.cpp ב-Colab. על ידי כתיבת כמה שורות קוד, תוכל לחוות את הביצועים החדשים של הדגם החדש במחשב האישי שלך או ב-Google Colab.

תחילת העבודה

ראשית, נוריד את מאגר GitHub llama.cpp באמצעות שורת הפקודה למטה:

!git clone --depth 1 https://github.com/ggerganov/llama.cpp.gitלאחר מכן, נשנה ספרייה למאגר ונתקין את ה-llama.cpp באמצעות הפקודה 'make'. אנו מתקינים את llama.cpp עבור NVidia GPU עם CUDA מותקן.

%cd llama.cpp

!make LLAMA_CUBLAS=1הורד את הדגם

נוכל להוריד את הדגם מ-Hugging Face Hub על ידי בחירת הגרסה המתאימה של קובץ הדגם `.gguf`. מידע נוסף על גרסאות שונות ניתן למצוא ב TheBloke/Mixtral-8x7B-Instruct-v0.1-GGUF.

תמונה מתוך TheBloke/Mixtral-8x7B-Instruct-v0.1-GGUF

אתה יכול להשתמש בפקודה `wget` כדי להוריד את הדגם בספרייה הנוכחית.

!wget https://huggingface.co/TheBloke/Mixtral-8x7B-Instruct-v0.1-GGUF/resolve/main/mixtral-8x7b-instruct-v0.1.Q2_K.ggufכתובת חיצונית עבור שרת LLaMA

כאשר אנו מפעילים את שרת LLaMA הוא ייתן לנו IP של localhost שהוא חסר תועלת עבורנו ב-Colab. אנחנו צריכים את החיבור ל-proxy localhost באמצעות יציאת ה-proxy של Colab.

לאחר הפעלת הקוד למטה, תקבל את ההיפר-קישור הגלובלי. אנו נשתמש בקישור הזה כדי לגשת לאפליקציית האינטרנט שלנו מאוחר יותר.

from google.colab.output import eval_js

print(eval_js("google.colab.kernel.proxyPort(6589)"))

https://8fx1nbkv1c8-496ff2e9c6d22116-6589-colab.googleusercontent.com/הפעלת השרת

כדי להפעיל את שרת LLaMA C++, עליך לספק את פקודת השרת עם המיקום של קובץ הדגם ומספר היציאה הנכון. חשוב לוודא שמספר היציאה תואם לזה שיזמנו בשלב הקודם עבור יציאת ה-proxy.

%cd /content/llama.cpp

!./server -m mixtral-8x7b-instruct-v0.1.Q2_K.gguf -ngl 27 -c 2048 --port 6589

ניתן לגשת לאפליקציית הצ'אט על ידי לחיצה על ההיפר-קישור של יציאת ה-proxy בשלב הקודם מכיוון שהשרת אינו פועל באופן מקומי.

אפליקציה אינטרנטית של LLaMA C++

לפני שנתחיל להשתמש בצ'אטבוט, עלינו להתאים אותו. החלף את "LLaMA" בשם הדגם שלך בסעיף ההנחיות. בנוסף, שנה את שם המשתמש ואת שם הבוט כדי להבחין בין התגובות שנוצרו.

התחל בצ'אט על ידי גלילה מטה והקלדה בקטע הצ'אט. אל תהסס לשאול שאלות טכניות שדגמי קוד פתוח אחרים לא הצליחו לענות עליהן כראוי.

אם אתה נתקל בבעיות עם האפליקציה, תוכל לנסות להפעיל אותה בעצמך באמצעות Google Colab שלי: https://colab.research.google.com/drive/1gQ1lpSH-BhbKN-DdBmq5r8-8Rw8q1p9r?usp=sharing

מדריך זה מספק מדריך מקיף כיצד להפעיל את מודל הקוד הפתוח המתקדם, Mixtral 8x7b, ב-Google Colab באמצעות ספריית LLaMA C++. בהשוואה לדגמים אחרים, Mixtral 8x7b מספק ביצועים ויעילות מעולים, מה שהופך אותו לפתרון מצוין למי שרוצה להתנסות במודלים של שפות גדולות אך אין להם משאבי חישוב נרחבים. אתה יכול להפעיל אותו בקלות על המחשב הנייד שלך או על מחשב ענן חינמי. זה ידידותי למשתמש, ואתה יכול אפילו לפרוס את אפליקציית הצ'אט שלך כדי שאחרים יוכלו להשתמש בה ולהתנסות איתה.

אני מקווה שמצאת את הפתרון הפשוט הזה להפעלת הדגם הגדול מועיל. אני תמיד מחפש אפשרויות פשוטות וטובות יותר. אם יש לך פתרון אפילו יותר טוב, אנא הודע לי, ואני אעסוק בו בפעם הבאה.

עביד עלי אוואן (@1abidaliawan) הוא איש מקצוע מוסמך של מדען נתונים שאוהב לבנות מודלים של למידת מכונה. נכון לעכשיו, הוא מתמקד ביצירת תוכן וכתיבת בלוגים טכניים על למידת מכונה וטכנולוגיות מדעי נתונים. עביד הוא בעל תואר שני בניהול טכנולוגיה ותואר ראשון בהנדסת טלקומוניקציה. החזון שלו הוא לבנות מוצר בינה מלאכותית באמצעות רשת עצבית גרפית עבור תלמידים הנאבקים במחלות נפש.

- הפצת תוכן ויחסי ציבור מופעל על ידי SEO. קבל הגברה היום.

- PlatoData.Network Vertical Generative Ai. העצים את עצמך. גישה כאן.

- PlatoAiStream. Web3 Intelligence. הידע מוגבר. גישה כאן.

- PlatoESG. פחמן, קלינטק, אנרגיה, סביבה, שמש, ניהול פסולת. גישה כאן.

- PlatoHealth. מודיעין ביוטכנולוגיה וניסויים קליניים. גישה כאן.

- מקור: https://www.kdnuggets.com/running-mixtral-8x7b-on-google-colab-for-free?utm_source=rss&utm_medium=rss&utm_campaign=running-mixtral-8x7b-on-google-colab-for-free

- :הוא

- :לֹא

- 1

- 12

- 27

- 46

- 7

- 8

- a

- יכול

- גישה

- נצפה

- השגתי

- בנוסף

- כתובת

- מתקדם

- AI

- תעשיות

- גם

- תמיד

- am

- an

- ו

- לענות

- אַפָּשׁ

- האפליקציה

- בקשה

- מתאים

- ארכיטקטורה

- ARE

- AS

- לשאול

- מבוסס

- BE

- להתחיל

- להלן

- מבחני ביצועים

- הטוב ביותר

- מוטב

- בֵּין

- לחסום

- בלוגים

- בוט

- שניהם

- לִבנוֹת

- בִּניָן

- אבל

- by

- C + +

- נקרא

- CAN

- מוסמך

- שינוי

- צ'אט

- chatbot

- משוחח

- בחירה

- ענן

- קוד

- שילוב

- לעומת

- תואם

- מַקִיף

- חישובית

- לחשב

- מחשוב

- הקשר

- תוכן

- יצירת תוכן

- הקשר

- לתקן

- עלות

- לכסות

- נוצר

- יצירה

- נוֹכְחִי

- כיום

- אישית

- נתונים

- מדע נתונים

- מדען נתונים

- תואר

- מספק

- מדגים

- לפרוס

- למרות

- לְהַבחִין

- do

- מטה

- להורדה

- כל אחד

- בקלות

- יְעִילוּת

- יעיל

- פְּגִישָׁה

- הנדסה

- אנגלית

- משפר

- אֲפִילוּ

- מצוין

- ניסיון

- לְנַסוֹת

- מומחים

- לחקור

- נרחב

- פָּנִים

- פייסבוק

- נכשל

- בז

- מהר יותר

- להרגיש

- מעטים

- שלח

- התמקדות

- בעד

- מצא

- חופשי

- צרפתית

- החל מ-

- פונקציה

- נוצר

- דור

- גרמנית

- לקבל

- GitHub

- לתת

- גלוֹבָּלִי

- GPU

- GPUs

- גרף

- גרף רשת עצבית

- קבוצה

- מדריך

- טיפול

- יש

- יש

- he

- מועיל

- גָבוֹהַ

- ביצועים גבוהים

- באיכות גבוהה

- שֶׁלוֹ

- מחזיק

- לקוות

- איך

- איך

- HTTPS

- טבור

- i

- if

- מחלה

- לייבא

- חשוב

- in

- כולל

- מידע

- יזם

- להתקין

- התקנה

- מִמְשָׁק

- אל תוך

- כרוך

- IP

- בעיות

- IT

- איטלקי

- KDnuggets

- לדעת

- שפה

- שפות

- מחשב נייד

- גָדוֹל

- חֶבִיוֹן

- מאוחר יותר

- לִלמוֹד

- למידה

- לתת

- סִפְרִיָה

- מורשה

- קַל מִשְׁקָל

- כמו

- קו

- קווים

- קשר

- לינקדין

- לאמה

- באופן מקומי

- מיקום

- הסתכלות

- אוהב

- מכונה

- למידת מכונה

- לעשות

- עשייה

- ניהול

- ניהול

- אב

- גפרורים

- me

- זכרון

- נפשי

- מחלת נפש

- שיטה

- תַעֲרוֹבֶת

- מודל

- מודלים

- לשנות

- יותר

- רוב

- מספר

- my

- שם

- צורך

- רשת

- עצביים

- רשת עצבית

- חדש

- הבא

- מספר

- Nvidia

- of

- on

- ONE

- לפתוח

- קוד פתוח

- פועל

- מערכות הפעלה

- אפשרויות

- or

- אחר

- אחרים

- שלנו

- ביצועים טובים יותר

- תפוקה

- פלטים

- שֶׁלוֹ

- פרמטר

- פרמטרים

- PC

- ביצועים

- אפלטון

- מודיעין אפלטון

- אפלטון נתונים

- אנא

- הודעה

- קודם

- המוצר

- מקצועי

- כמו שצריך

- לספק

- מספק

- פרוקסי

- שאלה

- שאלות

- רכס

- מופחת

- בדבר

- להחליף

- מאגר

- מחקר

- משאבים

- תגובות

- נתב

- הפעלה

- ריצה

- s

- מדע

- מַדְעָן

- ציונים

- גלילה

- סעיף

- בחירה

- שרת

- פָּשׁוּט

- since

- פִּתָרוֹן

- מָקוֹר

- ספרדי

- תֶקֶן

- מדינה-of-the-art

- שלב

- חזק

- נאבק

- סטודנטים

- מעולה

- תומך

- בטוח

- מערכות

- משימות

- טכני

- טכנולוגיות

- טכנולוגיה

- טֵלֵקוֹמוּנִיקַציָה

- טֶקסט

- דור טקסט

- זֶה

- השמיים

- שֶׁלָהֶם

- אלה

- זֶה

- אלה

- זמן

- ל

- אסימון

- מטבעות

- סה"כ

- תרגום

- לנסות

- הדרכה

- שתיים

- תחת

- us

- להשתמש

- מְשׁוּמָשׁ

- משתמש

- ידידותי למשתמש

- שימושים

- באמצעות

- מגוון

- שונים

- גרסה

- חזון

- רוצה

- we

- אינטרנט

- אפליקציית רשת

- אשר

- בזמן

- מי

- רָחָב

- טווח רחב

- יצטרך

- עם

- כתיבה

- אתה

- זפירנט