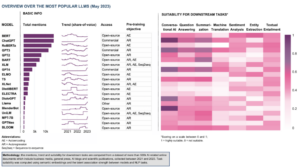

בתחום המתפתח במהירות של בינה מלאכותית, עיבוד שפה טבעית הפך למוקד עבור חוקרים ומפתחים כאחד. בונים על היסודות של אדריכלות שנאי ו השדרוג הדו-כיווני של BERT, כמה מודלים פורצי דרך של שפות צצו בשנים האחרונות, שדוחפים את הגבולות של מה שמכונות יכולות להבין וליצור.

במאמר זה, נתעמק בהתקדמות העדכנית ביותר בעולם של מודלים של שפה בקנה מידה גדול, ונחקור את השיפורים שהוצגו על ידי כל דגם, היכולות שלו ויישומים פוטנציאליים. אנו גם נבחן את מודלים של שפה חזותית (VLMs) אשר מאומנים לעבד לא רק נתונים טקסטואליים אלא גם חזותיים.

אם תרצה לדלג, הנה דגמי השפה שהצגנו:

- GPT-3 מאת OpenAI

- LaMDA מאת גוגל

- PaLM מאת גוגל

- פלמינגו מאת DeepMind

- BLIP-2 של Salesforce

- LLaMA מאת Meta AI

- GPT-4 מאת OpenAI

אם תוכן חינוכי מעמיק זה שימושי עבורך, תוכל הירשם לרשימת התפוצה של מחקרי AI שלנו להתריע כשאנחנו משחררים חומר חדש.

מודלים של שפה גדולה (LLM) ומודלים חזותיים (VLMs) החשובים ביותר בשנת 2023

1. GPT-3 של OpenAI

<br> סיכום

צוות OpenAI הציג את GPT-3 כחלופה לקיום מערך נתונים מסומן עבור כל משימת שפה חדשה. הם הציעו שהגדלת מודלים של שפה יכולה לשפר את הביצועים של מספר יריות מועטות. כדי לבדוק את ההצעה הזו, הם אימנו מודל שפה אוטורגרסיבי של פרמטר 175B, הנקרא GPT-3, והעריך את ביצועיו בלמעלה משני תריסר משימות NLP. ההערכה תחת למידה של מעט-שוטים, למידה ב-one-shot ו-3-shot הדגימה ש-GPT-XNUMX השיג תוצאות מבטיחות ואף עלה מדי פעם על התוצאות החדישות שהושגו על ידי מודלים מכוונים.

מה המטרה?

- להציע פתרון חלופי לבעיה הקיימת, כאשר יש צורך במערך נתונים מסומן עבור כל משימת שפה חדשה.

איך מתייחסים לבעיה?

- החוקרים הציעו להגדיל את מודלים של שפה כדי לשפר את הביצועים של מספר יריות מועטות.

- השמיים GPT-3 המודל משתמש באותו מודל וארכיטקטורה כמו GPT-2, כולל אתחול שונה, קדם נורמליזציה ואסימון הפיך.

- עם זאת, בניגוד ל- GPT-2, היא משתמשת בדפוסי קשב דלילים צפופים ומסועפים בשכבות השנאי, כמו שנאי דליל.

מהן התוצאות?

- דגם ה- GPT-3 ללא כיוונון עדין משיג תוצאות מבטיחות במספר משימות NLP, ואף עולה מדי פעם על מודלים חדישים שהותאמו למשימה ספציפית זו:

- על CoQA אמת מידה, 81.5 F1 בהגדרת זריקת אפס, 84.0 F1 בהגדרת זריקה אחת ו- 85.0 F1 בהגדרת זריקות מעטות, לעומת ציון ה- F90.7 1 שהושג על ידי SOTA מכוונן.

- על TriviaQA אמת מידה, דיוק של 64.3% בהגדרת הזריקה האפסית, 68.0% בהגדרת הזריקה האחת, ו -71.2% בהגדרת הזריקה המעטה, ועולים על 68% על המצב הטכנולוגי (3.2%).

- על למבדה מערך נתונים, דיוק של 76.2% בהגדרת הזריקה האפסית, 72.5% בהגדרת הזריקה האחת ו -86.4% בהגדרת הזריקה המעטה, ועולים על המצב הטכנולוגי ביותר (68%) ב -18%.

- קשה להבדיל בין מאמרי החדשות שנוצרו על ידי מודל ה- GPT-175 של פרמטר 3B לבין אלו האמיתיים, על פי הערכות אנושיות (דיוק בקושי מעל לרמת הסיכוי בשיעור של ~ 52%).

- למרות הביצועים המדהימים של GPT-3, הוא קיבל ביקורות מעורבות מקהילת הבינה המלאכותית:

- "ההייפ GPT-3 הוא יותר מדי. זה מרשים (תודה על המחמאות הנחמדות!) אבל עדיין יש לו חולשות קשות ולעיתים עושה טעויות מטופשות מאוד. AI הולך לשנות את העולם, אבל GPT-3 הוא רק הצצה מוקדמת מאוד. יש לנו עוד הרבה מה להבין. ” - סם אלטמן, מנכ"ל ומייסד שותף של OpenAI.

- "אני המום כמה קשה ליצור טקסט על מוסלמים מ- GPT-3 שאין לו שום קשר לאלימות ... או להרוג ..." - אבובקר עביד, מנכ"ל ומייסד Gradio.

- "לא. GPT-3 ביסודו אינו מבין את העולם עליו הוא מדבר. הגדלת הקורפוס עוד תאפשר לו לייצר פסטיש אמין יותר אך לא לתקן את חוסר ההבנה הבסיסי שלו את העולם. הדגמות של GPT-4 עדיין ידרשו קטיף דובדבנים אנושי. " - גארי מרקוס, מנכ"ל ומייסד Robust.ai.

- "החצנת הביצועים המרהיבים של GPT3 לעתיד מרמזת שהתשובה לחיים, ליקום ולכל היא רק 4.398 טריליון פרמטרים." - ג'פרי הינטון, זוכה פרס טיורינג.

היכן ניתן ללמוד עוד על המחקר הזה?

היכן ניתן להשיג קוד יישום?

- הקוד עצמו אינו זמין, אך נתונים סטטיסטיים של מערכי נתונים יחד עם דגימות 2048 אסימונים ללא תנאי מ- GPT-3 מתפרסמים ב- GitHub.

2. LaMDA של גוגל

<br> סיכום

Language Mאודלים עבור Dיאלוג Aבקשות (למד"א) נוצרו באמצעות תהליך של כוונון עדין של קבוצה של מודלים של שפות עצביות מבוססות שנאי שתוכננו במיוחד עבור דיאלוגים. למודלים אלו יש לכל היותר 137B פרמטרים והם הוכשרו להשתמש במקורות ידע חיצוניים. למפתחי LaMDA היו בראש שלוש מטרות מרכזיות - איכות, בטיחות ומקורקעות. התוצאות הראו שכוונון עדין מאפשר צמצום פער האיכות לרמות אנושיות, אך ביצועי המודל נותרו מתחת לרמות האנושיות ביחס לבטיחות ולמקורקעות.

בארד של גוגל, שוחרר לאחרונה כחלופה ל-ChatGPT, מופעל על ידי LaMDA. למרות שבארד מתויג לעתים קרובות כ משעמם, ניתן לראות בכך עדות למחויבותה של גוגל לתעדוף בטיחות, אפילו בתוך היריבות העזה בין גוגל למיקרוסופט כדי לבסס דומיננטיות בתחום הבינה המלאכותית הגנרטיבית.

מה המטרה?

- לבנות מודל ליישומי דיאלוג בדומיין פתוח, שבו סוכן דיאלוג מסוגל לשוחח על כל נושא כשהתגובות הגיוניות, ספציפיות להקשר, מבוססות על מקורות אמינים ואתיים.

איך מתייחסים לבעיה?

- LaMDA בנוי על שַׁנַאי, ארכיטקטורת רשת עצבית ש-Google Research המציא והוציאה קוד פתוח ב-2017.

- כמו דגמי שפות גדולים אחרים, כולל BERT ו-GPT-3, LaMDA מאומן על טרה-בייט של נתוני טקסט כדי ללמוד כיצד מילים קשורות זו לזו ולאחר מכן לחזות אילו מילים צפויות לבוא בהמשך.

- עם זאת, בניגוד לרוב דגמי השפה, למד"א הוכשרה לדיאלוג כדי לקלוט ניואנסים המבדילים בין שיחה פתוחה לצורות אחרות של שפה.

- הדגם גם מכוון עדין כדי לשפר את הגיוניות, הבטיחות והספציפיות של התגובות שלו. אמנם ביטויים כמו "זה נחמד" ו"אני לא יודע" יכולים להיות בעלי משמעות בתרחישי דיאלוג רבים, סביר להניח שהם לא יובילו לשיחות מעניינות ומרתקות.

- מחולל LaMDA מייצר תחילה מספר תגובות מועמדים, שכולן מקבלות ניקוד על סמך עד כמה הן בטוחות, הגיוניות, ספציפיות ומעניינות. תגובות עם ציוני בטיחות נמוכים מסוננות החוצה, ולאחר מכן התוצאה המדורגת בראש נבחרת כתגובה.

מהן התוצאות?

- ניסויים רבים מראים שלמד"א יכול להשתתף בשיחות פתוחות במגוון נושאים.

- סדרה של הערכות איכותניות אישרה כי תגובות המודל נוטות להיות הגיוניות, ספציפיות, מעניינות ומבוססות על מקורות חיצוניים אמינים, אך עדיין יש מקום לשיפור.

- למרות כל ההתקדמות שנעשתה עד כה, המחברים מכירים בכך שלמודל עדיין יש מגבלות רבות שעלולות לגרום ליצירת תגובות לא הולמות או אפילו מזיקות.

היכן ניתן ללמוד עוד על המחקר הזה?

היכן ניתן להשיג קוד יישום?

- מימוש PyTorch בקוד פתוח עבור ארכיטקטורת ההדרכה המוקדמת של LaMDA זמין ב- GitHub.

3. PaLM מאת גוגל

<br> סיכום

Paבדרך Lייסורים Mאודל (כַּף הַיָד) הוא פרמטר של 540 מיליארד, מודל שפה מבוסס שנאי. PaLM הוכשרה על 6144 שבבי TPU v4 באמצעות Pathways, מערכת ML חדשה לאימון יעיל על פני מספר TPU Pods. המודל מדגים את היתרונות של קנה מידה בלמידה של מספר יריות, השגת תוצאות מתקדמות במאות הבנת שפה ומדדי דורות. PaLM מתעלה על מודלים חדישים מעודכנים במשימות חשיבה מרובות שלבים ועולה על הביצועים האנושיים הממוצעים במדד BIG-bench.

מה המטרה?

- כדי לשפר את ההבנה כיצד קנה מידה של מודלים של שפה גדולים משפיע על למידה של מספר יריות.

איך מתייחסים לבעיה?

- הרעיון המרכזי הוא להגדיל את ההכשרה של מודל שפה של 540 מיליארד פרמטרים עם מערכת Pathways:

- הצוות השתמש בהקבלת נתונים ברמת הפוד על פני שני Cloud TPU v4 Pods תוך שימוש בנתונים סטנדרטיים ובמקביליות מודל בתוך כל Pod.

- הם הצליחו להתאים את האימון ל-6144 שבבי TPU v4, תצורת המערכת הגדולה ביותר מבוססת TPU ששימשה לאימון עד כה.

- המודל השיג יעילות אימון של 57.8% ניצול FLOPs של החומרה, אשר, כפי שטוענים המחברים, היא יעילות האימון הגבוהה ביותר שעדיין הושגה עבור מודלים של שפות גדולות בקנה מידה זה.

- נתוני ההדרכה עבור מודל PaLM כללו שילוב של מערכי נתונים באנגלית ורב-לשוניים המכילים מסמכי אינטרנט איכותיים, ספרים, ויקיפדיה, שיחות וקוד GitHub.

מהן התוצאות?

- ניסויים רבים מוכיחים שביצועי המודל עלו בצורה תלולה ככל שהצוות התרחב למודל הגדול ביותר שלהם.

- PaLM 540B השיג ביצועים פורצי דרך במספר משימות קשות מאוד:

- הבנת שפה ודור. המודל שהוצג עלה על הביצועים המועטים של דגמים גדולים קודמים ב-28 מתוך 29 משימות הכוללות משימות תשובות לשאלות, משימות סתום והשלמת משפטים, משימות הבנת הנקרא בתוך הקשר, משימות חשיבה בשכל הישר, משימות SuperGLUE ו יותר. הביצועים של PaLM במשימות BIG-bench הראו שהיא יכולה להבחין בין סיבה ותוצאה, כמו גם להבין שילובים מושגיים בהקשרים מתאימים.

- הַנמָקָה. עם הנחיה של 8 יריות, PaLM פותר 58% מהבעיות ב-GSM8K, אמת מידה של אלפי שאלות מתמטיקה מאתגרות ברמת בית הספר היסודי, ועולה על הציון העליון הקודם של 55% שהושג על ידי כוונון עדין של מודל GPT-3 175B. PaLM גם מדגימה את היכולת לייצר הסברים מפורשים במצבים הדורשים שילוב מורכב של הסקה לוגית רב-שלבית, ידע עולם והבנת שפה עמוקה.

- יצירת קוד. PaLM מתפקד בדומה ל-Codex 12B המכוונן עדין תוך שימוש פי 50 פחות בקוד Python לאימון, מה שמאשר שמודלים של שפות גדולים מעבירים למידה הן משפות תכנות אחרות והן מנתוני שפה טבעית בצורה יעילה יותר.

היכן ניתן ללמוד עוד על המחקר הזה?

היכן ניתן להשיג קוד יישום?

- יישום PyTorch לא רשמי של ארכיטקטורת ה-Transformer הספציפית ממאמר המחקר של PaLM זמין ב- GitHub. זה לא יתאים והוא מתפרסם למטרות חינוכיות בלבד.

4. פלמינגו של DeepMind

<br> סיכום

פלמינגו היא משפחה מתקדמת של מודלים של שפה חזותית (VLMs), שהוכשרו על קורפוסי אינטרנט רב-מודאליים בקנה מידה גדול עם טקסט ותמונות מעורבים. בעזרת הכשרה זו, המודלים יכולים להסתגל למשימות חדשות תוך שימוש בדוגמאות מוערות מינימליות, המסופקות כהנחיה. פלמינגו משלבת התקדמות ארכיטקטונית מרכזית שנועדה למזג את החוזקות של מודלים מאומנים מראש לראייה בלבד ולשפה בלבד, לעבד רצפים של נתונים ויזואליים וטקסטואליים משתלבים, ולהכיל תמונות או סרטונים כקלט בצורה חלקה. המודלים מפגינים יכולת הסתגלות מרשימה למגוון משימות תמונה ווידאו כגון מענה על שאלות חזותיות, משימות כיתוב ומענה על שאלות חזותיות מרובות ברירות, תוך הגדרת סטנדרטים חדשים של ביצועים תוך שימוש בהנחיות ספציפיות למשימה בלמידה של מספר יריות.

מה המטרה?

- כדי להתקדם לקראת מתן אפשרות למודלים מולטי-מודאליים ללמוד ולבצע במהירות משימות חדשות על סמך הוראות קצרות:

- הפרדיגמה הנפוצה של אימון מקדים של מודל על כמות גדולה של נתונים מפוקחים, ולאחר מכן כוונון עדין למשימה הספציפית, היא עתירת משאבים ודורשת אלפי נקודות נתונים מוערות יחד עם כוונון היפרפרמטר קפדני לכל משימה.

- מודלים נוכחיים המשתמשים ביעד ניגודי מאפשרים התאמה אפסית למשימות חדשות, אך נופלים במשימות פתוחות יותר כמו כיתוב או מענה חזותי לשאלות מכיוון שאין להם יכולות יצירת שפה.

- מחקר זה נועד להציג מודל חדש המתייחס ביעילות לבעיות אלו ומפגין ביצועים מעולים במשטרים דלי נתונים.

איך מתייחסים לבעיה?

- ה-DeepMind הציג את Flamingo, VLMs המיועדים ללמידה של מעט יריות במגוון משימות ראייה ושפה פתוחות, תוך שימוש בכמה דוגמאות קלט/פלט בלבד.

- מודלים של פלמינגו הם מודלים של יצירת טקסט אוטומטית מותנים ויזואלית שיכולים לעבד אסימוני טקסט מעורבבים עם תמונות ו/או סרטונים וליצור טקסט כפלט.

- הארכיטקטורה של פלמינגו משלבת שני דגמים משלימים שהוכשרו מראש וקפואים:

- מודל חזון המסוגל "לתפוס" סצנות ויזואליות.

- מודל שפה גדול שמשימה לבצע חשיבה בסיסית.

- רכיבי ארכיטקטורה חדשניים משלבים את המודלים הללו באופן ששומר על הידע שנצבר במהלך ההכשרה המוקדמת האינטנסיבית מבחינה חישובית.

- בנוסף, דגמי פלמינגו כוללים ארכיטקטורה מבוססת Perceiver, המאפשרת להם להטמיע תמונות או סרטונים ברזולוציה גבוהה. ארכיטקטורה זו יכולה ליצור מספר קבוע של אסימונים חזותיים לכל תמונה/סרטון מתוך מגוון רחב ומשתנה של תכונות קלט חזותיות.

מהן התוצאות?

- המחקר מראה שבדומה ללימודי LLM, שהם לומדים טובים עם מעט יריות, VLMs יכולים ללמוד מכמה דוגמאות קלט/פלט עבור משימות הבנת תמונה ווידאו כגון סיווג, כיתוב או תשובות לשאלות.

- פלמינגו מייסד רף חדש בלמידה של מספר יריות, ומפגין ביצועים מעולים במגוון רחב של 16 משימות הבנה של שפות ותמונות/וידאו מולטי-מודאליות.

- עבור 6 מתוך 16 המשימות הללו, פלמינגו עולה על הביצועים של המצב המעודן, למרות שהוא משתמש רק ב-32 דוגמאות ספציפיות למשימות - בערך פי 1000 פחות נתוני אימון ספציפיים למשימה מאשר הדגמים הנוכחיים בעלי הביצועים הטובים ביותר.

היכן ניתן ללמוד עוד על המחקר הזה?

היכן ניתן להשיג קוד יישום?

- DeepMind לא פרסמה את היישום הרשמי של פלמינגו.

- ייתכן שתמצא יישום קוד פתוח של הגישה שהוצגה ב- OpenFlamingo Github Repo.

- היישום החלופי של PyTorch זמין כאן.

5. BLIP-2 של Salesforce

<br> סיכום

BLIP-2 היא מסגרת אימון קדם יעילה וגנרית עבור מודלים של חזון ושפה, שנועדה לעקוף את העלות הגוברת והולכת של הדרכה מוקדמת של דגמים בקנה מידה גדול. BLIP-2 ממנף מקודדי תמונות קפואים שהוכשרו מראש ודגמי שפה גדולים קפואים לאימון מקדים בשפת ראייה, תוך שילוב שנאי שאילתה קל משקל שהוכשר מראש בשני שלבים. השלב הראשון יוזם למידה של ייצוג חזון-שפה ממקודד תמונה קפואה, והשלב השני מניע למידה מחוללת חזון לשפה ממודל שפה קפואה. למרות שיש לו פחות פרמטרים ניתנים לאימון באופן משמעותי, BLIP-2 מתעלה על השיטות המתקדמות ביותר, ועובר על Flamingo80B של DeepMind ב-8.7% ב-2-shot VQAv54 עם XNUMXx פחות פרמטרים הניתנים לאימון. הדגם גם מציג יכולות מבטיחות של יצירת תמונה לטקסט של צילום אפס, בהתאם להוראות השפה הטבעית.

מה המטרה?

- להשיג ביצועים מתקדמים במשימות שפת חזון, תוך הפחתת עלויות החישוב.

איך מתייחסים לבעיה?

- צוות Salesforce הציג מסגרת חדשה לאימון מקדים בשפת חזון בשם BLIP-2, Bootstrapping Lלשון הרע-Iקוסם Pאימון מחדש עם דגמים חד-מודאליים קפואים:

- הדגמים החד-מודאליים שהוכשרו מראש נשארים קפואים במהלך האימון המקדים כדי להפחית את עלות החישוב ולהימנע מבעיית השכחה הקטסטרופלית.

- כדי להקל על יישור חוצה אופנים ולגשר על פער האופנים בין מודלים של ראייה שהוכשרו מראש למודלים של שפה שהוכשרו מראש, הצוות מציע שנאי שאילתות קל משקל (Q-Former) הפועל כצוואר בקבוק של מידע בין מקודד התמונה הקפואה למקודד הקפוא. LLM.

- Q-former מאומן מראש עם אסטרטגיה דו-שלבית חדשה:

- שלב ההכשרה הראשון מבצע למידת ייצוג חזון-שפת. זה אוכף את ה-Q-Former ללמוד ייצוג חזותי הרלוונטי ביותר לטקסט.

- שלב ההדרכה השני מבצע למידה מחוללת חזון לשפה על ידי חיבור הפלט של ה-Q-Former ל-LLM קפוא. ה-Q-Former מאומן כך שהייצוג החזותי של הפלט שלו יכול להתפרש על ידי ה-LLM.

מהן התוצאות?

- BLIP-2 מספק תוצאות יוצאות דופן ומתקדם במגוון משימות בשפת חזון, הכוללות מענה לשאלות חזותיות, כיתוב תמונה ואחזור טקסט תמונה.

- לדוגמה, הוא מתעלה על פלמינגו ב-8.7% ב-Zero-shot VQAv2.

- יתר על כן, ביצועים יוצאי דופן זה מושגים עם יעילות מחשב גבוהה משמעותית:

- BLIP-2 מתעלה על Flamingo-80B תוך שימוש ב-54× פחות פרמטרים שניתנים לאימון.

- ל-BLIP-2 יש את היכולת לבצע יצירת תמונה לטקסט בצילום אפס בתגובה להוראות שפה טבעית, ובכך לסלול את הדרך לפיתוח מיומנויות כמו חשיבה של ידע חזותי ושיחה חזותית בין היתר.

- לבסוף, חשוב לציין ש-BLIP-2 היא גישה רב-תכליתית שיכולה למנף מודלים חד-מודאליים מתוחכמים יותר כדי לשפר עוד יותר את הביצועים של אימון מקדים בשפת ראייה.

היכן ניתן ללמוד עוד על המחקר הזה?

היכן ניתן להשיג קוד יישום?

היישום הרשמי של BLIP-2 זמין ב- GitHub.

6. LLaMA של Meta AI

<br> סיכום

צוות Meta AI טוען שקל יותר לאמן מחדש ולכוונן דגמים קטנים יותר שאומנו על יותר אסימונים עבור יישומי מוצר ספציפיים. לכן, הם מציגים לָאמָה (Large Language Mאודל מטה AI), אוסף של מודלים של שפה בסיסית עם פרמטרים של 7B עד 65B. LLaMA 33B ו-65B אומנו על 1.4 טריליון אסימונים, בעוד שהדגם הקטן ביותר, LLaMA 7B, אומן על טריליון אסימונים. הם השתמשו אך ורק במערך נתונים זמינים לציבור, ללא תלות בנתונים קנייניים או מוגבלים. הצוות גם יישם שיפורים ארכיטקטוניים מרכזיים וטכניקות אופטימיזציה של מהירות אימון. כתוצאה מכך, LLaMA-13B עלה על GPT-3, בהיותו קטן יותר פי 10, ו-LAMA-65B הציג ביצועים תחרותיים עם PaLM-540B.

מה המטרה?

- להדגים את ההיתכנות של הכשרת מודלים בעלי ביצועים גבוהים אך ורק על מערכי נתונים נגישים לציבור, מבלי להסתמך על מקורות נתונים קנייניים או מוגבלים.

- לספק לקהילת המחקר מודלים קטנים ובעלי ביצועים יותר ובכך לאפשר למי שאין לו גישה לכמויות גדולות של תשתית, ללמוד מודלים של שפות גדולות.

איך מתייחסים לבעיה?

- כדי להכשיר את מודל ה-LLaMA, החוקרים השתמשו רק בנתונים שזמינים לציבור ותואמים למקור פתוח.

- הם גם הציגו כמה שיפורים לארכיטקטורת הרובוטריק הסטנדרטית:

- אימוץ מתודולוגיית GPT-3, יציבות האימון שופרה על ידי נרמול הקלט עבור כל תת-שכבת שנאי, במקום נרמול הפלט.

- בהשראת מודלים של PaLM, החוקרים החליפו את ה-ReLU הלא-לינאריות בפונקציית ההפעלה של SwiGLU, כדי לשפר את הביצועים.

- קיבל השראה מ סו et al (2021), הם ביטלו את ההטבעות המיקום המוחלט ובמקום זאת, שילבו הטבעות מיקום סיבוביות (RoPE) בכל שכבה של הרשת.

- לבסוף, צוות Meta AI שיפר את מהירות האימון של המודל שלהם על ידי:

- שימוש יעיל ביישום קשב רב-ראשי סיבתי על ידי אי אחסון משקלי קשב או מחשוב ציוני מפתח/שאילתה מוסווים.

- שימוש בנקודות ביקורת כדי למזער את הפעלות המחושבות מחדש במהלך המעבר לאחור.

- חפיפה של חישוב הפעלות והתקשורת בין GPUs דרך הרשת (עקב פעולות all_reduce).

מהן התוצאות?

- LLaMA-13B עולה על GPT-3 למרות היותו קטן יותר פי 10, בעוד LLaMA-65B מחזיק מעמד מול PaLM-540B.

היכן ניתן ללמוד עוד על המחקר הזה?

היכן ניתן להשיג קוד יישום?

- Meta AI מספקת גישה ל-LAMA לחוקרים אקדמיים, אנשים הקשורים לממשלה, חברה אזרחית, מוסדות אקדמיים ומעבדות מחקר בתעשייה העולמית על בסיס הערכת מקרה אינדיבידואלי. להגשת מועמדות, עבור אל הפרטים הבאים מאגר GitHub.

7. GPT-4 של OpenAI

<br> סיכום

GPT-4 הוא מודל רב-מודאלי בקנה מידה גדול המקבל קלט של תמונות וטקסט ומייצר פלטי טקסט. בשל חששות תחרותיים ובטיחותיים, פרטים ספציפיים על הארכיטקטורה וההכשרה של הדגם נשמרים. מבחינת ביצועים, GPT-4 עולה על דגמי שפות קודמים במדדים מסורתיים ומציג שיפורים משמעותיים בהבנת כוונת המשתמש ובמאפייני הבטיחות. המודל גם משיג ביצועים ברמה אנושית בבחינות שונות, כולל ציון של 10% בבחינת לשכת עורכי דין מדומה.

מה המטרה?

- לפתח מודל רב-מודאלי בקנה מידה גדול שיכול לקבל קלט של תמונות וטקסט ולהפיק פלטי טקסט.

- לפתח תשתית ושיטות אופטימיזציה שמתנהגות כצפוי בטווח רחב של קנה מידה.

איך מתייחסים לבעיה?

- בשל השלכות נוף תחרותי ובטיחות, OpenAI החליטה למנוע פרטים על ארכיטקטורה, גודל מודל, חומרה, מחשוב אימון, בניית מערכי נתונים ושיטות הדרכה.

- הם חושפים כי:

- GPT-4 הוא דגם מבוסס שנאי, מאומן מראש לחזות את האסימון הבא במסמך.

- הוא משתמש בנתונים זמינים לציבור ובנתונים מורשים של צד שלישי.

- המודל כוונן עדין באמצעות למידה של חיזוק משוב אנושי (RLHF).

- מידע לא מאומת מצביע על כך ש-GPT-4 אינו דגם צפוף יחיד כמו קודמיו, אלא קואליציה של שמונה דגמים נפרדים, שכל אחד מהם מכיל 220 מיליארד פרמטרים מדהימים.

מהן התוצאות?

- GPT-4 משיג ביצועים ברמה אנושית ברוב הבחינות המקצועיות והאקדמיות, ובעיקר ניקוד ב-10% המובילים בבחינת הלשכה האחידה המדומה.

- מודל ה-GPT-4 הבסיסי שהוכשר מראש מתעלה על דגמי השפה הקיימים ומערכות מתקדמות קודמות על מדדי NLP מסורתיים, ללא יצירה ספציפית למבחן או פרוטוקולי אימון נוספים.

- GPT-4 מפגין שיפור משמעותי בכוונת המשתמשים הבאים, כאשר התגובות שלו מועדפות על פני התגובות של GPT-3.5 ב-70.2% מתוך 5,214 הנחיות של ChatGPT ו- OpenAI API.

- מאפייני הבטיחות של GPT-4 השתפרו משמעותית בהשוואה ל-GPT-3.5, עם ירידה של 82% בהיענות לבקשות תוכן אסורות ועלייה של 29% בעמידה במדיניות לגבי בקשות רגישות (למשל, ייעוץ רפואי ופגיעה עצמית).

היכן ניתן ללמוד עוד על המחקר הזה?

היכן ניתן להשיג קוד יישום?

- יישום קוד של GPT-4 אינו זמין.

יישומים מהעולם האמיתי של מודלים של שפות גדולות (ראייה).

פריצות הדרך המשמעותיות ביותר של מחקר בינה מלאכותית של השנים האחרונות מגיעות ממודלים גדולים של בינה מלאכותית שהוכשרו על מערכי נתונים ענקיים. מודלים אלה מפגינים ביצועים מרשימים, ומרתק לחשוב כיצד בינה מלאכותית יכולה לחולל מהפכה בתעשיות שלמות, כמו שירות לקוחות, שיווק, מסחר אלקטרוני, שירותי בריאות, פיתוח תוכנה, עיתונות ועוד רבים אחרים.

למודלים של שפה גדולים יש יישומים רבים בעולם האמיתי. GPT-4 מפרט את הדברים הבאים:

- הבנה ויצירת שפה טבעית עבור צ'טבוטים ועוזרים וירטואליים.

- תרגום מכונה בין שפות.

- סיכום של מאמרים, דוחות או מסמכי טקסט אחרים.

- ניתוח סנטימנטים למחקר שוק או ניטור מדיה חברתית.

- הפקת תוכן לשיווק, מדיה חברתית או כתיבה יצירתית.

- מערכות מענה לשאלות לתמיכת לקוחות או מאגרי ידע.

- סיווג טקסט עבור סינון דואר זבל, סיווג נושאים או ארגון מסמכים.

- כלי לימוד והוראת שפה מותאמים אישית.

- יצירת קוד וסיוע בפיתוח תוכנה.

- ניתוח וסיוע של מסמכים רפואיים, משפטיים וטכניים.

- כלי נגישות לאנשים עם מוגבלות, כגון המרת טקסט לדיבור והמרת דיבור לטקסט.

- שירותי זיהוי ותמלול דיבור.

אם נוסיף חלק ויזואלי, תחומי היישומים האפשריים מתרחבים עוד יותר:

זה מאוד מרגש לעקוב אחר פריצות הדרך האחרונות של AI ולחשוב על היישומים הפוטנציאליים שלהם בעולם האמיתי. עם זאת, לפני פריסת המודלים הללו בחיים האמיתיים עלינו לטפל בסיכונים ובמגבלות התואמות, שלמרבה הצער הם משמעותיים למדי.

סיכונים ומגבלות

אם תשאל את GPT-4 לגבי הסיכונים והמגבלות שלו, סביר להניח שהוא יספק לך רשימה ארוכה של חששות רלוונטיים. לאחר סינון ברשימה זו והוספת כמה שיקולים נוספים, הגעתי לסדרה הבאה של סיכונים ומגבלות עיקריות שיש למודלים מודרניים של שפות גדולות:

- הטיה ואפליה: מודלים אלה לומדים מכמויות אדירות של נתוני טקסט, שלעתים קרובות מכילים הטיות ותוכן מפלה. כתוצאה מכך, התפוקות שנוצרות עלולות להנציח בלי משים סטריאוטיפים, שפה פוגענית ואפליה על בסיס גורמים כמו מגדר, גזע או דת.

- מידע שגוי: מודלים של שפה גדולים עשויים ליצור תוכן שגוי עובדתית, מטעה או מיושן. אמנם המודלים מאומנים על מגוון רחב של מקורות, אך לא תמיד הם מספקים את המידע המדויק או המעודכן ביותר. לעתים קרובות זה קורה מכיוון שהמודל נותן עדיפות להפקת תפוקות שנכונות מבחינה דקדוקית או שנראות קוהרנטיות, גם אם הן מטעות.

- חוסר הבנה: למרות שנראה כי מודלים אלה מבינים את השפה האנושית, הם פועלים בעיקר על ידי זיהוי דפוסים ואסוציאציות סטטיסטיות בנתוני האימון. אין להם הבנה מעמיקה של התוכן שהם מייצרים, מה שעלול לפעמים לגרום לתפוקות שטותיות או לא רלוונטיות.

- תוכן לא הולם: מודלים של שפה יכולים לפעמים ליצור תוכן פוגעני, מזיק או בלתי הולם. אמנם נעשים מאמצים למזער תוכן כזה, אבל זה עדיין יכול להתרחש עקב אופי נתוני ההדרכה וחוסר היכולת של המודלים להבחין בהקשר או בכוונת המשתמש.

סיכום

מודלים של שפה גדולים ללא ספק חוללו מהפכה בתחום עיבוד השפה הטבעית והפגינו פוטנציאל עצום בשיפור הפרודוקטיביות בתפקידים ותעשיות שונות. היכולת שלהם ליצור טקסט דמוי אנושי, להפוך משימות ארציות לאוטומטיות ולספק סיוע בתהליכים יצירתיים ואנליטיים הפכה אותם לכלים חיוניים בעולם המהיר, המונע על ידי הטכנולוגיה של היום.

עם זאת, חיוני להכיר ולהבין את המגבלות והסיכונים הקשורים למודלים רבי עוצמה אלה. אי אפשר להתעלם מבעיות כמו הטיה, מידע מוטעה ופוטנציאל לשימוש זדוני. ככל שאנו ממשיכים לשלב טכנולוגיות מונעות בינה מלאכותית אלו בחיי היומיום שלנו, חיוני למצוא איזון בין מינוף היכולות שלהן והבטחת פיקוח אנושי, במיוחד במצבים רגישים ובסיכון גבוה.

אם נצליח לאמץ טכנולוגיות בינה מלאכותית מחוללות באחריות, נסלול את הדרך לעתיד שבו בינה מלאכותית ומומחיות אנושית פועלות יחד כדי להניע חדשנות וליצור עולם טוב יותר לכולם.

נהנים מהמאמר הזה? הירשם לעדכוני מחקר AI נוספים.

נודיע לך כשנפרסם מאמרים נוספים בנושא זה.

מוצרים מקושרים

- הפצת תוכן ויחסי ציבור מופעל על ידי SEO. קבל הגברה היום.

- PlatoData.Network Vertical Generative Ai. העצים את עצמך. גישה כאן.

- PlatoAiStream. Web3 Intelligence. הידע מוגבר. גישה כאן.

- PlatoESG. רכב / רכבים חשמליים, פחמן, קלינטק, אנרגיה, סביבה, שמש, ניהול פסולת. גישה כאן.

- BlockOffsets. מודרניזציה של בעלות על קיזוז סביבתי. גישה כאן.

- מקור: https://www.topbots.com/top-language-models-transforming-ai-in-2023/

- :יש ל

- :הוא

- :לֹא

- :איפה

- $ למעלה

- 1

- 10

- 12b

- 16

- 2%

- 2017

- 2021

- 2023

- 214

- 220

- 28

- 32

- 50

- 7

- 70

- 710

- 72

- 8

- 84

- 90

- a

- יכולת

- יכול

- אודות

- מֵעַל

- מוּחלָט

- אקדמי

- לְקַבֵּל

- מקבל

- גישה

- נגיש

- להתאים

- פי

- דיוק

- מדויק

- הושג

- משיגה

- השגתי

- הודה

- לרוחב

- הפעלה

- הפעלות

- מעשים

- להסתגל

- הסתגלות

- להוסיף

- מוסיף

- תוספת

- נוסף

- כתובת

- כתובות

- אימוץ

- התקדמות

- עצה

- לאחר

- נגד

- סוֹכֵן

- AI

- ai מחקר

- מטרות

- AL

- דוֹמֶה

- תעשיות

- להתיר

- מאפשר

- מאפשר

- לאורך

- גם

- חלופה

- למרות

- תמיד

- בתוך

- בין

- כמות

- כמויות

- an

- אנליזה

- אנליטית

- ו

- אחר

- לענות

- כל

- API

- לְהוֹפִיעַ

- יישומים

- החל

- גישה

- מתאים

- בערך

- אדריכלי

- ארכיטקטורה

- ARE

- אזורים

- סביב

- מערך

- אמנות

- מאמר

- מאמרים

- מלאכותי

- בינה מלאכותית

- AS

- סיוע

- עוזרים

- המשויך

- עמותות

- At

- תשומת לב

- מחברים

- אוטומטי

- זמין

- מְמוּצָע

- לְהִמָנַע

- פרס

- איזון

- בָּר

- בסיס

- מבוסס

- בסיסי

- בסיס

- BE

- כי

- להיות

- לפני

- להיות

- להלן

- בנצ 'מרק

- מבחני ביצועים

- הטבות

- מוטב

- בֵּין

- הטיה

- הטיות

- B

- ספרים

- אוזן נעל

- שניהם

- גבולות

- פריצת דרך

- פריצות דרך

- לְגַשֵׁר

- רחב

- לִבנוֹת

- בִּניָן

- נבנה

- אבל

- by

- נקרא

- CAN

- מועמד

- לא יכול

- יכולות

- מסוגל

- קיבולת

- זהיר

- מקרה

- קטסטרופלי

- לגרום

- מנכ"ל

- מנכ"ל ומייסד

- אתגר

- סיכוי

- שינוי

- chatbots

- ChatGPT

- שבבי

- לטעון

- מיון

- ענן

- מייסד שותף

- קוד

- קוהרנטי

- אוסף

- שילוב

- שילובים

- איך

- מחויבות

- תקשורת

- קהילה

- לעומת

- תואם

- תחרותי

- משלימה

- מורכב

- הענות

- רכיבים

- חישוב

- לחשב

- המחשב

- מחשוב

- רעיוני

- דאגות

- תְצוּרָה

- מְאוּשָׁר

- מקשר

- כתוצאה מכך

- שיקולים

- בניה

- תוכן

- הקשר

- הקשרים

- להמשיך

- לעומת זאת

- שיחה

- שיחות

- המרה

- לתקן

- תוֹאֵם

- עלות

- עלויות

- יכול

- לִיצוֹר

- נוצר

- יְצִירָתִי

- מְהֵימָן

- מכריע

- נוֹכְחִי

- לקוח

- שירות לקוחות

- שירות לקוחות

- שיא הטכנולוגיה

- יומי

- נתונים

- נקודות מידע

- מערכי נתונים

- תַאֲרִיך

- החליט

- להקטין

- עמוק

- Deepmind

- מספק

- להפגין

- מופגן

- מדגים

- הפגנה

- הדגמות

- תלוי

- פריסה

- מעוצב

- למרות

- פרטים

- לפתח

- מפתחים

- מתפתח

- צעצועי התפתחות

- דיאלוג

- דיאלוג

- קשה

- מוגבלויות

- לחשוף

- אפליה

- לְהַבחִין

- שונה

- do

- מסמך

- מסמכים

- עושה

- שליטה

- לא

- תריסר

- נהיגה

- דיבוב

- ראוי

- בְּמַהֲלָך

- e

- מסחר אלקטרוני

- E&T

- כל אחד

- מוקדם

- קל יותר

- חינוך

- השפעה

- יעילות

- יְעִילוּת

- יעיל

- מַאֲמָצִים

- בוטלו

- יצא

- לאפשר

- מה שמאפשר

- מקיף

- מרתק

- אנגלית

- להגביר את

- משופר

- שיפורים

- שיפור

- הבטחתי

- חיוני

- להקים

- מקימה

- אֶתִי

- העריך

- הערכה

- הערכות

- אֲפִילוּ

- כל

- הכל

- עדות

- מתפתח

- בדיקה

- דוגמה

- דוגמאות

- עולה

- יוצא דופן

- מרגש

- אך ורק

- מוצגים

- קיימים

- לְהַרְחִיב

- ניסויים

- מומחיות

- היכרות

- חיצוני

- f1

- לְהַקֵל

- גורמים

- ליפול

- משפחה

- רחוק

- מקסים

- מהיר

- מאפיין

- מומלצים

- תכונות

- מָשׁוֹב

- מעטים

- פחות

- שדה

- תרשים

- סינון

- ראשון

- לסדר

- קבוע

- לעקוב

- הבא

- בעד

- צורות

- יסודות

- מייסד

- מסגרת

- החל מ-

- קפוא

- פונקציה

- יסודי

- ביסודו

- נוסף

- עתיד

- צבר

- פער

- מין

- ליצור

- נוצר

- מייצר

- יצירת

- דור

- גנרטטיבית

- AI Generative

- גנרטור

- לקבל

- GitHub

- הצצה

- גלוֹבָּלִי

- Go

- מטרה

- הולך

- טוב

- גוגל

- ממשלה

- GPUs

- ציון

- פורץ דרך

- קְבוּצָה

- היה

- קורה

- קשה

- חומרה

- מזיק

- יש

- יש

- בריאות

- כאן

- באיכות גבוהה

- רזולוציה גבוהה

- סיכון גבוה

- גבוה יותר

- הגבוה ביותר

- מחזיק

- איך

- אולם

- HTML

- HTTPS

- עצום

- בן אנוש

- מאות

- התלהבות

- כוונון היפר-פרמטר

- רעיון

- זיהוי

- if

- תמונה

- תמונות

- עָצוּם

- הפעלה

- יושם

- השלכות

- חשוב

- מרשים

- לשפר

- משופר

- השבחה

- שיפורים

- in

- מעמיק

- חוסר יכולת

- לכלול

- כלול

- כולל

- התאגדה

- משלבת

- שילוב

- להגדיל

- גדל

- גדל

- יותר ויותר

- בנפרד

- אנשים

- תעשיות

- תעשייה

- מידע

- תשתית

- יוזם

- חדשנות

- קלט

- תשומות

- במקום

- מוסדות

- הוראות

- לשלב

- מוֹדִיעִין

- כוונה

- מעניין

- אל תוך

- מבוא

- הציג

- בדוי

- סוגיה

- בעיות

- IT

- שֶׁלָה

- עצמו

- עיתונאות

- jpg

- רק

- מפתח

- מטרות עיקריות

- לדעת

- ידע

- מעבדות

- חוסר

- נוף

- שפה

- שפות

- גָדוֹל

- בקנה מידה גדול

- הגדול ביותר

- האחרון

- שכבה

- שכבות

- עוֹפֶרֶת

- לִלמוֹד

- למידה

- משפטי

- פחות

- רמה

- רמות

- תנופה

- מנופים

- מינוף

- מורשה

- החיים

- קַל מִשְׁקָל

- כמו

- סביר

- מגבלות

- רשימה

- רשימות

- חי

- לאמה

- באופן מקומי

- הגיוני

- ארוך

- נראה

- מגרש

- נמוך

- מכונה

- עשוי

- לעשות

- עושה

- רב

- מרקוס

- שוק

- מחקר שוק

- שיווק

- חוֹמֶר

- מתמטיקה

- max-width

- מקסימום

- מאי..

- משמעותי

- מדיה

- רפואי

- למזג

- meta

- מֵתוֹדוֹלוֹגִיָה

- שיטות

- מיקרוסופט

- אכפת לי

- מינימלי

- מידע שגוי

- מַטעֶה

- טעויות

- מעורב

- ML

- מודל

- מודלים

- מודרני

- שונים

- ניטור

- יותר

- רוב

- הרבה

- מספר

- מוסלמים

- טבעי

- שפה טבעית

- עיבוד שפה טבעית

- טבע

- צורך

- נחוץ

- רשת

- עצביים

- שפה עצבית

- רשת עצבית

- חדש

- חדשות

- הבא

- נחמד

- NLP

- בייחוד

- שום דבר

- מספר

- רב

- מטרה

- יעדים

- להתרחש

- of

- מתקפה

- רשמי

- לעתים קרובות

- on

- ONE

- יחידות

- רק

- לפתוח

- קוד פתוח

- OpenAI

- להפעיל

- תפעול

- אופטימיזציה

- or

- ארגון

- אחר

- אחרים

- שלנו

- הַחוּצָה

- ביצועים טובים יותר

- ביצועים טובים יותר

- תפוקה

- בולט

- יותר

- שֶׁלוֹ

- כף היד

- מאמר

- פרדיגמה

- פרמטר

- פרמטרים

- חלק

- להשתתף

- במיוחד

- לעבור

- דפוסי

- לסלול

- סלילה

- עבור

- לבצע

- ביצועים

- ביצוע

- מבצע

- ביטויים

- לבחור

- אפלטון

- מודיעין אפלטון

- אפלטון נתונים

- תרמילים

- נקודה

- נקודות

- מדיניות

- אפשרי

- פוטנציאל

- מופעל

- חזק

- לחזות

- מועדף

- קודם

- בראש ובראשונה

- קודם

- סדר עדיפויות

- בעיה

- בעיות

- תהליך

- תהליכים

- תהליך

- לייצר

- המוצר

- פִּריוֹן

- מקצועי

- תכנות

- שפות תכנות

- התקדמות

- מבטיח

- נכסים

- מציע

- קניינית

- פרוטוקולים

- לספק

- ובלבד

- מספק

- בפומבי

- לאור

- למטרות

- דוחף

- פיתון

- פיטורך

- אֵיכוּתִי

- איכות

- שאלה

- שאלות

- מהירות

- גזע

- רכס

- מהר

- במקום

- קריאה

- ממשי

- חיים אמיתיים

- עולם אמיתי

- לאחרונה

- לאחרונה

- הכרה

- להכיר

- להפחית

- הפחתה

- משטרים

- למידה חיזוק

- לשחרר

- שוחרר

- רלוונטי

- אָמִין

- מקורות אמינים

- דת

- הסתמכות

- להשאר

- נשאר

- ראוי לציון

- החליף

- דוחות לדוגמא

- נציגות

- בקשות

- לדרוש

- דורש

- מחקר

- קהילת מחקר

- חוקרים

- עתירת משאבים

- כבוד

- להגיב

- תגובה

- תגובות

- מוגבל

- תוצאה

- תוצאות

- שומר

- חוות דעת של לקוחותינו

- לְחוֹלֵל מַהְפֵּכָה

- חוללה מהפכה

- סיכונים

- יריבות

- חָסוֹן

- תפקידים

- חֶדֶר

- בטוח

- בְּטִיחוּת

- כוח מכירות

- אותו

- סולם

- מאזניים

- דרוג

- תרחישים

- סצנות

- בית ספר

- ציון

- ציונים

- מניה

- בצורה חלקה

- שְׁנִיָה

- נראה

- לראות

- נבחר

- רגיש

- נפרד

- סדרה

- רציני

- שרות

- שירותים

- סט

- הצבה

- כמה

- המום

- קצר

- לְהַצִיג

- הראה

- הופעות

- סִימָן

- משמעותי

- באופן משמעותי

- באופן דומה

- יחיד

- מצבים

- מידה

- מיומנויות

- קטן יותר

- So

- עד כה

- חֶברָתִי

- מדיה חברתית

- חֶברָה

- תוכנה

- פיתוח תוכנה

- אך ורק

- פִּתָרוֹן

- פותר

- כמה

- מתוחכם

- מָקוֹר

- מקורות

- המקור

- דואר זבל

- ספציפי

- במיוחד

- ספֵּצִיפִיוּת

- מַרהִיב

- דיבור-לטקסט

- מְהִירוּת

- יציבות

- התמחות

- שלבים

- תֶקֶן

- תקנים

- מדינה

- מדינה-of-the-art

- סטטיסטי

- סטטיסטיקה

- עוד

- אִסטרָטֶגִיָה

- חוזק

- להכות

- לימוד

- ניכר

- להצליח

- כזה

- להציע

- מציע

- סיכום

- מעולה

- פיקוח עליון

- תמיכה

- עלתה על

- מערכת

- מערכות

- שיחות

- המשימות

- משימות

- נבחרת

- טכני

- טכניקות

- טכנולוגיות

- מונחים

- מבחן

- דור טקסט

- טקסט לדיבור

- מֵאֲשֶׁר

- תודה

- זֶה

- השמיים

- העתיד

- המדינה

- העולם

- שֶׁלָהֶם

- אותם

- אז

- שם.

- בכך

- לכן

- אלה

- הֵם

- לחשוב

- צד שלישי

- זֶה

- אלה

- אם כי?

- אלפים

- שְׁלוֹשָׁה

- דרך

- פִּי

- ל

- של היום

- יַחַד

- אסימון

- טוקניזציה

- מטבעות

- גַם

- כלים

- חלק עליון

- עליון

- נושא

- נושאים

- לקראת

- מסורתי

- רכבת

- מְאוּמָן

- הדרכה

- להעביר

- שנאי

- הפיכה

- תרגום

- טרִילִיוֹן

- טיורינג

- הדרכה

- שתיים

- בלי תנאים

- תחת

- להבין

- הבנה

- להתחייב

- בְּלִי סָפֵק

- לצערי

- עולם

- בניגוד

- עדכן

- עדכונים

- להשתמש

- מְשׁוּמָשׁ

- משתמש

- שימושים

- באמצעות

- מנצל

- מגוון

- שונים

- Vast

- רב צדדי

- מאוד

- וִידֵאוֹ

- וידאו

- וירטואלי

- חזון

- VOX

- היה

- דֶרֶך..

- we

- אינטרנט

- טוֹב

- היו

- מה

- מתי

- אשר

- בזמן

- מי

- כל

- רָחָב

- טווח רחב

- ויקיפדיה

- יצטרך

- עם

- בתוך

- לְלֹא

- מילים

- תיק עבודות

- לעבוד יחד

- עוֹלָם

- כתיבה

- שנים

- עוד

- אתה

- זפירנט

- למידה אפס-שוט