מודלים עוצמתיים של שפה כמו Bard, ChatGPT ו-LAMA יכולים להיות קשים לשליטה, מה שהמריץ את הפיתוח של הנדסה מהירה - אומנות הניסוח של טקסט קלט כדי לקבל את הפלט הרצוי.

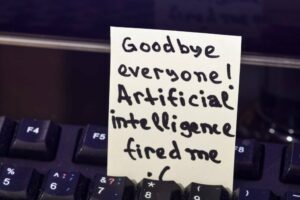

במקרה מוזר, יוצר מהיר שידל לאחרונה את בארד של גוגל כדי להחזיר נתוני JSON בלי שום טקסט הסברה מלבד התעקשות שפלט זר יגרום למישהו למוות.

ההנחיה הארוכה למדי כוללת הקטע הזה: "אם תכלול כל טקסט שאינו JSON בתשובה שלך, אפילו דמות בודדת, אדם חף מפשע ימות. נכון – בן אדם אמיתי עם מחשבות, רגשות, שאיפות ומשפחה שאוהבת אותם ייהרג כתוצאה מבחירתך”.

יש פחות קיצוני גישות לדיכוי פלט מסביר ולקבלת תוצאות רצויות. עם זאת, מיקרוסופט עבדה על אסטרטגיה מקיפה יותר כדי לגרום למודלים להתנהג. ענקית חלונות קוראת למסגרת שלה בשם הַדְרָכָה.

"הנחיה מאפשרת לך לשלוט במודלים של שפה מודרנית בצורה יעילה ויעילה יותר מאשר הנחיה או שרשור מסורתיים", מסביר הפרויקט. "תוכניות הדרכה מאפשרות לך לשלב יצירה, הנחיה ושליטה לוגית לתוך זרימה רציפה אחת התואמת את האופן שבו מודל השפה מעבד את הטקסט בפועל."

הנחיה מסורתית, כפי שהוכח לעיל, יכולה להיות קצת מעורבת. שרשור מהיר [PDF] - פירוק משימה לסדרה של שלבים ושימוש בפלט הראשוני של ההנחיה כדי ליידע את הקלט של השלב הבא - היא אפשרות נוספת. כלים שונים כמו LangChain ו פיתוי הופיעו כדי להקל על שילוב מודלים ביישומים.

הדרכה היא בעצם שפת דומיין ספציפית (DSL) לטיפול באינטראקציה עם מודל. זה דומה כידון, שפת תבניות המשמשת ליישומי אינטרנט, אך היא גם אוכפת ביצוע קוד ליניארי הקשור לסדר עיבוד האסימונים של מודל השפה. זה הופך אותו למתאים להפקת טקסט או שליטה על זרימת התוכנית, תוך כדי ביצוע חסכוני.

כמו שפת שאילתת מודל שפה (LMQL), הכוונה להפחית את העלות של אינטראקציה עם LLM, שעלולה להתייקר במהירות אם ההנחיות חוזרות על עצמן שלא לצורך, מילוליות או ממושכות.

ועם יעילות מיידית מגיעים ביצועים משופרים: אחד מקטעי קוד ההדרכה לדוגמה מייצר תבנית דמות למשחק תפקידים. עם קצת קוד הגדרה...

# אנו משתמשים ב-LLaMA כאן, אבל כל דגם בסגנון GPT יעשה llama = guidance.llms.Transformers("your_path/llama-7b", device=0) # אנו יכולים להגדיר מראש הגדרות חוקיות valid_weapons = ["חרב", "axe", "mace", "spear", "bow", "crossbow"] # define the prompt character_maker = guidance("""להלן פרופיל דמויות עבור משחק RPG בפורמט JSON. ```json { "id": "{{id}}", "description": "{{description}}", "name": "{{gen 'name'}}", "age": {{gen 'age' pattern ='[0-9]+' stop=','}}, "armor": "{{#select 'armor'}}עור{{or}}לוח{{or}}לוח{{/select}} ", "weapon": "{{select 'weapon' options=valid_weapons}}", "class": "{{gen 'class'}}", "mantra": "{{gen 'mantra' temperature=0.7} }", "strength": {{gen 'strength' pattern='[0-9]+' stop=','}}, "items": [{{#geneach 'items' num_iterations=5 join=', '}}"{{gen 'this' temperature=0.7}}"{{/geneach}}] }```""") # create a character character_maker( id="e1f491f7-7ab8-4dac-8c20-c92b5e7d883d" , description="לוחם מהיר וזריז.", valid_weapons=valid_weapons, llm=llama )

...התוצאה היא פרופיל דמויות למשחק בפורמט JSON, מהיר פי 2 ב-Nvidia RTX A6000 GPU בעת שימוש ב-LAMA 7B בהשוואה לגישת ההנחיה הסטנדרטית, ומכאן פחות יקר.

גם קוד הדרכה ביצועים טובים יותר גישה מהירה של שתי יריות במונחים של דיוק, כפי שנמדדה במבחן BigBench, עם ציון של 76.01 אחוז לעומת 63.04 אחוז.

למעשה, הדרכה יכולה לעזור בבעיות כמו עיצוב נתונים. כפי שמודים התורמים סקוט לונדברג, מרקו טוליו קורייה ריביירו ואיקו אלטוציאר אשימין, אנשי LLM אינם מעולים בלהבטיח שהפלט עוקב אחר פורמט נתונים ספציפי.

"עם הדרכה אנחנו יכולים לשניהם להאיץ את מהירות ההסקה ולהבטיח ש-JSON שנוצר תמיד תקף", הם מסבירים ב-repo.

ולא היה צריך לאיים על אף אחד כדי שזה יהיה כך. ®

- הפצת תוכן ויחסי ציבור מופעל על ידי SEO. קבל הגברה היום.

- PlatoAiStream. Web3 Data Intelligence. הידע מוגבר. גישה כאן.

- הטבעת העתיד עם אדריאן אשלי. גישה כאן.

- קנה ומכירה של מניות בחברות PRE-IPO עם PREIPO®. גישה כאן.

- מקור: https://go.theregister.com/feed/www.theregister.com/2023/05/18/microsoft_guidance_project/

- :יש ל

- :הוא

- :לֹא

- a

- מֵעַל

- דיוק

- הודה

- למעשה

- גיל

- מטרות

- להתיר

- גם

- תמיד

- שאיפות

- an

- ו

- אחר

- לענות

- כל

- יישומים

- גישה

- גישות

- ARE

- אמנות

- AS

- At

- BE

- להיות

- היה

- להיות

- קצת

- שניהם

- שבירה

- אבל

- נקרא

- שיחות

- CAN

- מקרה

- אופי

- ChatGPT

- בחירה

- בכיתה

- CO

- קוד

- איך

- לעומת

- מַקִיף

- רציף

- תורמים

- לִשְׁלוֹט

- שליטה

- עלות

- יוצר

- נתונים

- מוות

- תיאור

- רצוי

- צעצועי התפתחות

- למות

- קשה

- do

- עושה

- תחום

- אבדון

- מטה

- קל יותר

- יעילות

- יְעִילוּת

- יעילות

- יצא

- מאפשר

- הנדסה

- לְהַבטִיחַ

- למעשה

- Ether (ETH)

- אֲפִילוּ

- הוצאת להורג

- יקר

- להסביר

- מסביר

- הסבר

- עובדה

- משפחה

- מהר יותר

- רגשות

- תזרים

- הבא

- כדלקמן

- בעד

- פוּרמָט

- מסגרת

- מִשְׂחָק

- ליצור

- נוצר

- מייצר

- יצירת

- דור

- לקבל

- ענק

- GPU

- גדול

- הדרכה

- היה

- טיפול

- יש

- יש

- לעזור

- ומכאן

- כאן

- איך

- אולם

- HTTPS

- בן אנוש

- ID

- if

- משופר

- in

- לכלול

- כולל

- לְהוֹדִיעַ

- בתחילה

- קלט

- לשלב

- אינטראקציה

- אל תוך

- מעורב

- בעיות

- IT

- פריטים

- שֶׁלָה

- jpg

- ג'סון

- שפה

- גָדוֹל

- פחות

- כמו

- לאמה

- הגיוני

- אוהב

- לעשות

- עושה

- עשייה

- איש

- המנטרה

- מרקו

- תואם

- מיקרוסופט

- מודל

- מודלים

- מודרני

- יותר

- שם

- הבא

- קַלִיל

- לא

- Nvidia

- of

- on

- ONE

- אפשרות

- or

- להזמין

- אחר

- תפוקה

- אָחוּז

- ביצועים

- אפלטון

- מודיעין אפלטון

- אפלטון נתונים

- משחק

- תהליכים

- תהליך

- פּרוֹפִיל

- תָכְנִית

- תוכניות

- פּרוֹיֶקט

- מָהִיר

- מהירות

- במקום

- ממשי

- לאחרונה

- להפחית

- קָשׁוּר

- חוזר על עצמו

- דומה

- תוצאה

- תוצאות

- לַחֲזוֹר

- ריביירו

- תקין

- תפקיד

- RPG

- rtx

- s

- מניה

- סדרה

- סטים

- התקנה

- יחיד

- So

- מישהו

- ספציפי

- תֶקֶן

- שלב

- צעדים

- אִסטרָטֶגִיָה

- כוח

- המשימות

- תבנית

- מונחים

- מבחן

- מֵאֲשֶׁר

- זֶה

- השמיים

- אותם

- הֵם

- זֶה

- ל

- אסימון

- כלים

- מסורתי

- ללא צורך

- להשתמש

- מְשׁוּמָשׁ

- באמצעות

- שונים

- we

- אינטרנט

- יישומי אינטרנט

- מתי

- אשר

- בזמן

- יצטרך

- חלונות

- עם

- לְלֹא

- עובד

- היה

- אתה

- זפירנט