Stiamo iniziando a vedere emergere le primissime fasi di uno stack tecnologico nell'intelligenza artificiale generativa (AI). Centinaia di nuove startup si stanno precipitando sul mercato per sviluppare modelli di base, creare app native per l'intelligenza artificiale e creare infrastrutture/strumenti.

Molte tendenze tecnologiche calde vengono pubblicizzate molto prima che il mercato raggiunga. Ma il boom dell'IA generativa è stato accompagnato da guadagni reali nei mercati reali e da una vera trazione da parte di aziende reali. Modelli come Stable Diffusion e ChatGPT stanno stabilendo record storici per la crescita degli utenti e diverse applicazioni hanno raggiunto $ 100 milioni di entrate annualizzate meno di un anno dopo il lancio. I confronti affiancati mostrano i modelli AI superando gli umani in alcune attività di più ordini di grandezza.

Quindi, ci sono abbastanza dati iniziali per suggerire che sta avvenendo un'enorme trasformazione. Quello che non sappiamo, e che ora è diventata la domanda critica, è: Dove in questo mercato maturerà il valore?

Nell'ultimo anno abbiamo incontrato decine di fondatori di startup e operatori di grandi aziende che si occupano direttamente di IA generativa. Lo abbiamo osservato fornitori di infrastrutture sono probabilmente i maggiori vincitori in questo mercato finora, catturando la maggior parte dei dollari che scorrono attraverso lo stack. Società di applicazione stanno aumentando molto rapidamente i ricavi principali, ma spesso hanno problemi con la fidelizzazione, la differenziazione dei prodotti e i margini lordi. E la maggior parte fornitori di modelli, sebbene responsabili dell'esistenza stessa di questo mercato, non hanno ancora raggiunto una grande scala commerciale.

In altre parole, le aziende che creano il massimo valore, ad esempio addestrando modelli di intelligenza artificiale generativa e applicandoli in nuove app, non ne hanno catturato la maggior parte. Prevedere cosa accadrà dopo è molto più difficile. Ma pensiamo che la cosa fondamentale da capire sia quali parti dello stack sono veramente differenziate e difendibili. Ciò avrà un impatto notevole sulla struttura del mercato (ad es. sviluppo aziendale orizzontale o verticale) e sui driver del valore a lungo termine (ad es. margini e fidelizzazione). Finora, abbiamo avuto difficoltà a trovare una difesa strutturale ovunque nella catasta, al di fuori dei tradizionali fossati per gli operatori storici.

Siamo incredibilmente ottimisti sull'IA generativa e crediamo che avrà un impatto enorme nell'industria del software e oltre. L'obiettivo di questo post è mappare le dinamiche del mercato e iniziare a rispondere alle domande più ampie sui modelli di business dell'IA generativa.

Stack tecnologico di alto livello: infrastruttura, modelli e app

Per capire come sta prendendo forma il mercato dell'IA generativa, dobbiamo prima definire l'aspetto attuale dello stack. Ecco la nostra visione preliminare.

La pila può essere suddivisa in tre livelli:

- Applicazioni che integrano modelli di intelligenza artificiale generativa in un prodotto rivolto all'utente, eseguendo le proprie pipeline di modelli ("app end-to-end") o facendo affidamento su un'API di terze parti

- Modelli che alimentano i prodotti AI, resi disponibili come API proprietarie o come punti di controllo open source (che, a loro volta, richiedono una soluzione di hosting)

- Infrastruttura fornitori (ovvero piattaforme cloud e produttori di hardware) che eseguono carichi di lavoro di addestramento e inferenza per modelli di intelligenza artificiale generativa

È importante notare che questa non è una mappa di mercato, ma un quadro per analizzare il mercato. In ogni categoria, abbiamo elencato alcuni esempi di fornitori noti. Non abbiamo fatto alcun tentativo di essere esaustivi o elencare tutte le incredibili applicazioni di intelligenza artificiale generativa che sono state rilasciate. Inoltre, non stiamo andando in profondità qui sugli strumenti MLops o LLMops, che non sono ancora altamente standardizzati e saranno affrontati in un post futuro.

La prima ondata di app di intelligenza artificiale generativa sta iniziando a raggiungere la scala, ma lotta con la conservazione e la differenziazione

Nei precedenti cicli tecnologici, la saggezza convenzionale era che per costruire una grande azienda indipendente, devi possedere il cliente finale, sia che si intendesse singoli consumatori o acquirenti B2B. È allettante credere che le più grandi aziende nell'IA generativa saranno anche applicazioni per l'utente finale. Finora, non è chiaro che sia così.

A dire il vero, la crescita delle applicazioni di intelligenza artificiale generativa è stata sbalorditiva, spinta dalla pura novità e da una pletora di casi d'uso. In effetti, siamo a conoscenza di almeno tre categorie di prodotti che hanno già superato i 100 milioni di dollari di entrate annualizzate: generazione di immagini, copywriting e scrittura di codice.

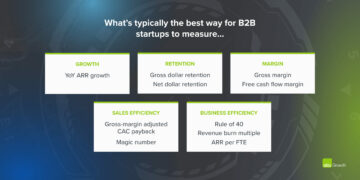

Tuttavia, la crescita da sola non è sufficiente per costruire società di software durevoli. Fondamentalmente, la crescita deve essere redditizia, nel senso che utenti e clienti, una volta registrati, generano profitti (margini lordi elevati) e rimangono a lungo (alta fidelizzazione). In assenza di una forte differenziazione tecnica, le app B2B e B2C generano valore per il cliente a lungo termine attraverso effetti di rete, conservazione dei dati o creazione di flussi di lavoro sempre più complessi.

Nell'IA generativa, questi presupposti non sono necessariamente veri. Tra le società di app con cui abbiamo parlato, esiste un'ampia gamma di margini lordi, fino al 90% in alcuni casi, ma più spesso fino al 50-60%, determinato in gran parte dal costo dell'inferenza del modello. La crescita all'inizio della canalizzazione è stata sorprendente, ma non è chiaro se le attuali strategie di acquisizione dei clienti saranno scalabili: stiamo già assistendo a un calo dell'efficacia e della fidelizzazione delle acquisizioni a pagamento. Molte app sono anche relativamente indifferenziate, poiché si basano su modelli di intelligenza artificiale sottostanti simili e non hanno scoperto evidenti effetti di rete o dati/flussi di lavoro difficili da duplicare per i concorrenti.

Quindi, non è ancora ovvio che la vendita di app per l'utente finale sia l'unica, o addirittura la migliore, strada per costruire un'attività di intelligenza artificiale generativa sostenibile. I margini dovrebbero migliorare con l'aumentare della concorrenza e dell'efficienza nei modelli linguistici (più su questo sotto). La fidelizzazione dovrebbe aumentare man mano che i turisti AI lasciano il mercato. E c'è un forte argomento da sostenere che le app integrate verticalmente hanno un vantaggio nel guidare la differenziazione. Ma c'è ancora molto da dimostrare.

Guardando al futuro, alcune delle grandi domande che devono affrontare le aziende di app di intelligenza artificiale generativa includono:

- Integrazione verticale (“modello + app”). Il consumo di modelli di intelligenza artificiale come servizio consente agli sviluppatori di app di iterare rapidamente con un piccolo team e scambiare fornitori di modelli man mano che la tecnologia avanza. D'altra parte, alcuni sviluppatori sostengono che il prodotto is il modello e che la formazione da zero è l'unico modo per creare difendibilità, ad esempio riqualificando continuamente i dati di prodotto proprietari. Ma a costo di requisiti patrimoniali molto più elevati e di un team di prodotto meno agile.

- Funzionalità di creazione vs. app. I prodotti di intelligenza artificiale generativa assumono una serie di forme diverse: app desktop, app mobili, plug-in Figma/Photoshop, estensioni di Chrome e persino robot Discord. È facile integrare i prodotti AI dove gli utenti già lavorano, poiché l'interfaccia utente è generalmente solo una casella di testo. Quali di queste diventeranno aziende autonome e quali saranno assorbite da operatori storici, come Microsoft o Google, che già incorporano l'intelligenza artificiale nelle loro linee di prodotti?

- Gestire il ciclo dell'hype. Non è ancora chiaro se il tasso di abbandono sia inerente all'attuale lotto di prodotti di intelligenza artificiale generativa o se sia un artefatto di un mercato iniziale. O se l'ondata di interesse per l'IA generativa diminuirà man mano che l'hype si placherà. Queste domande hanno importanti implicazioni per le società di app, incluso quando premere il pedale del gas sulla raccolta fondi; quanto aggressivamente investire nell'acquisizione dei clienti; a quali segmenti di utenti dare la priorità; e quando dichiarare l'idoneità del prodotto al mercato.

I fornitori di modelli hanno inventato l'IA generativa, ma non hanno raggiunto una larga scala commerciale

Quella che oggi chiamiamo AI generativa non esisterebbe senza il brillante lavoro di ricerca e ingegneria svolto in luoghi come Google, OpenAI e Stability. Attraverso nuove architetture di modelli e sforzi eroici per ridimensionare le pipeline di formazione, tutti noi traiamo vantaggio dalle capacità strabilianti degli attuali modelli di linguaggi di grandi dimensioni (LLM) e modelli di generazione di immagini.

Tuttavia, le entrate associate a queste società sono ancora relativamente ridotte rispetto all'utilizzo e al ronzio. Nella generazione di immagini, Stable Diffusion ha visto una crescita esplosiva della comunità, supportata da un ecosistema di interfacce utente, offerte ospitate e metodi di messa a punto. Ma Stability offre gratuitamente i loro principali checkpoint come principio fondamentale della loro attività. Nei modelli di linguaggio naturale, OpenAI domina con GPT-3/3.5 e ChatGPT. Ma relativamente Finora esistono poche app killer basate su OpenAI e i prezzi lo sono già caduto una volta.

Questo potrebbe essere solo un fenomeno temporaneo. La stabilità è una nuova società che non si è ancora concentrata sulla monetizzazione. OpenAI ha il potenziale per diventare un enorme business, guadagnando una parte significativa di tutte le entrate della categoria NLP man mano che vengono create più app killer, specialmente se il loro integrazione nel portafoglio di prodotti Microsoft va liscio. Dato l'enorme utilizzo di questi modelli, i ricavi su larga scala potrebbero non essere molto indietro.

Ma ci sono anche forze contrarie. I modelli rilasciati come open source possono essere ospitati da chiunque, incluse aziende esterne che non sostengono i costi associati alla formazione di modelli su larga scala (fino a decine o centinaia di milioni di dollari). E non è chiaro se qualche modello closed-source possa mantenere il proprio vantaggio indefinitamente. Ad esempio, stiamo iniziando a vedere gli LLM creati da aziende come Anthropic, Cohere e Character.ai avvicinarsi ai livelli di prestazioni OpenAI, formati su set di dati simili (ad esempio Internet) e con architetture di modelli simili. L'esempio della diffusione stabile lo suggerisce if i modelli open source raggiungono un livello sufficiente di prestazioni e supporto da parte della comunità, quindi le alternative proprietarie potrebbero avere difficoltà a competere.

Forse la conclusione più chiara per i fornitori di modelli, finora, è che la commercializzazione è probabilmente legata all'hosting. La domanda di API proprietarie (ad esempio da OpenAI) sta crescendo rapidamente. I servizi di hosting per modelli open source (ad es. Hugging Face e Replicate) stanno emergendo come hub utili per condividere e integrare facilmente i modelli e hanno anche alcuni effetti di rete indiretti tra produttori di modelli e consumatori. C'è anche una forte ipotesi che sia possibile monetizzare attraverso la messa a punto e accordi di hosting con i clienti aziendali.

Oltre a ciò, tuttavia, ci sono una serie di grandi domande che i fornitori di modelli devono affrontare:

- Mercificazione. È opinione comune che i modelli di intelligenza artificiale convergeranno in termini di prestazioni nel tempo. Parlando con gli sviluppatori di app, è chiaro che non è ancora successo, con forti leader sia nei modelli di testo che di immagine. I loro vantaggi non si basano su architetture di modelli univoci, ma su requisiti patrimoniali elevati, dati di interazione del prodotto proprietari e scarso talento di intelligenza artificiale. Questo servirà come vantaggio durevole?

- Rischio laurea. Affidarsi a fornitori di modelli è un ottimo modo per le aziende di app per iniziare e persino per far crescere le loro attività. Ma c'è un incentivo per loro a costruire e/o ospitare i propri modelli una volta raggiunta la scala. E molti fornitori di modelli hanno distribuzioni dei clienti molto distorte, con poche app che rappresentano la maggior parte delle entrate. Cosa succede se/quando questi clienti passano allo sviluppo interno dell'IA?

- I soldi sono importanti? La promessa dell'IA generativa è così grande - e anche potenzialmente così dannosa - che molti fornitori di modelli si sono organizzati come società di pubblica utilità (B corps), hanno emesso quote di profitto limitate o hanno altrimenti incorporato esplicitamente il bene pubblico nella loro missione. Ciò non ha affatto ostacolato i loro sforzi di raccolta fondi. Ma c'è una discussione ragionevole da fare sul fatto che la maggior parte dei fornitori di modelli in realtà volere per acquisire valore, e se dovrebbero.

I fornitori di infrastrutture toccano tutto e raccolgono i frutti

Quasi tutto nell'IA generativa passa prima o poi attraverso una GPU (o TPU) ospitata nel cloud. Che si tratti di fornitori di modelli/laboratori di ricerca che eseguono carichi di lavoro di formazione, società di hosting che eseguono inferenza/regolazione fine o società di applicazioni che eseguono una combinazione di entrambi: FLOPS sono la linfa vitale dell'IA generativa. Per la prima volta da molto tempo, i progressi sulla tecnologia informatica più dirompente sono fortemente legati al calcolo.

Di conseguenza, gran parte del denaro nel mercato dell'IA generativa alla fine passa alle società di infrastrutture. Per metterne un po' molto numeri approssimativi: stimiamo che, in media, le aziende di app spendano circa il 20-40% delle entrate per l'inferenza e la messa a punto per cliente. Questo in genere viene pagato direttamente ai fornitori di servizi cloud per le istanze di calcolo o ai fornitori di modelli di terze parti, che, a loro volta, spendono circa la metà delle loro entrate nell'infrastruttura cloud. Quindi, è ragionevole supporre che il 10-20% di ricavi totali nell'IA generativa oggi va ai fornitori di servizi cloud.

Inoltre, le startup che addestrano i propri modelli hanno raccolto miliardi di dollari in capitale di rischio, la maggior parte dei quali (fino all'80-90% nei primi turni) viene generalmente spesa anche con i fornitori di servizi cloud. Molte aziende di tecnologia pubblica spendono centinaia di milioni all'anno per l'addestramento dei modelli, sia con provider di cloud esterni che direttamente con i produttori di hardware.

Questo è ciò che chiameremmo, in termini tecnici, "un sacco di soldi", soprattutto per un mercato nascente. La maggior parte viene spesa al Big 3 cloud: Amazon Web Services (AWS), Google Cloud Platform (GCP) e Microsoft Azure. Questi fornitori di servizi cloud collettivamente spendere di più di $ 100 miliardi all'anno in capex per assicurarsi di disporre delle piattaforme più complete, affidabili e competitive in termini di costi. Nell'IA generativa, in particolare, beneficiano anche di vincoli di offerta perché hanno accesso preferenziale a hardware scarso (ad es. GPU Nvidia A100 e H100).

È interessante notare, tuttavia, che stiamo iniziando a vedere emergere una concorrenza credibile. Challenger come Oracle hanno fatto breccia con grandi spese in conto capitale e incentivi alle vendite. E alcune startup, come Coreweave e Lambda Labs, sono cresciute rapidamente con soluzioni mirate specificamente ai grandi sviluppatori di modelli. Competono su costi, disponibilità e supporto personalizzato. Inoltre espongono astrazioni di risorse più granulari (ad esempio container), mentre i cloud di grandi dimensioni offrono solo istanze VM a causa dei limiti di virtualizzazione della GPU.

Dietro le quinte, che esegue la stragrande maggioranza dei carichi di lavoro IA, è forse il più grande vincitore finora nell'IA generativa: Nvidia. L'azienda segnalato $ 3.8 miliardo delle entrate GPU del data center nel terzo trimestre del suo anno fiscale 2023, inclusa una parte significativa per i casi d'uso dell'IA generativa. E hanno costruito solidi fossati attorno a questa attività attraverso decenni di investimenti nell'architettura GPU, un robusto ecosistema software e un utilizzo approfondito nella comunità accademica. Un'analisi recente ha scoperto che le GPU Nvidia sono citate nei documenti di ricerca 90 volte di più rispetto alle migliori startup di chip AI messe insieme.

Esistono altre opzioni hardware, tra cui Google Tensor Processing Units (TPU); GPU AMD Instinct; chip AWS Inferentia e Trainium; e acceleratori di intelligenza artificiale di startup come Cerebras, Sambanova e Graphcore. Anche Intel, in ritardo, sta entrando nel mercato con i suoi chip Habana di fascia alta e le GPU Ponte Vecchio. Ma finora, pochi di questi nuovi chip hanno conquistato quote di mercato significative. Le due eccezioni da tenere d'occhio sono Google, i cui TPU hanno guadagnato terreno nella comunità di Stable Diffusion e in alcuni grandi accordi GCP, e TSMC, che si ritiene produca contro tutti i dei chip elencati qui, comprese le GPU Nvidia (Intel utilizza un mix dei propri fab e TSMC per realizzare i propri chip).

L'infrastruttura è, in altre parole, uno strato redditizio, duraturo e apparentemente difendibile nello stack. Le grandi domande a cui rispondere per le società infra includono:

- Mantenimento dei carichi di lavoro stateless. Le GPU Nvidia sono le stesse ovunque le noleggi. La maggior parte dei carichi di lavoro AI è senza stato, nel senso che l'inferenza del modello non richiede database o archiviazione collegati (a parte i pesi del modello stessi). Ciò significa che i carichi di lavoro AI possono essere più portabili tra i cloud rispetto ai tradizionali carichi di lavoro delle applicazioni. In che modo, in questo contesto, i fornitori di servizi cloud possono creare viscosità e impedire ai clienti di passare all'opzione più economica?

- Sopravvivere alla fine della scarsità di chip. I prezzi per i fornitori di servizi cloud e per la stessa Nvidia sono stati supportati da scarse forniture delle GPU più desiderabili. Un fornitore ci ha detto che il prezzo di listino per gli A100 è effettivamente è aumentato dal lancio, il che è molto insolito per l'hardware di elaborazione. Quando questo vincolo di fornitura verrà infine rimosso, attraverso l'aumento della produzione e/o l'adozione di nuove piattaforme hardware, in che modo ciò influirà sui fornitori di servizi cloud?

- Può una nuvola sfidante sfondare? Lo crediamo fermamente nuvole verticali prenderà quote di mercato dai Big 3 con offerte più specializzate. Nell'intelligenza artificiale finora, gli sfidanti hanno ottenuto una trazione significativa attraverso una moderata differenziazione tecnica e il supporto di Nvidia, per la quale i fornitori di servizi cloud storici sono sia i maggiori clienti che i concorrenti emergenti. La domanda a lungo termine è: sarà sufficiente per superare i vantaggi di scala dei Big 3?

Quindi... dove maturerà il valore?

Ovviamente non lo sappiamo ancora. Ma sulla base dei primi dati che abbiamo per l'IA generativa, combinati con la nostra esperienza con precedenti società di AI/ML, la nostra intuizione è la seguente.

Non sembrano esserci, oggi, fossati sistemici nell'IA generativa. Come approssimazione di primo ordine, le applicazioni mancano di una forte differenziazione del prodotto perché utilizzano modelli simili; i modelli affrontano una differenziazione a lungo termine poco chiara perché vengono addestrati su set di dati simili con architetture simili; i fornitori di servizi cloud mancano di una profonda differenziazione tecnica perché eseguono le stesse GPU; e anche le aziende produttrici di hardware producono i loro chip nelle stesse fabbriche.

Ci sono, ovviamente, i fossati standard: fossati di scala ("Ho o posso raccogliere più soldi di te!"), Fossati della catena di approvvigionamento ("Io ho le GPU, tu no!"), Fossati dell'ecosistema (" Tutti usano già il mio software!"), fossati algoritmici ("Siamo più intelligenti di te!"), fossati di distribuzione ("Ho già un team di vendita e più clienti di te!") e fossati di pipeline di dati ("I' abbiamo scansionato più Internet di te!"). Ma nessuno di questi fossati tende a durare a lungo termine. Ed è troppo presto per dire se forti effetti di rete diretti stiano prendendo piede in qualsiasi livello dello stack.

Sulla base dei dati disponibili, non è chiaro se ci sarà una dinamica a lungo termine in cui il vincitore prende tutto nell'IA generativa.

Questo è strano. Ma per noi è una buona notizia. La dimensione potenziale di questo mercato è difficile da comprendere, una via di mezzo tutto il software ed tutti gli sforzi umani - quindi ci aspettiamo molti, molti giocatori e una sana concorrenza a tutti i livelli dello stack. Ci aspettiamo inoltre che le aziende orizzontali e verticali abbiano successo, con l'approccio migliore dettato dai mercati finali e dagli utenti finali. Ad esempio, se la differenziazione primaria nel prodotto finale è l'intelligenza artificiale stessa, è probabile che la verticalizzazione (ovvero l'accoppiamento stretto dell'app rivolta all'utente al modello sviluppato in casa) abbia la meglio. Considerando che se l'intelligenza artificiale fa parte di un set di funzionalità a coda lunga più ampio, è più probabile che si verifichi l'orizzontalizzazione. Naturalmente, nel tempo dovremmo anche vedere la costruzione di fossati più tradizionali e potremmo persino vedere prendere piede nuovi tipi di fossati.

In ogni caso, una cosa di cui siamo certi è che l'IA generativa cambierà le regole del gioco. Stiamo tutti imparando le regole in tempo reale, c'è un'enorme quantità di valore che verrà sbloccato e, di conseguenza, il panorama tecnologico apparirà molto, molto diverso. E noi siamo qui per questo!

Tutte le immagini in questo post sono state create utilizzando Midjourney.

- Distribuzione di contenuti basati su SEO e PR. Ricevi amplificazione oggi.

- Platoblockchain. Web3 Metaverse Intelligence. Conoscenza amplificata. Accedi qui.

- Fonte: https://a16z.com/2023/01/19/who-owns-the-generative-ai-platform/

- $100 milioni

- $3

- 1

- a

- A100

- Chi siamo

- accademico

- acceleratori

- accesso

- raggiunto

- acquisizione

- operanti in

- effettivamente

- Adozione

- avanzamenti

- Vantaggio

- vantaggi

- Dopo shavasana, sedersi in silenzio; saluti;

- accordi

- avanti

- AI

- Piattaforma AI

- casi d'uso ai

- AI / ML

- algoritmica

- Tutti

- consente

- da solo

- già

- alternative

- stupefacente

- Amazon

- Amazon Web Services

- Amazon Web Services (AWS)

- AMD

- quantità

- analizzare

- ed

- annualizzato

- rispondere

- chiunque

- API

- App

- apparire

- Applicazioni

- applicazioni

- AMMISSIONE

- approccio

- applicazioni

- architettura

- discutere

- argomento

- in giro

- artificiale

- intelligenza artificiale

- Intelligenza artificiale (AI)

- associato

- disponibilità

- disponibile

- media

- AWS

- AWS Inferenza

- azzurro

- B2B

- B2C

- basato

- Orso

- perché

- diventare

- prima

- dietro

- fede

- CREDIAMO

- creduto

- credenti

- sotto

- beneficio

- MIGLIORE

- fra

- Al di là di

- Big

- Maggiore

- Miliardo

- miliardi

- boom

- bots

- legato

- Scatola

- Rompere

- brillante

- più ampia

- costruire

- Costruzione

- costruito

- Bullish

- affari

- aziende

- acquirenti

- chiamata

- funzionalità

- capitale

- catturare

- Catturare

- Custodie

- casi

- categoria

- Categoria

- centro

- certo

- sfidante

- Modifiche

- carattere

- ChatGPT

- più economico

- patata fritta

- Chips

- Chrome

- citato

- pulire campo

- più vicino

- Cloud

- infrastruttura cloud

- cloud Platform

- codice

- collettivamente

- combinazione

- combinato

- Venire

- commercializzazione

- Uncommon

- comunità

- Aziende

- azienda

- rispetto

- competere

- concorrenza

- concorrenti

- complesso

- globale

- Calcolare

- informatica

- vincoli

- Consumatori

- Tecnologie Container

- contesto

- continuamente

- convenzionale

- converge

- copy professionale

- Nucleo

- Corporazioni

- Costo

- Costi

- corso

- creare

- creato

- Creazione

- credibile

- critico

- Corrente

- cliente

- Clienti

- cicli

- dati

- Banca dati

- banche dati

- dataset

- affare

- Offerte

- decenni

- deep

- Richiesta

- tavolo

- sviluppare

- sviluppatori

- Mercato

- devs

- diverso

- forme diverse

- diversificato

- Emittente

- dirette

- direttamente

- discordia

- scoperto

- discussione

- dirompente

- distribuzione

- distribuzioni

- Diviso

- fare

- dollari

- domina

- Dont

- decine

- guidare

- spinto

- driver

- guida

- dinamico

- dinamica

- ogni

- In precedenza

- Presto

- Guadagno

- facilmente

- ecosistema

- bordo

- effetti

- efficienza

- sforzi

- o

- emergenti del mondo

- Ingegneria

- abbastanza

- garantire

- Impresa

- clienti aziendali

- particolarmente

- stima

- Anche

- alla fine

- qualunque cosa

- esempio

- Esempi

- attenderti

- esperienza

- estensioni

- esterno

- Faccia

- di fronte

- Autunno

- caratteristica

- Caratteristiche

- pochi

- Trovare

- ricerca

- Nome

- prima volta

- Fiscale

- in forma

- Capovolgere

- fluente

- flussi

- concentrato

- i seguenti

- Forze

- forme

- essere trovato

- Fondazione

- fondatori

- Contesto

- Gratis

- da

- Raccolta fondi

- futuro

- Guadagni

- gioco

- GAS

- generalmente

- generare

- ELETTRICA

- generativo

- AI generativa

- ottenere

- dato

- dà

- scopo

- va

- andando

- buono

- Google cloud

- Google Cloud Platform

- GPU

- GPU

- afferrala

- grande

- lordo

- Crescere

- Crescita

- cresciuto

- Crescita

- Metà

- accadere

- successo

- accade

- Hard

- Hardware

- dannoso

- sano

- qui

- Alta

- superiore

- vivamente

- storico

- Colpire

- tenere

- possesso

- Orizzontale

- host

- ospitato

- di hosting

- HOT

- Come

- HTTPS

- Enorme

- umano

- centinaia

- centinaia di milioni

- Montatura

- Immagine

- generazione di immagini

- immagini

- Impact

- implicazioni

- importante

- competenze

- in

- In altre

- Incentivo

- Incentive

- includere

- Compreso

- Incorporated

- incorporando

- Aumento

- è aumentato

- Aumenta

- sempre più

- incredibilmente

- in carica

- studente indipendente

- individuale

- industria

- Infrastruttura

- inerente

- integrare

- integrato

- integrazione

- Intel

- Intelligence

- interazione

- interesse

- interfacce

- Internet

- intuizione

- Inventato

- Investire

- investimento

- Rilasciato

- IT

- stessa

- Le

- Sapere

- Labs

- Dipingere

- paesaggio

- Lingua

- grandi

- larga scala

- maggiormente

- superiore, se assunto singolarmente.

- Cognome

- L'anno scorso

- In ritardo

- lanciare

- strato

- galline ovaiole

- capi

- apprendimento

- Lasciare

- Livello

- livelli

- probabile

- limiti

- Linee

- Lista

- elencati

- Lunghi

- a lungo

- a lungo termine

- Guarda

- SEMBRA

- lotto

- Basso

- lucrativo

- fatto

- mantenere

- maggiore

- Maggioranza

- make

- Produttori

- molti

- carta geografica

- margini

- Rappresentanza

- mappa del mercato

- Struttura del mercato

- Mercati

- massiccio

- massicciamente

- max-width

- significativo

- si intende

- metodi

- Microsoft

- Microsoft Azure

- Mezzo viaggio

- milione

- milioni

- Missione

- MLOp

- Mobile

- mobili-apps

- modello

- modelli

- monetazione

- monetizzare

- soldi

- Scopri di più

- maggior parte

- multiplo

- nascente

- Naturale

- Linguaggio naturale

- necessariamente

- Bisogno

- Rete

- New

- nuovo hardware

- notizie

- GENERAZIONE

- agile

- nlp

- romanzo

- novità

- numero

- numeri

- Nvidia

- ovvio

- offrire

- offerte

- ONE

- aprire

- open source

- OpenAI

- Operatori

- Opzione

- Opzioni

- oracolo

- ordini

- Organizzato

- Altro

- altrimenti

- al di fuori

- Superare

- proprio

- possiede

- pagato

- documenti

- parte

- particolare

- Ricambi

- Passi

- sentiero

- performance

- Forse

- Personalizzata

- fenomeno

- conduttura

- posto

- Partner

- piattaforma

- Piattaforme

- Platone

- Platone Data Intelligence

- PlatoneDati

- giocatori

- pletora

- i plugin

- punto

- possibile

- Post

- potenziale

- potenzialmente

- energia

- previsione

- prevenire

- prezzo

- Prezzi

- primario

- Precedente

- Dare priorità

- lavorazione

- Produttori

- Prodotto

- Produzione

- Prodotti

- Profitto

- redditizio

- profitti

- Progressi

- PROMETTIAMO

- proprio

- Dimostra

- fornitore

- fornitori

- la percezione

- metti

- Trimestre

- domanda

- Domande

- rapidamente

- aumentare

- sollevato

- gamma

- rapidamente

- raggiungere

- a raggiunto

- di rose

- tempo reale

- ragionevole

- recente

- record

- relativamente

- rilasciato

- affidabile

- rimosso

- Affitta

- che rappresenta

- richiedere

- Requisiti

- riparazioni

- risorsa

- responsabile

- colpevole

- ritenzione

- Le vendite

- ricavi

- Rischio

- robusto

- round

- norme

- Correre

- running

- vendite

- Incentivi alle vendite

- stesso

- scalabile

- Scala

- Scarsa

- Scarsità

- Scene

- vedendo

- segmenti

- Vendita

- senso

- servire

- servizio

- Servizi

- set

- regolazione

- alcuni

- Forma

- Condividi

- azioni

- dovrebbero

- mostrare attraverso le sue creazioni

- segno

- significativa

- simile

- da

- Taglia

- piccole

- liscio

- So

- finora

- Software

- soluzione

- Soluzioni

- alcuni

- da qualche parte

- Fonte

- specializzata

- in particolare

- spendere

- esaurito

- Stabilità

- stabile

- pila

- tappe

- stare in piedi

- standalone

- Standard

- inizia a

- iniziato

- Di partenza

- startup

- Startup

- Bastone

- Ancora

- conservazione

- strategie

- forte

- strutturale

- La struttura

- Lotta

- avere successo

- sufficiente

- suggerisce

- fornire

- supporto

- supportato

- ondata

- sostenibile

- Interruttore

- sistemico

- Fai

- presa

- Talento

- parlando

- mirata

- task

- team

- Tech

- tech

- Consulenza

- Tecnologia

- temporaneo

- condizioni

- I

- loro

- si

- cosa

- Terza

- di parti terze standard

- tre

- Attraverso

- Legato

- strettamente

- tempo

- volte

- a

- oggi

- pure

- top

- toccare

- trazione

- tradizionale

- allenato

- Training

- Trasformazione

- enorme

- tendenze

- vero

- tsmc

- TURNO

- Tipi di

- tipicamente

- ui

- in definitiva

- sottostante

- capire

- unico

- unità

- insolito

- us

- Impiego

- uso

- Utente

- utenti

- APPREZZIAMO

- Fisso

- fornitori

- impresa

- capitale di rischio

- via

- Visualizza

- Orologio

- Wave

- sito web

- servizi web

- noto

- Che

- se

- quale

- while

- OMS

- largo

- Vasta gamma

- wikipedia

- volere

- vincere

- vincitori

- saggezza

- senza

- parole

- Lavora

- flussi di lavoro

- scrittura

- anno

- zefiro