Conosci i costi di una scarsa qualità dei dati? Di seguito, esplorerò l'importanza dell'osservabilità dei dati, come può mitigare i rischi di dati errati e i modi per misurarne il ROI. Comprendendo l'impatto dei dati errati e implementando strategie efficaci, le organizzazioni possono massimizzare i vantaggi delle proprie iniziative sulla qualità dei dati.

I dati sono diventati parte integrante del processo decisionale moderno e, pertanto, la qualità dei dati è fondamentale per garantire che le parti interessate aziendali traggano conclusioni accurate.

Ma ecco il problema che ogni moderno leader dei dati ti dirà: la gestione della qualità dei dati è difficile. Ci vuole tempo e impegno. Inoltre, il ROI (ritorno sull’investimento) è spesso difficile da misurare.

Quanto sono dannosi i dati errati?

Dati errati possono portare a perdite finanziarie significative. Gartner stima che ogni anno la scarsa qualità dei dati costa in media alle organizzazioni $12.9 milioni. Nel 2022, Software Unity ha riportato una perdita di 110 milioni di dollari di ricavi e di 4.2 miliardi di dollari di capitalizzazione di mercato. "Conseguenze dell'acquisizione di dati errati da un grande cliente", ha affermato la società. Allo stesso modo, sono stati causati dati errati Equifax, un'agenzia di segnalazione del credito quotata in borsa, a cui inviare ai prestatori punteggi di credito imprecisi milioni dei clienti. Più recentemente, un incidente relativo ai dati ha causato enormi disagi al traffico aereo del Regno Unito e dell’Irlanda. È stato riferito che oltre 2,000 voli sono stati cancellati, lasciando centinaia di migliaia di viaggiatori a terra, la perdita finanziaria accumulata per le compagnie aeree è stimata in 126.5 milioni di dollari.

Le implicazioni dei dati errati

I dati sono al centro di ogni azienda moderna. La responsabilità principale del team dati è creare e mantenere prodotti dati che vengono serviti ai clienti internamente ed esternamente, consentendo al tempo stesso all'organizzazione di scalare e raggiungere i propri obiettivi.

Quando si tratta di garantire che le iniziative sui dati dell’organizzazione siano pronte per il successo, alcune aspettative di base di un team di dati possono essere riassunte come segue:

- uptime: I dati sono un servizio e quindi garantire che siano disponibili quando necessario è fondamentale.

- Sicurezza: Conformità alle normative (come GDPR o HIPAA). Il team è responsabile dell'implementazione di misure e pratiche per proteggere le informazioni sensibili e mantenere la riservatezza dei dati.

- L’affidabilità: Sia dei dati che della piattaforma dati. Parte di questo riguarda il tempo di attività, ma anche la qualità e l'accuratezza dei dati nel senso tradizionale.

- Scala: La piattaforma dati dovrebbe consentire la scalabilità per soddisfare i crescenti volumi di dati, il numero di casi d’uso e le esigenze dell’azienda.

- Innovazione: I dati dovrebbero guidare l’innovazione, e questa è un’area in cui è importante che il team dedicato ai dati dia l’esempio portando innovazione all’interno e all’esterno delle pratiche relative ai dati.

Raggiungere la qualità dei dati attraverso l'osservabilità dei dati

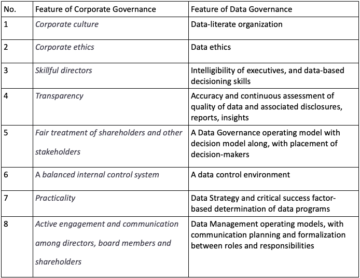

L'osservabilità dei dati è una soluzione per monitorare e mantenere in modo proattivo l'integrità dei dati durante tutto il loro ciclo di vita. Implementando tecniche di registrazione, tracciamento e monitoraggio, le organizzazioni ottengono visibilità sui flussi di dati, identificano e risolvono rapidamente i problemi di qualità dei dati e prevengono interruzioni dei dashboard di analisi. Alfabetizzazione dei dati, che coinvolge l'approvvigionamento, l'interpretazione e la comunicazione dei dati, è essenziale affinché i decisori possano tradurre i dati in valore aziendale in modo efficace. Coltivare una cultura basata sui dati e investire negli strumenti giusti sono passi cruciali verso il raggiungimento della qualità dei dati attraverso l’osservabilità dei dati.

Quantificare il ROI dell'osservabilità dei dati

Misurare il ROI dell’osservabilità dei dati aiuta i leader aziendali a comprendere il valore e i vantaggi associati all’investimento in questa pratica. Diversi parametri quantificabili possono servire come punto di partenza per valutare il costo di dati errati, tra cui il tasso di occorrenza o il numero di incidenti all'anno, il tempo necessario per il rilevamento e il tempo necessario per la risoluzione.

L'impatto di problemi di qualità dei dati può variare a seconda delle dimensioni e della complessità delle operazioni aziendali. Al fine di valutare il danno e costruire una valida causa per una soluzione di osservabilità dei dati, proponiamo cinque parametri chiave che i professionisti dei dati possono facilmente implementare e monitorare e che possono essere utilizzati per supportare un caso internamente:

- Numero e frequenza degli incidenti: Mentre alcune aziende potrebbero riscontrare incidenti legati ai dati su base giornaliera, altre potrebbero trascorrere giorni, se non settimane, senza che si verifichino incidenti. La criticità degli incidenti può variare da qualcosa di “minore”, come dati obsoleti collegati a un dashboard che nessuno utilizza da secoli, a un problema di duplicazione dei dati che causa il sovraccarico del server e alla fine si blocca (storia vera, Netflix 2016). Scopriamo che è spesso legato a: dimensioni e complessità della piattaforma dati, settore dell'azienda (alcuni settori sono intrinsecamente più maturi rispetto ad altri), tipo di architettura dei dati (centralizzata, decentralizzata, ibrida), ecc. La documentazione degli incidenti fornirà un'idea migliore di cosa cercare la prossima volta che ce n'è uno, gli incidenti ripetuti sono spesso un buon indicatore che qualcosa sotto necessita di maggiore attenzione.

- Classificazione degli incidenti: Non tutti gli incidenti relativi ai dati hanno la stessa gravità; alcuni possono essere minori e facilmente mitigabili, mentre altri possono avere conseguenze gravi. Documentare la criticità degli incidenti è importante per garantire un'escalation e una definizione delle priorità adeguate. È qui che la derivazione dei dati può essere determinante, poiché consente di valutare l’impatto a valle dell’incidente per comprendere meglio la criticità. È probabile che un incidente collegato alla dashboard preferita del CEO, a un database di produzione o a un prodotto di dati importante abbia un’elevata criticità.

- Tempo medio di rilevamento (MTTD): Quando si tratta di creare fiducia nei dati e nel relativo team, l’incubo di ogni professionista dei dati è quando gli stakeholder aziendali sono i primi a rilevare i problemi di qualità dei dati. Può davvero danneggiare la credibilità del team e la capacità dell’azienda di diventare veramente guidata dai dati. Quando si inizia a documentare gli incidenti e a classificarne la criticità, è importante tenere traccia anche del modo in cui sono stati rilevati e del tempo impiegato dal team addetto ai dati per riconoscerli. Questa metrica può essere un buon indicatore della solidità della gestione degli incidenti, ma ridurla significa anche ridurre il rischio che l'incidente possa causare maggiori danni.

- Tempo medio di risoluzione (MTTR): Cosa succede una volta segnalato un incidente? MTTR è il tempo medio trascorso tra la presa di coscienza di un incidente relativo ai dati e la sua risoluzione. Il tempo di risoluzione è fortemente influenzato dalla criticità dell’incidente e dalla complessità della piattaforma dati, motivo per cui ai fini di questo framework consideriamo la media.

- Tempo medio di produzione (MTTP) è il tempo medio necessario per spedire nuovi prodotti dati o, in altre parole, il tempo medio di commercializzazione dei prodotti dati. Questo potrebbe essere il tempo impiegato da un analista per “ripulire” i dati per un modello di data science. Infatti, secondo Forbes, la preparazione dei dati rappresenta circa l'80% del lavoro dei data scientist. In un mondo in cui vogliamo trattare i dati come un prodotto, il miglioramento della qualità dei dati può avere un impatto diretto sulla riduzione del time-to-market.

Oltre ai parametri quantificabili di cui sopra, vale la pena considerarne altri meno facilmente quantificabili ma altrettanto importanti quando si esamina il costo dei dati errati.

- Erosione della fiducia: Nei dati ed il gruppo dati. Questa è, a mio avviso, la conseguenza più pericolosa di dati errati, che può comportare problemi più grandi come il turnover nel team addetto ai dati o la perdita di fiducia nella capacità dell’azienda di basarsi sui dati e di stare al passo con il panorama digitale in evoluzione. E una volta che la fiducia viene tradita, è molto difficile riconquistarla. In un'esperienza precedente, ho lavorato con consumatori di dati che preferirebbero non utilizzare i dati e fare affidamento sull'"esperienza" e sul "istinto" in un ambiente di negoziazione azionario molto volatile piuttosto che utilizzarli sapendo che avevano un'alta probabilità di essere imprecisi. .

- Perdita di produttività: Con dati errati, le squadre sono costrette a combattere e correggere gli errori non appena si presentano. Questa continua lotta agli incendi non solo è estenuante ma anche controproducente. Il tempo prezioso che potrebbe essere dedicato alla pianificazione strategica e alle iniziative di crescita viene sprecato nella risoluzione dei problemi, dirottando risorse da attività più critiche.

- Rischio normativo e reputazionale: Errori nella rendicontazione finanziaria o nella cattiva gestione dei dati personali possono comportare sanzioni costose e battaglie legali. Affrontare i problemi di conformità comporta un notevole dispendio di produttività, per non parlare dell’onere finanziario che essi impongono.

- Scarsa performance aziendale: Oltre a perdere produttività all'interno del data team, i dati errati possono ostacolare le prestazioni aziendali complessive poiché l'azienda lotta con la preparazione digitale e la credibilità di fronte ai propri clienti e diventa vulnerabile alle minacce esterne.

I problemi di qualità dei dati possono causare vari problemi, tra cui la perdita di fiducia nei dati, la riduzione della produttività e del morale del team, il mancato rispetto delle normative e una diminuzione della qualità del processo decisionale. I dati isolati all’interno di dipartimenti o unità aziendali rendono difficile ottenere una visione olistica del panorama dei dati dell’organizzazione. Ciò può portare a un processo decisionale inefficace, ostacolare la cultura dei dati e mettere a repentaglio la conformità a normative come GDPR e HIPAA. Inoltre, i team dati possono sentirsi frustrati se dedicano troppo tempo alla risoluzione dei problemi relativi ai dati, incidendo negativamente sulla loro soddisfazione lavorativa e portando potenzialmente all’abbandono dei dipendenti.

La regola 1x10x100

La regola 1x10x100, un principio ampiamente riconosciuto nella gestione degli incidenti, sottolinea i costi crescenti associati alla cattiva qualità dei dati. Secondo questa regola, il costo per affrontare un problema di qualità dei dati al punto di ingresso è circa 1 volta il costo originale. Se il problema non viene rilevato e si propaga all’interno del sistema, il costo aumenta fino a circa 10 volte, comportando interventi di correzione e risoluzione. Tuttavia, se la scarsa qualità dei dati raggiunge l’utente finale o la fase decisionale, i costi possono salire vertiginosamente fino a 100 volte la spesa iniziale a causa di conseguenze aziendali significative, tra cui interruzioni operative, perdita di opportunità e insoddisfazione dei clienti. Questa regola sottolinea l’impatto esponenziale della cattiva qualità dei dati, rendendo fondamentale per le organizzazioni investire nell’osservabilità dei dati, che aiuta a mantenere i problemi, se si verificano, più vicini alla causa principale rispetto a quelli a valle.

Conclusione

I problemi relativi alla qualità dei dati hanno un impatto significativo sulle aziende, determinando uno spreco di risorse e opportunità mancate. Investire nell’osservabilità dei dati è essenziale per prevenire e mitigare i rischi associati a dati errati. Sfruttando metriche quantificabili e considerando fattori non quantificabili, le organizzazioni possono misurare il ROI dell'osservabilità dei dati e dimostrarne il valore ai decisori. Garantire la fiducia dei dati, promuovere un processo decisionale efficace nel dominio, rispettare le normative e promuovere un team di dati soddisfatto sono tutti aspetti critici per massimizzare i vantaggi delle iniziative di qualità dei dati. Abbracciare l’osservabilità dei dati è un investimento strategico che salvaguarda l’accuratezza, l’affidabilità e l’utilizzo dei dati nel mondo odierno basato sui dati.

Le organizzazioni che sviluppano una pratica di osservabilità avanzata hanno maggiore visibilità nei loro ambienti interconnessi, il che si traduce in meno interruzioni, risoluzione più rapida dei problemi, maggiore fiducia nell'affidabilità delle loro app e, in definitiva, più entrate e clienti più soddisfatti.

- Distribuzione di contenuti basati su SEO e PR. Ricevi amplificazione oggi.

- PlatoData.Network Generativo verticale Ai. Potenzia te stesso. Accedi qui.

- PlatoAiStream. Intelligenza Web3. Conoscenza amplificata. Accedi qui.

- PlatoneESG. Carbonio, Tecnologia pulita, Energia, Ambiente, Solare, Gestione dei rifiuti. Accedi qui.

- Platone Salute. Intelligence sulle biotecnologie e sulle sperimentazioni cliniche. Accedi qui.

- Fonte: https://www.dataversity.net/putting-a-number-on-bad-data/

- :ha

- :È

- :non

- :Dove

- $ SU

- 000

- 1

- 100x

- 2016

- 2022

- 9

- a

- capacità

- Chi siamo

- sopra

- ospitare

- Secondo

- conti

- Accumulato

- precisione

- preciso

- il raggiungimento

- riconoscere

- Ad

- aggiunta

- indirizzamento

- agenzia

- Ages

- ARIA

- Compagnie Aeree

- Tutti

- consentire

- Consentire

- consente

- anche

- an

- analista

- analitica

- ed

- circa

- architettura

- SONO

- RISERVATA

- sorgere

- in giro

- AS

- aspetti

- valutare

- valutazione

- associato

- At

- attenzione

- disponibile

- media

- consapevole

- Vasca

- dati errati

- Linea di base

- base

- battaglie

- BE

- diventare

- diventa

- diventando

- essendo

- sotto

- vantaggi

- Meglio

- fra

- maggiore

- Miliardo

- entrambi

- Portare

- Rotto

- costruire

- Costruzione

- onere

- affari

- Dirigenti d'impresa

- operazioni affaristiche

- le prestazioni di business

- aziende

- ma

- by

- Materiale

- annullato

- berretto

- Custodie

- casi

- lotta

- Causare

- ha causato

- causando

- centralizzata

- impegnativo

- possibilità

- classificazione

- classificare

- più vicino

- CO

- viene

- comunicare

- Aziende

- azienda

- Società

- complessità

- conformità

- fiducia

- conseguenza

- Conseguenze

- considerando

- costante

- Consumatori

- correggere

- Costo

- costoso

- Costi

- potuto

- controproducente

- coperto

- Credibilità

- credito

- critico

- criticità

- cruciale

- Cultura

- cliente

- Clienti

- alle lezioni

- danno

- Pericoloso

- cruscotto

- cruscotti

- dati

- Piattaforma dati

- Preparazione dei dati

- privacy dei dati

- qualità dei dati

- scienza dei dati

- data-driven

- Banca Dati

- VERSITÀ DEI DATI

- Giorni

- trattare

- decentrata

- Decision Making

- decisori

- dimostrare

- dipartimenti

- Dipendente

- individuare

- rilevato

- rivelazione

- difficile

- digitale

- dirette

- Rottura

- interruzioni

- documento

- documentazione

- dominio

- giù

- scolare

- guidare

- dovuto

- facilmente

- Efficace

- in maniera efficace

- sforzo

- sforzi

- abbracciando

- sottolinea

- Dipendente

- garantire

- assicurando

- iscrizione

- Ambiente

- ambienti

- Equifax

- errori

- intensificazione

- essential

- stimato

- stime

- eccetera

- Etere (ETH)

- la valutazione

- Evento

- Ogni

- evoluzione

- esempio

- eccessivo

- le aspettative

- esperienza

- esplora

- esponenziale

- esterno

- esternamente

- fatto

- Fattori

- più veloce

- preferito

- meno

- finanziario

- Trovare

- fine

- Nome

- cinque

- Voli

- segue

- Nel

- Forbes

- forzato

- promozione

- Contesto

- Frequenza

- da

- anteriore

- frustrato

- Inoltre

- Guadagno

- Gartner

- GDPR

- Dare

- Go

- va

- buono

- maggiore

- molto

- Crescita

- Crescita

- ha avuto

- accade

- più felice

- Hard

- Avere

- Salute e benessere

- Cuore

- aiuta

- Alta

- ostacolare

- olistica

- Come

- Tuttavia

- HTML

- HTTPS

- Enorme

- centinaia

- Male

- IBRIDO

- i

- idea

- identificare

- if

- Impact

- impatto

- realizzare

- implementazione

- Implementazione

- implicazioni

- importante

- imporre

- miglioramento

- in

- In altre

- impreciso

- incidente

- incidenti

- Compreso

- Aumenta

- industrie

- industria

- influenzato

- informazioni

- intrinsecamente

- inizialmente

- iniziative

- Innovazione

- strumentale

- integrale

- internamente

- ai miglioramenti

- Investire

- investire

- investimento

- coinvolgendo

- Irlanda

- problema

- sicurezza

- IT

- SUO

- Mettere a repentaglio

- Lavoro

- ad appena

- mantenere

- Le

- Sapere

- Conoscere

- paesaggio

- grandi

- portare

- leader

- capi

- principale

- a sinistra

- Legale

- istituti di credito

- meno

- leveraging

- ciclo di vita

- piace

- probabile

- connesso

- registrazione

- Guarda

- cerca

- a

- spento

- perdite

- perso

- LP

- mantenere

- FA

- Fare

- gestione

- Rappresentanza

- Market Cap

- MERCATO

- alunni

- Massimizzare

- massimizzando

- Maggio..

- si intende

- misurare

- analisi

- Soddisfare

- menzione

- metrico

- Metrica

- milione

- minore

- maltrattamento

- perse

- Ridurre la perdita dienergia con una

- modello

- moderno

- Monitorare

- monitoraggio

- Scopri di più

- Inoltre

- maggior parte

- my

- di applicazione

- esigenze

- negativamente

- Netflix

- New

- GENERAZIONE

- numero

- Obiettivi d'Esame

- verificarsi

- evento

- of

- di frequente

- on

- una volta

- ONE

- esclusivamente

- operativa

- Operazioni

- Opinione

- Opportunità

- or

- minimo

- organizzazione

- organizzazioni

- i

- Altro

- Altri

- interruzioni

- al di fuori

- ancora

- complessivo

- supremo

- parte

- per

- performance

- cronologia

- dati personali

- pianificazione

- piattaforma

- Platone

- Platone Data Intelligence

- PlatoneDati

- punto

- in bilico

- povero

- potenzialmente

- pratica

- pratiche

- preparazione

- prevenire

- precedente

- principio

- prioritizzazione

- Privacy

- Problema

- problemi

- Prodotto

- Produzione

- della produttività

- Prodotti

- promuovere

- corretto

- offre

- protegge

- pubblicamente

- scopo

- qualità

- quantificabile

- rapidamente

- tasso

- piuttosto

- raggiunge

- prontezza

- veramente

- recentemente

- riconosciuto

- ridurre

- Ridotto

- riducendo

- riguadagnare

- normativa

- problemi di

- fare affidamento

- ripetuto

- Segnalati

- Reportistica

- Risoluzione

- risolvere

- Risorse

- responsabilità

- responsabile

- colpevole

- ritorno

- Le vendite

- Ricco

- destra

- Rischio

- rischi

- robustezza

- ROI

- radice

- Regola

- garanzie

- stesso

- soddisfazione

- soddisfatte

- Scalabilità

- Scala

- Scienze

- scienziati

- punteggi

- inviare

- senso

- delicata

- grave

- servire

- servito

- server

- servizio

- alcuni

- gravità

- nave

- dovrebbero

- significato

- significativa

- significativamente

- in silenzio

- Allo stesso modo

- Taglia

- d'altissimo profilo

- soluzione

- alcuni

- qualcosa

- Reperimento

- Spendere

- esaurito

- Stage

- barcollante

- stakeholder

- inizia a

- Di partenza

- ha dichiarato

- Passi

- Strategico

- INVESTIMENTO STRATEGICO

- strategie

- flussi

- forte

- Lotte

- il successo

- tale

- supporto

- sistema

- prende

- task

- team

- le squadre

- tecniche

- dire

- di

- che

- I

- loro

- Li

- Là.

- perciò

- di

- questo

- migliaia

- minacce

- Attraverso

- per tutto

- tempo

- a

- di oggi

- ha preso

- strumenti

- verso

- Tracciato

- pista

- negoziate

- tradizionale

- traffico

- tradurre

- Viaggiatori

- trattare

- veramente

- Affidati ad

- turnover

- Digitare

- Regno Unito

- in definitiva

- sotto

- sottolineature

- capire

- e una comprensione reciproca

- inosservato

- unità

- uptime

- uso

- utilizzato

- Prezioso

- APPREZZIAMO

- vario

- molto

- Visualizza

- visti

- visibilità

- volatile

- volumi

- vs

- Vulnerabile

- volere

- sprecato

- modi

- we

- Settimane

- sono stati

- Che

- quando

- quale

- while

- OMS

- perché

- ampiamente

- volere

- con

- entro

- senza

- parole

- Lavora

- lavorato

- mondo

- valore

- sarebbe

- WSJ

- anno

- Tu

- Trasferimento da aeroporto a Sharm

- zefiro