Ho parlato di recente con Stelios Diamantidis (Distinguished Architect, Head of Strategy, Autonomous Design Solutions) dell'annuncio di Synopsys sul 100th tapeout del cliente utilizzando la soluzione DSO.ai. La mia preoccupazione per gli articoli relativi all’intelligenza artificiale è quella di evitare l’hype che circonda l’intelligenza artificiale in generale, e viceversa lo scetticismo in reazione a quell’hype che spinge alcuni a respingere tutte le affermazioni sull’intelligenza artificiale come olio di serpente. Sono stato felice di sentire Stelios ridere e concordare con tutto il cuore. Abbiamo avuto una discussione molto approfondita su cosa può fare DSO.ai oggi, cosa vedono nella soluzione i loro clienti di riferimento (in base a cosa può fare oggi) e cosa potrebbe dirmi sulla tecnologia.

Cosa fa DSO.ai

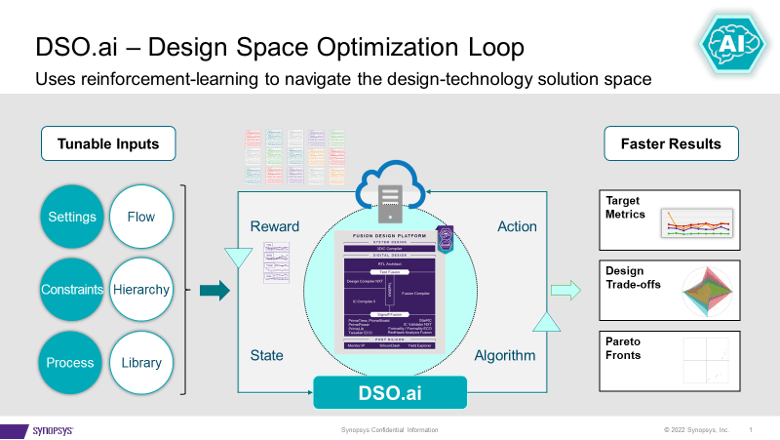

DSO.ai si accoppia con Fusion Compiler e IC Compiler II, il che, come Stelios ha voluto sottolineare, significa che si tratta di una soluzione di ottimizzazione a livello di blocco; I SoC completi non sono ancora un obiettivo. Ciò si adatta alle attuali pratiche di progettazione poiché Stelios ha affermato che un obiettivo importante è adattarsi facilmente ai flussi esistenti. Lo scopo della tecnologia è consentire agli ingegneri dell'implementazione, spesso un singolo ingegnere, di migliorare la propria produttività esplorando al tempo stesso uno spazio di progettazione più ampio per un PPA migliore di quanto sarebbe stato possibile individuare altrimenti.

Synopsys ha annunciato il primo tapeout nell'estate del 2021 e ora ha annunciato 100 tapeout. Ciò parla bene della richiesta e dell’efficacia di una soluzione come questa. Stelios ha aggiunto che il valore diventa ancora più evidente per le applicazioni che devono istanziare un blocco più volte. Pensa a un server multi-core, una GPU o uno switch di rete. Ottimizza un blocco una volta, crea un'istanza molte volte: ciò può comportare un significativo miglioramento del PPA.

Ho chiesto se i clienti che lo fanno lavorano tutti a 7 nm e sotto. Sorprendentemente, c'è un uso attivo fino a 40 nm. Un esempio interessante è un controller flash, un progetto che non è molto sensibile alle prestazioni ma può funzionare da decine a centinaia di milioni di unità. Ridurre le dimensioni anche del 5% in questo caso può avere un grande impatto sui margini.

Cosa c'è sotto il cofano

DSO.ai si basa sull'apprendimento per rinforzo, un argomento caldo di questi tempi ma in questo articolo non ho promesso alcun clamore. Ho chiesto a Stelios di approfondire un po' di più, anche se non sono rimasto sorpreso quando ha detto che non poteva rivelare troppo. Ciò che poteva dirmi era abbastanza interessante. Ha sottolineato che in applicazioni più generali, un ciclo attraverso un set di addestramento (un'epoca) presuppone un metodo veloce (da secondi a minuti) per valutare i successivi possibili passaggi, ad esempio attraverso confronti di gradienti.

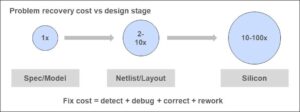

Ma la progettazione di blocchi seri non può essere ottimizzata con stime rapide. Ogni prova deve percorrere l'intero flusso di produzione, mappando i processi di produzione reali. Flussi che possono richiedere ore per essere eseguiti. Parte della strategia per un apprendimento di rinforzo efficace dato questo vincolo è il parallelismo. Il resto è la salsa segreta di DSO.ai. Certamente si può immaginare che se quella salsa segreta può produrre perfezionamenti efficaci basati su una data epoca, allora il parallelismo accelererà il progresso attraverso l’epoca successiva.

A tal fine, questa funzionalità deve davvero essere eseguita in un cloud per supportare il parallelismo. Il cloud privato locale è un'opzione. Microsoft ha annunciato che ospiterà DSO.ai su Azure e la ST riferisce nel comunicato stampa DSO.ai di aver utilizzato questa funzionalità per ottimizzare l'implementazione di un core Arm. Immagino che potrebbero esserci alcuni dibattiti interessanti sui pro e contro dell'esecuzione di un'ottimizzazione in un cloud pubblico su circa 1000 server se ne vale la pena.

Opinioni dei clienti

Synopsys afferma che i clienti (tra cui ST e SK Hynix in questo annuncio) stanno segnalando aumenti di produttività oltre 3 volte, una potenza totale inferiore fino al 25% e una significativa riduzione delle dimensioni dello stampo, il tutto con un utilizzo ridotto delle risorse complessive. Considerando quanto descritto da Stelios, mi sembra ragionevole. Lo strumento consente l'esplorazione di più punti nello spazio degli stati di progettazione all'interno di un determinato programma rispetto a quanto sarebbe possibile se tale esplorazione fosse manuale. Finché l’algoritmo di ricerca (la salsa segreta) è efficace, ovviamente troverebbe un risultato ottimale migliore rispetto a una ricerca manuale.

In breve, né campagna pubblicitaria sull’IA né olio di serpente. DSO.ai suggerisce che l’intelligenza artificiale sta diventando mainstream come un’estensione ingegneristica credibile dei flussi esistenti. Puoi imparare di più da comunicato stampa e di questo blog.

Condividi questo post tramite:

- Distribuzione di contenuti basati su SEO e PR. Ricevi amplificazione oggi.

- Platoblockchain. Web3 Metaverse Intelligence. Conoscenza amplificata. Accedi qui.

- Fonte: https://semiwiki.com/artificial-intelligence/324430-synopsys-design-space-optimization-hits-a-milestone/

- 100

- 2021

- a

- Chi siamo

- accelerare

- operanti in

- attivo

- aggiunto

- AI

- algoritmo

- Tutti

- consente

- ed

- ha annunciato

- Annuncio

- applicazioni

- RISERVATA

- ARM

- in giro

- articolo

- news

- autonomo

- evitando

- azzurro

- basato

- diventa

- sotto

- Meglio

- Big

- Po

- Bloccare

- attento

- certamente

- Cloud

- Venire

- Problemi della Pelle

- Svantaggi

- controllore

- Nucleo

- potuto

- corso

- credibile

- Corrente

- cliente

- Clienti

- ciclo

- Giorni

- dibattiti

- Richiesta

- descritta

- Design

- *

- discussione

- Nascondi

- Distinto

- fare

- giù

- ogni

- facilmente

- Efficace

- efficacia

- enfatizzare

- enable

- ingegnere

- Ingegneria

- Ingegneri

- abbastanza

- epoca

- stime

- Anche

- esempio

- esistente

- esplorazione

- Esplorare

- estensione

- FAST

- Trovare

- Nome

- in forma

- Cromatografia

- flusso

- flussi

- da

- pieno

- fusione

- Generale

- dato

- scopo

- GPU

- contento

- capo

- qui

- Visualizzazioni

- di hosting

- HOT

- ORE

- HTTPS

- Montatura

- Impact

- implementazione

- importante

- competenze

- miglioramento

- in

- Compreso

- Aumenta

- interessante

- IT

- superiore, se assunto singolarmente.

- ridere

- IMPARARE

- apprendimento

- Lunghi

- fatto

- corrente principale

- Manuale

- consigliato per la

- molti

- mappatura

- margini

- max-width

- si intende

- metodo

- Microsoft

- forza

- pietra miliare

- milione

- verbale

- Scopri di più

- Nessuno dei due

- Rete

- GENERAZIONE

- ovvio

- Olio

- ONE

- ottimizzazione

- OTTIMIZZA

- ottimizzati

- ottimale

- Opzione

- altrimenti

- complessivo

- parte

- performance

- Platone

- Platone Data Intelligence

- PlatoneDati

- punto

- punti

- possibile

- Post

- energia

- pratiche

- stampa

- Comunicati Stampa

- un bagno

- i processi

- Produzione

- della produttività

- Progressi

- promesso

- PROS

- la percezione

- cloud pubblico

- scopo

- Presto

- reazione

- di rose

- ragionevole

- recentemente

- Ridotto

- riducendo

- insegnamento rafforzativo

- rilasciare

- rapporto

- Reportistica

- Risorse

- REST

- rivelare

- Correre

- running

- Suddetto

- programma

- Cerca

- secondo

- Segreto

- delicata

- grave

- set

- Corti

- significativa

- singolo

- Taglia

- Scetticismo

- soluzione

- Soluzioni

- alcuni

- lo spazio

- Parla

- Regione / Stato

- Passi

- Strategia

- suggerisce

- estate

- supporto

- sorpreso

- Interruttore

- Fai

- Target

- Tecnologia

- I

- L'area

- loro

- Attraverso

- volte

- a

- oggi

- pure

- argomento

- Totale

- Training

- prova

- per

- unità

- uso

- APPREZZIAMO

- via

- Che

- quale

- while

- volere

- entro

- lavoro

- valore

- sarebbe

- zefiro