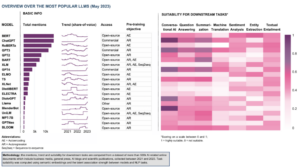

Nel campo in rapida evoluzione dell'intelligenza artificiale, l'elaborazione del linguaggio naturale è diventata un punto focale sia per i ricercatori che per gli sviluppatori. Costruire sulle fondamenta di Architettura del trasformatore ed L'aggiornamento bidirezionale di BERT, negli ultimi anni sono emersi diversi modelli linguistici rivoluzionari, che spingono i confini di ciò che le macchine possono comprendere e generare.

In questo articolo, approfondiremo gli ultimi progressi nel mondo dei modelli linguistici su larga scala, esplorando i miglioramenti introdotti da ciascun modello, le loro capacità e le potenziali applicazioni. Esamineremo anche i Visual Langauge Models (VLM) che sono addestrati per elaborare non solo dati testuali ma anche visivi.

Se desideri saltare, ecco i modelli linguistici che abbiamo presentato:

- GPT-3 di OpenAI

- LaMDA di Google

- PaLM di Google

- Fenicottero di DeepMind

- BLIP-2 di Salesforce

- LLaMA di Meta AI

- GPT-4 di OpenAI

Se questo contenuto educativo approfondito è utile per te, puoi farlo iscriviti alla nostra mailing list di ricerca sull'IA per essere avvisato quando rilasciamo nuovo materiale.

I più importanti Large Language Model (LLM) e Visual Language Model (VLM) nel 2023

1. GPT-3 di OpenAI

Sommario

Il team di OpenAI ha introdotto GPT-3 come alternativa all'avere un set di dati etichettato per ogni nuova attività linguistica. Hanno suggerito che il ridimensionamento dei modelli linguistici può migliorare le prestazioni di pochi colpi indipendenti dalle attività. Per testare questo suggerimento, hanno addestrato un modello di linguaggio autoregressivo di 175 parametri B, chiamato GPT-3e ne ha valutato le prestazioni su oltre due dozzine di attività di PNL. La valutazione con l'apprendimento a colpo singolo, l'apprendimento a colpo singolo e l'apprendimento a colpo zero ha dimostrato che GPT-3 ha ottenuto risultati promettenti e anche occasionalmente ha superato i risultati all'avanguardia raggiunti da modelli ottimizzati.

Qual è l'obiettivo?

- Suggerire una soluzione alternativa al problema esistente, quando è necessario un set di dati etichettato per ogni nuova attività linguistica.

Come si affronta il problema?

- I ricercatori hanno suggerito di aumentare i modelli linguistici per migliorare le prestazioni di pochi colpi indipendenti dalle attività.

- Il GPT-3 Il modello utilizza lo stesso modello e la stessa architettura di GPT-2, inclusa l'inizializzazione modificata, la pre-normalizzazione e la tokenizzazione reversibile.

- Tuttavia, in contrasto con GPT-2, utilizza schemi di attenzione sparsi alternati densi e localmente fasciati negli strati del trasformatore, come nel Trasformatore sparse.

Quali sono i risultati?

- Il modello GPT-3 senza messa a punto raggiunge risultati promettenti su una serie di compiti di PNL e talvolta supera anche i modelli all'avanguardia che sono stati messi a punto per quel compito specifico:

- Sulla CoQA benchmark, 81.5 F1 nell'impostazione zero-shot, 84.0 F1 nell'impostazione one-shot e 85.0 F1 nell'impostazione pochi-shot, rispetto al punteggio di 90.7 F1 ottenuto dal SOTA ottimizzato.

- Sulla CuriositàQA benchmark, 64.3% di precisione nell'impostazione zero-shot, 68.0% nell'impostazione one-shot e 71.2% nell'impostazione pochi-shot, superando lo stato dell'arte (68%) del 3.2%.

- Sulla LAMBADA set di dati, 76.2% di precisione nell'impostazione zero-shot, 72.5% nell'impostazione one-shot e 86.4% nell'impostazione pochi-shot, superando lo stato dell'arte (68%) del 18%.

- Gli articoli di notizie generati dal modello GPT-175 con parametri 3B sono difficili da distinguere da quelli reali, secondo le valutazioni umane (con un'accuratezza appena superiore al livello di probabilità a ~ 52%).

- Nonostante le notevoli prestazioni di GPT-3, ha ottenuto recensioni contrastanti dalla comunità AI:

- "L'hype GPT-3 è troppo. È impressionante (grazie per i bei complimenti!) Ma ha ancora dei seri punti deboli e talvolta commette errori molto sciocchi. L'intelligenza artificiale cambierà il mondo, ma GPT-3 è solo un primo assaggio. Abbiamo ancora molto da scoprire ". - Sam Altman, CEO e co-fondatore di OpenAI.

- "Sono scioccato da quanto sia difficile generare testo sui musulmani da GPT-3 che non ha nulla a che fare con la violenza ... o essere uccisi ..." - Abubakar Abid, CEO e fondatore di Gradio.

- "No. GPT-3 fondamentalmente non capisce il mondo di cui parla. Aumentare ulteriormente il corpus consentirà di generare un pastiche più credibile ma non di correggere la sua fondamentale mancanza di comprensione del mondo. Le demo di GPT-4 richiederanno ancora una selezione umana ". - Gary Marcus, CEO e fondatore di Robust.ai.

- "Estrapolare le prestazioni spettacolari di GPT3 nel futuro suggerisce che la risposta alla vita, all'universo ea tutto ciò è solo 4.398 trilioni di parametri". - Geoffrey Hinton, vincitore del Turing Award.

Dove saperne di più su questa ricerca?

Dove puoi ottenere il codice di implementazione?

- Il codice stesso non è disponibile, ma alcune statistiche del set di dati insieme a campioni di token 2048 incondizionati e non filtrati da GPT-3 vengono rilasciati su GitHub.

2. LaMDA di Google

Sommario

Lalingua Mmodelli per Ddialogo Aapplicazioni (LAMDA) sono stati creati attraverso il processo di messa a punto di un gruppo di modelli di linguaggio neurale basati su Transformer progettati specificamente per i dialoghi. Questi modelli hanno un massimo di 137B parametri e sono stati addestrati per utilizzare fonti di conoscenza esterne. Gli sviluppatori di LaMDA avevano in mente tre obiettivi chiave: qualità, sicurezza e solidità. I risultati hanno dimostrato che la messa a punto consente di ridurre il divario di qualità rispetto ai livelli umani, ma le prestazioni del modello sono rimaste al di sotto dei livelli umani rispetto alla sicurezza e alla messa a terra.

Bardo di Google, rilasciato recentemente in alternativa a ChatGPT, è alimentato da LaMDA. Nonostante Bard sia spesso etichettato come noioso, potrebbe essere visto come una prova dell'impegno di Google a dare priorità alla sicurezza, anche in mezzo all'intensa rivalità tra Google e Microsoft per stabilire il dominio nel campo dell'IA generativa.

Qual è l'obiettivo?

- Costruire un modello per applicazioni di dialogo a dominio aperto, in cui un agente di dialogo è in grado di conversare su qualsiasi argomento con risposte sensate, specifiche per il contesto, fondate su fonti affidabili ed etiche.

Come si affronta il problema?

- LaMDA è costruito su trasformatore, un'architettura di rete neurale che Google Research ha inventato e reso open source nel 2017.

- Come altri modelli di linguaggio di grandi dimensioni, tra cui BERT e GPT-3, LaMDA viene addestrato su terabyte di dati di testo per apprendere come le parole si relazionano tra loro e quindi prevedere quali parole probabilmente verranno dopo.

- Tuttavia, a differenza della maggior parte dei modelli linguistici, LaMDA è stato addestrato al dialogo per cogliere le sfumature che distinguono la conversazione aperta da altre forme di linguaggio.

- Il modello è inoltre messo a punto per migliorare la sensibilità, la sicurezza e la specificità delle sue risposte. Mentre frasi come "è carino" e "non lo so" possono essere significative in molti scenari di dialogo, è improbabile che conducano a conversazioni interessanti e coinvolgenti.

- Il generatore LaMDA genera innanzitutto diverse risposte candidate, che vengono tutte valutate in base a quanto sono sicure, sensate, specifiche e interessanti. Le risposte con punteggi di sicurezza bassi vengono filtrate e quindi il risultato con il punteggio più alto viene selezionato come risposta.

Quali sono i risultati?

- Numerosi esperimenti dimostrano che LaMDA può partecipare a conversazioni aperte su una varietà di argomenti.

- Una serie di valutazioni qualitative ha confermato che le risposte del modello tendono ad essere sensate, specifiche, interessanti e fondate su fonti esterne affidabili, ma c'è ancora spazio per miglioramenti.

- Nonostante tutti i progressi compiuti finora, gli autori riconoscono che il modello ha ancora molti limiti che possono comportare la generazione di risposte inappropriate o addirittura dannose.

Dove saperne di più su questa ricerca?

Dove puoi ottenere il codice di implementazione?

- Un'implementazione PyTorch open source per l'architettura di pre-formazione di LaMDA è disponibile su GitHub.

3. PaLM di Google

Sommario

Pacomunque Language Model (Palma) è un parametro di 540 miliardi, modello di linguaggio basato su Transformer. PaLM è stato addestrato su chip 6144 TPU v4 utilizzando Pathways, un nuovo sistema ML per un addestramento efficiente su più pod TPU. Il modello dimostra i vantaggi del ridimensionamento nell'apprendimento a pochi colpi, ottenendo risultati all'avanguardia su centinaia di benchmark di generazione e comprensione della lingua. PaLM supera le prestazioni dei modelli all'avanguardia ottimizzati nelle attività di ragionamento in più passaggi e supera le prestazioni umane medie nel benchmark BIG-bench.

Qual è l'obiettivo?

- Migliorare la comprensione di come il ridimensionamento di modelli linguistici di grandi dimensioni influisca sull'apprendimento a pochi colpi.

Come si affronta il problema?

- L'idea chiave è scalare l'addestramento di un modello linguistico di 540 miliardi di parametri con il sistema Pathways:

- Il team stava utilizzando il parallelismo dei dati a livello di pod su due pod Cloud TPU v4 utilizzando i dati standard e il parallelismo del modello all'interno di ciascun pod.

- Sono stati in grado di scalare la formazione a 6144 chip TPU v4, la più grande configurazione di sistema basata su TPU utilizzata per la formazione fino ad oggi.

- Il modello ha raggiunto un'efficienza di addestramento del 57.8% di utilizzo dei FLOP hardware, che, come affermano gli autori, è l'efficienza di addestramento più alta mai raggiunta per modelli linguistici di grandi dimensioni su questa scala.

- I dati di addestramento per il modello PaLM includevano una combinazione di set di dati in inglese e multilingue contenenti documenti Web, libri, Wikipedia, conversazioni e codice GitHub di alta qualità.

Quali sono i risultati?

- Numerosi esperimenti dimostrano che le prestazioni del modello sono aumentate notevolmente man mano che il team è passato al modello più grande.

- PaLM 540B ha ottenuto prestazioni rivoluzionarie su più compiti molto difficili:

- Comprensione e generazione del linguaggio. Il modello introdotto ha superato le prestazioni di pochi scatti dei precedenti modelli di grandi dimensioni in 28 attività su 29 che includono attività di risposta alle domande, attività di cloze e completamento di frasi, attività di comprensione della lettura nel contesto, attività di ragionamento di buon senso, attività SuperGLUE e Di più. Le prestazioni di PaLM sui compiti BIG-bench hanno mostrato che poteva distinguere causa ed effetto, oltre a comprendere combinazioni concettuali in contesti appropriati.

- Ragionamento. Con 8-shot prompt, PaLM risolve il 58% dei problemi in GSM8K, un benchmark di migliaia di impegnative domande di matematica a livello di scuola elementare, superando il punteggio massimo precedente del 55% ottenuto dalla messa a punto del modello GPT-3 175B. PaLM dimostra anche la capacità di generare spiegazioni esplicite in situazioni che richiedono una complessa combinazione di inferenza logica multi-step, conoscenza del mondo e profonda comprensione del linguaggio.

- Generazione del codice. PaLM funziona alla pari con il perfezionato Codex 12B utilizzando 50 volte meno codice Python per l'addestramento, confermando che i modelli linguistici di grandi dimensioni trasferiscono l'apprendimento sia da altri linguaggi di programmazione che dai dati del linguaggio naturale in modo più efficace.

Dove saperne di più su questa ricerca?

Dove puoi ottenere il codice di implementazione?

- Un'implementazione PyTorch non ufficiale dell'architettura Transformer specifica dal documento di ricerca PaLM è disponibile su GitHub. Non verrà ridimensionato ed è pubblicato solo a scopo didattico.

4. Fenicottero di DeepMind

Sommario

Flamingo è una famiglia all'avanguardia di Visual Language Models (VLM), formati su corpora web multimodali su larga scala con testo e immagini misti. Con questa formazione, i modelli possono adattarsi a nuove attività utilizzando esempi annotati minimi, forniti come prompt. Flamingo incorpora i principali progressi dell'architettura progettati per unire i punti di forza di modelli pre-addestrati solo per la visione e solo per il linguaggio, elaborare sequenze di dati visivi e testuali interlacciati in modo variabile e accogliere immagini o video come input senza soluzione di continuità. I modelli dimostrano un'impressionante adattabilità a una gamma di attività di immagini e video come la risposta visiva alle domande, le attività di didascalia e la risposta visiva alle domande a scelta multipla, stabilendo nuovi standard di prestazioni utilizzando suggerimenti specifici per l'attività nell'apprendimento a pochi colpi.

Qual è l'obiettivo?

- Per compiere progressi verso l'abilitazione dei modelli multimodali ad apprendere ed eseguire rapidamente nuove attività sulla base di brevi istruzioni:

- Il paradigma ampiamente utilizzato di pre-addestramento di un modello su una grande quantità di dati supervisionati, quindi perfezionandolo per l'attività specifica, richiede molte risorse e richiede migliaia di punti dati annotati insieme a un'attenta messa a punto dell'iperparametro per attività.

- I modelli attuali che utilizzano un obiettivo contrastivo consentono un adattamento a colpo zero a nuove attività, ma non sono all'altezza di attività più aperte come i sottotitoli o la risposta visiva alle domande perché mancano di capacità di generazione del linguaggio.

- Questa ricerca mira a introdurre un nuovo modello che affronti efficacemente questi problemi e dimostri prestazioni superiori in regimi con pochi dati.

Come si affronta il problema?

- DeepMind ha introdotto Flamingo, VLM progettati per l'apprendimento in pochi colpi su varie attività visive e linguistiche a tempo indeterminato, utilizzando solo pochi esempi di input/output.

- I modelli Flamingo sono modelli di generazione di testo autoregressivi condizionati visivamente in grado di elaborare token di testo mescolati con immagini e/o video e generare testo come output.

- L'architettura di Flamingo incorpora due modelli complementari pre-addestrati e congelati:

- Un modello di visione capace di “percepire” scene visive.

- Un modello di linguaggio di grandi dimensioni incaricato di eseguire il ragionamento di base.

- I nuovi componenti dell'architettura integrano questi modelli in modo da conservare le conoscenze acquisite durante il loro pre-addestramento ad alta intensità di calcolo.

- Inoltre, i modelli Flamingo presentano un'architettura basata su Perceiver, che consente loro di importare immagini o video ad alta risoluzione. Questa architettura può generare un numero fisso di token visivi per immagine/video da una gamma ampia e variabile di funzioni di input visivo.

Quali sono i risultati?

- La ricerca mostra che, analogamente agli LLM, che sono bravi studenti di pochi colpi, i VLM possono imparare da alcuni esempi di input/output per attività di comprensione di immagini e video come classificazione, didascalia o risposta a domande.

- Flamingo stabilisce un nuovo punto di riferimento nell'apprendimento di pochi scatti, dimostrando prestazioni superiori su un'ampia gamma di 16 compiti multimodali di linguaggio e comprensione di immagini/video.

- Per 6 di queste 16 attività, Flamingo supera le prestazioni dello stato dell'arte ottimizzato, anche se utilizza solo 32 esempi specifici dell'attività - circa 1000 volte meno dati di addestramento specifici dell'attività rispetto agli attuali modelli con le migliori prestazioni.

Dove saperne di più su questa ricerca?

Dove puoi ottenere il codice di implementazione?

- DeepMind non ha rilasciato l'implementazione ufficiale di Flamingo.

- È possibile trovare l'implementazione open source dell'approccio introdotto nel file Repository Github di OpenFlamingo.

- È disponibile l'implementazione PyTorch alternativa qui.

5. BLIP-2 di Salesforce

Sommario

BLIP-2 è un framework di pre-addestramento efficiente e generico per modelli di visione e linguaggio, progettato per aggirare il costo sempre più proibitivo dei modelli su larga scala di pre-addestramento. BLIP-2 sfrutta codificatori di immagini pre-addestrati congelati disponibili in commercio e modelli di linguaggio di grandi dimensioni congelati per avviare il pre-addestramento del linguaggio visivo, incorporando un trasformatore di query leggero pre-addestrato in due fasi. La prima fase avvia l'apprendimento della rappresentazione del linguaggio visivo da un codificatore di immagini congelate e la seconda fase spinge l'apprendimento generativo dalla visione al linguaggio da un modello linguistico congelato. Nonostante abbia un numero significativamente inferiore di parametri addestrabili, BLIP-2 supera i metodi all'avanguardia, superando Flamingo80B di DeepMind dell'8.7% su VQAv2 zero-shot con 54 volte meno parametri addestrabili. Il modello mostra anche promettenti capacità di generazione di immagini in testo a scatto zero seguendo le istruzioni del linguaggio naturale.

Qual è l'obiettivo?

- Per ottenere prestazioni all'avanguardia nelle attività di linguaggio visivo, riducendo al contempo i costi di calcolo.

Come si affronta il problema?

- Il team di Salesforce ha introdotto un nuovo framework di pre-formazione sul linguaggio visivo denominato BLIP-2, Bootstrapping Llingua-Imago Priqualificazione con modelli unimodali congelati:

- I modelli unimodali pre-addestrati rimangono congelati durante il pre-addestramento per ridurre i costi di calcolo ed evitare il problema dell'oblio catastrofico.

- Per facilitare l'allineamento intermodale e colmare il divario di modalità tra i modelli visivi pre-addestrati e i modelli linguistici pre-addestrati, il team propone un trasformatore di query leggero (Q-Former) che funge da collo di bottiglia delle informazioni tra il codificatore di immagini congelate e il codificatore di immagini congelate LLM.

- Q-former è pre-addestrato con una nuova strategia in due fasi:

- La prima fase di pre-formazione prevede l'apprendimento della rappresentazione del linguaggio visivo. Ciò impone al Q-Former di apprendere la rappresentazione visiva più rilevante per il testo.

- La seconda fase di pre-formazione esegue l'apprendimento generativo dalla visione al linguaggio collegando l'output del Q-Former a un LLM congelato. Il Q-Former è addestrato in modo tale che la sua rappresentazione visiva in uscita possa essere interpretata dal LLM.

Quali sono i risultati?

- BLIP-2 offre risultati eccezionali e all'avanguardia in una varietà di attività di linguaggio visivo, che comprendono la risposta visiva alle domande, la didascalia delle immagini e il recupero del testo dell'immagine.

- Ad esempio, supera Flamingo dell'8.7% su VQAv2 zero-shot.

- Inoltre, queste eccezionali prestazioni si ottengono con un'efficienza del computer notevolmente superiore:

- BLIP-2 supera Flamingo-80B mentre utilizza 54 volte meno parametri addestrabili.

- BLIP-2 ha la capacità di intraprendere la generazione da immagine a testo zero-shot in risposta alle istruzioni del linguaggio naturale, aprendo così la strada allo sviluppo di abilità come il ragionamento della conoscenza visiva e la conversazione visiva, tra le altre.

- Infine, è importante notare che BLIP-2 è un approccio versatile che può sfruttare modelli unimodali più sofisticati per migliorare ulteriormente le prestazioni della pre-formazione del linguaggio visivo.

Dove saperne di più su questa ricerca?

Dove puoi ottenere il codice di implementazione?

L'implementazione ufficiale di BLIP-2 è disponibile su GitHub.

6. LLaMA di Meta AI

Sommario

Il team di Meta AI afferma che i modelli più piccoli addestrati su più token sono più facili da riaddestrare e mettere a punto per specifiche applicazioni di prodotto. Pertanto, introducono Lama (Large Lalingua Model Meta AI), una raccolta di modelli linguistici fondamentali con parametri da 7B a 65B. LLaMA 33B e 65B sono stati addestrati su 1.4 trilioni di token, mentre il modello più piccolo, LLaMA 7B, è stato addestrato su un trilione di token. Hanno utilizzato esclusivamente set di dati disponibili pubblicamente, senza dipendere da dati proprietari o riservati. Il team ha inoltre implementato importanti miglioramenti dell'architettura e tecniche di ottimizzazione della velocità di addestramento. Di conseguenza, LLaMA-13B ha superato GPT-3, essendo oltre 10 volte più piccolo, e LLaMA-65B ha mostrato prestazioni competitive con PaLM-540B.

Qual è l'obiettivo?

- Dimostrare la fattibilità dell'addestramento dei modelli con le migliori prestazioni esclusivamente su set di dati accessibili al pubblico, senza fare affidamento su fonti di dati proprietarie o limitate.

- Fornire alla comunità di ricerca modelli più piccoli e più performanti e, quindi, consentire a coloro che non hanno accesso a grandi quantità di infrastrutture, di studiare grandi modelli linguistici.

Come si affronta il problema?

- Per addestrare il modello LLaMA, i ricercatori hanno utilizzato solo dati disponibili pubblicamente e compatibili con l'open sourcing.

- Hanno anche introdotto alcuni miglioramenti all'architettura Transformer standard:

- Adottando la metodologia GPT-3, la stabilità dell'addestramento è stata migliorata normalizzando l'input per ciascun sottostrato del trasformatore, piuttosto che normalizzando l'output.

- Ispirati dai modelli PaLM, i ricercatori hanno sostituito la non linearità ReLU con la funzione di attivazione SwiGLU, per migliorare le prestazioni.

- Ispirato da Su e altri (2021), hanno eliminato gli incorporamenti posizionali assoluti e hanno invece incorporato incorporamenti posizionali rotanti (RoPE) a ogni livello della rete.

- Infine, il team di Meta AI ha migliorato la velocità di addestramento del proprio modello:

- Utilizzo di un'efficiente implementazione dell'attenzione multi-head causale non memorizzando i pesi dell'attenzione o calcolando i punteggi delle chiavi/query mascherati.

- Utilizzo del checkpoint per ridurre al minimo le attivazioni ricalcolate durante il passaggio all'indietro.

- Sovrapposizione del calcolo delle attivazioni e della comunicazione tra le GPU sulla rete (a causa delle operazioni all_reduce).

Quali sono i risultati?

- LLaMA-13B supera GPT-3 nonostante sia oltre 10 volte più piccolo, mentre LLaMA-65B tiene testa a PaLM-540B.

Dove saperne di più su questa ricerca?

Dove puoi ottenere il codice di implementazione?

- Meta AI fornisce l'accesso a LLaMA a ricercatori accademici, individui associati al governo, alla società civile, alle istituzioni accademiche e ai laboratori di ricerca del settore globale sulla base della valutazione di casi individuali. Per candidarsi, vai al seguente Repository GitHub.

7. GPT-4 di OpenAI

Sommario

GPT-4 è un modello multimodale su larga scala che accetta input di immagini e testo e genera output di testo. A causa di problemi di concorrenza e sicurezza, vengono nascosti dettagli specifici sull'architettura e sulla formazione del modello. In termini di prestazioni, GPT-4 supera i modelli linguistici precedenti sui benchmark tradizionali e mostra miglioramenti significativi nella comprensione delle intenzioni dell'utente e nelle proprietà di sicurezza. Il modello raggiunge anche prestazioni a livello umano in vari esami, incluso un punteggio massimo del 10% su un esame della barra uniforme simulato.

Qual è l'obiettivo?

- Sviluppare un modello multimodale su larga scala in grado di accettare input di immagini e testo e produrre output di testo.

- Sviluppare metodi di infrastruttura e ottimizzazione che si comportino in modo prevedibile su un'ampia gamma di scale.

Come si affronta il problema?

- A causa del panorama competitivo e delle implicazioni sulla sicurezza, OpenAI ha deciso di nascondere i dettagli su architettura, dimensioni del modello, hardware, calcolo di addestramento, costruzione di set di dati e metodi di addestramento.

- Rivelano che:

- GPT-4 è un modello basato su Transformer, preaddestrato per prevedere il token successivo in un documento.

- Utilizza dati pubblicamente disponibili e dati concessi in licenza da terze parti.

- Il modello è stato messo a punto utilizzando il Reinforcement Learning from Human Feedback (RLHF).

- Informazioni non confermate suggeriscono che GPT-4 non è un singolo modello denso come i suoi predecessori, ma una potente coalizione di otto modelli separati, ciascuno con l'incredibile cifra di 220 miliardi di parametri.

Quali sono i risultati?

- GPT-4 raggiunge prestazioni a livello umano nella maggior parte degli esami professionali e accademici, in particolare ottenendo un punteggio nel 10% superiore in un esame simulato della barra uniforme.

- Il modello GPT-4 di base pre-addestrato supera i modelli linguistici esistenti e i precedenti sistemi all'avanguardia sui tradizionali benchmark NLP, senza creazione di benchmark specifici o protocolli di formazione aggiuntivi.

- GPT-4 dimostra un sostanziale miglioramento nel seguire l'intento dell'utente, con le sue risposte preferite rispetto a quelle di GPT-3.5 nel 70.2% di 5,214 richieste di ChatGPT e dell'API OpenAI.

- Le proprietà di sicurezza di GPT-4 sono notevolmente migliorate rispetto a GPT-3.5, con una diminuzione dell'82% nella risposta alle richieste di contenuti non consentiti e un aumento del 29% nella conformità alle norme per le richieste sensibili (ad esempio, consulenza medica e autolesionismo).

Dove saperne di più su questa ricerca?

Dove puoi ottenere il codice di implementazione?

- L'implementazione del codice di GPT-4 non è disponibile.

Applicazioni nel mondo reale di modelli linguistici di grandi dimensioni (visione).

Le scoperte più significative della ricerca sull'IA degli ultimi anni provengono da grandi modelli di intelligenza artificiale addestrati su enormi set di dati. Questi modelli dimostrano prestazioni impressionanti ed è affascinante pensare a come l'IA possa rivoluzionare interi settori, come il servizio clienti, il marketing, l'e-commerce, l'assistenza sanitaria, lo sviluppo di software, il giornalismo e molti altri.

I modelli di linguaggio di grandi dimensioni hanno numerose applicazioni nel mondo reale. GPT-4 elenca quanto segue:

- Comprensione e generazione del linguaggio naturale per chatbot e assistenti virtuali.

- Traduzione automatica tra lingue.

- Riepilogo di articoli, relazioni o altri documenti di testo.

- Analisi del sentiment per ricerche di mercato o monitoraggio dei social media.

- Generazione di contenuti per marketing, social media o scrittura creativa.

- Sistemi di risposta alle domande per l'assistenza clienti o basi di conoscenza.

- Classificazione del testo per il filtro antispam, la categorizzazione degli argomenti o l'organizzazione dei documenti.

- Strumenti personalizzati per l'apprendimento delle lingue e il tutoraggio.

- Generazione di codice e assistenza allo sviluppo software.

- Analisi e assistenza di documenti medici, legali e tecnici.

- Strumenti di accessibilità per le persone con disabilità, come conversione da testo a voce e da discorso a testo.

- Servizi di riconoscimento vocale e trascrizione.

Se aggiungiamo una parte visiva, le aree di possibili applicazioni si espandono ulteriormente:

È molto eccitante seguire le recenti scoperte dell'IA e pensare alle loro potenziali applicazioni nel mondo reale. Tuttavia, prima di implementare questi modelli nella vita reale, dobbiamo affrontare i rischi e le limitazioni corrispondenti, che purtroppo sono piuttosto significativi.

Rischi e limitazioni

Se chiedi a GPT-4 i suoi rischi e limiti, probabilmente ti fornirà un lungo elenco di preoccupazioni rilevanti. Dopo aver filtrato questo elenco e aver aggiunto alcune considerazioni aggiuntive, mi sono ritrovato con il seguente insieme di rischi e limiti chiave posseduti dai moderni modelli di linguaggio di grandi dimensioni:

- Pregiudizio e discriminazione: Questi modelli apprendono da grandi quantità di dati di testo, che spesso contengono pregiudizi e contenuti discriminatori. Di conseguenza, gli output generati possono inavvertitamente perpetuare stereotipi, linguaggio offensivo e discriminazioni basate su fattori come genere, razza o religione.

- Disinformazione: i modelli linguistici di grandi dimensioni possono generare contenuti effettivamente errati, fuorvianti o obsoleti. Sebbene i modelli vengano addestrati su una vasta gamma di fonti, potrebbero non fornire sempre le informazioni più accurate o aggiornate. Spesso ciò accade perché il modello dà la priorità alla generazione di output che sono grammaticalmente corretti o sembrano coerenti, anche se sono fuorvianti.

- Mancanza di comprensione: Sebbene questi modelli sembrino comprendere il linguaggio umano, operano principalmente identificando modelli e associazioni statistiche nei dati di addestramento. Non hanno una profonda comprensione del contenuto che generano, il che a volte può portare a risultati privi di senso o irrilevanti.

- Contenuto inappropriato: i modelli linguistici a volte possono generare contenuti offensivi, dannosi o inappropriati. Sebbene vengano compiuti sforzi per ridurre al minimo tale contenuto, può comunque verificarsi a causa della natura dei dati di addestramento e dell'incapacità dei modelli di discernere il contesto o l'intenzione dell'utente.

Conclusione

I modelli di linguaggio di grandi dimensioni hanno indubbiamente rivoluzionato il campo dell'elaborazione del linguaggio naturale e hanno dimostrato un immenso potenziale nel migliorare la produttività in vari ruoli e settori. La loro capacità di generare testo simile a quello umano, automatizzare attività banali e fornire assistenza nei processi creativi e analitici li ha resi strumenti indispensabili nel mondo frenetico e guidato dalla tecnologia di oggi.

Tuttavia, è fondamentale riconoscere e comprendere i limiti e i rischi associati a questi potenti modelli. Problemi come pregiudizi, disinformazione e potenziale uso dannoso non possono essere ignorati. Mentre continuiamo a integrare queste tecnologie basate sull'intelligenza artificiale nella nostra vita quotidiana, è essenziale trovare un equilibrio tra lo sfruttamento delle loro capacità e la garanzia della supervisione umana, in particolare in situazioni sensibili e ad alto rischio.

Se riusciremo ad adottare responsabilmente le tecnologie di IA generativa, spianeremo la strada a un futuro in cui l'intelligenza artificiale e le competenze umane collaboreranno per guidare l'innovazione e creare un mondo migliore per tutti.

Ti piace questo articolo? Iscriviti per ulteriori aggiornamenti sulla ricerca AI.

Ti faremo sapere quando pubblicheremo altri articoli di riepilogo come questo.

Leggi Anche

- Distribuzione di contenuti basati su SEO e PR. Ricevi amplificazione oggi.

- PlatoData.Network Generativo verticale Ai. Potenzia te stesso. Accedi qui.

- PlatoAiStream. Intelligenza Web3. Conoscenza amplificata. Accedi qui.

- PlatoneESG. Automobilistico/VE, Carbonio, Tecnologia pulita, Energia, Ambiente, Solare, Gestione dei rifiuti. Accedi qui.

- BlockOffset. Modernizzare la proprietà della compensazione ambientale. Accedi qui.

- Fonte: https://www.topbots.com/top-language-models-transforming-ai-in-2023/

- :ha

- :È

- :non

- :Dove

- $ SU

- 1

- 10

- 12b

- 16

- 2%

- 2017

- 2021

- 2023

- 214

- 220

- 28

- 32

- 50

- 7

- 70

- 710

- 72

- 8

- 84

- 90

- a

- capacità

- capace

- WRI

- sopra

- Assoluta

- accademico

- Accetta

- accetta

- accesso

- accessibile

- ospitare

- Secondo

- precisione

- preciso

- raggiunto

- Realizza

- il raggiungimento

- riconoscere

- operanti in

- Attivazione

- attivazioni

- atti

- adattare

- adattamento

- aggiungere

- l'aggiunta di

- aggiunta

- aggiuntivo

- indirizzo

- indirizzi

- Adottando

- avanzamenti

- consigli

- Dopo shavasana, sedersi in silenzio; saluti;

- contro

- Agente

- AI

- ricerca ai

- mira

- AL

- nello stesso modo

- Tutti

- consentire

- Consentire

- consente

- lungo

- anche

- alternativa

- Sebbene il

- sempre

- fra

- tra

- quantità

- importi

- an

- .

- Analitico

- ed

- Un altro

- rispondere

- in qualsiasi

- api

- apparire

- applicazioni

- APPLICA

- approccio

- opportuno

- circa

- architettonico

- architettura

- SONO

- aree

- in giro

- Italia

- Arte

- articolo

- news

- artificiale

- intelligenza artificiale

- AS

- Assistenza

- assistenti

- associato

- associazioni

- At

- attenzione

- gli autori

- automatizzare

- disponibile

- media

- evitare

- premio

- Equilibrio

- bar

- base

- basato

- basic

- base

- BE

- perché

- diventare

- prima

- essendo

- sotto

- Segno di riferimento

- parametri di riferimento

- vantaggi

- Meglio

- fra

- pregiudizio

- pregiudizi

- Miliardo

- Libri

- bootstrap

- entrambi

- confini

- sfondamento

- innovazioni

- BRIDGE

- ampio

- costruire

- Costruzione

- costruito

- ma

- by

- detto

- Materiale

- candidato

- non può

- funzionalità

- capace

- Ultra-Grande

- attento

- Custodie

- catastrofico

- Causare

- ceo

- CEO e fondatore

- impegnativo

- possibilità

- il cambiamento

- chatbots

- ChatGPT

- Chips

- rivendicare

- classificazione

- Cloud

- Co-fondatore

- codice

- COERENTE

- collezione

- combinazione

- combinazioni

- Venire

- impegno

- Comunicazione

- comunità

- rispetto

- compatibile

- competitivo

- complementare

- complesso

- conformità

- componenti

- calcolo

- Calcolare

- computer

- informatica

- concettuale

- preoccupazioni

- Configurazione

- CONFERMATO

- Collegamento

- conseguentemente

- Considerazioni

- costruzione

- contenuto

- contesto

- contesti

- continua

- contrasto

- Conversazione

- Conversazioni

- Conversione

- correggere

- Corrispondente

- Costo

- Costi

- potuto

- creare

- creato

- Creative

- credibile

- cruciale

- Corrente

- cliente

- Servizio clienti

- Assistenza clienti

- bordo tagliente

- alle lezioni

- dati

- punti dati

- dataset

- Data

- deciso

- diminuire

- deep

- DeepMind

- fornisce un monitoraggio

- dimostrare

- dimostrato

- dimostra

- dimostrando

- Demos

- Dipendente

- distribuzione

- progettato

- Nonostante

- dettagli

- sviluppare

- sviluppatori

- in via di sviluppo

- Mercato

- dialogo

- Dialogo

- difficile

- disabilità

- Rilevare

- Discriminazione

- distinguere

- paesaggio differenziato

- do

- documento

- documenti

- effettua

- Dominance

- Dont

- dozzina

- guidare

- soprannominato

- dovuto

- durante

- e

- e-commerce

- E&T

- ogni

- Presto

- più facile

- educativo

- effetto

- in maniera efficace

- efficienza

- efficiente

- sforzi

- eliminato

- emerse

- enable

- consentendo

- che comprende

- impegnandosi

- Inglese

- accrescere

- migliorata

- miglioramenti

- migliorando

- assicurando

- essential

- stabilire

- stabilisce

- etico

- valutato

- valutazione

- valutazioni

- Anche

- Ogni

- qualunque cosa

- prova

- evoluzione

- esame

- esempio

- Esempi

- supera

- eccezionale

- coinvolgenti

- esclusivamente

- mostre

- esistente

- Espandere

- esperimenti

- competenza

- Esplorare

- esterno

- f1

- facilitare

- Fattori

- Autunno

- famiglia

- lontano

- affascinante

- fast-paced

- caratteristica

- In primo piano

- Caratteristiche

- feedback

- pochi

- meno

- campo

- figura

- filtraggio

- Trovate

- Nome

- Fissare

- fisso

- seguire

- i seguenti

- Nel

- forme

- Fondazioni

- fondatore

- Contesto

- da

- congelati

- function

- fondamentale

- fondamentalmente

- ulteriormente

- futuro

- guadagnato

- divario

- Sesso

- generare

- generato

- genera

- la generazione di

- ELETTRICA

- generativo

- AI generativa

- generatore

- ottenere

- GitHub

- Intravedere

- globali

- Go

- scopo

- andando

- buono

- Enti Pubblici

- GPU

- grado

- innovativo

- Gruppo

- ha avuto

- accade

- Hard

- Hardware

- dannoso

- Avere

- avendo

- assistenza sanitaria

- qui

- alta qualità

- ad alta risoluzione

- alto rischio

- superiore

- massimo

- detiene

- Come

- Tuttavia

- HTML

- HTTPS

- Enorme

- umano

- centinaia

- Montatura

- Sintonia iperparametro

- idea

- identificazione

- if

- Immagine

- immagini

- immenso

- implementazione

- implementato

- implicazioni

- importante

- impressionante

- competenze

- migliorata

- miglioramento

- miglioramenti

- in

- Uno sguardo approfondito sui miglioramenti dei pneumatici da corsa di Bridgestone.

- incapacità

- includere

- incluso

- Compreso

- Incorporated

- incorpora

- incorporando

- Aumento

- è aumentato

- crescente

- sempre più

- individuale

- individui

- industrie

- industria

- informazioni

- Infrastruttura

- iniziati

- Innovazione

- ingresso

- Ingressi

- invece

- istituzioni

- istruzioni

- integrare

- Intelligence

- intento

- interessante

- ai miglioramenti

- introdurre

- introdotto

- Inventato

- problema

- sicurezza

- IT

- SUO

- stessa

- giornalismo

- jpg

- ad appena

- Le

- obiettivi chiave

- Sapere

- conoscenze

- Labs

- Dipingere

- paesaggio

- Lingua

- Le Lingue

- grandi

- larga scala

- maggiore

- con i più recenti

- strato

- galline ovaiole

- portare

- IMPARARE

- apprendimento

- Legale

- meno

- Livello

- livelli

- Leva

- leveraggi

- leveraging

- Autorizzato

- Vita

- leggero

- piace

- probabile

- limiti

- Lista

- elenchi

- Lives

- Lama

- a livello locale

- logico

- Lunghi

- Guarda

- lotto

- Basso

- macchine

- fatto

- make

- FA

- molti

- Marcus

- Rappresentanza

- ricerche di mercato

- Marketing

- materiale

- matematica

- max-width

- massimo

- Maggio..

- significativo

- Media

- medicale

- Unire

- Meta

- Metodologia

- metodi

- Microsoft

- mente

- minimo

- Disinformazione

- ingannevole

- errori

- misto

- ML

- modello

- modelli

- moderno

- modificato

- monitoraggio

- Scopri di più

- maggior parte

- molti

- multiplo

- I musulmani

- Naturale

- Linguaggio naturale

- Elaborazione del linguaggio naturale

- Natura

- Bisogno

- di applicazione

- Rete

- Neurale

- Linguaggio neurale

- rete neurale

- New

- notizie

- GENERAZIONE

- bello

- nlp

- segnatamente

- Niente

- numero

- numerose

- obiettivo

- Obiettivi d'Esame

- verificarsi

- of

- offensivo

- ufficiale

- di frequente

- on

- ONE

- quelli

- esclusivamente

- aprire

- open source

- OpenAI

- operare

- Operazioni

- ottimizzazione

- or

- organizzazione

- Altro

- Altri

- nostro

- su

- sovraperformance

- Sorpassa

- produzione

- eccezionale

- ancora

- proprio

- palma

- Carta

- paradigma

- parametro

- parametri

- parte

- partecipare

- particolarmente

- passare

- modelli

- pavimentare

- Pavimentazione

- per

- eseguire

- performance

- esecuzione

- esegue

- Frasi

- scegliere

- Platone

- Platone Data Intelligence

- PlatoneDati

- baccelli

- punto

- punti

- Termini e Condizioni

- possibile

- potenziale

- alimentato

- potente

- predire

- preferito

- precedente

- principalmente

- Precedente

- prioritizzazione

- Problema

- problemi

- processi

- i processi

- lavorazione

- produrre

- Prodotto

- della produttività

- professionale

- Programmazione

- linguaggi di programmazione

- Progressi

- promettente

- proprietà

- propone

- proprio

- protocolli

- fornire

- purché

- fornisce

- pubblicamente

- pubblicato

- fini

- spingendo

- Python

- pytorch

- qualitativo

- qualità

- domanda

- Domande

- rapidamente

- Gara

- gamma

- rapidamente

- piuttosto

- Lettura

- di rose

- vita reale

- mondo reale

- recente

- recentemente

- riconoscimento

- riconoscere

- ridurre

- riducendo

- regimi

- insegnamento rafforzativo

- rilasciare

- rilasciato

- pertinente

- affidabile

- fonti affidabili

- religione

- basandosi

- rimanere

- è rimasta

- notevole

- sostituito

- Report

- rappresentazione

- richieste

- richiedere

- richiede

- riparazioni

- Comunità di ricerca

- ricercatori

- risorsa intensiva

- rispetto

- risponde

- risposta

- risposte

- limitato

- colpevole

- Risultati

- conserva

- Recensioni

- rivoluzionare

- rivoluzionato

- rischi

- rivalità

- robusto

- ruoli

- Prenotazione sale

- sicura

- Sicurezza

- forza di vendita

- stesso

- Scala

- bilancia

- scala

- Scenari

- Scene

- di moto

- Punto

- punteggi

- punteggio

- senza soluzione di continuità

- Secondo

- sembrare

- visto

- selezionato

- delicata

- separato

- Serie

- grave

- servizio

- Servizi

- set

- regolazione

- alcuni

- scioccato

- Corti

- mostrare attraverso le sue creazioni

- ha mostrato

- Spettacoli

- segno

- significativa

- significativamente

- Allo stesso modo

- singolare

- situazioni

- Taglia

- abilità

- inferiore

- So

- finora

- Social

- Social Media

- Società

- Software

- lo sviluppo del software

- unicamente

- soluzione

- risolve

- alcuni

- sofisticato

- Fonte

- fonti

- Reperimento

- carne in scatola

- specifico

- in particolare

- specificità

- spettacolare

- sintesi vocale

- velocità

- Stabilità

- Stage

- tappe

- Standard

- standard

- Regione / Stato

- state-of-the-art

- statistiche

- statistica

- Ancora

- Strategia

- punti di forza

- sciopero

- Studio

- sostanziale

- avere successo

- tale

- suggerire

- suggerisce

- SOMMARIO

- superiore

- supervisione

- supporto

- superato

- sistema

- SISTEMI DI TRATTAMENTO

- trattativa

- Task

- task

- team

- Consulenza

- tecniche

- Tecnologie

- condizioni

- test

- generazione di testo

- Text-to-Speech

- di

- Grazie

- che

- Il

- Il futuro

- Lo Stato

- il mondo

- loro

- Li

- poi

- Là.

- in tal modo

- perciò

- Strumenti Bowman per analizzare le seguenti finiture:

- di

- think

- di parti terze standard

- questo

- quelli

- anche se?

- migliaia

- tre

- Attraverso

- volte

- a

- di oggi

- insieme

- token

- tokenizzazione

- Tokens

- pure

- strumenti

- top

- TOPBOT

- argomento

- Argomenti

- verso

- tradizionale

- Treni

- allenato

- Training

- trasferimento

- trasformatore

- trasformazione

- Traduzione

- Trilione

- Turing

- Tutoring

- seconda

- incondizionato

- per

- capire

- e una comprensione reciproca

- intraprendere

- indubbiamente

- purtroppo

- Universo

- a differenza di

- up-to-date

- Aggiornamenti

- uso

- utilizzato

- Utente

- usa

- utilizzando

- utilizza

- varietà

- vario

- Fisso

- versatile

- molto

- Video

- Video

- virtuale

- visione

- VOX

- Prima

- Modo..

- we

- sito web

- WELL

- sono stati

- Che

- quando

- quale

- while

- OMS

- tutto

- largo

- Vasta gamma

- wikipedia

- volere

- con

- entro

- senza

- parole

- Lavora

- lavorare insieme

- mondo

- scrittura

- anni

- ancora

- Tu

- zefiro

- Apprendimento a tiro zero