Immagine dell'autore

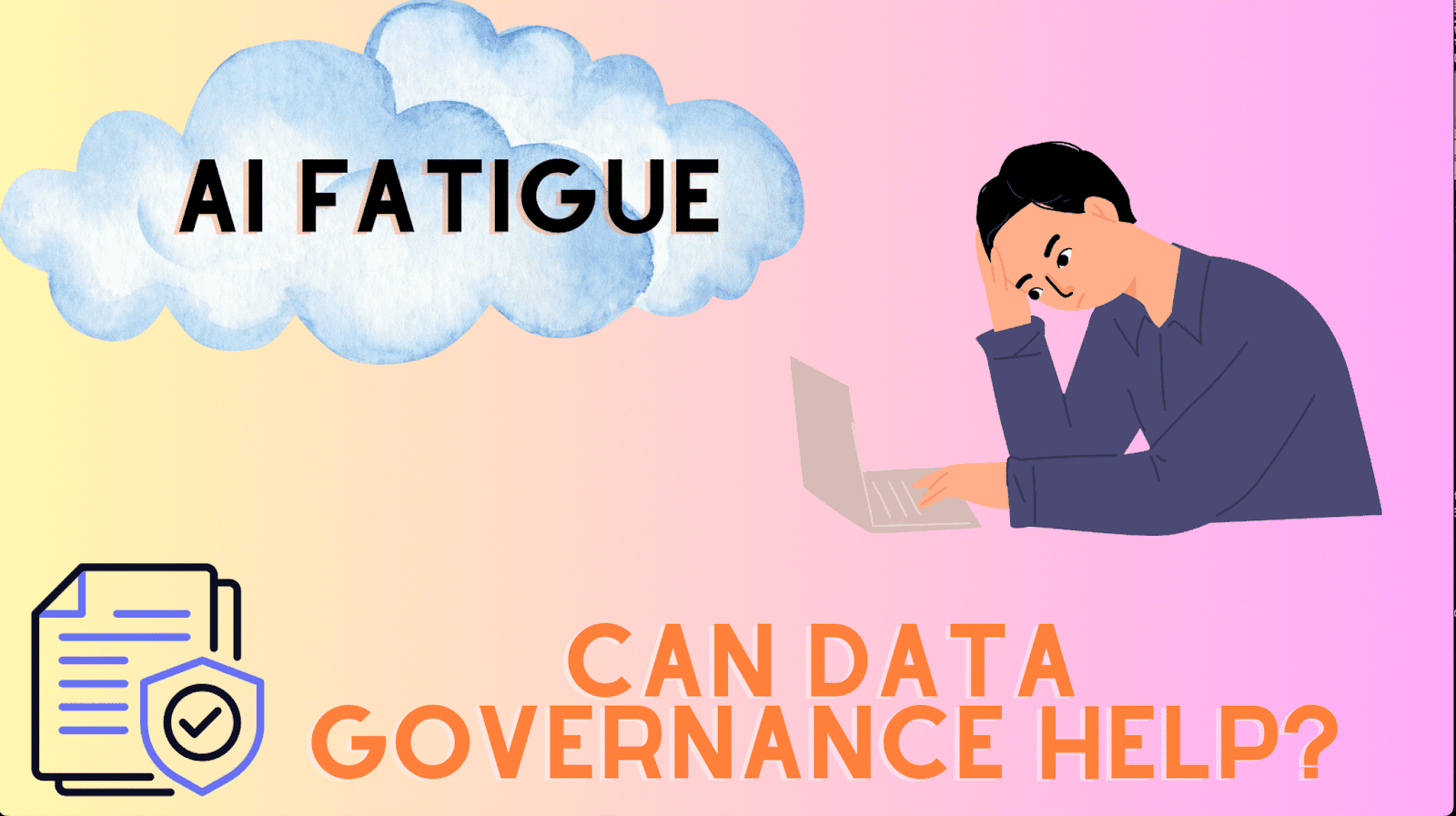

La governance dei dati e l’affaticamento dell’intelligenza artificiale sembrano due concetti diversi, ma esiste una connessione intrinseca tra i due. Per capirlo meglio, partiamo dalla loro definizione.

È stato per molto tempo il fulcro dell’industria dei dati.

Google dice bene: “La governance dei dati è tutto ciò che fai per garantire che i dati siano sicuri, privati, accurati, disponibili e utilizzabili. Implica la definizione di standard interni – politiche sui dati – che si applicano al modo in cui i dati vengono raccolti, archiviati, elaborati ed eliminati”.

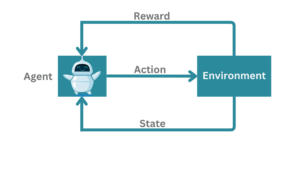

Come evidenzia questa definizione, la governance dei dati riguarda la gestione dei dati, ovvero il motore che guida i modelli di intelligenza artificiale.

Ora che i primi segnali del legame tra governance dei dati e intelligenza artificiale hanno iniziato a emergere, colleghiamolo all’affaticamento dell’intelligenza artificiale. Sebbene il nome lo tradisca, evidenziare le ragioni che portano a tale stanchezza garantisce un uso coerente di questo termine in tutto il post.

L’affaticamento dell’intelligenza artificiale si manifesta a causa degli ostacoli e delle sfide che le organizzazioni, gli sviluppatori o i team devono affrontare, spesso portando a una realizzazione di valore o a un’implementazione infruttuosa dei sistemi di intelligenza artificiale.

Per lo più inizia con aspettative irrealistiche su ciò di cui è capace l’intelligenza artificiale. Per le tecnologie sofisticate come l’intelligenza artificiale, le principali parti interessate devono allinearsi non solo alle capacità e alle possibilità dell’intelligenza artificiale, ma anche ai suoi limiti e rischi.

Quando si parla di rischi, l’etica è spesso considerata un ripensamento che porta a scartare iniziative di IA non conformi.

Ti starai chiedendo quale sia il ruolo della governance dei dati nel causare l’affaticamento dell’IA: la premessa di questo post.

È lì che ci dirigeremo dopo.

L’affaticamento dell’IA può essere generalmente classificato come pre-distribuzione e post-distribuzione. Concentriamoci innanzitutto sulla pre-implementazione.

Pre-distribuzione

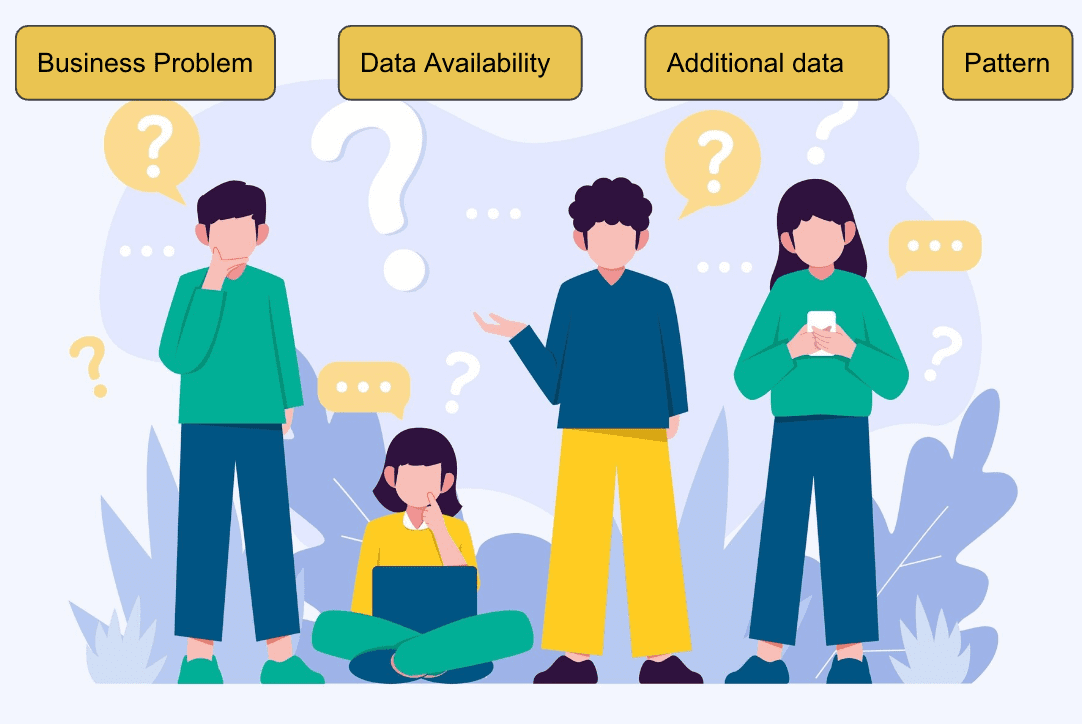

Vari fattori contribuiscono al passaggio di una Proof of Concept (PoC) alla distribuzione, come ad esempio:

- Cosa stiamo cercando di risolvere?

- Perché è un problema urgente dare la priorità adesso?

- Quali dati sono disponibili?

- È risolvibile con il machine learning?

- I dati hanno uno schema?

- Il fenomeno è ripetibile?

- Quali dati aggiuntivi aumenterebbero le prestazioni del modello?

Immagine da Freepik

Una volta valutato che il problema può essere risolto al meglio utilizzando algoritmi ML, il team di data science esegue un'analisi esplorativa dei dati. In questa fase vengono scoperti molti modelli di dati sottostanti, evidenziando se i dati forniti sono ricchi di segnale. Aiuta anche a creare funzionalità ingegnerizzate per accelerare il processo di apprendimento dell'algoritmo.

Successivamente, il team costruisce il primo modello di base, spesso scoprendo che non raggiunge il livello accettabile. Un modello il cui risultato è pari al lancio di una moneta non aggiunge alcun valore. Questo è uno dei primi intoppi, ovvero le lezioni, durante la creazione di modelli ML.

Le organizzazioni possono passare da un problema aziendale a un altro, causando affaticamento. Tuttavia, se i dati sottostanti non portano un segnale ricco, nessun algoritmo di intelligenza artificiale può basarsi su di essi. Il modello deve apprendere le associazioni statistiche dai dati di addestramento per generalizzare su dati invisibili.

Post-distribuzione

Nonostante il modello addestrato mostri risultati promettenti sul set di validazione, in linea con i criteri aziendali qualificanti, come la precisione del 70%, può comunque verificarsi affaticamento se il modello non riesce a funzionare adeguatamente nell'ambiente di produzione.

Questo tipo di affaticamento dell'IA è chiamato fase post-distribuzione.

Una miriade di ragioni potrebbero portare a un peggioramento delle prestazioni, laddove la scarsa qualità dei dati è il problema più comune che affligge il modello. Limita la capacità del modello di prevedere con precisione la risposta target in assenza di attributi cruciali.

Consideriamo il caso in cui una delle funzionalità essenziali, che mancava solo per il 10% nei dati di addestramento, ora diventa nulla nel 50% dei casi nei dati di produzione, portando a previsioni errate. Tali iterazioni e sforzi per garantire modelli con prestazioni costanti creano affaticamento nei data scientist e nei team aziendali, erodendo così la fiducia nelle pipeline di dati e mettendo a rischio gli investimenti effettuati nel progetto.

Misure robuste di governance dei dati sono fondamentali per affrontare entrambi i tipi di affaticamento dell’IA. Dato che i dati sono al centro dei modelli ML, dati ricchi di segnali, privi di errori e di alta qualità sono un must per il successo di un progetto ML. Affrontare l’affaticamento dell’IA richiede una forte attenzione alla governance dei dati. Dobbiamo quindi lavorare rigorosamente per garantire la giusta qualità dei dati, gettando le basi per costruire modelli all’avanguardia e fornire insight aziendali affidabili.

Qualità dei dati

La qualità dei dati, la chiave per una governance dei dati prospera, è un fattore critico di successo per gli algoritmi di machine learning. Le organizzazioni devono investire nella qualità dei dati, ad esempio pubblicando report per i consumatori di dati. Nei progetti di data science, pensa a cosa succede quando dati di cattiva qualità arrivano ai modelli, il che può portare a scarse prestazioni.

Solo durante l'analisi degli errori i team riuscirebbero a identificare i problemi relativi alla qualità dei dati che, una volta inviati per essere risolti a monte, finiscono per causare affaticamento tra i team.

Chiaramente, non è solo lo sforzo speso, ma si perde molto tempo finché non iniziano ad arrivare i dati giusti.

Pertanto, è sempre consigliabile risolvere i problemi relativi ai dati alla fonte per evitare iterazioni così dispendiose in termini di tempo. Alla fine, i rapporti sulla qualità dei dati pubblicati alludono al team di data science (o, del resto, a qualsiasi altro utente a valle e consumatore di dati) con una comprensione della qualità accettabile dei dati in arrivo.

Senza misure di qualità e governance dei dati, i data scientist sarebbero sovraccarichi di problemi relativi ai dati, contribuendo a modelli infruttuosi che guidano l’affaticamento dell’IA.

Il post ha evidenziato le due fasi in cui si manifesta l’affaticamento dell’IA e ha presentato come le misure di governance dei dati, come i report sulla qualità dei dati, possano essere un fattore abilitante per la costruzione di modelli affidabili e solidi.

Stabilendo una solida base attraverso la governance dei dati, le organizzazioni possono costruire una tabella di marcia verso uno sviluppo e un’adozione dell’intelligenza artificiale di successo e senza soluzione di continuità, infondendo entusiasmo.

Per garantire che il post offra una panoramica olistica dei vari modi per affrontare l'affaticamento dell'IA, sottolineo anche il ruolo della cultura organizzativa, che, combinata con altre migliori pratiche come la governance dei dati, consentirà e consentirà ai team di data science di creare contributi significativi all'IA prima e Più veloce.

Vidhi Chug è uno stratega dell'intelligenza artificiale e un leader della trasformazione digitale che lavora all'intersezione di prodotto, scienza e ingegneria per costruire sistemi di apprendimento automatico scalabili. È una pluripremiata leader dell'innovazione, un'autrice e una relatrice internazionale. La sua missione è democratizzare l'apprendimento automatico e rompere il gergo affinché tutti possano far parte di questa trasformazione.

- Distribuzione di contenuti basati su SEO e PR. Ricevi amplificazione oggi.

- PlatoData.Network Generativo verticale Ai. Potenzia te stesso. Accedi qui.

- PlatoAiStream. Intelligenza Web3. Conoscenza amplificata. Accedi qui.

- PlatoneESG. Carbonio, Tecnologia pulita, Energia, Ambiente, Solare, Gestione dei rifiuti. Accedi qui.

- Platone Salute. Intelligence sulle biotecnologie e sulle sperimentazioni cliniche. Accedi qui.

- Fonte: https://www.kdnuggets.com/can-data-governance-address-ai-fatigue?utm_source=rss&utm_medium=rss&utm_campaign=can-data-governance-address-ai-fatigue

- :ha

- :È

- :non

- :Dove

- $ SU

- a

- capacità

- WRI

- accettabile

- preciso

- con precisione

- aggiuntivo

- indirizzo

- indirizzamento

- Aggiunge

- adeguatamente

- Adozione

- consigliato

- AI

- Modelli AI

- Sistemi di intelligenza artificiale

- aka

- algoritmo

- Algoritmi

- allineare

- anche

- sempre

- tra

- an

- .

- ed

- Un altro

- in qualsiasi

- APPLICA

- SONO

- sorgere

- AS

- associazioni

- At

- gli attributi

- autore

- disponibile

- premiata

- lontano

- Vasca

- Linea di base

- BE

- diventa

- stato

- MIGLIORE

- best practice

- Meglio

- fra

- entrambi

- Rompere

- in linea di massima

- costruire

- Costruzione

- costruisce

- affari

- ma

- by

- detto

- Materiale

- funzionalità

- capace

- trasportare

- causando

- sfide

- Moneta

- combinato

- Uncommon

- avvincente

- concetto

- concetti

- preoccupazioni

- fiducia

- veloce

- considerato

- coerente

- costantemente

- Consumatori

- contribuire

- contribuendo

- contributi

- Nucleo

- potuto

- creare

- criteri

- critico

- cruciale

- Cultura

- dati

- analisi dei dati

- qualità dei dati

- scienza dei dati

- definizione

- consegnare

- democratizzare

- deployment

- sviluppatori

- Mercato

- diverso

- digitale

- DIGITAL TRANSFORMATION

- do

- effettua

- guida

- dovuto

- durante

- sforzo

- sforzi

- emergere

- enfatizzare

- e potenza

- enable

- enabler

- fine

- motore

- progettato

- Ingegneria

- garantire

- assicura

- entusiasmo

- Ambiente

- errore

- essential

- stabilire

- Etere (ETH)

- etica

- valutato

- alla fine

- tutti

- qualunque cosa

- le aspettative

- Analisi dei dati esplorativi

- Faccia

- fattore

- Fattori

- fallisce

- più veloce

- fatica

- Caratteristiche

- ricerca

- Nome

- Fissare

- fisso

- Capovolgere

- Focus

- Nel

- Fondazione

- da

- raccolto

- ottenere

- dato

- dà

- buono

- la governance

- basi

- accade

- Avere

- Titolo

- aiuta

- alta qualità

- Evidenziato

- mettendo in evidenza

- evidenzia

- olistica

- Come

- HTTPS

- i

- identificare

- if

- implementazione

- in

- In arrivo

- industria

- iniziative

- Innovazione

- intuizioni

- interno

- Internazionale

- intersezione

- ai miglioramenti

- intrinseco

- Investire

- Investimenti

- comporta

- problema

- sicurezza

- IT

- iterazioni

- SUO

- gergo

- ad appena

- KDnuggets

- Le

- posa

- portare

- leader

- principale

- Leads

- IMPARARE

- apprendimento

- Lezioni

- lasciare

- Livello

- piace

- limiti

- limiti

- linea

- LINK

- Lunghi

- a lungo

- perso

- lotto

- macchina

- machine learning

- fatto

- make

- FA

- gestione

- molti

- Importanza

- Maggio..

- significativo

- analisi

- medie

- mancante

- Missione

- ML

- Algoritmi ML

- modello

- modelli

- maggior parte

- soprattutto

- cambiano

- devono obbligatoriamente:

- Nome

- Bisogno

- GENERAZIONE

- no

- adesso

- of

- di frequente

- on

- ONE

- esclusivamente

- or

- organizzativa

- organizzazioni

- Altro

- produzione

- panoramica

- parte

- Cartamodello

- modelli

- eseguire

- performance

- esecuzione

- esegue

- fase

- fenomeno

- tubo

- posto

- Platone

- Platone Data Intelligence

- PlatoneDati

- PoC

- povero

- possibilità

- Post

- pratiche

- precisamente

- Precisione

- predire

- Previsioni

- presentata

- prevenire

- Dare priorità

- un bagno

- Problema

- processi

- elaborati

- Prodotto

- Produzione

- progetto

- progetti

- promettente

- prova

- prova del concetto

- pubblicato

- editoriale

- mette

- qualifica

- qualità

- dati di qualità

- realizzazione

- motivi

- ripetibile

- Report

- richiede

- risposta

- Risultati

- Ricco

- destra

- rischiando

- rischi

- tabella di marcia

- robusto

- Ruolo

- scalabile

- Scienze

- SCIENZE

- scienziati

- senza soluzione di continuità

- sicuro

- inviato

- set

- Battute d'arresto

- Set

- regolazione

- lei

- mostra

- Signal

- Segni

- So

- solido

- RISOLVERE

- risolto

- sofisticato

- Suono

- Fonte

- Speaker

- velocità

- Stage

- tappe

- stakeholder

- inizia a

- iniziato

- inizio

- state-of-the-art

- statistiche

- Ancora

- memorizzati

- Stratega

- forte

- il successo

- di successo

- tale

- SISTEMI DI TRATTAMENTO

- Affronto

- Target

- team

- le squadre

- Tecnologie

- termine

- che

- Il

- loro

- Là.

- in tal modo

- think

- questo

- anche se?

- fiorente

- Attraverso

- per tutto

- tempo

- richiede tempo

- a

- allenato

- Training

- Trasformazione

- affidabili sul mercato

- cerca

- seconda

- Digitare

- Tipi di

- scoperto

- sottostante

- capire

- e una comprensione reciproca

- fino a quando

- su

- us

- utilizzabile

- uso

- utenti

- utilizzando

- convalida

- APPREZZIAMO

- Prima

- Modo..

- modi

- we

- WELL

- Che

- quando

- se

- quale

- while

- di chi

- volere

- con

- chiedendosi

- Lavora

- lavoro

- sarebbe

- Tu

- zefiro