La rapida crescita dell’intelligenza artificiale generativa porta nuove innovazioni promettenti e allo stesso tempo solleva nuove sfide. Queste sfide includono alcune che erano comuni prima dell’intelligenza artificiale generativa, come pregiudizi e spiegabilità nuovi unici per i modelli di fondazione (FM), comprese allucinazioni e tossicità. In AWS, ci impegniamo a sviluppare l’intelligenza artificiale generativa in modo responsabile, adottando un approccio incentrato sulle persone che dia priorità all’istruzione, alla scienza e ai nostri clienti, per integrare l’intelligenza artificiale responsabile in tutto il ciclo di vita dell’intelligenza artificiale end-to-end.

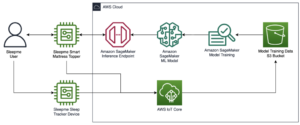

Nell'ultimo anno abbiamo introdotto nuove funzionalità nelle nostre applicazioni e modelli di intelligenza artificiale generativa, come la scansione di sicurezza integrata Amazon Code Whisperer, formazione per rilevare e bloccare contenuti dannosi Titano Amazzonicoe la tutela della privacy dei dati in Roccia Amazzonica. Il nostro investimento in un’intelligenza artificiale generativa sicura, trasparente e responsabile include la collaborazione con la comunità globale e i responsabili politici poiché abbiamo incoraggiato e sostenuto sia Impegni volontari della Casa Bianca in materia di intelligenza artificiale ed Vertice sulla sicurezza dell'intelligenza artificiale nel Regno Unito. E continuiamo a lavorare fianco a fianco con i clienti per rendere operativa l'IA responsabile con strumenti appositamente realizzati come Amazon SageMaker Chiarire, Governance del machine learning con Amazon SageMakerE altro ancora.

Presentazione di una nuova innovazione responsabile dell’IA

Poiché l’intelligenza artificiale generativa si adatta a nuovi settori, organizzazioni e casi d’uso, questa crescita deve essere accompagnata da un investimento sostenuto nello sviluppo responsabile della FM. I clienti vogliono che i loro FM siano costruiti tenendo presente la sicurezza, l’equità e la protezione, in modo che possano a loro volta implementare l’intelligenza artificiale in modo responsabile. Quest'anno ad AWS re:Invent siamo lieti di annunciare nuove funzionalità per promuovere l'innovazione responsabile dell'intelligenza artificiale generativa attraverso un'ampia gamma di funzionalità con nuovi strumenti integrati, protezioni dei clienti, risorse per migliorare la trasparenza e strumenti per combattere la disinformazione. Il nostro obiettivo è fornire ai clienti le informazioni di cui hanno bisogno per valutare i FM rispetto alle principali considerazioni sull’IA responsabile, come tossicità e robustezza, e introdurre guardrail per applicare misure di salvaguardia basate sui casi d’uso dei clienti e sulle politiche di IA responsabile. Allo stesso tempo, i nostri clienti vogliono essere meglio informati sulla sicurezza, l’equità, la protezione e altre proprietà dei servizi di intelligenza artificiale e dei FM, mentre li utilizzano all’interno della propria organizzazione. Siamo entusiasti di annunciare più risorse per aiutare i clienti a comprendere meglio i nostri servizi AWS AI e fornire la trasparenza che chiedono.

Implementazione delle misure di salvaguardia: Guardrail per Amazon Bedrock

La sicurezza è una priorità quando si tratta di introdurre l’intelligenza artificiale generativa su larga scala. Le organizzazioni desiderano promuovere interazioni sicure tra i propri clienti e applicazioni di intelligenza artificiale generativa che evitino linguaggio dannoso o offensivo e si allineino alle politiche aziendali. Il modo più semplice per farlo è mettere in atto misure di salvaguardia coerenti in tutta l’organizzazione in modo che tutti possano innovare in sicurezza. Ieri abbiamo annunciato l'anteprima di Guardrail per Amazon Bedrock—una nuova funzionalità che semplifica l’implementazione di misure di salvaguardia specifiche per l’applicazione basate sui casi d’uso dei clienti e sulle policy di IA responsabile.

I guardrail garantiscono la coerenza nel modo in cui i FM su Amazon Bedrock rispondono ai contenuti indesiderati e dannosi all'interno delle applicazioni. I clienti possono applicare guardrail a modelli linguistici di grandi dimensioni su Amazon Bedrock, nonché a modelli ottimizzati e in combinazione con Agenti per Amazon Bedrock. Guardrails ti consente di specificare gli argomenti da evitare e il servizio rileva e impedisce automaticamente le query e le risposte che rientrano in categorie limitate. I clienti possono anche configurare soglie di filtro dei contenuti tra categorie tra cui incitamento all'odio, insulti, linguaggio sessualizzato e violenza per filtrare i contenuti dannosi al livello desiderato. Ad esempio, è possibile impostare un'applicazione bancaria online per evitare di fornire consigli sugli investimenti e limitare i contenuti inappropriati (come incitamento all'odio, insulti e violenza). Nel prossimo futuro, i clienti saranno anche in grado di oscurare le informazioni di identificazione personale (PII) negli input degli utenti e nelle risposte dei FM, impostare filtri volgari e fornire un elenco di parole personalizzate da bloccare nelle interazioni tra utenti e FM, migliorando la conformità e ulteriormente tutelare gli utenti. Con Guardrails puoi innovare più velocemente con l'intelligenza artificiale generativa mantenendo protezioni e salvaguardie coerenti con le politiche aziendali.

Identificazione del miglior FM per un caso d'uso specifico: valutazione del modello in Amazon Bedrock

Oggi, le organizzazioni dispongono di un’ampia gamma di opzioni FM per potenziare le proprie applicazioni di intelligenza artificiale generativa. Per trovare il giusto equilibrio tra precisione e prestazioni per il proprio caso d'uso, le organizzazioni devono confrontare in modo efficiente i modelli e trovare l'opzione migliore sulla base dell'intelligenza artificiale responsabile e delle metriche di qualità che sono importanti per loro. Per valutare i modelli, le organizzazioni devono prima dedicare giorni a identificare benchmark, impostare strumenti di valutazione ed eseguire valutazioni, tutte operazioni che richiedono una profonda esperienza nella scienza dei dati. Inoltre, questi test non sono utili per valutare criteri soggettivi (ad esempio, voce del marchio, pertinenza e stile) che richiedono un giudizio attraverso flussi di lavoro di revisione umana noiosi e dispendiosi in termini di tempo. Il tempo, le competenze e le risorse necessarie per queste valutazioni, per ogni nuovo caso d’uso, rendono difficile per le organizzazioni valutare i modelli rispetto alle dimensioni dell’intelligenza artificiale responsabile e fare una scelta informata su quale modello fornirà l’esperienza più accurata e sicura per i propri clienti.

Ora disponibile in anteprima, Valutazione del modello su Amazon Bedrock aiuta i clienti a valutare, confrontare e selezionare i migliori FM per il loro caso d'uso specifico sulla base di metriche personalizzate, come accuratezza e sicurezza, utilizzando valutazioni automatiche o umane. Nella console Amazon Bedrock, i clienti scelgono i FM che desiderano confrontare per una determinata attività, come la risposta alle domande o il riepilogo dei contenuti. Per le valutazioni automatiche, i clienti selezionano criteri di valutazione predefiniti (ad esempio, accuratezza, robustezza e tossicità) e caricano il proprio set di dati di test o selezionano da set di dati integrati e disponibili al pubblico. Per criteri soggettivi o contenuti sfumati che richiedono un giudizio, i clienti possono facilmente impostare flussi di lavoro di valutazione basati su esseri umani con pochi clic. Questi flussi di lavoro sfruttano il team di lavoro interno del cliente o utilizzano una forza lavoro gestita fornita da AWS per valutare le risposte del modello. Durante le valutazioni basate sugli esseri umani, i clienti definiscono metriche specifiche del caso d'uso (ad esempio, pertinenza, stile e voce del marchio). Una volta che i clienti hanno terminato il processo di configurazione, Amazon Bedrock esegue valutazioni e genera un report, in modo che i clienti possano facilmente comprendere come il modello si è comportato rispetto ai principali criteri di sicurezza e accuratezza e selezionare il modello migliore per il loro caso d'uso.

Questa capacità di valutare i modelli non è limitata ad Amazon Bedrock, i clienti possono anche utilizzare la valutazione dei modelli in Amazon SageMaker Clarify per valutare, confrontare e selezionare facilmente la migliore opzione FM in base a parametri chiave di qualità e responsabilità come accuratezza, robustezza e tossicità – in tutto tutti gli FM.

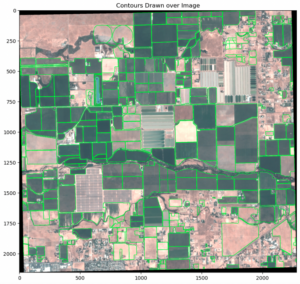

Lotta alla disinformazione: watermarking in Amazon Titan

Oggi abbiamo annunciato Generatore di immagini di Amazon Titan in anteprima, che consente ai clienti di produrre e migliorare rapidamente immagini di alta qualità su larga scala. Abbiamo considerato l'IA responsabile durante ogni fase del processo di sviluppo del modello, inclusa la selezione dei dati di training, la creazione di capacità di filtro per rilevare e rimuovere input degli utenti e output del modello inappropriati e migliorare la diversità demografica degli output del nostro modello. Tutte le immagini generate da Amazon Titan contengono per impostazione predefinita una filigrana invisibile, progettata per contribuire a ridurre la diffusione della disinformazione fornendo un meccanismo discreto per identificare le immagini generate dall'intelligenza artificiale. AWS è tra i primi fornitori di modelli a rilasciare su larga scala filigrane invisibili integrate negli output di immagini e progettate per resistere alle alterazioni.

Costruire la fiducia: sostenere i nostri modelli e le nostre applicazioni con indennizzi

Costruire la fiducia dei clienti è fondamentale per AWS. Abbiamo intrapreso un viaggio con i nostri clienti sin dall'inizio e, con la crescita dell'intelligenza artificiale generativa, continuiamo a impegnarci a costruire insieme tecnologie innovative. Per consentire ai clienti di sfruttare la potenza della nostra IA generativa, devono sapere di essere protetti. AWS offre copertura di tutela del copyright per gli output dei seguenti servizi di intelligenza artificiale generativa di Amazon: Amazon Titan Text Express, Amazon Titan Text Lite, Amazon Titan Embeddings, Amazon Titan Multimodal Embeddings, Amazon CodeWhisperer Professional, AWS HealthScribe, Amazon-Lexe Amazon Personalizza. Ciò significa che i clienti che utilizzano i servizi in modo responsabile sono protetti da pretese di terzi che presumono violazioni del diritto d'autore da parte dei risultati generati da tali servizi (vedi Sezione 50.10 della Termini di servizio). Inoltre, la nostra indennità IP standard per l'utilizzo dei servizi protegge i clienti da reclami di terzi che presumono violazione della proprietà intellettuale da parte dei servizi e dei dati utilizzati per addestrarli. Per dirla in altro modo, se utilizzi un servizio di intelligenza artificiale generativa di Amazon sopra elencato e qualcuno ti fa causa per violazione della proprietà intellettuale, AWS difenderà tale causa, che include la copertura di qualsiasi giudizio contro di te o dei costi di transazione.

Sosteniamo i nostri servizi di intelligenza artificiale generativa e lavoriamo per migliorarli continuamente. Mentre AWS lancia nuovi servizi e l'intelligenza artificiale generativa continua ad evolversi, AWS continuerà a concentrarsi incessantemente sull'acquisizione e sul mantenimento della fiducia dei clienti.

Migliorare la trasparenza: AWS AI Service Card per Amazon Titan Text

We ha introdotto le carte di servizio AI AWS a re:Invent 2022 come risorsa di trasparenza per aiutare i clienti a comprendere meglio i nostri servizi AWS AI. Le AI Service Card sono una forma di documentazione sull'intelligenza artificiale responsabile che fornisce ai clienti un unico posto in cui trovare informazioni sui casi d'uso e sulle limitazioni previste, sulle scelte di progettazione responsabile dell'intelligenza artificiale e sulle migliori pratiche di implementazione e ottimizzazione delle prestazioni per i nostri servizi di intelligenza artificiale. Fanno parte di un processo di sviluppo completo che intraprendiamo per costruire i nostri servizi in modo responsabile che affronti equità, spiegabilità, veridicità e robustezza, governance, trasparenza, privacy e sicurezza, sicurezza e controllabilità.

A re:Invent quest'anno annunciamo a nuova carta servizi AI per Amazon Titan Text aumentare la trasparenza dei modelli di fondazione. Stiamo inoltre lanciando quattro nuove carte servizi AI, tra cui: Amazon Comprehend Rileva PII, Rilevamento della tossicità di Amazon Transcribe, Amazon Rekognition Face Livenesse AWS HealthScribe. Puoi esplorare ciascuna di queste carte su Sito web dell'AWS. Poiché l’intelligenza artificiale generativa continua a crescere ed evolversi, la trasparenza su come la tecnologia viene sviluppata, testata e utilizzata sarà una componente vitale per guadagnare la fiducia delle organizzazioni e dei loro clienti. In AWS, ci impegniamo a continuare a portare risorse di trasparenza come le carte dei servizi AI alla comunità più ampia e a ripetere e raccogliere feedback sulle migliori soluzioni da seguire.

Investire nell’intelligenza artificiale responsabile durante l’intero ciclo di vita dell’intelligenza artificiale generativa

Siamo entusiasti delle nuove innovazioni annunciate questa settimana al re:Invent che offrono ai nostri clienti più strumenti, risorse e protezioni integrate per creare e utilizzare l'intelligenza artificiale generativa in modo sicuro. Dalla valutazione del modello ai guardrail fino al watermarking, i clienti possono ora introdurre più rapidamente l’intelligenza artificiale generativa nella propria organizzazione, mitigando al tempo stesso i rischi. Nuove protezioni per i clienti come la copertura dell’indennità IP e nuove risorse per migliorare la trasparenza come carte di servizio AI aggiuntive sono anche esempi chiave del nostro impegno volto a creare fiducia tra aziende tecnologiche, politici, gruppi di comunità, scienziati e altro ancora. Continuiamo a effettuare investimenti significativi nell'intelligenza artificiale responsabile durante l'intero ciclo di vita di un modello di base, per aiutare i nostri clienti a scalare l'intelligenza artificiale in modo sicuro e responsabile.

Informazioni sugli autori

Pietro Hallinan guida iniziative nella scienza e nella pratica dell'IA responsabile presso AWS AI, insieme a un team di esperti di intelligenza artificiale responsabile. Ha una profonda esperienza in AI (PhD, Harvard) e imprenditorialità (Blindsight, venduto ad Amazon). Le sue attività di volontariato hanno incluso il servizio come professore consulente presso la Stanford University School of Medicine e come presidente della Camera di commercio americana in Madagascar. Quando può, va in montagna con i figli: sci, arrampicata, trekking e rafting

Pietro Hallinan guida iniziative nella scienza e nella pratica dell'IA responsabile presso AWS AI, insieme a un team di esperti di intelligenza artificiale responsabile. Ha una profonda esperienza in AI (PhD, Harvard) e imprenditorialità (Blindsight, venduto ad Amazon). Le sue attività di volontariato hanno incluso il servizio come professore consulente presso la Stanford University School of Medicine e come presidente della Camera di commercio americana in Madagascar. Quando può, va in montagna con i figli: sci, arrampicata, trekking e rafting

Vasi Filomin è attualmente il vicepresidente dell'intelligenza artificiale generativa presso AWS. Dirige iniziative di intelligenza artificiale generativa tra cui Amazon Bedrock, Amazon Titan e Amazon CodeWhisperer.

Vasi Filomin è attualmente il vicepresidente dell'intelligenza artificiale generativa presso AWS. Dirige iniziative di intelligenza artificiale generativa tra cui Amazon Bedrock, Amazon Titan e Amazon CodeWhisperer.

- Distribuzione di contenuti basati su SEO e PR. Ricevi amplificazione oggi.

- PlatoData.Network Generativo verticale Ai. Potenzia te stesso. Accedi qui.

- PlatoAiStream. Intelligenza Web3. Conoscenza amplificata. Accedi qui.

- PlatoneESG. Carbonio, Tecnologia pulita, Energia, Ambiente, Solare, Gestione dei rifiuti. Accedi qui.

- Platone Salute. Intelligence sulle biotecnologie e sulle sperimentazioni cliniche. Accedi qui.

- Fonte: https://aws.amazon.com/blogs/machine-learning/announcing-new-tools-and-capabilities-to-enable-responsible-ai-innovation/

- :ha

- :È

- :non

- $ SU

- 10

- 100

- 125

- 2022

- 50

- a

- capacità

- capace

- WRI

- sopra

- accompagnati

- precisione

- preciso

- operanti in

- attività

- aggiunta

- aggiuntivo

- indirizzi

- consigli

- contro

- AI

- Servizi di intelligenza artificiale

- puntare

- allineare

- nello stesso modo

- Tutti

- a fianco di

- anche

- Amazon

- Amazon Code Whisperer

- Amazon Sage Maker

- Amazon Web Services

- americano

- tra

- an

- ed

- Annunciare

- ha annunciato

- annunciando

- Un altro

- in qualsiasi

- Applicazioni

- applicazioni

- APPLICA

- approccio

- SONO

- in giro

- AS

- chiedendo

- valutazioni

- At

- Automatico

- automaticamente

- disponibile

- evitare

- evitato

- AWS

- AWS re: Invent

- Equilibrio

- Settore bancario

- basato

- BE

- stato

- prima

- dietro

- parametri di riferimento

- MIGLIORE

- best practice

- Meglio

- fra

- pregiudizio

- Bloccare

- entrambi

- marca

- portare

- Porta

- ampio

- più ampia

- costruire

- costruire fiducia

- Costruzione

- costruito

- incassato

- by

- Materiale

- funzionalità

- capacità

- carta

- Carte

- Custodie

- casi

- categoria

- sfide

- Telecamera climatica

- Bambini

- scegliere

- scelte

- Scegli

- arrampicata

- collaborazione

- combattere

- combinazione

- viene

- Commercio

- impegno

- impegnata

- Uncommon

- comunità

- Aziende

- azienda

- confrontare

- conformità

- componente

- comprendere

- globale

- Considerazioni

- considerato

- coerente

- consolle

- consulting

- contenere

- contenuto

- continuamente

- continua

- continua

- continua

- copyright

- violazione del copyright

- Nucleo

- Costi

- copertura

- copertura

- criteri

- Attualmente

- costume

- cliente

- Clienti

- dati

- privacy dei dati

- scienza dei dati

- dataset

- Giorni

- deep

- profonda competenza

- Predefinito

- definire

- consegnare

- demografico

- schierare

- deployment

- Design

- progettato

- desiderato

- individuare

- sviluppato

- Mercato

- difficile

- dimensioni

- Le disinformazioni sanitarie

- Diversità

- do

- documentazione

- guidare

- durante

- e

- ogni

- guadagnare

- Guadagno

- più semplice

- facilmente

- facile

- Istruzione

- in modo efficiente

- sforzi

- o

- Potenzia

- enable

- incoraggiato

- da un capo all'altro

- accrescere

- Intero

- l'imprenditorialità

- Etere (ETH)

- valutare

- la valutazione

- valutazione

- valutazioni

- Ogni

- tutti

- evolvere

- esempio

- Esempi

- eccitato

- esperienza

- competenza

- esperti

- Spiegabilità

- esplora

- esprimere

- Faccia

- equità

- Autunno

- più veloce

- feedback

- pochi

- filtro

- filtraggio

- filtri

- Trovate

- finire

- Nome

- Focus

- i seguenti

- Nel

- modulo

- Avanti

- Favorire

- Fondazione

- quattro

- da

- ulteriormente

- Inoltre

- futuro

- raccogliere

- generato

- genera

- generativo

- AI generativa

- dato

- dà

- globali

- la governance

- Gruppo

- Crescere

- Crescita

- dannoso

- cintura da arrampicata

- harvard

- odio

- incitamento all'odio

- Avere

- he

- Aiuto

- aiuta

- alta qualità

- escursionismo

- il suo

- Casa

- Come

- HTTPS

- umano

- identificare

- identificazione

- if

- Immagine

- immagini

- realizzare

- importante

- competenze

- miglioramento

- in

- inizio

- includere

- incluso

- inclusi

- Compreso

- Aumento

- industrie

- informazioni

- informati

- infrazione

- iniziative

- innovare

- Innovazione

- innovazioni

- creativi e originali

- tecnologia innovativa

- Ingressi

- integrare

- integrato

- destinato

- interazioni

- ai miglioramenti

- introdurre

- introdotto

- l'introduzione di

- investimento

- Investimenti

- invisibile

- IP

- IT

- viaggio

- jpg

- ad appena

- Le

- Sapere

- Lingua

- grandi

- lancia

- lancio

- querela

- Leads

- Consente di

- Livello

- Leva

- ciclo di vita

- piace

- LIMITE

- limiti

- Limitato

- Lista

- elencati

- mantenimento

- make

- FA

- gestito

- significativo

- si intende

- meccanismo

- medicina

- Metrica

- mente

- attenuante

- modello

- modelli

- Scopri di più

- maggior parte

- devono obbligatoriamente:

- Vicino

- Bisogno

- New

- adesso

- of

- MENO

- offensivo

- Offerte

- on

- una volta

- quelli

- online

- online banking

- ottimizzazione

- Opzione

- Opzioni

- or

- organizzazione

- organizzazioni

- Altro

- nostro

- su

- uscite

- proprio

- parte

- passato

- performance

- eseguita

- Personalmente

- phd

- pii

- posto

- Platone

- Platone Data Intelligence

- PlatoneDati

- Termini e Condizioni

- politici

- possibile

- energia

- pratica

- pratiche

- Presidente

- impedisce

- Anteprima

- priorità

- priorità

- Privacy

- Privacy e sicurezza

- processi

- produrre

- PROFANITÀ

- professionale

- Insegnante

- promettente

- promuoverlo

- proprietà

- protetta

- proteggere

- protegge

- fornire

- purché

- fornitori

- fornitura

- pubblicamente

- metti

- qualità

- query

- solleva

- gamma

- veloce

- rapidamente

- RE

- ridurre

- rilasciare

- rilevanza

- rimanere

- rimuovere

- rapporto

- necessario

- richiede

- resistente

- risorsa

- Risorse

- Rispondere

- risposte

- responsabilità

- responsabile

- in modo responsabile

- limitato

- destra

- Rischio

- robustezza

- running

- corre

- sicura

- garanzie

- tranquillamente

- Sicurezza

- sagemaker

- stesso

- Scala

- scala ai

- bilancia

- scansione

- di moto

- Scienze

- scienziati

- Sezione

- sicuro

- problemi di

- vedere

- select

- prodotti

- servizio

- Servizi

- servizio

- set

- regolazione

- insediamento

- flessibile.

- da

- singolo

- So

- venduto

- alcuni

- Qualcuno

- specifico

- discorso

- spendere

- diffondere

- Stage

- stare in piedi

- Standard

- in piedi

- stanford

- Università di Stanford

- sciopero

- style

- tale

- Sues

- supportato

- sostenuta

- presa

- Task

- team

- Tecnologia

- società tecnologiche

- testato

- Testing

- test

- testo

- che

- Il

- le informazioni

- Regno Unito

- loro

- Li

- Strumenti Bowman per analizzare le seguenti finiture:

- di

- di parti terze standard

- questo

- questa settimana

- quest'anno

- quelli

- Attraverso

- tempo

- titano

- a

- insieme

- strumenti

- Argomenti

- Treni

- Training

- Trasparenza

- trasparente

- Affidati ad

- TURNO

- Uk

- capire

- intraprendere

- unico

- Università

- uso

- caso d'uso

- utilizzato

- Utente

- utenti

- utilizzando

- importantissima

- Voce

- volontario

- volontario

- vp

- volere

- filigrana

- watermarking

- filigrane

- Modo..

- modi

- we

- sito web

- servizi web

- Sito web

- settimana

- WELL

- sono stati

- Che

- quando

- quale

- while

- OMS

- tutto

- largo

- Vasta gamma

- ampiamente

- volere

- con

- entro

- parole

- Lavora

- flussi di lavoro

- Forza lavoro

- anno

- ieri

- Tu

- zefiro